Podręcznik

1. Modele neuronów

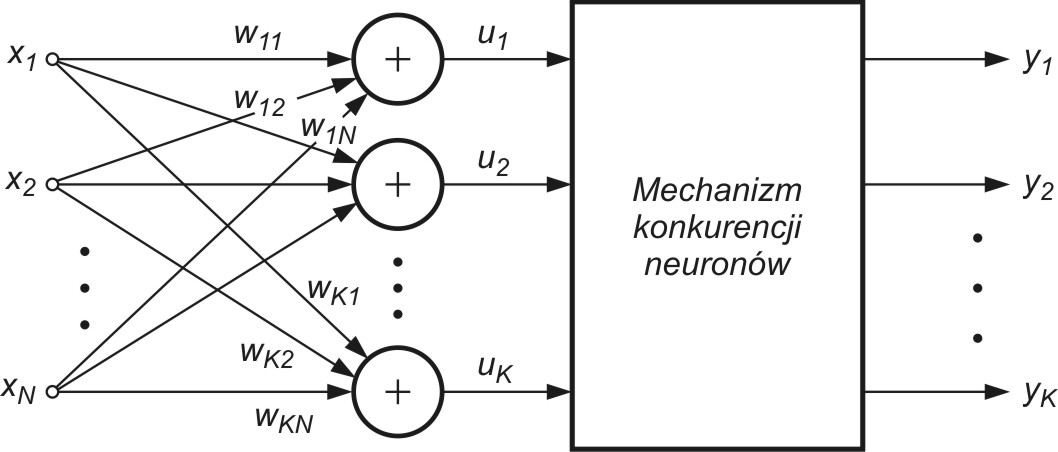

1.5. Model neuronów samoorganizujących się poprzez współzawodnictwo

Specjalny typ stanowią neurony samoorganizujące się poprzez konkurencję. W klasycznym ujęciu mają one stopień wejściowy w postaci standardowego sumatora wagowego o wagach (rys. 1.6), dla którego sygnał wyjściowy

(rys. 1.6), dla którego sygnał wyjściowy  -tego sumatora opisany jest relacją

-tego sumatora opisany jest relacją

|

(1.15) |

w której x jest znormalizowanym  -wymiarowym wektorem wejściowym a

-wymiarowym wektorem wejściowym a  wektorem wagowym

wektorem wagowym  -tego neuronu.

-tego neuronu.

Grupa neuronów współzawodniczących ze sobą pobudzana jest tymi samymi sygnałami wejściowymi  .

W zależności od aktualnych wartości sygnałów sumacyjnych

.

W zależności od aktualnych wartości sygnałów sumacyjnych  poszczególnych neuronów za zwycięzcę uważa się neuron,

którego wartość

poszczególnych neuronów za zwycięzcę uważa się neuron,

którego wartość  jest największa. Neuron zwycięzca przyjmuje na swoim wyjściu stan

jest największa. Neuron zwycięzca przyjmuje na swoim wyjściu stan  , a pozostałe (przegrywające) stan zero.

Ze względu na normalizację sygnałów wejściowych neuronem zwycięskim jest zawsze ten, który znajduje się najbliżej aktualnego wektora wejściowego

, a pozostałe (przegrywające) stan zero.

Ze względu na normalizację sygnałów wejściowych neuronem zwycięskim jest zawsze ten, który znajduje się najbliżej aktualnego wektora wejściowego

, a więc o najmniejszej wartości normy

, a więc o najmniejszej wartości normy  .

W praktyce zamiast obliczać sumy wagowe poszczególnych neuronów w procesie wyłaniania zwycięzcy oblicza się miary odległościowe i na tej podstawie

wyłania zwycięzcę [46]. Najprostsza adaptacja wag neuronów jest typu WTA (ang. Winner Takes All) i nie wymaga nauczyciela. Na wstępie przyjmuje się losowe,

znormalizowane wartości wag poszczególnych neuronów. Po podaniu wektora wejściowego

.

W praktyce zamiast obliczać sumy wagowe poszczególnych neuronów w procesie wyłaniania zwycięzcy oblicza się miary odległościowe i na tej podstawie

wyłania zwycięzcę [46]. Najprostsza adaptacja wag neuronów jest typu WTA (ang. Winner Takes All) i nie wymaga nauczyciela. Na wstępie przyjmuje się losowe,

znormalizowane wartości wag poszczególnych neuronów. Po podaniu wektora wejściowego  wyłaniany jest zwycięzca.

Neuron zwyciężający w konkurencji przyjmuje stan 1, a pozostałe 0. Aktualizacja wag odbywa się według wzoru Grosberga zapisanego w formie skalarnej

dla

wyłaniany jest zwycięzca.

Neuron zwyciężający w konkurencji przyjmuje stan 1, a pozostałe 0. Aktualizacja wag odbywa się według wzoru Grosberga zapisanego w formie skalarnej

dla  -tej wagi wektora

-tej wagi wektora  -tego

-tego

![w_{ij} (k+1) = w_{ij} (k) + \eta [ x_j - w_{ij}(k) ] w_{ij} (k+1) = w_{ij} (k) + \eta [ x_j - w_{ij}(k) ]](https://esezam.okno.pw.edu.pl/filter/tex/pix.php/0f63954106d1629c860b6bfe4505de54.gif) |

(1.16) |

lub wektorowej

![\mathbf{w}_{i} (k+1) = \mathbf{w}_{i} (k) + \eta [ \mathbf{x} - \mathbf{w}_{i}(k) ] \mathbf{w}_{i} (k+1) = \mathbf{w}_{i} (k) + \eta [ \mathbf{x} - \mathbf{w}_{i}(k) ]](https://esezam.okno.pw.edu.pl/filter/tex/pix.php/ec37e843d2a67d172a184cdd8bdbc2cb.gif) |

(1.17) |

Zauważmy, że w formule WTA jedynie neurony zwycięskie o sygnale wyjściowym  uaktualniają swoje wagi.

Neurony przegrywające konkurencję nie zmieniają swoich wag. W efekcie takiej organizacji algorytmu uczącego wektory wagowe neuronów podążają

za wektorami uczącymi

uaktualniają swoje wagi.

Neurony przegrywające konkurencję nie zmieniają swoich wag. W efekcie takiej organizacji algorytmu uczącego wektory wagowe neuronów podążają

za wektorami uczącymi  , przyjmując w efekcie uśrednione wartości wektorów wejściowych, dla których dany neuron był zwycięzcą.

W praktyce stosuje się również strategię WTM (Winner Takes Most), w której neurony przegrywające konkurencję uczestniczą również w adaptacji

swoich wag, ale przy współczynniku adaptacji

, przyjmując w efekcie uśrednione wartości wektorów wejściowych, dla których dany neuron był zwycięzcą.

W praktyce stosuje się również strategię WTM (Winner Takes Most), w której neurony przegrywające konkurencję uczestniczą również w adaptacji

swoich wag, ale przy współczynniku adaptacji  uzależnionym od odległości tych neuronów od wektora wejściowego

uzależnionym od odległości tych neuronów od wektora wejściowego  .

.

W wyniku zwycięstwa neuronu następuje douczenie jego wag, przybliżające je do odpowiednich składowych danego wektora  .

Przy podaniu na wejście sieci wielu wektorów zbliżonych do siebie, zwyciężać będzie ciągle ten sam neuron, w wyniku czego jego wagi odpowiadać

będą uśrednionym wartościom wektorów wejściowych, dla których dany neuron był zwycięzcą. Neurony przegrywające nie zmieniają swoich wag.

Dopiero zwycięstwo przy następnej prezentacji wektora wejściowego umożliwi im dokonanie aktualizacji wag i rozpoczęcie procesu douczania przy

kolejnych zwycięstwach. W efekcie takiego współzawodnictwa następuje automatyczne grupowanie danych. Neurony dopasowują swoje wagi w ten sposób,

że przy prezentacji grup wektorów wejściowych zbliżonych do siebie zwycięża zawsze ten sam neuron. Neuron ten reprezentować będzie swoimi wagami

wszystkie wektory

.

Przy podaniu na wejście sieci wielu wektorów zbliżonych do siebie, zwyciężać będzie ciągle ten sam neuron, w wyniku czego jego wagi odpowiadać

będą uśrednionym wartościom wektorów wejściowych, dla których dany neuron był zwycięzcą. Neurony przegrywające nie zmieniają swoich wag.

Dopiero zwycięstwo przy następnej prezentacji wektora wejściowego umożliwi im dokonanie aktualizacji wag i rozpoczęcie procesu douczania przy

kolejnych zwycięstwach. W efekcie takiego współzawodnictwa następuje automatyczne grupowanie danych. Neurony dopasowują swoje wagi w ten sposób,

że przy prezentacji grup wektorów wejściowych zbliżonych do siebie zwycięża zawsze ten sam neuron. Neuron ten reprezentować będzie swoimi wagami

wszystkie wektory  znajdujące się w jego strefie dominacji. W efekcie powstaje samoczynny podział danych na klastry reprezentowane

przez neuron zwycięzcę. Układy tego typu są stosowane najczęściej do grupowania danych jak również do klasyfikacji wektorów.

znajdujące się w jego strefie dominacji. W efekcie powstaje samoczynny podział danych na klastry reprezentowane

przez neuron zwycięzcę. Układy tego typu są stosowane najczęściej do grupowania danych jak również do klasyfikacji wektorów.