Podręcznik

3. Perceptron wielowarstwowy

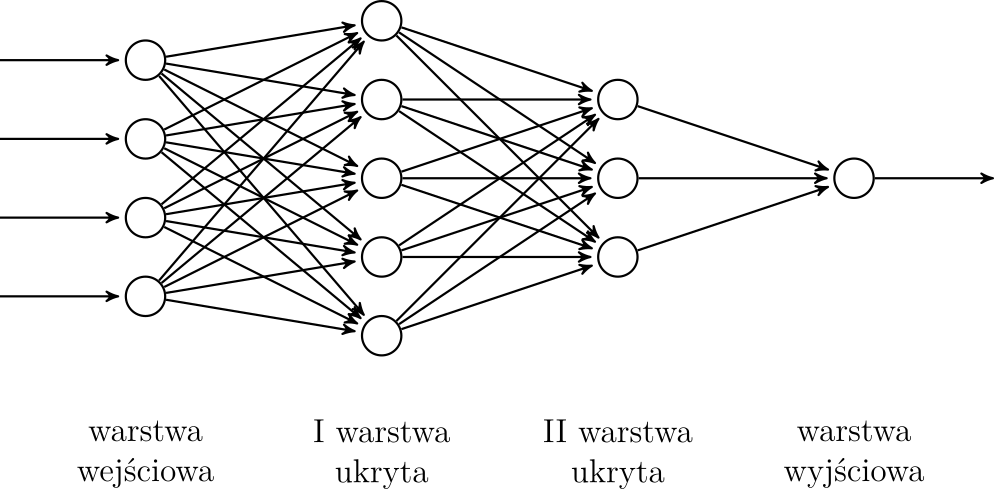

W tym rozdziale omówimy podstawową architekturę sieci neuronowej - perceptron wielowarstwowy (ang. MLP - Multi Layer Perceptron). Poznamy również podstawowe koncepcje przydatne również w bardziej złożonych sieciach. Schemat perceptoronu został przedstawiony na rysunku 3. Neurony (okręgi na rysunku) ułożone są w warstwy. Warstwa wejściowa odpowiada za wejście modelu, warstwa wyjściowa za wyjście, a warstwy pośrednie nazywamy warstwami ukrytymi. Sieć powinna posiadać przynajmniej jedną warstwę ukrytą. Często posiada ich więcej, a sieci głębokie [Goodfellow et al., 2016] zawierają dużo (nawet kilkaset) warstw ukrytych. W perceptronie wszystkie neurony warstwy poprzedniej są połączone z wszystkimi neuronami warstwy kolejnej.

Rysunek 3: Perceptron wielowarstwowy

Literatura

|

[Goodfellow et al., 2016]

|

Goodfellow, I., Bengio, Y., and Courville, A. (2016). Deep Learning. MIT Press. http://www.deeplearningbook.org. |