Podręcznik

3. Cyfrowe przetwarzanie sygnałów

3.2. Problemy związane z próbkowaniem

Przejście do sygnału cyfrowego pozwala na efektywne przetwarzanie, przechowywanie i transmisję, ale wiąże się z szeregiem potencjalnych problemów technicznych:

- aliasing (zakłócenia aliasowe),

- błąd kwantyzacji,

- opóźnienia,

- ograniczenia sprzętowe,

- artefakty cyfrowe.

Poprawne zaprojektowanie procesu próbkowania i konwersji ma kluczowe znaczenie dla jakości całego systemu cyfrowego.

W procesie próbkowania część informacji o sygnale jest pomijana. Jeżeli zmiany sygnału są bardzo szybkie w porównaniu z częstotliwością próbkowania, dynamika sygnału oryginału nie zostanie uchwycona. Podstawowym zagadnieniem podczas cyfrowego przetwarzania sygnałów jest właściwy dobór częstotliwości próbkowania. Powinna ona być dobrana tak, aby:

- była wystarczająco duża, by dokładnie odwzorowywać zmienność i dynamikę badanego sygnału,

- nie była nadmiernie wysoka, ponieważ zbyt gęste próbkowanie prowadzi do powstania dużej liczby silnie skorelowanych próbek, co zwiększa koszty pamięciowe i obliczeniowe, nie przynosząc istotnych korzyści informacyjnych,

- nie była też zbyt niska, ponieważ zbyt rzadkie próbkowanie może prowadzić do zjawiska, w którym informacje o składowych wysokoczęstotliwościowych zostają zniekształcone lub nieodróżnialne od składowych niskoczęstotliwościowych.

Podczas próbkowania sygnału z częstotliwością \( f_s \) próbek na sekundę, niemożliwe staje się jednoznaczne rozróżnienie między sygnałem sinusoidalnym o częstotliwości \( f \), a sygnałami o częstotliwościach \( f+kf_s \), gdzie \( k \) jest dowolną liczbą całkowitą. Oznacza to, że ten sam zbiór próbek może odpowiadać nieskończonej liczbie sinusoid różniących się całkowitymi wielokrotnościami częstotliwości próbkowania.

Jest to podstawowa właściwość próbkowania i jedna z kluczowych konsekwencji analizy sygnałów w dziedzinie częstotliwości. Niewłaściwie dobrana częstotliwość próbkowania prowadzi często do błędnej interpretacji sygnału analogowego, znanej jako aliasing. Zjawisko to polega na tym, że na podstawie zbyt rzadko pobranych próbek z oryginalnego przebiegu sygnału system cyfrowy interpretuje sygnał jako mający inną częstotliwość, niż w rzeczywistości.

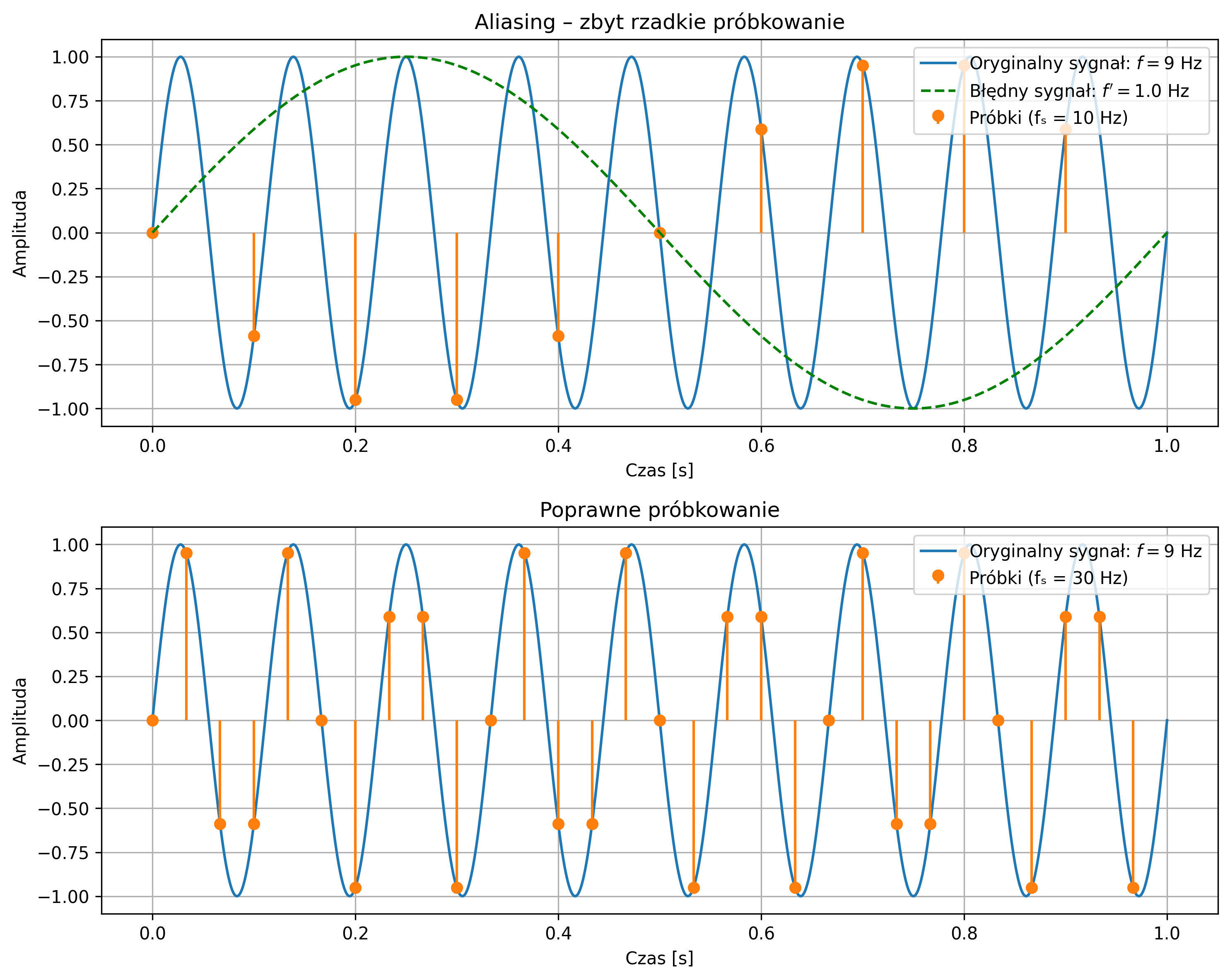

Na rys. 3.3 zostało graficznie przedstawione zjawisko aliasingu. Na pierwszym wykresie próbkowanie sygnału sinusoidalnego (o częstotliwości \(9\) Hz) jest zbyt rzadkie (częstotliwość próbkowania wynosi \(10\) Hz), co skutkuje jego błędnym odwzorowaniem sygnału. System identyfikuje sygnał jako mający niższą częstotliwość, niż w rzeczywistości. Drugi wykres pokazuje poprawne próbkowanie (na poziomie \(30\) Hz) – częstotliwość próbkowania jest wystarczająco wysoka, aby dokładnie odwzorować przebieg oryginalnego sygnału.

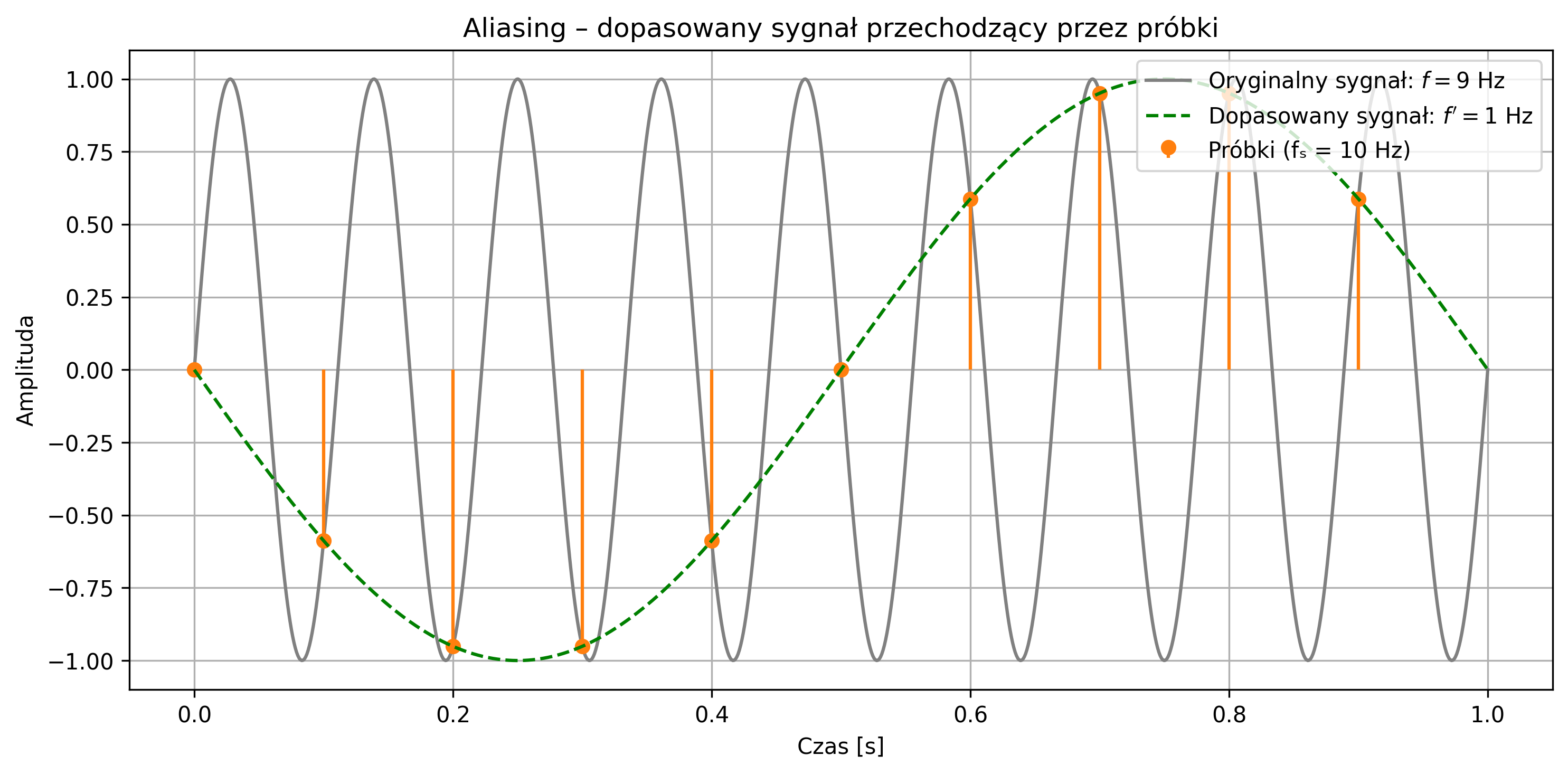

Błędnie odtworzony sygnał (zielona przerywana linia) nie musi przechodzić przez wszystkie próbki, ponieważ on nie jest rekonstrukcją sygnału rzeczywistego, tylko fałszywym sygnałem sinusoidalnym o innej częstotliwości, który mógłby dać te same próbki w tych samych chwilach czasu (rys. 3.4). Jednakże, pomimo tego, że próbkujemy zbyt rzadko, to więcej niż jeden sygnał ciągły może dawać te same próbki – takie same wartości w chwilach próbkowania (np. co \(0.1\) s), mimo że mają zupełnie inne kształty między tymi punktami.

Aby uniknąć aliasingu i móc jednoznacznie odtworzyć sygnał na podstawie jego próbek, konieczne jest spełnienie twierdzenia Nyquista-Shannona, które mówi, że:

gdzie:

- \( x(t) \) – sygnał pasmowo ograniczony do \( f_{max} \),

- \( x[n]=x(nT) \) – próbki sygnału, dla okresu próbkowania \( T=1/f_s \).

Częstotliwość próbkowania musi być co najmniej dwa razy większa od najwyższej częstotliwości zawartej w sygnale. Tę minimalną dopuszczalną częstotliwość próbkowania \( f_s=2f_{max} \) nazywamy częstotliwością Nyquista. Jeśli próbkowanie przebiega zgodnie z tym warunkiem, sygnał może zostać dokładnie zrekonstruowany z próbek.

Gdy częstotliwość sygnału przekracza częstotliwość Nyquista, wysokoczęstotliwościowe składowe sygnału „nakładają się” na niższe, tworząc mylący obraz przebiegu. Zjawisko to stanowi potencjalne źródło błędów, specyficznych dla cyfrowego przetwarzania sygnałów. Dlatego poprawny dobór częstotliwości próbkowania oraz zastosowanie odpowiednich filtrów antyaliasingowych są kluczowe dla wiarygodności cyfrowej analizy sygnałów.

Przypomnijmy, że sygnał spróbkowany to sygnał, który jest dyskretny w czasie, ale w ogólności ciągły w amplitudzie. Oznacza to, że jego wartości występują tylko w wybranych chwilach czasu, lecz same wartości próbek mogą przyjmować dowolne wartości rzeczywiste – należące do zbioru ciągłego. Aby możliwe było jego pełne przetwarzanie w systemach cyfrowych, konieczne jest ograniczenie również zakresu możliwych wartości amplitudy.

Proces ten nazywamy kwantyzacją – polega on na zaokrągleniu wartości próbek do najbliższych poziomów z ustalonego, skończonego zbioru dopuszczalnych wartości. W niniejszym opracowaniu, proces kwantyzacji nie jest uwzględniany, gdyż zwykle jest realizowany automatycznie przez przetworniki analogowo-cyfrowe i systemy komputerowe. Jednakże należy podkreślić, że kwantyzacja wiąże się z powstaniem błędu, tzw. szumu kwantyzacji. Jest to różnica między rzeczywistą wartością próbki, a jej reprezentacją cyfrową. Wartości tego błędu mogą obniżać jakość sygnału.

Kolejnym problemem są opóźnienia. Przetwarzanie cyfrowe zajmuje czas – w systemach czasu rzeczywistego może to prowadzić do opóźnień. Podobnie nieprawidłowe taktowanie może wprowadzić zmienność między odstępami próbkowania. Ponadto, przetworniki mają ograniczony zakres dynamiczny, pasmo przenoszenia i szybkość konwersji. Mogą nie nadążyć za sygnałem, zwłaszcza przy dużych częstotliwościach. Z kolei błędy numeryczne, aliasing, niewłaściwe próbkowanie lub filtrowanie mogą prowadzić do artefaktów w sygnałach – w obrazie, dźwięku lub analizie danych biomedycznych (np. EKG).