Podręcznik

| Strona: | SEZAM - System Edukacyjnych Zasobów Akademickich i Multimedialnych |

| Kurs: | 1. Podstawy testowania oprogramowania |

| Książka: | Podręcznik |

| Wydrukowane przez użytkownika: | Gość |

| Data: | sobota, 14 lutego 2026, 23:37 |

Opis

1. Podstawy testowania oprogramowania

Testowanie oprogramowania jest nieodzownym elementem cyklu życia oprogramowania (SDLC), zapewniającym, że każdy etap produkcji działa zgodnie z oczekiwaniami i normami jakościowymi. Rozpoczynając od analizy wymagań, proces ten wymaga dogłębnego zrozumienia potrzeb użytkownika i rynku, aby zapewnić, że oprogramowanie spełni oczekiwania końcowe. Następnie, w fazie projektowania systemu, testowanie koncentruje się na strukturze i architekturze oprogramowania, aby zapewnić jego skalowalność i wydajność. Implementacja to etap, na którym programiści przekształcają projekt w działający kod, a testerzy odgrywają kluczową rolę w wykrywaniu błędów i nieścisłości.

Testowanie staje się jeszcze bardziej istotne, gdy produkt zbliża się do etapu wdrożenia, gdzie każda niezgodność może mieć poważne konsekwencje. Utrzymanie oprogramowania, ostatnia faza SDLC, wymaga ciągłego monitorowania i testowania, aby zapewnić stabilność i bezpieczeństwo produktu na rynku. Testowanie jednostkowe, pierwszy poziom testowania, koncentruje się na najmniejszych częściach kodu, zapewniając, że każdy moduł działa poprawnie w izolacji.

Testowanie integracyjne, kolejny krok, bada interakcje między modułami, identyfikując problemy w komunikacji i działaniu systemu jako całości. Testowanie systemowe, szerzej obejmujące całe oprogramowanie, sprawdza, czy wszystkie wymagania i funkcje zostały spełnione. Testowanie akceptacyjne z kolei angażuje użytkowników końcowych, aby upewnić się, że oprogramowanie spełnia ich oczekiwania i jest gotowe do użycia w realnym środowisku.

Testowanie funkcjonalne koncentruje się na działaniach, które oprogramowanie powinno wykonywać, podczas gdy testy niefunkcjonalne oceniają aspekty takie jak wydajność, bezpieczeństwo i użyteczność. Testowanie regresyjne i eksploracyjne odgrywają ważną rolę w utrzymaniu jakości oprogramowania poprzez regularne sprawdzanie istniejących funkcji pod kątem nowych błędów oraz poszukiwanie niewykrytych wcześniej problemów.

Cykl życia testów obejmuje planowanie i analizę, gdzie określane są cele testów, projektowanie testów, które precyzuje przypadki testowe, wykonanie testów, a następnie ich ocenę i raportowanie. Zarządzanie testami wymaga skutecznej organizacji zespołu i efektywnego wykorzystania narzędzi zarządzania testami. Zakończenie cyklu testów to etap, na którym oceniane są wyniki testów, a produkt jest przekazywany do produkcji lub wprowadzany na rynek. Na tym etapie kluczowe jest również wyciąganie wniosków i lekcji na przyszłość.

Testowanie oprogramowania jest zatem nie tylko procesem technicznym, ale również strategicznym, wymagającym dogłębnej wiedzy, umiejętności analitycznych i zdolności adaptacji do zmieniających się wymagań i technologii. Zapewnia to, że oprogramowanie nie tylko spełnia swoje funkcje, ale jest również bezpieczne, niezawodne i gotowe na przyszłe wyzwania.

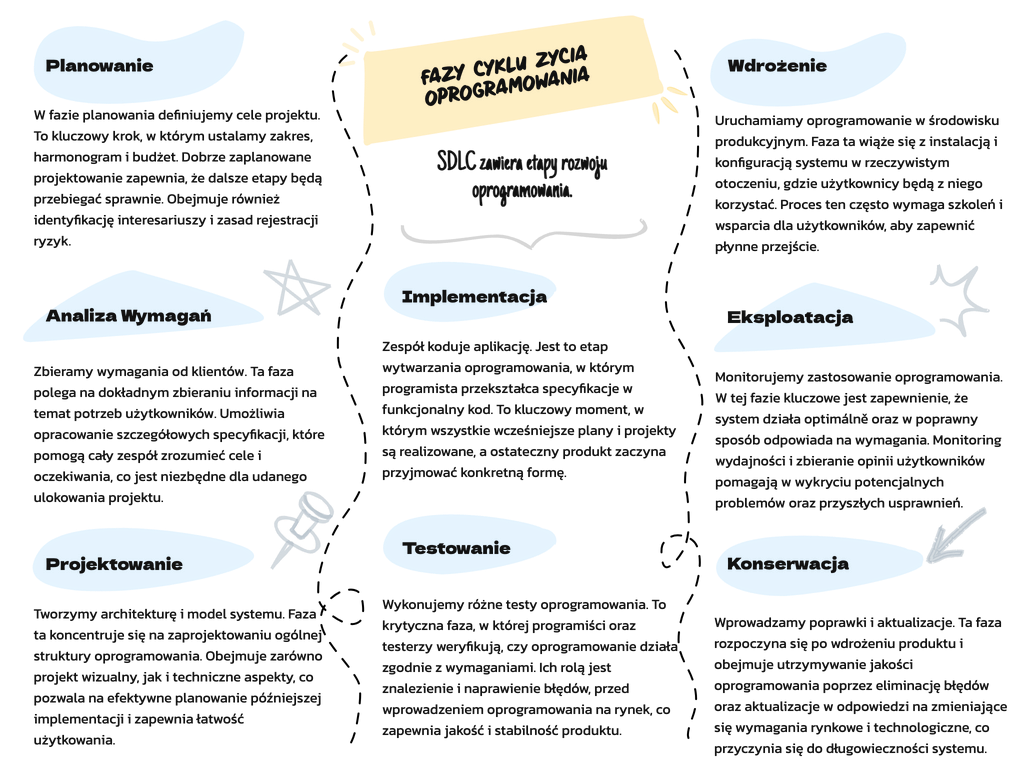

1.1. Cykl życia oprogramowania (SDLC) i testowanie

Testowanie oprogramowania jest nieodłączną częścią każdego etapu cyklu życia oprogramowania, znanego jako Software Development Life Cycle (SDLC). SDLC reprezentuje sekwencję etapów inżynierii oprogramowania, które są konieczne do opracowania i dostarczenia produktu programistycznego. Zrozumienie tego cyklu oraz roli, jaką testowanie odgrywa na każdym jego etapie, jest kluczowe dla zapewnienia, że finalne oprogramowanie będzie charakteryzowało się wysoką jakością i stosunkowo małą liczbą błędów.

1.1.1. Przegląd SDLC

Rozwój oprogramowania to proces złożony i wielowymiarowy, który wykracza poza prostą implementację kodu. SDLC definiuje strukturę i kolejność działań projektowych, począwszy od wstępnej koncepcji, przez analizę, projektowanie, implementację, aż po wdrożenie i konserwację. Każda faza ma wyznaczone cele i zadania, a testowanie przeplata się przez wszystkie te etapy, pomagając identyfikować i rozwiązywać problemy na bieżąco. Taka zintegrowana perspektywa testowania zapewnia, że produkty programistyczne spełniają zarówno wymagania biznesowe, jak i techniczne, co jest fundamentem dla dostarczania wartościowych i niezawodnych rozwiązań informatycznych.

Etap 1: Planowanie - na tym początkowym etapie określane są wymagania, cele oraz zakres projektu oprogramowania. Planowanie obejmuje również identyfikację potencjalnych ryzyk i ustalenie priorytetów. Testowanie w tej fazie obejmuje przegląd wymagań i ocenę ich testowalności.

Etap 2: Analiza Wymagań - podczas analizy wymagań zbiera się i dokładnie definiuje oczekiwania klienta odnośnie do funkcjonalności i ograniczeń systemu. Testowanie na tym etapie koncentruje się na walidacji wymagań, aby upewnić się, że są one jasne, kompletne i realizowalne.

Etap 3: Projektowanie - faza projektowania wypracowuje sposób realizacji wymagań analizy. Tworzone są architektura systemu, bazy danych oraz interfejsy użytkownika. Testowanie w tej fazie często obejmuje opracowanie strategii testów oraz projektowanie testów na podstawie dokumentacji projektowej.

Etap 4: Implementacja - podczas implementacji, kod źródłowy oprogramowania jest pisany i integrowany. Testowanie jednostkowe i integracyjne są kluczowe na tym etapie, aby zapewnić, że każdy moduł działa zgodnie z wymaganiami.

Etap 5: Testowanie - to dedykowana faza, w której przeprowadza się testy systemowe i akceptacyjne. Jej celem jest wykrycie i usunięcie błędów przed wdrożeniem systemu. Testowanie może być wykonane manualnie lub z wykorzystaniem automatyzacji.

Etap 6: Wdrożenie - po pomyślnym przetestowaniu, oprogramowanie jest instalowane w środowisku docelowym. Testowanie w tej fazie może obejmować testy akceptacyjne użytkownika oraz monitorowanie oprogramowania w celu identyfikacji problemów występujących w rzeczywistych warunkach użytkowania.

Etap 7: Konserwacja i Eksploatacja - po wdrożeniu, oprogramowanie jest utrzymywane i aktualizowane, aby zapewnić jego ciągłą funkcjonalność i bezpieczeństwo. Testowanie w tym okresie obejmuje regresję i testy wydajnościowe, mające na celu upewnić się, że zmiany nie wprowadzają nowych błędów.

Testowanie w SDLC nie jest jednorazowym wydarzeniem, lecz ciągłym procesem. Wspiera ono każdy etap rozwoju oprogramowania, od planowania aż po konserwację, zapewniając, że finalny produkt spełnia zarówno wymagania biznesowe, jak i techniczne. Testowanie jest nie tylko kluczowe dla zapewnienia jakości, ale również pomaga w zarządzaniu ryzykiem na każdym etapie cyklu życia oprogramowania.

1.1.2. Integracja testowania w SDLC

Faza analizy wymagań i testowanie:

Czynności: Weryfikacja wymagań, testowanie wykonalności.

Koncentracja: Upewnienie się, że wymagania są jasne, kompletne i testowalne. Potencjalne niejasności lub sprzeczności w wymaganiach są oznaczane. Określa etap definiowania celów i zakresu testów na późniejszych etapach.

Faza projektowa i testowanie:

Czynności: Przegląd projektu, tworzenie planu testów.

Koncentracja: Przegląd architektury oprogramowania i projektu pod kątem testowalności, skalowalności i wydajności. Faza ta obejmuje stworzenie wstępnego planu testów, określającego ogólną strategię testowania, narzędzia i zasoby.

Faza wdrożenia i testowania:

Czynności: Testowanie jednostkowe, przegląd kodu.

Główny cel: Podczas pisania kodu przez programistów, poszczególne jednostki (funkcje, metody lub klasy) są testowane w celu wczesnego wykrycia usterek. Dodatkowo, przeglądy kodu zapewniają zgodność ze standardami kodowania i najlepszymi praktykami.

Faza testowania:

Czynności: Testowanie systemu, testowanie integracyjne, testowanie regresji, testowanie wydajności, testowanie akceptacyjne itp.

Cel: Jest to najbardziej intensywna faza testowania. Oprogramowanie jako całość (testowanie systemu), a także jego interakcje z innymi systemami (testowanie integracyjne) są rygorystycznie oceniane. Wszelkie zmiany w kodzie są weryfikowane za pomocą testów regresji. Wreszcie, testy akceptacyjne zapewniają, że oprogramowanie spełnia wymagania użytkowników.

Faza wdrożenia i testowanie:

Czynności: Testy akceptacyjne użytkownika (UAT), testy dymne.

Główny cel: Przed wdrożeniem produkcyjnym na pełną skalę, podzbiór użytkowników końcowych często angażuje się w UAT, aby zweryfikować oprogramowanie w rzeczywistym środowisku. Po wdrożeniu, testy dymu zapewniają, że najważniejsze funkcje działają poprawnie w środowisku produkcyjnym.

Faza utrzymania i testowania:

Działania: Testowanie regresji, testowanie poprawek.

Koncentracja: W miarę zgłaszania błędów po wdrożeniu lub aktualizacji oprogramowania, testowanie regresji zapewnia, że nowe zmiany w kodzie nie wpływają negatywnie na istniejące funkcje. Wszelkie natychmiastowe poprawki (hotfix) są również testowane przed wydaniem.

1.1.3. Pętla ciągłej informacji zwrotnej

Nowoczesne metodologie SDLC, zwłaszcza Agile i DevOps, kładą nacisk na ciągłą informację zwrotną i iterację. Testowanie w tych kontekstach nie ogranicza się do jednej fazy, ale jest działaniem ciągłym, oferującym informacje zwrotne na każdym etapie SDLC. Potoki ciągłej integracji (CI) i ciągłego wdrażania (CD) obejmują zautomatyzowane testowanie w celu zapewnienia jakości oprogramowania przy dużej prędkości rozwoju.

W dziedzinie tworzenia i testowania oprogramowania, jeśli istnieje koncepcja, która zawiera w sobie nowoczesne metodologie, takie jak Agile i DevOps, to jest to pętla ciągłego sprzężenia zwrotnego. Pętla ta ma na celu regularne przechwytywanie informacji zwrotnych na każdym etapie cyklu życia oprogramowania (SDLC) i natychmiastowe wplatanie ich z powrotem w proces, udoskonalając i poprawiając jakość oprogramowania w czasie rzeczywistym.

Pętla Continuous Feedback Loop nie jest procesem liniowym, ale cyklicznym, zapewniając, że każda faza SDLC jest zarówno odbiorcą, jak i dostawcą informacji zwrotnych.

Od wymagań do projektu: Po zebraniu wymagań są one często weryfikowane z interesariuszami. Informacje zwrotne na tym etapie zapewniają jasność i wykonalność, tworząc solidne podstawy dla fazy projektowania.

Od projektu do wdrożenia: Gdy plany architektoniczne są tłumaczone na kod, programiści mogą wskazać wyzwania projektowe lub niejasności. Informacje zwrotne zapewniają, że projekt jest solidny i możliwy do wdrożenia.

Od wdrożenia do testowania: Gdy kod jest wykonywany, testerzy zapewniają jego zgodność zarówno z projektem, jak i wymaganiami. Błędy, problemy z wydajnością lub odchylenia są zgłaszane programistom, upewniając się, że kod jest zarówno funkcjonalny, jak i wydajny.

Po wdrożeniu: Gdy oprogramowanie znajdzie się w rękach użytkowników końcowych, ich doświadczenia, zgłoszone błędy i obawy dotyczące użyteczności są kierowane z powrotem do SDLC, napędzając przyszłe analizy wymagań i ulepszenia projektu.

Automatyzacja Nowoczesne praktyki programistyczne wzmacniają ciągłą pętlę sprzężenia zwrotnego dzięki automatyzacji. Narzędzia takie jak Jenkins do ciągłej integracji i SonarQube do ciągłej kontroli jakości kodu zapewniają programistom natychmiastową informację zwrotną. Zautomatyzowane zestawy testów są uruchamiane okresowo, aby upewnić się, że żadna zmiana kodu nie wprowadza nowych defektów, co jeszcze bardziej zacieśnia pętlę.

Rola współpracy Wydajność pętli ciągłej informacji zwrotnej jest często określana przez poziom współpracy w zespołach. Zespoły interdyscyplinarne - w których programiści, testerzy, pracownicy operacyjni, a nawet interesariusze ściśle ze sobą współpracują - zapewniają, że informacje zwrotne są nie tylko przechwytywane, ale także szybko reagowane. Platformy takie jak JIRA czy Slack umożliwiają płynną komunikację, dzięki czemu wymiana informacji zwrotnych jest szybka i przejrzysta.

Korzyści i wpływ stosowania pętli ciągłej informacji zwrotnej

Podwyższona jakość oprogramowania:** Dzięki ciągłym informacjom zwrotnym, problemy są identyfikowane i szybko naprawiane, co prowadzi do wyższej jakości produktu końcowego.

Skrócenie czasu wprowadzenia produktu na rynek:** Ciągłe informacje zwrotne przyspieszają proces SDLC, umożliwiając szybsze wydania bez uszczerbku dla jakości.

Wzmocniona dynamika zespołu:** Ponieważ zespoły angażują się w ciągłą komunikację, sprzyja to kulturze współpracy i wzajemnego szacunku.

Wyzwania

Chociaż pętla ciągłej informacji zwrotnej oferuje liczne korzyści, nie jest pozbawiona wyzwań. Informacje zwrotne przekazywane z dużą częstotliwością mogą czasami prowadzić do przeciążenia informacyjnego. Priorytetyzacja informacji zwrotnych i zapewnienie, że prowadzą one do praktycznych spostrzeżeń ma kluczowe znaczenie. Dodatkowo, zmiana kulturowa w kierunku ciągłej informacji zwrotnej może początkowo być szokująca dla zespołów przyzwyczajonych do tradycyjnego, silosowego podejścia. Szkolenia i wsparcie kierownictwa mają kluczowe znaczenie w takich zmianach.

1.1.4. Rola testerów w SDLC

Tradycyjnie testerzy byli zaangażowani głównie w fazie testowania. Jednak współczesny SDLC angażuje testerów przez cały cykl życia produktu. Począwszy od przeglądu wymagań pod kątem testowalności, po udział w dyskusjach projektowych i oczywiście wykonywanie samych testów, testerzy odgrywają wielopłaszczyznową rolę, zapewniając jakość oprogramowania od jego powstania do wdrożenia.

Cykl życia oprogramowania (SDLC) przypomina skomplikowany taniec, w którym każdy uczestnik odgrywa kluczową rolę w tworzeniu oprogramowania. Wśród tych uczestników testerzy wyróżniają się nie tylko jako ewaluatorzy, ale także jako strażnicy jakości. Ich rola, często postrzegana jako zwykłe znajdowanie defektów, sięga znacznie głębiej, przeplatając się z każdą fazą SDLC.

Testerzy: Beyond Bug Hunting

W przeszłości testerzy byli włączani do procesu tworzenia oprogramowania na późniejszych etapach, głównie w celu identyfikacji i zgłaszania usterek. Jednak współczesne spojrzenie na testowanie, zwłaszcza w świetle metodologii, które kładą nacisk na ciągłą pętlę sprzężenia zwrotnego, znacznie poszerza rolę testerów.

Analiza wymagań: Testerzy są nieocenieni jeszcze przed napisaniem choćby jednej linijki kodu. W fazie analizy wymagań zapewniają, że wymagania są jasne, jednoznaczne i testowalne. Ich perspektywa na tym etapie może zapobiec problemom, które mogą pojawić się podczas rzeczywistego testowania.

Projektowanie: Podczas fazy projektowania testerzy często współpracują z architektami i programistami, aby przejrzeć i zrozumieć plan systemu. Ich spostrzeżenia pomagają w formułowaniu strategii testowych i przypadków testowych, zapewniając wczesną identyfikację potencjalnych błędów w projekcie.

Wdrożenie: Podczas gdy kodowanie jest głównie domeną programistów, testerzy często angażują się w przeglądy kodu, oferując świeże spojrzenie na potencjalne pułapki, możliwości optymalizacji lub obszary podatne na defekty.

Testowanie: Bez wątpienia ta faza jest domeną testerów. Projektują i wykonują przypadki testowe, identyfikują defekty i przekazują informacje zwrotne. Od testów jednostkowych po systemowe, integracyjne i akceptacyjne, testerzy zapewniają, że oprogramowanie spełnia zarówno wymagania funkcjonalne, jak i niefunkcjonalne.

Wdrożenie: Po zakończeniu fazy testów podstawowych testerzy są nadal aktywnie zaangażowani. Przeprowadzają testy dymu w środowisku produkcyjnym i często kierują testami akceptacji użytkownika (UAT), zapewniając, że oprogramowanie jest gotowe dla użytkowników końcowych.

Utrzymanie: W miarę rozwoju oprogramowania testerzy zapewniają, że aktualizacje i poprawki nie wprowadzają nowych defektów. Ich ciągłe zaangażowanie gwarantuje, że oprogramowanie pozostanie niezawodne i wydajne przez długi czas.

Testerzy w ekosystemie współpracy

W nowoczesnych metodologiach SDLC, zwłaszcza Agile i DevOps, współpraca jest najważniejsza. Testerzy nie pracują już w izolacji; są integralnymi członkami wielofunkcyjnych zespołów. Ich ścisła współpraca z programistami, działami operacyjnymi, a nawet interesariuszami biznesowymi zapewnia ciągłą informację zwrotną, szybkie rozwiązywanie problemów i spójne zrozumienie celów projektu.

Ewoluujący zestaw umiejętności

Rola współczesnego testera wymaga różnorodnych umiejętności. Oprócz biegłości w narzędziach i technikach testowania, potrzebują oni podstawowej wiedzy na temat architektury oprogramowania, baz danych, a nawet kontroli wersji. Dodatkowo, wraz z rozwojem automatyzacji, umiejętności pisania skryptów i korzystania z narzędzi do automatyzacji stają się niezbędne.

Wyzwania i rozwój

Bycie w czołówce branży zapewniania jakości oznacza, że testerzy często stają przed wyzwaniami - szybko zmieniającymi się wymaganiami, ewoluującymi narzędziami i ciągłą presją zapewnienia niezawodności oprogramowania. Jednak wyzwania te oferują również możliwości rozwoju. Będąc na bieżąco z najnowszymi technologiami i metodologiami, testerzy mogą stale doskonalić swoje umiejętności i wnosić głęboki wkład w SDLC.

Rola testerów w cyklu życia oprogramowania przekształciła się z odizolowanych ewaluatorów w zintegrowanych mistrzów jakości. Ich zaangażowanie od momentu powstania do wdrożenia i poza nim zapewnia, że oprogramowanie jest nie tylko funkcjonalne, ale także przekracza oczekiwania. Na każdym tworzenia oprogramowania testerzy stanowią fundament który zwiększa niezawodność, wydajność oraz doskonałość oprogramowania.

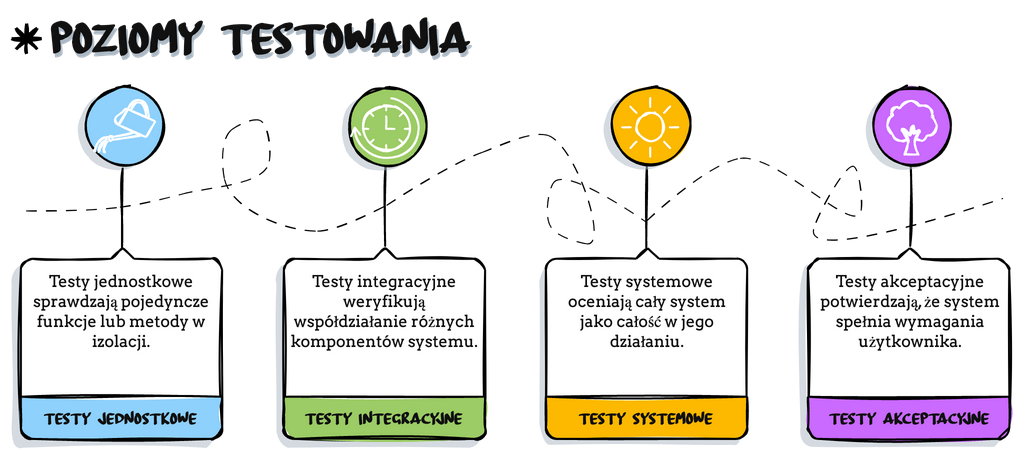

1.2. Poziomy testowania

W procesie tworzenia oprogramowania testowanie nie jest jednolitym zadaniem, lecz składa się z wielu warstw, każda z nich odpowiada za różne aspekty i etapy weryfikacji produktu. Niniejszy rozdział przedstawia szczegółowy przegląd czterech głównych poziomów testowania, które są niezbędne do zapewnienia jakości i efektywności współczesnego oprogramowania. Te poziomy obejmują:

Testy Jednostkowe: Pierwsza linia obrony przed błędami, koncentrująca się na najmniejszych jednostkach kodu.

Testy Integracyjne: Sprawdzają interakcje między zintegrowanymi komponentami, ujawniając problemy, które nie były widoczne podczas testów jednostkowych.

Testy Systemowe: Przeprowadzane są na kompletnym systemie, aby zweryfikować, że wszystkie komponenty współpracują harmonijnie, dostarczając wymaganej funkcjonalności na poziomie systemowym.

Testy Akceptacyjne: Ostateczna weryfikacja przed wypuszczeniem produktu na rynek, zapewniająca, że oprogramowanie spełnia oczekiwania użytkowników końcowych i biznesowe wymogi.

Każdy poziom jest kluczowy w cyklu życia oprogramowania i odgrywa unikalną rolę w dostarczaniu wartości dla klienta i użytkowników. W kolejnych sekcjach omówione zostanie , jak każdy poziom przyczynia się do sukcesu projektu, jakie narzędzia są najbardziej efektywne, a także wyzwania i najlepsze praktyki związane z każdym etapem testowania. Przedstawione zostaną również przykładowe scenariusze sukcesów i porażek, które posłużą jako cenne lekcje dla deweloperów i testerów oprogramowania.

1.2.1 Testy Jednostkowe (Unit Testing)

Przed opisaniem testów jednostkowych należy zając się terminem "jednostka" wymagającym dodatkowego wyjaśnienia. Istnieje kilka interpretacji na temat tego, co dokładnie co stanowi jednostkę. W proceduralnym języku programowania, jednostką może być:

pojedyncza procedura,

funkcja,

ciało kodu, które implementuje pojedynczą funkcję,

kod źródłowy, który mieści się na jednej stronie,

ciało kodu, które reprezentuje pracę wykonaną w określonym czasie,

najmniejszy fragment kodu, który może być skompilowany samodzielnie.

W obiektowym języku programowania istnieje ogólna zgoda, że klasa jest jednostką. Jednakże metody klasy mogą być opisane przez którąkolwiek z powyższych "definicji" jednostki dla języka programowania proceduralnego.

Wniosek jest taki, że "jednostka" jest prawdopodobnie najlepiej zdefiniowana przez twórcę kodu - najczęściej programistę. Może być również zdefiniowana w zasadach ogólnych zespołu programistycznego i wtedy taką część kodu uważamy za jednostkę.

Z punktu widzenia testów należy założyć, że jednostką jest fragment oprogramowania który został zaprojektowany oraz napisany przez jedną osobę i przez ta osoba będzie go testowała.

Testy jednostkowe koncentrują się na indywidualnych komponentach oprogramowania, takich jak funkcje, metody lub klasy. Są to testy izolowane, co oznacza, że każdy testowany element jest sprawdzany niezależnie od innych. Celem testów jednostkowych jest weryfikacja, czy poszczególne jednostki działają poprawnie w izolacji.

Scenariusze Testowe: Scenariusz testowy dla funkcji obliczającej VAT może wyglądać następująco:

Przypadek testowy 1:

Podstawowa stawka VAT.

Wejście: Kwota netto 100, stawka VAT 23%.

Oczekiwane wyjście: Kwota VAT 23.

Przypadek testowy 2:

Stawka VAT zwolniona.

Wejście: Kwota netto 100, stawka VAT 0%.

Oczekiwane wyjście: Kwota VAT 0.

Narzędzia:

Jest dla JavaScript: Framework testowy zapewniający prostotę i szybkość wykonania testów.

JUnit dla Javy: Popularne narzędzie do automatyzacji testów jednostkowych w środowisku JVM.

Mockito dla Javy: Umożliwia tworzenie obiektów mockowych do izolowania testowanych komponentów.

Wyzwania i Najlepsze Praktyki:

Wyzwanie: Utrzymanie izolacji testów może być trudne, gdy komponenty są silnie powiązane.

Najlepsza praktyka: Używanie technik mockowania i iniekcji zależności do minimalizowania zależności między testowanymi komponentami.

Przykłady Sukcesów i Niepowodzeń:

Sukces: Użycie TDD w rozwoju nowej funkcji pozwoliło na szybkie wykrycie i naprawę błędów, skutkując stabilnym wypuszczeniem produktu.

Niepowodzenie: Brak odpowiednich testów jednostkowych dla funkcji przeliczającej waluty doprowadził do niewykrycia błędu zaokrągleń, co miało wpływ na błędne faktury klientów.

Testy jednostkowe są fundamentem jakości kodu w procesie deweloperskim. Przeprowadzane na wczesnym etapie rozwoju oprogramowania, pozwalają na szybką i skuteczną weryfikację logiczną poszczególnych jednostek kodu. Jest to również pierwszy krok w kierunku budowy solidnej architektury oprogramowania, która będzie odporna na błędy i łatwa w utrzymaniu. Przyjęcie TDD może wydłużyć czas niezbędny do rozpoczęcia implementacji, ale w dłuższej perspektywie czasowej pozwala na oszczędność czasu i zasobów dzięki redukcji liczby defektów w oprogramowaniu.

1.2.2 Testy Integracyjne (Integration Testing)

Testy integracyjne oceniają współpracę i komunikację między zintegrowanymi komponentami oprogramowania, takimi jak moduły, klasy, funkcje, czy całe usługi. Głównym celem jest identyfikacja problemów, które mogą wystąpić gdy oddzielnie testowane jednostki są połączone w jeden system. Testy te sprawdzają poprawność interfejsów, zgodność danych, oraz współpracę funkcji w złożonym środowisku.

Scenariusze Testowe: Dla systemu zarządzania zamówieniami scenariusze mogą obejmować:

Przypadek testowy 1: Przepływ danych między modułem koszyka a systemem płatności.

Wejście: Wprowadzenie danych kart kredytowych i potwierdzenie zakupu.

Oczekiwane wyjście: Poprawne przekazanie danych do systemu płatności i zainicjowanie transakcji.

Przypadek testowy 2: Integracja modułu wysyłkowego z modułem zarządzania zamówieniami.

Wejście: Status zamówienia zmieniony na "gotowe do wysyłki".

Oczekiwane wyjście: Poprawne wygenerowanie listu przewozowego.

Narzędzia:

Postman dla API: Pozwala na testowanie i debugowanie API przez wysyłanie zapytań i analizowanie odpowiedzi.

Selenium dla UI: Automatyzuje przeglądarki internetowe, umożliwiając testowanie integracji interfejsu użytkownika z logiką biznesową.

Jenkins dla CI/CD: Automatyzuje procesy budowania i testowania, wspierając ciągłą integrację komponentów.

Wyzwania i Najlepsze Praktyki:

Wyzwanie: Zapewnienie kompatybilności i spójności danych między modułami, które były rozwijane niezależnie.

Najlepsza praktyka: Wczesne planowanie i definiowanie jasnych interfejsów i kontraktów między modułami; regularne przeprowadzanie testów integracyjnych w procesie rozwoju.

Przykłady Sukcesów i Niepowodzeń:

Sukces: Skuteczne wdrożenie testów integracyjnych umożliwiło szybką identyfikację i naprawę problemów komunikacyjnych między nowym API a istniejącą bazą danych, co zapobiegło przerwom w działaniu systemu w produkcji.

Niepowodzenie: Brak kompleksowych testów integracyjnych dla systemu e-commerce doprowadził do niezgodności w przepływie zamówień, co skutkowało przestojami i utratą dochodów.

Testy integracyjne są kluczowym elementem zapewnienia wysokiej jakości oprogramowania. Pozwalają nie tylko wykryć problemy na poziomie współdziałania komponentów, ale również sprawdzają, czy cały system jest gotowy do dalszych etapów testów, takich jak testy systemowe czy akceptacyjne. Aby maksymalizować efektywność testów integracyjnych, zaleca się ich automatyzację, co pozwala na częste i powtarzalne ich wykonanie, a także zapewnia szybką informację zwrotną o stanie systemu po wprowadzeniu zmian w kodzie. Implementacja ciągłej integracji (CI) i ciągłego wdrażania (CD) może znacznie usprawnić ten proces, zapewniając, że wszystkie komponenty systemu są regularnie testowane i gotowe do produkcji.

1.2.3 Testy Systemowe (System Testing)

Testy systemowe to proces weryfikacji kompletnego i zintegrowanego systemu informatycznego w celu zapewnienia, że spełnia on wszystkie zdefiniowane wymagania. Są one przeprowadzane w środowisku symulującym rzeczywistą eksploatację, co obejmuje nie tylko oprogramowanie, ale również sprzęt komputerowy oraz interakcje z użytkownikami i innymi systemami. Cel testów systemowych jest wielowymiarowy – nie tylko sprawdzają poprawność funkcjonalną i niefunkcjonalną systemu, ale również identyfikują błędy, które nie zostały wykryte na wcześniejszych etapach testów.

Scenariusze Testowe: Przykładowe scenariusze dla systemu rezerwacji biletów mogą wyglądać następująco:

Przypadek testowy 1: Rezerwacja biletu przez użytkownika.

Wejście: Użytkownik wprowadza datę, wybiera lot i dokonuje płatności.

Oczekiwane wyjście: System rejestruje rezerwację, przetwarza płatność i wysyła potwierdzenie.

Przypadek testowy 2: Anulowanie rezerwacji i zwrot kosztów.

Wejście: Użytkownik anuluje bilet co najmniej 24 godziny przed lotem.

Oczekiwane wyjście: System anuluje rezerwację i inicjuje proces zwrotu kosztów.

Narzędzia:

LoadRunner lub JMeter: Narzędzia do testowania wydajności i obciążenia, które pomagają w ocenie, jak system zachowuje się pod dużym obciążeniem.

Selenium WebDriver: Automatyzuje testy funkcjonalne interfejsu użytkownika w różnych przeglądarkach i systemach operacyjnych.

QTP (QuickTest Professional): Narzędzie do zautomatyzowanych testów funkcjonalnych, które wspiera różne środowiska aplikacji.

Wyzwania i Najlepsze Praktyki:

Wyzwanie: Złożoność środowiska testowego i konieczność symulacji rzeczywistych warunków użytkowania, w tym integracji z zewnętrznymi systemami.

Najlepsza praktyka: Stworzenie dedykowanego środowiska testowego, które naśladuje produkcyjne warunki użytkowania, w tym dane, obciążenie oraz integracje zewnętrzne.

Metody:

Black Box Testing: Testowanie bez znajomości wewnętrznej struktury systemu.

Performance Testing: Ocena wydajności systemu pod dużym obciążeniem.

Przykłady:

Sprawdzenie działania aplikacji e-commerce podczas symulacji ruchu użytkowników.

Testy bezpieczeństwa systemu bankowości internetowej.

Przykłady Sukcesów i Niepowodzeń:

Sukces: System ERP przeszedł kompleksowe testy systemowe, co pozwoliło na wychwycenie i naprawienie błędów związanych z przetwarzaniem danych, zanim system został wdrożony w organizacji.

Niepowodzenie: Niewystarczające testy systemowe aplikacji mobilnej doprowadziły do niewykrycia błędu w module geolokalizacji, co wpłynęło na negatywne doświadczenia użytkowników i konieczność szybkiego wydania poprawki.

Testy systemowe są niezbędne do potwierdzenia, że złożony system jako całość działa zgodnie z oczekiwaniami i jest gotowy do wdrożenia. Powinny obejmować różne aspekty systemu, takie jak funkcjonalność, bezpieczeństwo, wydajność, skalowalność i interoperacyjność. Ważnym aspektem jest również zapewnienie, że testy systemowe są powtarzalne i możliwe do zautomatyzowania, co pozwala na ich regularne wykonywanie i szybką reakcję na wykryte defekty. Umożliwia to również realizację ciągłego cyklu zwrotnego (feedback loop) między zespołem deweloperskim a zespołem testowym, co jest kluczowe dla iteracyjnego procesu poprawy jakości oprogramowania.

1.2.4 Testy Akceptacyjne (Acceptance Testing)

Definicja i Cel: Testy akceptacyjne są finalnym etapem procesu testowania oprogramowania, gdzie system jest oceniany z perspektywy użytkownika końcowego lub zgodności z biznesowymi wymaganiami. Celem testów akceptacyjnych jest potwierdzenie, czy system jest gotowy do wdrożenia i czy spełnia wszystkie ustalone kryteria akceptacji, które mogą być związane z funkcjonalnością, użytecznością, wydajnością i niezawodnością. Testy te są często przeprowadzane w środowisku produkcyjnym lub bardzo zbliżonym do produkcyjnego, aby zapewnić możliwie najbardziej autentyczne warunki użytkowania.

Scenariusze Testowe: Dla aplikacji mobilnej służącej do zamawiania jedzenia, scenariusze mogą obejmować:

Przypadek testowy 1:

Proces zamówienia od wyboru restauracji do finalizacji płatności.

Wejście: Użytkownik przegląda menu, dodaje wybrane pozycje do koszyka i dokonuje płatności.

Oczekiwane wyjście: Zamówienie jest poprawnie złożone i płatność jest autoryzowana.

Przypadek testowy 2:

Reakcja aplikacji na utratę połączenia z Internetem w trakcie składania zamówienia.

Wejście: Utrata połączenia z siecią w trakcie finalizacji zamówienia.

Oczekiwane wyjście: Aplikacja informuje użytkownika o błędzie i zapisuje zamówienie do późniejszego przesłania.

Narzędzia:

Cucumber lub SpecFlow: Narzędzia wspierające Behavior-Driven Development (BDD), pozwalające na definiowanie testów w języku naturalnym.

HP Quality Center: Zintegrowane środowisko do zarządzania testami, które wspomaga planowanie, śledzenie i raportowanie testów akceptacyjnych.

UserTesting lub BetaTesting: Platformy do przeprowadzania testów akceptacyjnych z rzeczywistymi użytkownikami, oferujące cenne wglądy w doświadczenia i opinie użytkowników.

Wyzwania i Najlepsze Praktyki:

Wyzwanie: Trudność w zdefiniowaniu wszystkich kryteriów akceptacji, które będą odzwierciedlać różnorodne oczekiwania i wymagania użytkowników.

Najlepsza praktyka: Ścisła współpraca z interesariuszami projektu oraz użytkownikami końcowymi w celu ustalenia kryteriów akceptacji oraz przeprowadzania iteracyjnych sesji testowych.

Przykłady Sukcesów i Niepowodzeń:

Sukces: Poprzez zastosowanie User Acceptance Testing (UAT), firma zdołała dopracować interfejs użytkownika aplikacji mobilnej, co znacząco zwiększyło jej przyjęcie na rynku.

Niepowodzenie: Brak odpowiednich testów akceptacyjnych dla systemu rezerwacji biletów lotniczych doprowadził do pominięcia krytycznych błędów w interfejsie użytkownika, co skutkowało złą prasą i koniecznością drogich poprawek po wdrożeniu.

Testy akceptacyjne są niezwykle ważne, ponieważ stanowią ostateczną weryfikację gotowości systemu do użytku. Ich zignorowanie może prowadzić do wprowadzenia na rynek produktu, który nie spełnia oczekiwań klientów, co może skutkować stratami finansowymi i reputacyjnymi. Współpraca z użytkownikami końcowymi i uwzględnienie ich opinii jest kluczowe dla sukcesu testów akceptacyjnych. Dobrze jest również włączyć do testów osoby niezwiązane z procesem tworzenia oprogramowania, ponieważ ich świeże spojrzenie może ujawnić problemy, które specjaliści mogli przeoczyć.

Metody:

Alpha/Beta Testing: Testy przeprowadzane przez wewnętrznych (Alpha) lub zewnętrznych (Beta) użytkowników.

Contract Acceptance Testing: Sprawdzenie zgodności systemu z warunkami umowy.

Przykłady:

Ocenianie przez rzeczywistych użytkowników wygody korzystania z nowej aplikacji mobilnej.

Walidacja spełnienia wymagań regulacyjnych przez system informatyczny szpitala.

1.3. Rodzaje testów

Testowanie oprogramowania to nie tylko proces sprawdzania poprawności działania kodu; to skomplikowana dyscyplina, która wymaga głębokiego zrozumienia różnorodnych aspektów aplikacji, od jej funkcji po odporność na potencjalne zagrożenia. W tym rozdziale zanurzymy się w świat testów oprogramowania, aby odkryć różnorodność i złożoność metod oceny jakości systemów informatycznych. Przedstawimy cztery główne kategorie testów, które są niezbędne do kompleksowej oceny i zapewnienia, że finalny produkt spełnia zarówno oczekiwania użytkowników, jak i rygorystyczne wymagania biznesowe.

Testy Funkcjonalne koncentrują się na tym, co system ma robić - sprawdzając, czy spełnia zdefiniowane funkcje i wymagania biznesowe. Obejmują one bezpośrednie interakcje z systemem i jego modułami, weryfikując, czy wyniki działania są zgodne z oczekiwaniami.

Testy Niefunkcjonalne to przeciwieństwo testów funkcjonalnych; nie badają bezpośrednio funkcji systemu, lecz jak system te funkcje wykonuje. Testy te oceniają wydajność, niezawodność, skalowalność i inne kluczowe atrybuty jakości.

Testy Regresji są przeprowadzane, aby upewnić się, że nowe zmiany w kodzie nie wpłynęły negatywnie na już istniejące funkcje systemu. Są niezwykle ważne w szybko rozwijających się i często aktualizowanych systemach.

Testy Bezpieczeństwa badają system pod kątem potencjalnych słabości i luk, które mogą być wykorzystane do nieautoryzowanego dostępu lub ataków. W dzisiejszym cyfrowym świecie, gdzie dane są nowym złotem, testy te są niezbędne dla każdej aplikacji i systemu informatycznego.

Przez każdą z tych kategorii przewija się jedna wspólna myśl przewodnia: jakość. W tym rozdziale zgłębimy, jak każdy z tych rodzajów testów przyczynia się do budowania i utrzymania wysokiej jakości produktów, jakie narzędzia wspierają proces testowania, oraz jakie są najlepsze praktyki i największe wyzwania związane z każdym typem testów.

1.3.1 Testy Funkcjonalne

Testy funkcjonalne to kategoria testowania oprogramowania skoncentrowana na weryfikacji funkcji systemu informatycznego w kontekście zdefiniowanych wymagań. Obejmują one sprawdzanie określonych akcji i reakcji aplikacji, aby upewnić się, że wykonuje ona zadania zgodnie z oczekiwaniami użytkowników i specyfikacją biznesową.

Cechy charakterystyczne testów funkcjonalnych:

Zgodność z Wymaganiami: Sprawdzają, czy system działa zgodnie z dokumentacją wymagań, zarówno tych stawianych przez klienta, jak i wewnętrznych dla systemu.

Interfejs Użytkownika: Testują interakcje użytkownika z aplikacją, w tym przepływ pracy, nawigację, wprowadzanie danych i obsługę błędów.

Przepływy Biznesowe: Ocena przepływów procesów biznesowych realizowanych przez oprogramowanie, sprawdzenie logiki biznesowej i zasad decyzyjnych.

Integracja z Innymi Systemami: Weryfikacja, jak system komunikuje się z innymi aplikacjami i usługami, z którymi jest zintegrowany.

Dane i Bazy Danych: Testowanie operacji na danych, w tym ich tworzenia, odczytu, aktualizacji i usuwania, oraz interakcji z bazami danych.

Funkcje Bezpieczeństwa: Sprawdzenie mechanizmów uwierzytelniania, autoryzacji, szyfrowania i zarządzania dostępem w ramach funkcjonalności systemu.

Obsługa Wyjątków: Ocena sposobu, w jaki system radzi sobie z nieoczekiwanymi lub błędnymi wejściami oraz innymi wyjątkowymi warunkami.

Ograniczenia i Walidacje: Testy funkcjonalne obejmują również sprawdzenie ograniczeń systemowych, takich jak walidacja danych wejściowych i zachowanie przy przekroczeniu zakładanych limitów.

Zalety przeprowadzania testów funkcjonalnych:

Zapewnienie jakości: Są one kluczowe dla potwierdzenia jakości oprogramowania przed wdrożeniem.

Zredukowanie ryzyka: Pomagają w identyfikacji i naprawie błędów przed ich wystąpieniem w środowisku produkcyjnym.

Zwiększenie zaufania użytkowników: Dzięki potwierdzeniu, że aplikacja działa poprawnie, zwiększa się satysfakcję i zaufanie użytkowników.

Ochrona inwestycji: Zapobiegają kosztownym naprawom i zmianom po wdrożeniu systemu.

Metodologie i podejścia:

Black-box Testing: Testy funkcjonalne są często przeprowadzane jako testy "black-box", co oznacza, że testerzy nie muszą znać wewnętrznej struktury kodu.

Behavior-Driven Development (BDD): Współczesne podejście, które promuje tworzenie testów funkcjonalnych opartych na zachowaniach użytkowników, opisanych w języku naturalnym.

Testy funkcjonalne mogą być przeprowadzane ręcznie lub zautomatyzowane przy użyciu specjalistycznych narzędzi i frameworków testowych. Automatyzacja testów funkcjonalnych jest szczególnie efektywna w przypadku dużych systemów, gdzie ręczne testowanie wszystkich funkcji byłoby czasochłonne i podatne na błędy. Narzędzia automatyzacji pozwalają na szybkie przeprowadzenie testów, zapewniające powtarzalność i dokładność.

1.3.2 Testy Niefunkcjonalne

Testy niefunkcjonalne to krytyczny aspekt zapewniania jakości oprogramowania, skupiający się na aspektach systemu, które nie są bezpośrednio związane z konkretnymi funkcjami lub procesami biznesowymi, lecz z ogólnymi atrybutami jakości, takimi jak wydajność, bezpieczeństwo, skalowalność, czy też użyteczność. Są one istotne dla zapewnienia, że system jest nie tylko funkcjonalny, ale również wytrzymały, bezpieczny, i wydajny.

Cechy charakterystyczne testów niefunkcjonalnych:

Wydajność: Ocena, jak szybko system reaguje na określone zapytania.

Obciążenie: Sprawdzenie, jak system radzi sobie z dużą liczbą równoczesnych użytkowników lub transakcji.

Skalowalność: Weryfikacja zdolności systemu do rozwijania się wraz ze wzrostem wymagań.

Stabilność: Testowanie odporności systemu na błędy i awarie.

Zgodność: Sprawdzenie, czy system przestrzega określonych standardów i protokołów.

Bezpieczeństwo: Ocena systemu pod kątem potencjalnych słabości i luk w zabezpieczeniach.

Użyteczność: Weryfikacja, czy system jest łatwy w użyciu dla docelowych użytkowników.

Dostępność: Testy, które określają, jak łatwo system jest dostępny dla użytkowników z różnymi potrzebami, w tym dla osób niepełnosprawnych.

Zalety przeprowadzania testów niefunkcjonalnych:

Zwiększona satysfakcja użytkowników: poprzez zapewnienie, że system jest szybki, efektywny i łatwy w użyciu.

Ochrona przed ryzykiem: identyfikacja i naprawa potencjalnych słabości przed atakami lub awariami.

Zapewnienie ciągłości biznesowej: upewnienie się, że system pozostanie działający nawet podczas wysokiego obciążenia.

Zgodność z regulacjami: zapewnienie, że oprogramowanie spełnia wszystkie wymagane standardy i przepisy prawne.

Metodologie i podejścia:

Stress Testing: Sprawdzenie zachowania systemu w ekstremalnych warunkach, często poza normalnymi oczekiwaniami użytkowania.

Load Testing: Ocena wydajności systemu podczas oczekiwanych warunków operacyjnych.

Security Testing: Testowanie skoncentrowane na identyfikacji potencjalnych słabości systemu, które mogą zostać wykorzystane przez osoby trzecie.

Narzędzia i techniki:

Automatyzacja: Wykorzystanie specjalistycznych narzędzi, takich jak HP LoadRunner, JMeter, czy OWASP ZAP, do symulowania obciążenia lub ataków i monitorowania reakcji systemu.

Monitoring: Używanie narzędzi do monitorowania wydajności i bezpieczeństwa w czasie rzeczywistym w celu szybkiej reakcji na potencjalne problemy.

Wyzwania i Najlepsze Praktyki:

Wyzwanie: Symulacja rzeczywistego środowiska użytkownika oraz różnorodnych scenariuszy, które mogą mieć miejsce po wdrożeniu.

Najlepsza praktyka: Włączenie testów niefunkcjonalnych na wczesnym etapie cyklu życia oprogramowania, aby zapewnić wystarczający czas na poprawki i optymalizację.

Testy niefunkcjonalne wymagają często znacznych zasobów, zarówno pod względem sprzętu, jak i czasu potrzebnego na ich przygotowanie i przeprowadzenie. Jednakże ich wartość jest nieoceniona, gdyż brak odpowiedniej wydajności, bezpieczeństwa czy dostępności może skutkować dużymi stratami finansowymi i reputacyjnymi dla firmy. Zapewniają one także, że system jest przygotowany na rzeczywiste warunki, które napotka po wdrożeniu, co jest kluczowe dla sukcesu każdego produktu software'owego.

1.3.3 Testy Regresji

Testy regresji to metoda testowania oprogramowania, która skupia się na potwierdzeniu, że niedawno wprowadzone zmiany lub aktualizacje nie wpłynęły negatywnie na istniejącą funkcjonalność systemu. Celem testów regresji jest upewnienie się, że nowy kod nie zakłócił pracy poprzednio stabilnych funkcji, zapewniając ciągłość i niezawodność działania oprogramowania.

Główne aspekty testów regresji:

Zapobieganie Niespodziankom: Gwarantują, że zmiany, naprawy błędów, ulepszenia lub aktualizacje nie wprowadzają nowych błędów w już przetestowanych częściach systemu.

Powtarzalność: Mogą być wielokrotnie wykonywane na tych samych scenariuszach testowych, aby upewnić się, że zmiany w kodzie nie spowodowały nieprzewidzianych efektów.

Automatyzacja: Testy regresji są idealnym kandydatem do automatyzacji, ponieważ są przeprowadzane wielokrotnie i często wymagają powtarzania tych samych kroków testowych.

Oszczędność Czasu: Poprzez automatyzację testów regresji, zespoły deweloperskie mogą skupić się na tworzeniu nowych funkcji zamiast manualnego testowania istniejących.

Szeroki Zakres: Testy regresji obejmują nie tylko testy jednostkowe, ale również testy integracyjne i systemowe, w zależności od zakresu wprowadzonych zmian.

Zalety przeprowadzania testów regresji:

Stabilność Oprogramowania: Pomagają w utrzymaniu i poprawie stabilności oprogramowania w miarę jego rozwoju.

Zaufanie Klientów: Klienci mogą mieć większe zaufanie do produktu, wiedząc, że każda nowa wersja jest dokładnie testowana pod kątem regresji.

Redukcja Ryzyka: Zmniejszają ryzyko wprowadzenia nowych błędów, które mogłyby zostać niezauważone bez przeprowadzenia testów regresji.

Zgodność z Wymaganiami: Upewniają, że oprogramowanie nadal spełnia wymagania biznesowe i techniczne po wprowadzeniu zmian.

Narzędzia i techniki:

Narzędzia Automatyzacji Testów: Takie jak Selenium, QTP (QuickTest Professional), lub TestComplete, które pozwalają na szybkie i efektywne przeprowadzenie testów regresji.

Frameworki Testowe: Frameworki takie jak JUnit dla Javy czy NUnit dla .NET, które wspierają tworzenie i zarządzanie testami regresji.

Systemy CI/CD: Platformy ciągłej integracji i dostarczania, takie jak Jenkins czy Travis CI, które mogą automatycznie uruchamiać testy regresji po każdym commitcie.

Wyzwania i Najlepsze Praktyki:

Wyzwanie: Zarządzanie złożonością testów regresji i utrzymanie ich aktualności w miarę zmian w oprogramowaniu.

Najlepsza Praktyka: Regularna aktualizacja i przegląd zestawów testów regresji, aby upewnić się, że nadal są one relewantne dla aktualnego stanu aplikacji.

Testy regresji są nieodłącznym elementem cyklu wydawniczego oprogramowania, szczególnie w metodykach Agile i DevOps, gdzie częste iteracje i szybkie wprowadzanie zmian są normą. Zapewniają one, że wprowadzane ulepszenia nie tylko dodają wartość, ale również nie pogarszają istniejącej funkcjonalności, co jest kluczowe dla utrzymania wysokiej jakości i niezawodności produktu.

Narzędzia:

TestComplete: Zautomatyzowane narzędzie do testowania regresji.

Ranorex: Platforma testowa wspierająca różne technologie.

1.3.4 Testy Bezpieczeństwa

Testy bezpieczeństwa, znane również jako testy penetracyjne lub audyty bezpieczeństwa, to proces oceny oprogramowania pod kątem potencjalnych słabości, luk i zagrożeń, które mogą być wykorzystane do nieautoryzowanego dostępu lub wykonania niepożądanych działań przez użytkowników lub złośliwe oprogramowanie. Te testy są kluczowe dla ochrony poufnych danych, zapewnienia integralności i dostępności systemów oraz utrzymania zaufania użytkowników.

Kluczowe aspekty testów bezpieczeństwa:

Identyfikacja Słabości: Wyszukiwanie i raportowanie słabości w zabezpieczeniach, które mogą obejmować zarówno problemy w kodzie, jak i konfiguracji systemu.

Ocena Ryzyka: Określanie potencjalnego wpływu znalezionych słabości na ogólną postawę bezpieczeństwa organizacji.

Eksploracja Luki: Próba wykorzystania znalezionych słabości, aby zrozumieć możliwe ścieżki ataku i ich skutki.

Testowanie Zgodności: Sprawdzanie, czy system spełnia standardy bezpieczeństwa i regulacje prawne, takie jak GDPR, HIPAA czy PCI-DSS.

Analiza Bezpieczeństwa Aplikacji: Testowanie aplikacji pod kątem słabości bezpieczeństwa na różnych poziomach, od frontendu po backend i bazy danych.

Testowanie Odporności na Ataki: Symulacja różnych scenariuszy ataku, w tym wstrzykiwanie SQL, Cross-Site Scripting (XSS), Cross-Site Request Forgery (CSRF), i inne.

Zalety przeprowadzania testów bezpieczeństwa:

Ochrona przed Naruszeniami: Pomagają w zapobieganiu naruszeniom danych, które mogą prowadzić do znacznych strat finansowych i reputacyjnych.

Zapewnienie Ciągłości Biznesowej: Chronią krytyczne systemy przed awariami i przestojami spowodowanymi atakami.

Zwiększenie Zaufania Klientów: Poprzez demonstrację zaangażowania w ochronę danych i systemów.

Zminimalizowanie Ryzyka Prawnego: Pomagają w zapobieganiu naruszeniom przepisów prawa, co może prowadzić do sankcji i grzywien.

Metodologie i podejścia:

White-box Testing: Testowanie z wiedzą o wewnętrznej strukturze i kodzie systemu, co pozwala na dogłębną analizę bezpieczeństwa.

Black-box Testing: Testowanie bez znajomości wewnętrznej struktury systemu, symulujące działania potencjalnego atakującego.

Narzędzia i techniki:

OWASP ZAP: Narzędzie do automatycznego testowania aplikacji webowych w poszukiwaniu słabości.

Metasploit: Zaawansowana platforma do testowania penetracyjnego, pozwalająca na symulację ataków i ocenę odporności systemu.

Burp Suite: Zestaw narzędzi do testowania bezpieczeństwa aplikacji internetowych.

Wyzwania i Najlepsze Praktyki:

Wyzwanie: Utrzymanie bieżącej wiedzy na temat nowych wektorów ataku i metod penetracji.

Najlepsza Praktyka: Regularne przeprowadzanie testów bezpieczeństwa, włączając w to zarówno automatyczne skanowanie, jak i ręczne testy penetracyjne.

Testy bezpieczeństwa są nieodłącznym elementem cyklu rozwoju oprogramowania, zwłaszcza w obliczu rosnącej liczby zagrożeń i stale zmieniającego się krajobrazu bezpieczeństwa cybernetycznego. Są one integralną częścią zarządzania ryzykiem i powinny być przeprowadzane regularnie, aby zapewnić, że systemy są zabezpieczone przed znanymi słabościami i gotowe na nowe wyzwania.

1.4. Cykl życia testów

Cykl życia testów to sekwencja działań i procesów w testowaniu oprogramowania, które zaczynają się od planowania i kończą na wykonaniu testów i ich ewentualnej ponownej realizacji. Ten podrozdział wyjaśnia etapy cyklu życia testów, ich znaczenie i wpływ na sukces projektu oprogramowania.

1.4.1 Planowanie Testów (Test Planning)

Pierwszym krokiem w cyklu życia testowania jest planowanie, które ustala zakres i cele testów, określa zasoby i narzędzia, a także harmonogramy. Planowanie testów jest strategiczną fazą, podczas której zespół testowy identyfikuje obszary aplikacji wymagające szczególnej uwagi i decyduje o najlepszych metodach testowania. Ta sekcja obejmuje kilka istotnych aspektów, które są niezbędne do skutecznego planowania testów.

Na początku procesu planowania, zespół testowy musi zdefiniować zakres testów. Jest to kluczowy element, który określa, jakie funkcje, moduły lub aspekty systemu będą poddane testom. Definicja zakresu testów opiera się na analizie wymagań systemu, specyfikacji technicznej oraz oczekiwaniach użytkowników. Ta część procesu wymaga dogłębnego zrozumienia aplikacji i jej kontekstu biznesowego. Zakres testów powinien odzwierciedlać zarówno krytyczne obszary funkcjonalności, jak i te elementy, które mogą być bardziej narażone na błędy lub które mają szczególne znaczenie dla użytkowników końcowych. Przy definiowaniu zakresu testów, zespół powinien również uwzględniać ograniczenia czasowe i zasobowe, aby upewnić się, że testy będą skuteczne i wykonalne w ramach dostępnych zasobów.

Następnym krokiem jest wybór odpowiednich metodologii i standardów testowych. Ten aspekt planowania testów obejmuje decyzje dotyczące podejścia do testowania, takiego jak testy manualne czy automatyczne, a także wybór konkretnych technik testowania, na przykład testowania czarno-skrzynkowego, biało-skrzynkowego czy testowania opartego na ryzyku. Wybór metodologii i standardów testowych powinien opierać się na charakterystyce projektu, technologii wykorzystywanej w aplikacji oraz celach testów. Ważne jest, aby podejście testowe było spójne z ogólną strategią projektu i zapewniało pokrycie testowe w kluczowych obszarach funkcjonalności systemu.

Alokacja zasobów i narzędzi testowych to kolejny ważny element planowania testów. Obejmuje to przypisanie odpowiednich osób do zespołu testowego, zapewnienie niezbędnych narzędzi i infrastruktury oraz określenie potrzeb szkoleniowych. Alokacja zasobów powinna uwzględniać zarówno umiejętności techniczne i doświadczenie zespołu testowego, jak i wymagania specyficzne dla testowanej aplikacji. Narzędzia testowe, takie jak oprogramowanie do automatyzacji testów, narzędzia do śledzenia błędów czy narzędzia do zarządzania testami, muszą być dopasowane do potrzeb projektu i wspierać zespół w osiągnięciu celów testowych.

Ostatnim elementem planu testów jest szacowanie czasu i kosztów. Jest to kluczowy etap, który pozwala na ocenę, czy planowane testy są realistyczne z punktu widzenia dostępnych zasobów i terminów. Szacowanie czasu i kosztów powinno uwzględniać wszystkie aspekty procesu testowego, od przygotowania, poprzez wykonanie testów, aż po analizę wyników i raportowanie. W tym kontekście, ważne jest, aby plan testów był elastyczny i mógł być dostosowany do ewentualnych zmian w zakresie projektu.

Składniki Planu Testów:

Definicja zakresu testów.

Wybór metodologii i standardów testowych.

Alokacja zasobów i narzędzi testowych.

Szacowanie czasu i kosztów.

1.4.2 Projektowanie Testów (Test Design)

Projektowanie testów to etap, w którym zespół testowy opracowuje szczegółowe przypadki testowe, scenariusze i procedury. Zadaniem jest przekształcenie wymagań i specyfikacji w konkretny, mierzalny zestaw testów. Efektywne projektowanie testów jest kluczowe dla sukcesu całego procesu testowania, ponieważ właściwie opracowane przypadki testowe i scenariusze pozwalają na dokładne sprawdzenie, czy oprogramowanie spełnia określone wymagania.

Projektowanie testów rozpoczyna się od opracowania przypadków testowych. Przypadki testowe są podstawowymi elementami testowania, które opisują, jakie działania zostaną wykonane, aby sprawdzić poszczególne funkcje lub aspekty systemu. Dobre przypadki testowe powinny być jasne, precyzyjne i skoncentrowane na konkretnych aspektach funkcjonalności lub wydajności systemu. Podczas opracowywania przypadków testowych, zespół testowy powinien szczegółowo przeanalizować specyfikacje i wymagania, aby upewnić się, że wszystkie kluczowe scenariusze użytkowania są adekwatnie pokryte. Opracowanie przypadków testowych wymaga także uwzględnienia różnych ścieżek wykonania, warunków granicznych oraz potencjalnych scenariuszy błędów. Przypadki te stanowią podstawę dla późniejszych działań testowych i są niezbędne do oceny jakości i niezawodności oprogramowania.

Kolejnym ważnym elementem w procesie projektowania testów jest definiowanie kryteriów wejścia i wyjścia. Kryteria te określają, kiedy testy powinny być rozpoczęte (wejście) i kiedy mogą być uznane za zakończone (wyjście). Kryteria wejścia mogą obejmować dostępność pełnej specyfikacji, zakończenie określonego etapu rozwoju oprogramowania lub dostępność niezbędnych zasobów. Z kolei kryteria wyjścia definiują warunki, które muszą być spełnione, aby testy były uznane za zakończone, na przykład osiągnięcie określonego poziomu pokrycia testowego, brak krytycznych błędów lub zgodność z określonymi wymaganiami jakości. Definiowanie tych kryteriów jest ważne dla zapewnienia, że proces testowania jest skuteczny i skoncentrowany na osiągnięciu określonych celów.

Tworzenie zestawów danych testowych to kolejny kluczowy element projektowania testów. Dane testowe są niezbędne do wykonania przypadków testowych i mogą być różnorodne, w zależności od rodzaju testów i testowanej aplikacji. Zestawy danych testowych powinny być reprezentatywne dla różnych scenariuszy użytkowania systemu, w tym typowych przypadków użycia, warunków brzegowych oraz nietypowych lub ekstremalnych scenariuszy. Tworzenie efektywnych zestawów danych testowych wymaga zrozumienia, jak użytkownicy będą korzystać z systemu, a także identyfikacji różnych danych wejściowych, które mogą wpłynąć na działanie oprogramowania. Dane te mogą obejmować różne formaty danych, zakresy wartości oraz kombinacje danych wejściowych. Dobrze zaprojektowane zestawy danych testowych są kluczowe dla zapewnienia, że testy będą wiarygodne i kompleksowe.

Proces Projektowania:

Opracowanie przypadków testowych.

Definiowanie kryteriów wejścia i wyjścia.

Tworzenie zestawów danych testowych.

1.4.3 Konfiguracja Środowiska Testowego (Test Environment Setup)

Konfiguracja środowiska testowego to przygotowanie środowiska, w którym będą przeprowadzone testy. Środowisko to musi odwzorować warunki produkcyjne tak dokładnie, jak to możliwe, aby wyniki testów były wiarygodne. Ta część procesu testowania wymaga starannego przygotowania i koordynacji, aby zapewnić, że wszystkie komponenty są prawidłowo skonfigurowane i gotowe do przeprowadzenia testów.

Proces konfiguracji środowiska testowego rozpoczyna się od instalacji i konfiguracji oprogramowania i sprzętu. Ta faza obejmuje ustawienie serwerów, stacji roboczych i innych urządzeń, które będą używane do przeprowadzania testów. Obejmuje to również instalację systemów operacyjnych, oprogramowania aplikacyjnego oraz narzędzi i frameworków testowych. W przypadku oprogramowania, ważne jest, aby upewnić się, że wersje i konfiguracje oprogramowania są zgodne z tymi, które będą używane w rzeczywistym środowisku użytkowania. Na przykład, jeśli aplikacja ma być uruchamiana na określonej wersji systemu operacyjnego lub przeglądarce internetowej, środowisko testowe powinno odzwierciedlać te warunki. Dodatkowo, sprzęt używany do testowania powinien być odpowiednio wydajny i konfigurowalny, aby mógł symulować różne scenariusze użytkowania.

Kolejnym ważnym zadaniem jest utworzenie bazy danych i konfiguracja sieci. Bazy danych są kluczowym elementem wielu systemów i aplikacji, dlatego ważne jest, aby środowisko testowe zawierało realistyczne dane testowe, które odzwierciedlają dane, z którymi system będzie pracować po wdrożeniu. Konfiguracja sieci jest również istotna, ponieważ pozwala na testowanie aplikacji w warunkach, które symulują rzeczywiste użycie, włączając w to różne prędkości połączenia, opóźnienia oraz potencjalne problemy związane z łącznością. W tym kontekście, konfiguracja sieci powinna również uwzględniać bezpieczeństwo i możliwość testowania aplikacji w warunkach, które odzwierciedlają różnorodne zagrożenia i ataki, które mogą wystąpić w rzeczywistym środowisku.

Weryfikacja i walidacja środowiska testowego to ostatni etap procesu konfiguracji. Jest to etap, w którym zespół testowy sprawdza, czy wszystkie elementy środowiska testowego są prawidłowo skonfigurowane i działają zgodnie z oczekiwaniami. Ta faza obejmuje testowanie infrastruktury, oprogramowania, sieci oraz innych składowych, aby upewnić się, że środowisko jest stabilne i gotowe do rozpoczęcia testów. Weryfikacja i walidacja powinny być przeprowadzone w sposób systematyczny i dokładny, aby zminimalizować ryzyko wystąpienia problemów związanych ze środowiskiem, które mogłyby wpłynąć na wyniki testów. Ważne jest, aby w tym etapie zidentyfikować i rozwiązać wszelkie problemy związane ze sprzętem, oprogramowaniem lub konfiguracją, które mogą wpłynąć na przebieg i wyniki testów.

Zadania do Realizacji:

Instalacja i konfiguracja oprogramowania i sprzętu.

Utworzenie bazy danych i konfiguracja sieci.

Weryfikacja i walidacja środowiska testowego.

1.4.4 Wykonanie Testów (Test Execution)

Faza wykonania testów to praktyczna realizacja zaplanowanych scenariuszy testowych. Testerzy wykonują testy, dokumentują wyniki i rejestrują wszelkie odnalezione błędy. Jest to etap, w którym planowanie i przygotowania przechodzą w fazę aktywnego testowania, a zespół testowy angażuje się w realizację skonstruowanych przypadków testowych, śledzenie i dokumentowanie wyników oraz raportowanie wszelkich błędów i problemów.

Realizacja przypadków testowych zgodnie z planem jest pierwszym i najważniejszym krokiem w wykonaniu testów. W tej fazie, zespół testowy przeprowadza zaplanowane testy, stosując się do opracowanych scenariuszy i procedur. Każdy przypadek testowy jest wykonywany zgodnie z jego specyfikacją, co obejmuje określone kroki, warunki początkowe i oczekiwane wyniki. Ważne jest, aby każdy przypadek testowy był przeprowadzany dokładnie i systematycznie, aby zapewnić, że wszystkie aspekty aplikacji są gruntownie przetestowane. Realizacja testów wymaga nie tylko technicznej wiedzy i umiejętności, ale także szczegółowej uwagi i koncentracji, aby upewnić się, że wszystkie scenariusze są właściwie oceniane i że wyniki testów są wiarygodne.

Śledzenie i dokumentowanie wyników to drugi kluczowy element wykonania testów. W trakcie testowania, zespół testowy musi dokładnie rejestrować wyniki każdego przeprowadzonego testu. Obejmuje to nie tylko informacje o tym, czy test przeszedł pomyślnie, ale także wszelkie obserwacje, które mogą być istotne, na przykład nieoczekiwane zachowania systemu czy problemy z wydajnością. Dokładne dokumentowanie wyników testów jest niezbędne, aby zespół projektowy mógł dokładnie zrozumieć, jak oprogramowanie funkcjonuje i jakie problemy mogą wymagać rozwiązania. Dokumentacja testów powinna być przeprowadzana w sposób zorganizowany i systematyczny, aby zapewnić, że wszystkie informacje są kompletnie i precyzyjnie zarejestrowane.

Raportowanie błędów i problemów to ostatni, ale nie mniej ważny aspekt wykonania testów. W trakcie testowania, zespół testowy może napotkać różne błędy, problemy i niezgodności, które mogą mieć wpływ na działanie oprogramowania. Każdy zidentyfikowany problem musi być dokładnie zarejestrowany i zgłoszony zespołowi deweloperskiemu. Raportowanie błędów powinno zawierać szczegółowe informacje, takie jak opis problemu, warunki, w których wystąpił, kroki potrzebne do jego odtworzenia oraz wszelkie inne informacje, które mogą pomóc w diagnozowaniu i rozwiązywaniu problemu. Efektywne raportowanie błędów jest kluczowe dla szybkiego i skutecznego rozwiązywania problemów, co jest niezbędne do poprawy jakości i niezawodności oprogramowania.

Elementy Wykonania Testów:

Realizacja przypadków testowych zgodnie z planem.

Śledzenie i dokumentowanie wyników.

Raportowanie błędów i problemów.

1.4.5 Monitorowanie i Kontrola (Test Monitoring and Control)

Etap monitorowania i kontroli polega na ciągłym monitorowaniu procesu testowania i wprowadzaniu niezbędnych zmian, aby zapewnić, że cele testów są osiągane efektywnie. Jest to jednocześnie krok, w którym zespół testowy nie tylko śledzi postępy w stosunku do planu testów, ale również zarządza zmianami, które mogą pojawić się w trakcie realizacji testów oraz dostosowuje plany i strategie w odpowiedzi na napotkane problemy.

Śledzenie postępów w stosunku do planu testów jest podstawowym działaniem w monitorowaniu i kontroli testów. Jest to proces ciągły, który zapewnia, że zespół testowy ma jasny obraz tego, gdzie aktualnie znajduje się w planie testowania i czy jest na dobrej drodze do osiągnięcia zakładanych celów. Śledzenie postępów obejmuje ocenę, jak wiele przypadków testowych zostało już wykonanych, jakie wyniki przyniosły te testy oraz czy zostały zidentyfikowane jakieś krytyczne błędy. Jest to także ważne dla zapewnienia, że testy są przeprowadzane zgodnie z ustalonym harmonogramem, a wszelkie opóźnienia lub problemy są szybko identyfikowane i rozwiązywane. W tym kontekście, ważne jest, aby zespół testowy regularnie aktualizował status testów i informował o postępach, aby wszyscy zainteresowani, w tym zarządzający projektem i deweloperzy, mieli aktualny obraz sytuacji.

Zarządzanie zmianami w przypadkach testowych i środowisku testowym to kolejne kluczowe działanie w procesie monitorowania i kontroli. W trakcie cyklu życia testów mogą pojawić się zmiany, które wymagają modyfikacji w planie testów, przypadkach testowych lub nawet w środowisku testowym. Zmiany te mogą wynikać z różnych przyczyn, takich jak zmiany w wymaganiach, odkrycie nowych błędów wymagających dodatkowych testów, lub konieczność dostosowania środowiska testowego do nowych warunków. Zarządzanie tymi zmianami wymaga szybkiego reagowania i elastyczności ze strony zespołu testowego, aby upewnić się, że plany testów są aktualne i nadal skuteczne. W tym kontekście, ważne jest, aby wszystkie zmiany były dokładnie dokumentowane, a ich wpływ na proces testowy był analizowany i komunikowany zespołowi projektowemu.

Dostosowywanie planów i strategii testowych w odpowiedzi na napotkane problemy jest niezbędne dla zapewnienia skuteczności procesu testowania. Niezależnie od tego, jak dobrze zaplanowane są testy, zawsze istnieje możliwość napotkania nieoczekiwanych problemów, które mogą wpłynąć na przebieg testów. Problemy te mogą obejmować techniczne trudności, nieoczekiwane zachowania systemu, lub konieczność przeprowadzenia dodatkowych testów. W takich sytuacjach, zespół testowy musi być gotowy do szybkiego dostosowania planów testów, zmiany strategii testowych lub nawet modyfikacji kryteriów sukcesu. Dostosowanie planów może obejmować reorganizację kolejności wykonywania testów, zmianę priorytetów testów, lub wprowadzenie nowych przypadków testowych. Ważne jest, aby wszelkie zmiany w planach i strategiach były dokładnie analizowane pod kątem ich potencjalnego wpływu na wyniki testów oraz komunikowane wszystkim zainteresowanym stroną.

Kluczowe Działania:

Śledzenie postępów w stosunku do planu testów.

Zarządzanie zmianami w przypadkach testowych i środowisku.

Ajustowanie planów i strategii w odpowiedzi na napotkane problemy.

1.4.6 Zakończenie Testów (Test Closure)

Zakończenie Testów to ostatni etap, w którym zespół testowy ocenia całość wykonanych prac, analizuje wyniki i przygotowuje raporty podsumowujące działania testowe. Ta faza jest niezbędna do oceny efektywności testów, dokumentowania wniosków i rekomendacji, a także zbierania i archiwizowania wszystkich artefaktów testowych. Jest to moment, w którym zespół testowy podsumowuje pracę, ocenia wyniki i przygotowuje dokumentację końcową, która jest kluczowa dla zrozumienia efektów testów i dalszego rozwoju projektu.

Ocena, czy wszystkie kryteria testowe zostały spełnione, jest pierwszym krokiem w procesie zakończenia testów. Zespół testowy dokonuje przeglądu celów i wymagań testowych, które zostały zdefiniowane na początku procesu testowania, aby ocenić, czy zostały one w pełni osiągnięte. Ta ocena obejmuje analizę wyników wszystkich przeprowadzonych testów, w tym przypadków testowych, które przeszły pomyślnie, jak i tych, które wykazały błędy lub problemy. Zespół testowy dokonuje również oceny pokrycia testowego, aby upewnić się, że wszystkie kluczowe obszary systemu zostały przetestowane. Jest to ważne dla zapewnienia, że oprogramowanie spełnia wymagane standardy jakości i jest gotowe do wdrożenia lub dalszego rozwoju.

Dokumentowanie wniosków i rekomendacji to kolejny istotny element zakończenia testów. Zespół testowy przygotowuje szczegółowy raport, który zawiera podsumowanie wyników testów, w tym kluczowe odkrycia, błędy i problemy, które zostały zidentyfikowane. Raport ten może również zawierać rekomendacje dotyczące dalszych działań, takich jak poprawki błędów, optymalizacja systemu czy dalsze testy. Dokumentacja ta jest niezbędna dla zespołów deweloperskich, zarządzających projektem oraz innych interesariuszy, ponieważ dostarcza ważnych informacji o stanie oprogramowania i pomaga w podejmowaniu decyzji dotyczących dalszego rozwoju projektu.

Zbieranie i archiwizacja artefaktów testowych to ostatni etap zakończenia testów. W tym procesie zespół testowy gromadzi wszystkie dokumenty, przypadki testowe, dane testowe, logi, raporty z błędów oraz inne materiały, które zostały wygenerowane w trakcie testów. Zbieranie i archiwizowanie tych artefaktów jest kluczowe dla utrzymania ciągłości informacji, umożliwiając odniesienie do nich w przyszłości, na przykład podczas testów regresyjnych czy w kolejnych etapach rozwoju oprogramowania. Archiwizacja artefaktów testowych pomaga również w analizie trendów i wzorców, które mogą być wykorzystane do usprawnienia procesów testowych w przyszłości.

Czynności Końcowe:

Ocena, czy wszystkie kryteria testowe zostały spełnione.

Dokumentowanie wniosków i rekomendacji.

Zbieranie i archiwizacja artefaktów testowych.

1.5. Normy i standardy w testowaniu oprogramowania

Profesjonalne testowanie oprogramowania nie może obyć się bez odniesień do międzynarodowych norm i standardów, które określają dobre praktyki, terminologię, a także struktury dokumentacji i procesów testowych. Zapoznanie się z nimi jest kluczowe nie tylko dla testerów, ale również dla kierowników projektów i zespołów odpowiedzialnych za jakość oprogramowania.

| Standard/Norma | Zakres | Zastosowanie |

|---|---|---|

| ISO/IEC/IEEE 29119 | Kompletny proces testowania | Standaryzacja dokumentacji i procesów |

| ISTQB | Wiedza i certyfikacja testerów | Edukacja, rekrutacja |

| ISO/IEC 25010 | Model jakości oprogramowania | Testy niefunkcjonalne |

| OWASP | Bezpieczeństwo aplikacji | Testy bezpieczeństwa |

| ISO/IEC 12207 | Procesy cyklu życia oprogramowania | Ogólne zarządzanie jakością |

1.5.1 ISO/IEC/IEEE 29119 – Międzynarodowy standard testowania oprogramowania

Standard ISO/IEC/IEEE 29119 to najbardziej uznany i kompleksowy zbiór norm międzynarodowych dotyczących testowania oprogramowania. Został opracowany przez organizacje ISO (Międzynarodowa Organizacja Normalizacyjna), IEC (Międzynarodowa Komisja Elektrotechniczna) oraz IEEE (Instytut Inżynierów Elektryków i Elektroników). Ma zastosowanie zarówno w dużych organizacjach, jak i w mniejszych zespołach oraz w projektach prowadzonych zgodnie z podejściem klasycznym (np. kaskadowym), jak i zwinnie (Agile).

Standard składa się z pięciu części, z których każda koncentruje się na innym aspekcie procesu testowania.

ISO/IEC/IEEE 29119-1 – Pojęcia i definicje

Ta część definiuje wspólne słownictwo używane w procesie testowania. Standaryzacja terminologii ułatwia komunikację między zespołami, firmami i interesariuszami.

Przykładowe zdefiniowane pojęcia:

-

Test case (przypadek testowy) – zestaw wejść, warunków wykonania i oczekiwanych wyników.

-

Defect (błąd) – niezgodność pomiędzy faktycznym a oczekiwanym zachowaniem oprogramowania.

-

Test coverage (pokrycie testowe) – miara pokazująca zakres testowanych elementów systemu.

Dzięki tej części można uniknąć nieporozumień i niejednoznaczności przy opisywaniu i raportowaniu testów.

ISO/IEC/IEEE 29119-2 – Procesy testowaniaOkreśla standardowe procesy testowania, które mogą być stosowane w dowolnym cyklu życia oprogramowania. Proponuje strukturalne podejście, które można dostosować do różnych modeli SDLC (np. V-Model, Agile). Podstawowe procesy:

-

Test Planning – planowanie zakresu i harmonogramu testów.

-

Test Monitoring & Control – śledzenie postępu testowania i podejmowanie decyzji.

-

Test Design & Implementation – projektowanie przypadków testowych i przygotowanie środowiska testowego.

-

Test Execution – wykonywanie testów i rejestrowanie wyników.

-

Test Completion – przegląd rezultatów, raport końcowy, retrospektywa.

Wskazuje również role odpowiedzialne za poszczególne procesy i zasady ich dokumentowania.

ISO/IEC/IEEE 29119-3 – Dokumentacja testowaZawiera szczegółowe szablony i wymagania dla dokumentów testerskich. Umożliwia jednolite prowadzenie dokumentacji w różnych projektach i zespołach.

Typowe dokumenty:

-

Test Plan – plan testowania: zakres, strategia, harmonogram, zasoby, ryzyka.

-

Test Design Specification – opis projektowania testów.

-

Test Case Specification – szczegóły przypadków testowych (kroki, dane wejściowe, oczekiwane wyniki).

-

Test Execution Log – rejestr wykonanych testów.

-

Test Incident Report – zgłoszenia błędów i defektów.

-

Test Summary Report – raport podsumowujący cały proces testowania.

Dokumenty te ułatwiają audytowalność, zgodność z wymaganiami regulacyjnymi (np. RODO, FDA) i usprawniają zarządzanie wiedzą testerską.

ISO/IEC/IEEE 29119-4 – Techniki testoweOpisuje różne techniki testowania, które mogą być stosowane na różnych poziomach testów: jednostkowych, integracyjnych, systemowych i akceptacyjnych. Wyróżniane techniki to m.in.:

-

Podział na klasy równoważności (Equivalence Partitioning) – dzielenie danych wejściowych na grupy, które powinny być traktowane jednakowo.

-

Analiza wartości brzegowych (Boundary Value Analysis) – testowanie granicznych wartości danych wejściowych.

-

Tablica decyzyjna (Decision Table Testing) – testowanie logicznych kombinacji warunków.

-

Grafy przepływu sterowania (Control Flow Testing) – analiza przepływu sterowania w kodzie źródłowym.

-

State Transition Testing – testowanie zmian stanów systemu.

ISO/IEC/IEEE 29119-5 – Testowanie opartych na ryzyku

Koncentruje się na podejściu Risk-Based Testing (RBT), czyli testowaniu skoncentrowanym na ryzykach, które mogą najbardziej zaszkodzić systemowi lub firmie.

Główne kroki:

-

Identyfikacja ryzyk (np. przez analizę SWOT, oceny krytyczności funkcji).

-

Ocena ryzyka – analiza prawdopodobieństwa i wpływu potencjalnych błędów.

-

Priorytetyzacja testów – zasoby są kierowane na funkcje najbardziej podatne na awarie.

-

Monitorowanie i aktualizacja – zmieniające się ryzyka są ciągle oceniane.

RBT wspiera efektywne wykorzystanie czasu i zasobów testowych, minimalizując ryzyko wdrożenia wadliwego produktu.

1.5.2 ISTQB (International Software Testing Qualifications Board)

Choć nie jest normą ISO, ISTQB jest najpowszechniej stosowanym standardem wiedzy i certyfikacji w dziedzinie testowania.

Dostarcza słownika pojęć (glossary of terms), który standaryzuje terminologię w testowaniu.

Strukturyzuje wiedzę w ścieżkach certyfikacyjnych: Foundation Level, Advanced Level, Specialist i Expert.

Zawiera informacje na temat metod testowania, raportowania defektów, automatyzacji, testów niefunkcjonalnych i zarządzania testami.

Zastosowanie: Często wykorzystywany w rekrutacjach i szkoleniach w firmach IT; podstawowe odniesienie w materiałach edukacyjnych.

1.5.3 ISO/IEC 25010 – Model jakości oprogramowania

Norma ta definiuje model jakości oprogramowania, który wykorzystywany jest w testach niefunkcjonalnych.

Składa się z 8 głównych cech jakości:

Funkcjonalność

Wydajność

Kompatybilność

Użyteczność

Niezawodność

Bezpieczeństwo

Utrzymywalność

Przenaszalność

Zastosowanie: Pomaga w tworzeniu kryteriów testowych dla testów jakościowych, np. testów wydajnościowych lub bezpieczeństwa.

1.5.4 OWASP (Open Worldwide Application Security Project)

Organizacja non-profit tworząca standardy testów bezpieczeństwa:

OWASP Top 10 – lista najważniejszych zagrożeń bezpieczeństwa aplikacji webowych (np. XSS, SQL Injection).

OWASP Testing Guide – szczegółowy przewodnik po technikach testowania bezpieczeństwa.

Zastosowanie: Niezbędny punkt odniesienia przy projektowaniu testów bezpieczeństwa w aplikacjach webowych.

1.5.5 ISO/IEC 12207 – Procesy cyklu życia oprogramowania

Ta norma opisuje wszystkie procesy związane z tworzeniem i utrzymaniem oprogramowania – w tym testowanie jako jeden z procesów weryfikacji i walidacji.

Zastosowanie: Wspiera zarządzanie jakością w projektach informatycznych, zwłaszcza w sektorze publicznym lub podlegającym audytom.

2. Podstawy weryfikacji oprogramowania

Weryfikacja oprogramowania polega na ocenie jego zgodności z wymaganiami, regulacjami i standardami, aby upewnić się, że spełnia oczekiwania użytkowników i biznesu. Proces ten obejmuje analizę dokumentacji, kodu i modeli bez wykonywania programu, przy użyciu technik takich jak przeglądy kodu, analiza statyczna, czy formalne metody matematyczne. Jego celem jest wczesne wykrywanie błędów, poprawa jakości oraz minimalizacja ryzyka związanego z błędami, szczególnie w systemach krytycznych. Weryfikacja jest istotna dla zapewnienia niezawodności i bezpieczeństwa oprogramowania na każdym etapie jego rozwoju.

2.1. Definicja i cele

Weryfikacja oprogramowania to proces oceny systemu lub jego komponentów z zamiarem znalezienia, czy spełnia określone wymagania. Weryfikacja jest procesem używanym do sprawdzenia, czy produkt jest zgodny z regulacjami i specyfikacjami w każdym etapie procesu rozwoju oprogramowania. Jest to krytyczny krok w zapewnieniu jakości i jest zasadniczo skoncentrowany na 'sprawdzaniu poprawności' oprogramowania, co oznacza upewnienie się, że produkt spełnia zamiary biznesowe i użytkowników końcowych.

W kontekście weryfikacji, głównym celem jest przeprowadzenie dokładnej i systematycznej oceny oprogramowania, aby upewnić się, że procesy i produkty w trakcie cyklu życia oprogramowania są zgodne z zapisanymi procedurami i planami. Weryfikacja obejmuje szereg czynności, w tym przeglądy projektowe, walidację modeli i symulacje, a także inne formy analiz statycznych, które pomagają w identyfikacji błędów i niespójności na wczesnych etapach cyklu życia oprogramowania.

W odniesieniu do praktyk weryfikacji, proces ten może być realizowany za pomocą różnych technik i narzędzi. Weryfikacja statyczna, przeglądy kodu, przeglądy formalne i walkthroughs, a także modele formalne są częścią składową procesu weryfikacji. Te techniki pozwalają na ocenę kodu i dokumentacji bez wykonania programu. Chodzi tu o wykrywanie błędów, które mogłyby zostać przeoczone w trakcie tradycyjnego testowania.

Weryfikacja jest także powiązana z analizą i oceną ryzyka, gdzie potencjalne zagrożenia dla systemu są rozważane, a strategie są opracowywane w celu ich minimalizacji. Jest to szczególnie ważne w krytycznych dla bezpieczeństwa systemach, takich jak kontrole ruchu pociągów, systemy awioniki w samolotach, czy systemy zarządzania elektrowniami jądrowymi, gdzie błędy mogą mieć katastrofalne skutki. Programiści i inżynierowie muszą przestrzegać restrykcyjnych standardów jakości i niezawodności, aby zapewnić, że oprogramowanie jest bezpieczne i skuteczne w działaniu

Zatem weryfikacja oprogramowania jest kluczowym elementem procesu testowania, który pomaga zapewnić, że systemy są niezawodne, bezpieczne i odpowiadają na potrzeby użytkowników oraz spełniają wymagania biznesowe. Jest to działanie ciągłe, które wymaga zaangażowania i umiejętności specjalistów, aby skutecznie ocenić i poprawić jakość oprogramowania w każdym etapie jego rozwoju.

Walidacja oprogramowania

Drugim pojęciem często mylonym z weryfikacją jest walidacja. Te dwa terminy często są używane zamiennie, ale w rzeczywistości odnoszą się do dwóch różnych procesów w cyklu życia oprogramowania.

Weryfikacja oprogramowania, tak jak zostało to powiedziane wcześniej, jest procesem oceny systemu lub jego komponentów w celu określenia, czy produkty pracy z danej fazy rozwoju oprogramowania spełniają określone wcześniej warunki. Weryfikacja koncentruje się na analizie, inspekcji, przeglądzie, i testowaniu podczas procesu tworzenia oprogramowania, aby upewnić się, że przebiega zgodnie z planem i że produkt jest tworzony prawidłowo. Weryfikacja zadaje pytanie: "Czy budujemy produkt w prawidłowy sposób?"

Z drugiej strony, walidacja oprogramowania jest procesem oceny gotowego produktu w celu ustalenia, czy spełnia on wymagania biznesowe i potrzeby użytkowników. Walidacja to końcowe testowanie i inne metody, które pozwalają na stwierdzenie, że oprogramowanie jest gotowe do użycia. W tym kontekście zadaje się pytanie: "Czy zbudowaliśmy właściwy produkt?"

Główna różnica między weryfikacją a walidacją leży w ich celach i ich miejscu w cyklu życia oprogramowania. Weryfikacja odnosi się do technicznej poprawności tworzonego oprogramowania, podczas gdy walidacja odnosi się do spełnienia wymagań funkcjonalnych i użytkowych. Weryfikacja to proces wewnętrzny i często techniczny, walidacja natomiast jest bardziej zewnętrzna i biznesowa.

W przypadku testowania opartego na specyfikacji, które jest formą walidacji, nie analizuje się kodu źródłowego ani wewnętrznej struktury oprogramowania, ale skupia się na tym, czy oprogramowanie spełnia zdefiniowane wymagania i specyfikacje. Testy są tworzone na podstawie dokumentacji wymagań i scenariuszy użycia, koncentrują się na interfejsach i reakcjach systemu, i są niezależne od użytej technologii czy architektury systemu. Staranne planowanie, opracowanie przypadków testowych, monitorowanie wyników i uwzględnienie różnych warunków brzegowych są kluczowe dla sukcesu testowania opartego na specyfikacji.

Weryfikacja oprogramowania pełni kluczową rolę w zapewnieniu bezpieczeństwa i niezawodności systemów krytycznych dla bezpieczeństwa, takich jak te używane w transporcie kolejowym, lotnictwie czy elektrowniach jądrowych. W tych dziedzinach, gdzie nawet najmniejsze błędy mogą prowadzić do katastroficznych skutków, programiści muszą przestrzegać surowych regulacji i standardów jakości. Dzięki weryfikacji, która obejmuje analizę ryzyka, projektowanie odpornościowe, przeglądy kodu, testowanie i inne procesy, można zminimalizować ryzyko awarii oprogramowania i zapewnić, że systemy działają zgodnie z oczekiwaniami i wymaganiami bezpieczeństwa.

Zatem, zarówno weryfikacja i walidacja są kluczowymi elementami zapewnienia jakości oprogramowania, ale każda służy innemu celowi i odnosi się do innych aspektów produktu. Weryfikacja zapewnia, że produkt jest tworzony prawidłowo, walidacja zaś, że tworzymy właściwy produkt, spełniający potrzeby użytkowników końcowych i wymagania biznesowe.

Cele weryfikacji oprogramowania