Podręcznik

| Strona: | SEZAM - System Edukacyjnych Zasobów Akademickich i Multimedialnych |

| Kurs: | 2. Warstwa fizyczna i Nośniki transmisyjne |

| Książka: | Podręcznik |

| Wydrukowane przez użytkownika: | Gość |

| Data: | czwartek, 15 stycznia 2026, 16:11 |

Opis

Warstwa łącza danych to druga warstwa modelu OSI, odpowiedzialna za niezawodne przesyłanie ramek danych między bezpośrednio połączonymi urządzeniami sieciowymi. Jej główną rolą jest organizacja surowych bitów warstwy fizycznej w logiczne jednostki – ramki – oraz zapewnienie ich poprawnej transmisji przez medium komunikacyjne. Warstwa ta realizuje funkcje takie jak adresowanie fizyczne (MAC), wykrywanie i korekcję błędów, kontrolę przepływu oraz zarządzanie dostępem do wspólnego medium transmisyjnego. W tym celu stosuje różne protokoły dostępu do medium, takie jak CSMA/CD w Ethernet czy HDLC i LCP w PPP. Technologie takie jak Ethernet, PPP i Frame Relay są przykładami różnych sposobów implementacji tej warstwy, przystosowanych do pracy w sieciach lokalnych, punkt-punkt oraz rozległych. Poprawne działanie warstwy łącza danych ma kluczowe znaczenie dla efektywnej pracy całego stosu protokołów sieciowych i minimalizacji strat w transmisji.

1. Warstwa Fizyczna i Nośniki Transmisyjne

Warstwa fizyczna, będąca najniższą warstwą w modelu OSI, jest podstawą każdej sieci komputerowej. Odpowiada za przesyłanie surowych bitów danych przez fizyczne medium transmisyjne, niezależnie od ich treści i struktury.

1.1. Medium transmisyjne: przewodowe i bezprzewodowe

Sieciowe media transmisyjne dzielimy na przewodowe oraz bezprzewodowe. Przewodowe media transmisyjne obejmują kable miedziane (np. skrętka, kale koaksjalne) i światłowody, stosowane do bezpośredniego fizycznego połączenia urządzeń sieciowych, oferujące stabilność i wysoką przepustowość. Drugą grupę stanowią bezprzewodowe media transmisyjne. Wykorzystują one fale radiowe, mikrofale lub podczerwień do przesyłania danych bez fizycznego połączenia, idealne dla mobilności i elastyczności, lecz z potencjalnymi ograniczeniami zasięgu i zakłóceniami.

Przewodowe Media Transmisyjne

Medium transmisyjne przewodowe to wszelkie fizyczne kanały, przez które przesyłane są sygnały elektryczne, świetlne lub elektromagnetyczne. Najczęściej stosowanymi rodzajami są kable miedziane (takie jak skrętka, kabel koaksjalny) czy przewody światłowodowe.

Kable Miedziane: Są one podstawą tradycyjnych sieci LAN, oferując stosunkowo niski koszt i łatwość instalacji. Kable miedziane, takie jak skrętka UTP (Unshielded Twisted Pair) lub STP (Shielded Twisted Pair), są używane do transmisji danych poprzez sygnały elektryczne. Są one jednak podatne na zakłócenia elektromagnetyczne (EMI) i mają ograniczony zasięg.

Światłowody: Wykorzystują transmisję światła do przesyłania danych, co pozwala na osiągnięcie znacznie wyższych prędkości i większych dystansów niż w przypadku kabli miedzianych. Światłowody są odporne na EMI i oferują bardzo wysoką przepustowość, co czyni je idealnymi do zastosowań wymagających dużego transferu danych, takich jak połączenia międzycentrowe, backbones sieciowe czy transmisje długodystansowe.

Technologie Transmisyjne w Medium Przewodowym: Do technologii wykorzystujących medium przewodowe należą Ethernet (dla kabli miedzianych) i różne standardy światłowodowe. Ethernet jest standardem w przewodowych sieciach LAN, obsługującym różne prędkości – od 10 Mbps do 10 Gbps i więcej. Technologie światłowodowe, takie jak FDDI (Fiber Distributed Data Interface), oferują jeszcze wyższe prędkości, sięgające nawet 100 Gbps.

Zastosowania i Ograniczenia: Kable miedziane są powszechnie stosowane w środowiskach biurowych i domowych, podczas gdy światłowody znajdują zastosowanie w sieciach backbone, centrach danych i do połączeń długodystansowych. Głównym ograniczeniem kabli miedzianych jest ich podatność na EMI i ograniczony zasięg bez pogorszenia sygnału.

Bezprzewodowe Medium Transmisyjne

Definicja i Rodzaje: Medium transmisyjne bezprzewodowe to metody przesyłania danych bez bezpośredniego fizycznego połączenia, wykorzystujące fale radiowe, mikrofale lub podczerwień. Do najczęściej stosowanych technologii należą WiFi, Bluetooth, sieci komórkowe (3G, 4G, 5G) i satelitarne.

WiFi i Sieci LAN: WiFi (IEEE 802.11) jest standardem w bezprzewodowych sieciach LAN, umożliwiającym bezprzewodowy dostęp do Internetu i zasobów sieciowych. Charakteryzuje się łatwością instalacji i elastycznością, ale jest podatny na zakłócenia i ma ograniczony zasięg.

Technologie Komórkowe: Sieci komórkowe, takie jak 4G i 5G, oferują szerokopasmowy dostęp do Internetu z przenośnych urządzeń. Technologia 5G, będąca najnowszą generacją, przynosi znaczne usprawnienia w prędkości transmisji danych, redukcji opóźnień i obsłudze większej ilości urządzeń.

Satelitarne i Inne Technologie Bezprzewodowe: Komunikacja satelitarna zapewnia globalny zasięg i jest kluczowa w obszarach, gdzie inne formy łączności są niedostępne. Bluetooth i NFC (Near Field Communication) to przykłady technologii krótkiego zasięgu, stosowane w urządzeniach mobilnych i do komunikacji typu "urządzenie do urządzenia".

Zastosowania i Ograniczenia: Sieci bezprzewodowe są idealne do zastosowań mobilnych i tam, gdzie instalacja kabli jest trudna lub niemożliwa. Ich głównymi ograniczeniami są mniejsza przepustowość w porównaniu do medium przewodowego, większa podatność na zakłócenia oraz kwestie bezpieczeństwa.

1.2. Charakterystyka warstwy fizycznej

Warstwa fizyczna, będąca najniższą warstwą w modelu OSI, jest podstawą każdej sieci komputerowej. Odpowiada za przesyłanie surowych bitów danych przez fizyczne medium transmisyjne, niezależnie od ich treści i struktury. Ta warstwa definiuje specyfikacje elektryczne, mechaniczne, procedury i funkcje niezbędne do aktywowania, utrzymywania i dezaktywowania fizycznych połączeń. Jest niezbędna do realizacji podstawowych funkcji sieci, takich jak inicjalizacja połączeń, synchronizacja transmisji oraz regulacja przepływu danych.

Elementy Warstwy Fizycznej

Urządzenia i Sprzęt Sieciowy: Do urządzeń warstwy fizycznej należą kable, światłowody, złącza, repeatery, huby, karty sieciowe (NICs), modemy oraz inne urządzenia transmisyjne. Każde z tych urządzeń ma specyficzne wymagania dotyczące sygnałów, napięć, konnektorów i protokołów fizycznych.

Sygnały i Kodowanie: Warstwa fizyczna zajmuje się przekształcaniem bitów danych na sygnały elektryczne, świetlne lub radiowe. Proces ten nazywany jest kodowaniem sygnału. W zależności od medium i technologii, kodowanie może obejmować różne formy modulacji sygnału, takie jak modulacja amplitudy, częstotliwości lub fazy.

Prędkość Transmisji i Synchronizacja: Warstwa fizyczna definiuje również prędkość transmisji danych, mierzoną w bitach na sekundę (bps). Prędkość ta może być różna w zależności od medium i technologii. Ważnym aspektem jest synchronizacja transmisji, która zapewnia, że nadawca i odbiorca są zsynchronizowani czasowo, co umożliwia poprawne odczytanie sygnału.

Specyfikacje i Standardy

Elektryczne i Mechaniczne Specyfikacje: Warstwa fizyczna określa charakterystyki napięcia, poziomy sygnałów, schematy połączeń i typy złączy. Na przykład, w przypadku Ethernetu wykorzystującego kable miedziane, standardy określają właściwości elektryczne takich połączeń.

Topologie Sieciowe: Warstwa fizyczna jest również odpowiedzialna za topologie sieci, czyli układ fizycznych połączeń w sieci. Przykłady topologii to topologia gwiazdy, pierścienia, szyny czy siatki, każda z własnymi zaletami i ograniczeniami w kontekście wydajności i niezawodności.

1.3. Technologie transmisyjne: Ethernet, Fibre Optics

Ethernet

Wprowadzenie do Ethernetu

Historia i Rozwój: Ethernet, rozwinięty w latach 70. przez firmę Xerox PARC, stał się standardową technologią sieci LAN. Jego ewolucja od prostych systemów o prędkości 10 Mbps do zaawansowanych konfiguracji 10 Gbps i więcej, świadczy o elastyczności i skalowalności tej technologii.

Zasada Działania: Ethernet wykorzystuje model CSMA/CD (Carrier Sense Multiple Access with Collision Detection) do zarządzania dostępem do medium transmisyjnego. Jest to metoda, która pozwala wielu urządzeniom na współdzielenie tego samego medium transmisyjnego (np. kabla miedzianego), przy minimalnym ryzyku kolizji danych.

Standardy i Konfiguracje Ethernetu

Kable i Złącza: Ethernet może operować na różnych typach kabli, w tym skrętce miedzianej (kategoria 5e, 6, 6a) oraz światłowodach, z złączami typu RJ45 (dla kabli miedzianych) i różnymi złączami światłowodowymi.

Prędkości Transmisji: Ethernet ewoluował od standardowych 10 Mbps (10BASE-T) do 100 Mbps (100BASE-TX), 1 Gbps (1000BASE-T), a nawet 10 Gbps (10GBASE-T) i wyższych prędkościach w nowoczesnych konfiguracjach.

Protokoły i Ramki: Ethernet używa własnych formatów ramek do przesyłania danych, które zawierają adresy MAC, umożliwiając komunikację na poziomie warstwy łącza danych modelu OSI.

Zastosowania i Ograniczenia

Wszechstronność: Ethernet jest używany w różnorodnych środowiskach, od małych domowych sieci do dużych przedsiębiorstw i centrów danych.

Ograniczenia: Obejmują ograniczenia dystansu dla kabli miedzianych oraz potencjalne zakłócenia elektromagnetyczne.

Światłowody

Podstawy Technologii Światłowodowej

Mechanizm Działania: Światłowody przesyłają dane za pomocą impulsów świetlnych, co umożliwia transmisję z bardzo wysoką prędkością i na długie dystanse bez znacznego tłumienia.

Typy Światłowodów: Istnieją dwa główne typy: światłowody jednomodowe (dla bardzo długich dystansów) i wielomodowe (dla krótszych dystansów).

Zalety i Zastosowania Światłowodów

Wysoka Przepustowość i Niezawodność: Światłowody oferują znacznie wyższe prędkości transmisji w porównaniu z tradycyjnymi kablami miedzianymi, sięgając nawet terabitów na sekundę, przy minimalnym tłumieniu i zakłóceniach.

Długodystansowe Transmisje i Połączenia Sieciowe: Idealne do zastosowania w backbone'ach sieciowych, centrach danych, a także do połączeń międzykontynentalnych i w miejskich sieciach światłowodowych.

Technologie i Standardy Światłowodowe

Standardy i Protokoły: Obejmują różne standardy światłowodowe, takie jak FDDI, a także nowsze technologie jak DWDM (Dense Wavelength Division Multiplexing), które pozwalają na przesyłanie wielu sygnałów świetlnych jednocześnie w jednym włóknie.

Rozwój i Innowacje: Stale rosnące wymagania dotyczące przepustowości sieci i szybkości transmisji danych napędzają rozwój nowych technologii światłowodowych.

ISDN (Integrated Services Digital Network)

Podstawy ISDN:

ISDN to system telekomunikacyjny zapewniający jednoczesny transfer danych cyfrowych i usług głosowych. Został wprowadzony w latach 80. XX wieku jako ulepszenie analogowych linii telefonicznych.

Pozwala na transmisję cyfrową przez tradycyjne miedziane linie telefoniczne, oferując lepszą jakość i szybkość niż tradycyjne połączenia analogowe.

Zastosowanie i Działanie:

ISDN znajduje zastosowanie w małych i średnich przedsiębiorstwach do szybkiego dostępu do Internetu oraz usług głosowych.

Zawiera dwa rodzaje kanałów: B (Bearer) dla danych i D (Data) dla sygnałowania i kontroli. Standardowe konfiguracje to BRI (Basic Rate Interface) i PRI (Primary Rate Interface).

T1 (oraz E1 w Europie)

Podstawy Technologii T1:

T1 to format transmisji danych wykorzystujący dedykowane linie, charakterystyczny dla Ameryki Północnej. E1 jest jego odpowiednikiem w Europie.

Oferuje stałą przepustowość 1.544 Mbps (T1) lub 2.048 Mbps (E1), podzieloną na 24 (T1) lub 32 (E1) kanały.

Zastosowanie T1/E1:

T1 i E1 są często wykorzystywane w środowiskach korporacyjnych i przez dostawców usług telekomunikacyjnych do zapewnienia stabilnych połączeń głosowych i danych.

Są idealne do zastosowań, które wymagają gwarantowanej przepustowości i niskiego opóźnienia.

DSL (Digital Subscriber Line)

Wprowadzenie do DSL:

DSL to rodzina technologii wykorzystujących istniejące linie telefoniczne do dostarczania szybkiego dostępu do Internetu.

Charakteryzuje się asymetryczną (ADSL) i symetryczną (SDSL) przepustowością, gdzie ADSL jest bardziej powszechna w użytku domowym.

Działanie i Zastosowanie:

DSL wykorzystuje wyższe częstotliwości niż tradycyjne linie telefoniczne, umożliwiając jednoczesną transmisję danych i rozmów telefonicznych.

Jest popularnym rozwiązaniem w domach i małych firmach ze względu na stosunkowo niski koszt i dobre prędkości transmisji.

ADSL (Asymmetric Digital Subscriber Line)

Charakterystyka ADSL:

ADSL to najczęściej stosowana odmiana DSL, oferująca wyższe prędkości pobierania danych niż wysyłania. Idealna do zastosowań domowych, gdzie pobieranie danych (np. przeglądanie internetu, streaming wideo) jest częstsze niż wysyłanie.

ADSL dzieli pasmo częstotliwości linii telefonicznej na trzy kanały: jeden dla danych, jeden dla głosu i jeden jako bufor.

Zastosowanie ADSL:

ADSL jest powszechnie stosowana w domach ze względu na prostotę instalacji (wykorzystuje istniejące linie telefoniczne) i dobrą przepustowość w stosunku do kosztów.

Wymaga zastosowania specjalnych modemów ADSL, które są w stanie oddzielić sygnały danych od rozmów telefonicznych.

Ethernet i światłowody stanowią dwa główne filary technologii transmisyjnych w medium przewodowym. Ethernet, z jego prostotą, niezawodnością i elastycznością, pozostaje standardem w sieciach LAN, podczas gdy światłowody oferują rozwiązania do zastosowań wymagających wysokiej przepustowości i długodystansowych połączeń. Rozwój tych technologii jest nieustanny, z nowymi innowacjami i ulepszeniami, które pojawiają się regularnie, aby sprostać rosnącym wymaganiom sieci komputerowych.

Na drugim końcu stoją znacznie wolniejsze technologie ISDN, DSL, ADSL. Te technologie transmisyjne w medium przewodowym, choć niektóre z nich mogą wydawać się przestarzałe, nadal odgrywają kluczową rolę w infrastrukturze telekomunikacyjnej na całym świecie. Oferują one stabilne i niezawodne połączenia, będąc odpowiednimi rozwiązaniami dla specyficznych potrzeb i aplikacji.

1.4. Standardy i protokoły fizyczne

Standardy i protokoły fizyczne mają duże znaczenie w projektowaniu i funkcjonowaniu sieci komputerowych. Definiują one sposób, w jaki urządzenia sieciowe komunikują się za pośrednictwem różnych mediów transmisyjnych. W tej części omówione zostaną najważniejsze standardy i protokoły dla różnych mediów transmisyjnych, w tym dla Ethernetu, światłowodów, ISDN, T1, DSL, ADSL oraz technologii bezprzewodowych.

Standardy i Protokoły dla Ethernetu

IEEE 802.3

Protokół IEEE 802.3, powszechnie znany jako Ethernet, jest jednym z najbardziej rozpowszechnionych standardów w sieciach lokalnych (LAN). Został opracowany przez Institute of Electrical and Electronics Engineers (IEEE) i stanowi podstawę dla większości przewodowych sieci LAN na całym świecie. Jego głównym celem jest określenie sposobu, w jaki urządzenia sieciowe mogą bezpiecznie i skutecznie komunikować się za pośrednictwem wspólnego medium transmisyjnego, takiego jak kable miedziane lub światłowody.

Ethernet używa metody dostępu do medium transmisyjnego znanej jako CSMA/CD (Carrier Sense Multiple Access with Collision Detection). Ten mechanizm pozwala wielu urządzeniom na współdzielenie tego samego medium fizycznego, jednocześnie minimalizując ryzyko kolizji danych. W systemie tym każde urządzenie "nasłuchuje" medium przed przesłaniem danych, aby upewnić się, że żaden inny sygnał nie jest obecnie przesyłany. Jeśli medium jest zajęte, urządzenie oczekuje na wolną chwilę. W przypadku wykrycia kolizji, czyli gdy dwa urządzenia próbują jednocześnie przesłać dane, oba z nich zatrzymują transmisję i próbują ponownie po losowym odstępie czasu.

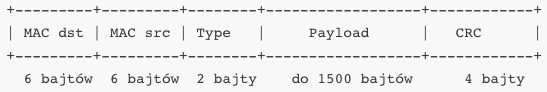

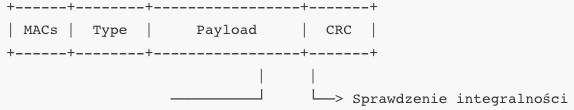

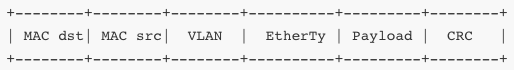

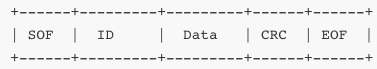

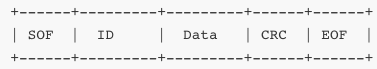

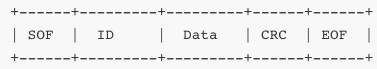

Ethernet definiuje również format ramki danych, który jest kluczowy dla przesyłania informacji. Każda ramka danych zawiera adresy MAC (Media Access Control) nadawcy i odbiorcy, co umożliwia urządzeniom identyfikowanie się nawzajem i kierowanie danych do odpowiednich miejsc. Ramka zawiera także pole danych, które transportuje właściwe informacje, oraz sekwencję sprawdzającą błędy, zwaną CRC (Cyclic Redundancy Check), która pomaga w wykrywaniu błędów w transmisji.

Przez lata standard IEEE 802.3 ewoluował, wprowadzając nowe warianty, aby sprostać rosnącym wymaganiom rynku w zakresie prędkości i niezawodności sieci. Pierwotne wersje Ethernetu działały z prędkościami 10 Mbps (10BASE-T), ale nowsze iteracje, takie jak Fast Ethernet (100BASE-TX), Gigabit Ethernet (1000BASE-T) i 10 Gigabit Ethernet (10GBASE-T), znacznie zwiększyły możliwości transmisji danych. Każdy z tych standardów zapewnia różne prędkości, metody modulacji sygnałów oraz typy kabli, dostosowane do różnych wymagań aplikacji i środowisk sieciowych.

Ethernet jest również dostosowany do różnych typów medium transmisyjnego. Choć pierwotnie wykorzystywał kable miedziane, takie jak skrętka, to późniejsze wersje wprowadziły możliwość korzystania ze światłowodów. Światłowody oferują znacznie wyższe prędkości i są odporne na zakłócenia elektromagnetyczne, co czyni je idealnymi dla połączeń długodystansowych i sieci o dużej przepustowości.

Kluczowym aspektem Ethernetu jest jego uniwersalność i skalowalność. Może być on stosowany w różnych konfiguracjach sieciowych, od prostych sieci domowych i małych biur, przez średnie i duże przedsiębiorstwa, aż po duże centra danych i infrastrukturę backbone sieci internetowej. Jego uniwersalność i powszechna kompatybilność sprawiają, że Ethernet jest często wybierany jako pierwszy wybór dla wielu aplikacji sieciowych.

W ramach standardu IEEE 802.3 określone są również specyfikacje dla kabli miedzianych (np. kategoria 5e, 6) oraz złącz, w tym popularnego RJ45. Reasumując, protokół IEEE 802.3 (Ethernet) odgrywa kluczową rolę w świecie sieci komputerowych, zapewniając elastyczne, niezawodne i skuteczne środowisko transmisji danych. Jego ewolucja i dostosowanie do zmieniających się potrzeb technologicznych potwierdzają jego trwałe miejsce jako fundamentu nowoczesnych sieci przewodowych.

W standardzie IEEE 802.3, znanym powszechnie jako Ethernet, wykorzystuje się różne typy kabli i złącz, które są dostosowane do określonych wymagań prędkości i jakości transmisji. Oto szczegółowy opis najczęściej stosowanych kabli i złącz w standardzie Ethernet:

Kable Miedziane:

Skrętka (Twisted Pair)

: Najpopularniejszym typem kabla w sieciach Ethernet są kable skrętkowe. Wyróżnia się dwie główne kategorie:

UTP (Unshielded Twisted Pair): Skrętka nieekranowana, często stosowana w środowiskach biurowych. Jest niedroga i łatwa w instalacji. Kable kategorii 5e, 6, 6a i wyższych są używane w zależności od wymaganej prędkości transmisji.

STP (Shielded Twisted Pair): Skrętka ekranowana, oferująca lepszą ochronę przed zakłóceniami elektromagnetycznymi. Jest bardziej kosztowna i stosowana w środowiskach, gdzie zakłócenia są szczególnym problemem.

Kabel Koaksjalny: Dawniej powszechnie używany w sieciach Ethernet, obecnie rzadziej spotykany. Składa się z centralnego przewodu miedzianego otoczonego izolatorem, ekranem i osłoną zewnętrzną.

Światłowody:

Są używane do transmisji danych na długie dystanse i w środowiskach, gdzie wymagana jest wysoka przepustowość i odporność na zakłócenia. Światłowody są zasadniczo wolne od zakłóceń elektromagnetycznych i oferują bardzo wysokie prędkości transmisji.

Złącza:

RJ45: Najczęściej stosowane złącze w sieciach Ethernet wykorzystujących kable skrętkowe. Jest to ośmiopinowe złącze, które umożliwia podłączenie kabli UTP lub STP do urządzeń sieciowych, takich jak komputery, przełączniki i routery.

Złącza Światłowodowe: W przypadku światłowodów stosuje się różne typy złącz, takie jak SC, LC, ST, które różnią się budową i sposobem montażu. Są one wybierane na podstawie typu włókna światłowodowego, wymaganej wydajności i specyfikacji sieci.

Inne Złącza:

W niektórych starszych wersjach Ethernetu, takich jak 10BASE2, używano złącz typu BNC do łączenia kabli koaksjalnych.

Standard IEEE 802.3 zdefiniował różnorodne opcje kabli i złącz, aby umożliwić efektywną transmisję danych w różnych środowiskach i aplikacjach, od prostych sieci domowych po zaawansowane instalacje w centrach danych i środowiskach przemysłowych. Wybór odpowiedniego kabla i złącza zależy od wielu czynników, w tym od wymaganej prędkości transmisji, dystansu, kosztów, a także środowiska, w którym sieć będzie działać.

Standardy i Protokoły dla ISDN, T1

ISDN Protokoły: ISDN wykorzystuje serię protokołów do cyfrowej transmisji danych i głosu. Obejmuje to protokoły warstwy łącza danych oraz warstwy fizycznej, które regulują formatowanie, synchronizację i błędy transmisji.

T1 i E1: Te standardy telekomunikacyjne określają formaty transmisji danych dla Ameryki Północnej (T1) i Europy (E1). Obejmują one szczegółowe specyfikacje dotyczące struktury ramki danych, schematów synchronizacji i interfejsów sprzętowych.

Standardy i Protokoły dla DSL, ADSL

ADSL Standards (ITU-T G.992.x): Szereg standardów ITU-T dla ADSL określa specyfikacje techniczne dla asymetrycznych połączeń DSL, w tym metody modulacji i szybkości transmisji.

DSLAM i Protokoły Dostępu: Urządzenia DSLAM (Digital Subscriber Line Access Multiplexer) używane w sieciach DSL korzystają z serii protokołów do zarządzania i kierowania ruchem danych od wielu użytkowników.

Standardy i Protokoły dla Technologii Bezprzewodowych

IEEE 802.11 (WiFi): Standardy IEEE 802.11 określają specyfikacje dla sieci bezprzewodowych WLAN, w tym protokoły dostępu do medium, formaty ramek danych oraz protokoły zabezpieczeń.

4G/5G Standards: Standardy dla sieci komórkowych 4G (np. LTE) i 5G określają techniki modulacji, struktury sieciowe, protokoły bezpieczeństwa i inne aspekty, które umożliwiają szybką i bezpieczną komunikację mobilną.

ITU-T G-Series: Standard ITU-T G. odnosi się do serii rekomendacji opracowanych przez Międzynarodową Unię Telekomunikacyjną (ITU), a konkretnie przez jej sektor standardyzacji telekomunikacyjnej (ITU-T). Seria ta skupia się na różnych aspektach systemów transmisyjnych, sieci, technologii światłowodowych i szerokopasmowych, oferując wytyczne dotyczące infrastruktury telekomunikacyjnej i transmisji danych.

Rekomendacje ITU-T G. obejmują szeroki zakres tematów, od fizycznych aspektów sieci, przez charakterystyki transmisji, aż po bardziej zaawansowane kwestie, takie jak zarządzanie siecią i jakość usług. Są one kluczowe dla rozwoju globalnych sieci telekomunikacyjnych, zapewniając standaryzację, która jest niezbędna do zapewnienia interoperacyjności i efektywności w różnych technologiach i systemach.

Centralnym punktem zainteresowania serii G. są technologie światłowodowe. Rekomendacje te koncentrują się na różnych aspektach światłowodów, takich jak ich właściwości transmisyjne, techniki modulacji, charakterystyki dyspersji i tłumienia. Przez lata seria G. wprowadziła szereg standardów dotyczących światłowodów jednomodowych i wielomodowych, które są stosowane w różnych zastosowaniach, od sieci lokalnych po długodystansowe połączenia światłowodowe.

Kolejnym istotnym obszarem, na który skupia się seria G., jest szerokopasmowy dostęp do Internetu. Rekomendacje te obejmują standardy dotyczące różnych technologii dostępu szerokopasmowego, w tym DSL (Digital Subscriber Line) i jej różnych odmian, takich jak ADSL (Asymmetric DSL) i VDSL (Very high-speed DSL). Te standardy odgrywają kluczową rolę w umożliwieniu szybkiego dostępu do Internetu dla gospodarstw domowych i przedsiębiorstw na całym świecie, oferując szczegółowe wytyczne dotyczące aspektów takich jak modulacja sygnału, zarządzanie pasmem czy minimalne wymagania usług.

Ponadto, seria G. obejmuje standardy i rekomendacje dotyczące zarządzania siecią i jakości usług (QoS). Te aspekty są kluczowe w zapewnieniu wysokiej wydajności i niezawodności sieci telekomunikacyjnych, zwłaszcza w kontekście rosnących wymagań dotyczących przepustowości i niskiego opóźnienia. Standardy te określają, jak sieci powinny zarządzać priorytetami ruchu, zapewniać równomierny dostęp do zasobów i utrzymywać wysoki poziom usług dla użytkowników końcowych.

Rekomendacje z serii ITU-T G. są stale aktualizowane, aby nadążać za szybkim rozwojem technologii telekomunikacyjnych. Obejmują one zarówno istniejące technologie, jak i te, które są obecnie w fazie rozwoju, takie jak nowe standardy dla sieci 5G, zaawansowane technologie światłowodowe i innowacje w dziedzinie transmisji szerokopasmowej.

2. Warstwa Łącza Danych

Warstwa łącza danych to druga warstwa modelu OSI, odpowiedzialna za niezawodne przesyłanie ramek danych między bezpośrednio połączonymi urządzeniami sieciowymi. Jej główną rolą jest organizacja surowych bitów warstwy fizycznej w logiczne jednostki – ramki – oraz zapewnienie ich poprawnej transmisji przez medium komunikacyjne. Warstwa ta realizuje funkcje takie jak adresowanie fizyczne (MAC), wykrywanie i korekcję błędów, kontrolę przepływu oraz zarządzanie dostępem do wspólnego medium transmisyjnego. W tym celu stosuje różne protokoły dostępu do medium, takie jak CSMA/CD w Ethernet czy HDLC i LCP w PPP. Technologie takie jak Ethernet, PPP i Frame Relay są przykładami różnych sposobów implementacji tej warstwy, przystosowanych do pracy w sieciach lokalnych, punkt-punkt oraz rozległych. Poprawne działanie warstwy łącza danych ma kluczowe znaczenie dla efektywnej pracy całego stosu protokołów sieciowych i minimalizacji strat w transmisji.

2.1. Rola i funkcje warstwy łącza danych

Warstwa łącza danych (Data Link Layer) jest drugą warstwą w modelu OSI i odgrywa kluczową rolę w zapewnianiu bezbłędnej transmisji ramek między urządzeniami w ramach jednego segmentu sieciowego. Jej zadaniem jest przyjęcie surowych danych z warstwy fizycznej i zorganizowanie ich w struktury logiczne (ramki), które mogą być bezpiecznie i skutecznie przesyłane i odbierane. Odpowiada ona także za adresowanie fizyczne, synchronizację, wykrywanie błędów i kontrolę dostępu do medium transmisyjnego.

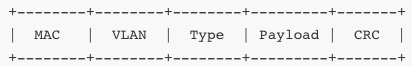

W typowej sieci Ethernet, warstwa ta jest odpowiedzialna za enkapsulację danych w ramki, czyli struktury zawierające nagłówki i dane użytkownika, które przesyłane są przez fizyczne łącze. Format ramki może się różnić w zależności od technologii (np. Ethernet, Wi-Fi, Frame Relay), jednak podstawowe założenia pozostają takie same: każda ramka zawiera adres źródłowy i docelowy, pole typu/rozmiaru, dane i pole kontrolne (np. CRC).

Adresowanie fizyczne odbywa się na poziomie warstwy łącza danych za pomocą 48-bitowych adresów MAC (Media Access Control), które są przypisywane każdemu interfejsowi sieciowemu w momencie produkcji przez producenta i zazwyczaj są unikalne na świecie. Adres MAC zapisany jest w postaci sześciu oktetów, na przykład: 00:1A:2B:3C:4D:5E. Pierwsze trzy oktety (tzw. OUI – Organizationally Unique Identifier) identyfikują producenta urządzenia, zaś pozostałe są nadawane przez producenta jako unikalny identyfikator.

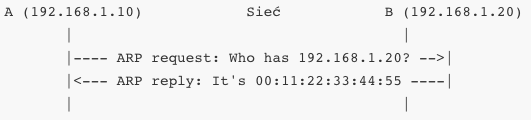

W praktyce komunikacja na poziomie warstwy łącza danych wygląda tak, że gdy komputer A chce przesłać dane do komputera B znajdującego się w tej samej sieci lokalnej (czyli w tym samym broadcast domain), musi znać jego adres MAC. Jeśli komputer A zna tylko adres IP komputera B, musi użyć protokołu ARP (Address Resolution Protocol), który zapyta: „kto ma ten adres IP?”. Komputer B odpowie, a jego adres MAC zostanie zapisany w pamięci podręcznej ARP komputera A.

Kiedy już adres MAC jest znany, komputer A tworzy ramkę Ethernet, w której wpisuje adres MAC komputera B jako adres docelowy, a swój jako źródłowy. Wewnątrz ramki umieszczony jest segment warstwy wyższej – zazwyczaj pakiet IP. Warstwa łącza danych nie „zna” semantyki danych, które przesyła – po prostu traktuje je jako ciąg bajtów do dostarczenia.

Każda ramka posiada także pole typu (lub długości, w zależności od wersji Ethernetu), które informuje, co znajduje się w polu danych – na przykład 0x0800 oznacza IPv4, 0x86DD oznacza IPv6, 0x0806 – ARP.

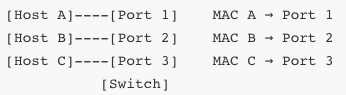

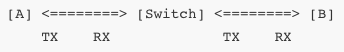

Ważnym aspektem działania warstwy łącza danych jest separacja kolizji i broadcast domain. W sieciach opartych o przełączniki (switches) każdy port jest osobnym segmentem kolizji – to warstwa łącza danych decyduje, do którego portu wysłać daną ramkę, bazując na docelowym adresie MAC.

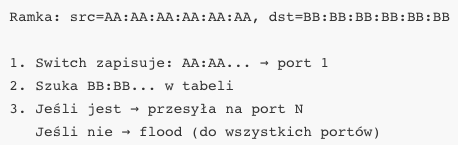

Switch buduje tablicę adresów MAC (MAC table) poprzez analizę adresów źródłowych nadchodzących ramek. Jeśli urządzenie wysyła ramkę z MAC AA:BB:CC:DD:EE:FF, switch zapamięta, że ten adres znajduje się na porcie np. 3. Jeśli później pojawi się ramka z adresem docelowym AA:BB:CC:DD:EE:FF, switch wie, że należy przesłać ją na port 3. Dzięki temu nie trzeba rozsyłać ramek do wszystkich portów.

W przypadku gdy adres docelowy nie jest jeszcze znany, switch dokonuje tzw. floodingu – wysyła ramkę do wszystkich portów z wyjątkiem portu, z którego przyszła. Jeśli adres MAC zostanie później odkryty, switch zapisze go w tablicy i w przyszłości będzie kierował ruch tylko do odpowiedniego portu. Ta cecha wyróżnia przełączniki warstwy łącza danych od koncentratorów (hubów), które przesyłają dane na wszystkie porty bez żadnej logiki.

Ramki mogą także być oznaczone jako broadcast – wówczas ich adres docelowy to FF:FF:FF:FF:FF:FF, co oznacza, że mają trafić do każdego hosta w sieci lokalnej. Typowe przykłady ramek broadcastowych to żądania ARP, DHCP Discover oraz niektóre protokoły sieciowe służące do autokonfiguracji lub detekcji topologii.

Warstwa łącza danych musi również radzić sobie z problemami pojawiającymi się w warstwie fizycznej – zakłóceniami, błędami transmisji, zakleszczeniami. Aby to osiągnąć, dodaje do każdej ramki specjalne pole CRC (Cyclic Redundancy Check), które umożliwia wykrycie uszkodzenia danych. Odbiornik oblicza CRC z zawartości ramki i porównuje ją z wartością dołączoną przez nadawcę. Jeśli wartości się różnią – ramka jest odrzucana.

Podczas transmisji przez warstwę łącza danych wykorzystywane są również specjalne ramki kontrolne: ramki z błędami, fragmenty ramek, ramki kontrolne w protokołach sterowania przepływem (np. w HDLC). W zależności od technologii, mogą też występować tzw. ramki z potwierdzeniami – np. w 802.11 (Wi-Fi) odbiornik potwierdza odebranie każdej ramki (ACK), co nie występuje w klasycznym Ethernet.

Z punktu widzenia modelu OSI, warstwa łącza danych współpracuje z warstwą sieciową (np. IP), ale też bezpośrednio z warstwą fizyczną. Jej zadaniem jest ułatwienie życia obu tym warstwom – dla IP zapewnia bezbłędne dostarczenie pakietów na tym samym łączu fizycznym, dla fizycznej – segmentację i interpretację ciągów bitów jako sensowne jednostki logiczne.

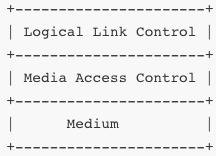

W niektórych przypadkach warstwa łącza danych dzieli się na dwie podwarstwy: MAC (Media Access Control) i LLC (Logical Link Control). Podwarstwa MAC odpowiada za fizyczny dostęp do medium, adresowanie, wykrywanie kolizji; podwarstwa LLC – za identyfikację protokołów warstwy sieciowej i opcjonalne zarządzanie sesją transmisji (w starszych systemach, np. IEEE 802.2).

Warstwa łącza danych odgrywa kluczową rolę w zapewnieniu integralności przesyłanych danych w środowiskach, gdzie występuje duże ryzyko błędów wynikających z zakłóceń elektromagnetycznych, kolizji, zaników sygnału lub niewłaściwego działania medium transmisyjnego. Ponieważ dane są przekazywane przez warstwę fizyczną jako ciągi impulsów elektrycznych, fal świetlnych lub sygnałów radiowych, pojawienie się błędów jest nieuniknione – zadaniem warstwy łącza danych jest wykrycie tych błędów i zapobieganie ich dalszemu propagowaniu.

Najważniejszym mechanizmem służącym do wykrywania błędów w transmisji jest kod CRC (Cyclic Redundancy Check). CRC opiera się na teorii arytmetyki binarnej i umożliwia detekcję bardzo dużej klasy błędów, w tym błędów pojedynczych, odwróconych bitów, uszkodzeń ciągłych i innych. Pole CRC jest obliczane przez nadawcę i dołączane do końca ramki – odbiorca wykonuje to samo działanie i porównuje wynik. Jeśli CRC się nie zgadza, ramka zostaje odrzucona.

W zależności od protokołu, możliwe są różne reakcje na wykrycie błędu. W klasycznym Ethernet, który działa w trybie bezpotwierdzeniowym (connectionless), uszkodzone ramki są po prostu odrzucane. Protokół nie oferuje mechanizmu retransmisji – zakłada, że warstwa wyższa (np. TCP) zajmie się wykryciem i ponownym przesłaniem utraconych danych. W innych protokołach, jak np. HDLC (High-Level Data Link Control), dostępny jest mechanizm potwierdzeń i retransmisji, co znacząco zwiększa niezawodność, ale kosztem wydajności i złożoności.

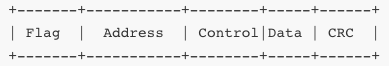

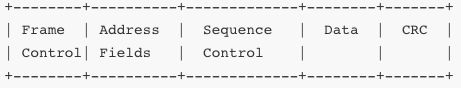

W protokołach typu HDLC ramki mogą mieć strukturę:

Flagą może być np. 01111110, która sygnalizuje początek i koniec ramki. Adres wskazuje na odbiorcę (np. w sieciach magistralowych), kontrola zawiera informacje o typie ramki (dane, potwierdzenie, negacja) oraz numerze sekwencyjnym. HDLC obsługuje tryby ramkowe, sekwencyjne, potokowe i wielodostępowe.

Niektóre implementacje protokołów warstwy łącza danych oferują mechanizmy detekcji duplikatów ramek i korekty błędów. Przykładem są protokoły używane w sieciach przemysłowych, np. Profinet RT lub EtherCAT, gdzie niezawodność ma kluczowe znaczenie. Te systemy bazują na ścisłej synchronizacji i potwierdzaniu danych w czasie rzeczywistym, z wykorzystaniem specjalnych ramek testujących i buforów sprzętowych.

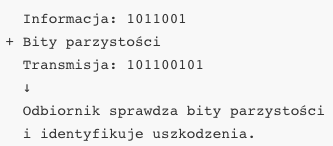

Oprócz CRC, historycznie wykorzystywano też prostsze mechanizmy kontroli – sumy kontrolne (np. w RS-232), parzystość bitową, a także tzw. kod Hamminga – pozwalający na korekcję pojedynczych błędów i detekcję wielobitowych. Te metody dziś występują głównie w sprzęcie niskopoziomowym, ale ich zasada działania ilustruje podstawy kodowania nadmiarowego.

Mechanizmy korekcji błędów (FEC – Forward Error Correction), takie jak Reed-Solomon, LDPC czy Turbo Codes, są bardziej typowe dla warstwy fizycznej lub stosowane w połączeniu z warstwą łącza danych w środowiskach wymagających wysokiej niezawodności, np. w Wi-Fi, LTE, satelitarnych transmisjach danych.

Ważnym elementem warstwy łącza danych jest także zarządzanie rozmiarami ramek i obsługa ich fragmentacji. Standardowy Ethernet obsługuje ramki o maksymalnej długości 1518 bajtów (tzw. MTU – Maximum Transmission Unit), z czego 1500 bajtów to dane, a pozostałe bajty zajmuje nagłówek i CRC. W przypadku gdy dane przekraczają tę wartość, warstwa wyższa (najczęściej IP) musi podzielić je na fragmenty.

Dla środowisk z dużymi wolumenami danych stosuje się tzw. Jumbo Frames – ramki Ethernet przekraczające 9000 bajtów. Pozwalają one zmniejszyć narzut związany z nagłówkami i zwiększyć efektywność transmisji, jednak wymagają, aby wszystkie urządzenia w sieci je obsługiwały – od kart sieciowych, przez przełączniki, po routery.

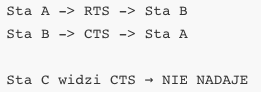

W niektórych technologiach, takich jak Wi-Fi, fragmentacja i retransmisje mogą występować wewnątrz warstwy łącza danych. Sieci bezprzewodowe są znacznie bardziej podatne na zakłócenia niż przewodowe – dlatego standard IEEE 802.11 definiuje własne mechanizmy: fragmentację ramek, potwierdzenia ACK, ramki RTS/CTS (Request to Send / Clear to Send) i retransmisje oparte o numery sekwencyjne.

W przypadku błędów, retransmisja może odbywać się na poziomie MAC, bez udziału warstw wyższych – jest to krytyczne w zapewnieniu jakości transmisji w czasie rzeczywistym.

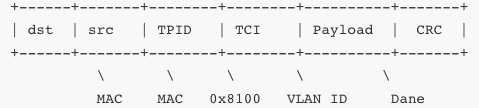

Innym istotnym zagadnieniem jest kompatybilność ramek pomiędzy różnymi standardami. W środowiskach złożonych, gdzie spotykają się np. Ethernet i Frame Relay, konieczna jest translacja formatów ramek. Wirtualizacja (np. w sieciach SDN czy maszynach wirtualnych) wprowadza dodatkowe nagłówki – np. 802.1Q (VLAN Tag), MPLS, GRE, co wymusza bardziej złożoną strukturę ramek.

Pole VLAN umożliwia logiczne rozdzielenie sieci w ramach jednej fizycznej infrastruktury – każde urządzenie może być przypisane do innego VLAN-u, a przełączniki przekazują tylko te ramki, które należą do odpowiedniego segmentu logicznego. Warstwa łącza danych rozpoznaje te oznaczenia i może używać ich do filtrowania, separacji ruchu, a także do dynamicznego przekierowywania pakietów między sieciami.

Jedną z fundamentalnych funkcji warstwy łącza danych jest zarządzanie dostępem do współdzielonego medium transmisyjnego. W środowiskach, gdzie wiele urządzeń korzysta z tego samego kanału transmisyjnego (np. przewodu koncentrycznego, medium radiowego czy światłowodu), niezbędne jest zastosowanie mechanizmów synchronizacji i wykrywania kolizji. Zasady te określa podwarstwa MAC (Media Access Control), która decyduje, kiedy urządzenie może nadawać i co się dzieje w przypadku jednoczesnych prób transmisji.

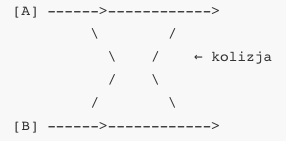

Klasycznym przykładem jest metoda CSMA/CD (Carrier Sense Multiple Access with Collision Detection), która była wykorzystywana w standardzie Ethernet 10BASE-T i 100BASE-TX działającym w trybie half-duplex. Jej zasada opiera się na tym, że urządzenie „nasłuchuje” medium, zanim rozpocznie transmisję – jeśli medium jest wolne (brak sygnału nośnego), urządzenie zaczyna nadawanie. Jednak, ponieważ sygnały nie rozchodzą się natychmiast, możliwe jest, że dwa urządzenia rozpoczną transmisję niemal jednocześnie. Gdy to się zdarzy, dochodzi do kolizji.

W przypadku kolizji urządzenia przerywają transmisję i wysyłają tzw. „jam signal”, informując inne stacje o problemie. Następnie każde z nich odczekuje losowy czas, tzw. backoff (zgodnie z algorytmem wykładniczym), i próbuje ponownie. Im więcej kolizji, tym dłuższy backoff – to ogranicza prawdopodobieństwo powtórnych kolizji. CSMA/CD działało skutecznie przy niewielkim ruchu, ale jego wydajność gwałtownie spadała w przeciążonych sieciach.

Wraz z popularyzacją przełączników (switches), Ethernet przeszedł na tryb full-duplex, eliminując całkowicie potrzebę stosowania CSMA/CD. W trybie full-duplex każde urządzenie może jednocześnie nadawać i odbierać dane, ponieważ transmisja odbywa się dwoma niezależnymi kanałami (np. oddzielne przewody w skrętce). Dzięki temu zniesiono ryzyko kolizji, co zwiększyło przepustowość i stabilność sieci.

Z kolei w sieciach bezprzewodowych nie da się wykrywać kolizji (brak możliwości nasłuchu podczas nadawania), więc zamiast CSMA/CD stosuje się CSMA/CA (Collision Avoidance). W tym przypadku urządzenie nasłuchuje kanału, a jeśli medium jest wolne, odczekuje jeszcze tzw. „random backoff” przed nadawaniem. Dodatkowo może wysłać ramkę RTS (Request to Send), a odbiornik odpowiada CTS (Clear to Send), co ma na celu poinformowanie innych urządzeń, że transmisja się rozpoczyna. Pozwala to uniknąć kolizji wynikających z tzw. „ukrytych stacji”.

W sieciach opartych o przełączniki warstwa łącza danych obsługuje również bufory i kolejkowanie ramek. Przełącznik, przyjmując ramki szybciej niż może je przesłać, buforuje je w pamięci. W sytuacjach przeciążenia (np. wielu hostów przesyła dane do jednego hosta), dochodzi do zjawiska tzw. bufferbloat – zbyt duże bufory wydłużają czas transmisji, powodując zwiększenie opóźnień i obniżenie wydajności.

Zarządzanie buforami obejmuje takie mechanizmy jak:

priorytetyzację ramek (np. VoIP traktowane jako high-priority)

eliminację ramek najstarszych (tail drop)

inteligentne usuwanie ramek (Random Early Detection – RED)

Przełączniki warstwy łącza danych analizują nagłówki MAC, ale nie interpretują adresów IP. Ich zadaniem jest szybkie przesyłanie ramek z portu źródłowego na port docelowy. Switch uczy się adresów MAC poprzez analizę ramek przychodzących – buduje dynamiczną tablicę (MAC address table), którą aktualizuje w czasie rzeczywistym.

Switch może również implementować tzw. port security – ograniczając liczbę możliwych adresów MAC na jednym porcie. Chroni to sieć przed atakami typu MAC flooding (przepełnienie tabeli MAC sztucznymi adresami, by zmusić przełącznik do przejścia w tryb „hub”).

W bardziej zaawansowanych zastosowaniach, np. w sieciach przemysłowych czy telekomunikacyjnych, wykorzystywane są technologie takie jak deterministyczne przesyłanie ramek (Time-Triggered Ethernet), zarządzanie opóźnieniami i QoS na poziomie MAC (np. IEEE 802.1p) oraz synchronizacja czasowa (IEEE 1588 – Precision Time Protocol).

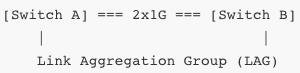

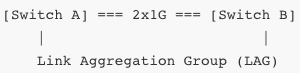

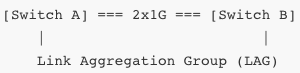

Warstwa łącza danych wspiera także agregację łączy – technika ta (np. LACP – Link Aggregation Control Protocol) pozwala na zestawienie wielu fizycznych połączeń między dwoma urządzeniami jako jedno logiczne połączenie. Wymaga to mechanizmu równoważenia obciążenia na poziomie ramek.

W sieciach korporacyjnych warstwa łącza danych obsługuje też VLAN-y. Przełącznik może tagować ramki dodatkowymi polami VLAN (802.1Q), przypisując je do konkretnych sieci logicznych. Każdy port może należeć do jednej lub wielu sieci VLAN, a komunikacja między nimi wymaga routera (lub switcha warstwy 3).

Systemy zarządzania ruchem w sieci (QoS) również mogą działać na poziomie warstwy łącza danych – ustawiając flagi priorytetu (np. DiffServ, PCP) lub kierując ruch do odpowiednich kolejek. Przełączniki mogą mieć wiele kolejek wyjściowych, z których każda obsługuje inny priorytet lub klasę usług.

W nowoczesnych przełącznikach dostępne są też funkcje takie jak storm control (zapobieganie zalewaniu sieci broadcastami), BPDU guard (ochrona przed atakami na protokół STP), oraz sieci oparte na redundancji (np. RSTP, MSTP).

W nowoczesnych środowiskach sieciowych warstwa łącza danych pełni funkcje znacznie bardziej zaawansowane niż tylko enkapsulacja ramek i detekcja kolizji. Z biegiem lat wprowadzono szereg rozszerzeń i standardów, które pozwalają na skalowanie, separację logiczną, agregację połączeń i zarządzanie ruchem na poziomie fizycznym oraz logicznym. Jednym z podstawowych mechanizmów rozdzielania ruchu w sieciach lokalnych są VLAN-y (Virtual LAN).

Standard IEEE 802.1Q umożliwia logiczne wydzielenie niezależnych segmentów sieci w obrębie jednej infrastruktury fizycznej. VLAN przypisuje do ramki dodatkowy tag zawierający identyfikator VLAN (12-bitowy VID) oraz pole PCP (Priority Code Point), które może służyć do oznaczania priorytetów (QoS).

TPID (Tag Protocol Identifier) ma wartość 0x8100 i oznacza, że w ramce znajduje się tag VLAN. TCI (Tag Control Information) zawiera 3 bity PCP, 1 bit CFI oraz 12-bitowy VID. Switch, który rozumie 802.1Q, może interpretować te oznaczenia i przypisać ramkę do odpowiedniego VLAN-u. Dzięki temu można zapewnić separację logiczną ruchu, co zwiększa bezpieczeństwo, elastyczność i skalowalność sieci.

Trunking to mechanizm przesyłania ramek wielu VLAN-ów przez jedno fizyczne połączenie (zwykle między przełącznikami). Na porcie trunkowym każda ramka jest oznaczona odpowiednim tagiem VLAN, dzięki czemu przełącznik odbierający wie, do którego VLAN-u przypisać pakiet. Porty dostępowe (access ports) obsługują tylko jeden VLAN i nie oczekują ramek oznaczonych.

Agregacja łączy (Link Aggregation) polega na łączeniu wielu fizycznych połączeń w jedno logiczne, co zwiększa przepustowość i redundancję. Standard IEEE 802.3ad (znany też jako LACP – Link Aggregation Control Protocol) umożliwia automatyczne wykrywanie i konfigurowanie grup agregacyjnych. Switch przypisuje ramki do kanałów agregacyjnych na podstawie różnych heurystyk, np. adresów MAC/IP, numerów portów TCP/UDP.

Ethernet przeszedł znaczną ewolucję od czasów 10BASE-T, przez Fast Ethernet (100 Mbps), aż po Gigabit Ethernet (1 Gbps), 10G, 40G, a obecnie 100G i więcej. Wraz ze wzrostem przepustowości konieczne było wdrażanie funkcji zarządzania ruchem (np. flow control, priorytety), synchronizacji (PTP – IEEE 1588), a także mechanizmów eliminujących broadcast stormy.

Jednym z zaawansowanych rozszerzeń Ethernetu są standardy Time-Sensitive Networking (TSN), opracowane w ramach IEEE 802.1. Umożliwiają one deterministyczne przesyłanie ramek, np. w sieciach przemysłowych, samochodowych lub audio/video, gdzie krytyczne jest zapewnienie niskiego jittera i opóźnień.

Wi-Fi, czyli standard IEEE 802.11, implementuje warstwę łącza danych w sposób różny od Ethernetu. Ramki 802.11 są znacznie bardziej rozbudowane, zawierają wiele pól związanych z bezpieczeństwem, kontrolą dostępu, roamingiem i potwierdzeniami transmisji. Istnieją różne typy ramek: danych, zarządzania i kontrolne. Każda z nich ma określone znaczenie – np. beacon (rozgłoszeniowa ramka AP), RTS/CTS, ACK, probe request/response.

Warstwa łącza danych w Wi-Fi musi także radzić sobie z problemem zwanego „ukrytym terminalem” (hidden node). Dwa komputery A i C mogą nie widzieć się nawzajem, ale obaj próbują nadawać do punktu B, powodując kolizje. Rozwiązaniem jest stosowanie mechanizmu RTS/CTS.

W środowiskach wirtualnych (np. serwery z maszynami wirtualnymi, kontenery) warstwa łącza danych jest emulowana programowo. Tworzy się tzw. mosty (bridges), wirtualne przełączniki (vSwitch), interfejsy wirtualne (vNIC), które łączą maszyny wirtualne z fizyczną siecią. W systemach Linux można używać brctl, ip link, ovs-vsctl (Open vSwitch) do konfigurowania takich struktur.

Komunikacja wirtualna może odbywać się całkowicie w przestrzeni hosta, bez wychodzenia na fizyczną kartę sieciową. Możliwe jest również tworzenie izolowanych sieci wirtualnych (np. VLAN-y dla maszyn wirtualnych, SR-IOV).

W sieciach przemysłowych, takich jak SCADA, Profinet, EtherCAT czy Modbus TCP, warstwa łącza danych często zawiera niestandardowe rozszerzenia umożliwiające pracę w środowiskach czasu rzeczywistego, z deterministycznymi wymaganiami dotyczącymi opóźnień. Przykładowo EtherCAT wysyła jedną dużą ramkę, która przechodzi szeregowo przez kolejne urządzenia i jest przez nie częściowo nadpisywana – każde urządzenie zna swój offset w ramce.

W wielu przypadkach warstwa łącza danych staje się również punktem integracji z systemami bezpieczeństwa. Switch może wspierać NAC (Network Access Control), czyli uwierzytelnianie użytkowników na porcie, np. przy pomocy 802.1X, współdziałającego z RADIUS.

Podsumowując, zaawansowane funkcje warstwy łącza danych dotyczą:

separacji logicznej (VLAN, trunking)

redundancji i agregacji (LAG, EtherChannel)

QoS i zarządzania opóźnieniami (802.1p, TSN)

bezpieczeństwa (802.1X, NAC)

wirtualizacji (vNIC, vSwitch)

sieci przemysłowych (Time-Triggered Ethernet, EtherCAT)

Warstwa łącza danych nie ogranicza się do klasycznego Ethernetu czy Wi-Fi. W wielu środowiskach technicznych stosowane są dedykowane protokoły o własnych strukturach ramek, metodach kontroli błędów i mechanizmach dostępu do medium. Jednym z najstarszych i jednocześnie najczęściej spotykanych w motoryzacji i automatyce systemów jest protokół CAN (Controller Area Network).

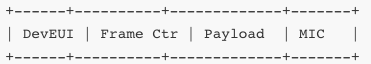

CAN został zaprojektowany przez firmę Bosch w latach 80. jako niezawodny sposób komunikacji pomiędzy mikrosterownikami w pojazdach. Ramka CAN zawiera identyfikator, dane, bit rozszerzenia i CRC. Cechą charakterystyczną CAN jest brak adresowania urządzeń – transmisja odbywa się przez identyfikatory wiadomości, do których każdy węzeł może się „zaprenumerować”.

Wersja CAN FD (Flexible Data Rate) pozwala na większą liczbę bajtów danych i elastyczne prędkości. CAN wykorzystuje arbitraż bitowy – jeśli dwa urządzenia jednocześnie zaczynają nadawać, wygrywa to z niższym identyfikatorem (dominującym bitem 0), a drugie przerywa transmisję i próbuje ponownie. Gwarantuje to deterministyczność i bezkolizyjność komunikacji.

W zastosowaniach automatyki przemysłowej popularne są także Modbus, Profinet oraz EtherCAT. Modbus działa na różnych warstwach fizycznych (np. RS-485, Ethernet), ale definiuje strukturę ramek i sposób komunikacji master-slave, gdzie master inicjuje każde zapytanie, a slave odpowiada.

Profinet (bazujący na Ethernecie) używa ramek z tagami VLAN i często działa w topologii z pętlą (ring), wspierając protokoły redundancji (MRP – Media Redundancy Protocol). EtherCAT natomiast realizuje strukturę ramek cyklicznych – jedna ramka przechodzi przez wszystkie urządzenia i każde z nich odczytuje/uzupełnia swoje dane w locie.

EtherCAT obsługuje dokładną synchronizację czasową (Distributed Clocks), co pozwala na zastosowanie w robotyce, precyzyjnych sterownikach i systemach czasu rzeczywistego. Warstwa łącza danych w takich sieciach musi być deterministyczna i odporna na zakłócenia.

W dziedzinie elektroniki użytkowej warstwa łącza danych występuje w Bluetooth. Bluetooth korzysta z protokołu L2CAP (Logical Link Control and Adaptation Protocol), który dzieli dane na segmenty i przesyła je w ramach tzw. ramek baseband. Bluetooth ma topologię master/slave (obecnie bardziej zwaną central/peripheral), z obsługą szyfrowania i retransmisji.

Bluetooth Low Energy (BLE) stosuje warstwę łącza danych zoptymalizowaną pod kątem małej ilości danych i bardzo niskiego zużycia energii. BLE przewiduje możliwość retransmisji pakietów na poziomie kontrolera i obsługuje kanały sterujące i danych.

W telekomunikacji komórkowej, choć większość protokołów opiera się na warstwach wyższych niż łącza danych (np. RLC, PDCP), to jednak np. w LTE (Long Term Evolution) oraz 5G stosuje się warstwę MAC z własnymi zasadami. MAC w LTE zarządza dostępem do medium radiowego, planuje transmisje na podstawie harmonogramów, a także realizuje segmentację i retransmisję danych.

W systemach światłowodowych, takich jak GPON (Gigabit Passive Optical Network), również mamy do czynienia z warstwą łącza danych, która koordynuje ruch upstream i downstream w architekturze punkt–wielopunkt. Warstwa ta odpowiada za nadawanie danych w precyzyjnie określonych slotach czasowych, co pozwala uniknąć kolizji.

W sieciach światłowodowych dla centrów danych, takich jak Fibre Channel, warstwa łącza danych łączy funkcje MAC z transmisją ramek SCSI, obsługując pełny duplex i bardzo niskie opóźnienia. Ramki Fibre Channel zawierają strukturę nagłówka, identyfikator portu, dane i FCS.

W sieciach domowych lub budynkowych, technologią wykorzystującą warstwę łącza danych jest Powerline Communication (PLC). W tym przypadku dane są przesyłane przez istniejącą instalację elektryczną z wykorzystaniem modulacji wysokoczęstotliwościowej. Warstwa łącza danych PLC odpowiada za podział pasma, kontrolę kolizji i retransmisje w zależności od zakłóceń w sieci energetycznej.

Z kolei w technologiach bezprzewodowych dalekiego zasięgu, takich jak LoRaWAN, warstwa łącza danych realizowana jest przez MAC layer definiujący dostęp do kanału i retransmisje. LoRaWAN wykorzystuje protokół ALOHA i adaptacyjne skalowanie mocy transmisji.

Wszystkie opisane technologie dzielą wspólne cechy charakterystyczne dla warstwy łącza danych: enkapsulacja danych w ramki, dodawanie informacji sterujących, detekcja błędów (CRC, sumy kontrolne), kontrola dostępu do medium oraz identyfikacja nadawcy i odbiorcy. Jednocześnie każda z nich implementuje te mechanizmy w sposób dostosowany do specyfiki danego środowiska – czasem z naciskiem na deterministyczność (EtherCAT), czasem na niskie zużycie energii (BLE), a czasem na wydajność i zasięg (LTE, GPON).

Tym samym warstwa łącza danych okazuje się nie tylko prostym pośrednikiem między warstwą fizyczną a siecią IP, lecz złożoną strukturą zarządzającą efektywnością, bezpieczeństwem i niezawodnością transmisji w bardzo zróżnicowanych warunkach środowiskowych.

2.2. Protokoły dostępu do medium (MAC)

Warstwa łącza danych pełni funkcję pośredniczącą między warstwą fizyczną a warstwą sieciową, odpowiadając za kontrolę transmisji ramek w obrębie lokalnego łącza. Jej integralnym elementem jest podwarstwa MAC, czyli Media Access Control. Zadaniem tej podwarstwy jest zorganizowanie dostępu do wspólnego medium transmisyjnego tak, by uniknąć konfliktów i zapewnić efektywne przesyłanie danych w środowiskach, gdzie wiele urządzeń współdzieli ten sam kanał fizyczny. Protokoły MAC są różnorodne i dostosowane do specyfiki medium – inne stosuje się w Ethernetcie przewodowym, inne w sieciach bezprzewodowych, jeszcze inne w magistralach szeregowych, światłowodach czy systemach przemysłowych.

Pierwotne wersje Ethernetu wykorzystywały podejście znane jako CSMA/CD – Carrier Sense Multiple Access with Collision Detection. W tym modelu każde urządzenie nasłuchuje medium przed rozpoczęciem transmisji. Jeśli medium jest wolne, urządzenie zaczyna nadawanie. Jeśli medium jest zajęte, urządzenie czeka, aż stanie się wolne. Kluczowy problem pojawia się wtedy, gdy dwa urządzenia rozpoczną nadawanie niemal jednocześnie – ze względu na opóźnienie propagacyjne w kablu, każde z nich może uznać medium za wolne i rozpocząć transmisję, nie wiedząc o drugim. To prowadzi do kolizji.

Gdy kolizja zostanie wykryta (poprzez porównanie nadawanego i odbieranego sygnału), urządzenie natychmiast przerywa transmisję i wysyła tzw. jam signal – specjalną sekwencję bitów sygnalizującą innym urządzeniom, że zaszła kolizja. Następnie każde z urządzeń losuje czas oczekiwania przed ponowną próbą nadawania. Ten czas, określany jako backoff, jest wyznaczany według algorytmu wykładniczego: po pierwszej kolizji losuje się czas z przedziału [0, T], po drugiej z [0, 2T], po trzeciej z [0, 4T] itd., aż do ustalonego maksimum. Zmniejsza to prawdopodobieństwo kolejnych kolizji.

CSMA/CD był efektywny przy niskim obciążeniu medium, ale jego skuteczność spadała gwałtownie przy dużym natężeniu ruchu. Obecnie nie jest już stosowany w sieciach Ethernet, ponieważ większość z nich działa w trybie full-duplex, eliminując kolizje. W tym trybie każde urządzenie korzysta z osobnych kanałów transmisji i odbioru, umożliwiając jednoczesne nadawanie i odbieranie.

W sieciach bezprzewodowych stosowanie CSMA/CD nie jest możliwe, ponieważ urządzenie nie może jednocześnie nadawać i odbierać w tym samym paśmie częstotliwości – tym samym nie jest w stanie wykryć kolizji. Dlatego w 802.11 opracowano wariant CSMA/CA – Collision Avoidance. W tej wersji urządzenie również nasłuchuje medium przed transmisją, ale dodatkowo losuje tzw. backoff już przed samym nadawaniem, nawet jeśli medium jest wolne. Ma to na celu zmniejszenie prawdopodobieństwa kolizji w sytuacjach, gdy wiele stacji czeka na zakończenie poprzedniej transmisji.

Dodatkowym mechanizmem jest RTS/CTS (Request to Send / Clear to Send). Przed wysłaniem właściwej ramki dane urządzenie wysyła krótką ramkę RTS, zawierającą informację o długości planowanej transmisji. Odbiorca odpowiada CTS, po czym rozpoczyna się transmisja danych. Wszystkie inne stacje, które odbiorą CTS, wstrzymują swoje nadawanie przez określony czas. Dzięki temu możliwe jest unikanie kolizji wynikających z tzw. problemu ukrytej stacji.

W środowiskach o dużej liczbie urządzeń korzystających z jednego medium, np. w sieciach przemysłowych lub autobusowych, stosuje się protokoły deterministyczne. Przykładem może być Token Ring – każda stacja może nadawać tylko wtedy, gdy posiada specjalną ramkę zwaną tokenem. Token krąży po pierścieniu między stacjami i tylko jedna może go posiadać w danym momencie. Zapobiega to kolizjom, ale wymaga dodatkowych mechanizmów zarządzających przypadkami utraty tokena, przeciążenia lub awarii stacji.

W innych wariantach, np. magistralach CAN, stosuje się arbitraż priorytetowy oparty na identyfikatorach wiadomości. Jeśli dwie stacje jednocześnie zaczynają nadawać, to transmisja zostaje przerwana na podstawie priorytetu zawartego w identyfikatorze. Bity 0 są dominujące (niski identyfikator = wyższy priorytet). Dzięki temu stacja o niższym priorytecie rezygnuje z transmisji bez wpływu na ramkę stacji o wyższym priorytecie.

W sieciach GPON (światłowodowych), gdzie wiele stacji dzieli jedną linię światłowodową, stosuje się planowanie transmisji na podstawie przydziałów czasowych (TDMA – Time Division Multiple Access). Każdy terminal ONT otrzymuje swój przydzielony slot czasowy i tylko w tym czasie może nadawać dane upstream. Planowanie przydziałów odbywa się przez centralną jednostkę OLT, która regularnie wysyła wiadomości grantowe. Takie podejście eliminuje ryzyko kolizji i umożliwia bardzo wydajne wykorzystanie pasma.

W miarę jak systemy komunikacyjne stawały się coraz bardziej złożone, również protokoły warstwy MAC ewoluowały w kierunku zwiększonej inteligencji, elastyczności i możliwości różnicowania ruchu. Przykładem są współczesne implementacje MAC w sieciach bezprzewodowych opartych na standardzie IEEE 802.11ax (Wi‑Fi 6) oraz 802.11be (Wi‑Fi 7), które oprócz tradycyjnego CSMA/CA wprowadzają mechanizmy takie jak OFDMA (Orthogonal Frequency Division Multiple Access), MU‑MIMO oraz deterministyczne sloty czasowe. W OFDMA każdy kanał dzielony jest na podnośne częstotliwości, które są przydzielane niezależnym stacjom klienckim, dzięki czemu wiele urządzeń może nadawać jednocześnie, nie kolidując ze sobą.

Rozszerzeniem tej techniki w środowiskach przemysłowych są mechanizmy deterministyczne znane z Time-Sensitive Networking (TSN). W tym podejściu MAC nie tylko decyduje o dostępie do medium na podstawie stanu kanału, ale uwzględnia także zegar globalny. Ramki są nadawane tylko w wyznaczonych slotach czasowych, a ich transmisja jest rezerwowana wcześniej, często z pomocą protokołów takich jak IEEE 802.1Qbv (Time-Aware Shaper). Pozwala to uzyskać bardzo precyzyjne i przewidywalne czasy transmisji niezbędne np. w sterowaniu ruchem maszyn lub pojazdów autonomicznych.

W środowiskach światłowodowych o architekturze pasywnej, jak GPON lub XGS-PON, mechanizm MAC oparty jest na koncepcji grantów. Centralne urządzenie OLT przydziela ONT (Optical Network Terminal) sloty czasowe, w których mogą one przesyłać dane upstream. W tym modelu MAC działa jako rozproszony scheduler – bierze pod uwagę potrzeby przepustowości, klasę ruchu i inne priorytety. Dzięki temu każda jednostka dostaje precyzyjnie określony czas nadawania, eliminując kolizje i zapewniając wysoki poziom efektywności.

W LTE i 5G warstwa MAC stanowi krytyczny komponent warstwy radiowej (RAN). Odpowiada za segmentację, agregację ramek i planowanie zasobów czasowo-częstotliwościowych. W przeciwieństwie do Ethernetu, gdzie MAC reaguje pasywnie na sytuację w medium, tutaj MAC aktywnie zarządza zasobami kanałowymi. Scheduler w eNB (LTE) lub gNB (5G) przydziela zasoby w jednostkach czasowych zwanych TTI (Transmission Time Interval). Każdy użytkownik otrzymuje odpowiedni fragment pasma (w domenie czasu i częstotliwości) w zależności od zapotrzebowania, priorytetu QoS i jakości kanału.

W sieciach przemysłowych (Industrial Ethernet, Profinet IRT, EtherCAT) protokoły MAC implementują własne harmonogramy transmisji deterministycznej, często wykorzystując prekonfigurowane listy czasowe (schedule tables) oraz priorytety transmisji. Ramki o wyższej krytyczności są przepuszczane jako pierwsze, zaś transmisje niższego priorytetu są opóźniane lub przerywane. W EtherCAT mechanizm MAC jest niemal zupełnie wyeliminowany – pojedyncza ramka przetwarzana jest w czasie przejścia przez kolejne węzły i nadpisywana w locie, co pozwala zredukować opóźnienia do kilku mikrosekund na każdy węzeł.

Nowoczesne przełączniki (switches) wyposażone są w zaawansowane implementacje MAC, które pozwalają na klasyfikację ramek, kolejkowanie ruchu (np. WRR – Weighted Round Robin, PQ – Priority Queuing) oraz obsługę reguł sieciowych. Mechanizm MAC współdziała z komponentami QoS – przykładowo ramki mogą być klasyfikowane na podstawie pola PCP (Priority Code Point) w tagu VLAN 802.1Q i przypisywane do odpowiednich kolejek.

Mechanizmy MAC mogą również uwzględniać dynamiczne zmiany stanu sieci, takie jak przeciążenia, opóźnienia, jitter czy fluktuacje przepustowości. Przełączniki z funkcją Adaptive MAC rewidują polityki dostępu i priorytety transmisji w czasie rzeczywistym. W niektórych implementacjach stosuje się tzw. mechanizmy flow control, w których odbiornik informuje nadawcę o konieczności wstrzymania transmisji przez wysłanie ramki PAUSE. Jest to przydatne, gdy odbiorca nie nadąża z przetwarzaniem ramek i zbliża się do przepełnienia buforów.

W sieciach zautomatyzowanych i chmurowych (np. Google B4, Microsoft Azure SONiC), MAC jest zintegrowany z kontrolerami SDN (Software Defined Networking). W tym modelu reguły dotyczące transmisji nie są lokalne dla przełącznika, lecz definiowane przez centralny kontroler. MAC realizuje więc polityki zgodnie z logiką warstwy sterowania, przydzielając pasmo, priorytety, klasy usług lub nawet zmieniając ścieżki na żywo.

Przykład bardziej nietypowy to MAC w systemach LoRaWAN. Ponieważ urządzenia końcowe działają z bardzo niską mocą i rzadko komunikują się z siecią, MAC pełni tu funkcję pasywną – urządzenie inicjuje transmisję kiedy tylko potrzebuje, a bramka odbiera pakiet i ewentualnie odpowiada z opóźnieniem. LoRaWAN stosuje technikę ALOHA z modyfikacjami (np. duty cycle ograniczony przepisami, kanały kontrolne i okna odbioru).

Istnieją także eksperymentalne rozwiązania, które wprowadzają sztuczną inteligencję do warstwy MAC. Algorytmy uczenia maszynowego przewidują zapotrzebowanie na pasmo, analizują historię kolizji i automatycznie dostosowują backoff, sloty czasowe i harmonogramy transmisji. Rozwiązania takie testowane są w środowiskach sieci IoT (np. Zigbee, Thread), gdzie liczba urządzeń i złożoność topologii utrudniają klasyczne zarządzanie medium.

Protokoły MAC są również nieodzownym komponentem architektur multi-hop, gdzie dane przechodzą przez wiele węzłów pośrednich. W takich sytuacjach MAC musi uwzględniać nie tylko natężenie ruchu lokalnego, ale również przewidywane przeciążenia downstream. Przykładem jest mesh routing w 802.11s, gdzie każde urządzenie pełni jednocześnie rolę klienta i przekaźnika. W takich topologiach MAC współdziała ściśle z warstwą routingu, planując okna nadawcze tak, by nie doszło do zatorów lub opóźnień na trasie.

Wreszcie, istotnym aspektem działania MAC jest bezpieczeństwo. Warstwa MAC może być wykorzystywana do identyfikacji urządzeń, przydzielania dynamicznych reguł ACL (Access Control List) lub stosowania kontroli dostępu 802.1X. Ramki mogą być filtrowane na podstawie adresu MAC, VLAN-u, zawartości nagłówków L2–L4, czy położenia geograficznego (w sieciach LoRa lub satelitarnych).

2.3. Kontrola błędów i przepływu danych

Warstwa łącza danych dodaje do każdej ramki pole CRC (Cyclic Redundancy Check) – cztero- lub zwłaszcza w HDLC krótsze – które obliczane jest na podstawie zawartości adresów, typu i danych. Odbiornik oblicza CRC niezależnie i porównuje z tym załączonym. Jeśli wartości się różnią, ramka jest odrzucana. W środowisku Ethernet brak retransmisji sprawia, że to warstwy wyższe, jak TCP, są odpowiedzialne za uzupełnienie braków. W protokołach takich jak HDLC, PPP czy Wi‑Fi możliwe jest automatyczne powtórne wysyłanie ramki przez warstwę MAC, co zwiększa niezawodność. W Wi‑Fi stosuje się potwierdzenia ACK – po wysłaniu ramki nadawca czeka na ACK, a jeśli ten nie nadejdzie, ramka jest retransmitowana.

W otoczeniu bezprzewodowym, warstwa MAC realizuje również usługę kontroli dostępu do medium, wykorzystując mechanizmy CSMA/CA i backoff. Jeśli po wysłaniu ramki nie nadejdzie ACK, urządzenie zakłada wystąpienie błędu i ponawia transmisję po losowym opóźnieniu, co zapobiega nadmiernej kolizji. W TX/RX przerzutach w sieciach przemysłowych pojawiają się mechanizmy deterministyczne, gdzie ramka jest planowana i nadawana tylko w przewidzianym czasie przez wyznaczony węzeł, co minimalizuje straty i opóźnienia.

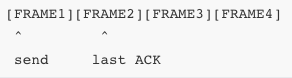

Kontrola przepływu (flow control) realizowana jest, gdy nadawca i odbiorca współpracują w celu nieprzepełnienia buforów. W środowisku Ethernet często używany jest mechanizm Flow Control (IEEE 802.3x) – odbiorca wysyła ramkę PAUSE, która blokuje nadawcę na określony czas. W wielu implementacjach konteneryzacja przesyłu jest prosta – bez restrykcji. W protokołach takich jak HDLC stosowany jest windowing – nadawca może wysłać maksymalnie określoną liczbę ramek przed otrzymaniem potwierdzenia. Windowing umożliwia płynną transmisję bez zatorów. Rysunek przedstawia mechanizm okna: nadawca wysyła N ramek, czeka na ACK, przesuwa okno.

Rysunek: okno przesuwne

W TCP mechanizm kontrolowany jest przez dynamiczne okno, które jest dostosowywane według warunków sieci, reagując na straty i opóźnienia w celu zapewnienia równowagi między niezawodnością a wydajnością. Jeśli przesył danych jest szybszy niż odbiorca jest w stanie przetworzyć, odbiorca zmniejszy okno, ograniczając tempo. Jeśli nie ma strat i przesył działa sprawnie, okno będzie się powiększać, aż osiągnie próg lub limit adresu bufora.

Niezawodność transmisji zależy też od reakcji na utratę ramek. W protokołach warstwy łącza danych, które wspierają retransmisję, odbiorca potwierdza odebranie ramki numerowanym ACK lub NAK, a nadawca powtarza, jeśli nie otrzyma potwierdzenia w określonym czasie. Algorytmy takie jak ARQ (Automatic Repeat reQuest) zapewniają, że dane dotrą kompletnie i w odpowiedniej kolejności. W ARQ stosuje się różne schematy: stop-and-wait – nadawca wysyła jedną ramkę i czeka na ACK, co jest proste, ale nieefektywne przy większych odległościach; go-back-n – nadawca może mieć wiele ramek na etapie nierepotwierdzonym, ale w razie błędu wraca do eseń po błędnej; selective repeat – retransmituje tylko brakujące ramki.

Protokoły sieciowe często implementują adaptacyjne przystosowanie tempa transmisji do warunków sieci. W algorytmach TCP używa się AIMD – additive increase, multiplicative decrease – co oznacza, że po każdym potwierdzeniu okienko zwiększa się liniowo, a po wykryciu straty zmniejsza się gwałtownie. W ten sposób unika się przeciążeń sieci, reagując na sygnały utraty pakietów. Najpierw stosuje się slow start – okno rośnie wykładniczo do momentu dotarcia do wartości progowej, potem linowo w Congestion Avoidance. W razie straty następuje fast retransmit i fast recovery, które pozwalają kontynuować transmisję bez powrotu do początku slow startu.

Niezależnie od warstwy transportowej, WBPD (window-based flow control with packet drop) w warstwie MAC powoduje, że węzeł odbierający informuje nadawcę o braku bufora – nadawca wstrzymuje wysyłkę, ale nie zeruje sesji. Ramka PAUSE w Ethernet służy temu samemu. W CAN i innych sieciach magistralowych kontrola przepływu wynika z arbitrażu – jeśli magistrala jest zajęta, alternatywny węzeł oczekuje, co powoduje naturalne ograniczenie.

Kontrola błędów może objąć również ochronę przed duplikacją ramek. W sieciach, które wspierają ARQ, odbiorca ignoruje duplikaty na podstawie numeru sekwencyjnego – nadawca numeruje ramki modulo okna, a odbiorca odbiera tylko ramki o oczekiwanym numerze, duplikaty odrzuca. Nadawca z kolei powtarza zaznaczone brakujące. Numeracja i sekwencjonowanie są więc elementem zarówno integralności jak i kontroli przepływu.

W sieciach przewodowych IEEE 802.5 (Token Ring) używa się starych MAC-owych potwierdzeń i kontroli ramkowej – ramka ze statusem "recognized" zostaje oznaczona bitowo. Kontrola przepływu odbywa się poprzez ograniczenie liczby ramek, które stacja może przesłać bezpośrednio po tokenie, co zapobiega monopolizacji medium.

W technologii HDLC liczby sekwencji roboczych (N(S), N(R)) używane są odpowiednio przez nadawcę i odbiorcę. Ramka I (informacyjna) ma N(S), potwierdzenie zawiera N(R). Window Receiver określa ile ramek może przetworzyć naraz. W razie wykrycia błędu przesyła ramkę rej (reject) lub srej (selective reject), co powoduje powtórkę.

Z punktu widzenia programisty, mechanizmy te wymagają utrzymywania buforów wysyłki i odbioru, struktur sekwencyjnych, liczników czasowych (timeout dla retransmisji) oraz procedur obsługi błędów. W zaawansowanych systemach telemetrycznych, gdzie stosowane są połączenia satelitarne, implementuje się hybrydowe protokoły FEC + ARQ, które minimalizują opóźnienia i maksymalizują skuteczność retransmisji. Dane są kodowane redundancją (FEC), a brakujące fragmenty uzupełniane poprzez ARQ.

W sieciach IoT, w technologii LoRaWAN czy NB-IoT, kontrola przepływu jest kluczowa przy limitach transmisji energetycznych i czasowych. LoRaWAN używa adaptive data rate (ADR) – każda ramka przesyłana jest z dostosowaną mocą i szybkością, a odbiorca wysyła MAC-command request/ack, co stanowi formę kontroli przepływu i błędów.

Mechanizm stop-and-wait jest często stosowany w prostych mikrokontrolerowych systemach – nadawca wysyła ramkę i czeka na potwierdzenie, co minimalizuje buforowanie, ale ogranicza przepustowość. Dla bardziej wymagających sieci stosuje się selective repeat lub sliding window – co pozwala zwiększyć efektywność.

Wychodząc poza czystą warstwę łącza danych, warto zauważyć, że algorytmy kontroli przepływu i błędów są stosowane również w warstwie aplikacji – np. w HTTP2 czy QUIC, które mają własny mechanizm window-based flow control. Również protokoły P2P implementują ARQ na poziomie warstwy aplikacji, co pozwala zbierać części plików z różnych źródeł i rekonstruować je z pominięciem utraconych fragmentów.

Kontrola błędów i przepływu danych to dwa wspierające się mechanizmy: pierwszy dba, by dane nie uszkodzono, drugi – by nie zalać odbiornika. Obie strategie są silnie powiązane w warstwach MAC, ale wymagają koordynacji między nadawcą, odbiorcą i często warstwą transportową, by sieć działała efektywnie, niezawodnie i stabilnie. Jeśli chcesz, mogę teraz stworzyć analogiczny materiał z rysunkami dotyczącymi algorytmów AIMD czy selective repeat w TCP.

2.4. Ethernet, PPP, Frame Relay

Ethernet jest najbardziej rozpowszechnioną technologią warstwy łącza danych i funkcjonuje jako standard IEEE 802.3. Od momentu jego wprowadzenia w latach 70., Ethernet przeszedł ewolucję od wersji bazującej na współdzielonym medium (koaksjalny kabel 10BASE5) do nowoczesnych systemów światłowodowych i skrętki miedzianej z pełnym dupleksem. Pierwsze wersje Ethernetu korzystały z magistrali, gdzie urządzenia nasłuchiwały medium i przesyłały dane, gdy było wolne. Współdzielenie medium wymagało mechanizmu unikania kolizji (CSMA/CD), co było wydajne przy małej liczbie stacji, ale z czasem ograniczało przepustowość.

W modelu tym sygnał nadawany przez jedną stację był odbierany przez wszystkie inne. Kolizje pojawiały się, gdy dwa urządzenia nadawały jednocześnie. Aby ograniczyć ich skutki, stosowano algorytm wykrywania kolizji i ponawiania transmisji po losowym czasie (binary exponential backoff).

Współczesne systemy Ethernet używają przełączników (switchy), które izolują domeny kolizji. Każde urządzenie jest połączone dedykowanym przewodem do portu przełącznika, a komunikacja odbywa się w trybie full-duplex – jednoczesne nadawanie i odbiór. Z tego względu CSMA/CD jest już nieużywane.

Podstawową jednostką transmisji w Ethernet jest ramka (frame), która zawiera pola adresowe, dane oraz kontrolne. Struktura ramki definiuje sposób działania warstwy MAC oraz sposób identyfikacji nadawcy i odbiorcy. Ramki Ethernetu mają określoną strukturę i ograniczenia długości. Minimalna długość ramki to 64 bajty (aby umożliwić detekcję kolizji), a maksymalna – 1518 bajtów (standardowa) lub do 9216 bajtów (jumbo frames w niektórych implementacjach).

Preambuła to ciąg bitów (101010...), który synchronizuje odbiornik. Adresy MAC to unikalne identyfikatory interfejsów sieciowych zapisane w postaci 48-bitowej (np. 00:1A:2B:3C:4D:5E). Pole typ określa protokół warstwy wyższej (np. 0x0800 dla IPv4, 0x86DD dla IPv6), a CRC (Cyclic Redundancy Check) służy do wykrywania błędów transmisji.

Adres MAC odgrywa kluczową rolę w warstwie łącza danych. Dzięki niemu przełączniki mogą tworzyć tablice MAC, które umożliwiają kierowanie ramek do konkretnego portu. Gdy przełącznik odbierze ramkę, analizuje pole źródłowe MAC i zapamiętuje, z którego portu nadeszła, a następnie przesyła ramkę na port skojarzony z adresem docelowym.

Oprócz standardowego Ethernetu istnieją rozszerzenia, takie jak VLAN (IEEE 802.1Q), który pozwala na logiczne grupowanie urządzeń niezależnie od fizycznego połączenia. W takiej sytuacji do ramki dodawany jest znacznik VLAN.Pole 0x8100 wskazuje, że dalsza część zawiera tag VLAN, który zawiera identyfikator (12 bitów) i priorytet (3 bity). Dzięki temu można wdrożyć polityki QoS i separację ruchu w przedsiębiorstwach.

Ethernet wspiera także inne rozszerzenia, takie jak 802.3ad (agregacja łączy), 802.3az (efektywność energetyczna), 802.1p (priorytety), a także protokoły do wykrywania pętli jak STP (Spanning Tree Protocol), które zapobiegają zatorom w topologiach z redundancją.

Ethernet ma również wersje światłowodowe – 100BASE-FX, 1000BASE-SX, 10GBASE-LR – które różnią się długością fali światła i typem włókna (jedno- lub wielomodowe). Medium to zapewnia większą odporność na zakłócenia elektromagnetyczne i umożliwia transmisję na duże odległości (do kilkudziesięciu kilometrów).

Ethernet zapewnia komunikację w różnych trybach: unicast (jeden do jednego), broadcast (do wszystkich) i multicast (do wybranych). Adres MAC broadcastowy to FF:FF:FF:FF:FF:FF i jest używany np. w protokołach ARP. Multicasty to adresy z zakresu 01:00:5E:xx:xx:xx i są używane w aplikacjach takich jak IPTV.

Zaawansowane sieci Ethernet implementują również funkcje bezpieczeństwa na poziomie warstwy łącza danych, takie jak port security (ograniczenie liczby adresów MAC na porcie), dynamiczne przypisywanie VLAN-ów, a także autoryzacja 802.1X (z użyciem EAP i RADIUS).

W środowiskach przemysłowych stosuje się wersje deterministyczne, np. Ethernet/IP, Profinet, EtherCAT – które wykorzystują specjalne ramki i zarządzanie czasem transmisji. Standardy Time-Sensitive Networking (TSN) rozwijane w ramach IEEE 802.1 umożliwiają synchronizację zegarów i deterministyczne przesyłanie ramek zgodnie z harmonogramem.

Na zakończenie tej części warto zaznaczyć, że Ethernet mimo swojej prostoty pozostaje podstawą działania sieci komputerowych – zarówno lokalnych (LAN), jak i centrów danych, gdzie funkcjonuje w topologiach spine-leaf z portami 100Gbps i większymi. W kolejnej części przejdziemy do opisu PPP (Point-to-Point Protocol) oraz Frame Relay, ich struktur ramek, zastosowań, mechanizmów negocjacji i obsługi błędów.

PPP, czyli Point‑to‑Point Protocol, działa w środowiskach, gdzie łącze łączy dokładnie dwa węzły – często modemy, łącza dzierżawione lub łącza dial‑up. Jego podstawą jest proste ramkowanie, ale protokół zapewnia także wykrywanie błędów, negocjację parametrów (automatyczne ustalanie i dopasowanie wielkości MSS, trybu kompresji itp.) oraz uwierzytelnianie (PAP, CHAP). Ramka PPP składa się z flagi początkowej i końcowej (01111110), pola adresu (domyślnie 11111111), pola kontroli (domyślnie 00000011 – oznacza ramkę nie-rozszerzoną), a dalej następuje pole protokołu, dane (payload) i CRC.

Pole protokołu informuje, czy wewnątrz znajdują się np. LCP, PAP, IP, IPv6, CHAP. Segment LCP (Link Control Protocol) inicjuje połączenie: negocjuje MRU, kompresję, obsługę równoległych protokołów. Ramka LCP flow: oba końce wymieniają Configure‑Request, Configure‑Ack, Configure‑Nak/Reject, aż do uzgodnienia. Potem następuje faza Authentication (PAP lub CHAP), a potem faza Network‑Layer Protocol (NAP) – transmitowane są ramki IP. Na koniec LCP negocjuje wyłączenie połączenia. Autentykacja PAP to prosty login/hasło przesłane w tekście jawnym. CHAP używa trójdrożnego wyzwania‑odpowiedzi (Challenge‑Handshake Authentication Protocol), gdzie serwer wysyła losowe wyzwanie, klient oblicza hasz i odsyła; serwer porównuje i akceptuje lub odrzuca.

PPP implementuje detekcję błędów dzięki FCS (Frame Check Sequence) – 16- lub 32‑bitowemu CRC, które sprawdza się po otrzymaniu całej ramki. Jeśli wartość CRC się nie zgadza, ramka jest odrzucana. PPP nie robi retransmisji – jeśli ramka ginie, LCP nie potwierdzi, klient zgłosi błąd wyłączenia połączenia lub timeout. W transmisji protokołów wyższych (np. TCP) to one odpowiadają za retransmisję, co w łączu punkt-punkt, rzadko obciążonym i zazwyczaj niezbyt zakłóconym, wystarcza.

Ramki PPP mogą zawierać dane protokołu IP, IPv6 i inne, przypisane do odpowiedniego pola Proto. Po etapie NAP dane te są enkapsulowane bez dodatkowej magii – PPP po prostu przesyła niestrukturalne pakiety warstwy sieci, a odbiorca wie, że to ramka IP.

Frame Relay powstał jako protokół dla sieci publicznych dzierżawionych – opartych na łączu ethernetowym, ale skalujący się jako rozwiązanie wirtualnej sieci szerokopasmowej (WAN). W środowisku Frame Relay ruch przesyłany jest przez wirtualne łącza punkt-punkt (PVC – Permanent Virtual Circuits), oznaczone identyfikatorami DLCI. Użytkownik nie zarządza fizycznym środowiskiem – ramki przesyłane są do sieci Frame Relay, która przekazuje je do końcowego węzła.

Struktura ramki Frame Relay obejmuje pole flagi, pola adresowe (DLCI + kontrola), dane i CRC. Pole adresowe zawiera 10‑bitowy DLCI i flagi DE (Discard Eligibility), CI (Forward Explicit Congestion Indication) i inni, które służą do określenia priorytetu i reakcji na przeciążenia. Za de-eskalację utraty transmisji odpowiadają protokoły warstw wyższych; Frame Relay może wykorzystywać FECN/BECN (Forward/Backward Explicit Congestion Notification) – gdy bufor przechodzi próg, urządzenie oznacza ramkę i przesyła informację o przeciążeniu do końca drogą powrotną lub dalej – co pozwala na reagowanie warstwom wyższym i dostosowanie tempa transmisji.

Adres DLCI identyfikuje konkretne wirtualne łącze, które może być mapowane na konkretny port logiczny. Np. DLCI 16 może prowadzić do miasta A, a 20 do B, a ramka trafia tylko do odpowiedniego węzła. Sieć transportuje wszystkie ramki użytkownika, niezależnie od ich docelowego VLAN-u – to model wielowątkowej transmisji w jednym medium fizycznym.

W momencie gdy pakiety IP (lub inne) mają przekroczyć MTU sieci Frame Relay (czasem bardzo ograniczone), warstwa Link Control (LAPF – Link Access Procedure for Frame Relay) może dzielić lub agregować ramki. Ramka LAPF zawiera swój własny nagłówek i kontrolę błędów. Frame Relay działa zazwyczaj w trybie bezpotwierdzeń – podobnie jak Ethernet, liczy się na retransmisję TCP/UDP wyżej.

W warstwie PPP exchange następuje faza końca połączenia – LCP negocjuje Terminate‑Request, potwierdza Terminate‑Ack, zanim fizyczne łącze zostanie zakończone. Frame Relay ustaje, gdy routing lub użytkownik zdeaktywuje PVC, co może być zakończone komunikatem LMI (Local Management Interface), informującym o stanie łącza. LMI działa jako protokół nadzoru, który wysyła keepalive, informuje o dostępnych DLCI, stanie SVC, korzystaniu z BECN/FECN itp.

Przechodząc między PPP a Frame Relay warto wspomnieć, że obydwa protokoły działają w środowisku pół‑trwałych połączeń – PPP w dial-up, Frame Relay w wirtualnej sieci WAN. PPP obsługuje dynamiczne parametry na obu końcach, idealne do połączeń indywidualnych. Frame Relay działa lepiej przy wielu wirtualnych kanałach na jednym medium, używanym przez centralkę dostępową.

Mechanizmy bezpieczeństwa: PPP implementuje PAP/CHAP oraz opcje kompresji i uwierzytelniania, ale nie szyfruje – przy transmisji wrażliwych danych wymaga się tunelowania (np. PPTP, L2TP) lub VTLS na wyższych warstwach. Frame Relay nie daje native bezpieczeństwa – wszystkie ramki przechodzą przez jedną fizyczną infrastrukturę, dlatego stosuje się separację logiczną i szyfrowanie na poziomie wyższych warstw, np. IPSec VPN.