Podręcznik

| Strona: | SEZAM - System Edukacyjnych Zasobów Akademickich i Multimedialnych |

| Kurs: | Zastosowania Algorytmów Inteligencji Masowej |

| Książka: | Podręcznik |

| Wydrukowane przez użytkownika: | Gość |

| Data: | środa, 14 stycznia 2026, 22:24 |

Spis treści

- 1. Optymalizacja

- 2. Zadanie minimalizacji

- 2.1. Wprowadzenie do problemu minimalizacji

- 2.2. Przestrzeń ciągła i dyskretna - czyli gdzie szuka algorytm

- 2.3. Klasyczne metody przeszukiwania – od pełnego przeglądu po losowe strzały

- 2.4. Algorytmy gradientowe - matematyczna droga w dół ...

- 2.5. Uwzględnianie ograniczeń w optymalizacji – kiedy nie wszystko wolno

- 3. Algorytmy genetyczne

- 4. Particle Swarm Optimization

1. Optymalizacja

Po co nam optymalizacja?

Wyobraźmy sobie codzienne sytuacje: chcemy dojechać do pracy jak najszybciej, wybrać najtańszy lot na wakacje czy zaprojektować konstrukcję mostu, który wytrzyma największe obciążenia przy jak najniższym koszcie. We wszystkich tych przypadkach chodzi o to samo: znaleźć najlepsze możliwe rozwiązanie, zgodne z przyjętym kryterium.

Tym właśnie zajmuje się optymalizacja. Matematycznie rzecz ujmując, optymalizacja to poszukiwanie minimum lub maksimum funkcji celu przy zadanych ograniczeniach. Funkcja celu to matematyczny opis tego, co chcemy zmaksymalizować (np. zysk) lub zminimalizować (np. koszt). Zmiennymi decyzyjnymi są parametry, które możemy kontrolować, a ograniczenia to zbiór warunków, które rozwiązanie musi spełniać, by było dopuszczalne.

Optymalizacja pojawia się wszędzie tam, gdzie trzeba podejmować decyzje. Trzeba jednak pamiętać, że nie każda decyzja intuicyjnie najlepsza jest naprawdę optymalna w sensie matematycznym — różnica ta staje się istotna w zastosowaniach inżynierskich czy ekonomicznych, gdzie nieoptymalny wybór może skutkować realnymi stratami.

Trudności w optymalizacji

Pierwszą trudnością w wielu problemach optymalizacyjnych jest rozmiar przestrzeni poszukiwań. Gdy liczba zmiennych jest duża, liczba możliwych rozwiązań rośnie wykładniczo, a pełne przeszukiwanie staje się praktycznie niemożliwe. Przykładowo, przy 100 zmiennych binarnych mamy do rozważenia wariantów. Nawet najpotężniejsze komputery nie są w stanie przetworzyć takiej ilości danych w sensownym czasie.

Drugi problem to natura samej funkcji celu. W praktyce funkcje te są często nieliniowe, nieciągłe, a czasem nawet stochastyczne. Może się okazać, że drobna zmiana parametrów powoduje duży i nieprzewidywalny skok wartości funkcji celu. Taka „dzika” topologia przestrzeni rozwiązań utrudnia klasyczne metody optymalizacji bazujące na pochodnych i gradientach.

Trzecią barierą są ograniczenia — formalne lub ukryte. Wiele rzeczywistych problemów zawiera trudne do opisania warunki dopuszczalności: fizyczne, techniczne, prawne, czy związane z bezpieczeństwem. Dodanie ich do modelu optymalizacyjnego komplikuje analizę i znacząco zmniejsza liczbę dopuszczalnych rozwiązań, często do bardzo nieregularnych obszarów.

Ostatni, ale nie mniej ważny problem to lokalne ekstrema. W przypadku funkcji nieliniowych algorytmy mogą „utknąć” w minimum lokalnym — rozwiązaniu, które wygląda na dobre, ale nie jest najlepsze globalnie. Problem ten jest szczególnie dotkliwy w optymalizacji dyskretnej i złożonych problemach inżynierskich, gdzie nie widać łatwej drogi ucieczki z takiego minimum bez globalnej wiedzy o przestrzeni rozwiązań

Przykłady zastosowania optymalizacji

Poniżej przedstawiamy kilka klasycznych przykładów pokazanych na slajdach prezentacji AE1 2020.

Optymalizacja konstrukcji

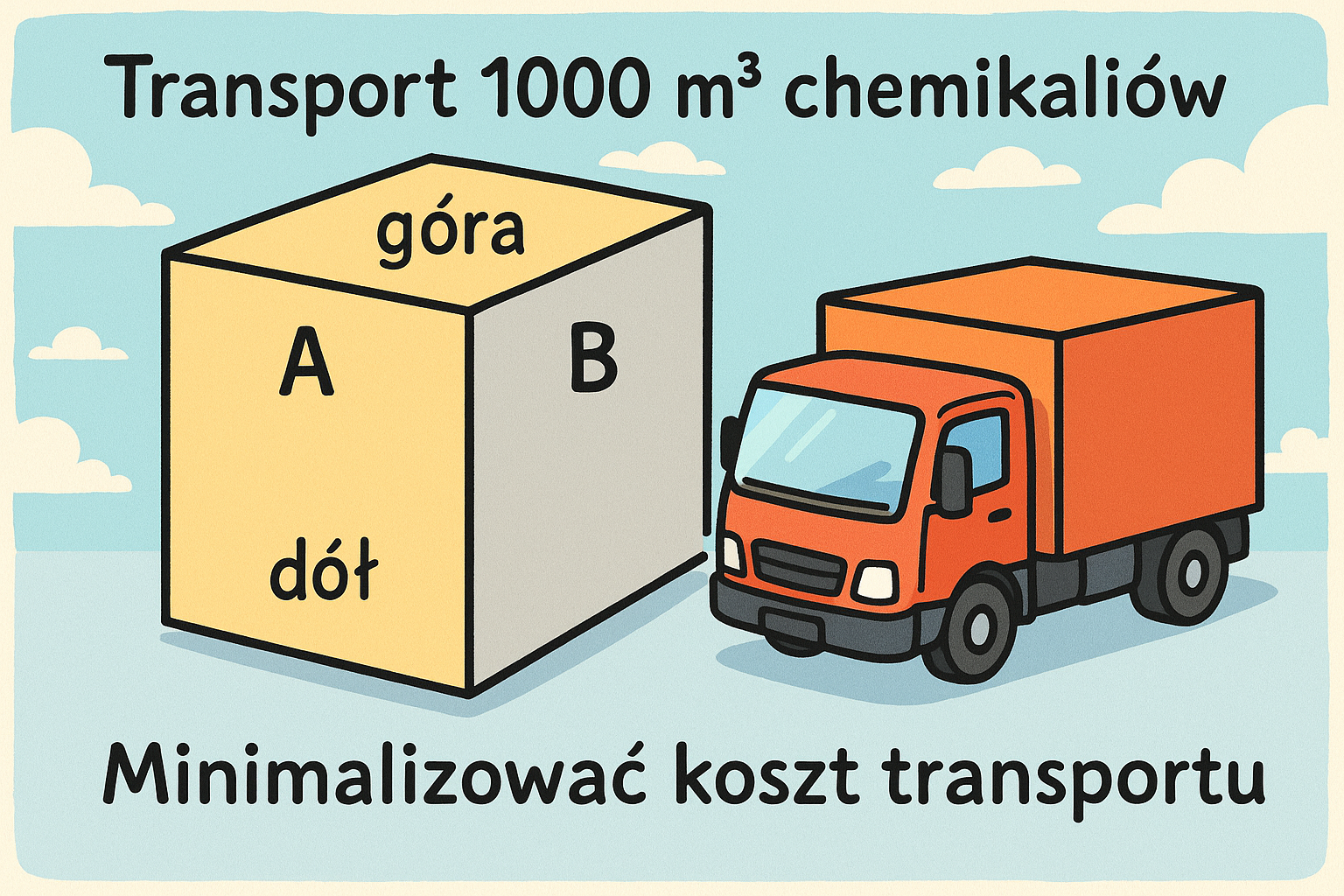

Transport 1000 m³ chemikaliów ma się odbywać w szczelnych, prostopadłościennych pojemnikach. Każdy pojemnik ma ściany boczne nazywane odpowiednio A i B, oraz dno i górę. Każdy pojemnik można zbudować przy zachowaniu konkretnych warunków:

- materiał na górę kosztuje 65 PLN za metr kwadratowy

- materiał na boki A kosztuje 35 PLN za metr kwadratowy

- materiał na boki B oraz dno jest dostępny za darmo (pochodzi z odpadów), natomiast jest ograniczenie w jego ilości - możemy wykorzystać nie więcej niż 10 metrów kwadratowych na pojemnik

Transport pojemnika kosztuje 4 PLN, niezależnie od jego wielkości. Celem jest minimalizacja kosztu transportu. To klasyczny przykład zadania liniowego z ograniczeniami — zmienne decyzyjne to wymiary pojemników, a funkcja celu może zależeć np. od kosztów materiałów i liczby pojemników.

\(

k_j(x_1, x_2, x_3) = km_A \cdot 2(x_2 \cdot x_3) + km_{góra} \cdot (x_1 \cdot x_2) + k_{transport} \)

gdzie:

\(\begin{align*}

x_3 &\text{ — wysokość pojemnika,} \\

x_1 &\text{ — szerokość pojemnika,} \\

x_2 &\text{ — głębokość pojemnika,} \\

k_{transport}&\text{ — koszt transportu pojedynczego pojemnika}

\end{align*}\)

Znając wymiary pojemnika możemy też obliczyć ile ich potrzebujemy:

\( z= \frac{V_{całkowita}}{x_1*x_2*x_3} \)

No i finalnie dochodzimy do wzoru na koszt całkowity

\( f(x_1,x_2,x_3)=z*k_j = \frac{V_{całkowita}}{x_1*x_2*x_3} * (km_A \cdot 2(x_2 \cdot x_3) + km_{góra} \cdot (x_1 \cdot x_2) + k_{transport} ) \)

Optymalizacja portfela inwestycyjnego

Optymalizacja portfela inwestycyjnego to jeden z klasycznych przykładów zastosowania metod optymalizacyjnych w finansach. Wyobraźmy sobie inwestora, który dysponuje pewnym kapitałem i chce go ulokować w różnych aktywach: np. akcjach dużych stabilnych spółek (tzw. blue chips), sektorze paliwowym, nieruchomościach oraz obligacjach. Każde z tych aktywów cechuje się określoną historyczną stopą zwrotu oraz zmiennością (czyli ryzykiem). Celem inwestora jest znalezienie takiego podziału środków, który zapewni możliwie wysoki zysk przy jednocześnie możliwie niskim ryzyku.

Zmiennymi decyzyjnymi w tym przypadku są procentowe udziały kapitału przeznaczone na każdą z czterech kategorii inwestycji, oznaczmy je odpowiednio jako x₁, x₂, x₃, x₄. Suma tych udziałów musi być równa 1 (czyli 100%), co stanowi podstawowe ograniczenie zadania. Dodatkowo mogą występować ograniczenia dolne i górne, np. minimalny udział w obligacjach albo maksymalny udział w akcjach wysokiego ryzyka.

| Typ inwestycji | Roczna stopa zwrotu | ||||||

|---|---|---|---|---|---|---|---|

| Rok | 1 | 2 | 3 | 4 | 5 | 6 | średnia |

| Blue Chip | 18,24 | 12,12 | 15,23 | 5,26 | 2,62 | 10,42 | 10,65 |

| Paliwa | 12,24 | 19,16 | 35,07 | 23,46 | -10,62 | -7,43 | 11,98 |

| Nieruchomości | 8,23 | 8,96 | 8,35 | 9,16 | 8,05 | 7,29 | 8,34 |

| Obligacje | 8,12 | 8,95 | 8,26 | 8,34 | 9,01 | 9,12 | 8,63 |

Funkcja celu w tym problemie ma charakter dwuwymiarowy. Z jednej strony chcemy zmaksymalizować średnią wartość zysku (czyli kombinację średnich stóp zwrotu poszczególnych aktywów ważonych przez x₁ do x₄), a z drugiej strony zminimalizować ryzyko, które najczęściej mierzy się poprzez wariancję lub odchylenie standardowe wartości portfela.

\( V_{j j}=\frac{1}{n} \sum_{k=1}^n\left(r_{j k}-\mu_j\right)^2 \)

Wariancja całego portfela nie zależy tylko od wariancji poszczególnych aktywów, ale również od ich kowariancji — czyli tego, jak bardzo dane aktywa „poruszają się razem”. Dlatego do zadania wprowadza się macierz kowariancji pomiędzy wszystkimi parami inwestycji. Każda komórka tej macierzy pokazuje wariancję wzajemną:

\( V_{i j}=\frac{1}{n} \sum_{k=1}^n\left(r_{i k}-\mu_i\right)\left(r_{j k}-\mu_j\right) \)

Teraz możemy już zapisać ryzyko:

\(

\text{Ryzyko} = \mathbf{x}^T \mathbf{V} \mathbf{x}

\)

Potem powinniśmy jeszcze uwzględnić ograniczenia (zmienne decyzyjne muszą sumować się do jedynki - musimy podzielić całe środki, i jednocześnie nie przekroczyć budżetu). Drugim ograniczeniem będzie zysk - chcemy mieć średni zysk co najmniej 10%:

\( 10.65*x_1+11.98*x_2+8,34*x_3+8,64*x_4 \geq10 \)

Ostatecznie zadaniem można zapisać jako

\( min {x^TVx} \)

Z ograniczeniami podanymi wyżej, przy dodatkowym założeniu, że żadna ze zmiennych decyzyjnych nie może być mniejsza od zera.

Formalnie zapisane, zadanie optymalizacji portfela przyjmuje postać problemu kwadratowego z ograniczeniami. Funkcja celu jest funkcją kwadratową (ze względu na macierz kowariancji), a ograniczenia mają postać równań liniowych (suma udziałów równa 1) oraz ewentualnie nierówności (udziały nieujemne, minimalne progi). Dodatkowy warunek na minimalny oczekiwany zysk — np. inwestor deklaruje, że chce mieć co najmniej 10% średniego zwrotu - też jest ograniczeniem liniowym.

Tego rodzaju problemy są idealnym kandydatem dla zastosowania algorytmów ewolucyjnych, zwłaszcza gdy w grę wchodzą nieliniowe zależności, dyskretne zmienne (np. minimalny próg inwestycyjny), nietypowe ograniczenia lub wiele konkurencyjnych celów naraz (np. zysk, ryzyko, płynność). Algorytmy genetyczne pozwalają łatwo modelować takie złożone sytuacje i znaleźć zbiór kompromisowych rozwiązań — tzw. front Pareto — dający inwestorowi wachlarz dobrze zbilansowanych opcji inwestycyjnych.

Alokacja zasobów (środek owadobójczy)

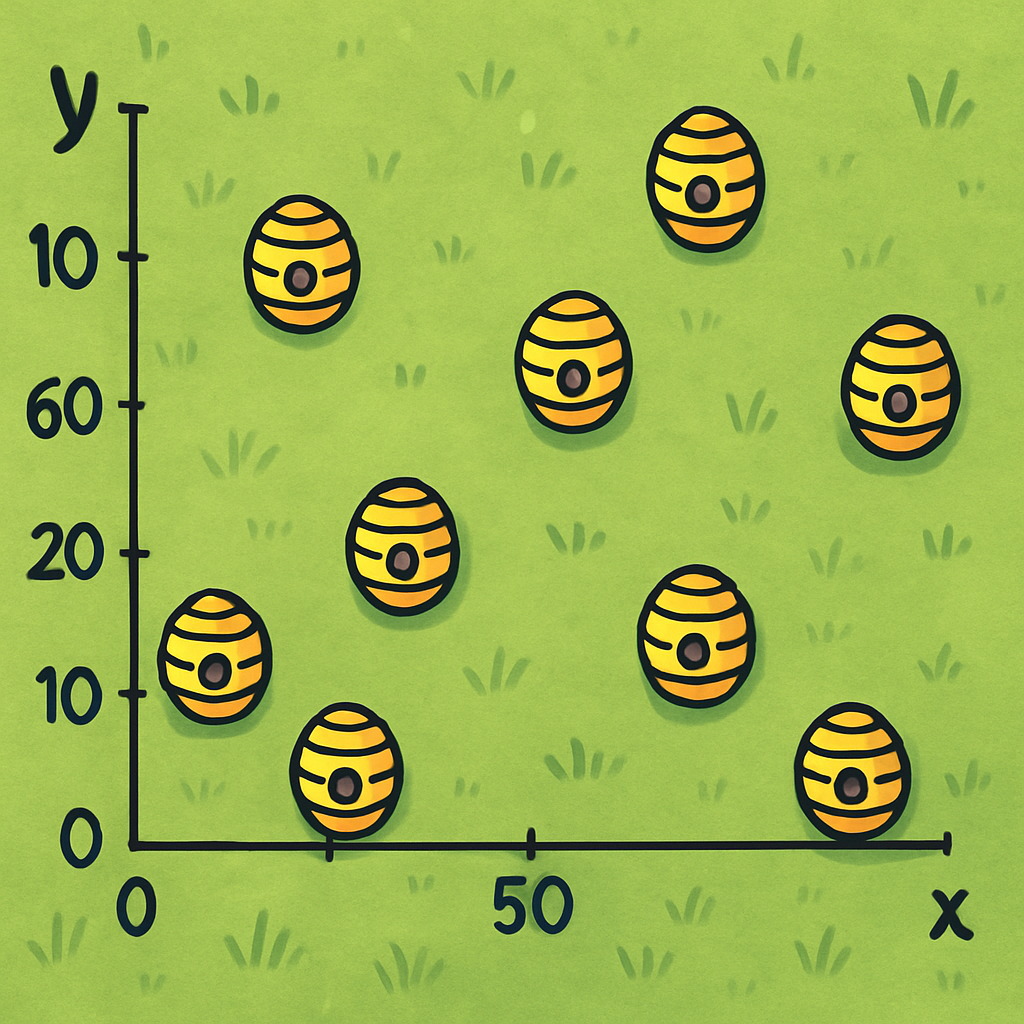

Wyobraźmy sobie plantację w kształcie kwadratu, na której zlokalizowano 12 aktywnych gniazd os. Każde z nich stanowi zagrożenie dla ludzi i upraw, dlatego konieczne jest ich unieszkodliwienie. Do dyspozycji mamy trzy pojemniki ze środkiem owadobójczym, które należy rozmieszczać na tej przestrzeni w taki sposób, by skutecznie zneutralizować jak największą liczbę gniazd.

Zmiennymi decyzyjnymi w tym problemie są współrzędne położenia każdego z trzech pojemników, co oznacza, że mamy do czynienia z problemem optymalizacji w przestrzeni sześciowymiarowej: (x₁, y₁, x₂, y₂, x₃, y₃). Każdy punkt w tej przestrzeni określa możliwe ustawienie pojemników na polu. Ograniczenia wynikają z fizycznych granic plantacji (np. wszystkie współrzędne muszą mieścić się w zakresie od 0 do 100 metrów, jeśli pole ma 100 m długości) oraz z odległości minimalnych między pojemnikami (np. ze względów bezpieczeństwa nie mogą znajdować się zbyt blisko siebie).

Funkcja celu opisuje skuteczność działania rozmieszczenia. Załóżmy, że każdy pojemnik działa w sposób radialny — jego skuteczność maleje z odległością od centrum działania. Możemy przyjąć model, w którym środek owadobójczy działa z pełną skutecznością w promieniu np. 10 m, a dalej jego efektywność spada np. wykładniczo. Dla każdego gniazda obliczamy wtedy skumulowany wpływ wszystkich pojemników i określamy, czy dawka przekracza próg skuteczności. Jeśli tak — gniazdo uznaje się za unieszkodliwione.

W ten sposób funkcja celu przyjmuje postać nieliniową i niegładką: jest to liczba gniazd os, które udało się zneutralizować przy danym ustawieniu pojemników. Funkcja ta może mieć wiele lokalnych maksimów (np. ustawienia pojemników skupiające się na części pola) i dlatego stanowi poważne wyzwanie dla klasycznych metod optymalizacji bazujących na pochodnych.

Dodatkową trudnością jest to, że zmienne są ciągłe, a przestrzeń rozwiązań nie jest prostą siatką — ma nieregularny kształt. Oznacza to, że metody optymalizacji wymagają inteligentnych strategii przeszukiwania, które potrafią unikać minimum lokalnych i są odporne na brak ciągłości lub nieregularność funkcji celu. Algorytmy genetyczne doskonale się w tym sprawdzają — operując populacją rozwiązań i stosując operatory krzyżowania i mutacji, mogą eksplorować różnorodne konfiguracje rozmieszczenia pojemników i z czasem wyłaniać te najbardziej skuteczne.

To przykład zadania nieliniowego z ograniczeniami, gdzie przestrzeń poszukiwań jest ciągła, ale funkcja celu — nieliniowa i trudna do zapisania analitycznie.

Optymalizacja produkcji

Przykład optymalizacji produkcji dotyczy zakładu przemysłowego, który wytwarza dwa rodzaje produktów przy użyciu dwóch różnych procesów technologicznych i dwóch rodzajów surowców: A i B. Zakład musi zaspokoić określone zapotrzebowanie rynkowe (np. 30 jednostek produktu X i 20 jednostek produktu Y), a jednocześnie działa w warunkach ograniczeń zasobów (np. dostępność 60 jednostek surowca A i 90 jednostek surowca B).

Zmiennymi decyzyjnymi są liczby cykli produkcyjnych w procesach I i II, oznaczane jako x₁ i x₂. Każdy cykl zużywa określoną ilość surowców A i B oraz dostarcza określoną liczbę produktów X i Y. Znając macierz współczynników technologicznych (ile surowca zużywa dany proces, ile produktu wytwarza), można sformułować model matematyczny całego systemu produkcyjnego.

Celem jest maksymalizacja zysku — różnicy między przychodem ze sprzedaży produktów a kosztem zużycia surowców. Zakłada się, że produkty X i Y mają znane ceny jednostkowe, a surowce A i B — znane koszty jednostkowe. Funkcja celu to więc wyrażenie liniowe zależne od zmiennych x₁ i x₂. Ograniczenia obejmują:

-

dostępność surowców: łączne zużycie A i B w obu procesach nie może przekroczyć ich dostępnych zasobów,

-

minimalne zamówienia: produkcja X i Y musi pokrywać popyt,

-

nieujemność zmiennych: liczba cykli produkcyjnych nie może być ujemna.

Formalnie jest to typowe zadanie programowania liniowego z ograniczeniami liniowymi. Rozwiązanie można znaleźć metodami klasycznymi (np. Simplex), ale w sytuacjach bardziej złożonych — np. gdy:

-

liczba produktów lub procesów wzrasta,

-

pojawiają się nieliniowe koszty (np. rabaty przy dużych zamówieniach),

-

występują zależności logiczne lub dyskretne zmienne (np. ograniczona liczba maszyn, minimalna seria produkcyjna), warto sięgnąć po algorytmy metaheurystyczne.

Algorytmy genetyczne dobrze radzą sobie w takich warunkach. Dzięki pracy na populacji rozwiązań i mechanizmowi selekcji, krzyżowania oraz mutacji są w stanie znajdować rozwiązania nie tylko poprawne, ale często zaskakująco dobre — zwłaszcza w przestrzeniach rozwiązań, w których metody klasyczne zawodzą lub wymagają znacznego uproszczenia modelu.

Celem jest maksymalizacja zysku. Zmiennymi są liczby cykli produkcyjnych dla obu typów procesów. Ograniczenia obejmują zużycie surowców i wymagania produkcyjne. To typowe zadanie liniowe z ograniczeniami.

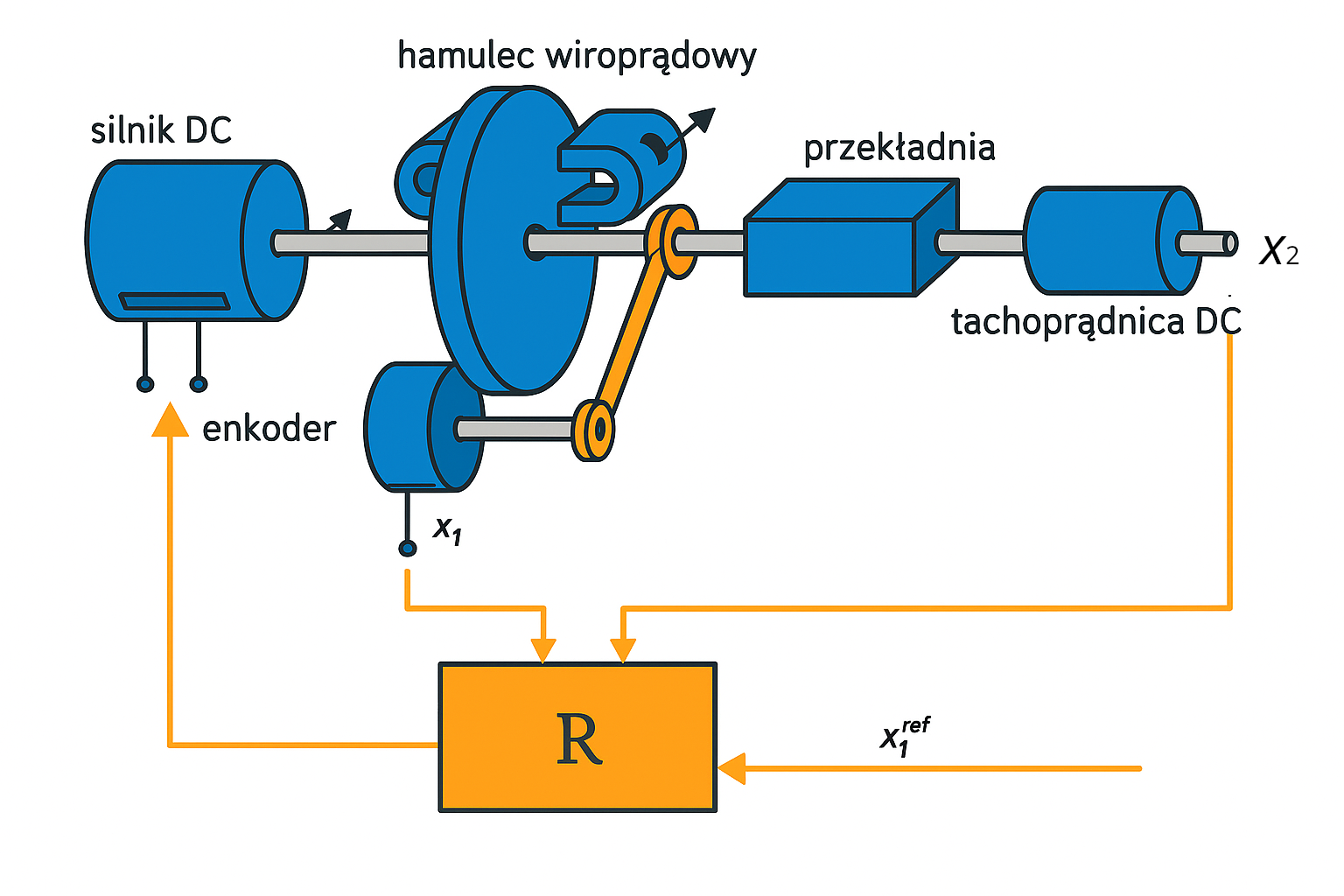

Sterowanie napędem prądu stałego (DC)

Sterowanie napędem prądu stałego to klasyczny problem z zakresu automatyki, w którym celem jest tak dobrać parametry regulatora, aby układ reagował szybko, bez przeregulowań i z jak najmniejszym błędem ustalonym. Tu rozpatrujemy przypadek optymalizacji odpowiedzi skokowej układu napędowego z regulatorem typu PID (proporcjonalno-całkująco-różniczkującego).

Zmiennymi decyzyjnymi w tym zadaniu są trzy współczynniki regulatora PID: Kₚ (wzmocnienie proporcjonalne), Tᵢ (czas całkowania) i Td (czas różniczkowania). To właśnie od ich wartości zależy jakość odpowiedzi układu: czas osiągania wartości zadanej, poziom przeregulowania oraz tłumienie oscylacji.

Aby ocenić jakość działania danego zestawu parametrów, definiujemy funkcję celu, która wyraża kompromis między różnymi wskaźnikami jakości regulacji. Najczęściej stosuje się kombinację:

- całkowego wskaźnika błędu (IAE, ISE lub ITAE),

- czasu regulacji (czas potrzebny do osiągnięcia zadanego poziomu z tolerancją),

- oraz maksymalnego przeregulowania.

W zależności od wag przypisanych poszczególnym składnikom funkcji celu, możemy preferować szybsze dojście do zadanej wartości kosztem większego przeregulowania, lub odwrotnie — stabilność kosztem szybkości.

Symulacja odpowiedzi skokowej dla każdego zestawu parametrów odbywa się numerycznie, najczęściej z użyciem pakietów typu MATLAB/Simulink lub podobnych narzędzi. Funkcja celu ma charakter nieliniowy i czarno-skrzynkowy, co oznacza, że nie jest znana w postaci analitycznej, a jej wartość można jedynie wyznaczyć przez symulację.

To czyni zadanie trudnym dla klasycznych metod optymalizacji gradientowej, ale bardzo dobrze przystosowanym do podejść ewolucyjnych. Algorytmy genetyczne pozwalają swobodnie eksplorować przestrzeń parametrów PID, a ich operatory krzyżowania i mutacji pomagają unikać utkwienia w minimach lokalnych. Dodatkowo, jeśli użyjemy podejścia wielokryterialnego, możemy uzyskać front Pareto przedstawiający kompromisy między czasem regulacji a przeregulowaniem.

Problem sterowania napędem DC ilustruje, jak teoria optymalizacji przekłada się na bardzo praktyczne, inżynierskie zastosowania — od przemysłu po robotykę mobilną i mechatronikę.

Dobór czynników do modelu predykcyjnego cen energii

W dziedzinie analizy szeregów czasowych jednym z ambitniejszych problemów jest przewidywanie przyszłych cen energii na podstawie danych historycznych. Zakładamy, że dysponujemy rozbudowanym zestawem zmiennych wejściowych: historyczne ceny energii, poziomy produkcji energii (np. z wiatru, fotowoltaiki, gazu), wskaźniki inflacyjne, indeksy giełdowe (np. WIG, S&P500), kursy walut (np. EUR/PLN), notowania surowców (ropa, gaz, węgiel), a także dane pogodowe (temperatura, siła wiatru, nasłonecznienie).

Zadanie polega na znalezieniu najlepszego modelu predykcyjnego (np. regresji liniowej, sieci neuronowej, drzewa decyzyjnego), który na podstawie wybranych zmiennych wejściowych pozwoli możliwie najdokładniej przewidzieć cenę energii w przyszłym kroku czasowym. Istotą problemu jest jednak dobór optymalnego podzbioru czynników wejściowych — nie chcemy używać ich wszystkich, ponieważ:

część może nie wnosić informacji (szum),

część może być redundantna,

większy model oznacza większą złożoność i trudność interpretacji.

Zmiennymi decyzyjnymi są tutaj kombinacje czynników wejściowych — problem ma charakter kombinatoryczny, ponieważ dla potencjalnych zmiennych istnieje możliwych podzbiorów. Dla 20 zmiennych to już ponad milion kombinacji. Dodatkowo, możemy rozważać także wybór typu modelu, hiperparametrów, lagów czasowych — co czyni problem jeszcze bardziej złożonym.

Funkcja celu mierzy jakość predykcji — może to być np. średni błąd bezwzględny (MAE), średni błąd kwadratowy (MSE) lub inna miara dopasowania, obliczana na podstawie danych walidacyjnych. Ponieważ funkcja celu nie ma analitycznego wyrazu i zależy od wyników trenowania modelu, mamy do czynienia z czarną skrzynką, którą można ocenić tylko przez symulację lub eksperyment.

Algorytmy genetyczne są doskonale przystosowane do tego typu problemów. Przestrzeń przeszukiwań to zbiory binarne (czy dany czynnik uwzględniamy), a operatory krzyżowania i mutacji pozwalają dynamicznie eksplorować nowe kombinacje. Warianty permutacyjne i wielokryterialne algorytmów pozwalają uwzględniać równocześnie jakość predykcji i prostotę modelu (np. liczbę zmiennych). Dzięki temu można uzyskać front Pareto modeli — od prostych i umiarkowanie skutecznych, po złożone o bardzo wysokiej trafności.

Ten przykład pokazuje, że optymalizacja nie ogranicza się tylko do „fizycznych” problemów inżynierskich, ale odgrywa coraz większą rolę w eksploracji danych, sztucznej inteligencji i nowoczesnej energetyce.

2. Zadanie minimalizacji

W niniejszym rozdziale zajmiemy się bardziej klasycznym podejściem do optymalizacji. Skupimy się przy tym na problemie minimalizacji - co nie powinno być żadnym ograniczeniem ... w praktyce prawie każdy problem polegający na maksymalizacji (np. zysku) można przekształcić w problem minimalizacji, po prostu odwracając znak funkcji celu. No właśnie - a co to jest wspomniana funkcja celu?2.1. Wprowadzenie do problemu minimalizacji

Zanim zaczniemy szukać rozwiązań, warto wiedzieć, czego w ogóle szukamy. W optymalizacji chodzi o znajdowanie najlepszych możliwych rozwiązań dla danego problemu. A w przypadku minimalizacji – po prostu takich, które dają najmniejszą możliwą wartość jakiejś funkcji. To właśnie tę funkcję nazywamy funkcją celu.

Brzmi ogólnie? To dobrze – bo tak naprawdę minimalizować można praktycznie wszystko: czas produkcji, koszt transportu, ryzyko inwestycji, liczbę strat podczas rozładunku, ilość odpadów, czy nawet… liczbę popełnionych błędów przy projektowaniu mostu.

Funkcja celu – czyli co właściwie minimalizujemy?

Funkcja celu to matematyczny sposób na opisanie tego, co chcemy zoptymalizować. Zazwyczaj oznacza się ją jako \(f(x)\), gdzie \(x\) to zestaw tzw. zmiennych decyzyjnych – czyli tego, na co mamy wpływ.

Przykład? Proszę bardzo – wróćmy do zadania z poprzedniego rozdziału, w którym projektowaliśmy prostopadłościenne zbiorniki do transportu chemikaliów. Celem było zminimalizowanie kosztów transportu, a zmiennymi decyzyjnymi były wymiary pojemników (np. wysokość, szerokość i długość). Funkcja celu mogła więc wyglądać np. tak:

\( f(x_1,x_2,x_3)=z*k_j = \frac{V_{całkowita}}{x_1*x_2*x_3} * (km_A \cdot 2(x_2 \cdot x_3) + km_{góra} \cdot (x_1 \cdot x_2) + k_{transport} ) \)

Szukaliśmy takiego zestawu wymiarów, który pozwala przewieźć zadaną objętość przy jak najmniejszym koszcie.

Ograniczenia – bo nie wszystko nam wolno

W rzeczywistości nie da się „po prostu” minimalizować. Zawsze są jakieś ograniczenia. To one wyznaczają granice naszej wolności w doborze zmiennych decyzyjnych. Ograniczenia pilnują, żeby proponowane rozwiązanie miało sens praktyczny, fizyczny, techniczny, ekonomiczny albo formalny.

Ograniczenia możemy podzielić na kilka rodzajów:

-

Twarde (formalne) – muszą być spełnione zawsze. Ich naruszenie oznacza, że rozwiązanie nie ma prawa istnieć. Np.:

-

\(x \geq 0\): długości, czasy, liczby jednostek nie mogą być ujemne,

-

\(\sum x_i = 1\): suma udziałów w portfelu inwestycyjnym musi wynosić 100%,

-

\(T_r \leq 10,\text{s}\): czas regulacji musi być mniejszy niż 10 sekund.

-

-

Miękkie (preferencyjne) – nie są obowiązkowe, ale zalecane. Zwykle wprowadza się je jako dodatkowe funkcje kary. Np.:

-

"unikaj użycia aluminium, jeśli nie jest konieczne",

-

"preferuj rozwiązania o mniejszej liczbie elementów ruchomych".

-

-

Geometryczne / fizyczne – wynikają z fizyki lub geometrii zadania:

-

pojemnik musi się zmieścić w kontenerze,

-

odległość między pojemnikami nie może być mniejsza niż 1 m,

-

długość pręta musi być większa niż 0, ale mniejsza niż 2,5 m.

-

-

Logiczne – np. zakaz inwestowania w firmy z określonego sektora, ograniczenia zgodne z regulaminem czy normą prawną.

W języku matematyki ograniczenia zapisujemy najczęściej jako:

-

nierówności: \(g(x) \leq 0\),

-

równości: \(h(x) = 0\).

W przykładzie portfela inwestycyjnego (z rozdziału 1) ograniczenia wyglądały tak:

-

\(\sum_{i=1}^4 x_i = 1\) – całość kapitału musi być zainwestowana,

-

\(x_i \geq 0\) – nie można inwestować ujemnych pieniędzy,

-

\(\sum_{i=1}^4 x_i \mu_i \geq 0.1\) – oczekiwany zysk powyżej 10%.

W przykładzie sterowania napędem, ograniczenia dotyczyły:

-

zakresów parametrów regulatora PID (np. \(K_r \in [0.1, 2.5]\)),

-

dopuszczalnych wartości odchyłki regulacji (\(e_\infty \leq 0.05\) mm),

-

fizycznych ograniczeń wynikających z modelu siłownika.

A w zadaniu rozmieszczenia pojemników z insektycydem mieliśmy np.:

-

pozycje pojemników musiały mieścić się na polu uprawnym,

-

minimalna odległość między nimi musiała gwarantować efektywne działanie,

-

niektóre rejony mogły być wykluczone ze względów bezpieczeństwa.

Dobre zdefiniowanie ograniczeń to często połowa sukcesu – od nich zależy, czy algorytm będzie przeszukiwał rozsądny obszar przestrzeni, czy błądził w miejscach kompletnie nieużytecznych.

Przestrzeń poszukiwań i rozwiązań dopuszczalnych

Zmiennych decyzyjnych zwykle jest kilka lub kilkanaście. Ich wszystkie możliwe kombinacje tworzą tzw. przestrzeń poszukiwań – czyli wszystkie teoretycznie dostępne rozwiązania.

Ale tylko część z nich spełnia wszystkie ograniczenia – i to właśnie ta część nazywa się przestrzenią rozwiązań dopuszczalnych. Przykładowo: możemy mieć 10 miliardów potencjalnych rozwiązań, ale tylko 5 milionów z nich spełnia warunki techniczne, prawne albo biznesowe.

Z punktu widzenia algorytmu optymalizacyjnego najważniejsze pytanie brzmi:

Przykłady z życia – optymalizacja jako chleb powszedni

Spróbujmy wrócić do przykładów z poprzedniego rozdziału:

-

Portfel inwestycyjny – minimalizujemy ryzyko inwestycji (wariancję zysków), ale przy założeniu, że średni zysk musi wynosić co najmniej 10%. Zmiennymi decyzyjnymi są udziały różnych aktywów. Ograniczenia? Łączna suma udziałów = 100%, żaden nie może być ujemny, zysk powyżej 10%.

-

Rozmieszczenie pojemników z insektycydem na polu – minimalizujemy liczbę przeżywających os (czyli maksymalizujemy skuteczność środka). Zmiennymi są współrzędne pojemników, a ograniczenia wynikają z rozmiarów pola, działania środka, bezpiecznych odległości.

-

Sterowanie napędem – minimalizujemy czas reakcji albo przeregulowanie, dbając o to, żeby układ był stabilny. Ograniczenia: dopuszczalne zakresy parametrów regulatora, wymogi na odpowiedź skokową, granice fizyczne układu.

Wszystkie te zadania są przykładami problemów minimalizacji, które pojawiają się w prawdziwej inżynierii, ekonomii i logistyce. A skoro już wiemy, że są – czas dowiedzieć się, jak się za nie zabrać.

2.2. Przestrzeń ciągła i dyskretna - czyli gdzie szuka algorytm

Zanim zaczniemy wybierać konkretne algorytmy optymalizacji, musimy się zastanowić: jak wygląda przestrzeń, w której będziemy szukać rozwiązań? To jedno z najważniejszych pytań, jakie należy sobie zadać w kontekście minimalizacji.

Przestrzeń poszukiwań – nie tylko zbiór liczb

W poprzednim rozdziale wprowadziliśmy pojęcie przestrzeni poszukiwań – zbioru wszystkich możliwych konfiguracji zmiennych decyzyjnych. Teraz dodajmy coś istotnego: ten zbiór może mieć bardzo różną strukturę.

Najczęściej spotykamy dwie sytuacje:

-

zmienne decyzyjne mogą przyjmować wartości ciągłe – np. długość pręta w metrach: 1.37 m, 2.03 m, 0.88 m, itd.

-

lub wartości dyskretne – np. wybór trasy w problemie komiwojażera, rozmieszczenie urządzeń na siatce, przypisanie pracowników do zadań.

Niektóre problemy można też przedstawić jako mieszane – część zmiennych jest ciągła, a część dyskretna. Takie przypadki są typowe np. w inżynierii procesowej.

Przestrzeń ciągła – gładka, ale nie zawsze łatwa

Przestrzeń ciągła to taka, w której zmienne mogą przyjmować dowolne wartości z pewnego przedziału. Matematycznie mówimy wtedy, że \(x \in \mathbb{R}^n\).

Zaletą przestrzeni ciągłej jest to, że możemy używać narzędzi analizy matematycznej – np. obliczać pochodne, badać gradienty, korzystać z metod iteracyjnych typu Newtona czy spadku gradientu. Tyle że jest pewien haczyk: takie metody zakładają gładkość funkcji celu (czyli że nie ma skoków, ostrych minimów ani zerwań ciągłości).

Problemy:

-

minimum może być lokalne, a nie globalne,

-

funkcja może być „płaska” – przez co gradient nic nie mówi,

-

ograniczenia mogą tworzyć bardzo wąskie lub nieregularne obszary.

Przestrzeń dyskretna – przeliczalna, ale ogromna

Z kolei przestrzeń dyskretna to taka, w której zmienne mogą przyjmować jedynie określone, policzalne wartości – np. liczby całkowite, ciągi permutacji, konfiguracje binarne.

Przykład:

-

Problem komiwojażera: przestrzeń to zbiór wszystkich permutacji miast (czyli $n!$ możliwości).

-

Alokacja pracowników do zmian: przestrzeń to zbiór możliwych macierzy przydziału z warunkami logicznymi.

Zaletą przestrzeni dyskretnej jest to, że nie potrzebujemy pochodnych, a każdy punkt jest „jednostką”, którą da się jednoznacznie opisać. Ale przestrzenie dyskretne rosną wykładniczo – tzn. liczba możliwych rozwiązań może szybko przekroczyć zdolność obliczeniową nawet dużych komputerów.

Problemy:

-

przeszukiwanie wyczerpujące staje się niemożliwe,

-

często nie ma pojęcia "bliskich" rozwiązań – trudno stosować pojęcie lokalnego minimum,

-

konieczne są sprytne strategie eksploracji (np. losowe skoki, heurystyki).

Różnice w optyce algorytmów

Wybór algorytmu powinien być dostosowany do rodzaju przestrzeni, bo algorytmy myślą (a raczej "liczą") w zupełnie inny sposób zależnie od tego, czy mają do czynienia z przestrzenią ciągłą czy dyskretną.

W przestrzeni ciągłej algorytmy często opierają się na lokalnej analizie funkcji celu:

szukają kierunku największego spadku (gradient),

opierają się na pochodnych, macierzy Hessego lub metodach quasi-Newtona,

iteracyjnie poprawiają rozwiązanie w stronę minimum,

zakładają pewną gładkość i regularność przestrzeni.

Typowe algorytmy:

metoda największego spadku,

metoda Newtona i quasi-Newtona (BFGS),

algorytmy ewolucyjne z kodowaniem rzeczywistoliczbowym.

W przestrzeni dyskretnej wszystko wygląda inaczej:

nie mamy pojęcia o "nachyleniu", bo między punktami nie istnieje pojęcie pochodnej,

bliskość rozwiązań nie zawsze przekłada się na podobieństwo funkcji celu,

konieczne są inne strategie eksploracji: permutacje, losowanie, heurystyki lokalne.

Typowe podejścia:

algorytmy zachłanne i lokalne przeszukiwanie (hill climbing),

algorytmy metaheurystyczne: symulowane wyżarzanie, algorytmy genetyczne,

strategie oparte na populacjach i losowym próbkowaniu.

Przykład porównawczy

Załóżmy, że projektujemy most i chcemy:

-

w przestrzeni ciągłej: dobrać grubości, długości i przekroje belek,

-

w przestrzeni dyskretnej: wybrać z katalogu gotowe komponenty (typu prefabrykaty).

Pierwszy problem daje więcej swobody, ale może prowadzić do rozwiązań nierealnych. Drugi wymaga kompromisów, ale łatwiej go uwzględnić w kosztorysie i harmonogramie.

2.3. Klasyczne metody przeszukiwania – od pełnego przeglądu po losowe strzały

Zanim rzucimy się w wir algorytmów ewolucyjnych, warto poznać kilka klasycznych podejść do przeszukiwania przestrzeni rozwiązań. Choć czasem uznawane za przestarzałe, wciąż stanowią punkt odniesienia dla każdej bardziej zaawansowanej metody. W tym podrozdziale skupimy się na przestrzeni dyskretnej – czyli takiej, gdzie liczba możliwych rozwiązań jest skończona (choć może być bardzo duża).

Przeszukiwanie pełne (brute force)

Najbardziej oczywista metoda: sprawdź wszystkie możliwe rozwiązania i wybierz najlepsze. Działa idealnie... pod warunkiem, że masz do przeszukania małą przestrzeń. Niestety, w praktyce:

- liczba możliwych rozwiązań rośnie wykładniczo z liczbą zmiennych,

- przy nawet kilku zmiennych dyskretnych zakres możliwości może sięgać miliardów,

- szybko przekraczamy możliwości obliczeniowe dostępnego sprzętu.

Przykład: jeśli mamy 10 zmiennych całkowitych przyjmujących po 10 wartości, to mamy \(10^{10} = 10,000,000,000\) rozwiązań.

Zalety:

- gwarantuje znalezienie najlepszego rozwiązania (jeśli istnieje),

- działa niezależnie od natury funkcji celu,

- bardzo prosta implementacja.

Wady:

- totalnie niepraktyczne dla większych problemów,

- nie wykorzystuje żadnej wiedzy o strukturze przestrzeni.

Przeszukiwanie losowe

Zamiast sprawdzać wszystko – losujemy. Algorytm losowy wybiera kolejne rozwiązania zupełnie przypadkowo z przestrzeni dyskretnej i ocenia ich jakość. Jeśli uda się znaleźć dobre – super. Jeśli nie – próbujemy dalej.

Jak to wygląda w praktyce:

- losujemy rozwiązanie \(x\),

- obliczamy wartość funkcji celu \(f(x)\),

- zapamiętujemy najlepszy wynik dotąd,

- powtarzamy przez ustaloną liczbę iteracji.

Zalety:

- prostota implementacji – dosłownie kilka linijek kodu,

- możliwość działania równoległego (każdy proces może losować osobno),

- działa w każdej przestrzeni dyskretnej (nie wymaga żadnych założeń).

Wady:

- zupełna przypadkowość – możemy długo błądzić zanim trafimy coś sensownego,

- nie wykorzystuje wiedzy z poprzednich prób – "ślepe strzelanie",

- nie gwarantuje znalezienia rozwiązania lepszego od startowego.

Mimo wad, algorytmy losowe bywają zaskakująco skuteczne w przestrzeniach, gdzie lokalne strategie często wpadają w minima lokalne – np. przy wielu zaporowych ograniczeniach.

Przeszukiwanie losowe z pamięcią

Wariant bardziej zaawansowany: próbujemy wykorzystać doświadczenia z poprzednich losowań. Czyli: pamiętamy coś o przeszłości i nie działamy całkiem na oślep. Oto dwie popularne techniki:

Symulowane wyżarzanie (simulated annealing)

Metoda inspirowana procesami fizycznymi – konkretnie wyżarzaniem metali. Algorytm:

- zaczyna od losowego rozwiązania,

- losowo modyfikuje je (tworzy sąsiada),

- jeśli sąsiad jest lepszy – przyjmuje go,

- jeśli jest gorszy – może go przyjąć z pewnym prawdopodobieństwem \(p = e^{-\Delta f / T}\),

- temperatura \(T\) maleje w czasie – co zmniejsza prawdopodobieństwo akceptowania gorszych rozwiązań.

To podejście pozwala wyjść z minimum lokalnego, ale z czasem staje się coraz bardziej zachowawcze – koncentruje się na najlepszych rozwiązaniach.

Algorytm tabu (tabu search)

Tutaj z kolei prowadzimy rodzaj "czarnej listy" – pamiętamy, gdzie już byliśmy i unikamy powtórek. Algorytm:

- przechodzi od rozwiązania do jego najlepszego sąsiada,

- jeśli sąsiad był niedawno odwiedzony – jest oznaczany jako tabu (czyli zakazany),

- lista tabu działa jak bufor cykliczny (np. ostatnie 100 odwiedzin),

- pozwala to uniknąć cyklicznego krążenia wokół tego samego minimum.

Algorytmy z pamięcią są inteligentniejszą odmianą przeszukiwania losowego – uczą się w czasie, nie pozwalają wracać do kiepskich punktów, próbują eksplorować nowe rejony przestrzeni.

Dyskretyzowane problemy ciągłe

W tym rozdziale skupiliśmy się na problemach dyskretnych, ale czy nie da się tego zastosować dla czasu ciągłego? Pewnie się da ... przecież komputery w naturalny sposób nie są w stanie pamiętać liczb rzeczywistych, ale rozwiązują problemy z nimi związane. Można więc działać tak jak typowy system cyfrowy - zastosować podejście zwane dyskretyzacją przestrzeni ciągłej.

Jak to działa:

- dzielimy przestrzeń ciągłą na siatkę (np. co 0.1 jednostki),

- traktujemy punkty siatki jako osobne, dyskretne rozwiązania,

- stosujemy klasyczne metody dyskretne (np. losowe przeszukiwanie, tabu search).

Zalety:

- umożliwia stosowanie metod dyskretnych tam, gdzie oryginalnie są zmienne ciągłe,

- pozwala testować algorytmy bez potrzeby obliczania pochodnych.

Wady:

- precyzja zależy od gęstości siatki – im dokładniej, tym więcej punktów do przeszukania,

- może prowadzić do pomijania istotnych cech funkcji celu (np. minimów między węzłami siatki).

2.4. Algorytmy gradientowe - matematyczna droga w dół ...

W przypadku optymalizacji w przestrzeni ciągłej, jedną z najstarszych i najbardziej klasycznych grup metod są algorytmy gradientowe. Ich zasada działania opiera się na założeniu, że funkcja celu jest gładka – czyli ciągła i różniczkowalna.

Intuicja: jak zejść po schodach w ciemności

Wyobraź sobie, że stoisz na środku zbocza i chcesz zejść na sam dół. Nie widzisz całej doliny – widzisz tylko to, co masz bezpośrednio wokół siebie. Możesz dotknąć ziemi wokół i ocenić, gdzie jest najstromiej w dół – i właśnie w tę stronę zrobisz krok. To właśnie jest gradient: wektor wskazujący kierunek najszybszego spadku wartości funkcji.

Gradient i krok

Jeśli funkcja celu to \(f(x)\), a \(x \in \mathbb{R}^n\), to gradient to:

\( \nabla f(x) = \left[ \frac{\partial f}{\partial x_1}, \ldots, \frac{\partial f}{\partial x_n} \right] \)

Podstawowa iteracyjna formuła wygląda następująco:

\( x_{k+1} = x_k - \alpha \nabla f(x_k) \)

- \(x_k\) to punkt aktualny,

- \(\alpha\) to współczynnik uczenia (długość kroku),

- \( \nabla f(x_k)\) to gradient w punkcie \(x_k\).

Metoda największego spadku

To najprostszy algorytm gradientowy. Za każdym razem idziemy w kierunku przeciwnym do gradientu – czyli w stronę, gdzie funkcja maleje najszybciej. W praktyce ważne jest dobranie odpowiedniej wartości \(\alpha\), bo:

- zbyt duży krok może przeskoczyć minimum,

- zbyt mały krok prowadzi do powolnej zbieżności.

Metoda Newtona i quasi-Newtona

Metoda Newtona wykorzystuje nie tylko gradient, ale też drugą pochodną – tzw. hesjan (macierz drugich pochodnych cząstkowych):

\[ H(x) = \left[ \frac{\partial^2 f}{\partial x_i \partial x_j} \right] \]

Formuła iteracyjna:

\[ x_{k+1} = x_k - H^{-1}(x_k) \nabla f(x_k) \]

Dlaczego druga pochodna daje nam przewagę? Bo zawiera informację o krzywiźnie funkcji celu. Gradient mówi tylko, w którą stronę funkcja maleje – ale nie mówi, jak szybko. Hesjan dostarcza wiedzy o tym, jak zakrzywiona jest funkcja w danym punkcie. Dzięki temu można:

- lepiej dobrać długość kroku (adaptacyjnie, zamiast na sztywno),

- szybciej zbliżyć się do minimum – zwłaszcza w pobliżu punktu optymalnego,

- unikać efektu "zygzakowania" w przypadku funkcji o bardzo różnych krzywiznach w różnych kierunkach.

Warunki stopu

W algorytmach gradientowych zatrzymujemy się, gdy:

- \(\| \nabla f(x_k) \| < \epsilon\) – gradient jest prawie zerowy,

- \(\| x_{k+1} - x_k \| < \delta\) – zmiana rozwiązania jest minimalna,

- osiągnięto maksymalną liczbę iteracji.

Ograniczenia i trudności

- Minimum lokalne – mogą "utknąć" w lokalnym minimum, nie docierając do globalnego,

- Brak gładkości – jeśli funkcja celu nie jest różniczkowalna, nie możemy użyć pochodnych,

- Siodła i płaskowyże – gradient może nie prowadzić w dobrą stronę.

Przykłady zastosowań

- Optymalizacja kształtów elementów mechanicznych,

- Minimalizacja strat w sieciach neuronowych (np. SGD w ML),

- Wyznaczanie parametrów modeli analitycznych,

- Problemy portfela inwestycyjnego, gdzie funkcja ryzyka i zwrotu ma formę analityczną.

W kolejnym rozdziale zobaczymy, jak w algorytmach klasycznych i gradientowych można wprowadzać ograniczenia – zarówno twarde (jawne) jak i miękkie (np. kary za przekroczenie dopuszczalnego zakresu).

2.5. Uwzględnianie ograniczeń w optymalizacji – kiedy nie wszystko wolno

Uwzględnianie ograniczeń w optymalizacji – kiedy nie wszystko wolno

W większości realistycznych problemów optymalizacyjnych nie możemy swobodnie dobierać zmiennych – jesteśmy ograniczeni przez warunki fizyczne, ekonomiczne, prawne czy techniczne. W tym rozdziale przyjrzymy się, jak klasyczne algorytmy radzą sobie z ograniczeniami. Omówimy metody jawne i niejawne, twarde i miękkie, dokładne i przybliżone.

Rodzaje ograniczeń

Zacznijmy od klasyfikacji. Ograniczenia w problemie optymalizacji można zapisać jako:

- Ograniczenia równościowe: \(h_i(x) = 0\)

- Ograniczenia nierównościowe: \(g_j(x) \leq 0\)

Mogą one dotyczyć jednej zmiennej lub całego ich zestawu, np. \(x_i \in [a_i, b_i]\).

Z punktu widzenia praktyki dzieli się je na:

- twarde (hard) – muszą być spełnione bez wyjątku,

- miękkie (soft) – można je naruszyć, ale z konsekwencjami (np. kara w funkcji celu).

Dodatkowo, wyróżniamy:

- ograniczenia jawne – znane i zapisane bezpośrednio,

- ograniczenia niejawne – wynikające z ukrytej logiki zadania lub symulacji.

Przypomnijmy sobie zadanie z rozdziału 2.1, gdzie projektowaliśmy prostopadłościenne zbiorniki na chemikalia. Naszą funkcją celu był koszt transportu, a zmiennymi decyzyjnymi były wymiary pojemników.

W tym przypadku ograniczenia obejmowało:

- \(x_1, x_2, x_3 > 0\) – bo pojemniki muszą mieć dodatnie rozmiary,

- ( \(2*x_1*x_3+x_1*x_2 \leq 10 \) - bo nie można zużyć za dużo materiału z recyklingu na jedno pudełko,

Metoda eliminacji – tylko to, co dopuszczalne

Najprostsza strategia to nie wpuszczać do przestrzeni przeszukiwania żadnego punktu, który nie spełnia ograniczeń. To tzw. metoda eliminacji (feasibility filter).

Jak to działa?

- Generujemy kandydatów (np. losowo lub iteracyjnie),

- Sprawdzamy, czy spełniają wszystkie ograniczenia,

- Jeśli nie – odrzucamy i szukamy dalej.

Zalety:

- prostota,

- 100% pewności, że rozwiązania są dopuszczalne.

Wady:

- może być ekstremalnie nieefektywna, jeśli dopuszczalna przestrzeń jest wąska,

- problematyczna w przestrzeniach ciągłych o trudnych ograniczeniach geometrycznych.

Metoda ta jest powszechna w prostych algorytmach przeszukiwania losowego.

Kara - niedobrze jak opuścisz obszar poszukiwań

Inna popularna strategia to włączenie ograniczeń do funkcji celu w postaci dodatkowej kary (penalty function). To pozwala naruszać ograniczenia, ale z kosztami.

Nowa funkcja celu ma postać:

\(f'(x) = f(x) + P(x)\)

gdzie \( P(x) \) to funkcja kary, np.:

\(P(x) = \sum_{i} r_i \cdot \max(0, g_i(x))^2 + \sum_{j} s_j \cdot h_j(x)^2\)

Parametry \(r_i\) i /(s_j\) to współczynniki kar. Ich dobór jest krytyczny – zbyt małe kary powodują lekceważenie ograniczeń, zbyt duże całkowicie blokują eksplorację.

Zalety:

- łatwa do zastosowania w istniejących algorytmach,

- działa także z funkcjami niegładkimi.

Wady:

- trudność w doborze wag kary,

- ryzyko, że dobre rozwiązania dopuszczalne będą pominięte, jeśli punkt niedopuszczalny ma niską wartość oryginalnej funkcji celu.

Metoda barier – podejście od wewnątrz

Alternatywą dla kar jest metoda barier, szczególnie w przestrzeni ciągłej. Zamiast pozwalać wejść do strefy niedozwolonej, bariera zapobiega zbliżaniu się do granicy dopuszczalności.

Typowa postać funkcji barierowej:

\[ f'(x) = f(x) + \mu \cdot \sum_j \frac{1}{-g_j(x)} \]

Bariera działa tylko dla punktów wewnątrz dopuszczalnego obszaru – im bliżej granicy, tym kara większa. to współczynnik kontrolujący siłę działania bariery.

Zalety:

- zachowujemy się "bezpiecznie", nie przekraczając granic,

- sprzyja optymalizacji wewnątrz trudnych wielowymiarowych obszarów.

Wady:

- nie działa dla równości,

- wymaga funkcji różniczkowalnej i pochodnych,

- może prowadzić do utknięcia daleko od minimum globalnego.

Metody rzutowania – powrót na ścieżkę

Jeśli w kolejnych krokach algorytmu zdarza się, że punkt wyjdzie poza dopuszczalną przestrzeń, możemy go ręcznie przywrócić do niej – poprzez tzw. rzutowanie.

Mamy ograniczenie \( x \in [0,1] \). Jeśli nowy punkt \( x_k = 1.3 \), to zamiast odrzucić, robimy ustawiamy \( x_k = 1.0 \).

Rzutowanie działa na granicy dopuszczalności i zachowuje sens matematyczny przeszukiwania.

Zalety:

- prosta implementacja,

- pozwala używać standardowych algorytmów nawet w obecności ograniczeń.

Wady:

- może prowadzić do "ślizgania się" po granicy,

- nie uwzględnia geometrii problemu.

Naprawianie (repair) – sprytna korekta

Zamiast odrzucać lub karać – można próbować naprawiać niedopuszczalne rozwiązania. Np. jeśli suma udziałów w portfelu przekracza 100%, można je przeskalować. Jeśli punkt leży poza granicą, można przesunąć go najkrótszą drogą do wnętrza.

Zalety:

- elastyczne i skuteczne w praktyce,

- pozwala korzystać z silnych heurystyk bez komplikowania algorytmu.

Wady:

- często wymaga znajomości problemu i specjalnych procedur,

- może zaburzać rozkład rozwiązań (np. w metodach losowych).

Metody hybrydowe i adaptacyjne

W rzeczywistości często stosuje się kombinacje powyższych metod:

- kara + rzutowanie,

- bariera + naprawianie,

- kara adaptacyjna – która zmienia siłę działania w czasie (np. rośnie w miarę trwania optymalizacji).

Szczególnie algorytmy ewolucyjne często korzystają z adaptacyjnych funkcji kary, które uwzględniają np. liczbę spełnionych ograniczeń w danej populacji.

Uwagi praktyczne

Dobór odpowiedniej strategii postępowania z ograniczeniami w optymalizacji zależy od wielu czynników. Przede wszystkim trzeba wziąć pod uwagę naturę problemu: czy mamy do czynienia z przestrzenią ciągłą, gdzie możemy wykorzystać pochodne i gładkość funkcji celu, czy z przestrzenią dyskretną, gdzie takie założenia nie obowiązują. Problemy ciągłe z ograniczeniami równościowymi wymagają często stosowania metod analitycznych lub przybliżających – na przykład przez przekształcenie równości w funkcje kary kwadratowe. W przypadku ograniczeń nierównościowych dobrze sprawdzają się metody barierowe lub adaptacyjne kary. Z kolei w przestrzeniach dyskretnych bardziej praktyczne okazują się metody naprawcze lub prosta eliminacja rozwiązań niedopuszczalnych.

Ważną rolę odgrywa także geometria przestrzeni rozwiązań – w niektórych problemach dopuszczalny obszar jest nieregularny, pełen dziur i nieciągłości. W takich przypadkach warto rozważyć metody rzutowania lub adaptacyjne przekształcanie przestrzeni przeszukiwania. W praktyce inżynierskiej, zwłaszcza w dziedzinach takich jak projektowanie mechaniczne, inżynieria materiałowa czy chemiczna, dobrze działa połączenie strategii optymalizacji z wiedzą ekspercką. Na przykład zamiast jedynie penalizować naruszenie granic geometrycznych, można wprowadzić sprytne algorytmy naprawcze, które przekształcają rozwiązania w realne i wykonalne, zgodnie z zasadami fizyki czy standardami technicznymi.

Warto też zauważyć, że sposób traktowania ograniczeń może wpływać nie tylko na skuteczność optymalizacji, ale również na jakość znalezionych rozwiązań – zwłaszcza w problemach, gdzie między ograniczeniami a funkcją celu istnieje subtelna zależność. Dlatego wybór metody powinien być dokonywany świadomie, w oparciu o analizę problemu, a nie przez przyzwyczajenie czy wygodę implementacyjną. (np. optymalizacja konstrukcji) warto wspomagać się informacjami z domeny.

3. Algorytmy genetyczne

W tym rozdziale przejdziemy już do klasycznych algorytmów genetycznych

3.1. Historia

Badania nad genetyką

Choć same zasady dziedziczności były obserwowane i opisywane znacznie wcześniej – wystarczy wspomnieć prace Grzegorza Mendla z połowy XIX wieku dotyczące krzyżówek grochu – to prawdziwa eksplozja wiedzy na temat genów i mechanizmów dziedziczenia rozpoczęła się dopiero w XX wieku. W 1910 roku po raz pierwszy wprowadzono pojęcie genu, jako najmniejszej, abstrakcyjnej jednostki dziedziczenia, odpowiedzialnej za pojawianie się określonych cech u organizmów. Początkowo nie było wiadomo, z czego ten gen się składa ani jak dokładnie działa – rozumiano go bardziej jako koncepcję niż konkretną strukturę biologiczną.

Tymczasem jeszcze wcześniej, bo w 1869 roku, niemiecki chemik Johann Friedrich Miescher, badając skład chemiczny jąder komórkowych, wyizolował substancję, którą nazwał „nukleiną”. Dziś wiemy, że była to forma DNA. Nie potrafiono jeszcze wtedy przypisać jej roli nośnika informacji genetycznej – dopiero z czasem okazało się, że to właśnie ten „niepozorny kwas” zapisuje wszystko, co dotyczy budowy i działania organizmów.

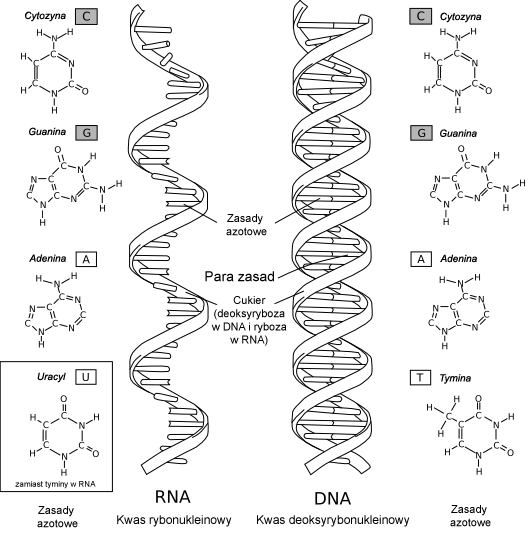

Punktem zwrotnym dla współczesnej genetyki był rok 1953. Wtedy to James Watson i Francis Crick – bazując m.in. na danych rentgenowskich Rosalind Franklin – opisali strukturę DNA jako podwójną helisę zbudowaną z czterech typów nukleotydów: adeniny (A), tyminy (T), guaniny (G) i cytozyny (C). Dzięki ustaleniu reguł łączenia się tych cząsteczek (A z T, G z C) zrozumiano, jak możliwe jest kopiowanie i przechowywanie informacji genetycznej.

Źródło - wikipedia

Z czasem poznano kolejne etapy „przepływu” informacji w organizmach żywych:

- Replikacja – czyli tworzenie kopii DNA, co umożliwia przekazywanie informacji do komórek potomnych, a więc i dziedziczenie cech.

- Transkrypcja – przepisanie fragmentu DNA na RNA, czyli swoistą roboczą kopię zawierającą instrukcję.

- Translacja – przetworzenie RNA w łańcuch aminokwasów, z których powstają białka, a więc budulec i „narzędzia” komórek.

W skrócie – DNA to nie tylko „kod”, ale raczej cały system zapisu, kompilacji i wykonania. Oczywiście, w genach zaszyte są też inne mechanizmy – jak mutacje (czyli losowe zmiany w zapisie) oraz mechanizmy naprawcze. Wszystko to razem stworzyło bazę wiedzy, która pozwoliła nie tylko lepiej zrozumieć życie, ale też zainspirować informatyków do tworzenia nowych metod optymalizacji – takich jak właśnie algorytmy genetyczne.

Teoria ewolucji

Gdy spojrzymy wstecz na historię biologii, zobaczymy, że jedną z najbardziej rewolucyjnych idei była teoria ewolucji przez dobór naturalny, zaproponowana przez Karola Darwina w połowie XIX wieku. W swoim dziele „O powstawaniu gatunków” Darwin zaproponował odważną myśl: że wszystkie organizmy żywe pochodzą od wspólnego przodka, a zmiany w ich cechach są wynikiem długotrwałego, stopniowego procesu selekcji.

Ewolucja – jak zauważył Darwin – działa trochę jak bardzo powolny, naturalny „algorytm”: losowe zmiany (mutacje) pojawiają się w populacji, a środowisko „ocenia”, które cechy są korzystne, a które nie. Organizmy o korzystniejszych cechach mają większą szansę na przeżycie i rozmnożenie się – czyli przekazanie tych cech dalej. To właśnie nazywamy doborem naturalnym. Główne filary teorii ewolucji to:

- Organizmy są śmiertelne – nie każdy przeżyje, więc istnieje presja selekcyjna.

- Rozmnażają się – ale ich potomstwo nie jest identyczne (istnieje zmienność).

- Cechy są dziedziczone – czyli potomstwo dziedziczy część cech od rodziców.

- Środowisko jest ograniczone – nie wystarczy zasobów dla wszystkich, więc trwa rywalizacja.

Warto podkreślić, że dobór naturalny działa niezależnie od jakiejkolwiek inteligencji czy celu – to czysty mechanizm statystyczny. Ale jego efekty – przystosowania, strategie przetrwania, niezwykłe złożone formy życia – są tak zaskakujące, że aż proszą się o porównania z projektowaniem.

Teoria ewolucji doczekała się wielu potwierdzeń – od badań nad muszką owocową, przez zapis kopalny, aż po symulacje komputerowe. I właśnie to ostatnie stało się punktem wyjścia dla informatyków i inżynierów: skoro natura potrafi znaleźć dobre (czasem zaskakująco dobre!) rozwiązania, to może warto od niej pożyczyć kilka sztuczek?

Syntetyczna teoria ewolucji

Na styku dwóch wielkich teorii – genetyki i darwinowskiej ewolucji – narodziło się podejście znane jako syntetyczna teoria ewolucji. To właśnie ono stanowi bezpośrednią inspirację dla algorytmów genetycznych, które stosujemy dziś w optymalizacji.

Syntetyczna teoria mówi: ewolucja to nie tylko „przetrwają najlepiej dostosowani”, ale cały złożony system oparty na:

- mutacjach – czyli losowych, często niewielkich zmianach w genotypie, które mogą prowadzić do nowych cech,

- rekombinacji – wymieszaniu materiału genetycznego dwóch organizmów (czyli krzyżowaniu),

- selekcji – w tym dobór naturalny, ale też np. seksualny, sztuczny, stabilizujący, itd.,

- dziedziczeniu – czyli transmisji informacji do potomstwa.

To wszystko razem tworzy „algorytm” przyrody, który jest zdolny – bez nadzoru, bez projektanta – tworzyć rozwiązania trudnych problemów przetrwania. Brzmi znajomo?

Takie właśnie podejście zostało zaadaptowane do tworzenia algorytmów genetycznych. Informatycy zrobili to, co najlepiej potrafią: formalizowali obserwacje, zdefiniowali pojęcia (osobnik, populacja, gen, funkcja celu), i zaczęli symulować ten proces. Algorytmy genetyczne tworzą sztuczne populacje rozwiązań, poddają je działaniu krzyżowania, mutacji, selekcji – i patrzą, co z tego wyjdzie.

Z czasem pojawiły się całe rodziny algorytmów ewolucyjnych (np. strategie ewolucyjne, programowanie ewolucyjne, algorytmy rojowe). Ale to właśnie genetyka – z jej strukturą DNA, z jej ideą genotypu i fenotypu – była tą najpierwszą, najbardziej inspirującą bazą.

Dzięki syntetycznej teorii ewolucji mamy dziś nie tylko lepsze zrozumienie przyrody, ale też potężne narzędzia optymalizacyjne, które z powodzeniem stosujemy w inżynierii, robotyce, finansach, a nawet sztuce.

3.2. Klasyczny algorytm genetyczny

Zgodnie z definicją podaną przez Goldberga (1995), algorytmy genetyczne stanowią klasę algorytmów poszukujących, które opierają swoje działanie na inspiracji mechanizmami znanymi z biologii: dziedzicznością oraz doborem naturalnym. Ich funkcjonowanie odzwierciedla sposób, w jaki ewolucja kształtuje populacje organizmów w naturze.

W ramach tego podejścia, algorytm operuje na całej populacji potencjalnych rozwiązań danego problemu – a nie tylko na pojedynczym rozwiązaniu, jak ma to miejsce w klasycznych metodach optymalizacji. Każdy osobnik w tej populacji stanowi konkretną propozycję rozwiązania. Osobniki funkcjonują w środowisku - które umożliwia ocenianie i porównywanie osobników, i jest zależne od funkcji celu. Każdy osobnik ma przyporządkowaną wartość liczbową, nazywaną stopniem przystosowania lub po prostu przystosowaniem. Przystosowanie określa bezpośrednio jakość danego osobnika, i zazwyczaj jest ona wyliczana na na podstawie funkcji celu, odpowiadającej konkretnemu zadaniu optymalizacyjnemu.

W naturze przetrwanie i możliwość rozmnażania się zależy od tego, jak dobrze organizm radzi sobie w danym środowisku. Im lepiej jest przystosowany, tym większe ma szanse na przekazanie swoich genów potomstwu. AG próbują wykorzystać tę ideę do rozwiązywania problemów optymalizacyjnych. Szukają rozwiązań, które w danym kontekście mają największe "szanse przetrwania" – czyli są najlepsze w sensie przyjętej funkcji celu.

Zamiast operować tylko na jednym kandydacie rozwiązania (jak robi to wiele klasycznych metod), AG pracują na całej populacji. Każdy osobnik tej populacji to konkretne rozwiązanie problemu – lepsze lub gorsze. W każdej iteracji (czyli pokoleniu) populacja ewoluuje: osobniki są selekcjonowane, krzyżowane, poddawane mutacjom. Dzięki temu, z pokolenia na pokolenie, jakość populacji (czyli jakość rozwiązań) zwykle się poprawia.

Genotyp i fenotyp – czym się różnią?

W AG każdy osobnik opisuje potencjalne rozwiązanie zadania, ale żeby algorytm mógł nad tym pracować, musi jakoś je zapisać. Dlatego stosuje się dwa poziomy reprezentacji:

-

Genotyp to zakodowana forma rozwiązania. Można o nim myśleć jak o "DNA" osobnika. Zwykle jest to wektor (lista) liczb, np.:

g = [g1, g2, ..., gng]W zależności od problemu, te liczby mogą być bitami (0 lub 1), wartościami rzeczywistymi, permutacjami elementów itd. Algorytm operuje właśnie na genotypie – krzyżuje go, mutuje itd. Sama forma genotypu jest zrozumiała dla AG, natomiast może być nieczytelna dla rozwiązującego. Jest to punkt w przestrzeni kodów - a nie konkretny zestaw parametrów stanowiących rozwiązanie problemu.

-

Fenotyp to rozkodowane (czyli przekształcone) rozwiązanie, które można bezpośrednio ocenić. To forma, którą rozumie funkcja celu – np. zestaw parametrów wejściowych do jakiegoś modelu lub układu. Fenotyp wynika z genotypu poprzez proces dekodowania (który może być prosty lub złożony, zależnie od zastosowania).

Przykład: jeśli mamy zadanie doboru parametrów regulatora PID, to:

- genotyp może zawierać binarne lub rzeczywiste zakodowanie wartości Kr, Ti, Td;

- fenotyp to konkretne wartości tych parametrów użyte do symulacji układu i obliczenia błędu regulacji.

Zatem genotyp to sposób przechowywania i operowania rozwiązaniami w AG, a fenotyp to to, co naprawdę reprezentują – ich realna "forma" z punktu widzenia zadania optymalizacyjnego.

Inne istotne pojęcia, które "odziedziczyliśmy" z nauk biologicznych:

- Populacja – zbiór osobników w danym pokoleniu. Jest to główny obiekt przetwarzania w AG – algorytm nie działa na jednym rozwiązaniu, lecz na całej grupie.

- Osobnik – pojedynczy element populacji. Reprezentuje jedno konkretne rozwiązanie problemu.

- Chromosom – struktura danych opisująca genotyp osobnika. Można go traktować jako kompletną reprezentację rozwiązania w postaci zakodowanej.

- Gen – najmniejszy element składowy chromosomu. Odpowiada jednej zmiennej problemu lub jednej cechy rozwiązania.

- Genotyp – cały zbiór genów osobnika, zakodowany w chromosomie. To właśnie na nim operują krzyżowanie i mutacja.

- Allel – wartość konkretnego genu. Czyli: gen to miejsce w chromosomie, allel to to, co tam siedzi. Np. jeśli gen odpowiada za kolor, to allel to „czerwony”, „zielony” itp.

- Locus – pozycja genu w chromosomie. Umożliwia jednoznaczną identyfikację, gdzie dany gen się znajduje.

Wszystkie te pojęcia wspólnie tworzą podstawowy język, w którym opisujemy działanie algorytmów genetycznych. W praktyce – dobre zrozumienie tych terminów pomaga w projektowaniu skutecznych algorytmów.

3.3. Schemat działania

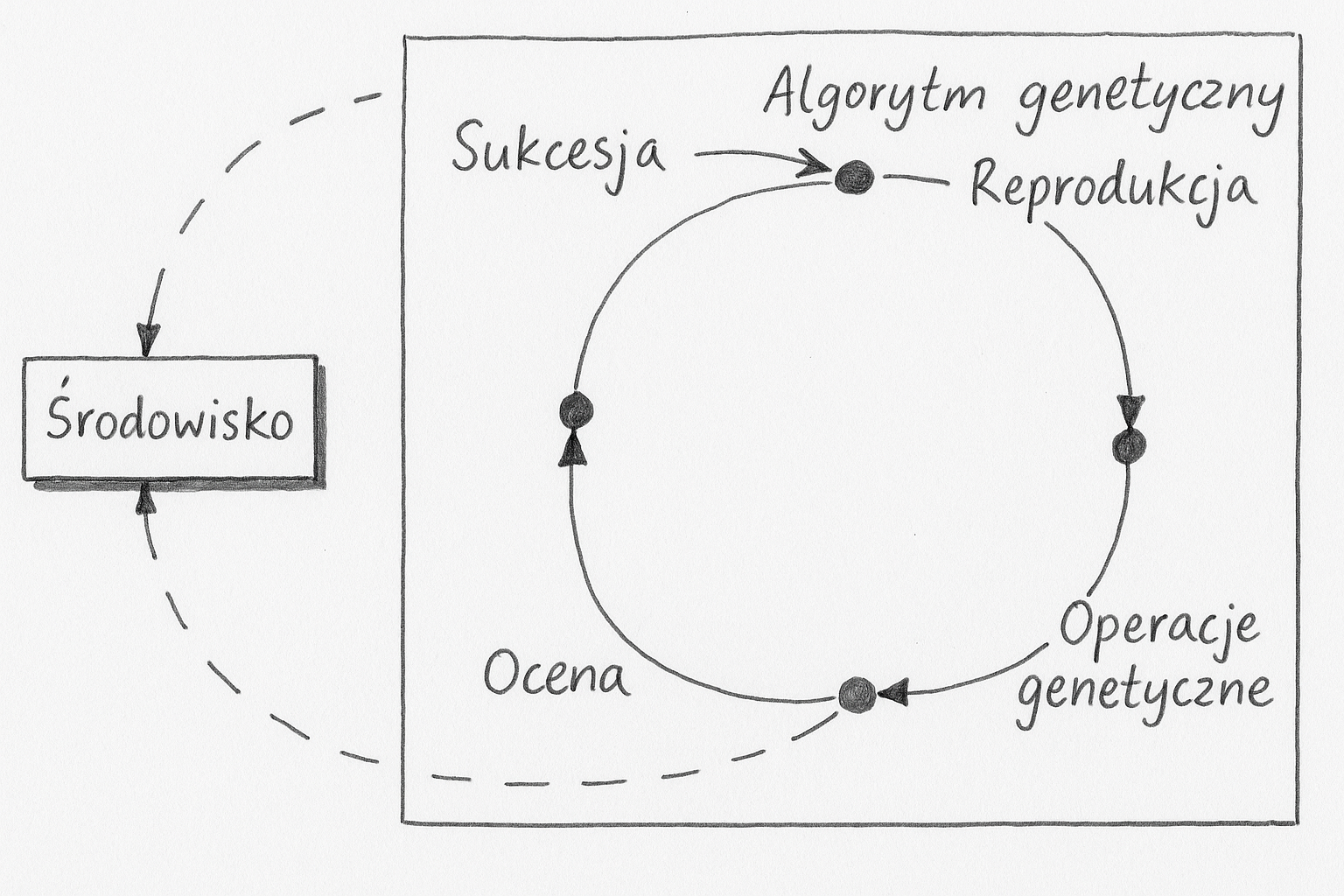

Schemat działania algorytmu genetycznego

Działanie klasycznego algorytmu genetycznego przebiega w pętli, w której każda iteracja odpowiada kolejnemu pokoleniu osobników. Schemat zamieszczony poniżej prezentuje pętlę, w której nastepują po sobie kolejno: reprodukcja, operacje genetyczne, ocena i sukcesja. Czasami reprodukcje i sukcesje określa się łącznym mianem selekcji. Reprodukcja w połączeniu z operacjami genetycznymi modeluje rozmnażanie, podczas którego materiał genetyczny rodziców przekazywany jest potomkom.

Najprostszy algorytm genetyczny operuje na dwóch populacjach: bazowej oraz potomnej. Dodatkowo wykorzystywane jest również pojęcie populacji tymczasowej. W każdej populacji zawarta jest jednakowa liczba osobników.

Typowy schemat działania algorytmu genetycznego rozpisany bardziej dokładnie wygląda następująco:

Inicjalizacja populacji

- Tworzymy początkową populację osobników. Zazwyczaj są one generowane losowo. Populacja powinna być zróżnicowana, aby dobrze pokryć przestrzeń poszukiwań.

- Dekodowanie genotypów do fenotypów

- Każdy osobnik jest dekodowany z formy genotypowej (czyli zapisanej w chromosomie) do fenotypu, czyli rzeczywistego rozwiązania problemu.

- Ocena przystosowania

- Na podstawie fenotypu obliczana jest wartość funkcji celu, która pełni rolę miary przystosowania osobnika. Lepsze rozwiązania mają wyższą wartość przystosowania (lub niższą – w zależności od problemu).

- Selekcja

- Wybieramy osobniki do rozrodu. Lepsze osobniki mają większą szansę na wybór, co odzwierciedla mechanizm doboru naturalnego. Najczęściej używane metody to selekcja ruletkowa, rankingowa oraz turniejowa.

- Krzyżowanie (rekombinacja)

- Łączymy pary wybranych osobników, tworząc nowe osobniki-potomków. Krzyżowanie pozwala mieszać cechy rodziców i eksplorować nowe fragmenty przestrzeni rozwiązań.

- Mutacja

- W genomie potomków losowo modyfikujemy niektóre geny. To wprowadza dodatkową zmienność i pozwala uniknąć zbyt szybkiego zbiegania do lokalnego optimum.

- Tworzenie nowej populacji (sukcesja)

- Nowa generacja może całkowicie zastąpić poprzednią, albo współistnieć z nią przez kilka pokoleń. Istnieją różne strategie: np. elitaryzm (najlepsi osobnicy są automatycznie przenoszeni dalej), sukcesja częściowa itd.

- Ocena nowego pokolenia

- Osobniki z nowej populacji, którzy jeszcze nie zostali ocenieni, są dekodowani do fenotypu, i poddawani ocenie.

- Sprawdzenie warunku zakończenia

- Algorytm kończy działanie, gdy spełniony jest określony warunek: osiągnięto maksymalną liczbę pokoleń, rozwiązania nie poprawiają się od kilku iteracji, lub osiągnięto wystarczające przystosowanie. Jeśli nie - wracamy do kroku 4.

Ten schemat jest podstawą działania większości wariantów algorytmów genetycznych. W bardziej zaawansowanych wersjach mogą pojawić się dodatkowe elementy, jak presja selekcyjna, adaptacja parametrów, koewolucja czy wielokrotne populacje działające równolegle. Jednak fundament pozostaje taki sam – inspirowany działaniem ewolucji w naturze.

3.4. Kodowanie

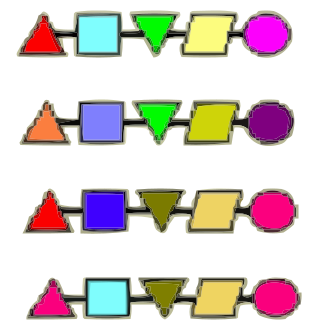

Kodowanie genomu w algorytmach genetycznych

Kodowanie genomu to sposób reprezentacji potencjalnych rozwiązań problemu optymalizacyjnego w postaci chromosomów – czyli łańcuchów danych, na których operują algorytmy genetyczne. Wybór odpowiedniego rodzaju kodowania ma kluczowe znaczenie dla efektywności działania algorytmu, ponieważ wpływa na to, jak łatwo można zastosować operatory genetyczne (krzyżowanie, mutację) oraz jak dobrze przestrzeń poszukiwań jest odwzorowywana.

Klasyfikacja metod kodowania

Najczęściej stosowane techniki kodowania genotypu dzielą się na:

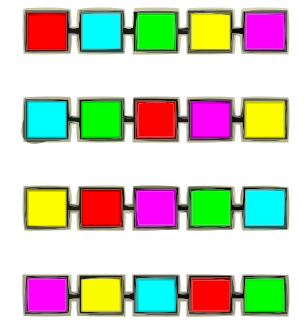

Kodowanie klasyczne (wektorowe)

W tym podejściu genotyp reprezentowany jest jako wektor wartości – może być to wektor binarny, liczbowy, całkowity itp. Każdy gen odpowiada za jedną cechę rozwiązania. To najczęściej stosowane podejście, zwłaszcza w problemach optymalizacji ciągłej lub dyskretnej.

Kodowanie permutacyjne

Tutaj chromosom zawiera permutację elementów – typowe zastosowanie to problemy kombinatoryczne, takie jak problem komiwojażera (TSP), harmonogramowanie zadań, kolejki produkcyjne itp. Operatory krzyżowania muszą być specjalnie przystosowane, by nie generowały nieprawidłowych permutacji.

Kodowanie drzewiaste

Stosowane głównie w programowaniu genetycznym. Genotyp ma strukturę drzewa – węzły to funkcje lub operatory, a liście to argumenty lub dane wejściowe. Struktura ta umożliwia reprezentację złożonych wyrażeń matematycznych, reguł lub algorytmów. Przykład: \( (x + y) * z \).

Kodowanie grafowe

Zamiast drzew czy wektorów, genotypem może być graf – używane np. w ewolucyjnej optymalizacji sieci (np. topologie połączeń neuronów w neuroewolucji). Pozwala to na reprezentowanie bardziej ogólnych struktur i zależności.

Kodowanie listy instrukcji (linearne kodowanie genów)

Popularne w ewolucyjnych algorytmach programujących. Genotyp zawiera liniową sekwencję poleceń lub instrukcji, podobnych do kodu asemblera. Taka reprezentacja ułatwia mutacje i krzyżowanie na poziomie składni.

Kodowanie symboliczne

Używane w problemach, gdzie rozwiązania mają strukturę symboliczną – np. ewolucja formuł logicznych, automaty, reguły IF-THEN. Genotyp zawiera symbole ze skończonego alfabetu, np. {A, B, C, ¬, ∧, ∨}.

Reprezentacja pojedynczych genów

Poza strukturą całego genotypu, istotne jest to, w jaki sposób kodowane są pojedyncze geny. Najczęściej stosuje się dwa podejścia: reprezentację binarną (w tym kod Graya) oraz reprezentację rzeczywistoliczbową.

Kodowanie binarne

W tym przypadku każda zmienna kodowana jest jako ciąg bitów. Długość ciągu określa precyzję odwzorowania. Na przykład, wartość z przedziału \([a, b]$\) reprezentujemy za pomocą \( n \) bitów, co pozwala wyróżnić \( 2^n \) wartości dyskretnych. Zamiana bitów na wartość rzeczywistą wymaga przeskalowania:

\[

x = a + \frac{b - a}{2^n - 1} \cdot \text{wartość binarna}

\]

Zaletą tego podejścia jest prostota operacji krzyżowania i mutacji. Wadą – ograniczona rozdzielczość i nieliniowość odwzorowania, szczególnie w problemach ciągłych.

Kodowanie Graya

Kod Graya to wariant kodowania binarnego, w którym dwie kolejne wartości różnią się tylko jednym bitem. Redukuje to problem „skokowych” zmian wartości przy małych mutacjach. Przydatny zwłaszcza tam, gdzie zmiana jednego bitu nie powinna prowadzić do dużej zmiany w wartości odwzorowanej.

Kodowanie rzeczywistoliczbowe

Zamiast bitów, gen przyjmuje bezpośrednio wartość rzeczywistą z określonego przedziału. Przykład: gen \( x_i \in [0, 10] \) może mieć wartość 7.35. Operatory genetyczne muszą być dostosowane do przestrzeni ciągłej – mutacja może np. polegać na dodaniu losowego zakłócenia \( \sim N(0, \sigma) \), a krzyżowanie – na liniowej kombinacji rodziców.

Zaletą tego podejścia jest jego naturalność i brak potrzeby dekodowania. Dobrze sprawdza się w optymalizacji ciągłej. Wadą jest większe ryzyko wyjścia poza dopuszczalne zakresy oraz konieczność dostosowania operatorów.

Podsumowanie

Dobór odpowiedniego kodowania zależy od rodzaju rozważanego problemu:

- dla problemów ciągłych preferowane jest kodowanie rzeczywiste,

- dla problemów kombinatorycznych – kodowanie permutacyjne,

- dla problemów strukturalnych – kodowanie drzewiaste, grafowe lub instrukcyjne.

Dodatkowo należy pamiętać, że rodzaj kodowania wpływa na konstrukcję operatorów genetycznych oraz na efektywność przeszukiwania przestrzeni rozwiązań. W praktyce często konieczne jest eksperymentalne dobranie najbardziej efektywnej reprezentacji.

3.5. Inicjacja

Czym są operatory inicjalizacji?

Operatory inicjalizacji to procedury odpowiedzialne za wygenerowanie pierwszej populacji w algorytmie genetycznym. To, jak zostaną rozłożone początkowe punkty w przestrzeni rozwiązań, może mieć ogromne znaczenie dla skuteczności dalszego poszukiwania. Celem inicjalizacji jest zapewnienie odpowiedniej różnorodności genetycznej, by uniknąć przedwczesnej zbieżności populacji.

Typowe metody inicjalizacji

W literaturze i praktyce algorytmów genetycznych spotyka się kilka głównych podejść:

Inicjacja równomierna (jednorodna)

Inicjalizacja równomierna (jednorodna) to najprostszy i najczęściej stosowany sposób generowania początkowej populacji w algorytmach genetycznych. Polega na tym, że każda zmienna decyzyjna (gen) losowana jest niezależnie z rozkładu jednostajnego w zadanym przedziale dopuszczalnych wartości. Dzięki temu cała przestrzeń poszukiwań jest wstępnie przeszukiwana z równym prawdopodobieństwem, co zapewnia dobrą eksplorację już od pierwszej generacji.

Wzór opisujący losowanie jednego genu \(g_i\) z rozkładu jednostajnego wygląda następująco:

\[g_i = a_i + (b_i - a_i) \cdot U(0,1)\]

- \(a_i\) i \(b_i\) to odpowiednio dolna i górna granica przedziału dla genu \(g_i\),

- \(U(0,1)\) to liczba losowa z rozkładu jednostajnego w przedziale \(<0,1>\).

Zaletą inicjalizacji równomiernej jest jej prostota i niskie wymagania obliczeniowe. Nie wymaga żadnych dodatkowych parametrów (jak np. średnia i odchylenie standardowe w rozkładzie normalnym), ani wstępnej wiedzy o funkcji celu. Jest idealna do zadań, gdzie brakuje jakiejkolwiek wiedzy wstępnej o położeniu optymalnych rozwiązań.

Wadą tej metody może być jednak zbyt rzadkie pokrycie przestrzeni w wysokich wymiarach — przy dużej liczbie zmiennych liczba możliwych kombinacji rośnie wykładniczo, przez co nawet duże populacje mogą „nie trafić” w istotne obszary.

Rozkład normalny (Gaussa)

Rozkład normalny (Gaussa) to klasyczny rozkład symetryczny, którego kształt opisywany jest przez funkcję dzwonową. Jego parametrami są średnia , wokół której skupiają się wartości, oraz odchylenie standardowe , określające szerokość rozrzutu. Rozkład ten jest szeroko stosowany w algorytmach genetycznych do lokalnej inicjalizacji populacji, szczególnie gdy znane jest przybliżone położenie optimum.

Funkcja gęstości prawdopodobieństwa rozkładu normalnego zapisana w postaci matematycznej wygląda następująco:

Rozkład normalny (Gaussa) to klasyczny rozkład symetryczny, którego kształt opisywany jest przez funkcję dzwonową. Jego parametrami są średnia , wokół której skupiają się wartości, oraz odchylenie standardowe , określające szerokość rozrzutu. Rozkład ten jest szeroko stosowany w algorytmach genetycznych do lokalnej inicjalizacji populacji, szczególnie gdy znane jest przybliżone położenie optimum.

Funkcja gęstości prawdopodobieństwa rozkładu normalnego zapisana w postaci matematycznej wygląda następująco:

\[ f(x) = \frac{1}{\sigma \sqrt{2\pi}} \exp\left( -\frac{(x - \mu)^2}{2\sigma^2} \right) \]

Rozkład normalny pozwala w naturalny sposób regulować intensywność eksploracji poprzez manipulowanie – im większe odchylenie, tym większy zasięg losowanych wartości. Jest często stosowany jako alternatywa dla rozkładu jednostajnego, gdy zależy nam na zbliżeniu się do konkretnych obszarów przestrzeni decyzyjnej.

Kiedy używać rozkładu normalnego do inicjalizacji?

Rozkład normalny (Gaussa) jest szczególnie użyteczny w sytuacjach, gdy chcemy skoncentrować generowane punkty w pobliżu znanego lub przypuszczalnego optimum. Jest to korzystne np. w zadaniach, gdzie:

- przestrzeń poszukiwań jest bardzo duża, a eksploracja całej przestrzeni byłaby nieefektywna,

- dysponujemy wcześniejszą wiedzą o typowym zakresie dobrych rozwiązań,

- potrzebujemy szybko zbliżyć się do dobrego punktu początkowego,

- wymagane jest utrzymanie populacji w ograniczonym zasięgu wokół konkretnego rozwiązania,

- zależy nam na dokładnej eksploracji lokalnej okolicy (eksploatacja zamiast eksploracji).

Stosując rozkład normalny, możemy łatwo regulować „rozrzut” poprzez parametr odchylenia standardowego σ – co czyni ten rozkład bardzo praktycznym narzędziem do lokalnego poszukiwania rozwiązań.

Inne operatory inicjalizacji spotykane w literaturze

Oprócz standardowych metod, w literaturze opisywane są również bardziej zaawansowane operatory inicjalizacji, które zwiększają jakość pokrycia przestrzeni poszukiwań. Przykładem jest Latin Hypercube Sampling (LHS), który zapewnia, że próbki są równomiernie rozmieszczone wzdłuż każdego wymiaru. Dzięki temu unika się sytuacji, w której populacja początkowa przypadkowo pomija duże obszary przestrzeni rozwiązań. LHS znajduje zastosowanie głównie w zadaniach o dużej liczbie zmiennych ciągłych, gdzie losowanie niezależnych wartości z rozkładu jednostajnego mogłoby prowadzić do nadmiernego skupienia próbek.

Rozkład Cauchy’ego zasługuje na osobne omówienie ze względu na jego unikalne właściwości. W przeciwieństwie do rozkładu normalnego, Cauchy charakteryzuje się tzw. grubymi ogonami – co oznacza, że wartości znacznie oddalone od średniej mają wyraźnie większe prawdopodobieństwo wystąpienia. Dzięki temu inicjalizacja z wykorzystaniem rozkładu Cauchy’ego może skutecznie wspierać eksplorację przestrzeni poszukiwań, zwłaszcza w problemach, gdzie dobre rozwiązania mogą występować daleko od środka przestrzeni decyzyjnej. Jest to zatem doskonała opcja w przypadkach, gdy zależy nam na agresywnym przeszukiwaniu całej przestrzeni, a nie tylko jej wycinka.

Drugą rodziną podejść są tzw. sekwencje niskiej dyskrepancji, takie jak Sobola, Haltona czy Faure’a. Są to quasi-losowe ciągi, które rozmieszczają punkty bardziej równomiernie niż czysto losowe próbkowanie. Dzięki temu zapewniają systematyczne i powtarzalne pokrycie przestrzeni, co czyni je przydatnymi np. w testowaniu algorytmów lub optymalizacji deterministycznej. Ich zaletą jest pełna kontrola nad rozkładem punktów oraz możliwość odwzorowania przestrzeni nawet w wysokich wymiarach.

Ciekawą propozycją jest również inicjalizacja warstwowa (layered), która łączy różne podejścia w jednej populacji. Na przykład, część populacji może być losowana z rozkładu jednostajnego dla szerokiej eksploracji, a inna część z rozkładu normalnego wokół znanych dobrych punktów – dla precyzyjnej eksploatacji. Takie połączenie działań eksploracyjnych i eksploatacyjnych już na etapie inicjalizacji pozwala algorytmowi rozpocząć poszukiwania z bardziej zrównoważonym rozkładem potencjalnych rozwiązań.

Nadinicjalizacja

Pojęcie nadinicjalizacji oznacza sytuację, w której generuje się znacznie więcej osobników niż wynosi docelowa liczność populacji – a następnie wybiera z nich najlepsze bądź najbardziej zróżnicowane. Pomaga to w uzyskaniu lepszej jakości początkowej populacji, ale wiąże się z większym kosztem obliczeniowym.

Można też rozumieć „nadinicjalizację” jako próbę kompensacji ubogiej struktury inicjalnej populacji przez sztuczne zwiększenie jej rozrzutu – np. przez silną mutację na etapie inicjalizacji lub przez celowe zwiększenie zakresów poszukiwań.

Podsumowanie

Wybór operatora inicjalizacji nie jest błahy:

- dla eksploracji warto korzystać z rozkładu równomiernego, Cauchy’ego lub LHS,

- dla eksploatacji – z rozkładów skoncentrowanych (np. normalnego, beta, wykładniczego),

- inicjalizacja hybrydowa (np. kilka punktów heurystycznych + losowanie) daje często najlepsze efekty.

Dobrze zaprojektowana inicjalizacja może zdecydować, czy algorytm w ogóle znajdzie sensowne rozwiązania.

3.6. Selekcja

Operatory selekcji w algorytmach genetycznych

Selekcja to kluczowy etap algorytmu genetycznego, w którym wybierane są osobniki do reprodukcji – czyli do krzyżowania i/lub mutacji. Celem selekcji jest premiowanie lepiej przystosowanych jednostek, a zarazem zachowanie pewnej różnorodności genetycznej w populacji. Istnieje wiele technik selekcji, z których każda ma inne właściwości pod względem presji selekcyjnej i zbieżności.

Selekcja ruletkowa (proporcjonalna)

Selekcja ruletkowa (ang. "roulette wheel selection") jest jedną z najprostszych i najbardziej intuicyjnych metod. Każdemu osobnikowi przypisywany jest wycinek koła proporcjonalny do jego wartości funkcji przystosowania (fitness). Im lepszy osobnik, tym większe ma szanse na wybór. Wyobrażamy to sobie jak koło fortuny, w którym sektory odpowiadają poszczególnym osobnikom – im większy sektor, tym większe prawdopodobieństwo trafienia.

Z matematycznego punktu widzenia, prawdopodobieństwo selekcji osobnika wyraża się jako:

\[P(i) = \frac{f_i}{\sum_{j=1}^{N} f_j}\]

gdzie:

- \(f_i\) to wartość funkcji przystosowania osobnika \(i\),

- \(N\) to liczba osobników w populacji.

Selekcja ruletkowa jest szybka i prosta, ale ma kilka wad. Przede wszystkim, jeśli w populacji znajduje się jeden bardzo dobrze przystosowany osobnik, to dominuje on selekcję – co może prowadzić do przedwczesnej zbieżności. Z drugiej strony, gdy wartości funkcji przystosowania są zbliżone, presja selekcyjna spada, a algorytm „drepcze w miejscu”.

Selekcja rankingowa

W selekcji rankingowej osobniki są najpierw sortowane według przystosowania (od najlepszego do najgorszego), a następnie każdemu przypisywana jest wartość selekcyjna zależna od jego pozycji (rangi), a nie od bezwzględnej wartości funkcji celu. Dzięki temu unika się problemów związanych z dużymi różnicami w wartościach funkcji przystosowania.

Presję selekcyjną można regulować poprzez funkcję przekształcającą rangę na prawdopodobieństwo – np. liniowo, wykładniczo lub z wykorzystaniem rozkładów losowych. Rankingowa metoda zapewnia bardziej kontrolowaną presję selekcyjną i pozwala uniknąć dominacji pojedynczych osobników, ale kosztem większej złożoności obliczeniowej (sortowanie).

Selekcja turniejowa

W selekcji turniejowej tworzy się losowo grupy (turnieje) złożone z osobników (zwykle lub ). W każdej grupie wygrywa najlepszy osobnik, który trafia do puli reprodukcyjnej. Metoda ta jest prosta do zaimplementowania i nie wymaga znajomości wartości funkcji przystosowania całej populacji.

Presję selekcyjną reguluje się wielkością turnieju – większe oznacza silniejszą presję. Przykładowo, turniej zachowuje sporo losowości, natomiast może szybko prowadzić do utraty różnorodności. Istnieją też warianty turnieju probabilistycznego, w którym zwycięzca wybierany jest z prawdopodobieństwem zależnym od jego jakości.

Porównanie technik

- Ruletka – szybka, ale wrażliwa na rozkład przystosowań; może prowadzić do dominacji jednego osobnika.

- Ranking – stabilna i odporna na ekstremalne wartości funkcji celu; presja zależna od rangi.

- Turniej – bardzo elastyczny, szybki i łatwy do równoleglenia; dobrze sprawdza się w praktyce.

Dobór operatora selekcji ma istotny wpływ na zachowanie algorytmu – jego zbieżność, eksplorację i eksploatację przestrzeni. W praktyce często testuje się różne metody dla konkretnego problemu, by dobrać najbardziej efektywną konfigurację.

Ciekawostka: Uruchamiając poniższy program możecie zobaczyć / testować jak działają omówione operatory selekcji:

import numpy as np

import matplotlib.pyplot as plt

# Generowanie populacji i przypisanie funkcji przystosowania

np.random.seed(42)

population_size = 20

fitness = np.sort(np.random.rand(population_size))[::-1] # Posortowane od najlepszego

# Selekcja ruletkowa

def roulette_selection(fitness, num_selected):

probabilities = fitness / fitness.sum()

return np.random.choice(len(fitness), size=num_selected, p=probabilities)

# Selekcja rankingowa (liniowa)

def ranking_selection(fitness, num_selected):

ranks = np.argsort(np.argsort(-fitness)) # 0 - najlepszy

rank_weights = (len(fitness) - ranks)

probabilities = rank_weights / rank_weights.sum()

return np.random.choice(len(fitness), size=num_selected, p=probabilities)

# Selekcja turniejowa

def tournament_selection(fitness, num_selected, tournament_size=3):

selected = []

for _ in range(num_selected):

participants = np.random.choice(len(fitness), tournament_size, replace=False)

winner = participants[np.argmax(fitness[participants])]

selected.append(winner)

return np.array(selected)

# Zastosowanie selekcji

num_selected = 1000

roulette_counts = np.bincount(roulette_selection(fitness, num_selected), minlength=population_size)

ranking_counts = np.bincount(ranking_selection(fitness, num_selected), minlength=population_size)

tournament_counts = np.bincount(tournament_selection(fitness, num_selected), minlength=population_size)

# Wizualizacja

plt.figure(figsize=(12, 6))

plt.plot(roulette_counts, label='Ruletkowa', marker='o')

plt.plot(ranking_counts, label='Rankingowa', marker='s')

plt.plot(tournament_counts, label='Turniejowa (k=3)', marker='^')

plt.title("Porównanie technik selekcji w algorytmie genetycznym")

plt.xlabel("Indeks osobnika (0 = najlepszy)")

plt.ylabel("Liczba wybrań w selekcji (z 1000 prób)")

plt.legend()

plt.grid(True)

plt.tight_layout()

plt.show()

3.7. Krzyżowanie

Krzyżowanie (ang. crossover) to kluczowy operator genetyczny odpowiedzialny za wymianę informacji pomiędzy osobnikami w populacji. Jego celem jest tworzenie nowych rozwiązań poprzez kombinację cech rodziców. Skuteczny operator krzyżowania powinien z jednej strony umożliwiać eksploatację dobrych rozwiązań, a z drugiej zachować wystarczającą różnorodność w populacji.

W zależności od rodzaju kodowania genotypu, stosuje się różne techniki krzyżowania. Poniżej przedstawiamy najważniejsze z nich.

Krzyżowanie dla kodowania binarnego (klasycznego)

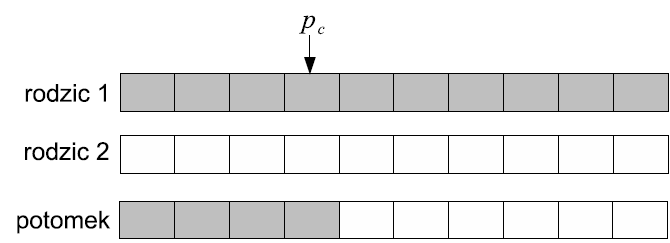

Jednopunktowe (single-point crossover)

Losowany jest jeden punkt podziału chromosomu. Dzieci dziedziczą część genów od jednego rodzica przed punktem, a drugą część od drugiego rodzica.

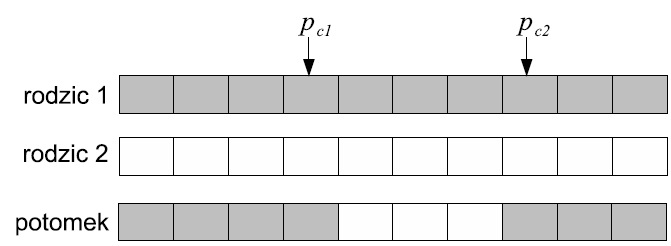

Dwupunktowe (two-point crossover)

Losowane są dwa punkty podziału. Fragment między nimi jest zamieniany pomiędzy rodzicami. Pozwala to na bardziej zróżnicowaną rekombinację.

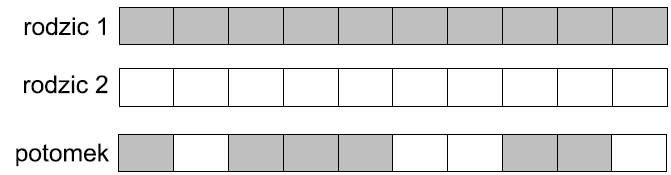

Jednorodne (uniform crossover)

Dla każdego genu losowo (z prawdopodobieństwem np. 0.5) wybierany jest jeden z rodziców. Zapewnia to największe wymieszanie cech.

Zalety tych metod to prostota, niska złożoność i szerokie zastosowanie w kodowaniu binarnym. Wadą może być generowanie dziwnych struktur rozwiązań – operacje są niezależne od semantyki problemu.

Krzyżowanie dla kodowania rzeczywistego

Krzyżowanie arytmetyczne

Potomkowie wyznaczani są jako liniowa kombinacja rodziców: