Podręcznik

| Strona: | SEZAM - System Edukacyjnych Zasobów Akademickich i Multimedialnych |

| Kurs: | 1. Podstawy sieci neuronowych |

| Książka: | Podręcznik |

| Wydrukowane przez użytkownika: | Gość |

| Data: | wtorek, 30 grudnia 2025, 15:18 |

Spis treści

- 1. Modele neuronów

- 2. Sieć perceptronu wielowarstwowego MLP

- 2.1. Wprowadzenie

- 2.2. Struktura sieci wielowarstwowej MLP

- 2.3. Proces uczenia sieci metodami gradientowymi optymalizacji

- 2.4. Generacja gradientu z użyciem grafów przepływu sygnałów

- 2.5. Metody wyznaczania kierunku minimalizacji

- 2.6. Dobór współczynnika uczenia

- 2.7. Metody heurystyczne uczenia sieci

- 2.8. Inicjalizacja wartości początkowych wag sieci

- 2.9. Program MLP do uczenia sieci wielowarstwowej

- 2.10. Zadania i problemy

- 2.11. Słownik

- 3. Zdolności generalizacyjne sieci neuronowych

- 3.1. Wprowadzenie pojęcia zdolności generalizacyjnych sieci

- 3.2. Miara VCdim i jej związek z generalizacją

- 3.3. Przegląd metod zwiększania zdolności generalizacyjnych sieci

- 3.4. Wstępny dobór architektury sieci

- 3.5. Poprawa zdolności generalizacyjnych poprzez regularyzację

- 3.6. Selekcja cech diagnostycznych

- 3.7. Zwiększanie zdolności generalizacyjnych poprzez użycie zespołu wielu sieci

- 3.8. Przykład metody zwiększania zdolności generalizacyjnych sieci

- 3.9. Zadania i problemy

- 3.10. Słownik

- 4. Literatura

1. Modele neuronów

Wprowadzenie

Sztuczne sieci neuronowe powstały na bazie wiedzy o działaniu systemu nerwowego istot żywych i stanowią próbę wykorzystania zjawisk zachodzących w systemach nerwowych przy poszukiwaniu nowych rozwiązań technologicznych tworząc interdyscyplinarną dziedzinę badań powiązaną z biocybernetyką, elektroniką, metodami optymalizacyjnymi, statystyką, automatyką, a nawet medycyną [18,24,32].

Komórka nerwowa, zwana w skrócie neuronem, stanowi podstawowy element systemu nerwowego. Poznanie mechanizmów działania poszczególnych neuronów i ich współdziałania jest szczególnie istotne dla zrozumienia procesów pozyskiwania, przesyłania i przetwarzania informacji zachodzących w sieciach neuronowych. Informacje te posłużyły zbudowaniu modelu sztucznego neuronu, który stanowi podstawę struktury sieci neuronowej – układu neuronów połączonych ze sobą w określony sposób.

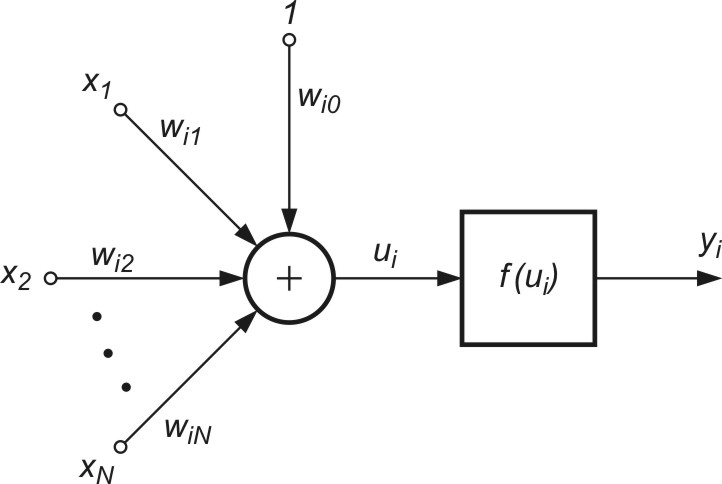

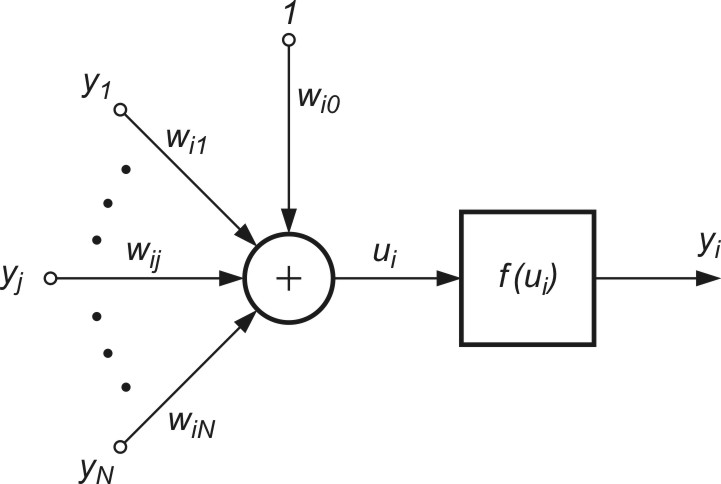

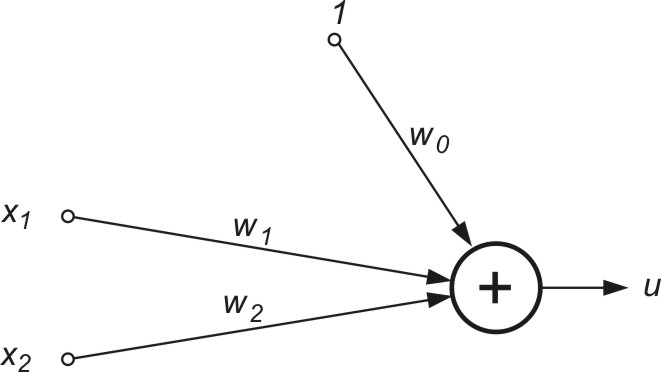

1.1. Model McCullocha-Pittsa

Na podstawie działania rzeczywistej komórki nerwowej stworzono wiele modeli matematycznych, w których uwzględnione zostały w większym lub mniejszym stopniu własności rzeczywistej komórki nerwowej. Pierwszym takim rozwiązaniem był model McCullocha-Pittsa, generujący wynik \( y_i = f ( \sum_{j=1}^N w_{ij} x_{j} + w_{i0} ) \). Na wynik składa się sumator wagowy sygnałów wejściowych oraz blok nieliniowy, realizujący funkcję aktywacji \( f(u_i) \) neuronu, w którym argumentem jest sygnał sumacyjny \( u_i = \sum_{j=1}^N w_{ij} x_{j} + w_{i0} \). Funkcja \( f(u_i) \) jest w modelu McCullocha opisana jest wzorem [24,46]

| \( f(u)= \begin{cases} { \begin{matrix} 1 \textrm{ dla } u>0 \\ 0 \textrm{ dla } u \leq 0 \end{matrix} } \end{cases} \) |

(1.1) |

Współczynniki \( w_{ij} \) występujące we wzorze (1.1) reprezentują wagi połączeń synaptycznych. Wartość dodatnia wagi oznacza synapsę pobudzającą, ujemna - hamującą, natomiast zerowa świadczy o braku połączenia między neuronem i-tym i j-tym.

Strategie uczenia

W adaptacji wartości wag neuronów stosuje się różne strategie [24,46]:

-

uczenie z nauczycielem, zwane również uczeniem pod nadzorem. (ang. supervised learning)

-

uczenie bez nauczyciela (ang. unsupervised learning)

-

uczenie ze wzmocnieniem (ang. reinforcement learning)

W trybie uczenia z nauczycielem przyjmuje się, że oprócz sygnałów wejściowych tworzących wektor x znane są również pożądane sygnały wyjściowe neuronu \( d_i \) tworzące wektor \( \textbf{d} \) (ang. destination), a dobór wag musi być przeprowadzony w taki sposób, aby aktualny sygnał wyjściowy neuronu \( y_i \) był najbliższy wartości zadanej \( d_i \). Istotnym elementem procesu jest tu znajomość zadanej wartości sygnału wyjściowego neuronu.

W strategii uczenia bez nauczyciela dobór wag odbywa się na innych zasadach i wiąże się z wykorzystaniem bądź to konkurencji neuronów między sobą (strategia Winner Takes All - WTA lub Winner Takes Most – WTM), bądź korelacji sygnałów uczących (uogólnione metody hebbowskie). Tego typu rozwiązania stosuje się w zadaniach grupowania danych (na przykład w sieciach Kohonena) bądź w różnego rodzaju transformacjach liniowych bądź nieliniowych (transformacje PCA, LDA, ICA, BSS, itp.).

Strategia uczenia ze wzmocnieniem wykorzystuje interakcje agenta ze środowiskiem, ukierunkowaną na zmaksymalizowanie zwracanej nagrody. Wzmacnianie polega na odpowiedniej polityce zbierania danych o środowisku, wytrenowaniu sieci na podstawie tych danych i powtarzaniu procesu dla uzyskania najlepszych wyników (typowe zastosowania to różnego rodzaju gry). W każdej iteracji agent otrzymuje informację o aktualnym stanie procesu i nagrody, na podstawie której wybiera następną akcję, której celem jest zwiększenie skumulowanej nagrody.

1.2. Model sigmoidalny neuronu

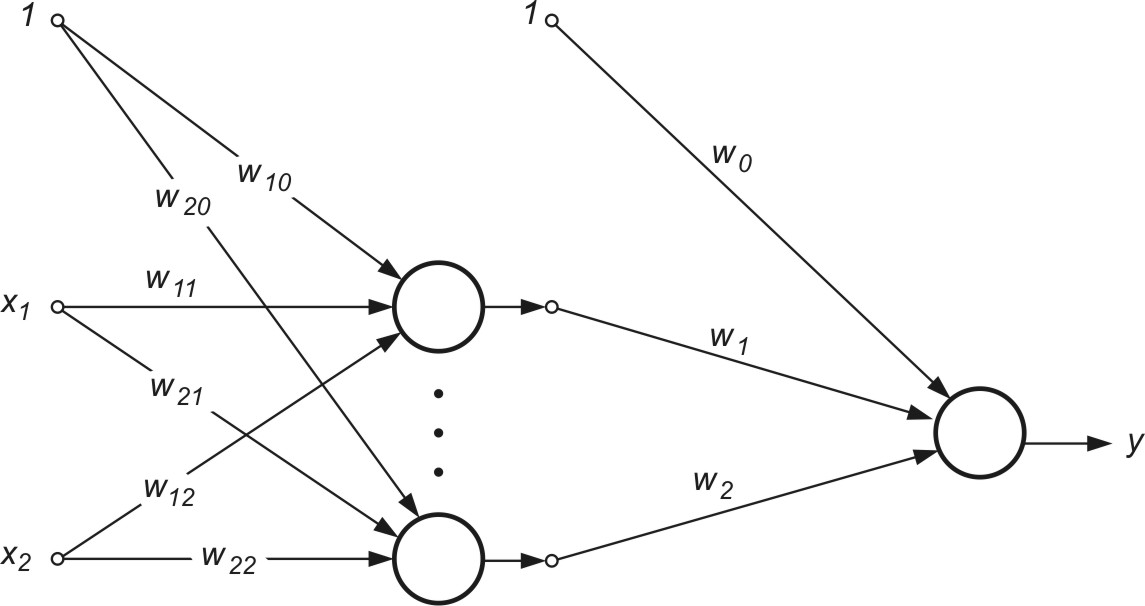

Struktura modelu sigmoidalnego neuronu przedstawiona na rys. 1.1) jest podobna do modelu McCullocha-Pittsa, z tą różnicą, że funkcja aktywacji jest ciągła i przyjmuje postać funkcji sigmoidalnej unipolarnej \( f_u(u) \) lub bipolarnej \( f_b(u) \) [46]. Funkcje te zapisuje się zwykle w postaci

| \( f(u) = \frac{1}{1+exp(-bu)} \) | (1.2a) |

| \( f_b(u)=tgh(bu) \) |

(1.2b) |

gdzie ![]() jest sygnałem sumacyjnym i-tego neuronu, zmienne \( x_i \) (i=1, 2, …, N) stanowią składowe wektora x a \( x_0 \) oznacza sygnał polaryzacji równy zwykle 1 (przy braku polaryzacji równy zeru). Wagi wij stanowią wartości połączeń synaptycznych reprezentowane zwykle poprzez wektor \( \textbf{w}_i = [ w_{i0}, w_{i1}, \ldots, w_{iN}]^T \).

jest sygnałem sumacyjnym i-tego neuronu, zmienne \( x_i \) (i=1, 2, …, N) stanowią składowe wektora x a \( x_0 \) oznacza sygnał polaryzacji równy zwykle 1 (przy braku polaryzacji równy zeru). Wagi wij stanowią wartości połączeń synaptycznych reprezentowane zwykle poprzez wektor \( \textbf{w}_i = [ w_{i0}, w_{i1}, \ldots, w_{iN}]^T \).

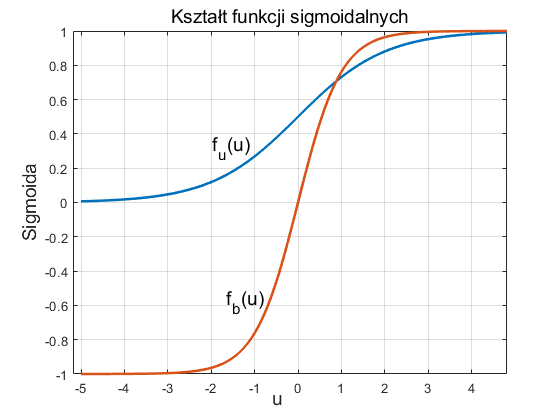

Na rys. 1.2a i 1.2b przedstawiono przebiegi funkcji odpowiednio sigmoidalnej unipolarnej i bipolarnej względem zmiennej \( u \). Przez wprowadzenie bardzo dużej wartości współczynnika \( b \) skalującego sygnał sumacyjny \( u \) funkcja sigmoidalna może odwzorować funkcję skokową, identyczną z funkcją aktywacji perceptronu McCulocha-Pitsa.

Ważną cechą funkcji sigmoidalnej jest jej różniczkowalność. W przypadku funkcji unipolarnej jej pochodna wyraża się wzorem

| \( \frac{df_u(u)}{du}=b f_u(u)(1-f_u(u)) \) |

(1.3) |

natomiast funkcji bipolarnej

| \( \frac{df_b(u)}{du} = b ( 1-f_b^2(u)) \) |

(1.4) |

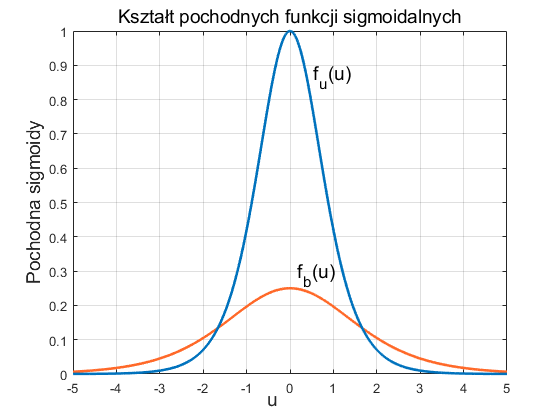

Zauważmy, że dla funkcji sigmoidalnych wartość pochodnej jest całkowicie określona przez wartość samej funkcji. W obu przypadkach wykres zmian pochodnej względem zmiennej u ma kształt krzywej dzwonowej, z maksimum odpowiadającym wartości u=0, jak to przedstawiono na rys. 1.3.

Uczenie neuronu sigmoidalnego odbywa się zwykle w trybie z nauczycielem, przez minimalizację funkcji celu, zwaną również kosztem uczenia, która w przypadku jednej pary uczącej (x, d) definiowana jest dla i-tego neuronu w postaci

| \( E = \frac{1}{2} ( y_i - d_i)^2 \) | (1.5) |

przy czym aktualny sygnał wyjściowy neuronu określony jest w postaci

| \( y_i=f(u_i)=f ( \sum_{j=0}^{N} w_{ij}x_j ) \) | (1.6) |

Funkcja \( f(u_i) \) jest funkcją sigmoidalną, a \( d_i \) wartością zadaną na wyjściu i-tego neuronu. W przypadku zbioru par uczących funkcja celu jest sumą składników dla każdej pary uczącej.

Założenie ciągłej funkcji aktywacji umożliwia zastosowanie w uczeniu metody gradientowej. Najprostszym rozwiązaniem jest zastosowanie metody największego spadku, zgodnie z którą aktualizacja wektora wagowego w odbywa się iteracyjnie z kroku na krok w kierunku ujemnego gradientu funkcji celu

| \( \textbf{w} (k+1)=\textbf{w}(k)-\eta \frac{\partial E}{\partial \textbf{w}} \) | (1.7) |

Dla j-tej wagi i-tego neuronu wzór powyższy przyjmie postać

| \( w_{ij} (k+1)=w_{ij}(k)-\eta \frac{\partial E}{\partial w_{ij}} \) | (1.8) |

Dla przyjętej definicji funkcji celu E łatwo pokazać, że

| \( \frac{\partial E}{\partial w_{ij}} = x_j ( y_i -d_i ) \frac{df(u_i)}{du_i} \) | (1.9) |

Wzór (1.9) w połączeniu z wyrażeniem określającym pochodną funkcji aktywacji definiują algorytm uczenia neuronu sigmoidalnego. Na skuteczność uczenia ma duży wpływ dobór wartości współczynnika uczenia η. W stosowanych rozwiązaniach praktycznych przyjmuje się go bądź to jako wielkość stałą, bądź zmienianą w trakcie uczenia w sposób adaptacyjny. Należy podkreślić, że metoda gradientowa zastosowana w uczeniu neuronu gwarantuje osiągnięcie jedynie minimum lokalnego odpowiadającego wstępnej inicjalizacji wag.

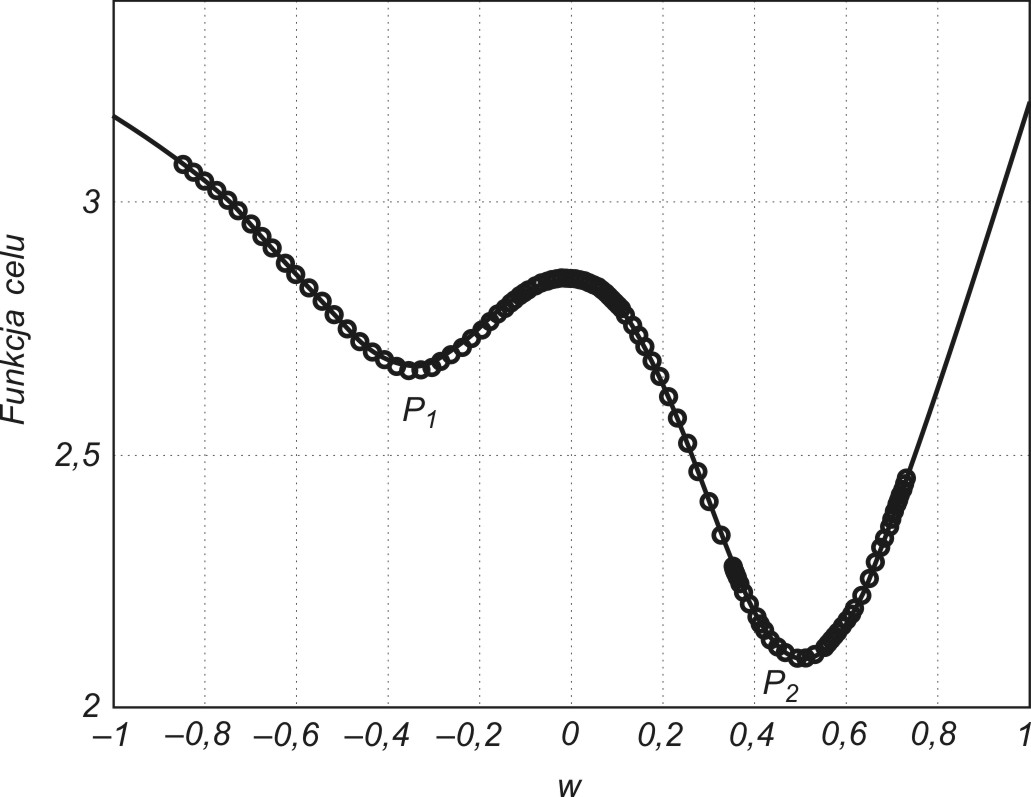

W przypadku funkcji celu wielomodalnej (o wielu minimach lokalnych) znalezione minimum lokalne może być odległe od globalnego. Wyjście ze strefy przyciągania określonego minimum lokalnego nie jest możliwe przy zastosowaniu prostego algorytmu największego spadku. Pewną pomocą może być zastosowanie uczenia z tak zwanym momentem rozpędowym. W metodzie tej proces aktualizacji wag uwzględnia nie tylko informację o gradiencie funkcji, ale również aktualny trend zmian wag. Matematycznie ten sposób uczenia można opisać za pomocą następującego wzoru określającego przyrost wartości wag [24,46]

| \( \Delta w_{ij} (k+1) = - \eta \frac{\partial E}{\partial w_{ij}} + \alpha \Delta w_{ij} (k) \) |

(1.10) |

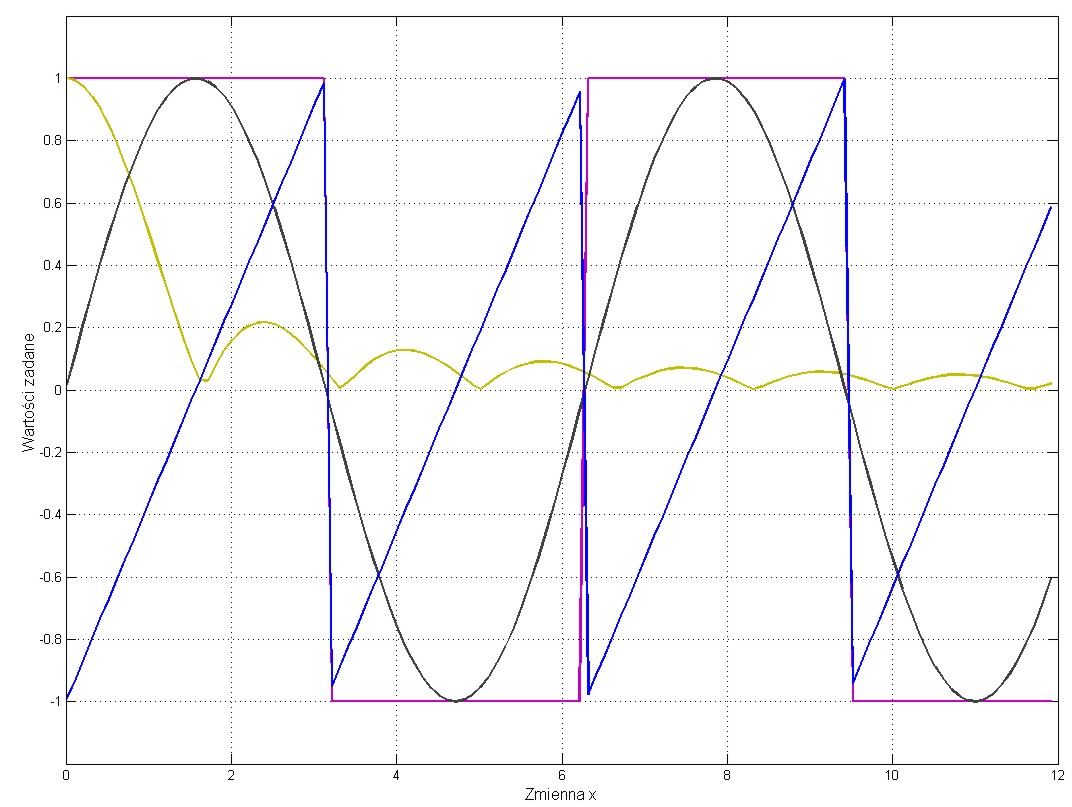

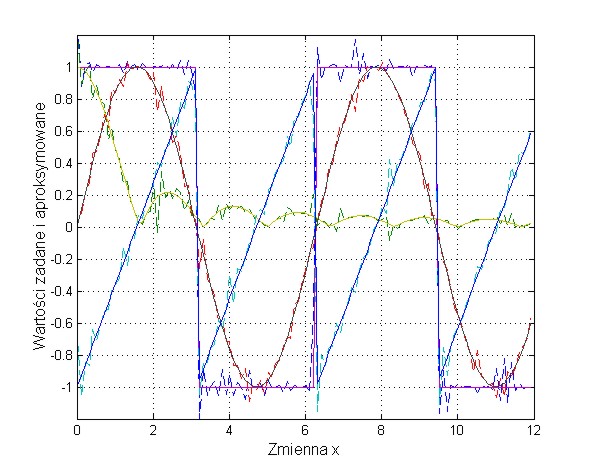

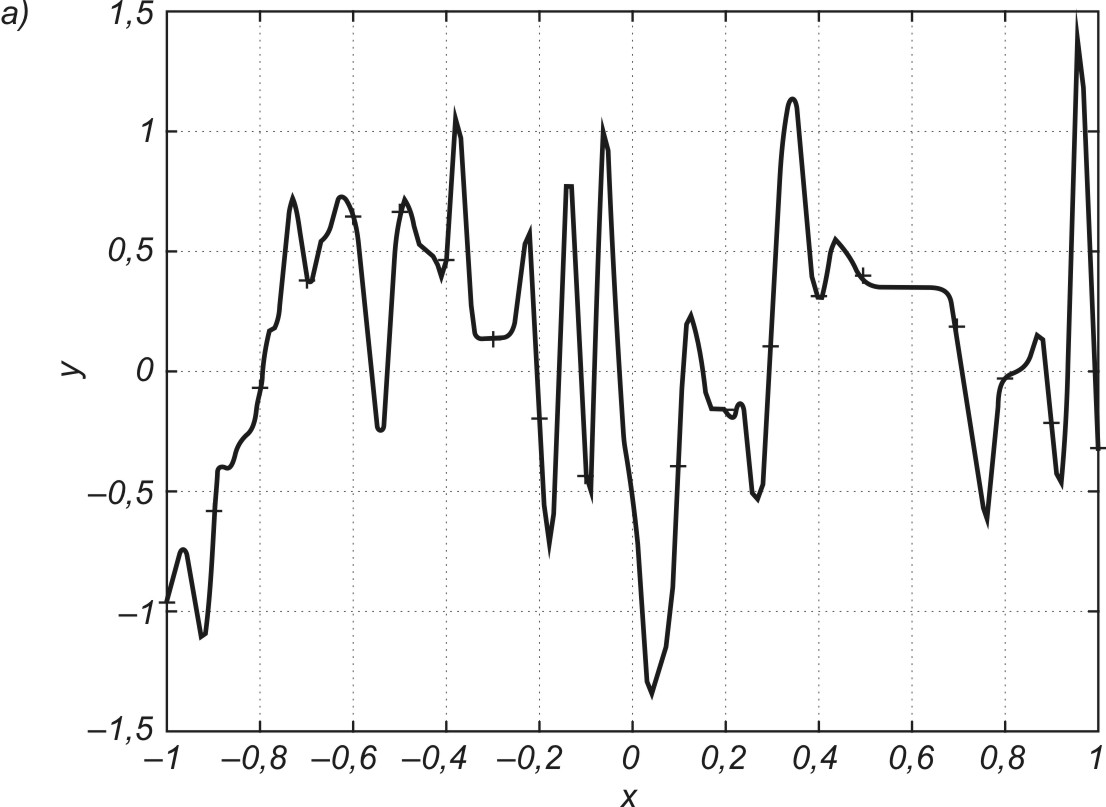

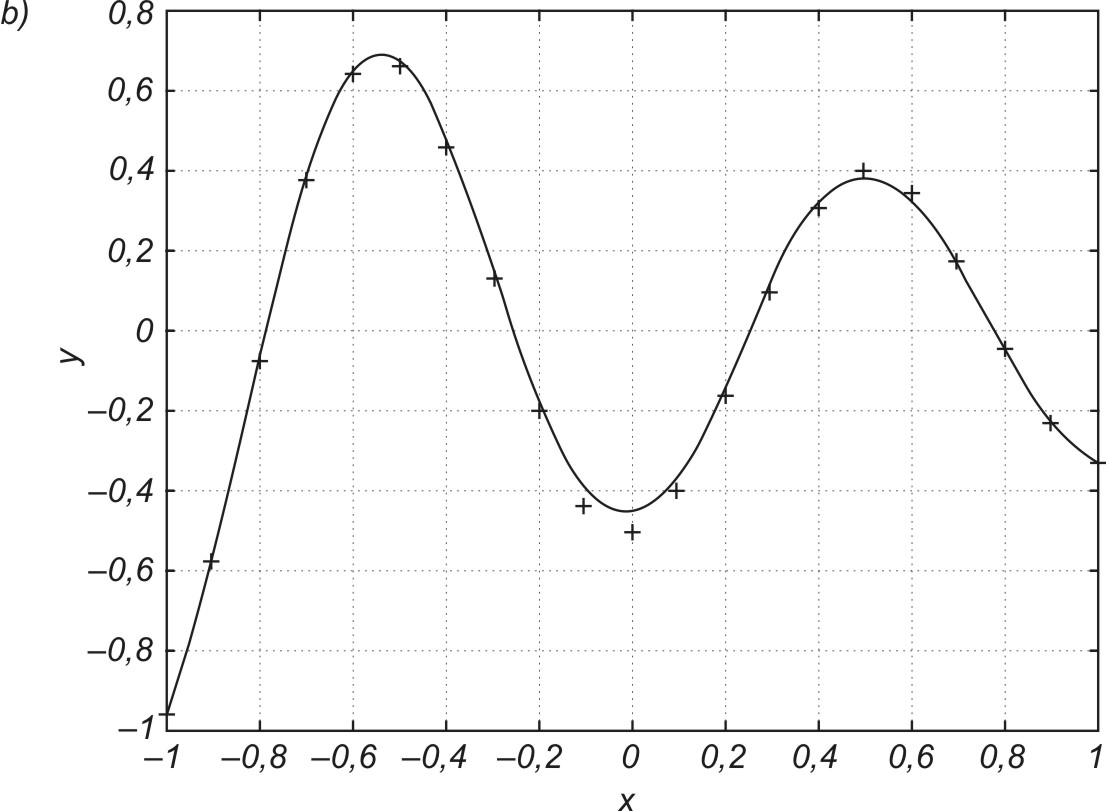

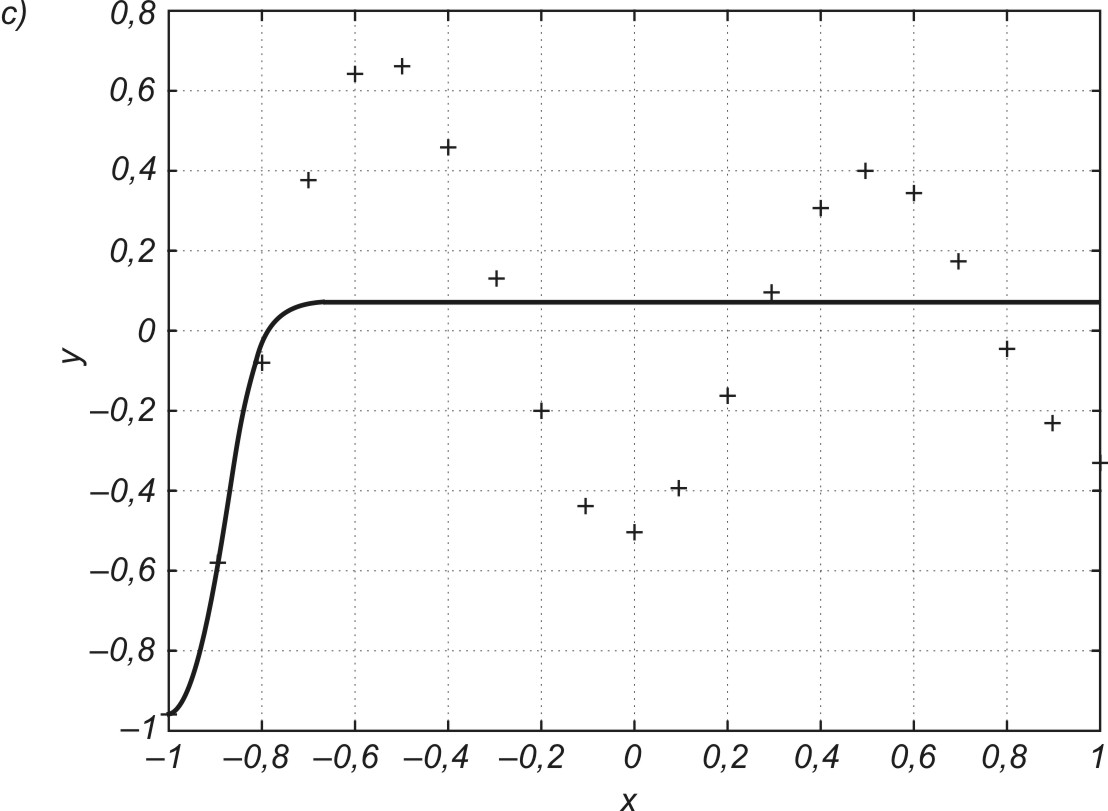

w którym pierwszy składnik odpowiada zwykłej metodzie największego spadku, natomiast składnik drugi, zwany składnikiem momentu rozpędowego uwzględnia ostatnią zmianę wag i jest niezależny od aktualnej wartości gradientu. Współczynnik momentu α jest zwykle przyjmowany z zakresu [0, 1] Należy zauważyć, że im większa jest wartość tego współczynnika, tym składnik wynikający z momentu ma większy wpływ na dobór wag. Jego wpływ wzrasta w sposób istotny w pobliżu minimum lokalnego, gdzie wartość gradientu jest bliska zeru. W tym przypadku możliwe są zmiany wag, prowadzące do wzrostu wartości funkcji celu, a więc pokonania bariery ograniczającej minimum lokalne. Ilustracja takiego przypadku przedstawiona jest na rys. 1.4, w zastosowaniu do sieci aproksymującej (spełniającej rolę układu aproksymującego dane wejściowe).

Punkty zaznaczone na wykresie oznaczają wartości funkcji celu uzyskiwane w kolejnych krokach uczących. Minimum lokalne P1 zostało opuszczone w wyniku działania momentu. Umożliwiło to znalezienie nowego minimum w punkcie P2 o mniejszej wartości funkcji celu, a więc korzystniejszego ze względu na dopasowanie wartości yi do wartości zadanej di. Należy podkreślić, że czynnik momentu nie może całkowicie zdominować procesu uczenia, gdyż prowadziłoby to do braku stabilizacji algorytmu. Zwykle kontroluje się wartość błędu (yi-di) w procesie uczenia, dopuszczając do jego wzrostu jedynie w ograniczonym zakresie, np. o 5%. W takim przypadku, jeśli wzrost błędu w kolejnym kroku jest mniejszy niż 5% krok jest akceptowany i w efekcie następuje uaktualnienie wartości wag. Jeśli natomiast wartość błędu przekracza założoną wartość 5% zmiany są ignorowane. Przy jednoczesnym założeniu \( \Delta w_{ij} (k) = 0 \) we wzorze (1.10) składnik gradientowy odzyskuje dominację nad składnikiem momentu zmuszając algorytm do działania zgodnego z klasycznym algorytmem największego spadku.

1.3. Funkcja ReLU aktywacji neuronu

Model sigmoidalny wykorzystuje sigmoidę jako funkcję aktywacji neuronu. Jest to funkcja gładka, zachowując ciągłość również dla pierwszej pochodnej (element ważny w procesie optymalizacji). Cechą charakterystyczną tego modelu jest jego aktywny charakter tylko w ograniczonym zakresie wartości i wystąpienie stanu nasycenia poza tym zakresem. Daje to efekt stagnacji w procesie uczenia, spowalniając dojście do rozwiązania, zwłaszcza przy bardzo dużej liczbie optymalizowanych parametrów (sieci głębokie).

Dogłębne badania problemu wykazały, że ciągłość pochodnej w procesie optymalizacji nie jest warunkiem koniecznym. Dużo lepsze wyniki uzyskuje się stosując znacznie uproszczoną, odcinkami liniową postać funkcji aktywacji, eliminując stan nasycenia. Powszechnie stosowaną formą w sieciach głębokich jest funkcja ReLU (ang. Rectified Linear Unit), którą można zapisać w postaci [78]

| \( y(x) = \begin{cases} { \begin{matrix} x \textrm{ dla } x>0 \\ 0 \textrm{ dla } x \leq 0 \end{matrix} } \end{cases} \) |

(1.11) |

Jest to postać liniowa dla dodatnich wartości argumentu i zero dla wartości ujemnych. Pochodna tej funkcji jest równa 1 w zakresie dodatnim i zero dla wartości ujemnych argumentu. Współcześnie występuje wiele różnych modyfikacji tej funkcji. Więcej na ich temat będzie w rozdziale dotyczącym sieci głębokich.

1.4. Model radialny neuronu

Innym rozwiązaniem stosowanym w sieciach neuronowych jest neuron o radialnej funkcji bazowej (aktywacji). Jest to zwykle funkcja typu gaussowskiego, która dla wielkości skalarnych może być opisana wzorem [24]

| \( \varphi (x) = \exp \left( - \frac{(x-c)^2}{\sigma^2 } \right) \) |

(1.12) |

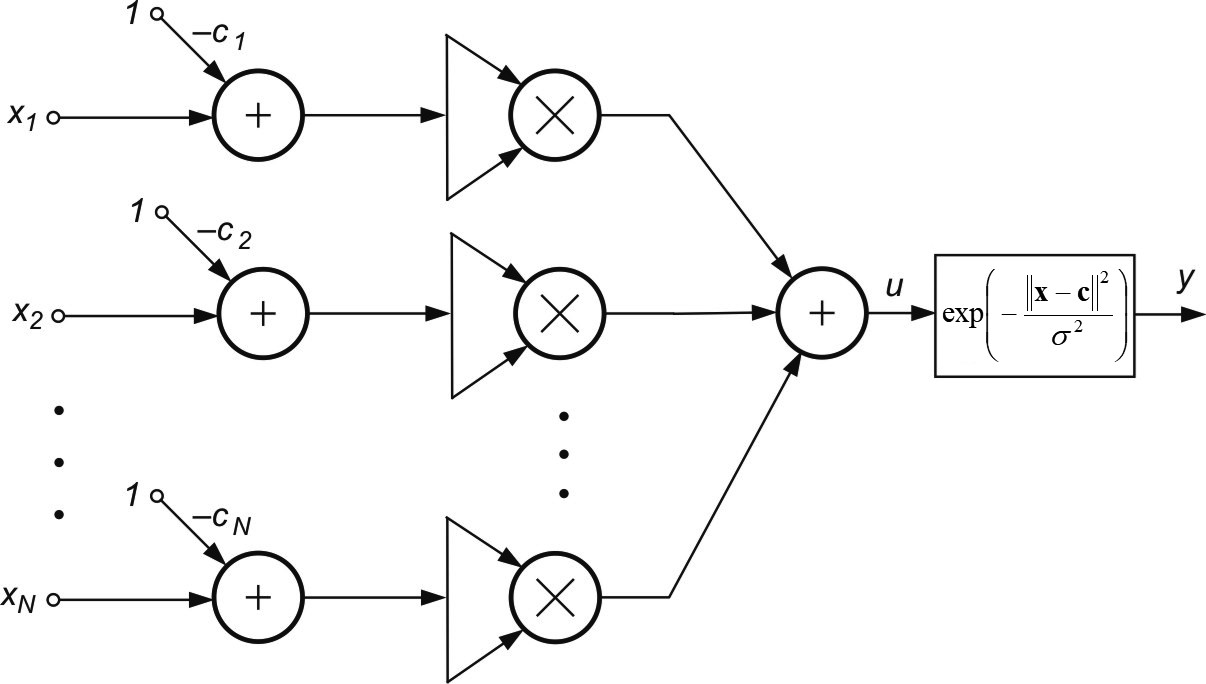

Wartość funkcji różna od zera występuje jedynie dla zmiennych \( x \) w pobliżu centrum \( c \). Wartość parametru \( \sigma \) decyduje o szerokości tej funkcji. Przy założeniu, że każdy neuron radialny poddany jest działaniu \( N \) sygnałów wejściowych tworzących wektor \( \mathbf{x} \) wartość sygnału wyjściowego \( y(\mathbf{x}) \) tego neuronu można wyrazić wzorem

| \( \varphi (\textbf {x}) = \exp \| - \frac{(\textbf{x}-\textbf{c})^2}{\sigma^2 } \| \) |

(1.13) |

w którym \( \mathbf{x} \) jest \( N \)-wymiarowym wektorem wejściowym, podobnie jak wektor centrów \( \mathbf{c} \). Jeżeli weźmiemy pod uwagę, że \( \Vert \textbf{x}-\textbf{c} \Vert ^2 =(x_1-c_1)^2 + (x_2-c_2)^2 + ... + (x_N-c_N)^2 \) wówczas strukturę szczegółową modelu neuronu radialnego można przedstawić w postaci pokazanej na rys. 1.5.

Pomimo pozornego podobieństwa ogólnej postaci neuronu sigmoidalnego i radialnego ich szczegółowe realizacje różnią się znacznie między sobą. Nieliniowość w neuronie radialnym dotyczy wartości sygnału obliczanego nie według zależności liniowej, jak dzieje się to w neuronie sigmoidalnym, ale według zależności nieliniowej (norma euklidesowa wektora).

Uczenie neuronu radialnego polega na doborze wektora centrum i szerokości funkcji radialnej \( \sigma \). Ze względu na lokalny charakter funkcji Gaussa (niezerowa wartość funkcji jedynie w pobliżu centrum) możliwe są tu znaczne uproszczenia, poprzez zastosowanie algorytmu samoorganizacji, adaptującego optymalne położenia centrów dla poszczególnych zmiennych jako środek odpowiedniej grupy danych uczących reprezentowanych przez wektory wejściowe \( \mathbf{x} \).

Najprostszy algorytm samoorganizacji polega na prezentacji wektorów uczących \( \mathbf{x} \) i obliczeniu ich odległości od centrów \( \mathbf{c}_i \) neuronów (na początku wagi centrów są dobierane losowo). Każdy wektor \( \mathbf{x}_i \) jest przypisywany do wektora \( \mathbf{c}_i \) najbliższego mu. Zbiór wektorów \( \mathbf{x} \) przypisanych do jednego centrum tworzy klaster, dla którego oblicza się nowe centrum będące średnią ze wszystkich wektorów \( \mathbf{x} \) przypisanych do niego

| \( \textbf{c}_i = \sum_{j=1}^{N_i} \textbf{x}_j \) |

(1.14) |

Uaktualnianie wartości wszystkich centrów odbywa się równolegle. Proces prezentacji zbioru wektorów \( \mathbf{x} \) oraz uaktualniania wartości centrów powtarzany jest wielokrotnie aż do ustalenia się wartości centrów.

Współczynnik \( \sigma \) jest dobierany w taki sposób, aby wartości funkcji radialnych sąsiednich neuronów pokrywały się częściowo ze sobą (dla zapewnienia gładkiego odwzorowania). Często przyjmuje się wartość stałą dla wszystkich neuronów (dla danych znormalizowanych typowa wartość to \( \sigma \cong 1 \)).

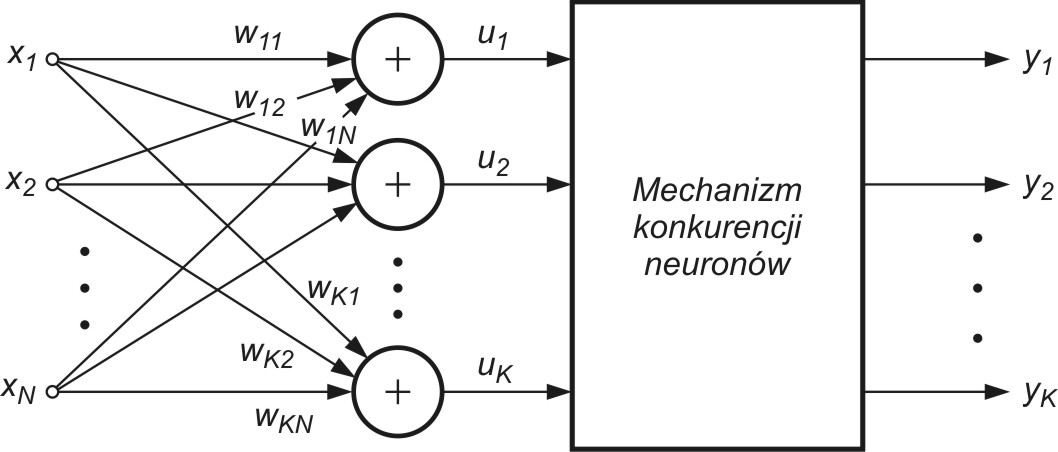

1.5. Model neuronów samoorganizujących się poprzez współzawodnictwo

Specjalny typ stanowią neurony samoorganizujące się poprzez konkurencję. W klasycznym ujęciu mają one stopień wejściowy w postaci standardowego sumatora wagowego o wagach \( w_{ij} \)(rys. 1.6), dla którego sygnał wyjściowy \(i\)-tego sumatora opisany jest relacją| \( u_i = \sum_{j=1}^N w_{ij} x_j = \mathbf{w}_i^T \mathbf{x} = \mathbf{x}^T \mathbf{w}_i \) |

(1.15) |

w której x jest znormalizowanym \( N \)-wymiarowym wektorem wejściowym a \( \mathbf{w}_i \) wektorem wagowym \( i \)-tego neuronu.

Grupa neuronów współzawodniczących ze sobą pobudzana jest tymi samymi sygnałami wejściowymi \( \mathbf{x}_j \). W zależności od aktualnych wartości sygnałów sumacyjnych \( \mathbf{u}_i \) poszczególnych neuronów za zwycięzcę uważa się neuron, którego wartość \( \mathbf{u}_i \) jest największa. Neuron zwycięzca przyjmuje na swoim wyjściu stan \( 1 \), a pozostałe (przegrywające) stan zero. Ze względu na normalizację sygnałów wejściowych neuronem zwycięskim jest zawsze ten, który znajduje się najbliżej aktualnego wektora wejściowego \( \mathbf{x} \), a więc o najmniejszej wartości normy \( d(\mathbf{x},\mathbf{w_i}) = \Vert \mathbf{x} - \mathbf{w}_i \Vert \). W praktyce zamiast obliczać sumy wagowe poszczególnych neuronów w procesie wyłaniania zwycięzcy oblicza się miary odległościowe i na tej podstawie wyłania zwycięzcę [46]. Najprostsza adaptacja wag neuronów jest typu WTA (ang. Winner Takes All) i nie wymaga nauczyciela. Na wstępie przyjmuje się losowe, znormalizowane wartości wag poszczególnych neuronów. Po podaniu wektora wejściowego \( \mathbf{x} \) wyłaniany jest zwycięzca. Neuron zwyciężający w konkurencji przyjmuje stan 1, a pozostałe 0. Aktualizacja wag odbywa się według wzoru Grosberga zapisanego w formie skalarnej dla \( j \)-tej wagi wektora \( i \)-tego

| \( w_{ij} (k+1) = w_{ij} (k) + \eta [ x_j - w_{ij}(k) ] \) |

(1.16) |

lub wektorowej

| \( \mathbf{w}_{i} (k+1) = \mathbf{w}_{i} (k) + \eta [ \mathbf{x} - \mathbf{w}_{i}(k) ] \) |

(1.17) |

Zauważmy, że w formule WTA jedynie neurony zwycięskie o sygnale wyjściowym \( y_i = 1 \) uaktualniają swoje wagi. Neurony przegrywające konkurencję nie zmieniają swoich wag. W efekcie takiej organizacji algorytmu uczącego wektory wagowe neuronów podążają za wektorami uczącymi \( \mathbf{x} \), przyjmując w efekcie uśrednione wartości wektorów wejściowych, dla których dany neuron był zwycięzcą. W praktyce stosuje się również strategię WTM (Winner Takes Most), w której neurony przegrywające konkurencję uczestniczą również w adaptacji swoich wag, ale przy współczynniku adaptacji \( \eta \) uzależnionym od odległości tych neuronów od wektora wejściowego \( \mathbf{x} \).

W wyniku zwycięstwa neuronu następuje douczenie jego wag, przybliżające je do odpowiednich składowych danego wektora \( \mathbf{x} \). Przy podaniu na wejście sieci wielu wektorów zbliżonych do siebie, zwyciężać będzie ciągle ten sam neuron, w wyniku czego jego wagi odpowiadać będą uśrednionym wartościom wektorów wejściowych, dla których dany neuron był zwycięzcą. Neurony przegrywające nie zmieniają swoich wag. Dopiero zwycięstwo przy następnej prezentacji wektora wejściowego umożliwi im dokonanie aktualizacji wag i rozpoczęcie procesu douczania przy kolejnych zwycięstwach. W efekcie takiego współzawodnictwa następuje automatyczne grupowanie danych. Neurony dopasowują swoje wagi w ten sposób, że przy prezentacji grup wektorów wejściowych zbliżonych do siebie zwycięża zawsze ten sam neuron. Neuron ten reprezentować będzie swoimi wagami wszystkie wektory \( \mathbf{x} \) znajdujące się w jego strefie dominacji. W efekcie powstaje samoczynny podział danych na klastry reprezentowane przez neuron zwycięzcę. Układy tego typu są stosowane najczęściej do grupowania danych jak również do klasyfikacji wektorów.

1.6. Model neuronu Hebba

Donald O. Hebb, badając działanie komórek nerwowych [24] zauważył, że powiązanie wagowe dwóch komórek jest wzmacniane, jeśli obie komórki są jednocześnie pobudzone (stają się aktywne). Jeśli \( j \)-ta komórka o sygnale wyjściowym \( y_j \) powiązana jest z \( i \)-tą o sygnale wyjściowym \( y_i\) przez wagę \( w_{ij} \), wówczas na stan powiązań tych komórek wpływają wartości ich sygnałów \( y_j \) oraz \( y_i \).

D. Hebb zaproponował regułę matematyczną, w której uwzględniony został wynik tej obserwacji. Zgodnie z regułą Hebba, zmiana wagi \( w_{ij}\) neuronu odbywa się proporcjonalnie do iloczynu jego sygnału wejściowego oraz wyjściowego [46]

| \( w_{ij} (k+1) = w_{ij} (k) + \eta y_i y_j \) |

(1.18) |

przy współczynniku \(\eta\) reprezentującym wartość stałej uczenia. Reguła Hebba może być stosowana do różnego typu struktur sieci neuronowych i różnych funkcji aktywacji zastosowanych w modelu neuronu.

Ogólny model neuronu Hebba, przedstawiony na rys. 1.7, odpowiada standardowej postaci modelu. Waga \( w_{ij} \) włączona jest między sygnałem wejściowym \( y_j \) a węzłem sumacyjnym \( i \)-tego neuronu o sygnale wyjściowym \( y_i \).

Uczenie neuronu z zastosowaniem reguły Hebba może się odbywać w trybie bez nauczyciela lub z nauczycielem. W pierwszym przypadku w regule Hebba używa się aktualnej wartości \( y_i \) sygnału wyjściowego neuronu (wzór (1.18)). W uczeniu z nauczycielem wartość sygnału wyjściowego \( y_i \) zastępuje się wartością zadaną \( d_i \) dla tego neuronu. Regułę Hebba można wówczas zapisać w postaci

| \( w_{ij} (k+1) = w_{ij} (k) + \eta d_i y_j \) |

(1.19) |

Reguła Hebba charakteryzuje się tym, że w jej wyniku wagi mogą przybierać wartości dowolnie duże i nie podlegają stabilizacji, gdyż w każdym cyklu uczącym następuje proces sumowania aktualnych przyrostów wartości wag.

Jedną z metod poprawy stabilności procesu uczenia według reguły Hebba jest przyjęcie przy aktualizacji wag nie ostatniej wartości \( w_{ij} \) ale wartości zmniejszonej o tak zwany współczynnik zapominania \( \gamma \) Wówczas regułę Hebba można zapisać w postaci

| \( w_{ij} (k+1) = (1-\gamma) w_{ij} (k) + \eta y_i y_j \) |

(1.20) |

Współczynnik zapominania \(\gamma\) zawiera się zwykle w przedziale (0, 1) i stanowi najczęściej niewielki procent stałej uczenia \(\eta\). Przyjęcie dużej wartości \(\gamma\) powoduje, że neuron zapomina większość tego, co zdołał nauczyć się w przeszłości. Uczenie Hebba zaliczane jest do uczenia typu korelacyjnego, gdyż w swojej istocie uwzględnia korelacje zachodzące między sygnałami neuronów sieci.

Stabilizacja reguły Hebba przez wprowadzenie współczynnika zapominania zawodzi w przypadku neuronu liniowego. Dla neuronu liniowego Hebba jego sygnał wyjściowy opisany jest zależnością linową \(y_i=\mathbf{w}_i^T \mathbf{x}=\mathbf{x}^T \mathbf{w}_i\), w której \( \mathbf{w}_i\) jest wektorem wagowym neuronu \(i\)-tego a \( \mathbf{x}\) wektorem sygnałów wejściowych tego neuronu. Zostało udowodnione, że w takim przypadku wartości wag \( \mathbf{x}\) procesie uczenia nigdy nie stabilizują się, a proces uczenia się nie kończy. Stabilizacja wag (połączona z jednoczesną normalizacją) jest możliwa przez wprowadzenie modyfikacji reguły Hebba. Zgodnie z modyfikacją zaproponowana przez E. Oję [46] aktualizacja wag \( w_{ij} \) wektora \( \mathbf{w}_i\) przebiega według wzoru

| \( w_{ij} (k+1) = w_{ij} (k) + \eta ( x_j - w_{ij} y_i ) \) |

(1.21) |

Reguła ta przypomina propagację wsteczną, gdyż sygnał \(x_j\) jest modyfikowany przez sygnał wsteczny, pochodzący od sygnału wyjściowego \(y_i\) neuronu. Przy jednym neuronie reguła Oji jest regułą lokalną, gdyż w procesie modyfikacji sygnału \(x_j\) bierze udział tylko waga, którą aktualnie adaptujemy.

1.7. Zadania i problemy

1. Narysować przebiegi funkcji sigmoidalnej unipolarnej \( f(u)= \frac{1}{1+ \exp ( - \beta u )} \) oraz bipolarnej \( f_b(u) = \text{tgh} (\beta u) \) w funkcji zmiennej u dla różnych wartości współczynnika \( \beta \) od 0.1 do 10.

2. Inną postacią funkcji sigmoidalnej jest \( f(u) = \frac{u}{\sqrt{1+u^2}} \). Wykreślić jej przebieg w funkcji zmiennej u. Udowodnić, że pochodna tej funkcji jest równa \( \frac{df(u)}{du} = \frac{f^3(u)}{u^3} \). Wykreślić przebieg pochodnej jako funkcję zmiennej u.

3. Neuron otrzymuje pobudzenie w postaci sygnałów wejściowych tworzących wektor \(\mathbf{<span>x}=[10 \; -10 \; 2 \; -2]^T\)

. Wektor wag wejściowych jest równy \(\mathbf{<span>x}=[0.4 \; 0.3\; -1\; 0.8]^T\). Określić odpowiedź tego neuronu przy założeniu, że-

neuron jest liniowy

-

neuron jest reprezentowany przez model McCullocha-Pittsa

-

neuron jest sigmoidalny bipolarny \( f_b(u) = \text{tgh}(u) \).

4. Porównać kształt funkcji radialnej gaussowskiej przy różnych wartościach parametru \( \sigma \). Wykreślić te funkcje na wspólnym wykresie. Narysować wykres zmian zależności sumy trzech funkcji gaussowskich o centrach przesuniętych w taki sposób, że suporty każdej z nich częściowo pokrywają się ze sobą, przy różnych wartościach \( \sigma \) jako funkcje zmiennej wejściowej \(x\).

5. Neuron RBF o gaussowskiej funkcji aktywacji z centrum \(\mathbf{<span>c}=[1 \; 0.5 \; 0.2 ]^T \) i wartością \( \sigma = 0.5\) otrzymał pobudzenie sygnałami \(x\) tworzącymi wektor trójwymiarowy \(\mathbf{x}=[0.8 \; 0.2 \; 0.1]^T \). Określić sygnał wyjściowy neuronu dla każdego z tych pobudzeń.

6. Dwa neurony o wagach: \(\mathbf{w}_1=[ 0.1 \; -0.2 \; 0.5 ]^T \), \(\mathbf{w}_2= [ -0.5 \; 0.5 \; 0.8]^T\) trenowane są poprzez współzawodnictwo w trybie WTA. Określić ich wagi po pierwszej iteracji przy istnieniu następujących wektorów uczących: \(\mathbf{x}=[ 0.1 \; 0.1 \; 0.6 ]^T \), \(\mathbf{x}= [ 0.2 \; -0.3 \; 0,7 ]^T \), \(\mathbf{x}= [ 0 \; -0.31 \; 0.9 ]^T \), \(\mathbf{x} = [ -0.4 \; 0.4 \; 0.9]^T \), \(\mathbf{x}= [-0.3 \; 0.6 \; 0.7]^T\), \(\mathbf{x}= [ 0.1 \; 0 \; 0.5]^T \), \(\mathbf{x}= [ -0.2 \; 0.6 \; 0.9]^T \), \(\mathbf{x}= [ -0.6 \; 0.3 \; 0.7]^T \) przy założeniu \(\eta=0.2\).

7. Dwa neurony o wagach \(\mathbf{w}_1=[ 0.2 \; 0.3 \; 0.8 ]^T \), \(\mathbf{w}_2= [ -1 \; 0.5 \; 0.5]^T \) pobudzono tymi samymi sygnałami \(x\) tworzącymi wektor \(\mathbf{x}= [ 0.1 \; 0.4 \; 0.6]^T \). Określić zwycięzcę posługując się miarą odległościową oraz iloczynem skalarnym wektorów.

1.8. Słownik

Słownik opanowanych pojęć

- Model neuronu – matematyczny opis przetwarzania sygnałów wzorujących się na procesach neuronowych w organizmach żywych.

- Model McCullocha-Pittsa – model neuronu stosujący skokową funkcję aktywacji.

- Model sigmoidalny – model neuronu stosujący sigmoidalną funkcję aktywacji

- Model radialny – model neuronu stosujący jako aktywację funkcję gaussowską.

- Model Hebba – model neuronu w którym zmiana wagi neuronu odbywa się proporcjonalnie do iloczynu jego sygnału wejściowego oraz wyjściowego.

- ReLU – funkcja aktywacji odcinkowo-liniowa opisana wzorem y(x)=x dla x>0 i zero w przeciwnym przypadku.

- Uczenie z nauczycielem – proces adaptacji parametrów sieci wykorzystujący parę danych (x,d), gdzie x reprezentuje sygnały wejściowe, a d wartość zadaną na wyjściu.

- Uczenie bez nauczyciela – proces adaptacji parametrów sieci przy znajomości jedynie danych wejściowych x (bez wartości zadanej na wyjściu).

- Uczenie ze wzmocnieniem – sposób adaptacji parametrów sieci wykorzystujący interakcje agenta ze środowiskiem, ukierunkowaną na zmaksymalizowanie zwracanej nagrody.

- Sztuczne sieci neuronowe – układ połączeń neuronów między sobą wzorujący się na sposobie przetwarzania danych w organizmach żywych.

- Moment rozpędowy – poprawka w uczeniu metodą największego spadku uwzględniająca ostatnią zmianę parametrów.

- Uczenie ze współzawodnictwem – metoda adaptacji parametrów neuronów współzawodniczących ze sobą pod względem odległości do aktualnego wektora wejściowego x.

- Reguła uczenia Oji – poprawiona przez Oję reguła Hebba w której sygnał wejściowy jest modyfikowany przez sygnał wsteczny, pochodzący od sygnału wyjściowego neuronu.

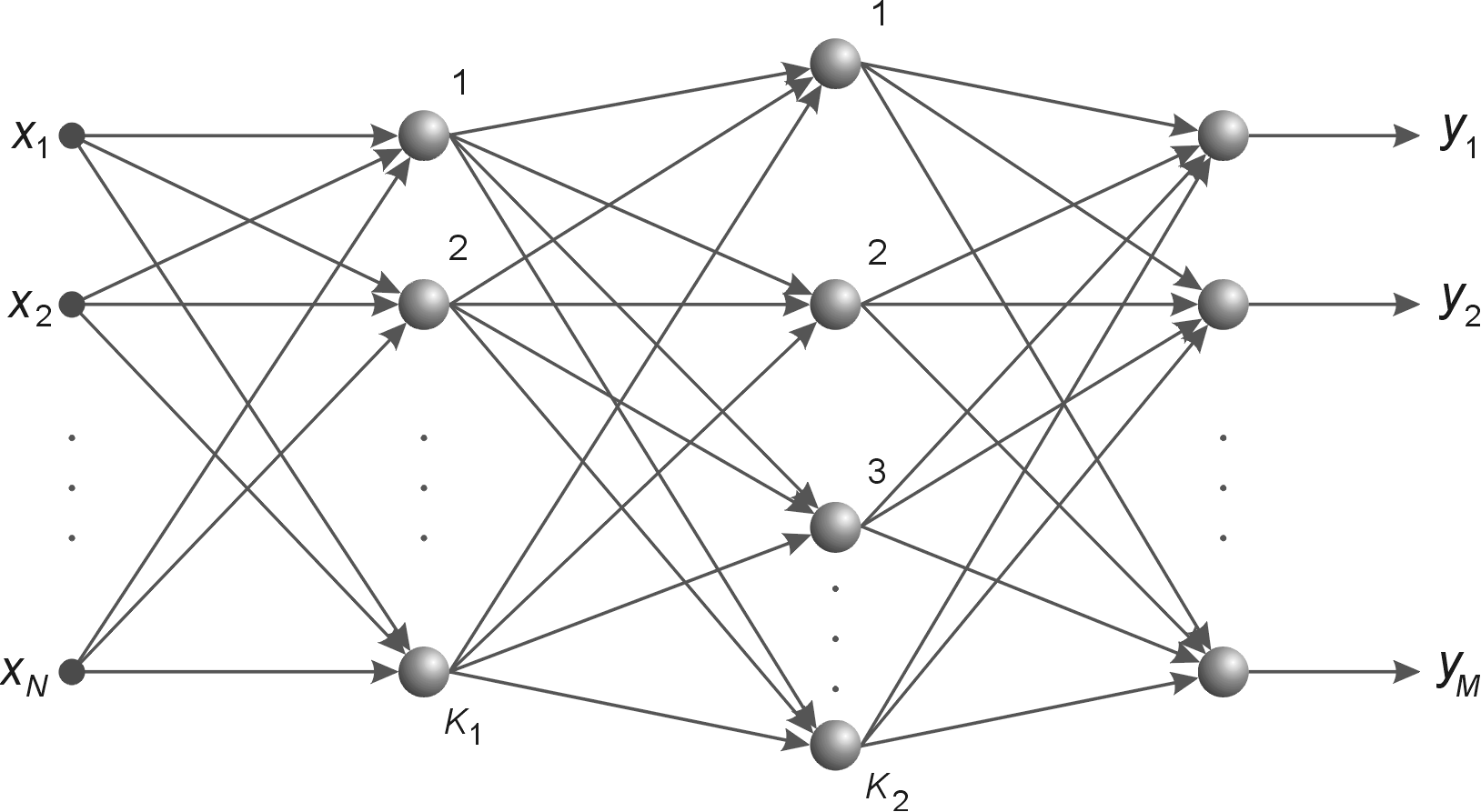

2. Sieć perceptronu wielowarstwowego MLP

Neurony połączone między sobą tworzą strukturę, zwykle w układzie warstwowym, która jest nazywana sztuczną siecią neuronową, w skrócie siecią neuronową. W zależności od sposobu połączenia neuronów mogą to być sieci jednokierunkowe lub rekurencyjne (ze sprzężeniem zwrotnym). Spośród wielu istniejących rodzajów sieci neuronowych dużym zainteresowaniem cieszy się w dalszym ciągu sieć jednokierunkowa, wielowarstwowa o neuronach typu sigmoidalnego, zwana w skrócie MLP (ang. MultiLayer Perceptron - MLP).

2.1. Wprowadzenie

Metody uczenia sieci jednokierunkowej, wielowarstwowej o neuronach typu sigmoidalnego są proste i łatwe w implementacji praktycznej, zwykle z nauczycielem, a podstawą uczenia jest zbiór stowarzyszonych par uczących (x, d) , w których x jest wektorem wejściowym, a d odpowiadającym mu, zadanym wektorem wyjściowym sieci. Sieć nazywana jest heteroasocjacyjną, jeśli wektory x oraz d są różne. W przypadku gdy x=d , sieć nosi nazwę autoasocjacyjnej. Funkcja aktywacji neuronu stosowana w sieciach MLP jest typu sigmoidalnego. W wykładzie tym przedstawione zostaną podstawowe zależności odnoszące się do sieci wielowarstwowych sigmoidalnych. Omówione zostaną najważniejsze aspekty metod gradientowych uczenia tych sieci, w tym algorytm propagacji wstecznej generacji, metody poszukiwania kierunku minimalizacji oraz współczynnika uczenia.

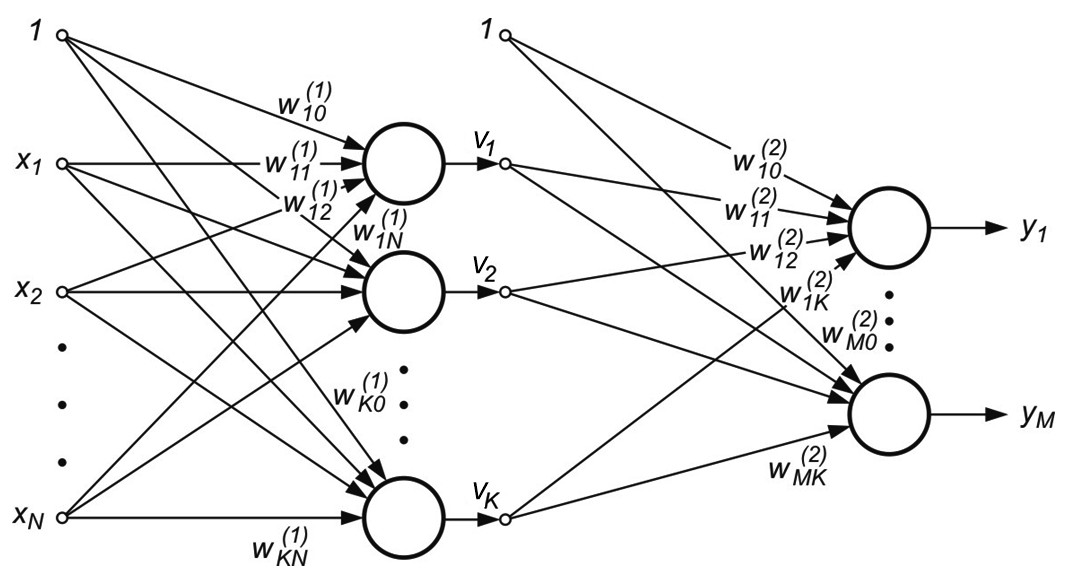

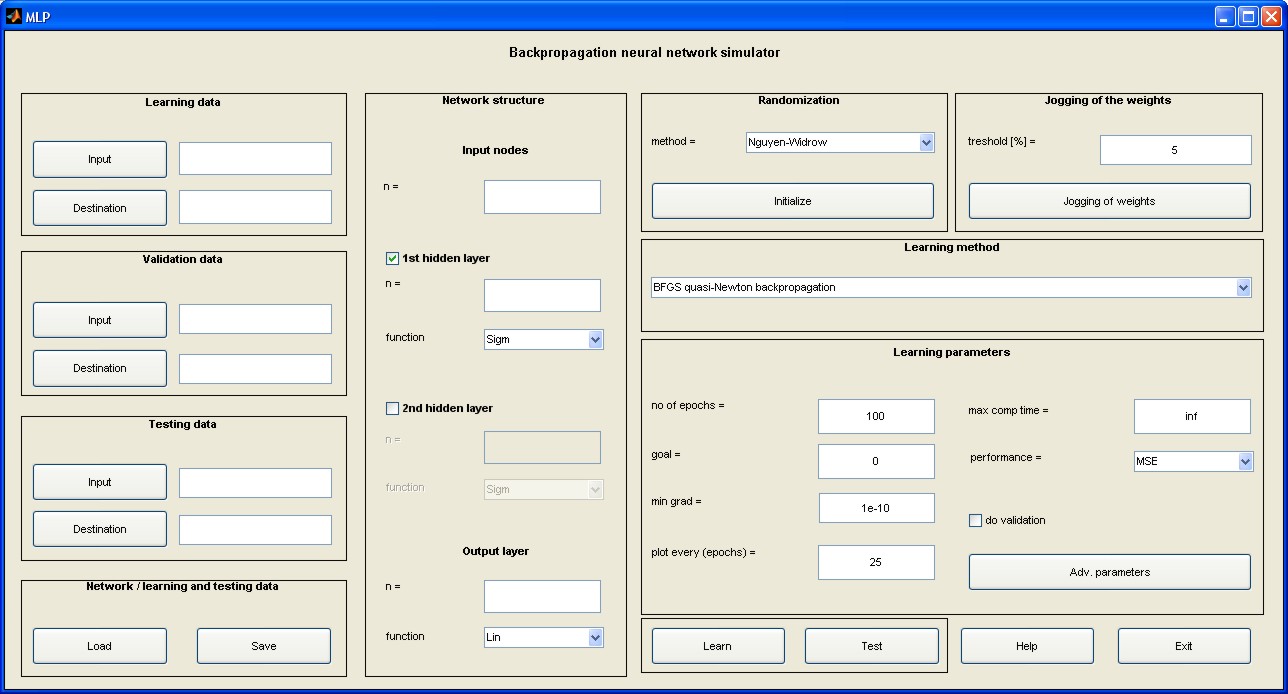

2.2. Struktura sieci wielowarstwowej MLP

Sieć wielowarstwową MLP tworzą neurony ułożone w warstwach połączonych kolejno między sobą, przy czym oprócz warstwy wejściowej i wyjściowej istnieje co najmniej jedna warstwa ukryta.

| a) |  |

| b) |  |

Rys. 2.1 a) Ogólny schemat sieci neuronowej sigmoidalnej o dwu warstwach ukrytych, b) sieć o jednej warstwie ukrytej z oznaczeniem połączeń wagowych i polaryzacją

Na rys. 2.1b przedstawiono sieć o jednej warstwie ukrytej [46]. Połączenia międzyneuronowe występują jedynie między sąsiednimi warstwami (w kierunku od wejścia do wyjścia). Stosowane będą oznaczenia sygnałów i wag zgodnie z rysunkiem. Wagi neuronów warstwy ukrytej otrzymają wskaźnik górny (1), natomiast warstwy wyjściowej wskaźnik (2). Sygnały wyjściowe neuronów warstwy ukrytej oznaczone są symbolem \( v_j (j=1, 2, \ldots, K) \), a warstwy wyjściowej symbol \( y_j (j=1, 2, \ldots, M) \). Zakłada się, że funkcja aktywacji neuronów jest dana w postaci sigmoidalnej unipolarnej bądź bipolarnej. Dla uproszczenia oznaczeń przyjęte będzie rozszerzone oznaczenie wektora wejściowego \( \textbf{x} \) sieci w postaci \( \textbf{x}=[x_0, x_1, x_2, \ldots, x_N]^T \), w którym \( x_0=1 \) oznacza sygnał jednostkowy polaryzacji. Z wektorem \( \textbf{x} \) są związane dwa wektory wyjściowe sieci: wektor aktualny \( \textbf{y}=[y_1, y_2, \ldots, y_M]^T \) oraz wektor zadany \( \textbf{d}=[d_1, d_2, \ldots, d_M]^T \).

Celem uczenia jest określenie wartości wag \( w_{ij}^{(1)} \) oraz \( w_{ij}^{(2)} \) wszystkich warstw sieci w taki sposób, aby przy zadanym wektorze wejściowym \( \textbf{x} \) uzyskać na wyjściu wartości sygnałów wektora \( \textbf{y} \) odpowiadające z dostateczną dokładnością wartościom zadanym reprezentowanym przez wektor \( \textbf{d} \). Traktując jednostkowy sygnał polaryzujący jako jedną ze składowych wektora wejściowego \( \textbf{x} \), wagi polaryzacji można włączyć do wektora wag poszczególnych neuronów obu warstw. Przy takim oznaczeniu sygnał wyjściowy \( i \)-tego neuronu warstwy ukrytej daje się opisać wzorem

| \( v_i=f\left(\sum_{j=0}^N w_{i j}^{(1)} x_j\right) \) | (2.1) |

w której wskaźnik \( j=0 \) odpowiada sygnałowi oraz wagom polaryzacji. W przypadku warstwy wyjściowej \( k\)-ty neuron wytwarza sygnał wyjściowy opisany następująco

| \( y_k=f\left(\sum_{i=0}^K w_{k i}^{(2)} v_i\right)=f\left(\sum_{i=0}^K w_{k i}^{(2)} f\left(\sum_{j=0}^N w_{i j}^{(1)} x_j\right)\right) \) | (2.2) |

Powyższy wzór reprezentuje formułę tak zwanego uniwersalnego aproksymatora, gdyż definiuje jawną postać funkcji aproksymującej, realizowanej przez sieć. Jak wynika z zależności (2.2), na wartość sygnału wyjściowego mają wpływ wagi obu warstw, których właściwy dobór pozwala dopasować wartości funkcji aproksymującej do wielkości zadanych (\( \textbf{x} \), \( \textbf{d} ) \).

2.3. Proces uczenia sieci metodami gradientowymi optymalizacji

Podstawę uczenia sieci MLP stanowi minimalizacja wartości funkcji celu (błędu), definiowanej klasycznie jako suma kwadratów różnic między aktualnymi wartościami sygnałów wyjściowych sieci a wartościami zadanymi. W przypadku pojedynczej próbki uczącej \( (\mathbf{x},d) \) i zastosowaniu normy euklidesowej funkcję celu definiuje się w postaci

| \( E=\frac{1}{2} \sum_{i=1}^M\left(y_i(\mathbf{x})-d_i\right)^2 \) | (2.3) |

W przypadku wielu par uczących (\( (\textbf{x}_k, \textbf{d}(\textbf{x}_k)) \) dla \( k=(1, 2, \ldots, p) \) funkcję celu stanowi suma błędów po wszystkich parach uczących

| \( E=\frac{1}{2} \sum_{k=1}^p\left\|y\left(\mathbf{x}_k\right)-\mathbf{d}\left(\mathbf{x}_k\right)\right\|^2=\frac{1}{2} \sum_{k=1}^p \sum_{i=1}^M\left(y_i\left(\mathbf{x}_k\right)-d_i\left(\mathbf{x}_k\right)\right)^2 \) | (2.4) |

W uproszczeniu można założyć, że celem uczenia sieci jest określenie wartości wag neuronów wszystkich warstw sieci w taki sposób, aby przy zadanym wektorze wejściowym \( \mathbf{x} \) uzyskać na wyjściu sieci wartości sygnałów wyjściowych \(y_i(\mathbf{x}) \), odpowiadające z dostateczną dokładnością wartościom zadanym \( d_i(\textbf{x}) \) dla \( i=1, 2, \ldots, M \). Obliczanie wartości funkcji celu i związane z nim uaktualnianie wartości wag w procesie uczenia może odbywać się po każdorazowej prezentacji każdej próbki uczącej (uczenie typu on-line) lub jednorazowo, po prezentacji wszystkich próbek tworzących cykl uczący (uczenie wsadowe typu off-line). Niezależnie od sposobu uczenia wartość błędu tworzącą funkcję celu należy obliczać po każdorazowej prezentacji pary uczącej. Uczenie sieci przy zastosowaniu algorytmu propagacji wstecznej składa się z kilku faz.

W fazie pierwszej następuje pobudzenie sieci poprzez sygnały wejściowe tworzące wektor \( \textbf{x} \) i obliczenie wartości sygnałów poszczególnych neuronów w sieci. Dla danego wektora \( \textbf{x} \) obliczane są wartości sygnałów \( v_i \) neuronów warstwy ukrytej, a następnie wartości \( y_i \) odpowiadające neuronom warstwy wyjściowej. Wykorzystuje się przy tym zależności (2.1) i (2.2). Po obliczeniu wartości sygnałów wyjściowych \( y_i \) możliwe staje się określenie aktualnej wartości funkcji celu \( E \) danej wzorem (2.3) lub (2.4).

W drugiej fazie algorytmu następuje minimalizacja wartości tej funkcji. Przy założeniu ciągłości funkcji celu najskuteczniejszymi metodami uczenia są gradientowe algorytmy optymalizacyjne, w których adaptacja wektora wag (uczenie) odbywa się zgodnie ze wzorem

| \( \textbf{w}(k+1)=\textbf{w}(k)+\eta\textbf{p}(k) \) | (2.5) |

w którym \( \eta \) jest współczynnikiem uczenia, a \( \textbf{p}(k) \) wektorem kierunkowym minimalizacji w przestrzeni wielowymiarowej utworzonej przez wektor wszystkich wag sieci \( \textbf{w} \). Adaptacja wag odbywa się iteracyjnie z kroku na krok zmieniając wartości elementów wektora \( \textbf{w} \) wzdłuż kierunku \( \textbf{p}(k) \). Kierunek ten jest bezpośrednio związany z wektorem gradientu \( \textbf{g}=\frac{\partial E}{\partial \textbf{w}} \), który powinien być wyznaczany w każdej iteracji. Jedynie w przypadku wag warstwy wyjściowej zadanie to jest określone w prosty sposób poprzez różniczkowanie funkcji prostej określonej wzorem (2.2). Warstwy pozostałe wymagają zastosowania specjalnej strategii postępowania, która w dziedzinie sieci neuronowych nosi nazwę algorytmu propagacji wstecznej (ang. backpropagation) utożsamianym często z procedurą uczenia sieci neuronowej [46].

W ogólności algorytm gradientowy uczenia sieci MLP wymaga wykonania następujących etapów obliczeniowych.

-

Analiza sieci neuronowej o zwykłym kierunku przepływu sygnałów przy pobudzeniu sieci poprzez sygnały wejściowe równe elementom aktualnego wektora \( \textbf{x} \). W wyniku analizy otrzymuje się wartości sygnałów wyjściowych neuronów warstw ukrytych oraz warstwy wyjściowej, a także odpowiednie pochodne funkcji aktywacji w poszczególnych warstwach.

-

Utworzenie sieci propagacji wstecznej przez odwrócenie kierunków przepływu sygnałów, zastąpienie funkcji aktywacji przez ich pochodne o wartości obliczonej w punkcie pracy elementu oryginalnego sieci, a także przyłożenie na byłym wyjściu sieci (obecnie wejściu) wymuszenia w postaci odpowiedniej różnicy między wartością aktualną i zadaną. Dla tak utworzonej sieci propagacji wstecznej należy obliczyć wartości odpowiednich sygnałów w poszczególnych punktach tej sieci.

-

Na podstawie wyników analizy sieci oryginalnej i sieci o propagacji wstecznej określa się wektor gradientu \( \textbf{g} \) a następnie na jego podstawie kierunek minimalizacji \( \textbf{p}(k) \) oraz współczynnik uczenia \( \eta \).

-

Adaptacja wag (uczenie sieci) w \( k \)-tym cyklu uczącym odbywa się według wzoru (2.5) na podstawie wyników uzyskanych w punkcie 3.

-

Opisany w punktach 1, 2, 3, 4 proces należy powtórzyć wielokrotnie dla wszystkich wzorców uczących, kontynuując go do chwili spełnienia warunku zatrzymania algorytmu. Działanie algorytmu kończy się w momencie, w którym norma gradientu spadnie poniżej pewnej z góry określonej wartości tolerancji, określającej dokładność procesu uczenia.

Podstawowym elementem w tym algorytmie uczenia jest wyznaczenie wektora gradientu funkcji celu, stanowiącego podstawę wyznaczania kierunku minimalizacji. W sieciach MLP wektor ten jest określany przy zastosowaniu algorytmu propagacji wstecznej. Algorytm ten zilustrujemy przy użyciu grafów przepływowych.

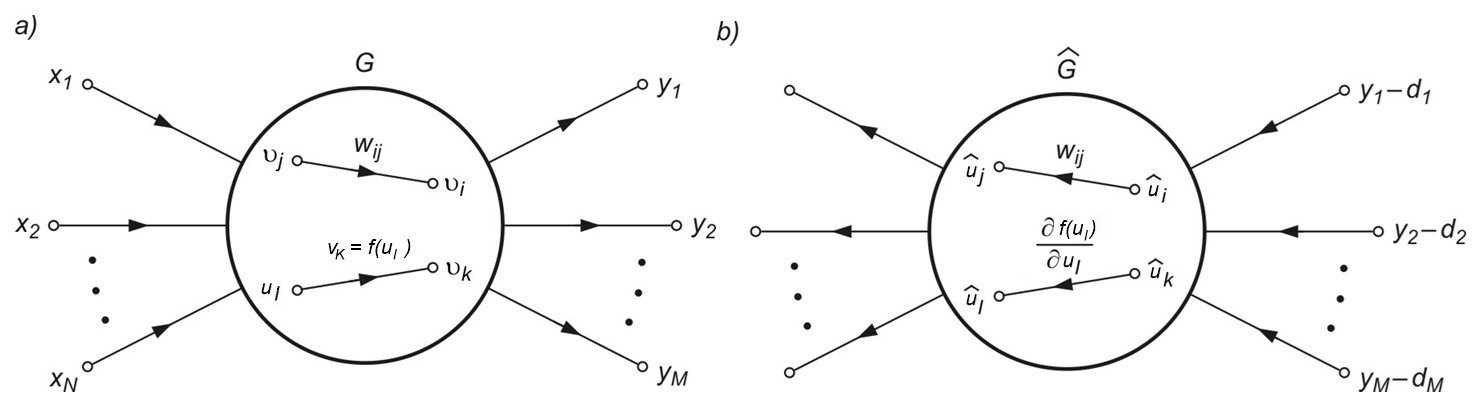

2.4. Generacja gradientu z użyciem grafów przepływu sygnałów

Algorytm propagacji wstecznej stanowi podstawowy etap w uczeniu gradientowym, gdyż pozwala w prosty sposób określić gradient minimalizowanej funkcji celu. Jest on uważany za jeden ze skuteczniejszych sposobów generacji pochodnej funkcji celu dla sieci wielowarstwowej. W metodzie tej dla uniknięcia bezpośredniego różniczkowania złożonej funkcji celu stosuje się graficzną reprezentację systemu za pomocą grafów przepływowych. Przykład symbolicznej reprezentacji sieci MLP o \( N \) wejściach i \( M \) neuronach wyjściowych za pomocą grafu przepływowego przedstawiono na rys. 2.2a. W grafie tym wyróżniona została gałąź liniowa o wadze \( w_{ij} \) łącząca węzeł o sygnale \( v_j \) z węzłem o sygnale \( v_i \) oraz gałąź nieliniowa \( f(v_l) \) określająca sygnał \( v_k=f(v_l) \), w której \( f(v_l) \) w sieci MLP jest funkcją sigmoidalną.

W generacji gradientu metodą grafów wykorzystuje się zależności odnoszące się do wrażliwości systemu badanego metodą układów dołączonych. Z teorii systemów wiadomo [46], że wrażliwość układu rozumiana jako pochodna dowolnego sygnału w tym układzie względem wartości wag może być określona na podstawie znajomości sygnałów w grafie zwykłym (oznaczonym przez \( G \)) oraz grafie dołączonym (zwanym również grafem sprzężonym) oznaczonym przez \( \hat{G} \). Graf \( \hat{G} \) jest zdefiniowany jak oryginalny graf \( G \) , w którym kierunki wszystkich gałęzi zostały odwrócone. Opis liniowej gałęzi grafu \( G \) i odpowiadającej jej gałęzi grafu dołączonego \( \hat{G} \) jest identyczny. W przypadku gałęzi nieliniowej \( f(u_l) \), gdzie \( u_l \) jest zmienną wejściową, odpowiadająca jej gałąź grafu \( \hat{G} \) staje się gałęzią zlinearyzowaną, o wzmocnieniu równym \( \frac{\partial f(u_l)}{u_l} \)obliczonym dla aktualnego punktu pracy nieliniowego grafu \( G \). Graf dołączony reprezentuje więc system zlinearyzowany. Przykład grafu dołączonego \( \hat{G} \) do grafu oryginalnego sieci MLP z rys. 2.2a przedstawiono na rys. 2.2b. Dla obliczenia gradientu funkcji celu konieczne jest jeszcze odpowiednie pobudzenie grafu dołączonego.

Jak zostało pokazane, dla określenia gradientu należy sieć dołączoną (graf \( \hat{G} \)) zasilić na zaciskach wyjściowych sieci oryginalnej (obecnie wejściowych) sygnałami wymuszającymi w postaci różnic między wartościami aktualnymi sygnałów wyjściowych \( y_i \) a ich wartościami pożądanymi \( d_i \), jak to pokazano na rys. 2.3 b. Przy takim sposobie tworzenia grafu dołączonego każdy składnik wektora gradientu będzie określony na podstawie odpowiednich sygnałów grafu G oraz grafu dołączonego \( \hat{G} \). W odniesieniu do wagi \( w_{ij} \) odpowiedni składnik gradientu będzie opisany wzorem

| \( \frac{\partial E}{\partial w_{ij}} =v_j \hat{v_i} \) | (2.6) |

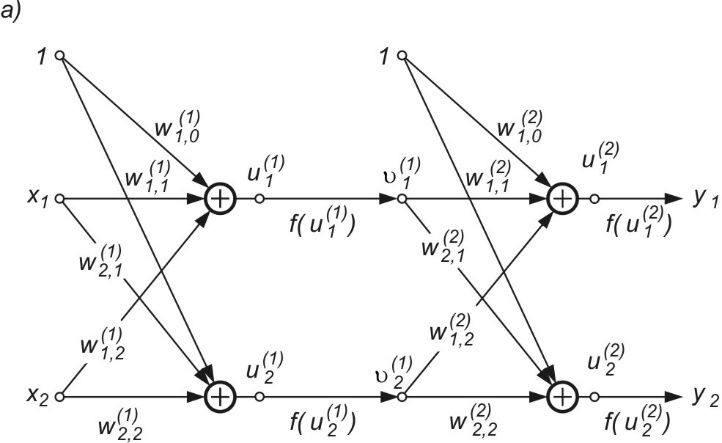

w którym sygnał \( v_j \) odnosi się do grafu \( G \) systemu oryginalnego a \( \hat{v_i} \) do grafu \( \hat{G} \) systemu dołączonego. Należy podkreślić, że podane zależności odnoszą się do dowolnych systemów (liniowych, nieliniowych, rekurencyjnych itp.). Metodę wyznaczania gradientu zilustrujemy przykładem grafu sieci MLP o 2 wejściach, 2 neuronach ukrytych i dwu neuronach wyjściowych przedstawionym na rys. 2.3a [46].

W celu wyznaczenia wszystkich składników gradientu względem wag poszczególnych warstw sieci wykorzystany zostanie graf dołączony \( \hat{G} \) przedstawiony na rys. 2.3b. Pobudzenie grafu dołączonego stanowią różnice między wartościami aktualnymi sygnałów wyjściowych \( y_i \) a wartościami zadanymi \( d_i \) dla \( i=1,2 \). Nieliniowe gałęzie \( f(u) \) grafu \( G \) zastąpione zostały w grafie dołączonym \( \hat{G} \) pochodnymi \( \frac{\partial f}{\partial u} \), obliczonymi odpowiednio w odpowiednich punktach pracy dla każdej warstwy oddzielnie. Zauważmy, że jeśli funkcja aktywacji neuronów ma postać sigmoidalną unipolarną \( f(u)=\frac{1}{1+\exp (-u)} \), wtedy \(\frac{\partial f}{\partial u}=f(u)(1-f(u))\) jest określona bezpośrednio na podstawie znajomości wartości funkcji sigmoidalnej w punkcie pracy \( u \) i nie wymaga żadnych dodatkowych obliczeń wartości funkcji. Wykorzystując wzór (2.6) można teraz określić poszczególne składowe wektora gradientu \( \mathbf{g}=\frac{\partial E}{\partial \mathbf{w}} \) dla dowolnej wagi, zarówno w warstwie ukrytej jak i wyjściowej. Przykładowo

| \( \frac {\partial E} {\partial w_{12}^{(1)}} =x_2 \hat{u}_1^{(1)} \) |

| \( \frac{\partial E}{\partial w_{20}^{(1)}} = \hat{u}_2^{(1)} \) |

| \( \frac{\partial E}{\partial w_{11}^{(2)}} =v_1^{(1)} \hat{u}_1^{(2)} \) |

| \( \frac{\partial E}{\partial w_{21}^{(2)}} =v_1^{(1)} \hat{u}_2^{(2)} \) |

Jak wynika z tych sformułowań, ogólna postać wzoru określającego odpowiedni składnik gradientu jest (przy zachowaniu odpowiednich oznaczeń sygnałów) identyczna, niezależnie od tego, w której warstwie neuronów znajduje się odpowiednia waga. Jest to reguła bardzo prosta w zastosowaniach, wymagająca przy określeniu składowej gradientu znajomości tylko dwóch sygnałów: sygnału węzła, z którego waga startuje w grafie zwykłym oraz sygnału węzła, będącego punktem startowym wagi w grafie dołączonym. Pod tym względem stanowi ona regułę lokalną.

2.5. Metody wyznaczania kierunku minimalizacji

Kierunek minimalizacji \( \textbf{p} \) w procesie optymalizacji wyznacza taki wektor kierunkowy w przestrzeni wielowymiarowej, w którym następuje zmniejszanie się wartości funkcji celu w następnym kroku. Metody wyznaczania takiego kierunku opierają się na rozwinięciu w szereg Taylora funkcji celu \( E \) w najbliższym sąsiedztwie (wzdłuż kierunku \( \textbf{p} \)) znanego, aktualnego punktu rozwiązania określonego wektorem \( \textbf{w} \) [14,18,45]

| \( E(\mathbf{w}+\mathbf{p})=E(\mathbf{w})+\mathbf{g}^T \mathbf{p}+\frac{1}{2} \mathbf{p}^T \mathbf{H} \mathbf{p}+\ldots \) | (2.7) |

W rozwinięciu tym \( \textbf{w} \) oznacza \( n \)-wymiarowy wektor wszystkich wag sieci, \( \textbf{p} \) – wektor kierunku poszukiwań, \( \textbf{g} \) – wektor gradientu a \( \textbf{H} \) - macierz drugich pochodnych funkcji celu (hesjan) wyznaczane w aktualnym punkcie pracy \( \textbf{w} \)

| \( \mathbf{H}=\left[\begin{array}{cccc} \frac{\partial^2 E}{\partial w_1^2} & \frac{\partial^2 E}{\partial w_1 \partial w_2} & \ldots & \frac{\partial^2 E}{\partial w_1 \partial w_n} \\ \frac{\partial^2 E}{\partial w_2 \partial w_1} & \frac{\partial^2 E}{\partial w_2^2} & \ldots & \frac{\partial^2 E}{\partial w_2 \partial w_n} \\ \ldots & \ldots & \ldots & \ldots \\ \frac{\partial^2 E}{\partial w_n \partial w_1} & \frac{\partial^2 E}{\partial w_n \partial w_2} & \ldots & \frac{\partial^2 E}{\partial w_n^2} \end{array}\right] \) |

W praktyce wykorzystuje się co najwyżej trzy pierwsze składniki wzoru (2.7) pomijając pozostałe. Zależność (2.7) jest wówczas kwadratowym przybliżeniem funkcji \( E( \textbf{w} ) \) w najbliższym sąsiedztwie znanego punktu rozwiązania \( \textbf{w} \). Dla uproszczenia zapisu wartości zmiennych uzyskane w \( k \)-tym cyklu oznaczane będą symbolem ze wskaźnikiem dolnym \( k \). Punkt rozwiązania \( \textbf{w} = \textbf{w}_k \) jest punktem odpowiadającym minimum wartości funkcji celu \( E \), jeśli pierwsza pochodna funkcji celu (gradient) jest równy zeru, a macierz hesjanu \( \textbf{H} \) jest dodatnio określona (warunki Kuhna-Tuckera [14]). Przy spełnieniu tych warunków funkcja w dowolnym punkcie należącym do sąsiedztwa \( \textbf{w} \) ma wartość większą niż w samym punkcie \( \textbf{w} \), a zatem punkt rozwiązania aktualnego \( \textbf{w} \) jest rozwiązaniem odpowiadającym minimalnej wartości funkcji celu.

Na \( k \)-tym etapie poszukiwania punktu minimalnego wartości funkcji celu kierunek poszukiwań \( \textbf{p} = \textbf{p}_k \) oraz krok \( \eta \) powinny być dobrane w taki sposób, aby dla nowego rozwiązania

| \( \textbf{w}_{k+1} = \textbf{w}_{k} + \eta \textbf{p}_{k} \) | (2.8) |

była spełniona zależność \( E (\textbf{w}_{k+1}) < E (\textbf{w}_{k}) \). Poszukiwania minimum funkcji celu trwają dopóty, dopóki norma gradientu nie spadnie poniżej założonej, dopuszczalnej wartości błędu bądź też nie będzie przekroczony określony czas obliczeń (liczba iteracji). Ogólny algorytm adaptacji wag sieci przedstawić można w następującej postaci (zakłada się, że dana jest wartość początkowa wektora optymalizowanego \( \textbf{w}_{k} = \textbf{w}_{0} \).

-

Test na zbieżność i optymalność aktualnego rozwiązania \( \textbf{w}_{k} \). Jeżeli aktualny punkt \( \textbf{w}_{k} \) spełnia warunki zatrzymania procesu ze względu na gradient - koniec obliczeń. W przeciwnym razie przejście do punktu 2.

-

Wyznaczenie wektora kierunku minimalizacji \( \textbf{p}_{k} \) w punkcie rozwiązania \( \textbf{w}_{k} \).

-

Wyznaczenie takiego kroku \( \eta \) na kierunku \( \textbf{p}_{k} \), że spełniony jest warunek \( E(\textbf{w}_{k} +\eta \textbf{p}_k) < E (\textbf{w}_{k}) \).

-

Określenie nowego punktu rozwiązania \( \textbf{w}_{k+1} = \textbf{w}_{k} + \eta \textbf{p}_{k} \) oraz odpowiadającej mu wartości \( E (\textbf{w}_{k+1}) < E (\textbf{w}_{k}) \) i powrót do punktu 1.

2.5.1 Algorytm największego spadku

Przy ograniczeniu się w rozwinięciu Taylora (2.7) do liniowego przybliżenia funkcji celu w najbliższym sąsiedztwie aktualnego rozwiązania \( \textbf{w} \) otrzymuje się algorytm największego spadku. Aby była spełniona zależność \( E (\textbf{w}_{k+1}) < E (\textbf{w}_{k}) \) , wystarczy dobrać \( \textbf{g}_k^T \textbf{p}_k < 0 \).

Przyjęcie wektora kierunkowego w postaci [18]

| \( \textbf{p} = - \textbf{g} \) | (2.9) |

spełnia wymagany warunek zmniejszenia wartości funkcji celu. Adaptacja wag przebiega wówczas według wzoru

| \( \mathbf{w}_{k+1}=\mathbf{w}_k-\eta \mathbf{g}_k \) | (2.10) |

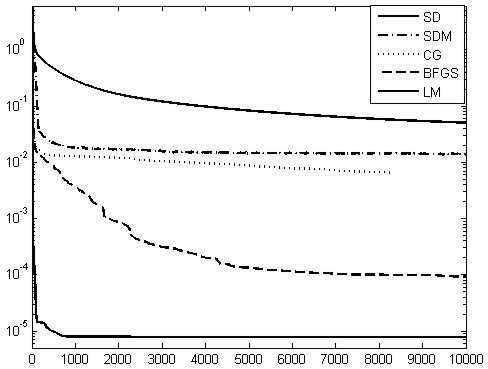

określającego metodę największego spadku. Ograniczenie się w rozwinięciu Taylora do składnika pierwszego rzędu powoduje niewykorzystanie informacji o krzywiźnie funkcji zawartej w hesjanie. To sprawia, że metoda jest wolno zbieżna (zbieżność liniowa: oznacza ona, iż przy spełnieniu założeń metody, odległości pomiędzy kolejnymi przybliżeniami \( \mathbf{x}_k \), a rzeczywistym minimum \( \mathbf{x}^{*} \) funkcji maleją liniowo, czyli \( \left\|\mathbf{x}^*-\mathbf{x}_{k+1}\right\| \leq c\left\|\mathbf{x}^*-\mathbf{x}_k\right\| \)). Wada ta oraz brak postępów minimalizacji w okolicy punktu optymalnego, gdzie gradient przyjmuje bardzo małe wartości, spowodowały, że metoda ta jest mało efektywna. Niemniej jednak, ze względu na jej prostotę, małe wymagania co do wielkości pamięci i małą złożoność obliczeniową stanowiła ona przez lata i nadal pozostaje podstawową metodą stosowaną w uczeniu sieci wielowarstwowych.

Poprawy efektywności poszukuje się przez modyfikację (zwykle heurystyczną) wzoru określającego kierunek. Dobre wyniki przynosi zwykle zastosowanie uczenia z momentem rozpędowym (w skrócie uczenie z momentem) W przypadku zastosowania tej techniki zmiana wektora wag sieci \( \Delta\mathbf{w} \) w \( k \)-tej iteracji uwzględnia nie tylko gradient, ale również zmianę wartości wag z poprzedniej \( (k-1) \) iteracji. Adaptacja wag przebiega wówczas według wzoru [43,46]

| |

(2.11) |

w którym \( \alpha \) jest współczynnikiem momentu, przyjmowanym zwykle w przedziale wartości [0, 1].

Składnik \( \eta \mathbf{g}_k \)tego wyrażenia odpowiada zwykłej metodzie uczenia największego spadku, natomiast drugi \( \alpha\left(\mathbf{w}_k-\mathbf{w}_{k-1}\right) \)uwzględnia ostatnią zmianę wag i jest niezależny od aktualnej wartości gradientu. Im większa jest wartość współczynnika \( \alpha \), tym składnik wynikający z momentu rozpędowego ma większy wpływ na adaptację wag. Jego wpływ wzrasta w sposób istotny na płaskich odcinkach funkcji celu oraz w pobliżu minimum lokalnego, gdzie wartość gradientu jest bliska zeru. Na płaskich odcinkach funkcji celu przyrost wag \( \Delta \mathbf{w} \), przy stałej wartości współczynnika uczenia \( \eta \) jest w przybliżeniu równy, co oznacza, że \( \Delta \mathbf{w}_k=-\eta \mathbf{g}_k+\alpha \Delta \mathbf{w}_k \). Wynika stąd, że efektywny przyrost wartości wag określa teraz relacja

| \( \Delta \mathbf{w}_k=-\frac{\eta}{1-\alpha} \mathbf{g}_k \) | (2.12) |

Przy wartości współczynnika \( \alpha=0,9 \) oznacza to 10-krotny wzrost efektywnej wartości współczynnika uczenia, a więc również 10-krotne przyśpieszenie procesu uczenia (na płaskich odcinkach funkcji celu). W pobliżu minimum lokalnego składnik momentu jako nie związany z wartością gradientu może spowodować zmianę wag, prowadzącą do wzrostu wartości funkcji celu i opuszczenie strefy ,,przyciągania" tego minimum. Przy małej wartości gradientu czynnik momentu może stać się dominujący we wzorze (2.11) i spowodować przyrost wag odpowiadający wzrostowi wartości funkcji celu i umożliwić opuszczenie bieżącego minimum lokalnego.

Czynnik momentu nie może przy tym całkowicie zdominować procesu uczenia, gdyż prowadziłoby to do niestabilności algorytmu. Zwykle kontroluje się wartość funkcji celu \( E \) w procesie uczenia, dopuszczając do jej wzrostu jedynie w ograniczonym zakresie, np. 4%. W takim przypadku, jeśli w kolejnych iteracjach \( k \) oraz \( k+1 \) spełniona jest relacja \( E(k+1) < 1,04E(k) \), krok jest akceptowany i następuje uaktualnienie wartości wag; jeżeli natomiast \( E(k+1) > 1,04E(k) \), zmiany są ignorowane i przyjmuje się \( \left(\mathbf{w}_k-\mathbf{w}_{k-1}\right)=\mathbf{0} \). W takim przypadku składnik gradientowy odzyskuje dominację nad składnikiem momentu i proces przebiega zgodnie z kierunkiem minimalizacji wyznaczonym przez wektor gradientu. Należy podkreślić, że dobór wartości współczynnika momentu jest zagadnieniem niełatwym i wymaga wielu eksperymentów, mających na celu dopasowanie jego wartości do specyfiki rozwiązywanego problemu.

2.5.2 Algorytm zmiennej metryki

Metoda zmiennej metryki wywodzi się z metody optymalizacyjnej Newtona, wykorzystującej kwadratowe przybliżenie funkcji celu w sąsiedztwie znanego rozwiązania \( \mathbf{w}_k \). Ograniczając się we wzorze (2.7) do trzech pierwszych składników, minimum funkcji celu \( E \) wyznacza się przyrównując do zera pochodną \( E(\textbf{w}+\textbf{p}) \) względem wektora \( \textbf{p} \), czyli \( \frac{\partial E(\mathbf{w}+p)}{\partial \mathbf{p}}=\mathbf{0} \). Po wykonaniu tej operacji mamy

| \( \textbf{g}+\textbf{Hp}=\textbf{0} \) | (2.13) |

Ze wzoru tego otrzymuje się wyrażenie określające kierunek newtonowski wyznaczający minimum funkcji celu w \( k \)-tej iteracji [45]

| \( \mathbf{p}_k=-\mathbf{H}_k^{-1} \mathbf{g}_k \) | (2.14) |

Wzór (2.14) wyznacza w sposób jednoznaczny taki kierunek \( \mathbf{p}_k \), który zapewnia minimum funkcji celu w danym kroku i stanowi istotę newtonowskiego algorytmu optymalizacji, jest zależnością czysto teoretyczną, gdyż wymaga zapewnienia dodatniej określoności hesjanu w każdym kroku, co w przypadku ogólnym jest niemożliwe do spełnienia.

Z tego powodu w praktycznych implementacjach algorytmu rezygnuje się z dokładnego wyznaczania hesjanu \( \mathbf{H} \), a w zamian stosuje się jego przybliżenie \( \mathbf{G} \) spełniające warunek dodatniej określoności. Jedną z najpopularniejszych metod jest przy tym metoda zmiennej metryki, posiadająca wiele odmian. W metodzie tej, w każdym kroku modyfikuje się hesjan (lub jego odwrotność) z kroku poprzedniego o pewną poprawkę. Oznaczmy przez \( \mathbf{s}_{\mathrm{k}}=\mathbf{w}_{\mathrm{k}}-\mathbf{w}_{\mathrm{k}-1} \) oraz \( \mathbf{r}_{\mathrm{k}}=\mathbf{g}_{\mathrm{k}}-\mathbf{g}_{\mathrm{k}-1} \), odpowiednio przyrosty wektora \( \mathbf{w} \) oraz gradientu \( \mathbf{g} \) w dwu kolejnych iteracjach, a przez \( \mathbf{V} \) - macierz odwrotną przybliżonego hesjanu \( \mathbf{V} = \mathbf{G}^{-1} \), to zgodnie z najefektywniejszą formułą Broydena-Fletchera-Goldfarba-Shanno (BFGS) proces uaktualniania macierzy \( \mathbf{V} \) opisuje się zależnością rekurencyjną [14]

| \( \mathbf{V}_k=\mathbf{V}_{k-1}+\left(1+\frac{\mathbf{r}_k^T \mathbf{V}_{k-1} \mathbf{r}_k}{\mathbf{s}_k^T \mathbf{r}_k}\right) \frac{\mathbf{s}_k \mathbf{s}_k^T}{\mathbf{s}_k^T \mathbf{r}_k}-\frac{\mathbf{s}_k \mathbf{r}_k^T \mathbf{V}_{k-1} \mathbf{r}_k \mathbf{s}_k^T}{\mathbf{s}_k^T \mathbf{r}_k} \) |

(2.15) |

Jako wartość startową przyjmuje się zwykle \( \mathbf{V}_{0}=\mathbf{1} \), co oznacza, że pierwsza iteracja przeprowadzana jest zgodnie z algorytmem największego spadku. Zostało wykazane [14], że przy wartości startowej \( \mathbf{V}_{0}=\mathbf{1} \) i zastosowaniu procedury minimalizacji kierunkowej w każdym kroku optymalizacyjnym można zawsze zapewnić dodatnią określoność aproksymowanej macierzy hesjanu.

Metoda zmiennej metryki charakteryzuje się szybszą zbieżnością (zbieżność superliniowa) niż metoda największego spadku (zbieżność liniowa). Poza tym fakt, że hesjan w każdym kroku spełnia warunek dodatniej określoności, daje pewność, że spełnienie warunku \( \mathbf{g}=\mathbf{0} \) odpowiada rozwiązaniu problemu minimalizacji. Metoda ta należy obecnie do grupy najlepszych technik optymalizacji funkcji wielu zmiennych. Jej wadą jest znaczna złożoność obliczeniowa (konieczność wyznaczenia w każdym cyklu \( n^2 \) elementów hesjanu), a także duże wymagania w odniesieniu do pamięci przy przechowywaniu macierzy hesjanu, co w przypadku funkcji z dużą liczbą zmiennych może być pewnym problemem.

Najważniejszym ograniczeniem jest jednak pogarszanie się uwarunkowania problemu przy znacznym wzroście liczby wag. Wzrastający wymiar hesjanu pociąga za sobą rosnącą wartość współczynnika uwarunkowania \( \text{cond}(\mathbf{H}) \) i pogarszającą się dokładność obliczeń. Z tego względu stosuje się ją do niezbyt dużych sieci. W przypadku komputerów PC jej skuteczne działanie zostało sprawdzone dla sieci o liczbie wag rzędu kilkuset (poniżej tysiąca).

2.5.3 Algorytm Levenberga-Marquardta

Inną implementacją newtonowskiej strategii optymalizacji jest metoda Levenberga-Marquardta. W metodzie tej dokładną wartość hesjanu \( \mathbf{H} \) we wzorze (2.14) zastępuje się wartością również aproksymowaną \( \mathbf{G} \), ale określaną na podstawie informacji zawartej w gradiencie z uwzględnieniem czynnika regularyzacji. Dla wprowadzenia metody przyjęta będzie definicja funkcji celu w postaci odpowiadającej istnieniu jednego wzorca uczącego, co przy \( M \) wyjściach sieci odpowiada

| \( E=\frac{1}{2} \sum_{i=1}^M\left(y_i(\mathbf{x})-d_i\right)=\sum_{i=1}^M e_i[(\mathbf{x})]^2 \) |

(2.16) |

gdzie \( e_i(\mathbf{x})=\left(y_i(\mathbf{x})-d_i\right) \) oznacza błąd na \( i \)-tym wyjściu sieci przy prezentacji wektora \( \mathbf{x} \). Przy wprowadzeniu oznaczeń (\( \mathbf{J} \) – macierz Jacobiego)

| \( \mathbf{e}(\mathbf{x})=\left[\begin{array}{c}

e_1(\mathbf{x}) \\

e_2(\mathbf{x}) \\

\ldots \\

e_M(\mathbf{x})

\end{array}\right] \) |

\( \mathbf{J}=\left[\begin{array}{cccc} \frac{\partial e_1}{\partial w_1} & \frac{\partial e_1}{\partial w_2} & \ldots & \frac{\partial e_1}{\partial w_n} \\ \frac{\partial e_2}{\partial w_1} & \frac{\partial e_2}{\partial w_2} & \ldots & \frac{\partial e_2}{\partial w_n} \\ \cdots & \cdots & \ldots & \ldots \\ \frac{\partial e_M}{\partial w_1} & \frac{\partial e_M}{\partial w_2} & \ldots & \frac{\partial e_M}{\partial w_n} \end{array}\right] \) |

wektor gradientu \( \mathbf{g} \) i aproksymowana macierz hesjanu \( \mathbf{G} \) odpowiadające funkcji celu (2.16) określane są w postaci [14,46]

| \( \mathbf{g}=\mathbf{J}^T \mathbf{e}(\mathbf{x}) \) |

(2.17) |

| \( \mathbf{G}=\mathbf{J}^T \mathbf{J}+v \mathbf{1} \) |

(2.18) |

W równaniu tym współczynnik \( v \) zwany parametrem regularyzacyjnym Levenberga-Marquardta jest wielkością skalarną, dążącą do zera w trakcie procesu optymalizacyjnego. Na starcie procesu uczenia, gdy aktualna wartość wektora wagowego \( \mathbf{w}_k \) jest daleka od rozwiązania (duże wartości składowych wektora błędu \( \mathbf{e} \)), przyjmuje się wartość parametru \( v \) bardzo dużą w porównaniu z największą wartością własną macierzy \( \mathbf{J}^T \mathbf{J} \). W takim przypadku hesjan jest reprezentowany przede wszystkim przez czynnik regularyzacyjny \( v \mathbf{1} \) a poszukiwanie kierunku odbywa się podobnie jak w metodzie największego spadku \( \mathbf{p}_k=-\mathbf{g}_k / v \). W miarę zmniejszania się residuum błędu i zbliżania do rozwiązania, parametr \( v \) ulega redukcji i pierwszy składnik sumy we wzorze (2.18) określającym hesjan odgrywa coraz większą rolę.

O skuteczności działania algorytmu decyduje odpowiedni dobór wartości \( v\). W praktyce wartość ta podlega ciągłej adaptacji przy zastosowaniu metody Levenberga-Marquardta [43]. Przy aktualnym rozwiązaniu bliskim optymalnemu hesjan jest dostatecznie wiernie reprezentowany przez składnik \( \mathbf{J}^T \mathbf{J} \) wzoru aproksymacyjnego (2.18). W takim przypadku czynnik regularyzacji \( v \mathbf{1} \) może być pominięty (\( v=0 \)) i proces określania hesjanu opiera się bezpośrednio na aproksymacji pierwszego rzędu, a kierunek wyznaczony jest wzorem \( \mathbf{p}_k=-\left[\mathbf{J}_k^T \mathbf{J}_k\right]^{-1} \mathbf{g}_k \). Algorytm Levenberga-Marquardta przechodzi wówczas w klasyczny algorytm Gaussa-Newtona [14], charakteryzujący się kwadratową zbieżnością do rozwiązania optymalnego. W praktyce algorytm Levenberga-Marquardta ma zbieżność super liniową i obok metody zmiennej metryki jest uważany za najlepszy algorytm uczący sieci MLP przy założeniu sieci o niezbyt dużej liczbie adaptowanych wag.

2.5.4 Algorytm gradientów sprzężonych

Metody newtonowskie bardzo dobrze sprawdzają się w zadaniach uczenia sieci MLP przy liczbie wag nie przekraczających kilkuset. Przy zbyt dużej liczbie zmiennych optymalizowanych pojawia się problem złego uwarunkowania macierzy \( \mathbf{H} \). W takim przypadku lepsze wyniki uczenia uzyskuje się zwykle stosując metodę gradientów sprzężonych [14]. W metodzie tej podczas wyznaczania kierunku minimalizacji rezygnuje się z bezpośredniej informacji o hesjanie. W zamian za to kierunek poszukiwań \( \mathbf{p} \) jest konstruowany w taki sposób, aby był ortogonalny oraz sprzężony ze wszystkimi poprzednimi kierunkami poszukiwań. W \( k \)-tej iteracji warunek ten jest spełniony przy doborze kierunku \( \mathbf{p} \) według wzoru

| \( \mathbf{p}_k=-\mathbf{g}_k+\beta \mathbf{p}_{k-1} \) |

(2.19) |

Ze wzoru (2.19) wynika, że nowy kierunek minimalizacji zależy tylko od wartości gradientu w aktualnym punkcie rozwiązania oraz od poprzedniego kierunku poszukiwań \( \mathbf{p}_{k-1} \), pomnożonego przez współczynnik sprzężenia \( \beta \). Współczynnik sprzężenia odgrywa bardzo ważną rolę, kumulując w sobie informacje o poprzednich kierunkach poszukiwań i zapewniając ich ortogonalność względem kierunku aktualnego. Spośród wielu sposobów wyznaczania wartości tego współczynnika ograniczymy się do reguły Polaka-Ribiery [46]

| \( \beta=\frac{\mathbf{g}_k^T\left(\mathbf{g}_k-\mathbf{g}_{k-1}\right)}{\mathbf{g}_{k-1}^T \mathbf{g}_{k-1}} \) |

(2.20) |

Ze względu na kumulację błędów zaokrąglenia podczas kolejnych cykli obliczeniowych metoda gradientów sprzężonych w praktyce zatraca własność ortogonalności między wektorami kierunków minimalizacji. Dlatego też po wykonaniu \( m \) iteracji (\( m \) przyjmuje się jako funkcję liczby zmiennych \( n \) podlegających optymalizacji) przeprowadza się jej restart, zakładając w pierwszym kroku po restarcie kierunek minimalizacji zgodnie z algorytmem największego spadku w aktualnie osiągniętym punkcie rozwiązania.

W praktyce obliczeniowej metoda gradientów sprzężonych wykazuje zbieżność super liniową, choć o mniejszej wartości wykładnika zbieżności niż metoda zmiennej metryki. Z tego powodu jest mniej skuteczna niż metody pseudo newtonowskie (zmiennej metryki i Levenberga-Marquardta), ale zdecydowanie szybsza niż metoda największego spadku. Stosuje się ją powszechnie jako skuteczny algorytm optymalizacji przy bardzo dużej liczbie zmiennych, sięgających nawet kilku tysięcy. Dzięki małym wymaganiom co do pamięci i niewielkiej złożoności obliczeniowej metoda ta pozwala na efektywne rozwiązanie stosunkowo dużych problemów optymalizacyjnych.

1.

2.6. Dobór współczynnika uczenia

2.6 Dobór współczynnika uczenia

Po wyznaczeniu kierunku poszukiwań p konieczne jest jeszcze określenie wartości współczynnika uczenia η aby można było jednoznacznie wyznaczyć nowy punkt rozwiązania \( \textbf{w}_{k+1} = \textbf{w}_{k} + \eta \textbf{p}_{k} \), spełniający warunek \( E(\textbf{w}_{k+1} ) < E (\textbf{w}_{k}) \). Pożądany jest taki dobór \( \eta \) aby nowy punkt rozwiązania \( w_{k+1} \) leżał możliwie blisko minimum funkcji celu na kierunku \( \textbf{p}_k \). Właściwy dobór współczynnika \( \eta \) ma ogromny wpływ na zbieżność algorytmu optymalizacyjnego. Im wartość \( \eta \) bardziej odbiega od wartości, przy której funkcja celu osiąga minimum na danym kierunku \( \textbf{p}_k \), tym większa liczba iteracji jest potrzebna do wyznaczenia optymalnego rozwiązania. Przyjęcie zbyt małej wartości \( \eta \) powoduje niewykorzystanie możliwości zminimalizowania wartości funkcji celu w danym kroku i konieczność jego powtórzenia w następnym. Zbyt duży krok powoduje ,,przeskoczenie" minimum funkcji i podobny efekt jak poprzednio. Istnieje wiele sposobów doboru wartości \( \eta \).

Najprostszy z nich (obecnie stosunkowo rzadko stosowany, głównie w uczeniu on-line) polega na przyjęciu stałej wartości \( \eta \) w całym procesie optymalizacyjnym. Stosuje się go praktycznie tylko w połączeniu z metodą największego spadku. Jest to sposób mało efektywny, gdyż nie uzależnia wartości współczynnika uczenia od aktualnego wektora gradientu, a więc i kierunku \( \textbf{p} \) w danej iteracji. Dobór wartości \( \eta \) odbywa się zwykle oddzielnie dla każdej warstwy sieci przy wykorzystaniu różnych zależności empirycznych. Jednym z rozwiązań jest przyjęcie oszacowania minimalnej wartości tego współczynnika dla każdej warstwy w postaci

| \( \eta \leq \min ( \frac{1}{n_i}) \) | (2.21) |

gdzie \( n_i \) oznacza liczbę wejść \( i \)-tego neuronu w warstwie.

Inną bardziej skuteczną metodą doboru wartości współczynnika uczenia jest założenie ciągłej adaptacji, dopasowującej się do aktualnych zmian wartości funkcji celu w procesie uczenia. W metodzie tej na podstawie porównania wartości funkcji celu w \( i \)-tej iteracji z jej poprzednią wartością, określa się strategię zmian wartości współczynnika uczenia. W celu przyspieszenia procesu uczenia w metodzie powinno się dążyć do ciągłego zwiększania wartości \( \eta \), jednocześnie sprawdzając, czy wartość funkcji błędu nie rośnie w porównaniu z błędem obliczanym przy starej wartości \( \eta \). Dopuszcza się przy tym nieznaczny wzrost wartości tego błędu w stosunku do wartości z poprzedniej iteracji. Jeżeli przez \( E(i-1) \) oraz \( E(i) \) oznaczymy wartość funkcji celu odpowiednio w \( (i-1) \) oraz w \( i \)-tej iteracji, a przez \( \eta_{i-1}, \eta_{i} \) współczynniki uczenia w odpowiednich iteracjach, to w przypadku, gdy \( E(i) > k_w E(i-1) \) (\( k_w \) - dopuszczalny współczynnik wzrostu błędu) powinno nastąpić zmniejszenie wartości \( \eta \), zgodnie z zależnością [43]

| \( \eta_{i+1}=\alpha_d\eta_i \) | (2.22) |

gdzie \( \alpha_d \) jest współczynnikiem zmniejszania wartości \( \eta \). W przeciwnym razie, gdy \( E(i) < k_{w} E(i-1) \) przyjmuje się

| \( \eta_{i+1}=\alpha_i\eta_i \) | (2.23) |

gdzie αi jest współczynnikiem zwiększającym wartość \( \eta \). Mimo pewnego zwiększenia nakładu obliczeniowego (potrzebnego do wyznaczenia dodatkowej wartości \( \eta \)) możliwe jest istotne przyspieszenie procesu uczenia. Charakterystyczna jest przy tym postać zmian wartości tego współczynnika w czasie uczenia. Zwykle na starcie (przy bardzo małej wartości startowej \( \eta \)) dominuje proces jego zwiększania, po czym po osiągnięciu pewnego stanu quasi-ustalonego jego wartość zmienia się, cyklicznie, narastając i zmniejszając się w następujących po sobie cyklach. Należy jednak podkreślić, że metoda adaptacyjna doboru \( \eta \) jest bardzo uzależniona od aktualnej postaci funkcji celu i wartości współczynników \( k_w, \alpha_d, \alpha_i \). Wartości optymalne przy jednej postaci funkcji mogą być dalekie od optymalnych przy zmianie postaci tej funkcji. Stąd w praktycznej realizacji tej metody należy uwzględnić mechanizmy kontroli i sterowania wartościami współczynników, dobierając je odpowiednio do specyfiki zadania.

Najefektywniejszy, choć zarazem najbardziej złożony, sposób doboru współczynnika uczenia polega na minimalizacji funkcji celu na wyznaczonym wcześniej kierunku \( \textbf{p} \). Należy tak dobrać skalarną wartość \( \eta \), aby nowe rozwiązanie odpowiadało minimum funkcji celu na tym kierunku \( \textbf{p} \). Zauważmy, że przy znanym kierunku \( \textbf{p} \) jest to zadanie znalezienia minimum funkcji jednej zmiennej (\( \eta \)). Wśród najpopularniejszych metod wyznaczania minimum kierunkowego można wyróżnić metody bez gradientowe i gradientowe. W metodach bez gradientowych korzysta się jedynie z informacji o wartościach funkcji celu i wyznacza jej minimum w wyniku kolejnych podziałów założonego na wstępie zakresu wektora \( \textbf{w} \). Przykładem takich metod są: metoda bisekcji, złotego podziału odcinka, metoda Fibonacciego czy lokalna aproksymacja funkcji celu przy użyciu wielomianu drugiego stopnia [14]. Jedną z najbardziej popularnych metod gradientowych jest aproksymacja funkcji celu przy użyciu wielomianu drugiego lub trzeciego stopnia. Do wyznaczenia jego współczynników wykorzystuje się zarówno informację o wartości aktualnej funkcji celu w dwu sąsiednich punktach jak i jej pochodnej (gradientu). Szczegóły dotyczące tych algorytmów można znaleźć w podręcznikach dotyczących optymalizacji.

2.7. Metody heurystyczne uczenia sieci

Oprócz algorytmów uczących implementujących wypróbowane metody optymalizacji nieliniowej funkcji celu, takie jak metoda zmiennej metryki, metoda Levenberga-Marquardta czy metoda gradientów sprzężonych, opracowano pewną liczbę algorytmów typu heurystycznego, stanowiących modyfikację metody największego spadku bądź metody gradientów sprzężonych. Modyfikacje takie, opierające się na algorytmach powszechnie znanych, wprowadzają do nich pewne poprawki, przyspieszające (zdaniem autorów) działanie algorytmu. Nie mają one najczęściej ścisłego uzasadnienia teoretycznego, zwłaszcza przy doborze wartości parametrów sterujących działaniem poprawki, ale uwzględnione są w nich doświadczenia różnych autorów z zakresu prac nad sieciami neuronowymi. Do najbardziej znanych algorytmów heurystycznych należą Quickprop S. Fahlmana oraz RPROP R. Riedmillera i H. Brauna, zaimplementowany w programie SNNS oraz w Matlabie. Tutaj ograniczymy się do przedstawienia jedynie algorytmu RPROP (skrót od angielskiej nazwy Resilient backPROPagation) [54]

W algorytmie tym przy zmianie wag uwzględnia się jedynie znak składowej gradientu, ignorując jej wartość. W efekcie w każdej iteracji algorytmu uczącego określa się zmianę wektora wagowego według prostego wzoru

| \( \Delta w_{i j}(k)=-\eta_{i j}(k) \operatorname{sgn}\left(\frac{\partial E}{\partial w_{i j}}\right) \) | (2.24) |

Współczynnik uczenia dobierany jest indywidualnie dla każdej wagi \( \textbf{w}_{ij} \) na podstawie zmian wartości gradientu

| \( f(u)= \begin{cases} { \begin{matrix} \min \left(a \eta_{i j}(k-1), \eta_{\max }\right) && \textrm{ dla } g_{i j}(k) g_{i j}(k-1)>0 \\ \max \left(b \eta_{i j}(k-1), \eta_{\min }\right) && \textrm{ dla } g_{i j}(k) g_{i j}(k-1) < 0 \\ \eta_{i j}(k-1) && \textrm{ dla } g_{i j}(k) g_{i j}(k-1)=0 \end{matrix} } \end{cases} \) | (2.25) |

W równaniu tym \( \textbf{g}_{ij}(k)=\frac{\partial E}{\partial \textbf{w}_{ij}} \) oznacza wartość składową gradientu funkcji celu w \( k \)-tej iteracji, \( a \) i \( b \) są współczynnikami liczbowymi (\( a=1.2 \), \( b=0.5 \)), natomiast \( \eta_{\min} \) i \( \eta_{\max} \) oznaczają odpowiednio minimalną i maksymalną wartość współczynnika uczenia, równą w algorytmie RPROP odpowiednio 10-6 oraz 50. Funkcja sgn oznacza znak argumentu (+1 lub -1). Zgodnie ze strategią doboru wag zakłada się ciągły wzrost współczynnika uczenia, jeśli w dwu kolejnych krokach znak gradientu jest taki sam, natomiast jego redukcję, gdy ten znak jest różny. Algorytm RPROP, ignorujący informację o wartości gradientu, pozwala na znaczne przyspieszenie procesu uczenia w tych obszarach, w których nachylenie funkcji celu jest niewielkie.

2.8. Inicjalizacja wartości początkowych wag sieci

Uczenie sieci neuronowych, nawet przy zastosowaniu najefektywniejszych algorytmów uczących, jest procesem trudnym i nie zawsze prowadzącym do właściwych wyników. Problemem są nieliniowości wprowadzane przez funkcje aktywacji, będące głównym powodem wytworzenia szeregu minimów lokalnych, w których może zatrzymać się proces uczenia. Wprawdzie zastosowanie odpowiedniej strategii postępowania (np. symulowane wyżarzanie, metoda multistaru, algorytmy genetyczne [11,15,44]) mogłoby zmniejszyć prawdopodobieństwo zatrzymania procesu w minimum lokalnym, ale konsekwencją tego jest duży nakład pracy i znaczne wydłużenie czasu uczenia. Ponadto zastosowanie tych metod wymaga dużego doświadczenia w trudnych zagadnieniach optymalizacji globalnej, zwłaszcza przy właściwym doborze parametrów procesu.

Na wyniki uczenia ogromny wpływ ma dobór wstępnych wartości wag sieci. Pożądany byłby start z wartości wag zbliżonych do optymalnych. Unika się w ten sposób nie tylko zatrzymania się w niewłaściwym minimum lokalnym, ale jednocześnie znacznie przyspiesza proces uczenia. Niestety, w ogólnym przypadku nie istnieją metody doboru wag, zapewniające optymalny punkt startowy niezależnie od rodzaju zadania. Stąd w większości zastosowań używa się nadal głównie losowego doboru wag, przyjmując ich rozkład równomierny w określonym przedziale liczbowym. Zły dobór zakresu wartości losowych wag może prowadzić do zjawiska przedwczesnego nasycenia neuronów, w wyniku którego mimo upływu czasu błąd średniokwadratowy pozostaje prawie stały w procesie uczenia. Jest on zwykle wynikiem zbyt dużych wartości startowych wag. Przy określonych sygnałach uczących, w węzłach sumacyjnych neuronów generowane są sygnały ui o wartościach odpowiadających głębokiemu nasyceniu funkcji sigmoidalnej aktywacji, przy czym polaryzacja nasycenia jest odwrotna do pożądanej (sygnał wyjściowy neuronu \( +1 \) przy pożądanej wartości \( -1 \) i odwrotnie). W punkcie nasycenia sygnał zwrotny generowany w metodzie propagacji wstecznej, jako proporcjonalny do pochodnej funkcji aktywacji, jest bliski zeru i zmiany wartości wag wyprowadzające neuron ze stanu nasycenia są bardzo powolne. Proces uczenia utyka na długo w punkcie siodłowym. Należy zauważyć, że tylko część neuronów może być w stanie nasycenia, pozostałe znajdują się w zakresie liniowym i dla nich sygnał zwrotny uczący przyjmie normalną postać. Oznacza to, że wagi związane z tymi neuronami zmieniają się w sposób normalny i w ich przypadku proces uczenia prowadzi do szybkiej redukcji błędu. W efekcie neuron pozostający w nasyceniu nie bierze udziału w odwzorowaniu danych, zmniejszając w ten sposób efektywną liczbę neuronów sieci. W wyniku tego następuje znaczne spowolnienie procesu uczenia, powodujące, że stan nasycenia pewnych neuronów może trwać prawie nieprzerwanie aż do wyczerpania limitu iteracji.

Inicjalizacja losowa, jako jedyna uniwersalna metoda przypisania wartości wstępnych wagom sieci, musi zatem zapewnić na wstępie taki punkt pracy neuronów, który jest daleki od nasycenia. Osiąga się to przez ograniczenie zakresu wartości krańcowych w losowaniu. Oszacowanie dolne i górne zakresu tego przedziału, proponowane przez różnych badaczy na podstawie wielu przeprowadzonych eksperymentów numerycznych, różnią się w szczegółach rozwiązania, ale prawie wszystkie znajdują się w przedziale [0, 1].

Jedną z najbardziej popularnych sposobów inicjalizacji wag jest metoda Nguyen’a i Widrow’a [43]. Optymalny zakres wartości losowych elementów wektora wagowego neuronów warstw ukrytych powinien według nich być równy \( \pm \sqrt[n_{in}]{N_h} \), gdzie \( N_h \) oznacza liczbę neuronów ukrytych w warstwie, a \( n_{in} \) liczbę wejść danego neuronu. Wartości wstępne wag neuronów wyjściowych powinny być losowe w zakresie [-0,5 0,5]. Tego typu strategia inicjalizacji wag została między innymi zastosowana w algorytmach uczących zaimplementowanych w programie MATLAB [43].

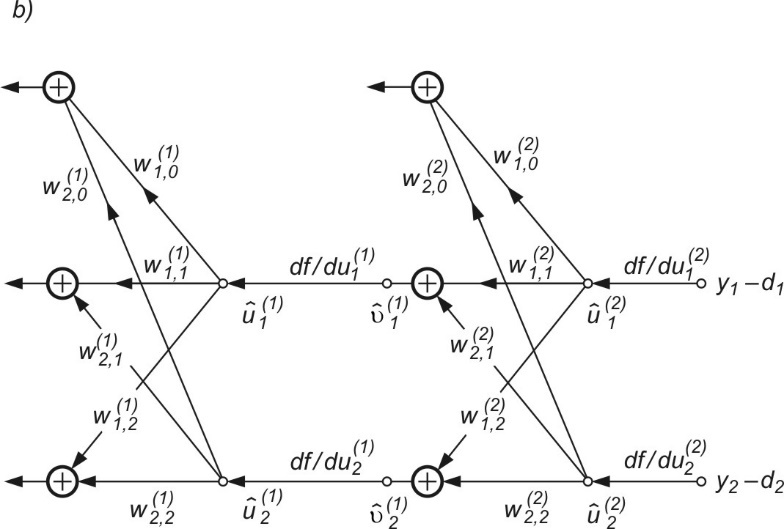

2.9. Program MLP do uczenia sieci wielowarstwowej

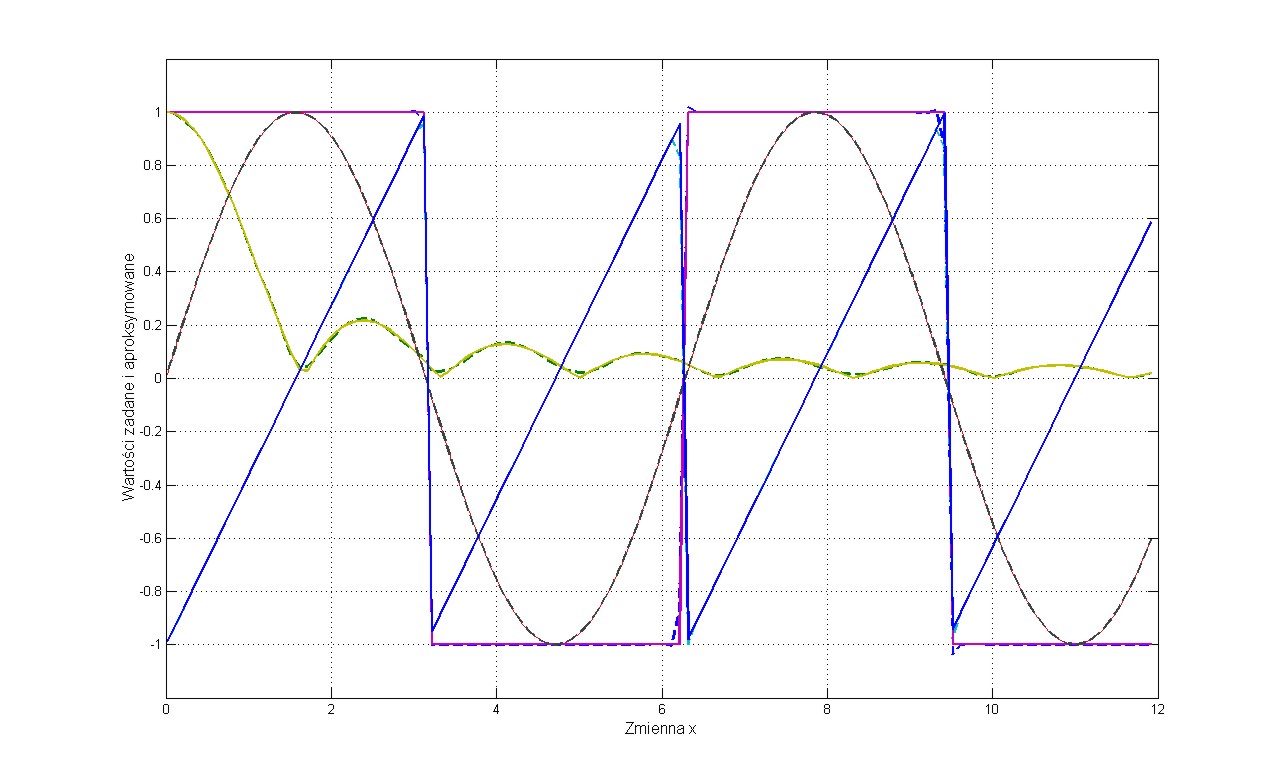

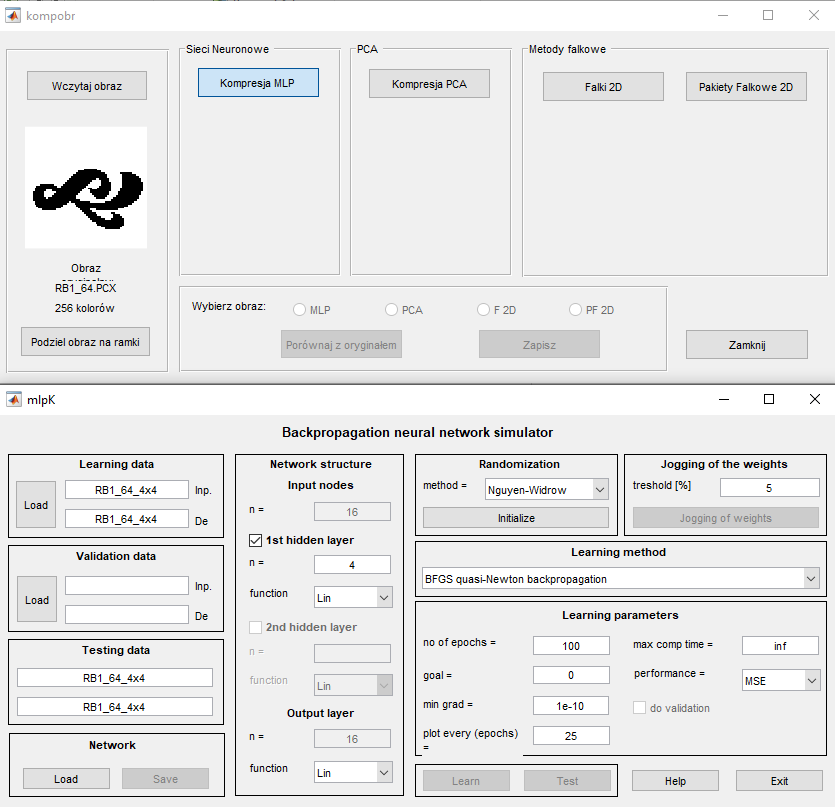

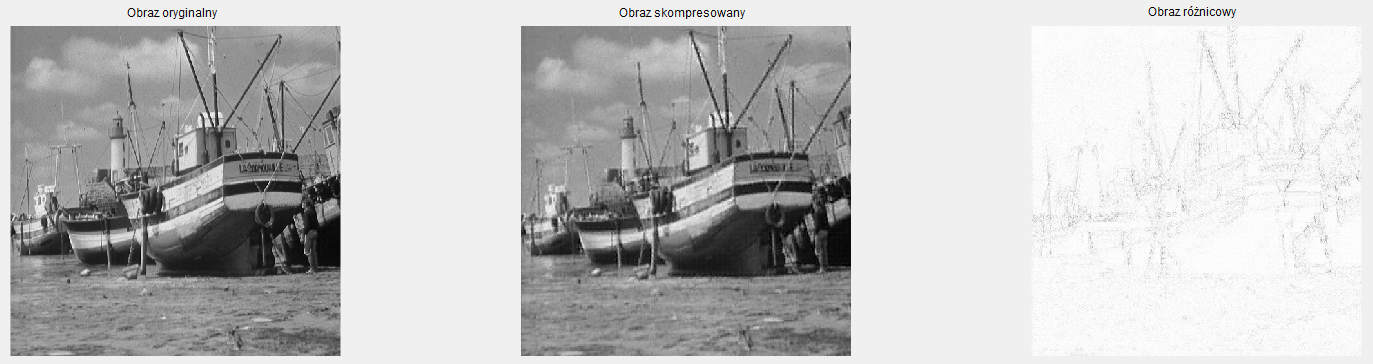

W wykładzie tym przedstawimy program MLP uczenia i użytkowania w trybie testującym sieci MLP. Program ten w postaci interfejsu graficznego został stworzony na bazie oprogramowania neuronowego toolboxu „Neural Network” Matlaba. Przedstawimy szczegóły dotyczące tego interfejsu, podstawowe opcje wykorzystania programu oraz wyniki testu na aproksymacji danych wielowymiarowych.

2.9.1 Opis programu

Wykorzystując toolbox "Neural Network" i inne funkcje wbudowane w programie Matlab zaimplementowano wszystkie wymienione w wykładzie trzecim algorytmy uczące w postaci pakietu programów pod nazwą MLP (plik uruchomieniowy mlp.m). Uruchomienie programu następuje w oknie komend Matlaba po napisaniu nazwy mlp programu. Pojawi się wówczas menu główne przedstawione na rys. 5.1 [46].

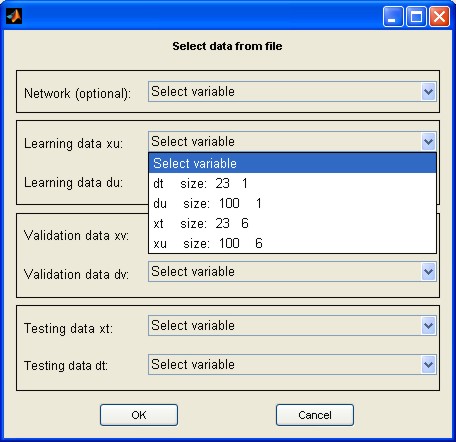

W lewej części menu znajdują się: pole do zadawania danych uczących (pole Learning data), weryfikujących (pole Validation data) oraz testujących, nie uczestniczących w uczeniu (pole Testing data). Przycisk Input służy do wczytania nazwy pliku z rozszerzeniem .mat zawierającego zbiór wektorów \( \textbf{x} \) zorganizowany w formie macierzy (liczba wierszy odpowiada liczbie tych wektorów, a liczba kolumn jest równa wymiarowi wektora \( \textbf{x} \)). Przycisk Destination pozwala na podanie nazwy pliku, również z rozszerzeniem .mat, zawierającego zbiór wektorów zadanych \( \textbf{d} \) stowarzyszonych z wektorami wejściowymi \( \textbf{x} \). Można również zapamiętać całą sesję uczącą (przycisk Save) lub załadować jej zawartość wcześniej zapamiętaną (przycisk Load). Po naciśnięciu przycisku Load pojawia się okno dialogowe menu wyboru struktury sieci i danych przedstawione na rys. 2.5 (xu – macierz zawierająca zbiór wektorów uczących \( \textbf{x}_u \), xt – macierz zawierająca zbiór wektorów testujących \( \textbf{x}_t \), du - macierz zawierająca zbiór zadanych (znanych) wektorów uczących \( \textbf{d}_u \) na wyjściu sieci stowarzyszonych z wektorami \( \textbf{x}_u \), dt - macierz zawierająca zbiór zadanych wektorów testujących \( \textbf{d}_t \) na wyjściu sieci stowarzyszonych z wektorami \( \textbf{x}_t \).

Wybierając nazwę wcześniej zapisanej struktury sieci można podać plik zawierający kompletne dane sieci MLP zapisane w poprzedniej sesji uczącej. Można również wybrać opcję wczytywania danych uczących, weryfikujących i testujących zapisanych w jednym wspólnym pliku, z wyróżnionymi nazwami odpowiednich zmiennych.

Definiowanie struktury sieciowej odbywa się w polu środkowym menu (pole Network structure). Należy wybrać liczbę warstw ukrytych (dostępne są dwie) oraz liczbę neuronów w każdej warstwie, jak również rodzaj funkcji aktywacji neuronów. Dostępne są następujące funkcje: liniowa (Lin), sigmoidalna jednopolarna (Sigm) oraz sigmoidalna bipolarna (Bip). Liczba węzłów wejściowych oraz neuronów wyjściowych są automatycznie wyznaczane na podstawie wymiaru wektorów \( \textbf{x} \) oraz \( \textbf{d} \) i użytkownik nie może ich zmienić.

Przed rozpoczęciem uczenia należy dokonać inicjalizacji wag sieci (pole Randomization) naciskając przycisk Initialize. W programie zaimplementowano specjalną metodę randomizacji Ngyen-Widrowa [43]. Przy utknięciu procesu uczenia w minimum lokalnym można dokonać losowej zmiany wag przez naciśnięcie przycisku Jogging of weights w polu Jogging of weights i kontynuacji uczenia z nowego punktu startowego wag. Przedtem należy ustawić zakres randomizacji (threshold).

Przed uruchomieniem procesu uczenia należy jeszcze ustawić wartości parametrów procesu w polu Learning parameters, w tym liczby cykli uczących (no of epochs), wartości oczekiwanej optymalnej wartości funkcji celu (goal), minimalnej wartości gradientu (min grad) kończącej proces uczenia, maksymalnego czasu uczenia (max comp time), a także sposobu definiowania funkcji celu (performance). Dostępne są następujące miary funkcji celu: MSE - wartość średnia sumy kwadratów błędów (Mean Squared Error) - zalecana, SSE - suma kwadratów błędów (Sum Squared Error), MAE - wartość średnia błędów absolutnych (Mean Absolute Error).

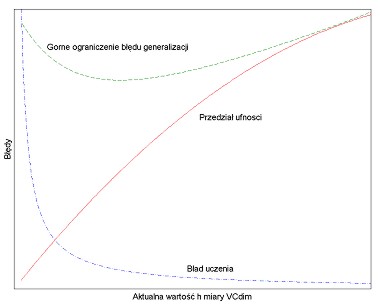

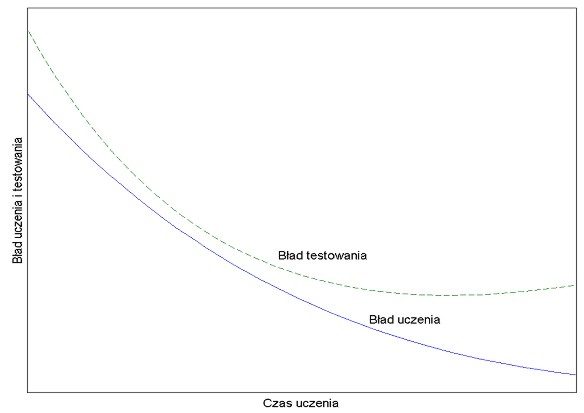

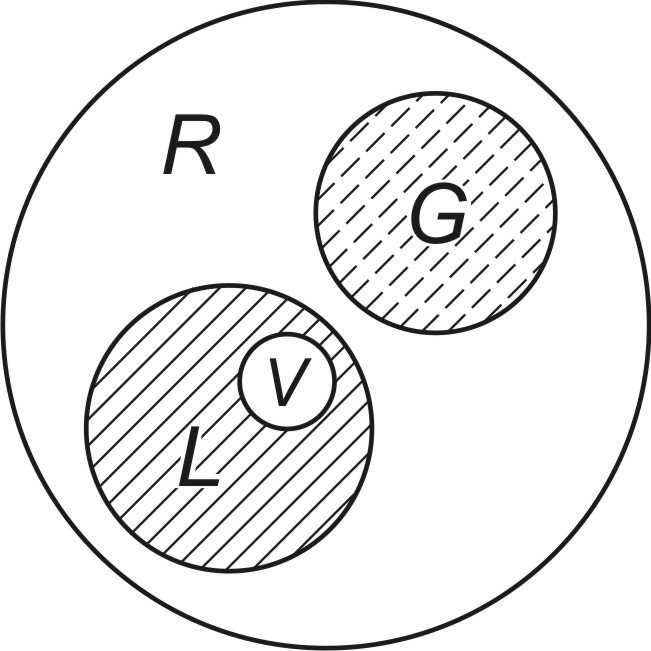

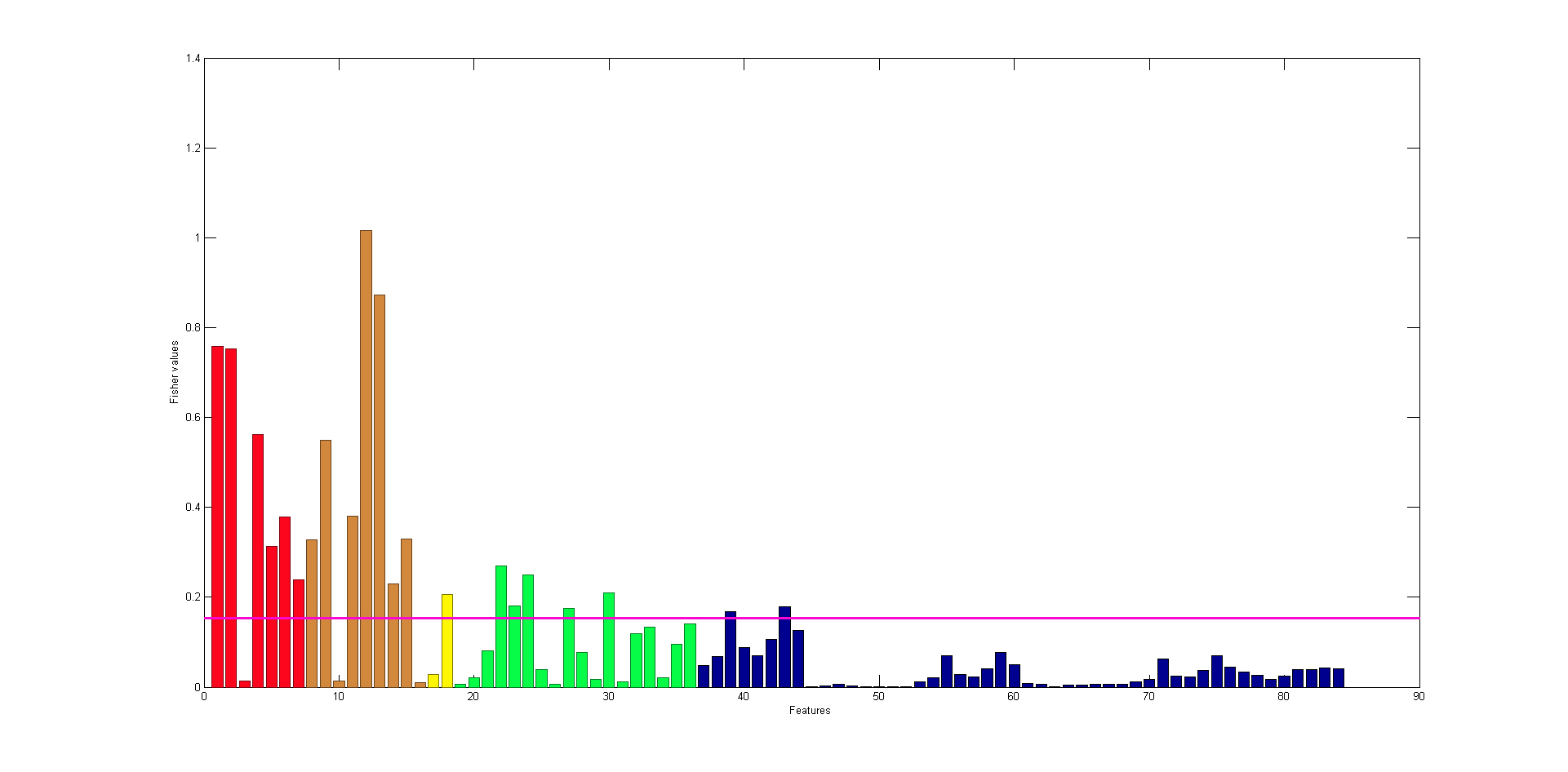

W trakcie uczenia program automatycznie wykreśla wartości aktualne funkcji celu z krokiem wybranym w polu plot every (epochs). Przy wielokrotnej kontynuacji procesu uczenia tworzony jest dodatkowy zbiorczy wykres postępów minimalizacji funkcji celu. Jeżeli w procesie uczenia przewiduje się weryfikację działania sieci na danych weryfikujących, należy uaktywnić przycisk do validation. Przy takim wyborze jednocześnie z krzywą uczenia wykreślany jest aktualny błąd dla danych weryfikujących.