Podręcznik

| Strona: | SEZAM - System Edukacyjnych Zasobów Akademickich i Multimedialnych |

| Kurs: | 4. Przykłady zastosowań sieci neuronowych |

| Książka: | Podręcznik |

| Wydrukowane przez użytkownika: | Gość |

| Data: | piątek, 16 stycznia 2026, 08:41 |

Spis treści

- 1. Zespoły klasyfikatorów

- 2. Metody oceny jakości rozwiązań

- 3. Przykłady zastosowań sieci neuronowych w zadaniach biznesowych

- 3.1. Wprowadzenie

- 3.2. Prognozowanie wskaźnika inflacji

- 3.3. Prognozowanie sygnałów kupna i sprzedaży spółek na giełdzie

- 3.4. Klasyfikacja przedsiębiorstwa pod względem zdolności kredytowych na podstawie wskaźników finansowych

- 3.5. Klasyfikacja przedsiębiorstw pod względem podatności na bankructwo

- 3.6. Zadania i problemy

- 3.7. Słownik

- 4. Prognozowanie obciążeń 24-godzinnych w systemie elektroenergetycznym z użyciem zespołu sieci neuronowych

- 5. Literatura

1. Zespoły klasyfikatorów

Dla polepszenia jakości działania systemu klasyfikacyjnego stosuje się wiele klasyfikatorów działających równolegle i rozwiązujących ten sam problem. Wyniki ich działania podlegają integracji (fuzji) dla wypracowania ostatecznego wyniki na danych podlegających testowaniu.

1.1. Struktura zespołu i metody integracji

Najbardziej oczywisty i najprostszy wybór werdyktu końcowego zespołu klasyfikatorów to zastosowanie głosowania większościowego (ang. majority voting). Każdy wzorzec charakteryzowany przez odpowiedni zestaw cech podawany jest na wszystkie klasyfikatory i podlega niezależnej klasyfikacji, będąc przypisany do odpowiedniej klasy. Następnie zliczana jest liczba przypisań tego wektora do każdej klasy. Zwycięża klasa, która uzyska największą liczbę wskazań. Jedną z odmian tego trybu jest przyjęcie założenia, że zwycięzca musi uzyskać minimum 50% plus jeden głos. W przeciwnym przypadku przyjmuje się brak rozstrzygnięcia.

Jeśli przyjąć identyczne prawdopodobieństwo \( \rho \) prawidłowego wskazania klasy przez wszystkie niezależnie działające klasyfikatory i założyć ich nieparzystą liczbę \( M \) to zostało udowodnione, że w głosowaniu większościowym statystyczna dokładność zespołu może być wyrażona wzorem [36]

| \( Acc=\sum_{m=[M / 2]+1}^M\left(\begin{array}{c} M \\ m \end{array}\right) p^m(1-p)^{M-m} \) | (11.1) |

W tabeli 11.1 przedstawiono wartości dokładności wskazań zespołu przy założeniu różnych wartości prawdopodobieństwa p (identycznego dla każdego klasyfikatora) dla liczby klasyfikatorów tworzących zespół, równej odpowiednio 3, 5, 7 oraz 9. Przyjmuje się pełną niezależność działania klasyfikatorów.

Tabela 11.1 Wartości dokładności Acc wskazania klasy przez zespół M niezależnych, jednakowej jakości klasyfikatorów

|

|

M=3 |

M=5 |

M=7 |

M=9 |

|

p=0.6 |

0.648 |

0.683 |

0.710 |

0.733 |

|

p=0.7 |

0.784 |

0.837 |

0.874 |

0.901 |

|

p=0.8 |

0.896 |

0.942 |

0.967 |

0.980 |

|

p=0.9 |

0.972 |

0.991 |

0.997 |

0.999 |

Zostało udowodnione teoretycznie, że jeśli wartość \( p > 0,5 \) to przy liczbie członków zespołu dążącej do nieskończoności dokładność wskazania klasy przez zespół dąży do 100%. Jeśli natomiast \( p < 0,5 \) to zwiększanie liczby członków zespołu zmniejsza dokładność. Przy \( M \rightarrow \infty \) dokładność zespołu zmaleje do zera. Dla \( p = 0,5 \) zastosowanie zespołu nie zmienia dokładności rozpoznania klasy.

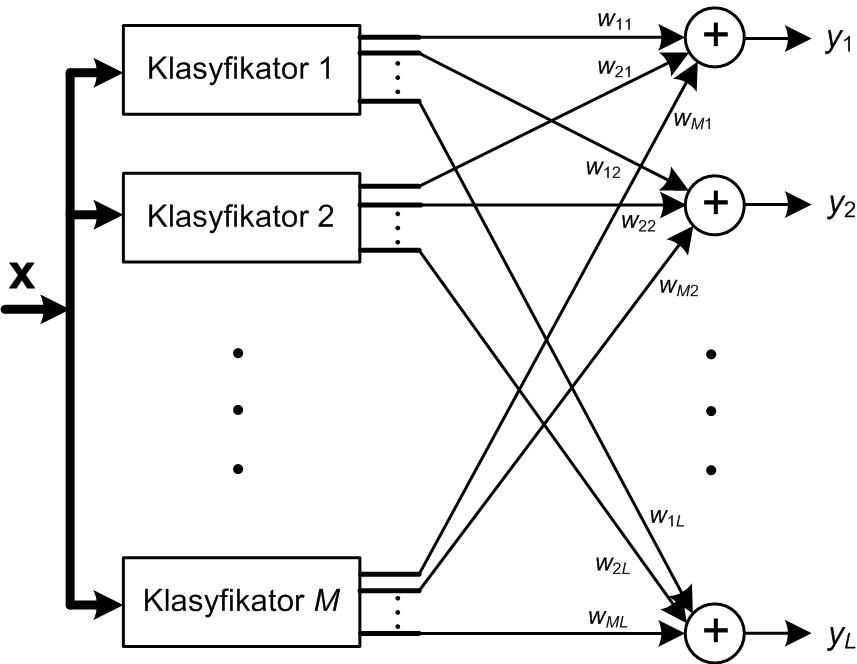

W praktyce rzadko można uzyskać identyczną dokładność wszystkich klasyfikatorów. Eksperymenty numeryczne pokazały, że w takim przypadku głosowanie większościowe nie zawsze gwarantuje uzyskanie wyniku zespołu lepszego niż najlepszy wynik indywidualny. W przypadku nierównej jakości poszczególnych klasyfikatorów można stosować głosowanie większościowe ważone. W tym rozwiązaniu siła głosu klasyfikatora indywidualnego zależy od jego dokładności rozpoznania poszczególnych klas, zmierzoną dla danych uczących (zakłada się, że dane uczące są reprezentatywne dla rozwiązywanego problemu klasyfikacji). Przy M klasyfikatorach tworzących zespół określa się wielkość yi(x) proporcjonalną do prawdopodobieństwa przynależności wektora x do i-tej klasy według wzoru [49]

| \( y_i(x)=\sum_{k=1}^M w_{k i} z_{k i}(x) \) | (11.2) |

w którym wki jest wagą z jaką k-ty klasyfikator jest uwzględniany przy rozpoznaniu i-tej klasy, natomiast zki jest sygnałem wyjściowym k-tego klasyfikatora odpowiedzialnym za rozpoznanie i-tej klasy (sygnał i-tego wyjścia klasyfikatora). Sygnał ten przyjmuje wartość 1 przy rozpoznaniu przez klasyfikator danej klasy bądź zero w przeciwnym przypadku.

Wartości wag wki mogą być wyznaczane w różny sposób, uwzględniający jakość poszczególnych członków zespołu. Do typowych rozwiązań należy

| \( w_{k i}=\frac{\eta_{k i}^m}{\sum_{j=1}^M \eta_{k i}^m} \) | (11.3) |

gdzie \( \eta_{k i}^m \) oznacza wskaźnik jakości (np. dokładność, czułość, precyzję) k-tego klasyfikatora przy rozpoznaniu i-tej klasy, m – wykładnik różnicujący wpływ poszczególnych jednostek zespołu na wynik działania zespołu (np. m= 1, 2, 3). Inny wzór wykorzystuje w integracji zespołu funkcje logarytmiczną [36]

| \( w_{k i}=\lg \left(\frac{\eta_{k i}}{1-\eta_{k i}}\right) \) | (11.4) |

Integracja zespołu klasyfikatorów (lub regresorów) jest również możliwa przy zastosowaniu dodatkowej sieci neuronowej, na wejścia której podawane są sygnały decyzyjne wszystkich członków zespołu. Sieć integrująca trenowana jest na danych (X, d), gdzie macierz wejściowa X jest utworzona z decyzji poszczególnych klasyfikatorów a wektor d reprezentuje przynależność klasową (bądź wartość zadaną w problemie regresji) poszczególnych obserwacji.

Zupełnie innym podejściem do integracji zespołu jest zastosowanie naiwnej reguły Bayesa [7]. Oznaczmy przez P(Dj) prawdopodobieństwo, że j-ty klasyfikator przypisuje wektor wejściowy x do odpowiedniej klasy i załóżmy niezależność działania klasyfikatorów.

Prawdopodobieństwo wskazania klasy \(d_i\)przez zespół \(M\) klasyfikatorów jest wówczas równe

| \( P\left(d_i \mid \mathbf{D}\right)=\frac{P\left(d_i\right) P\left(\mathbf{D} \mid d_i\right)}{P(\mathbf{D})}=\frac{P\left(d_i\right) \prod_{k=1}^M\left(D_k \mid d_i\right)}{P(\mathbf{D})} \) | (11.5) |

Ponieważ mianownik powyższej zależności nie zależy od klasy dk prawdopodobieństwo wskazania k-tej klasy przez zespół przy wystąpieniu na wejściu zespołu wektora wejściowego x jest proporcjonalne do wyrażenia z licznika powyższej zależności (założenie naiwnego klasyfikatora Bayesa). Oznaczmy ten współczynnik proporcjonalności przez µk(x). Wówczas

| \( \mu_i(\mathbf{x}) \approx P\left(d_i\right) \prod_{k=1}^M P\left(D_k \mid d_i\right) \) | (11.6) |

Prawdopodobieństwa występujące w tym wyrażeniu określa się na podstawie macierzy R rozkładu empirycznego klas (macierz pomyłek). Dla każdego klasyfikatora buduje się taką macierz na podstawie jego wyników klasyfikacji dla danych uczących. Przy M klasach jest to macierz M×M. Niech Nk oznacza całkowitą liczbę obserwacji (wektorów x zbioru uczącego ) należących do klasy k. Wówczas prawdopodobieństwo  może być estymowane w postaci [49]

może być estymowane w postaci [49]

| \( P\left(D_k \mid d_i\right)=\prod_{k=1}^M\left(\frac{1}{N_i} R_{i D_k}\right) \) | (11.7) |

gdzie \( R_{i D_k} \) oznacza element macierzy R odpowiadający k-temu wierszowi i Di-tej kolumnie na którą wskazał i-ty klasyfikator. Przyjmijmy równe prawdopodobieństwo wystąpienia k-tej klasy wśród całej populacji n danych w postaci ułamka

| \( P\left(d_i\right)=\frac{N_i}{n} \) | (11.8) |

Wówczas współczynnik proporcjonalności dla wyznaczenia prawdopodobieństwo wskazania i-tej klasy przez zespół może być estymowany w postaci

| \( \mu_i(x) \approx \frac{1}{N_i^{M-1}} \prod_{k=1}^M R_{i D_k} \) | (11.9) |

Powyższą procedurę zastosowania metody naiwnej Bayes’a do integracji zespołu klasyfikatorów zilustrujemy na przykładzie hipotetycznego zespołu zawierającego dwa klasyfikatory do rozpoznania 3 klas. Liczba obserwacji uczących jest równa n=30 (każda klasa reprezentowana przez 10 obserwacji). Przyjmijmy, że macierze rozkładu klas dla obu klasyfikatorów są dane w postaci

| \( \mathbf{R}(1)=\left[\begin{array}{lll} 6 & 2 & 2 \\ 2 & 5 & 3 \\ 1 & 3 & 6 \end{array}\right], \;\;\; \mathbf{R}(2)=\left[\begin{array}{lll} 2 & 4 & 4 \\ 2 & 5 & 3 \\ 4 & 0 & 6 \end{array}\right] \) |

Każdy wiersz macierzy odpowiada danym należącym do jednej klasy. Kolumna j-ta macierzy wskazuje, ile przypadków zostało przez dany klasyfikator rozpoznanych jako klasa j-ta. Elementy diagonalne odpowiadają danym rozpoznanym właściwie. Element Rij pokazuje ile razy obserwacja należąca do klasy i-tej została rozpoznana jako klasa j-ta. Dane z obu macierzy wskazują, że N1=10, N2=10, N3=10.

Załóżmy, że testowany wektor x został przypisany przez klasyfikator pierwszy do klasy drugiej, D1(x)=d2, a klasyfikator drugi D2(x)=d1 wskazał klasę pierwszą jako zwycięzcę. Rozpoznanie ostateczne klasy przez zespół klasyfikatorów będzie zależało od wartości µi dla i=1, 2, 3

| \( \begin{aligned} & \mu_1(\mathbf{x}) \approx \frac{1}{10} \times 2 \times 2=0.4 \\ & \mu_2(\mathbf{x}) \approx \frac{1}{10} \times 5 \times 2=1 \\ & \mu_3(\mathbf{x}) \approx \frac{1}{10} \times 3 \times 4=1.2 \end{aligned} \) | (11.10) |

Największą wartość osiągnął współczynnik µ3, stąd decyzją zespołu będzie wskazanie klasy trzeciej jako zwycięskiej dla tej obserwacji x. Zauważmy, że zwyciężyła klasa która nie uzyskała żadnego wskazania klasyfikatorów. To rozwiązanie integracji różni się znacząco od poprzedniej metody, w której zwycięzca był wyłaniany jedynie spośród klas, na którą wskazał co najmniej jeden klasyfikator.

1.2. Warunki właściwego działania zespołu

Uwzględnienie w zespole wielu rozwiązań na raz i ich integracja w jeden końcowy wynik ma sens tylko wtedy, gdy poszczególne rozwiązania są niezależne od siebie a ich wskaźniki jakości są do siebie zbliżone. Łączenie ich ze sobą stwarza wówczas szansę skompensowania pewnych błędów i poprawy dokładności klasyfikatora bądź regresora. Należy jednak podkreślić, że poszczególne rozwiązania nie mogą znacząco różnić się co do jakości, gdyż to najsłabsze może pogorszyć działanie całego zespołu [36].

Niezależność działania pojedynczych rozwiązań można uzyskać na wiele sposobów. Jednym z nich jest zastosowanie rozwiązania bazującego na innej zasadzie działania poszczególnych elementów zespołu. Na przykład zastosowanie klasyfikatora MLP, RBF, SVM daje dobrą przesłankę niezależności, gdyż każdy z nich opiera swój werdykt na innej zasadzie: MLP jest aproksymatorem globalnym, RBF lokalnym, natomiast SVM stosuje odmienne podejście do uczenia. W ramach każdego rozwiązania można również stosować struktury układu zróżnicowane pod względem złożoności (np. liczby neuronów ukrytych).

Innym rozwiązaniem problemu niezależności jest zastosowanie w uczeniu każdego członka zespołu różniących się zbiorów uczących. Takie podejście powoduje, że parametry poszczególnych układów dobrane w procesie uczenia będą inne, a więc ich działanie w trybie odtworzeniowym również odmienne. Problemem może być ograniczony zasób danych przeznaczonych do uczenia. Można go złagodzić przez zastosowanie procedury losowania danych, w której każdy układ stosuje określony procent całego zbioru danych zmieniany każdorazowo w procesie uczenia (np. procedura zwana bagging).

Innym rozwiązaniem jest stosowanie zróżnicowanego sposobu generacji cech diagnostycznych stanowiących informację wejściową dla każdego indywidualnego członka zespołu [22,49,60]. Cechy te generowane są na podstawie tych samych danych pomiarowych. W takiej sytuacji każde z indywidualnych rozwiązań systemu ma dostęp do pełnej informacji pomiarowej, ale inaczej przetworzonej.

1.3. Techniki tworzenia silnych rozwiązań na bazie słabych predyktorów

Interesującą techniką poprawy zdolności generalizacyjnych w uczeniu maszynowym jest tworzenie silnych predyktorów (klasyfikatorów bądź układów regresyjnych o podwyższonej dokładności) poprzez zastosowanie zespołów zbudowanych na bazie słabych rozwiązań predyktorów (mało dokładnych), na przykład lasu drzew decyzyjnych, nieoptymalnie dobranych struktur sieci neuronowych RBF lub MLP, itp. Klasyczne techniki tworzenia zespołu poprzez zastosowanie wielu równoległych rozwiązań indywidualnych predyktorów tego samego typu, ale trenowanych na losowo wybranych danych uczących (tzw. bagging), stosowane na przykład w lesie losowym drzew decyzyjnych [3] nie zawsze prowadzą do optymalnego wyniku pod względem generalizacji. Pojawiło się wiele ulepszonych rozwiązań tego typu zespołów. Do najbardziej znanych należą systemy wzmacniana (tzw. boosting), które wpływają na działanie zespołu już na etapie ich tworzenia, ingerując silnie w algorytm uczący. W tym punkcie przedstawione zostaną dwie techniki tworzenia takiego zespołu słabych predyktorów: wzmacnianie adaptacyjne (tzw. adaptive boosting) zwane w skrócie AdaBoost, oraz wzmacnianie gradientowe, zwane w skrócie gradient boosting.

11.3.1 AdaBoost

W technice AdaBoost każdy nowo dodawany członek zespołu (np. nowe drzewo decyzyjne czy klasyfikator MLP) jest trenowany na losowo wybranym zestawie danych uczących, przy czym każda próbka ucząca podlegająca losowaniu ma przypisaną wagę, której wartość jest uzależniona od aktualnego statystycznego błędu dla danej obserwacji przez aktualny stan zespołu [73]. Na starcie wszystkie obserwacje uczące mają identyczne wartości przypisanych wag, stąd prawdopodobieństwo ich wylosowania do zbioru uczącego danego członka zespołu jest identyczne. W wyniku ewaluacji danych przez aktualnie wytrenowany zespół następuje zwiększenie wagi dla obserwacji trudnych w testowaniu oraz zmniejszenie wagi dla danych, które dobrze wypadły na etapie ewaluacji. W efekcie obserwacje o większej wartości wagi mają zwiększone prawdopodobieństwo wylosowania do zbioru uczącego następnego członka zespołu (np. dodawanego drzewa decyzyjnego). Nowy członek zespołu w procesie uczenia specjalizuje się więc w rozpoznaniu przypadków trudniejszych. Każdy następny dodawany członek zespołu poddawany jest trenowaniu na zbiorze uczącym zawierającym coraz trudniejsze przypadki danych, źle rozpoznawane przez istniejących członków zespołu. Wynik działania tak powstałego zespołu jest sumą wagową wskazań poszczególnych członków, przy czym waga jest związana z wartością wagi przypisaną poszczególnym obserwacjom, dobraną wcześniej w procesie dodawania nowych członków zespołu. Jest to zasadnicza różnica w stosunku do klasycznej metody zwykłego głosowania większościowego, stosowanego w technice bagging [73].

Załóżmy, że dany jest zbiór par danych uczących klasyfikatora (xi, di) dla i=1, 2, …, p, gdzie xi jest wektorem wejściowym a di oznacza klasę kodowana na przykład w postaci binarnej (1, -1). Załóżmy, że zespół składa się z M słabych klasyfikatorów generujących wynik yi przynależności klasowej 1 lub -1 dla każdego wektora wejściowego xi. W wyniku (m-1) cykli tworzenia nowego członka powstanie zespół, którego werdykt przy pobudzeniu wektorem xi będzie sumą wagową wskazań wszystkich członków [73]

| \( F_{m-1}\left(\mathbf{x}_i\right)=\alpha_1 y_1\left(\mathbf{x}_i\right)+\alpha_2 y_2\left(\mathbf{x}_i\right)+\cdots+\alpha_{m-1} y_{m-1}\left(\mathbf{x}_i\right) \) | (11.11) |

Po dodaniu \( m \)-tego słabego predyktora wynik działania zespołu można przedstawić w postaci

| \( F_m\left(\mathbf{x}_i\right)=F_{m-1}\left(\mathbf{x}_i\right)+\alpha_m y_m\left(\mathbf{x}_i\right) \) | (11.12) |

Zadanie polega na doborze takiej wartości wagi \( \alpha_m \) oraz wyniku \( y_m\left(\mathbf{x}_i\right) \) sklasyfikowania wektora \( \mathbf{x}_i \) przez \( m \)-ty klasyfikator aby polepszyć działanie całego zespołu. Funkcję błędu (ang. loss function) definiuje się w postaci wykładniczej dla wszystkich wektorów \( \mathbf{x}_i \) biorących udział w procesie uczenia

| \( E=\sum_{i=1}^p e^{-d_i F_m\left(\mathbf{x}_i\right)}=\sum_{i=1}^p e^{-d_i F_{m-1}\left(\mathbf{x}_i\right)} e^{-d_i \alpha_m y_m\left(\mathbf{x}_i\right)} \) | (11.13) |

Wprowadźmy oznaczenia wagowe w powyższym wzorze

-

w pierwszym cyklu tworzenia zespołu \( w_i^{(1)} \)

-

w \( m \)-tym (\( m > 1\) cyklu \( w_i^{(m)}=e^{-d_i F_{m-1}\left(\mathbf{x}_i\right)} \)

Wówczas wyrażenie na funkcję błędu przyjmie postać

| \( E=\sum_{i=1}^p w_i^{(m)} e^{-d_i \alpha_m y_m\left(\mathbf{x}_i\right)} \) | (11.14) |

Rozdzielając to wyrażenie na dwa składniki:

-

jeden prawidłowo sklasyfikowany dla którego \( d_i y_m\left(\mathbf{x}_i\right)=1 \)

-

drugi sklasyfikowany z błędem dla którego \( d_i y_m\left(\mathbf{x}_i\right)=-1 \)

otrzymuje się wyrażenie na funkcję błędu w postaci

| \( E=\sum_{d_i=y\left(x_i\right)} w_i^{(m)} e^{-\alpha_m}+\sum_{d_i \neq y\left(x_i\right)} w_i^{(m)} e^{\alpha_m}=\sum_{i=1}^p w_i^{(m)} e^{-\alpha_m}+\sum_{d_i \neq y\left(x_i\right)} w_i^{(m)}\left(e^{\alpha_m}-e^{-\alpha_m}\right) \) | (11.15) |

Analiza powyższego wzoru wskazuje, że wartość błędu \(E\) zależy jedynie od czynnika \( \sum_{y\left(x_i\right) \neq d_i} w_i^{(m)} e^{\alpha_m} \), gdzie \( w_i^{(m)}=e^{-d_i F_{m-1}\left(\mathbf{x}_i\right)} \) . Minimalizacja błędu wymaga aby pochodna funkcji błędu względem \( \alpha_m \) była równa zeru, co oznacza

| \( \frac{d E}{d \alpha_m}=\frac{d\left(\sum_{y\left(x_i\right)=d_i} w_i^{(m)} e^{-\alpha_m}+\sum_{y\left(x_i\right) \neq d_i} w_i^{(m)} e^{\alpha_m}\right)}{d \alpha_m}=0 \) |

(11.16) |

Rozwiązanie powyższej zależności określa optymalną wartość \( \alpha_m \) w postaci

| \( \alpha_m=\frac{1}{2} \ln \left(\frac{\sum_{y\left(x_i\right)=d_i} w_i^{(m)}}{\sum_{y\left(x_i\right) \neq d_i} w_i^{(m)}}\right) \) | (11.17) |

Oznaczając względny błąd \( m \)-tego klasyfikatora jako \( \varepsilon_m \), przy czym

| \( \boldsymbol{\varepsilon}_m=\left(\frac{\sum_{y\left(x_i\right) \neq d_i} w_i^{(m)}}{\sum_{i=1}^p w_i^{(m)}}\right) \) | (11.18) |

wzór na wartość wagi \( \alpha_m \) przyjmie ostateczną postać

| \( \alpha_m=\frac{1}{2} \ln \left(\frac{1-\varepsilon_m}{\varepsilon_m}\right) \) | (11.19) |

Wartość ta będzie użyta w \( m \)-tym kroku przy dodaniu następnego klasyfikatora do zespołu. Wynik klasyfikacji tak rozszerzonego zespołu dla wektora wejściowego \( \mathbf{x}_i \) określa wówczas wzór

| \( F_m\left(\mathbf{x}_i\right)=\alpha_1 y_1\left(\mathbf{x}_i\right)+\alpha_2 y_2\left(\mathbf{x}_i\right)+\ldots+\alpha_m y_m\left(\mathbf{x}_i\right) \) | (11.20) |

gdzie \( y_i \) \( (i=1,2, \ldots, m) \) oznacza wskazanie klasy przez kolejnych członków zespołu, a współczynnik \( \alpha_m \) wagę z jaka to wskazanie jest brane pod uwagę.

Technika zwana gradient boosting stosuje inne rozwiązanie tworzenia i trenowania zespołu słabych predyktorów [2,55]. W odróżnieniu od metody AdaBoost stosującej wagi przypisane obserwacjom w zależności od skali trudności w ich rozpoznaniu technika gradient boosting koncentruje się na gradiencie funkcji strat \( E(d_i, y_i) \) przy czym funkcja strat może być rozumiana tradycyjnie jako różnica między wartościami aktualnymi i pożądanymi albo koncentrować się jedynie na określeniu jakości modelu, definiowanej dowolnie przez użytkownika. Kolejni członkowie są dodawani wybierając kierunek ujemnego gradientu funkcji strat, nie zmieniając przy tym parametrów dotychczasowych członków zespołu.

Podobnie jak w metodzie AdaBoost dany jest zbiór par danych uczących klasyfikatora \( (\mathbf{x}_i, d_i) \) dla \( (i=1,2, \ldots, p) \), gdzie \( \mathbf{x}_i \) jest wektorem wejściowym a \( d_i \) oznacza klasę kodowana na przykład w postaci binarnej \( (1, -1) \). Załóżmy, że zespół składa się z \( M \) słabych klasyfikatorów generujących wynik \( y_i \) przynależności klasowej \(1 \) lub \(-1\) dla każdego wektora wejściowego \( \mathbf{x}_i\). Celem jest stworzenie zespołu, którego działanie na zbiorze uczącym minimalizuje wartość średnią błędu. Wynik działania zespołu \(M\) predyktorów przy pobudzeniu wektorem \( \mathbf{x}_i \) będzie składał się z sumy wagowej wskazań poszczególnych jego członków

| \( F(\mathbf{x})=\sum_{i=1}^M \alpha_i y_i(\mathbf{x})+\mathrm{const} \) | (11.21) |

Dodanie \( m \)-tego członka zespołu powinno zmienić wynik działania w kierunku minimalizacji wartości funkcji strat. Działanie zespołu złożonego teraz z \( m \) członków można zapisać w postaci

| \( F_m(\mathbf{x})=F_{m-1}(\mathbf{x})+\underset{y_m}{\arg \min }\left(\sum_{i=1}^p E\left(d_i, F_{m-1}\left(\mathbf{x}_i\right)\right)+y_m\left(\mathbf{x}_i\right)\right) \) | (11.22) |

Rozwiązanie zastosowane w metodzie gradient boosting wykorzystuje metodę optymalizacyjną największego spadku, przy czym równanie (11.21) zastępuje się liniową aproksymacją uwzględniającą jedynie czynnik gradientowy (metoda największego spadku)

| \( F_m(\mathbf{x})=F_{m-1}(\mathbf{x})-\eta \sum_{i=1}^p \nabla_{F_{m-1}} E\left(d_i, F_{m-1}\left(\mathbf{x}_i\right)\right) \) | (11.23) |

gdzie \( \eta \) jest wielkością kroku w kierunku malejącej wartości gradientu funkcji strat \( \nabla_{F_{m-1}} E\left(d_i, F_{m-1}\left(\mathbf{x}_i\right)\right) \). Wartość \( \eta \) może podlegać optymalizacji w taki sposób, aby uzyskać minimum funkcji strat \( E\) w każdym cyklu dodawania członka zespołu.

| \( \eta_{o p t}=\underset{\eta}{\arg \min } \sum_{i=1}^p E\left[d_i, F_{m-1}\left(\mathbf{x}_i\right)-\eta \nabla_{F_{m-1}} E\left(d_i, F_{m-1}\left(\mathbf{x}_i\right)\right)\right] \) | (11.24) |

Po dodaniu \(m\)-tego członka wynik działania zespołu przy pobudzeniu wektorem \( \mathbf{x} \) określa zmodyfikowany model

| \( F_m(\mathbf{x})=F_{m-1}(\mathbf{x})+\eta y_m(\mathbf{x}) \) | (11.25) |

Technika gradient boosting jest najczęściej stosowana przy użyciu drzew decyzyjnych jako słabych predyktorów. Badania tego algorytmu pokazały, że najlepsze rezultaty uzyskuje się przy zastosowaniu liczby poziomów decyzyjnych od 4 do 8. W praktyce stosuje się dodatkowo inne metody regularyzacji.

Jednym z nich jest ograniczenie liczby drzew biorących udział w zespole. Wprawdzie zwiększenie ich liczby redukuje zwykle błąd uczenia, ale może prowadzić do „przeuczenia” pogarszając zdolność generalizacji (działanie modelu na danych nie uczestniczących w procesie uczenia). Zwykle obserwuje się zwiększoną efektywność działania zespołu jedynie do określonego poziomu populacji. Po uzyskaniu etapu stagnacji należy zaprzestać dodawania nowych członków.

Inna metoda regularyzacji wprowadza zmniejszenie wartości kroku \( \eta \) w procesie adaptacyjnym, zastępując wzór (11.25) określający działanie zespołu jego zmodyfikowaną wersją

| \( F_m(\mathbf{x})=F_{m-1}(\mathbf{x})+v \eta y_m(\mathbf{x}) \) | (11.26) |

w której współczynnik \( v \) jest ułamkiem. Typowa wartość to \( v=0.1\). Tym nie mniej należy zwrócić uwagę, że oznacza to zmniejszenie realnej wartości kroku uczenia, wydłużające cały proces adaptacji systemu.

Jeszcze innym podejściem jest zastosowanie w uczeniu kolejnych członków zespołu zredukowanej liczby obserwacji losowo wybieranych ze zbioru uczącego (tzw. dropout ratio). Przyspiesza to proces uczenia nie pogarszając zdolności generalizacyjnych (typowa regularyzacja typu niejawnego).

Jako czynnik regularyzacyjny stosuje się również wprowadzenie minimalnej liczby obserwacji dopuszczalnej w węzłach decyzyjnych zanim podział zbioru będzie możliwy. Stosuje się również karanie za zbyt dużą liczbę węzłów decyzyjnych oraz liści w drzewach. Istotnym parametrem działającym jako regularyzacja jest wprowadzenie ograniczenie czasu uczenia poprzez obserwacje postępu w kolejnych cyklach dodawania członków zespołu. Proces podlega zakończeniu, jeśli dodanie kolejnych członków nie poprawia działania zespołu powyżej założonego progu względnego. Zastosowanie wielu metod regularyzacyjnych na raz polepsza zdolności generalizacji zespołu pozwalając przy użyciu słabych predyktorów uzyskać bardzo dobre wyniki klasyfikacji całego zespołu.

W tworzeniu zespołu klasyfikatorów można łączyć ze sobą różnego rodzaju systemy: neuronowe, sieci głębokie CNN, drzewa decyzyjne czy klasyfikatory bayesowskie. W szczególności pojedyncze jednostki zespołu mogą zawierać wewnątrz inne podzespoły, na przykład zastosowanie lasu drzew decyzyjnych (typowy zespół klasyfikatorów) w zespole z pojedynczą siecią MLP, RBF czy SVM. Każde rozwiązanie prowadzące do polepszenia wyników klasyfikacji jest akceptowalne.

1.4. Przykład zastosowania zespołu klasyfikatorów w rozpoznaniu twarzy

Jako przykład zastosowania zespołu klasyfikatorów pokażemy jego działanie przy rozpoznaniu obrazów twarzy. Jako narzędzie klasyfikacyjne zastosowane zostaną sieci głębokie CNN powiązane w zespole. Istnieje aktualnie kilkanaście dostępnych w Matlabie sieci pre-trenowanych, miedzy innymi alexnet, shufflenet, darknet53, efficientnetb0, squeezenet, googlenet; inceptionv3, mobilenetv2, resnet50, xception, inceptionresnetv2, nasnetmobile, densenet201. Zespół sieci można tworzyć na wiele sposobów. Jednym z nich jest przyjęcie jednego rodzaju sieci i wielokrotne powtórzenie procesu z losowymi wartościami startowymi i zmieniona strukturą końcową. Inny sposób to zastosowanie wielu różnych rozwiązań na raz w zespole. Badanie obu rozwiązań zostanie zaimplementowane w rozpoznaniu obrazów twarzy tworzących 68 klas. Każda klasa była reprezentowana przez 20 przykładowych próbek. Różnice między członkami tych samych klas są duże, co pokazano dla 3 klas na rys. 11.2.

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Przykładowa implementacja programu w Matlabie:

% Program w Matlabie do rozpoznania obrazów twarzy przy użyciu zespołu pre-trenowanych sieci CNN

addpath 'pliki'

addpath 'pliki2'

addpath 'pliki3'

wyn=[]; wynVal=[];

Pred_y=[]; Pred_yVal=[]; time=[];

%% %Load Data

imds = imageDatastore( 'c:\chmura\ALEX_obrazy_all',...

'IncludeSubfolders',true,...

'ReadFcn', @customreader, ...

'LabelSource','foldernames');

[imdsTrain,imdsValidation] = splitEachLabel(imds,0.7,'randomized');

kk=10;

for i=1:kk

i

tic

% if i==1

net = alexnet;

% elseif i==2

% net = shufflenet;

% elseif i==3

% net = darknet53;

% elseif i==4

% net=efficientnetb0;

% elseif i==5

% net = squeezenet;

% elseif i==6

% net = googlenet;

% elseif i==7

% net = inceptionv3;

% elseif i==8

% net = mobilenetv2;

% elseif i==9

% net = resnet50;

% elseif i==10

% net = xception;

% elseif i==11

% net = inceptionresnetv2;

% elseif i==12

% net = nasnetmobile;

% elseif i==13

% net = densenet201;

% else

% end

analyzeNetwork(net)

net.Layers(1)

inputSize = net.Layers(1).InputSize;

lgraph = layerGraph(net);

[learnableLayer,classLayer] = findLayersToReplace(lgraph);

[learnableLayer,classLayer]

numClasses = numel(categories(imdsTrain.Labels));

if isa(learnableLayer,'nnet.cnn.layer.FullyConnectedLayer')

newLearnableLayer = fullyConnectedLayer(numClasses, ...

'Name','new_fc', ...

'WeightLearnRateFactor',10, ...

'BiasLearnRateFactor',10);

elseif isa(learnableLayer,'nnet.cnn.layer.Convolution2DLayer')

newLearnableLayer = convolution2dLayer(1,numClasses, ...

'Name','new_conv', ...

'WeightLearnRateFactor',10, ...

'BiasLearnRateFactor',10);

end

lgraph = replaceLayer(lgraph,learnableLayer.Name,newLearnableLayer);

newClassLayer = classificationLayer('Name','new_classoutput');

lgraph = replaceLayer(lgraph,classLayer.Name,newClassLayer);

figure('Units','normalized','Position',[0.3 0.3 0.4 0.4]);

plot(lgraph)

ylim([0,10])

layers = lgraph.Layers;

connections = lgraph.Connections;

layers(1:10) = freezeWeights(layers(1:10));

lgraph = createLgraphUsingConnections(layers,connections);

%TRAIN

pixelRange = [-30 30];

scaleRange = [0.9 1.1];

imageAugmenter = imageDataAugmenter( ...

'RandXReflection',true, ...

'RandXTranslation',pixelRange, ...

'RandYTranslation',pixelRange, ...

'RandXScale',scaleRange, ...

'RandYScale',scaleRange);

augimdsTrain = augmentedImageDatastore(inputSize(1:2),imdsTrain, ...

'DataAugmentation',imageAugmenter);

augimdsValidation = augmentedImageDatastore(inputSize(1:2),imdsValidation);

miniBatchSize = 10;

valFrequency = floor(numel(augimdsTrain.Files)/miniBatchSize);

options = trainingOptions('sgdm', ...

'MiniBatchSize',miniBatchSize, ...

'MaxEpochs',5, ...

'ExecutionEnvironment','gpu',...

'InitialLearnRate',3e-4, ...

'Shuffle','every-epoch', ...

'ValidationData',augimdsValidation, ...

'ValidationFrequency',valFrequency, ...

'Verbose',false, ...

'Plots','training-progress');

net = trainNetwork(augimdsTrain,lgraph,options);

[YPred,probs] = classify(net,augimdsValidation);

accuracy = mean(YPred == imdsValidation.Labels)

%i=i+1

toc

%STATYSTYKA

Pred_y=[double(YPred) double(imdsValidation.Labels)];

dtest=double(imdsValidation.Labels);

wyn=[wyn accuracy]

time=[time toc]

end

nclass=numClasses

%ZESPÓŁ

dy=[dtest Pred_y]

nclass=numClasses

clear dz

[lw,lk]=size(dy);

for i=1:lw

for j=1:nclass

d=0;

for k=2:lk

if (j==double(dy(i,k)))

d=d+1;

else

end

end

dz(i,j)=d;

% klasa=dy(:,1)

end

end

dz;

[q,cl_max]=max(dz');

zgod_class=length(find(double(dy(:,1))==cl_max'));

dokl_zesp=zgod_class/lw*100

median_zesp=median(wyn)

max_zesp=max(wyn)

mean_zesp=mean(wyn)

odch_zesp=std(wyn)

[C,order] = confusionmat(double(dtest),double(cl_max));

Confusion=C

for i=1:nclass,

sen(i)=C(i,i)/sum(C(i,:));

end

for i=1:nclass,

prec(i)=C(i,i)/sum(C(:,i));

end

lc1t=sum(dtest==1);

lc2t=sum(dtest==2);

%ROC

for i=1:length(dtest)

ydz(i)=dz(i,1)/(dz(i,1)+dz(i,2));

end

for i=1:lc1t

dtestroc(i)=1;

end

for i=lc1t+1:length(dtest)

dtestroc(i)=0;

end

wyn

sen

prec

F1_zesp=2*prec.*sen./(prec+sen)

time

Program stosuje aktualnie 10 członków zespołu (kk=10), generując wyniki poszczególnych członków oraz wyniki zespołu zintegrowanego poprzez głosowanie większościowe. W efekcie obliczone są takie miary jakości, jak dokładność, precyzja, czułość i miara F1 rozpoznania poszczególnych klas. Wyniki rozpoznania klas przedstawione zostaną dla 2 rozwiązań. Pierwszy zespół został zbudowany na bazie ALEXNET, wywołanym 10 razy z losowymi wartościami parametrów startowych. W drugim przypadku zespół złożony by z 10 różnych struktur sieci (w kolejności zadeklarowanej w liniach programu w Matlabie).

Tabela 11.2 przedstawia wartości średnie dokładności rozpoznania wszystkich klas przez klasyfikator ALEXNET w kolejnych próbach działania na tych samych danych testujących oraz przy zastosowaniu 10 różnych struktur sieciowych (kolejność jak w programie)

Tabela 11.2 Średnia dokładność rozpoznania 68 klas przez 2 zespoły: zespół zbudowany na bazie ALEXNET

i zespół złożony z 10 różnych struktur sieciowych CNN

|

Klasyfikator |

1 |

2 |

3 |

4 |

5 |

6 |

7 |

8 |

9 |

10 |

Mean ±std |

Zespół |

|

Zespół ATEXNET |

85.0 |

78.7 |

77.7 |

88.5 |

83.5 |

82.11 |

86.3 |

80.1 |

86.5 |

85.8 |

83.4±3.64 |

94.12 |

|

Zespół 10 różnych sieci |

85.3 |

87.0 |

99.0 |

62.7 |

60.3 |

75.5 |

75.6 |

87.2 |

91.2 |

54.4 |

77.87±14.7 |

81.37 |

Zastosowanie integracji wyników poszczególnych klasyfikatorów metodą głosowania większościowego zdecydowanie poprawiło końcową dokładność rozpoznania, która dla zespołu zbudowanego na bazie ALEXNET jest równa 94.12% (wzrost dokładności względem wartości średniej klasyfikatorów o 12.8%). W drugim przypadku ten przyrost był znacznie mniejszy ( z wartości 77.87 do 81.37%). Tym razem znacznie lepsze wyniki uzyskano w zespole zbudowanym na bazie jednego rodzaju sieci. Gorszy wynik zespołu zbudowanego z różnych sieci był spowodowany niewydolnością aż 3 rodzajów rozwiązań (sieć 4, 5 i 10) dla których dokładność rozpoznania była bardzo niska i zdecydowanie odbiegała od średniej pozostałych rozwiązań. Eliminacja tych słabszych sieci z zespołu pozwala uzyskać znacznie lepsze wyniki, przewyższające wyniki zespołu zbudowanego na bazie jednej sieci.

Należy przy tym zauważyć, że głosowanie większościowe (jakkolwiek najprostsze) nie zapewnia w każdym przypadku lepszych wyników zespołu niż najlepszy klasyfikator indywidualny ze względu na duże różnice dokładności poszczególnych rozwiązań (jest to widoczne w drugim przypadku eksperymentów).

Na rys. 12.3 przedstawiono wartości czułości i precyzji klasowej uzyskanej dla poszczególnych klas przez zespół klasyfikatorów. Wartość średnia precyzji klasowej jest równa 95.22%, natomiast czułości rozpoznania klas przez zespół równa 94.12%. Oba wyniki można uznać za bardzo dobre biorąc pod uwagę liczbę rozpoznawanych klas (68) jak i duże różnice w reprezentacji próbek należących do tej samej klasy.

Interesujące są również czasy działania poszczególnych implementacji sieci CNN. Na rys. 12.4 przedstawiono 2 wykresy ilustrujące czasy potrzebne na treningi poszczególnych rozwiązań sieci. Rys. 12.4a przedstawia czasy uczenia różnych implementacji sieci CNN, natomiast rys. 12.4b czas uczenia tej samej sieci ALEXNET w 10 kolejnych próbach.

Najdłuższy czas uczenia odpowiadał sieci czwartej (efficientnetb0) oraz sieci siódmej (inceptionv3). Najmniej wymagająca pod względem czasowym okazała się sieć piąta (squeezenet) oraz pierwsza (ALEXNET). Niewielkie różnice w czasach uczenia zaobserwować można przy powtarzanych próbach uczenia sieci ALEXNET. Średni czas w tych próbach był równy 109.5 sekund, przy odchyleniu standardowym 8.2 sekund.

|

a) |

b) |

1.5. Zadania i problemy

11.5 Zadania i problemy

1. Trzy klasyfikatory zastosowane do rozpoznania 2 klas dały wyniki uczenia w postaci macierzy rozbieżności klasowej \( \mathbf{R1} \), \(\mathbf{R2}\) i \( \mathbf{R3}\) o postaci

\( \mathbf{R1} =\left[\begin{array}{cc} 15 & 5 \\ 8 & 10 \end{array}\right], \mathbf{R2} =\left[\begin{array}{cc} 8 & 12 \\ 15 & 3 \end{array}\right], \mathbf{R3}=\left[\begin{array}{cc} 19 & 1 \\ 9 & 9 \end{array}\right] \)

Przy testowaniu wektorem testowym \(\mathbf{x}_{t1} \) poszczególne klasyfikatory wskazał następujące klasy:

-

Klasyfiktor 1 - -> klasa 2, klasyfikator 2 -> klasa 1, klasyfikator 3 -> klasa 1

Przy testowaniu wektorem testowym xt2 poszczególne klasyfikatory wskazał następujące klasy:

-

Klasyfiktor 1 - -> klasa 1, klasyfikator 2 -> klasa 2, klasyfikator 3 -> klasa 2

Jaki będzie wynik przynależności klasowej zespołu dla obu wektorów przy integracji większościowej oraz większościowej ważonej stosującej wzór (11.10b)

\( w_{k i}=\lg \left(\frac{\eta_{k i}}{1-\eta_{k i}}\right) \)

2. Zastosować naiwną regułę Bayes’a do integracji zespołu zawierającego dwa klasyfikatory do rozpoznania 3 klas. Liczba obserwacji uczących jest równa n=30. Macierze rozkładu klas dla obu klasyfikatorów są dane w postaci

\( \mathbf{R} 1=\left[\begin{array}{ccc} 5 & 3 & 0 \\ 1 & 6 & 2 \\ 2 & 1 & 10 \end{array}\right], \mathbf{R} 2=\left[\begin{array}{lll} 4 & 1 & 3 \\ 0 & 6 & 3 \\ 3 & 4 & 6 \end{array}\right] \)

Załóżmy, że testowany wektor \(\mathbf{x}_{t} \) został przypisany przez klasyfikator pierwszy do klasy drugiej, a klasyfikator drugi wskazał klasę pierwszą jako zwycięzcę.

3. Sprawdzić działanie pojedynczych sieci głębokich przy rozpoznaniu obrazów twarzy zawartych w bazie MUCT. Wykorzystać postać programu w Matlabie dla sieci przetrenowanych. Porównać czasy uczenia sieci.

4. Sprawdzić działanie zespołu różnych sieci głębokich przy rozpoznaniu obrazów twarzy zawartych w bazie MUCT. Wykorzystać postać programu w Matlabie dla sieci przetrenowanych. Porównać wyniki dla różnej liczby użytych członków zespołu.

5. Sprawdzić działanie zespołu sieci głębokich utworzonych na bazie jednej struktury sieciowej przy rozpoznaniu obrazów twarzy zawartych w bazie MUCT. Wykorzystać postać programu w Matlabie dla sieci przetrenowanych. Porównać wyniki dla różnej liczby użytych członków zespołu.

1.6. Słownik

Słownik opanowanych pojęć

Wykład 11

Zespół – zbiór indywidualnych rozwiązań zintegrowanych dla wytworzenia jednego wspólnego werdyktu końcowego (dotyczy klasyfikatorów lub systemów regresyjnych).

Integracja zespołu – sposób wytworzenia końcowego werdyktu zespołu (fuzja wyników członków zespołu).

Głosowanie większościowe – sposób wyłonienia zwycięzcy w systemie klasyfikacyjnym poprzez bezpośrednie zliczanie głosów na określoną klasę.

Głosowanie większościowe ważone – sposób wyłonienia zwycięzcy w systemie klasyfikacyjnym poprzez zliczanie głosów na określoną klasę z uwzględnieniem wagi każdego klasyfikatora.

Naiwna reguła Bayesa – metoda wyłonienia klasy na podstawie analizy prawdopodobieństwa a priori i aposteriori (stosowana między innymi w integracji zespołu).

Bagging – technika stosowana w uczeniu członków zespołu trenowanych na losowo wybranych danych uczących.

Boosting – technika wzmacniania stosowana w uczeniu członków zespołu trenowanych na wybranych danych uczących uwzględniająca błędy popełniane na każdej próbce uczącej.

AdaBoost – technika uczenia ze wzmacnianiem, w której każdy nowo dodawany członek zespołu jest trenowany na losowo wybranym zestawie danych uczących, przy czym każda próbka ucząca ma przypisaną wagę, której wartość jest uzależniona od aktualnego statystycznego błędu dla danej obserwacji.

Gradient boosting – technika tworzenia zespołu koncentrująca się na gradiencie funkcji strat.

2. Metody oceny jakości rozwiązań

Model odwzorowujący badany proces dokonuje estymacji odpowiedzi tego procesu na podstawie danych wejściowych. Dokładność tej odpowiedzi, czyli jej zgodność z wartością spodziewaną, może być różna w zależności od jakości zbudowanego modelu. Dla oceny modelu stosuje się różne miary, które pozwalają na ocenę jego jakości. W zależności od rodzaju zadania regresji (regresja czy klasyfikacja) stosuje się różne rodzaje tych miar.

2.1. Miary jakości regresji

W zadaniu regresji odpowiedź modelu określa wartość jego odpowiedzi na wymuszenie w postaci atrybutów wejściowych i jest wyrażona w postaci rzeczywisto-liczbowej. Dokładność modelu stanowi podstawowe kryterium, na podstawie którego jest oceniana jego przydatność.

Dla twórcy algorytmu prognozowania dokładność regresji określa, na ile dany model predykcyjny odtwarza poprawnie dane, które są już znane konstruktorowi. Dla użytkownika systemu prognostycznego istotne jest, na ile wiarygodna jest prognoza i czy spełni ona w przyszłości założone kryteria dokładnościowe. Miary dokładności regresji, obliczane są niejako po fakcie, to znaczy najpierw wyliczana jest prognoza, a później dokonywana jej ocena w oparciu o napływające dane rzeczywiste (dokładne). Stąd należą one do miar klasy ex post.

Załóżmy, że dla każdego rekordu danych dostępne są estymowane odpowiedzi modelu oznaczone przez \( y_i \) oraz znane wartości dokładne oznaczone symbolem \( d_i \) dla \( i = 1, 2, \ldots, n \), gdzie \( n \) oznacza liczbę rekordów. Chwilowy błąd estymacji jest różnicą między wartością estymowaną a wartością dokładną

| \( e_i=d_i-y_i \) | (12.1) |

Miara jakości modelu jest związana zwykle ze statystyką błędu estymacji. Wyróżnia się różne definicje błędów statystycznych. Do najbardziej popularnych należą [49]:

-

błąd średni absolutny (ang. Mean Absolute Error - \( \operatorname{MAE} \))

| \( \operatorname{MAE} =\frac{1}{n}\left(\sum_{i=1}^n\left|d_i-y_i\right|\right) \) | (12.2) |

-

względny błąd średni absolutny (ang. Mean Absolute Percentage Error - \( \operatorname{ MAPE }\))

| \( \operatorname{ MAPE }=\frac{1}{n}\left(\sum_{i=1}^n \frac{\left|d_i-y_i\right|}{\left|d_i\right|}\right) \cdot 100 \% \) | (12.3) |

Błąd MAPE jest najbardziej reprezentatywnym rodzajem oceny jakości regresji, niezależnym od wartości absolutnych ciągu poddanego regresji, stąd najczęściej stosowanym w praktyce. W przypadku, gdy część wartości zadanych \( d_i = 0 \) miara powyższa staje się równa nieskończoności, przez co staje się bezużyteczna. W takim przypadku przyjmuje się miarę uproszczoną w postaci wyrażonej poprzez normy wektorowe

| \( \operatorname{MAPE} \simeq \frac{\|d-y\|}{\|d\|} \cdot 100 \% \) | (12.4) |

gdzie \( \mathbf{d} \), \( \mathbf{y} \)oznaczają formę wektorową zbioru wartości, odpowiednio zadanych i estymowanych.

-

błąd średniokwadratowy (ang. Root Mean Squared Error - \( \operatorname{RMSE}\))

| \( \operatorname{RMSE}=\sqrt{\frac{1}{n} \sum_{i=1}^n\left|d_i-y_i\right|^2} \) | (12.5) |

-

błąd maksymalny (ang. Maximum Error - \( \operatorname{MAXE} \))

| \( \operatorname{MAXE} =\max _i\left|d_i-y_i\right| \) | (12.6) |

-

błąd maksymalny procentowy (ang. Maximum Percentage Error - \( \operatorname{MAXPE}\))

| \( \operatorname{MAXPE} =\max _i \frac{\left|d_i-y_i\right|}{\left|d_i\right|} \) | (12.7) |

W wielu zastosowaniach ważną rolę odgrywa miara korelacyjna między wartościami estymowanymi i rzeczywistymi zdefiniowana w postaci współczynnika korelacji

-

miara korelacyjna

| \( R=\frac{R_{y d}}{\operatorname{std}(y) \operatorname{std}(d)} \) | (12.8) |

We wzorze tym \( R_{yd} \) oznacza kowariancję między obu ciągami wartości, a \( \operatorname{std}\) jest oznaczeniem odchylenia standardowego. Im większa wartość miary korelacji tym lepsza jest jakość predyktora.

Niezależnie od zastosowanej miary jakości regresji ważnym czynnikiem oceny zastosowanego algorytmu jest porównanie osiągniętych wyników z wynikami predyktora naiwnego. Za najprostszy predyktor naiwny uznaje się ekstrapolator zerowego rzędu, przyjmujący jako prognozę wartość znaną dokładnie (element wektora \( \mathbf{d} \)) z poprzedniego kroku, czyli \( y_i = d_{i-1} \). Ograniczając się do miary \( \operatorname{MAPE} \) błąd naiwnej prognozy będzie wyrażony wzorem

| \( \operatorname{MAPE}_{n p}=\frac{1}{n-1}\left(\sum_{i=2}^n \frac{\left|d_i-d_{i-1}\right|}{\left|d_i\right|}\right) \cdot 100 \% \) | (12.9) |

Różnica między błędem metody naiwnej \( \operatorname{MAPE}_{n p} \) i błędem \( \operatorname{MAPE} \) odpowiadającym badanej (z definicji bardziej złożonej) metodzie

| \( \Delta=\operatorname{MAPE}_{np}-\operatorname{MAPE} \) | (12.10) |

stanowi miarę pozwalająca ocenić i porównać skuteczność zastosowanej metody regresji. Inną miarą oceniającą jakość testowanej metody regresji względem metody naiwnej jest współczynnik Theila [49], porównujący względną wartość błędu średniego badanej metody z odpowiadająca mu wartością błędu prognozy naiwnej. Jest on zdefiniowany wzorem

| \( U=\sqrt{\frac{\sum_{i=1}^{n-1}\left(\frac{y_i-d_i}{d_i}\right)^2}{\sum_{i=1}^{n-1}\left(\frac{d_{i+1}-d_i}{d_i}\right)^2}} \) | (12.11) |

Współczynnik ten jest równy zeru tylko wtedy, gdy zastosowana prognoza jest idealna, czyli gdy \( y_i = d_i \). W przypadku niezgodności regresji i wartości rzeczywistych wartość tego współczynnika staje się równa \( 1 \) tylko wtedy, gdy różnice między wynikami zastosowanej metody regresji i metody naiwnej są równe zeru. Oznacza to, że obie metody stanowią równie dobre podejścia do prognozowania. Jeśli \( U < 1 \) wówczas metoda badana jest lepsza niż podejście naiwne. W przeciwnym przypadku metoda naiwna jest lepsza i nie ma potrzeby stosowania bardziej złożonej metody regresji.

2.2. Metody oceny jakości rozwiązań w zadaniach klasyfikacji

W przypadku klasyfikacji miary jakości klasyfikatora są zdefiniowane na podstawie zgodności estymowanej etykiety klasy z etykietą rzeczywistą (prawdziwą). Najbardziej reprezentatywnym sposobem prezentacji wyników jest tutaj zastosowanie macierzy pomyłek, zwanej również macierzą niezgodności klasowej lub macierzą pomyłek (ang. confusion matrix), w której elementy wierszy reprezentują liczbę wzorców należących do kolejnych klas, a elementy kolumn – liczbę wzorców rozpoznanych przez klasyfikator jako dana klasa [65]. Przykład takiej macierzy dla trzech klas przedstawiono w tabeli 12.1. Elementy diagonalne macierzy reprezentują liczbę poprawnie rozpoznanych wzorców. Każdy element pozadiagonalny macierzy reprezentuje błędne rozpoznanie. Element ij-ty macierzy określa liczbę przypadków klasy i-tej rozpoznanych jako klasa j-ta. Klasa pierwsza jest reprezentowana przez pierwszy wiersz, klasa druga przez drugi a klasa trzecia przez wiersz trzeci.

Tabela 12.1 Przykład prezentacji wyników klasyfikacji wzorców 3 klas w postaci macierzy rozkładu klas

|

|

Klasa 1 |

Klasa 2 |

Klasa 3 |

|

Klasa 1 |

95 |

3 |

12 |

|

Klasa 2 |

8 |

20 |

2 |

|

Klasa 3 |

6 |

0 |

80 |

Przykładowo spośród 110 przypadków klasy pierwszej 95 zostało rozpoznanych poprawnie, 3 rozpoznanych błędnie jako klasa druga a 12 jako klasa trzecia.

12.2.1 Miary jakości klasyfikatora

Na podstawie wyników klasyfikacji przedstawionych w macierzy rozkładu klas można stworzyć wiele różnych wskaźników jakości klasyfikatora. Najbardziej ogólnym wskaźnikiem jest średni błąd względny w którym odnosi się liczbę klasyfikacji błędnych do liczby wszystkich przypadków poddanych badaniu. Błąd ten można zdefiniować na dwa sposoby: błąd średni dla całego zbioru bez uwzględnienia liczebności klas oraz z ich uwzględnieniem. Oznaczając elementy macierzy rozkładu klas przez aij, oba rodzaje błędów można zdefiniować w następujący sposób.

-

Błąd średni bez uwzględnienia liczebności klas

| \( \varepsilon_{w 1}=\frac{\sum_{i \neq j} a_{i j}}{\sum_{i, j} a_{i j}} \) | (12.12) |

-

Błąd średni ważony z uwzględnieniem liczebności klas

| \( \varepsilon_{w 2}=\frac{1}{K} \sum_{i=1}^K \frac{\sum_{j=1, j \neq i}^K a_{i j}}{K_i} \) | (12.13) |

We wzorach tych K oznacza liczbę klas, a \(K_i\) liczbę elementów \(i\)-tej klasy. W przypadku równej liczebności wszystkich klas oba wskaźniki przyjmują identyczne wartości. Przy nierównych populacjach klas wskaźnik drugi jest bardziej wymagający. Przykładowo dla danych z tabeli 12.1 \(\varepsilon_{w1}=31/226=0.137\), podczas gdy \(\varepsilon_{w2}=(15/110+10/30+6/86)/3=0.180\).

Wskaźniki zdefiniowane powyżej nie odzwierciedlają problemów występujących w przypadku dużego niezrównoważenia klas. Przykładowo, jeśli w zbiorze danych 99% danych należy do klasy pierwszej a tylko 1% do klasy drugiej (rzadkiej), wówczas przy pełnym rozpoznaniu klasy pierwszej i zerowej skuteczności rozpoznania klasy rzadkiej średni błąd rozpoznania \( \varepsilon_{w1}=1\% \), co jest rezultatem zwykle satysfakcjonującym z ogólnego punktu widzenia ale zupełnie nie odzwierciedlającym problemu (1% klasy rzadkiej może reprezentować właśnie te przypadki, które chcemy wykryć w populacji przypadków normalnych, np. chorobę nowotworową w grupie badanych pacjentów). Problem oceny klasyfikatora stosowanego do przypadków rzadkich wymaga innego podejścia do definicji miar jakości, gdyż przypomina szukanie igły w stogu siana.

Rozpatrzmy przypadek klasyfikacji danych należących do dwu klas. Klasę rzadką oznaczymy symbolem + a większościową symbolem –. W takim przypadku macierz rozkładu klasowego może być przedstawiona w postaci jak w tabeli 12.2 [49,65].

Tabela 12.2 Oznaczenia stosowane w macierzy rozkładu klas (+ oznacza klasę rzadką, natomiast – klasę większościową, reprezentującą pozostałe przypadki)

|

|

Klasa + |

Klasa – |

|

Klasa + |

a++ (TP) |

a+– (FN) |

|

Klasa – |

a–+ (FP) |

a– – (TN) |

Element a++ macierzy oznacza liczbę prawdziwie rozpoznanych przypadków rzadkich (ang. True Positive – TP), element a+– oznacza liczbę przypadków rzadkich rozpoznanych jako większościowe (ang. False Negative – FN), element a–+ oznacza liczbę przypadków większościowych rozpoznanych jako rzadkie (ang. False Positive – FP), a element a– – oznacza liczbę prawdziwie rozpoznanych przypadków większościowych (ang. True Negative – TN). Na bazie tych oznaczeń definiuje się szereg wskaźników jakości szerzej naświetlających problem klasyfikacji w przypadku klas rzadkich [45]. Pierwszym z nich jest czułość oznaczana zwykle symbolem TPR (ang. True Positive Rate), definiowana jako stosunek liczby poprawnie rozpoznanych przypadków rzadkich do liczby wszystkich przypadków rzadkich

| \( TPR = \frac{TP}{TP+FN} \) |

(12.14) |

Drugim ważnym parametrem jest specyficzność oznaczana symbolem TNR (ang. True Negative Rate), definiowana jako stosunek liczby poprawnie rozpoznanych przypadków większościowych do liczby wszystkich przypadków większościowych

| \( TNR = \frac{TN}{TN+FP} \) | (12.15) |

Inną miarą jest wskaźnik rozpoznań fałszywie pozytywnych oznaczany symbolem FPR (ang. False Positive Rate) zdefiniowany jako stosunek liczby przypadków większościowych sklasyfikowanych jako rzadkie do liczby wszystkich przypadków większościowych

| \( FPR = \frac{FP}{TN+FP} \) | (12.16) |

Miara ta jest znana również jako wskaźnik fałszywych alarmów FA (ang. False Alarm), określający względny udział błędnych kwalifikacji przypadków większościowych jako rzadkie (np. uznanie pacjenta zdrowego za chorego). Wskaźnik ten jest ściśle powiązany ze specyficznością TNR

| \( FA=FPR=\frac{FP}{FP+TN}=1-TNR \) | (12.17) |

Analogicznie definiuje się wskaźnik rozpoznań fałszywie negatywnych (szczególnie niebezpiecznych) oznaczany symbolem FNR (ang. False Negative Rate). Jest on zdefiniowany jako stosunek liczby przypadków rzadkich sklasyfikowanych jako większościowe do liczby wszystkich przypadków rzadkich

| \( FNR = \frac{FN}{TP+FN} \) | (12.18) |

Dwa dodatkowe wskaźniki definiują wartości prognostyczne metody. Dodatnia wartość prognostyczna PPV reprezentująca precyzję rozpoznawania przypadków rzadkich (ang. Positive Predictivity Value) określa jaka część przypadków zdiagnozowanych jako rzadkie (TP) jest rzeczywiście rzadka (percepcja rozpoznawania klasy rzadkiej)

| \( PPV = \frac{TP}{TP+FP} \) | (12.19) |

Ujemna wartość prognostyczna NPV (ang. Negative Predictivity Value) określa jaka część przypadków zdiagnozowanych jako większościowa (TN) jest rzeczywiście większościowa (percepcja rozpoznawania klasy większościowej)

| \( NPV = \frac{TN}{TN+FN} \) | (12.20) |

Ważną praktycznie miarą jakości systemu klasyfikacyjnego jest precyzja klasowa klasyfikatora. Jest ona definiowana jako stosunek prawdziwej liczby rozpoznanych przypadków danej klasy do wszystkich przypadków rozpoznanych przez klasyfikator jako dana klasa. Miara ta dotyczy każdej klasy, w tym większościowej i rzadkiej, oznaczonych jako PPV i NPV

Inną miarą uniwersalną systemu klasyfikacyjnego jest F1. Definiowana jest dla każdej klasy oddzielnie na podstawie precyzji oraz czułości klasowej. Oznaczając precyzję rozpoznania klasy k-tej przez \(\operatorname{Prec}(k)\) i czułość rozpoznania klasy przez \(\operatorname{Sens}(k) \) miara \( \operatorname{F1}(k) \) jest zdefiniowana w postaci

| \( \operatorname{F1}(k)=\frac{\operatorname{Prec}(k) * \operatorname{Sens}(k)}{0.5(\operatorname{Prec}(k)+\operatorname{Sens}(k))} \) | 12.21 |

Średnia dokładność prognozy ACC (ang. ACCuracy) określająca procent dobrze sklasyfikowanych przypadków może być zdefiniowana wzorem

| \( AC=\frac{TP+TN}{TP+TN+FP+FN} \) | (12.22) |

Oznacza ona liczbę prawidłowo sklasyfikowanych przypadków (rzadkich i większościowych) odniesioną do liczby wszystkich przypadków poddanych klasyfikacji. Miara ta jest ściśle związana ze średnim błędem względnym \(\varepsilon_{w1}\) zdefiniowanym wcześniej (zależność 12.12)

| \( \varepsilon_{w 1}=1-ACC=\frac{FP+FN}{TP+TN+FP+FN} \) | (12.23) |

Przedstawione powyżej miary jakości charakteryzują klasyfikator z różnych punktów widzenia. Maksymalizacja jednego wskaźnika jest często sprzężona z pogorszeniem innego.

W przypadku większej liczby klas przyjmuje się porównanie wybranej klasy z pozostałymi traktowanymi jako grupa wspólna (klasa zbiorowa). W ten sposób problem oceny sprowadza się do zadania 2-klasowego.

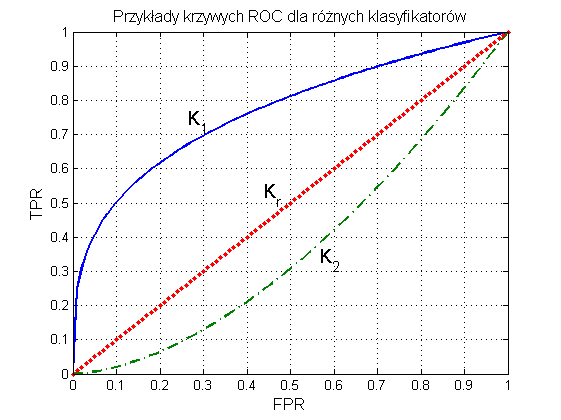

12.2.2 Charakterystyka ROC

Ważnym elementem oceny klasyfikatora jest porównanie jego działania z klasyfikatorem losowym [49,65]. Porównanie takie umożliwia reprezentacja graficzna wyników w postaci charakterystyki ROC (ang. Receiver Operating Characteristics). Krzywa ROC przedstawia relację między miarą TPR (oś pionowa y) a miarą FPR (oś pozioma x). Każdy punkt krzywej odpowiada innemu doborowi parametrów modelu klasyfikatora. Dwa typy możliwych przebiegów krzywej ROC dla klasyfikatorów K1 oraz K2 w porównaniu z klasyfikatorem losowym Kr (klasyfikacja poprzez losowanie) przedstawione są na rys. 12.1.

W krzywej ROC można wyróżnić kilka istotnych punktów [65].

-

(TPR=0, FPR=0) – klasyfikator kwalifikuje każdy przykład jako klasę większościową

-

(TPR=1, FPR=1) – klasyfikator kwalifikuje każdy przykład jako klasę rzadką

-

(TPR=1, FPR=0) – model idealny, rozpoznający bezbłędnie wszystkie przypadki

-

punkty (TPR, FPR) położone na prostej diagonalnej oznaczają klasyfikację całkowicie losową.

Dobry klasyfikator powinien mieć krzywą ROC położoną tak blisko jak to możliwe lewego górnego punktu o współrzędnych (0, 1). Miara jakości klasyfikatora może być oceniana na podstawie pola powierzchni SROC pod krzywą ROC. Pole powierzchni SROC=1 oznacza klasyfikator idealny. Wartość pola SROC=0.5 oznacza klasyfikację losową (rozwiązanie klasyfikatora bezsensowne). Im SROC jest bliższe jedności, tym lepsza jest ocena takiego rozwiązania modelu klasyfikacyjnego. Miara nosi popularną nazwę AUC (Area Under Curve).

Aby utworzyć krzywą ROC należy dysponować sygnałem wyjściowym klasyfikatora w postaci ciągłej (przed binaryzacją). Może to być aktualna wartość prawdopodobieństwa w klasyfikatorze Bayes’a, bezpośrednia wartość funkcji sigmoidalnej w klasyfikatorze MLP, wartość sumy wagowej neuronu wyjściowego sieci RBF czy wartość ciągła y(x) wytworzona w klasyfikatorze SVM. Procedurę tworzenia krzywej ROC można przedstawić w następujących punktach.

-

Ustaw wyniki klasyfikacji (rekordy danych testowych) w kolejności rosnącej (od najmniejszego do największego) sygnału wyjściowego klasyfikatora.

-

Wyselekcjonuj rekord o najmniejszej wartości sygnału. Sklasyfikuj wybrany rekord i wszystkie powyżej niego jako klasę rzadką (oznaczenie +). To oznacza w rzeczywistości przyjęcie, że wszystkie rekordy danych należą do klasy rzadkiej.

-

Przesuń się o jeden rekord w górę i sklasyfikuj wybrany rekord oraz wszystkie powyżej niego jako klasę rzadką, natomiast wszystkie poniżej niego jako klasę większościową (oznaczenie –). Dla każdego przypadku określ miary jakości w postaci wskaźników TP, FP, TN, FN, a następnie TPR oraz FPR.

-

Powtórz krok 3 dla wszystkich kolejnych rekordów, określając wartości wymienionych wyżej miar jakości.

-

Wykreśl otrzymaną zależność TPR=f(FPR), stanowiąca krzywą ROC.

-

Wyznacz pole powierzchni AUC pod krzywą ROC.

Charakterystyka ROC pozwala w prosty sposób porównać rozwiązania różnych rozwiązań systemu klasyfikacyjnego 2 klas. Istotna jest przy tym wartość pola pod krzywą ROC, tzw. AUC. Jest ona zawsze z przedziału [ 0, 1]. Im wyższa wartość AUC, tym lepsze jest rozwiązanie.

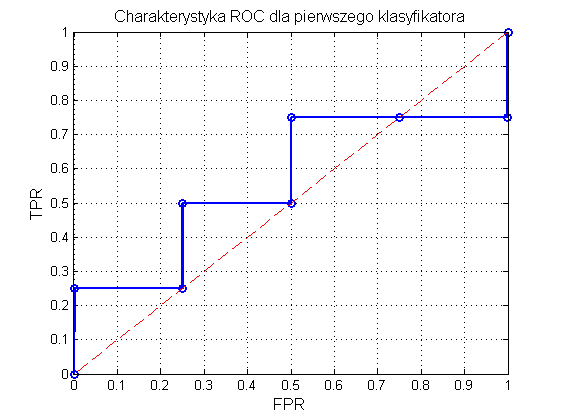

Procedurę wyznaczania krzywej ROC zilustrujemy przykładem dla wyników dwu różnych klasyfikatorów.

W pierwszym przypadku wyniki działania modelu na danych testujących przedstawiono w tabeli 12.3, w której wiersz pierwszy oznacza prawdziwą przynależność do klasy, a wiersz drugi sygnał wyjściowy klasyfikatora (przed poddaniem działaniu funkcji dyskryminującej klas).

Tabela 12.3 Wyniki testowania klasyfikatora pierwszego

|

Klasa |

+ |

– |

– |

+ |

– |

+ |

– |

+ |

|

Sygnał wyjściowy |

0.1 |

0.2 |

0.3 |

0.4 |

0.6 |

0.8 |

0.9 |

1.0 |

Stosując procedurę tworzenia charakterystyki ROC otrzymuje się wyniki przedstawione w tabeli 12.4.

Tabela 12.4 Ilustracja kolejnych etapów tworzenia charakterystyki ROC dla klasyfikatora pierwszego

|

Klasa |

+ |

– |

– |

+ |

– |

+ |

– |

+ |

|

Sygnał wyjściowy |

0.1 |

0.2 |

0.3 |

0.4 |

0.6 |

0.8 |

0.9 |

1.0 |

|

TP |

4 |

3 |

3 |

3 |

2 |

2 |

1 |

1 |

|

FP |

4 |

4 |

3 |

2 |

2 |

1 |

1 |

0 |

|

TN |

0 |

0 |

1 |

2 |

2 |

3 |

3 |

4 |

|

FN |

0 |

1 |

1 |

1 |

2 |

2 |

3 |

3 |

|

TPR |

1 |

3/4 |

3/4 |

3/4 |

2/4 |

2/4 |

1/4 |

1/4 |

|

FPR |

1 |

1 |

3/4 |

2/4 |

2/4 |

1/4 |

1/4 |

0 |

Na rys. 12.2 przedstawiono graficzną postać charakterystyki ROC. Pole powierzchni pod krzywą AUC=SROC wynosi 0.56. Jakość klasyfikatora jest więc jedynie nieznacznie lepsza od klasyfikatora losowego dla którego to pole wynosi 0.5. Jest to również uwidocznione na rysunku, gdzie prosta przerywana oznacza ROC dla klasyfikatora losowego.

Rys. 12.2 Charakterystyka ROC klasyfikatora z przykładu pierwszego

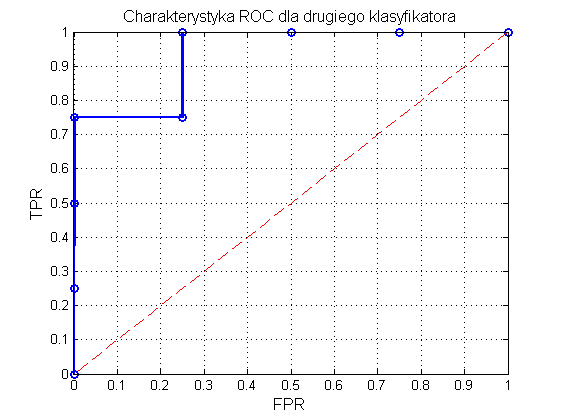

Dla porównania w tabeli 12.5 przedstawiono wyniki klasyfikacji innego klasyfikatora oraz obliczenia dotyczące miar jakości służące do wyznaczenia krzywej ROC.

Tabela 12.5 Ilustracja kolejnych etapów tworzenia charakterystyki ROC dla klasyfikatora drugiego

|

Klasa |

– |

– |

– |

+ |

– |

+ |

+ |

+ |

|

Sygnał wyjściowy |

0.1 |

0.3 |

0.4 |

0.5 |

0.7 |

0.8 |

0.9 |

1.0 |

|

TP |

4 |

4 |

4 |

4 |

3 |

3 |

2 |

1 |

|

FP |

4 |

3 |

2 |

1 |

1 |

0 |

0 |

0 |

|

TN |

0 |

1 |

2 |

3 |

3 |

4 |

4 |

4 |

|

FN |

0 |

0 |

0 |

0 |

1 |

1 |

2 |

3 |

|

TPR |

1 |

1 |

1 |

1 |

3/4 |

3/4 |

2/4 |

1/4 |

|

FPR |

1 |

3/4 |

2/4 |

1/4 |

1/4 |

0 |

0 |

0 |

Na rys. 12.3 przedstawiono graficzną postać charakterystyki ROC odpowiadającej wynikom zawartym w tabeli 12.4. Pole powierzchni pod krzywą AUC=SROC wynosi tym razem 0.94, a więc jest bliskie jedności. Jakość klasyfikatora jest zdecydowanie lepsza od klasyfikatora losowego.

Program Matlab zawiera gotowe funkcje do wykreślania charakterystyki ROC i obliczania wartości AUC. Przykład takiego programu dla danych zawartych w tabeli podany jest poniżej.

Tabela 12.6 Dane do utworzenia krzywej ROC i obliczenia wartości AUC

|

Klasa |

– |

– |

+ |

– |

+ |

+ |

+ |

+ |

– |

+ |

+ |

|

Sygnał wyjściowy |

0.1 |

0.2 |

0.3 |

0.35 |

0.45 |

0.5 |

0.6 |

0.7 |

0.8 |

0.9 |

1 |

y=[0.1 0.2 0.3 0.35 0.45 0.5 0.6 0.7 0.8 0.9 1]

d=[0 0 1 0 1 1 1 1 0 1 1]

[tpr,fpr,th]=roc(d,y);

figure(1), plot(fpr,tpr)

grid, xlabel('FPR'),ylabel('TPR'), title ('ROC')

[X,Y,T,AUC] = perfcurve(d,y,1)

figure(2), plotroc(d,y), grid

W wyniku uzyskuje się AUC=0.7857.

2.3. Metody poprawy jakości klasyfikatora

Dla uzyskania poprawy jakości rozwiązania klasyfikatora rozpoznającego dwie klasy o niezrównoważonej liczebności można stosować różne metody. Do najbardziej znanych należy zróżnicowanie kosztu błędnych klasyfikacji odpowiadających różnym rodzajom błędu, metody równoważenia klas, specjalne metody kodowania klas, czy stosowanie zespołu klasyfikatorów omówione w rozdziale poprzednim.

12.3.1 Metoda różnicowania kosztu błędnej klasyfikacji

Dla uzyskania lepszych miar jakości przy rozpoznawaniu elementów klasy rzadkiej można zastosować w uczeniu funkcję kary uwzględniającą koszt złego rozpoznania elementów tej klasy [58]. Niech \(K_{ij}\) oznacza koszt związany z błędnym rozpoznaniem przez model klasyfikatora klasy \(i\)-tej jako klasa \(j\)-ta. Jednocześnie można nagradzać klasyfikator za poprawną klasyfikację poprzez przyjęcie wartości ujemnej wagi dla kosztu \(K_{ij}\). Przy oznaczeniu klasy rzadkiej symbolem \(+\) a klasy większościowej symbolem \(–\) i uwzględnieniu przyjętych oznaczeń jak w tabeli 12.2 całkowity koszt klasyfikacji przy użyciu modelu M można wyrazić wzorem [65]

| \( K_c(M)=TP \times K_{TP}+FP \times K_{FP}+FN \times K_{FN}+TN \times K_{TN} \) | (12.24) |

Zauważmy, że przyjęcie standardowych wartości \(K_{TP}=K_{TN}=0\) oraz \(K_{FP}=K_{FN}=1\) oznacza klasyczne podejście do oceny jakości (równa kara za oba rodzaje błędów i brak nagrody za poprawną klasyfikację), gdyż

| \( K_c(M)=(TP+TN) \times 0+(FN+FP) \times 1=FN+FP \) | (12.25) |

Funkcja kary jest w tym przypadku równa liczbie błędnych klasyfikacji. Dla zilustrowania wpływu doboru wartości wag elementów kosztu na ocenę modelu klasyfikatora przyjmijmy wartości tych wag jak niżej:

\(K_{TP}=0\)

\(K_{FP}=1\)

\(K_{FN}=100\)

\(K_{TN}=0\)

W przyjętej definicji funkcji kary zakwalifikowanie błędne klasy rzadkiej do większościowej jest karane 100-krotnie bardziej niż przypadek fałszywego alarmu (zakwalifikowanie rekordu należącego do klasy większościowej jako rekordu klasy rzadkiej).

Rozważmy dla porównania dwa przypadki wyników odpowiadające dwu modelom klasyfikatora \(M_1\) oraz \(M_2\) jak przedstawiono w tabelach 12.7 oraz 12.8.

Tabela 12.7 Wyniki klasyfikacji przy użyciu modelu \(M_1\)

|

Model M1 |

Klasa + |

Klasa – |

|

Klasa + |

200 (TP) |

60 (FN) |

|

Klasa – |

50 (FP) |

300 (TN) |

Tabela 12.8 Wyniki klasyfikacji przy użyciu modelu \(M_2\)

|

Model M2 |

Klasa + |

Klasa – |

|

Klasa + |

180 (TP) |

80 (FN) |

|

Klasa – |

5 (FP) |

345 (TN) |

W przypadku klasycznej definicji kosztów klasyfikacji (oba rodzaje błędów traktowane z jednakową wagą równą 1) otrzymuje się

\( K_c\left(\mathrm{M}_1\right)=200 \times 0+60 \times 1+50 \times 1+300 \times 0=110 \)

\( K_c\left(\mathrm{M}_2\right)=180 \times 0+80 \times 1+5 \times 1+345 \times 0=85 \)

Lepszym klasyfikatorem jest tutaj model \(M_2\), gdyż jego funkcja kosztu jest mniejsza.

Koszty całkowite w przypadku przyjętego różnicowania wag błędnych klasyfikacji wynoszą

\( K_c\left(\mathrm{M}_1\right)=200 \times 0+100 \times 60+50 \times 1+300 \times 0=6050 \)

\( K_c\left(\mathrm{M}_2\right)=180 \times 0+80 \times 100+5 \times 1+345 \times 0=8005 \)

Tym razem lepszym klasyfikatorem okazał się model \(M_1\), gdyż wartość kosztu klasyfikacji z nim skojarzona jest mniejsza.

Zmodyfikowana metoda obliczania kosztu błędnej klasyfikacji może posłużyć odpowiedniemu zaprojektowaniu klasyfikatora. Jako funkcję celu w uczeniu definiować można nie liczbę wszystkich błędnych klasyfikacji traktowanych jednakowo (podejście klasyczne), ale z odpowiednimi mnożnikami za poszczególne rodzaje błędów które zmuszą klasyfikator do odpowiedniego ukształtowania granic przynależności do obu klas. W wyniku takiego podejścia próg przynależności do obu klas ulega takiemu przesunięciu, aby kosztem zwiększenia liczby fałszywych alarmów zmniejszyć liczbę błędnego rozpoznania elementów klasy rzadkiej.

12.3.2 Metody równoważenia klas

Inną metodą pozwalającą na polepszenie jakości klasyfikacji w przypadku dwu klas niezrównoważonych jest próba poprawy stopnia zrównoważenia poprzez zastosowanie odpowiedniego próbkowania [24,49,65]. W wyniku takiego podejścia względna reprezentacja klasy rzadkiej powinna zostać wzbogacona w stosunku do klasy większościowej. W praktycznym rozwiązaniu tego problemu stosuje się zarówno zmniejszanie liczebności klasy większościowej użytej w uczeniu jak i zwiększanie liczby reprezentantów klasy rzadkiej.

Najprostszym rozwiązaniem jest zredukowanie liczby danych uczących klasy większościowej do poziomu reprezentowanego przez klasę rzadką. Powstaje wówczas problem doboru próbek uwzględnionych w uczeniu. Jednym z rozwiązań jest stworzenie wielu klasyfikatorów, z których każdy trenowany jest na pełnym zbiorze próbek rzadkich i wybranym podzbiorze (innym dla każdego klasyfikatora) próbek większościowych. Na przykład, jeśli klasa rzadka jest reprezentowana przez 100 próbek uczących, a większościowa przez 1000, można wytrenować 10 klasyfikatorów, każdy na innym podzbiorze klasy większościowej. W następnym etapie tworzy się zespół klasyfikatorów a wynik końcowy może być otrzymany na zasadzie głosowania większościowego (ang. majority voting).

Innym rozwiązaniem, które nadaje się do zastosowań w pewnych przypadkach (np. dane wejściowe dwuwymiarowe, dane wielowymiarowe zrzutowane na płaszczyznę bądź w przestrzeń trójwymiarową) jest wizualizacja rozkładu danych obu klas. Bez utraty zdolności generalizacyjnych można odrzucić te próbki większościowe, które położone są daleko od przewidywanej granicy obu klas. W zbiorze uczącym pozostawia się jedynie reprezentatywną liczbę próbek, porównywalną z populacją klasy próbek rzadkich.

W przypadku podejścia drugiego celem jest zwiększenie liczby reprezentantów klasy rzadkiej do poziomu populacji klasy większościowej. Odbywa się to poprzez sztuczne dodawanie do zbioru uczącego dodatkowych próbek klasy rzadkiej na zasadzie interpolacji między oryginalnymi punktami danych. Współrzędne dodawanych punktów tworzy się na zasadzie uśredniania współrzędnych kilku najbliższych sąsiadów należących do tej samej klasy. Innym rozwiązaniem jest dodawanie szumu losowego do współrzędnych istniejących punktów klasy rzadkiej i tworzenie w ten sposób nowych danych klasy rzadkiej. Tego typu podejście wyrównuje liczebność obu klas, ale nie wzbogaca informacji o modelowanym procesie. Zapobiega jedynie obcięciu pojedynczych próbek rzadkich umieszczonych w otoczeniu próbek klasy większościowej.

Najczęściej łączy się oba podejścia, redukując zarówno liczebność klasy większościowej jak i wzbogacając reprezentację klasy rzadkiej. Takie podejście do problemu równoważenia klas jest najbardziej zalecane w praktyce, gdyż w stosunkowo najmniejszym stopniu zaburza oryginalny rozkład danych obu klas.

12.3.3 Problemy klasyfikacji wieloklasowej

Niektóre metody klasyfikacyjne, na przykład SVM są w oryginale zaprojektowane do klasyfikacji binarnej i są w stanie rozróżnić jedynie 2 klasy. Rozróżnianie wielu klas wymaga stosowania specjalnych technik stosujących kombinację klasyfikatorów binarnych. Do najbardziej znanych podejść należy metoda jeden przeciw jednemu i jeden przeciw pozostałym [59,68].

W pierwszej metodzie przy M klasach tworzy się M(M-1)/2 klasyfikatorów binarnych odpowiedzialnych za rozpoznanie kombinacji 2 klas kolejno parowanych ze sobą. Przy podaniu na wejście wszystkich klasyfikatorów wektora testowego x ostatecznym zwycięzcą jest ta klasa, która zostanie wskazana przez większość głosujących.

W metodzie jeden przeciw reszcie przy M klasach konstruuje się M klasyfikatorów, z których każdy trenowany jest do rozróżnienia między pojedynczą klasą a klasą zbiorczą złożoną z pozostałych. Przy podaniu na wejście takiego klasyfikatora wektora testowego x zwycięska klasa (pojedyncza lub wszystkie klasy zbiorowe tworzące resztę) jest nagradzana głosem. Klasa która otrzyma najwięcej głosów jest uważana za zwycięzcę.

Zdecydowana większość rozwiązań klasyfikatorów umożliwia rozróżnienie wielu klas jednocześnie w jednym układzie klasyfikacyjnym. Wymaga to zdefiniowania wektora etykiet klas (wektor \(\mathbf{d}\)). Najczęściej stosowanym rozwiązaniem jest wówczas zwykłe kodowanie zero-jedynkowe. Etykieta klasy do której należy wektor \(\mathbf{x}\) jest kodowana poprzez wartość 1, a pozostałe klasy przez zero. Wzorzec testowany \(\mathbf{x}\) należy do klasy, na którą wskazuje jedynka, przy czym wartość 1 przypisuje się neuronowi o największej wartości sygnału wyjściowego. Pozostałe neurony przyjmują zerową wartość sygnału wyjściowego. Przy takim rozwiązaniu liczba neuronów wyjściowych klasyfikatora jest równa liczbie klas.

Przykładowo przy zwykłym (pojedynczym) kodowaniu zero-jedynkowym czterech klas można je przyporządkować przy użyciu kodu przedstawionego w tabeli 12.9

Tabela 12.9 Przykład zwykłego kodowania zero-jedynkowego binarnego czterech klas

|

Klasa |

Kod klasy |

|

Klasa 1 |

1000 |

|

Klasa 2 |

0100 |

|

Klasa 3 |

0010 |

|

Klasa 4 |

0001 |

Należy zauważyć, że na etapie odtwarzania może powstać problem interpretacji binarnej wyniku rzeczywisto-liczbowego generowanego zwykle przez klasyfikator. Najczęściej wyjściu klasyfikatora o największym sygnale przypisuje się wartość 1 a pozostałym wyjściom zero. Problemem może być podobna wartość dwu lub więcej sygnałów lub ich bardzo mały (zbliżony do zera) poziom wartości. W takich przypadkach wiarygodność wyniku klasyfikacji opartej na jednej wartości jedynkowej jest stosunkowo mała.

Innym rodzajem kodowania zero-jedynkowego jest tak zwane kodowanie rozproszone, w którym liczba jedynek użyta w kodowaniu klasy może być dowolna. Oznacza to, że liczba neuronów wyjściowych w takim klasyfikatorze może być różna od liczby klas. Po określeniu sygnałów wyjściowych \(y_i\) poszczególnych neuronów i zaokrągleniu ich wartości do zera (gdy \(y < 0.5 \)) lub jedynki (gdy \(y > 0.5 \)) porównuje się wektor wyjściowy \(\mathbf{y}\) z wektorami kodowymi klas obliczając odległość Hamminga (odległość ta jest sumą różnic między poszczególnymi składowymi obu wektorów binarnych). Wzorzec przypisuje się do klasy dla której ta odległość jest najmniejsza. Przykład takiego kodowania dla czterech klas przy użyciu 5 neuronów wyjściowych przedstawiono w tabeli 12.10.

Tabela 12.10 Przykład kodowania zero-jedynkowego rozproszonego czterech klas

|

Klasa |

Kod klasy |

|

Klasa 1 |

00000 |

|

Klasa 2 |

00111 |

|

Klasa 3 |

11001 |

|

Klasa 4 |

11110 |

Zaletą kodowania rozproszonego jest mniejsza wrażliwość układu na wszelkiego rodzaju niedokładności klasyfikatora spowodowane szumem, zwłaszcza w przypadku, gdy sygnały wyjściowe neuronów są bliskie sobie i przypisanie jedynki największemu z nich może rodzić pewne wątpliwości.

2.4. Obiektywna ocena zdolności generalizacyjnych systemu

12.4 Obiektywna ocena zdolności generalizacyjnych systemu

Rozwiązując w sposób maszynowy problem klasyfikacji lub regresji należy podzielić dostępny zbiór danych na podzbiór uczący, na którym dobierane są optymalne wartości parametrów układu oraz podzbiór testujący (weryfikujący) nie uczestniczący w uczeniu a służący sprawdzaniu zdolności generalizacyjnych wytrenowanego układu. Z punktu widzenia użytkownika najważniejsze są wyniki testowania (weryfikacji), gdyż one ilustrują przyszłe zachowanie się systemu na danych rzeczywistych uzyskanych on-line w badanym procesie.

Zwykle zbiór dostępnych danych dzieli się w proporcji zbliżonej do 2:1 lub 3:1, w której większa część służy do uczenia a pozostała do testowania systemu. Podział danych jest najczęściej losowy (np. przy użyciu funkcji randperm Matlaba). Wiąże się z tym problem losowości uzyskanych wyników testowania. Jednokrotny test może nie być reprezentatywny dla zwykłego działania systemu i przyjęcie jego wyników jako obiektywnych nie jest uzasadnione.

Zalecane jest wielokrotne powtórzenie procesu uczenia i testowania przy innym zestawie danych uczących i testujących. Wynik takiego testu jest średnią z wyników poszczególnych prób. W praktycznej implementacji tego podejścia są stosowane różne metody. Jedną z najczęściej stosowanych jest k-krotna walidacja krzyżowa (ang. k-cross validation) [46,65]. Dostępny zbiór danych dzieli się na k części (często k jest równe 10), spośród których (k-1) jest użyte w uczeniu a jedna część pozostawiona do testowania. Próby uczenia i testowania przeprowadza się k razy zmieniając za każdym razem podzbiór testujący. Wynik ostateczny testu jest średnią ze wszystkich k eksperymentów.

Tego typu podejście jest trudne do przeprowadzenia przy bardzo małej liczbie danych, gdyż powoduje nadmierne zubożenie danych uczących. W takim przypadku polecaną metodą jest zastosowanie strategii leave-one-out, w której zbiór testujący zawiera tylko jedną daną, pozostałe służą uczeniu. Proces uczenia i testowania powtarza się tyle razy ile jest danych, za każdym razem zmieniając daną testującą.

Innym możliwą odmianą strategii walidacji krzyżowej jest losowanie wielokrotne danych uczących i testujących z pełnego zbioru. Każda próba uczenia i testowania poprzedzona jest losowaniem zbioru uczącego i testującego ze zbioru pełnego. Proporcje danych uczących i testujących mogą być przy tym dowolne, ustalane przez projektanta systemu, najczęściej w proporcji 2:1. Wynik końcowej oceny jest średnią ze wszystkich prób. W tym rozwiązaniu część danych testujących powtarza się wprawdzie z próby na próbę, ale przy dużej liczbie przeprowadzonych prób nie ma to istotnego znaczenia w obiektywnej ocenie rozwiązania.

2.5. Zadania i problemy

1. Zaproponować schemat kodowania zero-jedynkowego rozproszonego do rozpoznaniania 5 klas.

2. Porównać miary jakości 2 modeli: M1 i M2 przy standardowej definicji funkcji kosztu oraz funkcji różnicującej przypadki FN i FP. Przyjąć przy tym współczynniki KFP=1 i KFN=200. Macierze rozkładu klas są jak poniżej.

|

Model M1 |

Klasa + |

Klasa – |

|

Klasa + |

500 (TP) |

50 (FN) |

|

Klasa – |

50 (FP) |

1000 (TN) |

|

Model M2 |

Klasa + |

Klasa – |

|

Klasa + |

525 (TP) |

25 (FN) |

|

Klasa – |

250 (FP) |

800 (TN) |

3. Narysować krzywą ROC dla klasyfikatora o wynikach

|

Klasa |

+ |

– |

+ |

+ |

- |

– |

+ |

+ |

- |

+ |

|

Sygnał wyjściowy |

0.1 |

0.2 |

0.3 |

0.4 |

0.5 |

0.6 |

0.8 |

0.9 |

0.95 |

1.0 |

Określić wartość AUC.

4.Macierz rozkładu klas jest dana w postaci

\( \mathbf{R}=\left[\begin{array}{cccc}

100 & 8 & 10 & 2 \\

3 & 150 & 0 & 7 \\

30 & 50 & 200 & 20 \\

7 & 3 & 90 & 500

\end{array}\right] \)

Określić następujące miary jakości: dokładność, precyzje klasowe oraz czułości rozpoznania poszczególnych klas.

5. Wyniki regresji uzyskane przez sieć neuronową ( y ) oraz wartości rzeczywiste procesu ( d ) podane są w tablicy poniżej

|

d |

1 |

2 |

3 |

4 |

5 |

6 |

7 |

8 |

9 |

10 |

11 |

12 |

13 |

14 |

15 |

|

y |

0.87 |

2.3 |

3.2 |

3.9 |

5.1 |

6.5 |

7.5 |

7.8 |

8.5 |

10.1 |

11.6 |

12.7 |

12.9 |

14.8 |

13.9 |

Narysować rozkład obu wartości na wspólnym wykresie oraz rozkład błędów. Wyznaczyć wartości miar jakości: MAPE, RMSE oraz miarę korelacyjną.

2.6. Słownik

Słownik opanowanych pojęć

Chwilowy błąd estymacji – różnica między wartością estymowaną a wartością dokładną mierzonej wielkości.

Miara jakości rozwiązania – przyjęty sposób oceny jakości wyników działania systemu w stosunku do wartości rzeczywistych.

MAE – błąd średni absolutny (ang. Mean Absolute Error).

MAPE – średni błąd względny absolutny (ang. Mean Absolute Percentage Error).

RMSE – średni błąd kwadratowy (ang. Root Mean Squared Error).

MAXE – maksymalny błąd bezwzględny (ang. Maximum Error )

MAXPE –względny (procentowy) błąd maksymalny (ang. Maximum Percentage Error - MAXPE)

Miara korelacyjna – miara uwzględniająca korelację wyników wyjściowych z wartościami rzeczywistymi.

Współczynnik Theila – współczynnik porównujący względną wartość błędu średniego badanej metody z odpowiadającą mu wartością błędu prognozy naiwnej.

Macierz niezgodności klasowej – macierz prezentująca wyniki rozpoznania klas na tle wartości prawdziwych (macierz pomyłek).

Klasa rzadka – klasa reprezentowana przez małą liczbę obserwacji.

Klasa większościowa – klasa reprezentowana przez dominującą liczbę obserwacji.

TP – (ang. True Positive) oznacza przypadki prawdziwie pozytywne w rozpoznaniu pożądanej (rzadkiej) klasy (traktowanej jako pozytywna).

TN – (ang. True Negative) oznacza przypadki prawdziwie negatywne w rozpoznaniu klasy przeciwnej (traktowanej jako negatywna) .

FP – (ang. False Positive) oznacza przypadki prawdziwie negatywne rozpoznane jako klasa rzadka.

FN – (ang. False Negative) oznacza przypadki prawdziwie pozytywne (rzadkie) rozpoznane jako klasa większościowa.

TPR – (ang. True Positive Rate) oznacza stosunek liczby poprawnie rozpoznanych przypadków rzadkich do liczby wszystkich przypadków rzadkich – wielkość traktowana jako czułość klasowa.

TNR – (ang. True Negative Rate) oznacza stosunek liczby poprawnie rozpoznanych przypadków większościowych do liczby wszystkich przypadków większościowych – wielkość zwana również specyficznością.

FPR – (ang. False Positive Rate) zdefiniowany jako stosunek liczby przypadków większościowych sklasyfikowanych jako rzadkie do liczby wszystkich przypadków większościowych.

FNR – (ang. False Negative Rate) zdefiniowany jako stosunek liczby przypadków rzadkich sklasyfikowanych jako większościowe do liczby wszystkich przypadków rzadkich.

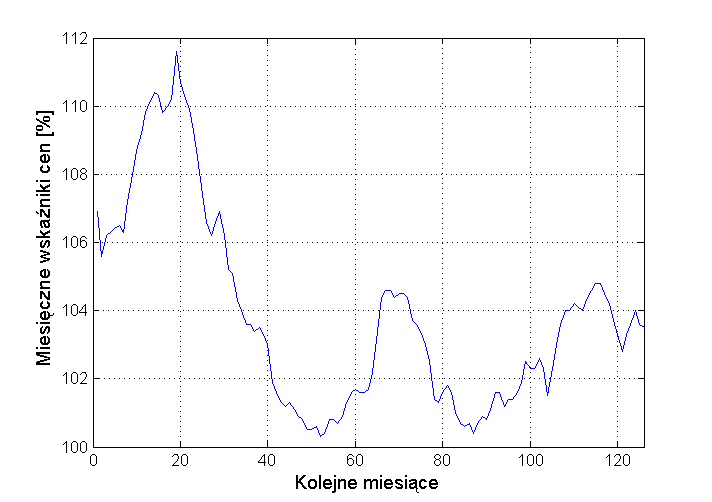

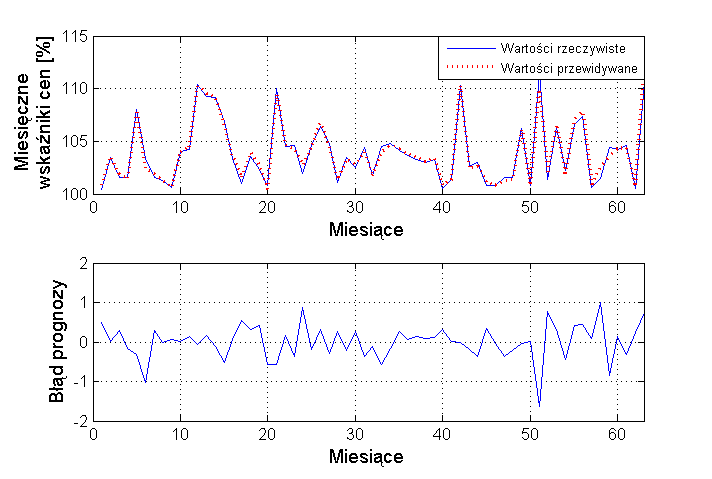

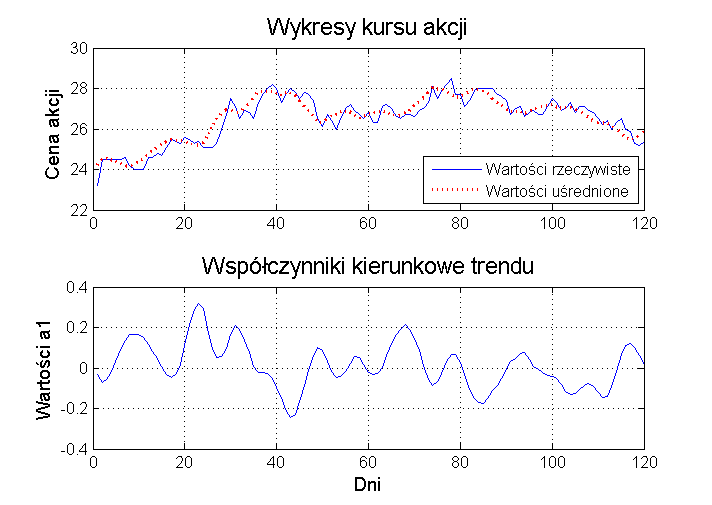

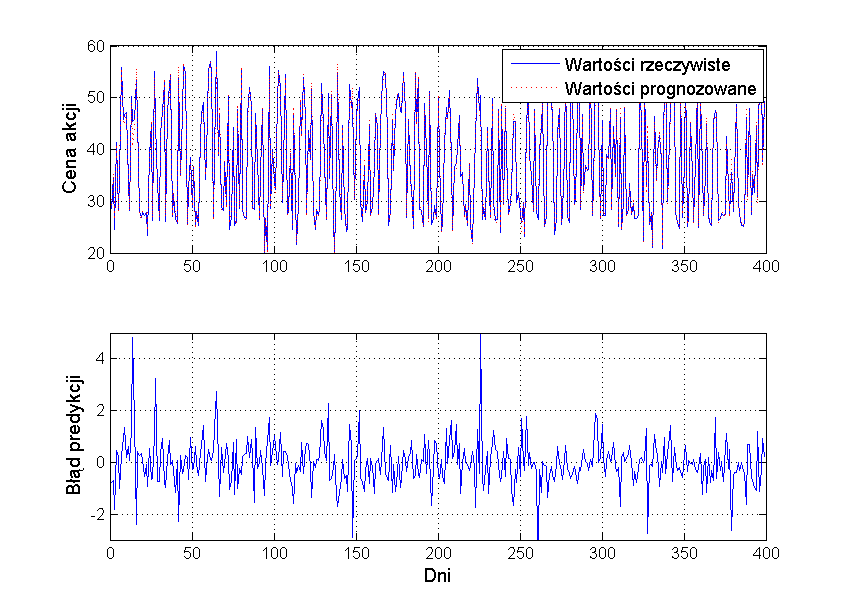

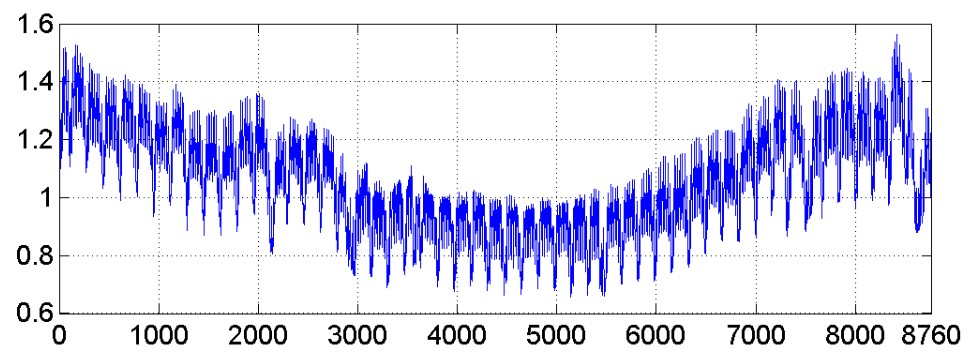

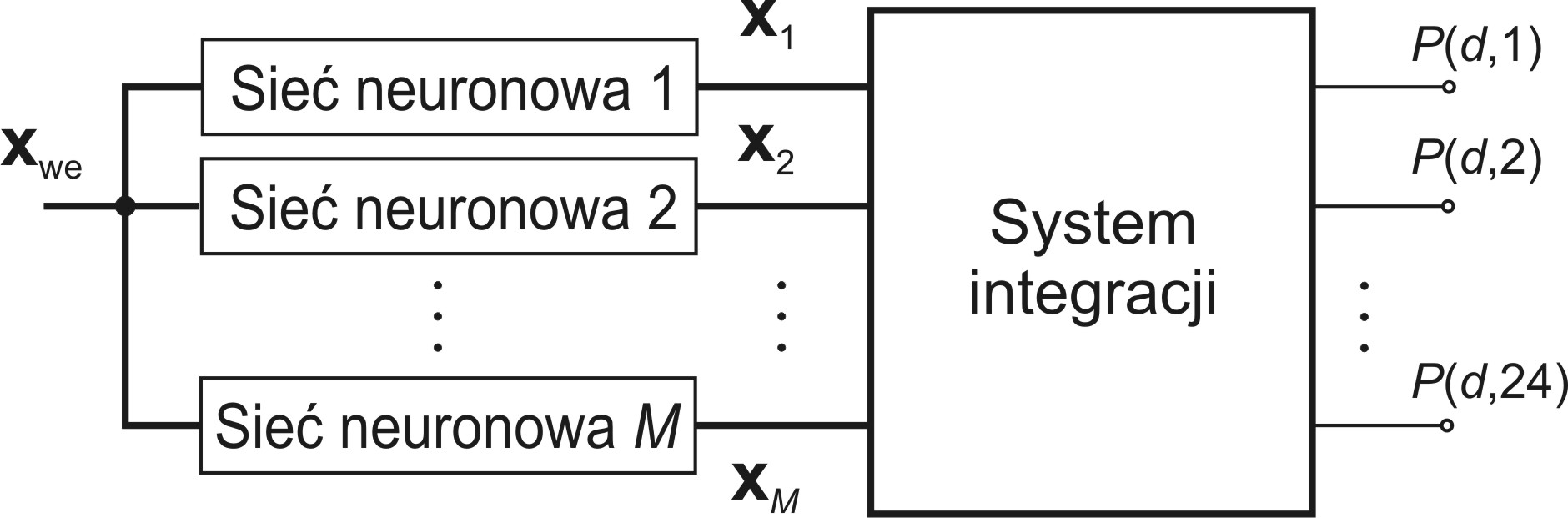

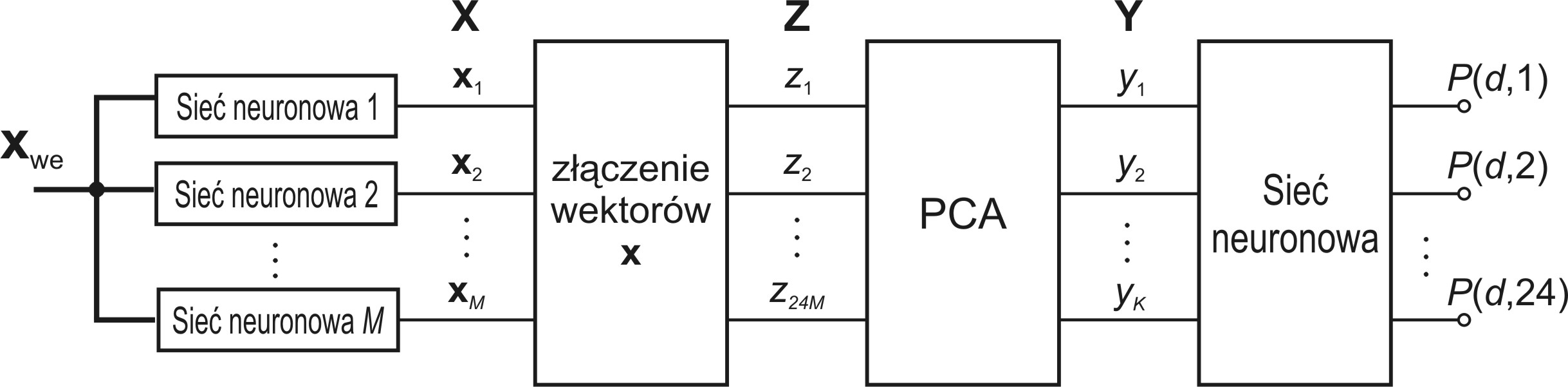

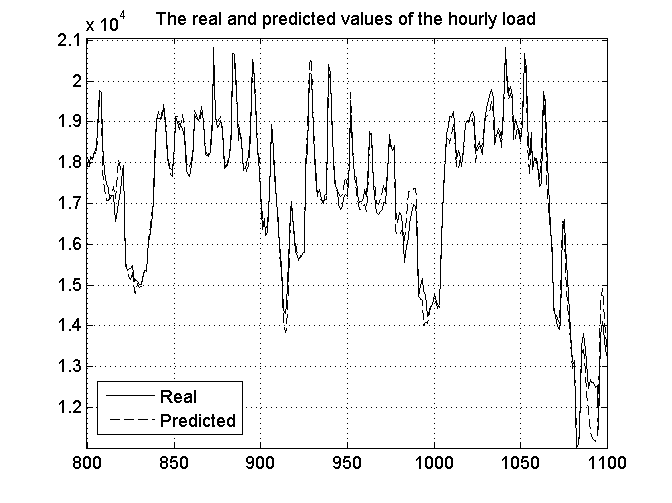

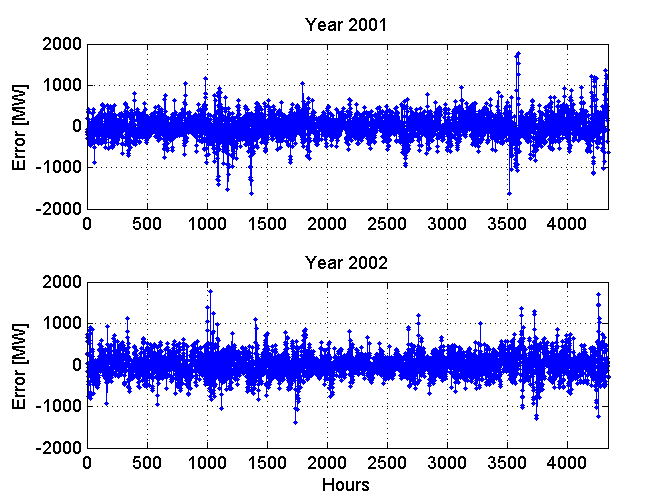

Precyzja klasowa – stosunek prawdziwej liczby rozpoznanych przypadków danej klasy do wszystkich przypadków rozpoznanych przez klasyfikator jako dana klasa.