Podręcznik

| Strona: | SEZAM - System Edukacyjnych Zasobów Akademickich i Multimedialnych |

| Kurs: | Wprowadzenie do przetwarzania sygnałów |

| Książka: | Podręcznik |

| Wydrukowane przez użytkownika: | Gość |

| Data: | piątek, 13 lutego 2026, 13:32 |

Spis treści

- 1. Wstęp

- 2. Sygnały i ich charakterystyki

- 2.1. Pojęcia podstawowe

- 2.2. Dziedzina i zakres określoności sygnałów

- 2.3. Przekształcenia sygnałów

- 2.4. Operacja splotu i jej zastosowanie do opisu układów liniowych

- 2.5. Parametry energetyczne sygnałów

- 2.6. Korelacja wzajemna i autokorelacja

- 2.7. Sygnały zespolone

- 2.8. Reprezentacja sygnałów w języku Python

- 2.9. Charakterystyki sygnałów w języku Python

- 2.10. Test A - sprawdź swoją wiedzę

- 3. Cyfrowe przetwarzanie sygnałów

- 4. Analiza częstotliwościowa sygnałów

- 5. Analiza częstotliwościowa sygnałów losowych

1. Wstęp

Przetwarzanie sygnałów stanowi jeden z kluczowych obszarów inżynierii biomedycznej, znajdując zastosowanie m.in. w analizie sygnałów fizjologicznych, takich jak EKG, EEG, EMG czy sygnały akustyczne i obrazowe. Zrozumienie podstawowych pojęć związanych z sygnałami oraz metod ich analizy jest niezbędne do prawidłowej interpretacji danych pomiarowych oraz projektowania nowoczesnych systemów diagnostycznych.

Celem niniejszego skryptu jest zapoznanie czytelnika z zagadnieniami związanymi z analizą i cyfrowym przetwarzaniem sygnałów, ze szczególnym uwzględnieniem zastosowań biomedycznych. Materiał został podzielony na kilka tematycznych rozdziałów, które prowadzą od podstawowych definicji do bardziej zaawansowanych metod analizy sygnałów deterministycznych i losowych.

W rozdziale drugim omówione zostały podstawowe pojęcia związane z sygnałami oraz ich parametrami. Rozdział trzeci poświęcony jest cyfrowemu przetwarzaniu sygnałów, w tym operacjom dyskretyzacji, próbkowania oraz podstawowym algorytmom stosowanym w analizie sygnałów w postaci cyfrowej. W rozdziale czwartym przedstawiono analizę częstotliwościową sygnałów deterministycznych, obejmującą m.in. transformatę Fouriera oraz jej zastosowania w analizie widmowej. Rozdział piąty koncentruje się na analizie częstotliwościowej sygnałów losowych. Na końcu każdego rozdziału zamieszczono test sprawdzający, wraz z odpowiedziami, umożliwiający samodzielną ocenę stopnia opanowania omawianego materiału.

W każdym rozdziale zaprezentowane zostały przykłady implementacji omawianych pojęć w języku Python. Pozwala to czytelnikowi nie tylko przyswoić podstawy teoretyczne, lecz także zastosować je w praktycznej analizie i przetwarzaniu sygnałów. Należy zaznaczyć, że ze względu na ograniczenia platformy eSezam oraz brak możliwości wykorzystania dodatkowych wtyczek, zastosowane podświetlanie składni ma charakter uproszczony i może nie w pełni odpowiadać standardowemu wyglądowi kodu Pythona w środowiskach programistycznych (np. PyCharm, VS Code czy Jupyter Notebook).

Dodatkowo, w celu poszerzenia wiedzy, zamieszczono poniżej wybraną literaturę polsko- i anglojęzyczną dotyczącą cyfrowego przetwarzania sygnałów, sygnałów losowych oraz ich zastosowań w analizie sygnałów biomedycznych:

- Rangaraj M. Rangayyan, Sridhar Krishnan, Biomedical Signal Analysis, John Wiley & Sons / Wiley‑IEEE Press, wyd. 3, 2024.

- Richard G. Lyons, Wprowadzenie do cyfrowego przetwarzania sygnałów, Wydawnictwa Komunikacji i Łączności (WKŁ), 2006.

- Zbigniew Gajo, Podstawy cyfrowego przetwarzania sygnałów, Oficyna Wydawnicza Politechniki Warszawskiej, 2019.

- Andrzej Zieliński, Cyfrowe przetwarzanie sygnałów. Od teorii do zastosowań, Wydawnictwa Komunikacji i Łączności (WKŁ), 2014.

- Steven W. Smith, Cyfrowe przetwarzanie sygnałów. Praktyczny poradnik dla inżynierów i naukowców, BTC, Warszawa, 2007.

- Richard G. Lyons, Understanding Digital Signal Processing, Pearson, 3rd ed., 2010.

2. Sygnały i ich charakterystyki

W niniejszym rozdziale przedstawione zostaną podstawowe pojęcia związane z sygnałami oraz ich najważniejsze charakterystyki. Rozpoczniemy od omówienia podstawowych definicji, takich jak sygnał, dziedzina określoności i zakres sygnałów, a także przedstawienia różnic między sygnałami ciągłymi a dyskretnymi. Następnie przyjrzymy się przekształceniom sygnałów - takimi jak przesunięcie, skalowanie i odwrócenie - które pozwalają na elastyczne modelowanie i analizę sygnałów.

W dalszej części rozdziału skoncentrujemy się na operacji splotu, która stanowi fundamentalne pojęcie w analizie i opisie liniowych układów niezmienniczych w czasie. Pokażemy, w jaki sposób splot pozwala określić odpowiedź układu na dowolny sygnał wejściowy, wykorzystując jego odpowiedź impulsową.

Kolejnym omawianym zagadnieniem będą parametry energetyczne sygnałów, takie jak wartość średnia, energia oraz moc średnia, które pozwalają na ilościową ocenę sygnałów, a także operacje korelacji wzajemnej i autokorelacji umożliwiające ocenę podobieństwa sygnałów, wykrywanie opóźnień oraz analizę ich struktury czasowej.

Oprócz sygnałów rzeczywistych, omówione zostaną sygnały zespolone w kontekście ich reprezentacji w dziedzinie amplitudy i fazy, a także przy użyciu części rzeczywistej i urojonej. Pozwoli to na dokładniejszą analizę przebiegów harmonicznych, modulacji oraz filtracji sygnałów, które często występują w praktyce inżynierskiej.

Rozdział zawiera także przykłady implementacji omawianych pojęć w języku Python, obejmujące m.in. generowanie sygnałów, wykonywanie operacji splotu, obliczanie energii i mocy oraz korelację. Umożliwia to czytelnikowi nie tylko przyswojenie podstaw teoretycznych, lecz również ich praktyczne zastosowanie w analizie i przetwarzaniu sygnałów.

2.1. Pojęcia podstawowe

Sygnał jest to funkcja, która opisuje zmianę pewnej wielości fizycznej lub stanu obiektu fizycznego w czasie. Sygnały mogą obejmować m.in. sygnały dźwiękowe, obrazowe, elektryczne i biologiczne.

Przykłady sygnałów:

- mowa człowieka – sygnał akustyczny,

- zdjęcie cyfrowe – sygnał dwuwymiarowy,

- EKG serca – sygnał biomedyczny,

- sygnał radiowy – sygnał elektromagnetyczny,

- napięcie i prąd w układach elektrycznych – sygnał elektryczny.

Pojęcie sygnału będziemy utożsamiać z jego modelem matematycznym. Sygnały mogą być opisane za pomocą funkcji jednej lub wielu zmiennych. W praktyce wykorzystuje się funkcje czasu i/lub położenia w przestrzeni. Funkcje te mogą przyjmować zarówno wartości rzeczywiste, jak i zespolone. W przypadku modeli zespolonych mamy ułatwioną ich analizę formalną, ale kosztem zwiększenia stopnia abstrakcji opisu sygnałów. Jako modele sygnałów wprowadza się również wielkości niefunkcyjne, określane mianem dystrybucji.

Dysponując modelem matematycznym sygnału, możemy dokonać jego przetworzenia, które polega na modyfikowaniu i wydobywaniu użytecznych informacji z sygnału w celu jego poprawy, kompresji, interpretacji, przesyłania czy wizualizacji. Jako główne cele przetwarzania sygnałów można wymienić:

- usuwanie zakłóceń, szumów i artefaktów, np. z nagrań audio i obrazów, pochodzących z aparatury pomiarowej, ruchu pacjenta lub impulsów elektrycznych,

- wzmacnianie użytecznych informacji, np. wyodrębnianie sygnału EKG,

- kompresja danych, np. w formatach MP3 i JPEG, a także zmniejszanie objętości danych biomedycznych w celu ich przesyłania w systemach telemedycyny,

- rozpoznawanie wzorców i zdarzeń, np. mowy lub twarzy, a także wykrywanie napadów epilepsji, migotania przedsionków czy bezdechu sennego,

- analiza sygnału w dziedzinie czasu i częstotliwości, np. w diagnostyce omdleń lub analizy aktywności fal mózgowych w sygnałach EEG.

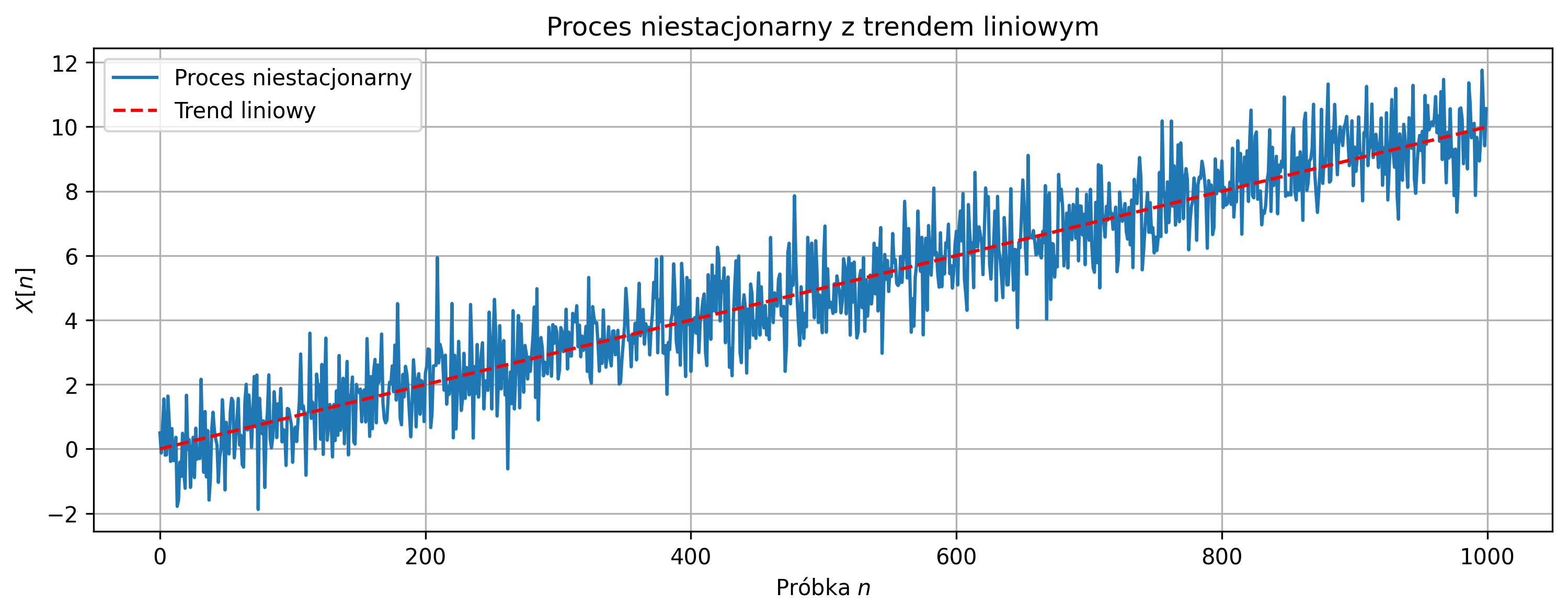

W teorii przetwarzania sygnałów wyróżnia się podstawowy podział sygnałów na:

- deterministyczne – sygnały w pełni określone poprzez zależności matematyczne, na podstawie których można dokładnie przewidzieć ich wartości w każdym momencie czasu,

- stochastyczne (losowe) – sygnały, których wartości są nieprzewidywalne i zmieniają się w sposób losowy.

W zastosowaniach inżynierskich, elektronicznych, telekomunikacyjnych czy biomedycznych mamy do czynienia zarówno z sygnałami deterministycznymi, jak i losowymi.

Sygnały deterministyczne są powtarzalne i przewidywalne:

- sinusoida – fale nośne w radiu,

- impuls prostokątny – sygnał zegarowy w mikroprocesorach,

- EKG – w warunkach spoczynku i bez zakłóceń (składa się z powtarzalnych cykli pracy serca),

- EMG podczas rytmicznego skurczu – powtarzalny wzorzec aktywności mięśni,

- EEG z wywołanym potencjałem – powtarzalna rekcja mózgu na bodziec (np. błysk światła).

W praktyce sygnały deterministyczne zawierają zakłócenia losowe. Każdy pomiar jest obarczony pewnymi błędami o charakterze losowym, które są zwykle eliminowane przez operację filtracji.

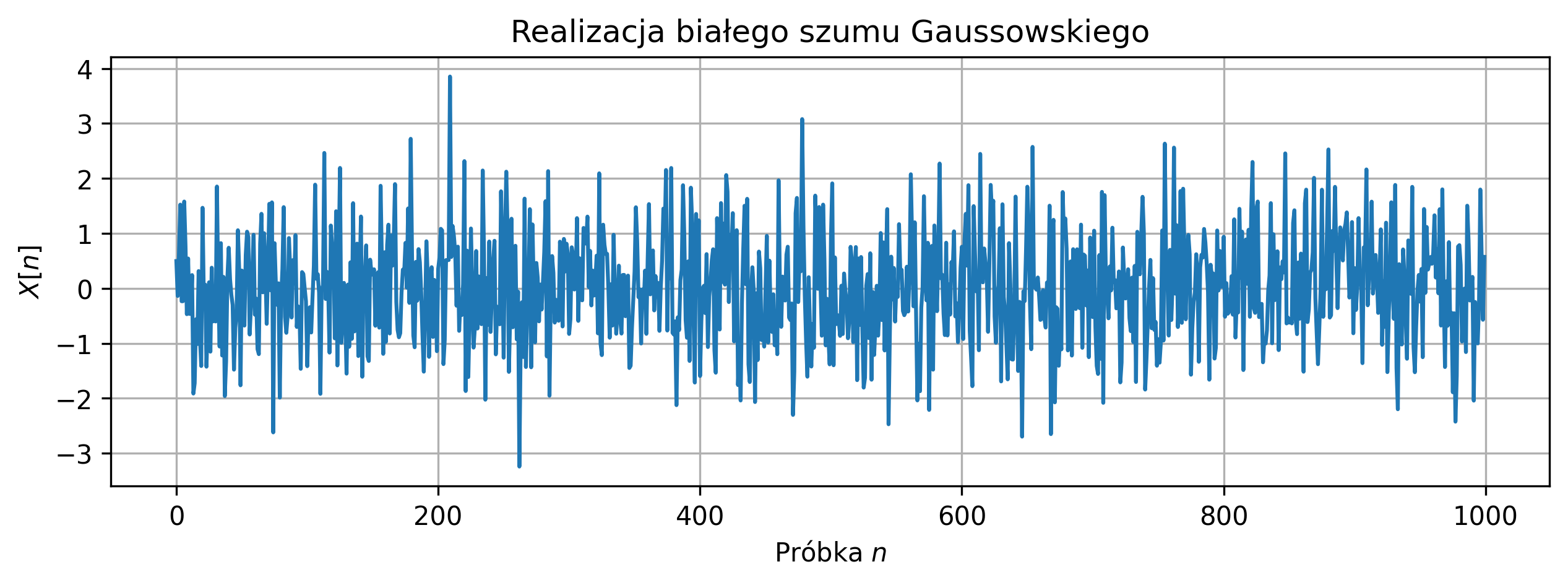

Sygnały losowe zmieniają się w sposób trudny do przewidzenia:

- szum biały – wykorzystywany do testowania odpowiedzi systemu oraz modelowania zakłóceń,

- zakłócenia elektromagnetyczne – występujące w transmisji danych, zasilaczach i czujnikach,

- EEG – aktywność mózgu, zmieniająca się dynamicznie i nieregularnie,

- EMG – aktywność mięśni, silnie losowa podczas dowolnego ruchu,

- zmienne tętno (HRV) – różnice między kolejnymi uderzeniami serca, naturalnie losowe.

Rozdziały 2–4 niniejszego skryptu poświęcone są sygnałom deterministycznym, na podstawie których wyjaśnione zostaną podstawowe sposoby opisu i reprezentacji sygnałów. Pojęcia te zostaną następnie uogólnione na sygnały losowe w rozdziale 5.

2.2. Dziedzina i zakres określoności sygnałów

Sygnały są nośnikami informacji, których wartości można zmierzyć i za ich pomocą przekazywana jest informacja. Może ona mieć charakter ciągły, przyjmując nieskończoną liczbę wartości, lub charakter dyskretny, ograniczony do skończonej liczby wartości. Dziedzina i zakres określoności sygnałów informują o tym, jak zmienia się zmienna niezależna opisująca sygnał, na przykład czas lub przestrzeń, oraz jakie wartości może przyjmować sygnał. Stanowią one podstawowe kryterium podziału sygnałów.

Wyróżnia się trzy podstawowe typy sygnałów:

- analogowe,

- dyskretne,

- cyfrowe.

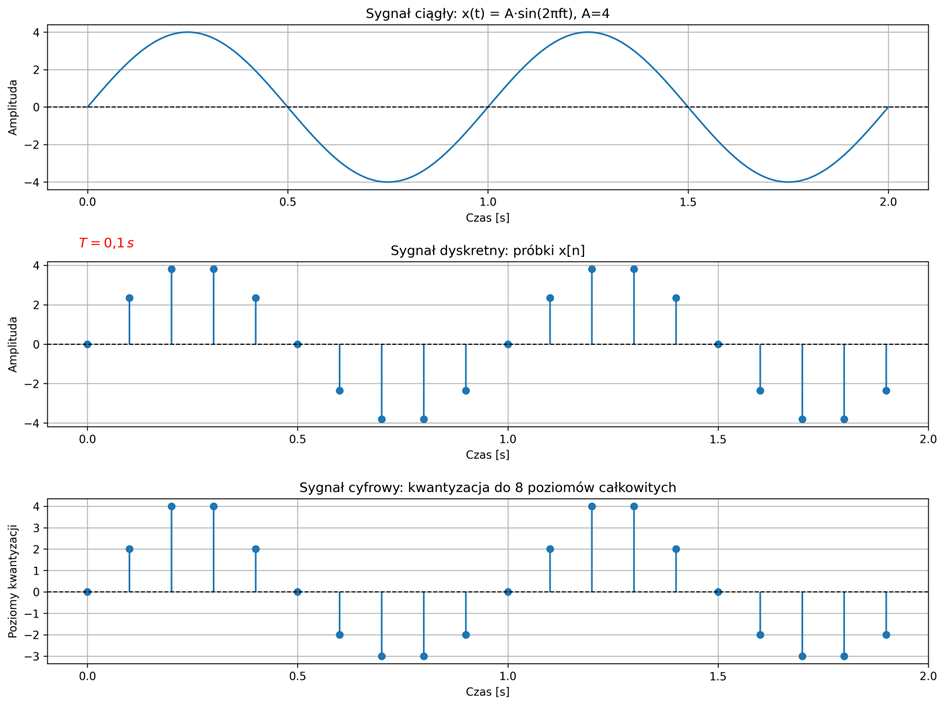

Termin analogowy jest używany przy opisie sygnału, który jest ciągły w czasie i ma ciągły zakres wartości – tzw. ciągły w amplitudzie. W przypadku sygnału dyskretnego, jego wartości określone są tylko w wybranych chwilach czasowych, a amplitudy próbek sygnału należą do zbioru liczb rzeczywistych. Sygnał cyfrowy to sygnał o czasie dyskretnym, którego zbiór wartości również jest dyskretny – tzw. dyskretny w amplitudzie. Sygnały cyfrowe są sygnałami dyskretnymi, dla których przeprowadzono operację kwantowania – przypisywania każdej wartości próbki do najbliższej wartości z ograniczonego zbioru możliwych poziomów. Komputery i systemy cyfrowe nie mogą zapisywać nieskończonej liczby wartości, dlatego dyskretyzacja sygnału w amplitudzie pozwala przetwarzać i przechowywać dane w formie cyfrowej.

W dalszej części rozważań analizowane będą wyłącznie sygnały ciągłe w czasie oraz ich próbkowe wersje dyskretne. Procesy kwantyzacji i kodowania, które są etapami przekształcania sygnału do postaci cyfrowej, nie będą tutaj uwzględniane. Zwykle są one realizowane automatycznie przez przetworniki analogowo-cyfrowe i systemy komputerowe, dlatego nie wpływają na zrozumienie podstawowych problemów związanych z przetwarzaniem sygnałów.

Przyjmijmy formalny zapis jednowymiarowego sygnału jako:

\( x(t) \) lub \( x[n] \)

gdzie:

- \( x(t) \) – sygnał ciągły w czasie \( t \),

- \( x[n] \) – sygnał dyskretny, określony tylko w wybranych chwilach czasowych \( n\in D \).

Zbiór \( D \) wartości zmiennej dyskretnej \( n \) jest zwykle zbiorem wszystkich liczb całkowitych, zbiorem liczb naturalnych lub jego skończonym podzbiorem \( [n_1, n_2] \).

Dziedziną sygnałów ciągłych \( x(t) \) może być:

- zbiór liczb \( \mathbb{R} \) – w modelach matematycznych,

- dodatnia półoś \( [0,\infty) \) – w modelach przyczynowych,

- odcinek \( [t_1, t_2] \) osi czasu – fizycznie istniejące układy.

W przypadku sygnałów dyskretnych \( x[n] \), dziedziną jest zwykle zbiór chwil \( t_n = nT \), \( n\in \mathbf{D} \), odległych od siebie o stały odstęp \( T \), nazywany okresem próbkowania lub przedziałem dyskretyzacji. Istotny dla nas będzie jedynie kolejny numer w ciągu próbek, a nie w jakiej chwili \( t_n \) została pobrana próbka. Dlatego też, argumentem sygnału dyskretnego będzie czas unormowany względem okresu próbkowania, czyli \( n = t_n/T \).

Jeżeli sygnał przyjmuje wartości różne od zera:

- w przedziale nieskończonym, to nazywamy go sygnałem o nieskończonym czasie trwania,

- w przedziale skończonym, to nazywamy go sygnałem o skończonym czasie trwania lub sygnałem impulsowym.

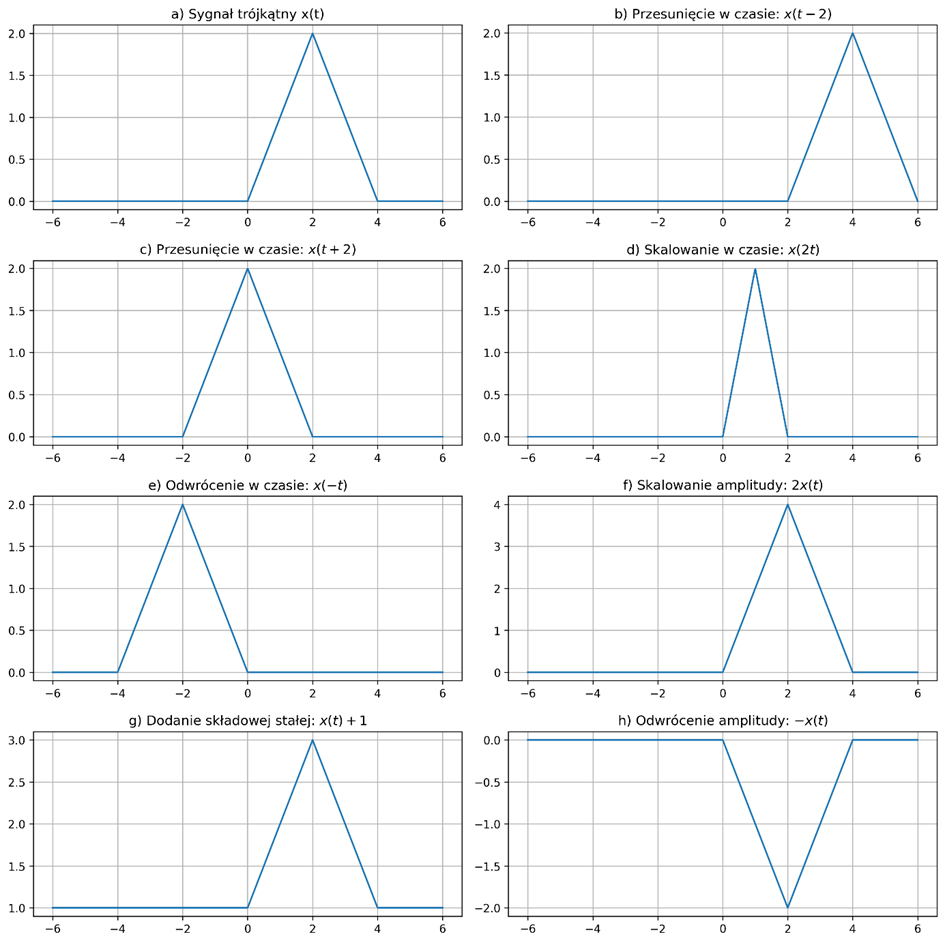

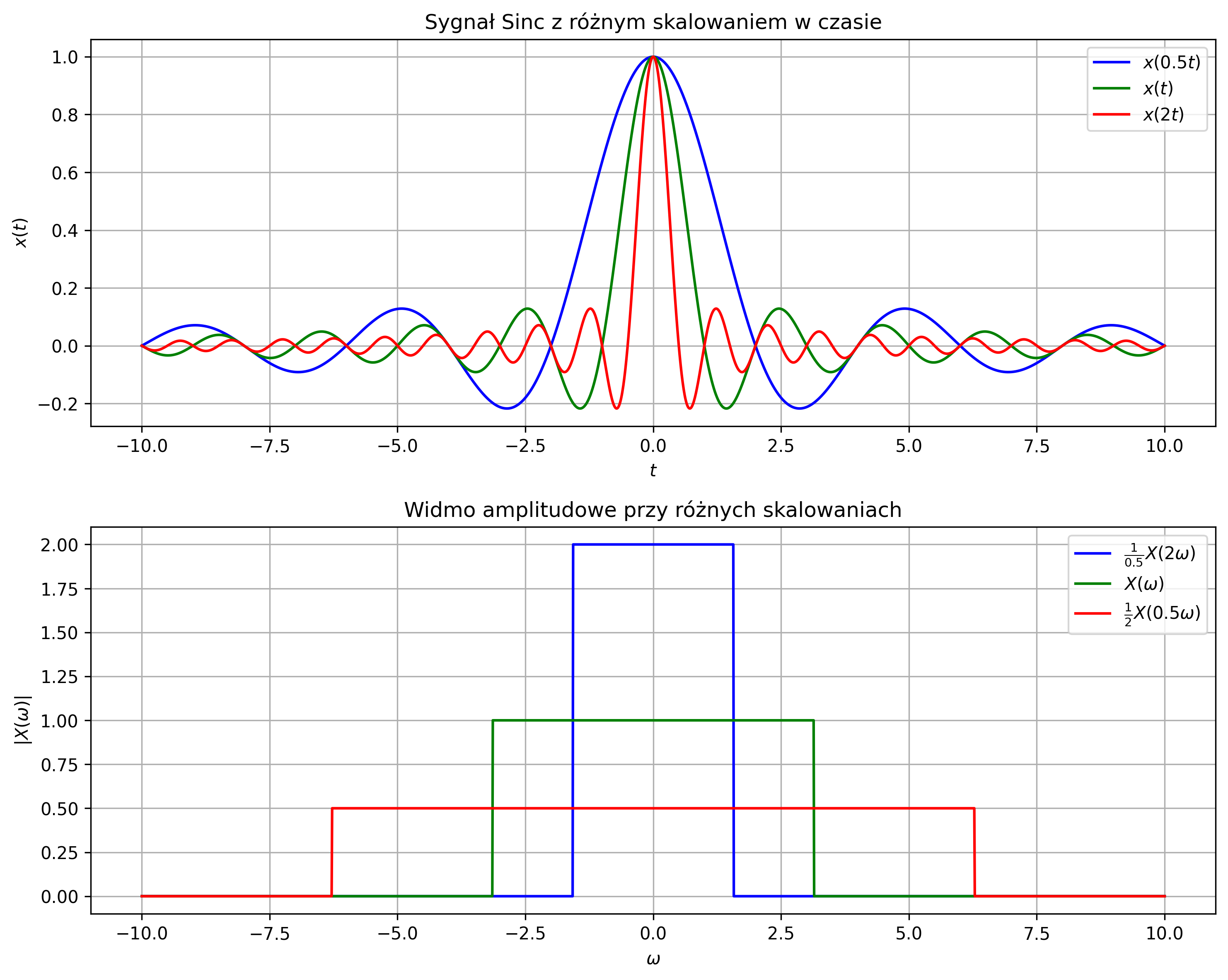

2.3. Przekształcenia sygnałów

Przekształcenia sygnałów w dziedzinie czasu to operacje, które zmieniają ich kształt, pozycję lub wartości. Do podstawowych operacji można zaliczyć przesunięcie, skalowanie i odwrócenie w czasie, skalowanie amplitudy, dodanie składowej stałej i odwrócenie amplitudy.

- Przesunięcie w czasie – sygnał \( x(t) \) jest przesuwany o \( t_0 \) w lewo lub prawo na osi czasu (rys. 2.3b-c):

\( y(t)=x(t-t_0) \)

- jeśli \( t_0 < 0 \) to mamy do czynienia z przyśpieszeniem sygnału,

- jeśli \( t_0 > 0 \) to mamy do czynienia z jego opóźnieniem.

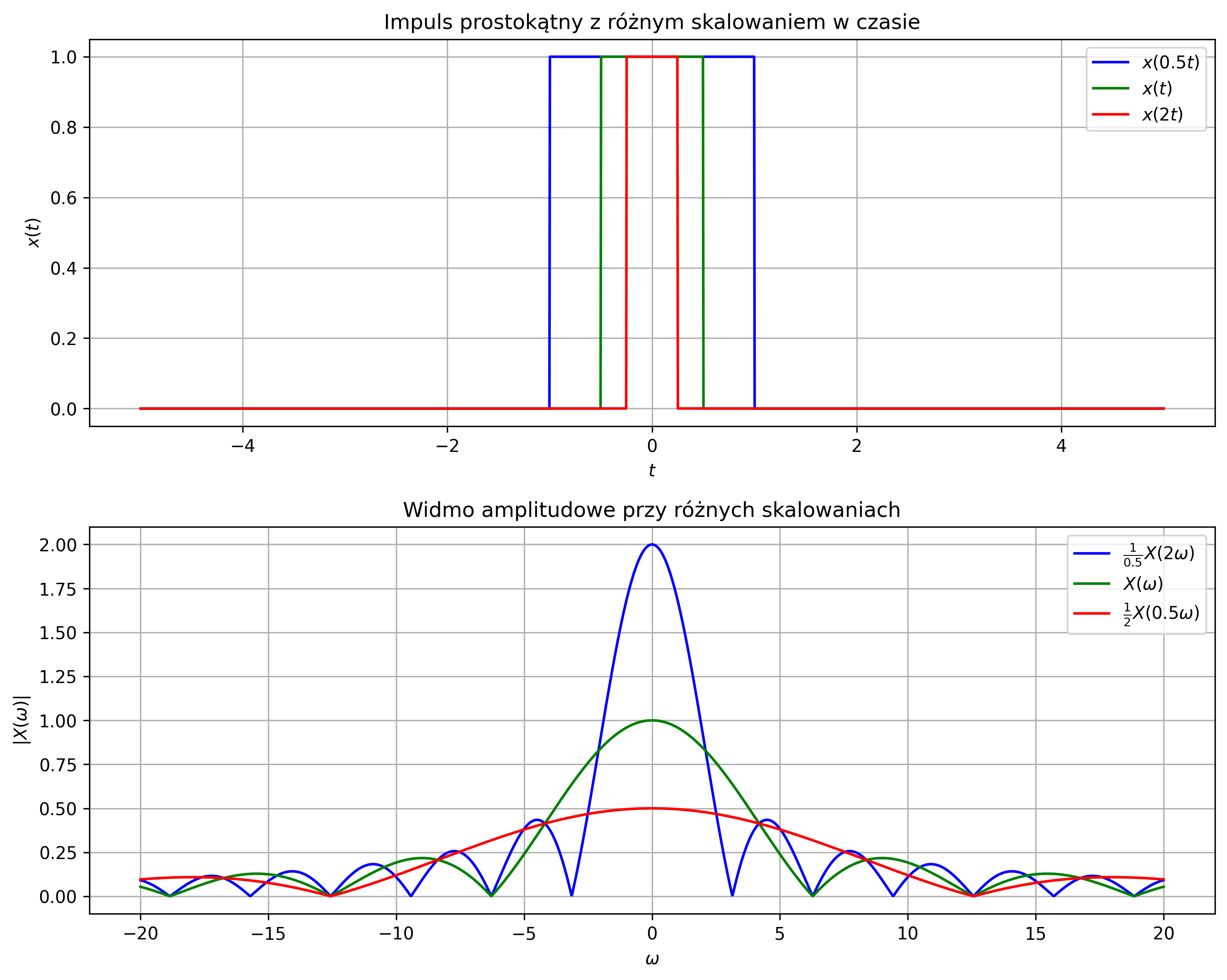

- Skalowanie w czasie – zmiana szybkości przebiegu sygnału \( x(t) \) poprzez stały współczynnik skalowania czasu \( a \) (rys. 2.3d):

\( y(t)=x(at) \)

- jeśli \( \lvert a \rvert < 1 \) to mamy do czynienia z „rozciąganiem” sygnału w czasie,

- jeśli \( \lvert a \rvert > 1 \) to mamy do czynienia z jego „ściskaniem” w czasie.

- Odwrócenie w czasie – zmiana kierunku przebiegu czasu poprzez odbicie sygnału \( x(t) \) względem osi pionowej (rys. 2.3e):

\( y(t)=x(-t) \)

- Skalowanie amplitudy – zmiana wartości sygnału \( x(t) \) poprzez stały współczynnik skalowania amplitudy \( A \) (rys. 2.3f):

\( y(t)=A\,x(t) \)

- jeśli \( 0 < A < 1 \) to mamy do czynienia z osłabieniem sygnału – amplituda maleje, zachowując kształt w czasie,

- jeśli \( A > 1 \) to mamy do czynienia ze wzmacnianiem sygnału – amplituda rośnie, jednocześnie zachowując jego kształt w czasie,

- jeśli \( A < 0 \) to mamy do czynienia z operacją odwracania w czasie i skalowania amplitudy.

- Dodanie składowej stałej – przesunięcie sygnału \( x(t) \) w górę lub w dół o stałą wartość \( C \) (rys. 2.3g):

\( y(t)=x(t)+C \)

- jeśli \( C < 0 \) to mamy do czynienia z przesunięciem sygnału o \( C \) jednostek w dół, zachowując jego kształt w czasie,

- jeśli \( C > 0 \) to mamy do czynienia z przesunięciem sygnału o \( C \) jednostek w górę, zachowując jego kształt w czasie.

- Odwrócenie amplitudy – zmiana znaku każdej wartości sygnału na przeciwną poprzez odbicie sygnału \( x(t) \) względem osi poziomej (rys. 2.3h):

\( y(t)=-x(t) \)

Przesunięcie z odwróceniem sygnału w czasie posłuży nam do obliczania splotu dwóch sygnałów – operacji opisanej w rozdziale 2.4.

2.4. Operacja splotu i jej zastosowanie do opisu układów liniowych

Istotną klasą systemów w przetwarzaniu sygnałów są systemy liniowe i niezmiennicze w czasie (LTI, ang. Linear Time-Invariant). Systemy LTI to takie, które spełniają dwa podstawowe warunki:

1. liniowość, na którą składa się jednorodność i addytywność:

-

jeżeli sygnał wejściowy \( x(t) \) systemu jest skalowany za pomocą stałego czynnika \( a \), wówczas sygnał wyjściowy \( y(t) \) również jest skalowany przez ten czynnik:

\( H(x(t)) = y(t)\quad\Rightarrow\quad H(a x(t)) = a\cdot y(t) \) -

jeżeli sygnał wejściowy systemu jest sumą sygnałów \( x_1(t) \) i \( x_2(t) \), to aby ten system był addytywny, jego sygnał wyjściowy musi być sumą poszczególnych sygnałów wyjściowych:

\( \begin{cases} H(x_1(t)) = y_1(t) \\ H(x_2(t)) = y_2(t) \end{cases}\quad\Rightarrow\quad H(x_1(t)+x_2(t)) = H(x_1(t)) + H(x_2(t)) = y_1(t) + y_2(t) \)

2. niezmienniczość w czasie:

-

przesunięcie sygnału \( x(t) \) o \( t_0 \) powoduje tylko przesunięcie wyjścia \( y(t) \) o \( t_0 \), bez zmiany kształtu:

\( H(x(t)) = y(t)\quad\Rightarrow\quad H(x(t - t_0)) = y(t - t_0) \)

Powyższe warunki składają się na zasadę superpozycji, którą można analogicznie wyprowadzić dla systemów dyskretnych.

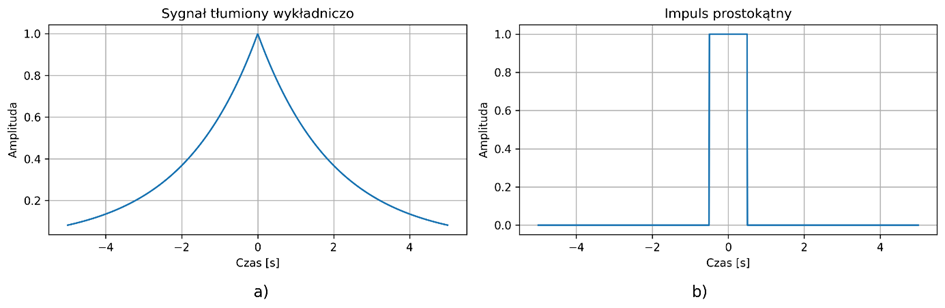

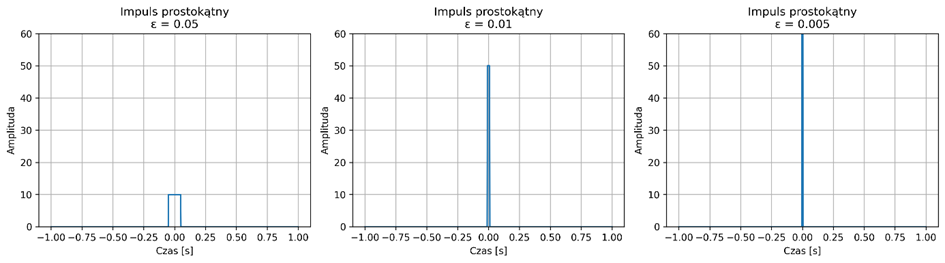

Jeżeli system jest liniowy i niezależny od czasu, to kluczowe staje się pojęcie odpowiedzi impulsowej (ang. Impulse Response). Jest to odpowiedź systemu na pobudzenie w formie impulsu jednostkowego, nazywanego również deltą Diraca (dystrybucja delta) \( \delta(t) \):

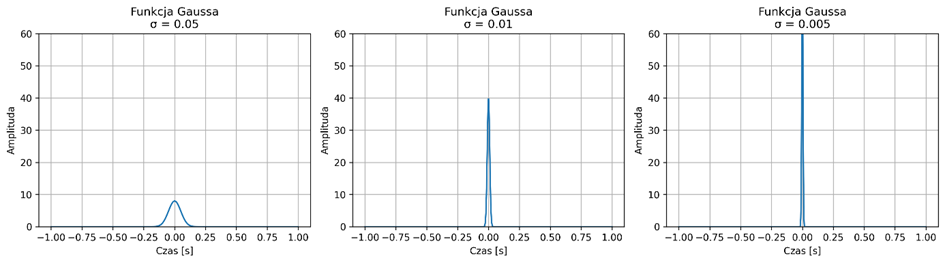

Delta Diraca nie jest funkcją w klasycznym sensie, ale idealizowanym impulsem o nieskończonej amplitudzie i zerowej szerokości – używamy jej przybliżenia. Najczęściej do wizualizacji używa się wąskiego i wysokiego impulsu, np. prostokątnego (rys. 2.4) lub funkcji Gaussa (rys. 2.5).

Rys. 2.4. Sekwencja przybliżeń delty Diraca przy użyciu coraz wyższych i węższych impulsów prostokątnych

Rys. 2.5. Sekwencja przybliżeń delty Diraca przy użyciu coraz wyższych i węższych krzywych Gaussa

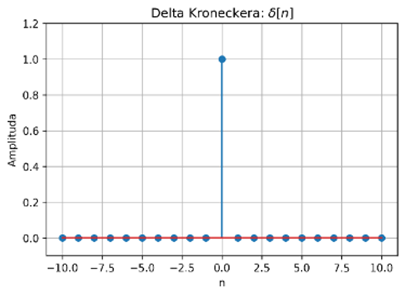

W przypadku sygnałów dyskretnych mamy do czynienia z deltą Kroneckera \( \delta[n] \):

której graficzne przedstawienie zostało pokazane na rys. 2.6. Sygnał ten jest podstawą koncepcji odpowiedzi impulsowej oraz splotu dyskretnego.

Odpowiedź impulsową oznaczamy \( h(t) \) lub \( h[n] \), odpowiednio dla sygnałów ciągłych i dyskretnych. Jeżeli znamy odpowiedź impulsową systemu LTI, to odpowiedź systemu na pobudzenie dowolnym sygnałem możemy obliczyć jako splot tego sygnału z odpowiedzią impulsową.

Splot (ang. Convolution) jest jednym z fundamentalnych pojęć teorii sygnałów. Jest to operacja matematyczna, która oblicza odpowiedź systemu liniowego na dowolny sygnał wejściowy, nakładając odpowiedź impulsową przesuniętą w czasie.

Splot dla:

- sygnałów ciągłych:

- sygnałów dyskretnych:

gdzie \( x \) jest sygnałem wejściowym, \( h \) jest odpowiedzią impulsową systemu oraz \( y \) jest sygnałem wyjściowym, będącym wynikiem splotu. Nakładając odpowiedź impulsową \( h \) na każdą próbkę sygnału \( x \), przesuwając ją w czasie (ciągłym lub dyskretnym) i sumując wpływ wszystkich tych przesunięć, otrzymujemy wynik operacji splotu. Kluczowa jest kolejność wykonywania działań:

1. odwróć w czasie drugi z sygnałów ze względu na \( \tau \) lub \( k \):

2. przesuń go w czasie o czas \( t \) lub o \( n \) próbek:

3. wymnóż pierwszy sygnał ze zmodyfikowanym drugim:

4. scałkuj wynik mnożenia lub zsumuj wszystkie iloczyny próbek.

Znajomość pojęcia splotu pozwala na zrozumienie podstawowych właściwości impulsu Diraca:

-

splot z \( \delta(t) \) – impuls Diraca jest elementem identycznościowym operacji splotu:

\( x(t)\ast \delta(t) = x(t) \) -

splot z przesuniętą deltą \( \delta(t - t_0) \) przesuwa sygnał w czasie o \( t_0 \):

\( x(t)\ast \delta(t - t_0) = x(t - t_0) \)

Zatem, skoro impuls jednostkowy jest sygnałem, który podany na wejście dowolnego liniowego i niezmienniczego w czasie układu powoduje wygenerowanie odpowiedzi równej odpowiedzi impulsowej tego układu:

to odpowiedź takiego systemu na dowolny sygnał wejściowy \( x(t) \) jest jego splotem ze znaną odpowiedzią impulsową \( h(t) \):

W przypadku sygnałów dyskretnych opis systemów LTI za pomocą splotu jest analogiczny:

Oznacza to, że:

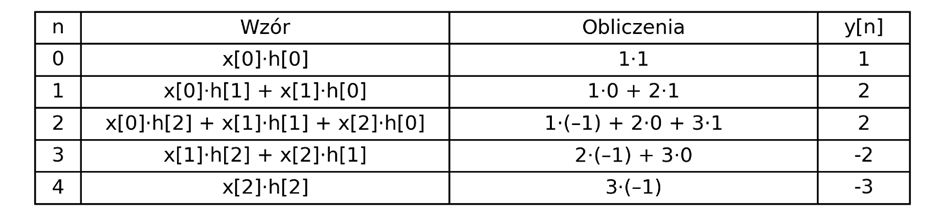

Ponieważ \( x[k] \) i \( h[k] \) mają tylko 3 niezerowe próbki, splot będzie miał długość:

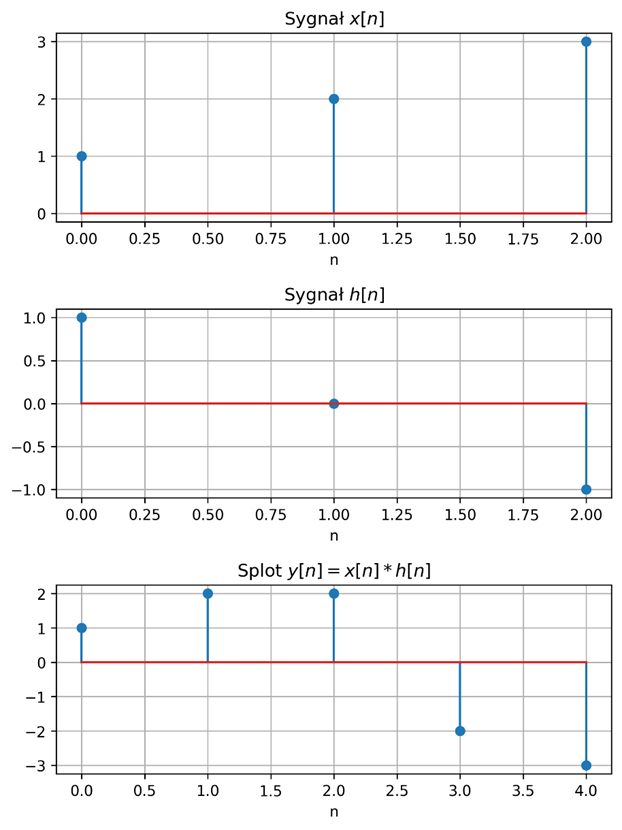

otrzymamy kolejne wartości sygnału \( y[n] \). Kolejne kroki zostały przedstawione w tabeli:

Poniżej przedstawiono wykresy sygnałów i ich splotu:

2.5. Parametry energetyczne sygnałów

Parametry energetyczne sygnałów to miary opisujące ilość energii zawartej w sygnale lub jego moc w czasie, które pozwalają na ilościową ocenę jego właściwości. W analizie i przetwarzaniu sygnałów mają kluczowe znaczenie, ponieważ umożliwiają:

- ocenę amplitudy i intensywności sygnału,

- wykrywanie zmian i anomalii,

- porównywanie i klasyfikowanie sygnałów,

- dobór parametrów filtrów i algorytmów przetwarzania,

- ocenę jakości sygnału.

W kontekście sygnałów biomedycznych analiza parametrów energetycznych jest niezwykle istotna, ponieważ pozwala na ilościową ocenę zarówno aktywności biologicznej, jak i jakości sygnałów rejestrowanych przez aparaturę medyczną. Energia i moc sygnału umożliwiają m.in.:

- ocenę intensywności procesów fizjologicznych – np. amplituda i energia sygnału EKG odzwierciedlają siłę skurczów serca, energia sygnałów EEG koreluje z poziomem aktywności mózgu, a sygnały EMG odzwierciedlają aktywność mięśni,

- wykrywanie nieprawidłowości i patologii – nagłe zmiany energii sygnału mogą wskazywać na arytmie serca, napady epilepsji, migotanie przedsionków lub inne stany chorobowe,

- ocenę jakości sygnału i skuteczności przetwarzania – sygnały o niskiej energii w stosunku do szumu wymagają wzmocnienia lub filtracji, co jest istotne w telemedycynie i zdalnym monitoringu pacjentów,

- dobór parametrów filtrów i algorytmów analizy – energia sygnału pozwala określić, które składowe częstotliwości są istotne, a które stanowią zakłócenia, co ma znaczenie przy projektowaniu algorytmów do analizy EKG, EEG i EMG,

- porównania między pacjentami lub stanami fizjologicznymi – parametry energetyczne umożliwiają obiektywne porównanie sygnałów w różnych warunkach, np. spoczynkowych, wysiłkowych czy patologicznych.

Sygnały deterministyczne przyjmują w dowolnej chwili czasowej wartości rzeczywiste, które są określone przez jawne zależności matematyczne. Z takimi sygnałami wiąże się wiele parametrów, które charakteryzują ich właściwości. Wartość średnia, energia, moc średnia i wartość skuteczna należą do najważniejszych parametrów sygnałów.

- Wartością średnią ciągłego sygnału \( x(t) \), określonego w przedziale \( [t_1, t_2] \), nazywamy wielkość:

- W przypadku sygnału o nieskończonym czasie trwania, wartością średnią nazywamy wielkość graniczną:

- Energią ciągłego sygnału \( x(t) \) nazywamy wielkość:

- Mocą średnią ciągłego sygnału \( x(t) \) nazywamy wielkość graniczną:

- Mocą średnią ciągłego sygnału \( x(t) \) o skończonym czasie trwania, określonego w przedziale \( [t_1, t_2] \), nazywamy wielkość:

- Wartością skuteczną ciągłego sygnału \( x(t) \) jest nazywany pierwiastek z jego mocy:

Wartości energii i mocy sygnału odnoszą się nie bezpośrednio do fizycznych zjawisk, lecz do analizy właściwości sygnału. W teorii sygnałów często nie przypisuje się jednostki sygnału. W takim przypadku wymiarem energii sygnału jest sekunda, natomiast moc jest bezwymiarowa.

Energia i moc charakteryzują właściwości energetyczne sygnału. Na ich podstawie sygnały deterministyczne (ciągłe lub dyskretne) można podzielić na dwie klasy:

- sygnały o ograniczonej energii, gdy:

- sygnały o ograniczonej mocy, gdy:

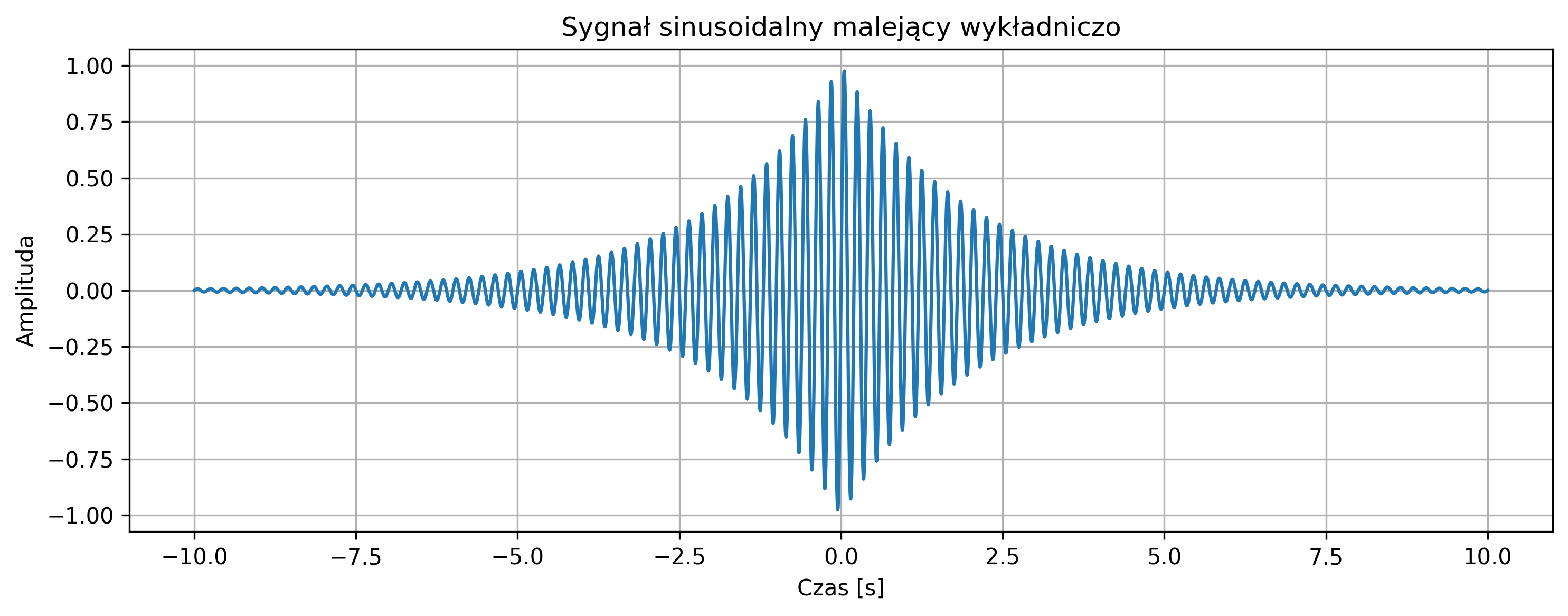

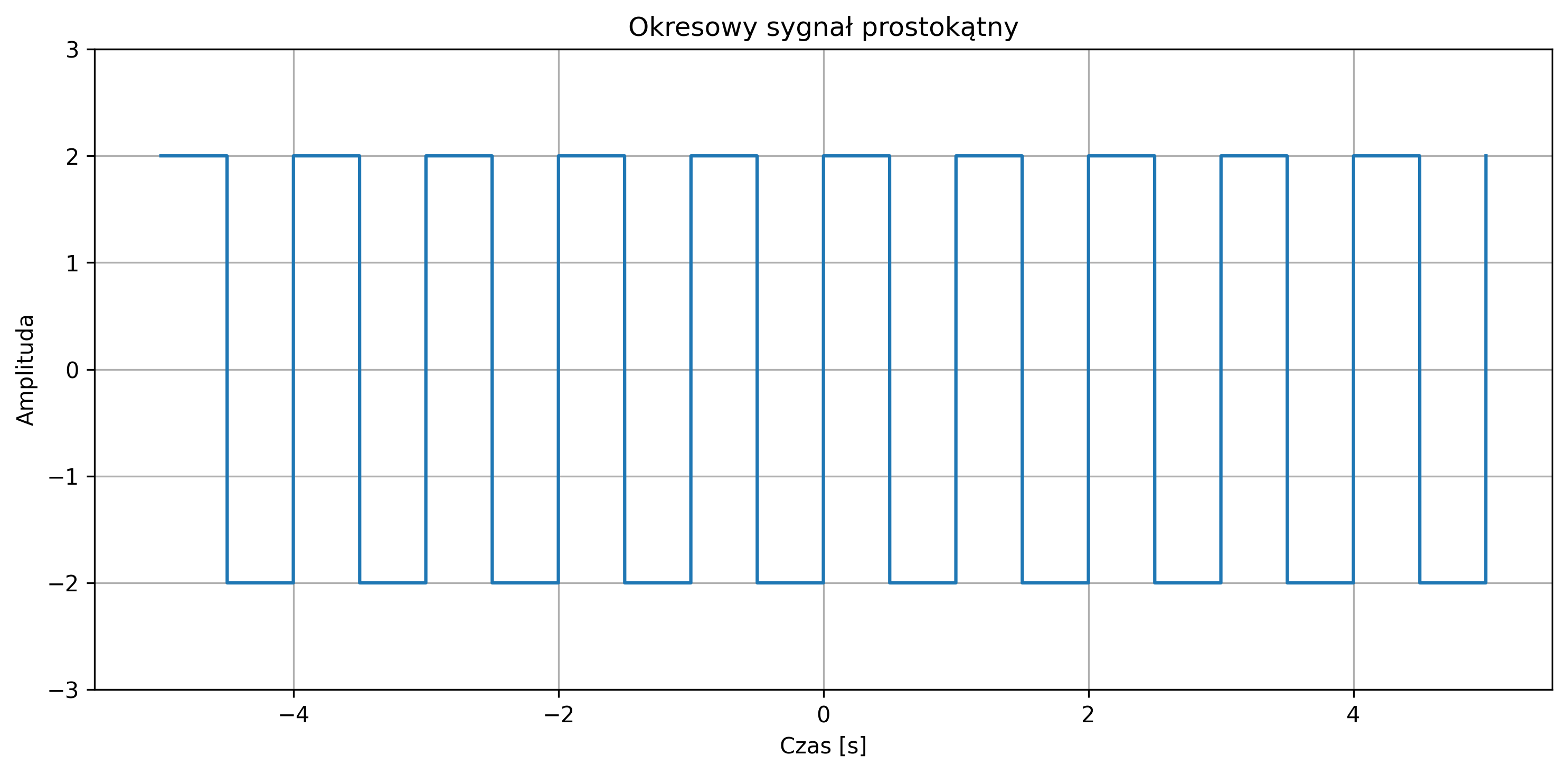

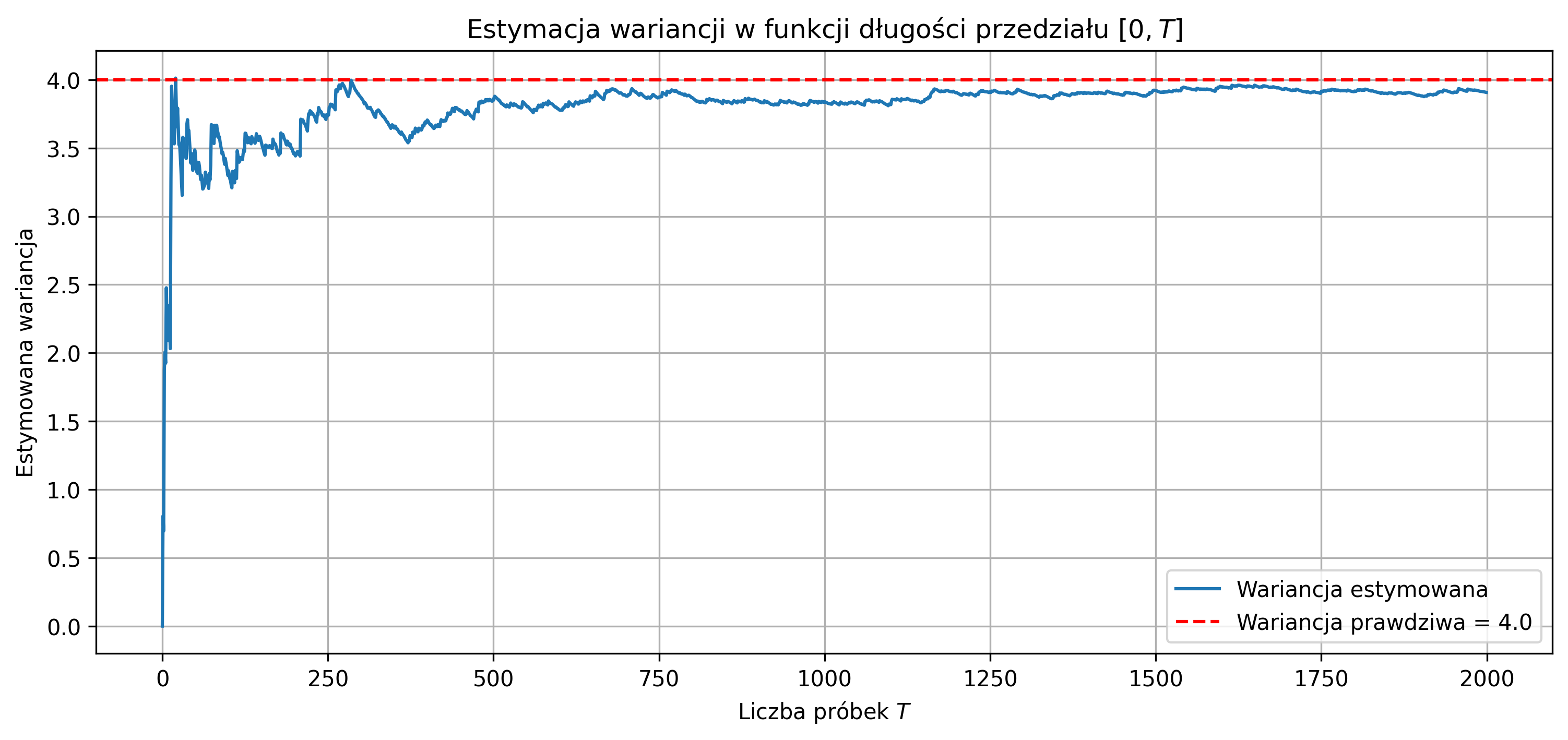

Na rys. 2.8 przedstawiono okresowy sygnał prostokątny o amplitudzie \( A = 2 \), którego moc średnia jest ograniczona i równa \(4\) (\( A^2 \)), zaś jego energia z czasem rośnie do nieskończoności.

Do sygnałów o ograniczonej energii zaliczamy:

- sygnały impulsowe o ograniczonej amplitudzie, np.:

- impuls prostokątny, trójkątny, radiowy,

- impulsowy skurcz mięśnia w EMG,

- sygnały o nieskończonym czasie trwania, np.:

- sygnał sinusoidalny malejący,

- sygnał Gaussa,

- sygnał wykładniczy malejący – odpowiedź tkanek na krótki impuls stymulacji nerwowej w badaniu przewodnictwa (ENG), podczas którego rejestruje się odpowiedź mięśni lub nerwu,

- sygnały nieustalone, np.:

- drgania tłumione,

- sygnał EEG z napadem padaczkowym – nieregularny i zmienny, po napadzie zwykle wraca do wartości typowych.

Sygnały o ograniczonej mocy i ograniczone w amplitudzie są sygnałami o nieskończonym czasie trwania:

- sygnały nieokresowe, np.:

- długotrwały EMG przy skurczu izometrycznym – stała aktywność mięśnia, np. przy utrzymywaniu pozycji,

- sygnały okresowe, np.:

- sygnał sinusoidalny, fala prostokątna bipolarna,

- długotrwały sygnał EKG – ciągła rejestracja rytmu serca, np. z użyciem Holtera, sygnał okresowy i stabilny, o regularnym rytmie serca.

Szczególną podklasą sygnałów o ograniczonej mocy są sygnały okresowe. Sygnał opisany funkcją okresową czasu nazywamy sygnałem okresowym. Dla sygnału okresowego \( x(t) \) istnieje taka wartość \( T \), dla której spełniony jest warunek:

dla każdego \( t \). Czas \( T \) nazywamy okresem sygnału, \( k \) jest liczbą całkowitą. W każdej chwili czasu \( t \) przesunięcie na osi czasu o okres lub jego wielokrotność nie zmienia wartości sygnału. Odwrotność okresu podstawowego nazywamy częstotliwością sygnału:

Jednostką częstotliwości jest herc (jeden Hz stanowi pojedynczą oscylację, okres lub cykl na sekundę). Częstotliwością kątową (pulsacją) nazywamy szybkość zmiany fazy sygnału okresowego w czasie:

Częstotliwość kątową określa się w radianach na sekundę (rd/s).

Gdy sygnał jest okresowy o okresie \( T \), uśrednianie w czasie nieskończonym jest równoważne uśrednianiu za okres. Wtedy wartością średnią ciągłego sygnału okresowego \( x(t) \) jest:

gdzie \( t_0 \) jest dowolną chwilą. Moc średnia ciągłego sygnału okresowego jest równa mocy średniej w jednym okresie \( T \):

dla dowolnej chwili \( t_0 \). Jeżeli energia sygnału okresowego, przypadająca na pojedynczy okres \( T \), jest różna od zera, to całkowita energia sygnału \( E_x \) jest nieskończona.

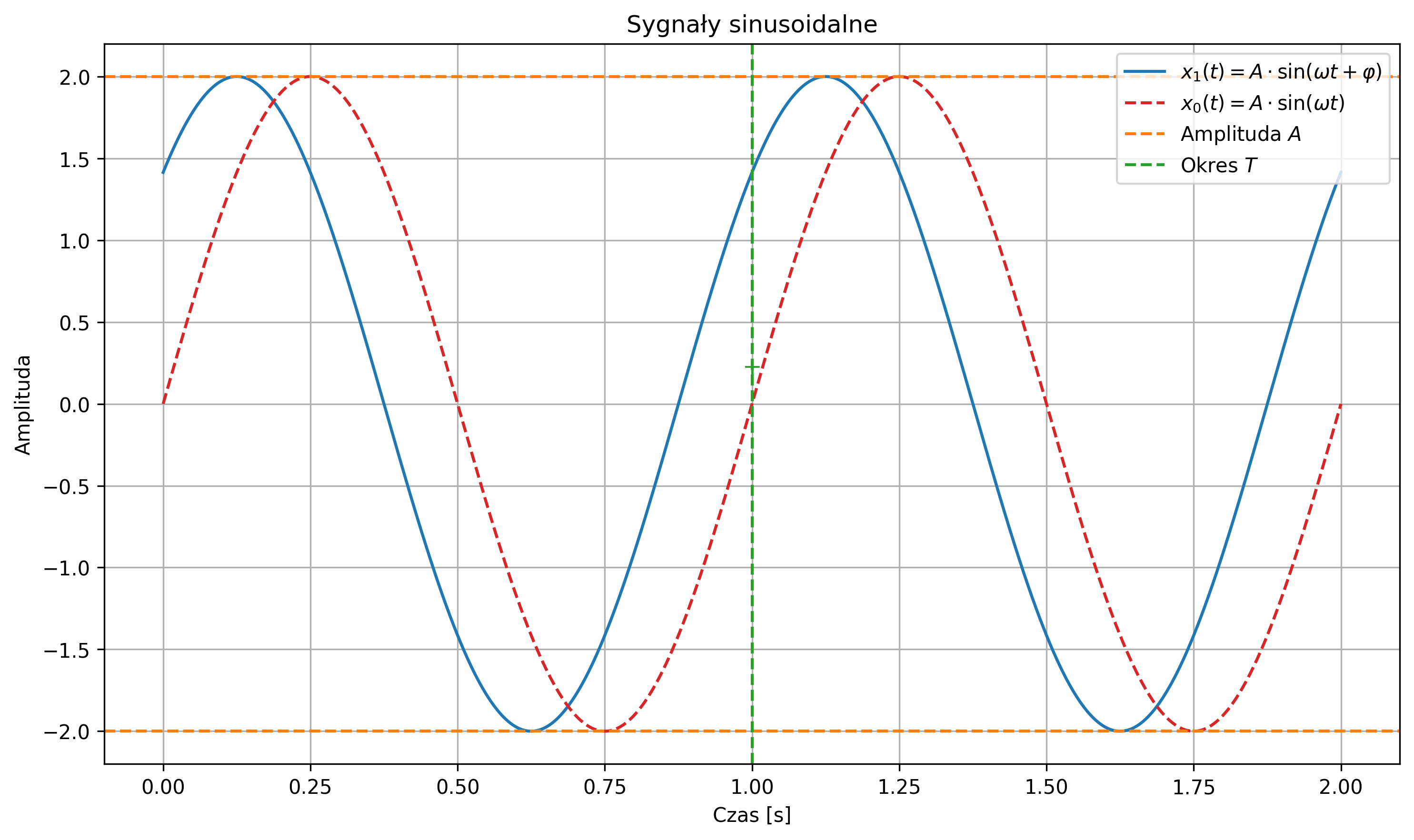

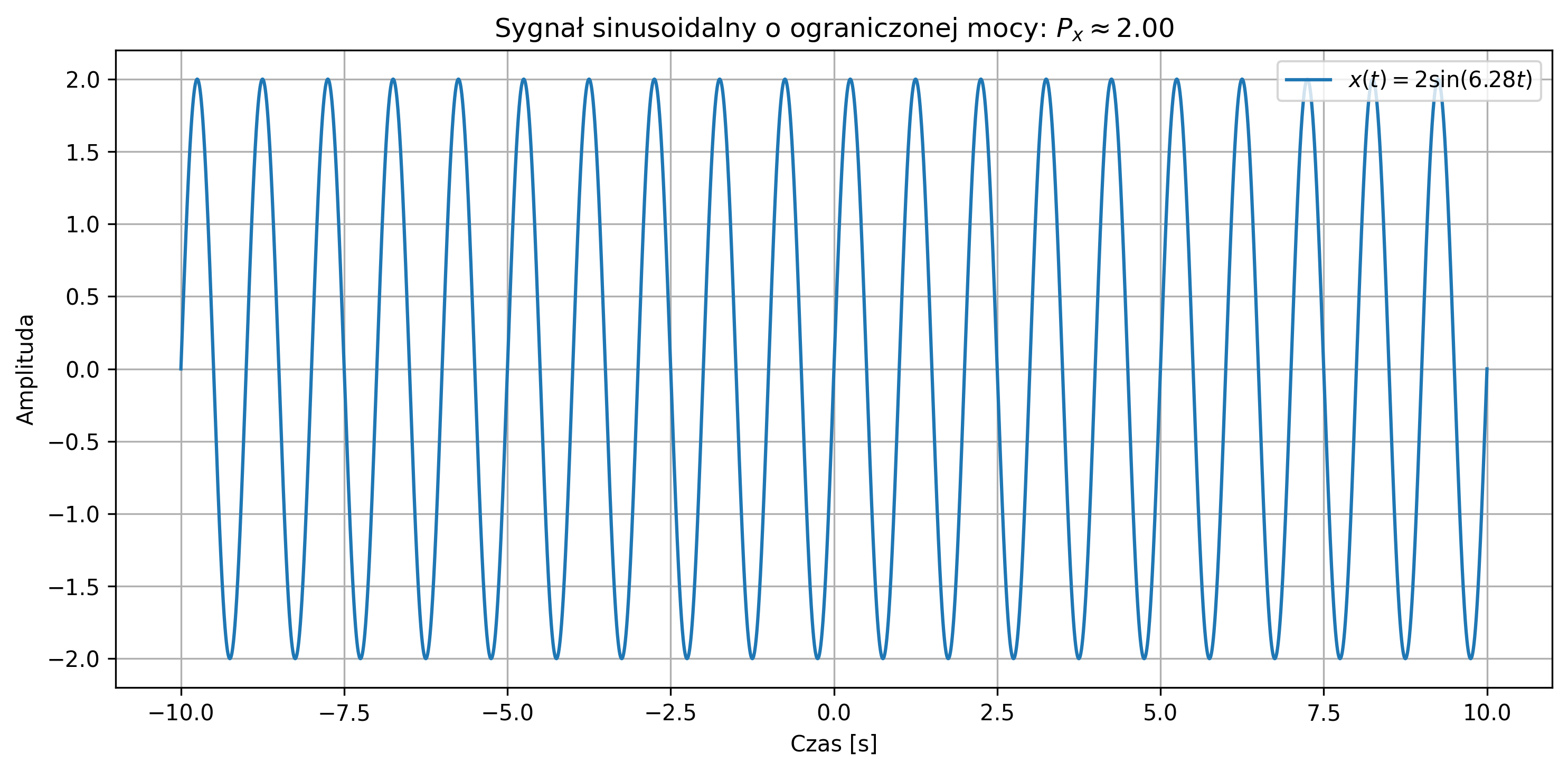

Najbardziej znanym sygnałem okresowym jest sygnał sinusoidalny (rys. 2.9):

gdzie:

- \( A \) to amplituda sygnału,

- \( \omega \) to pulsacja sygnału,

- \( f \) to częstotliwość sygnału,

- \( \varphi \) to faza sygnału.

Wartość średnia sygnału sinusoidalnego wynosi \( 0 \) (w rzeczywistości \( \approx 0 \)), zaś jego moc średnia zależy tylko od amplitudy i jest równa \( A^2 / 2 \). Suma sygnałów sinusoidalnych o różnych częstotliwościach jest także sygnałem okresowym. Stanowi to istotny fakt przy analizie częstotliwościowej sygnałów.

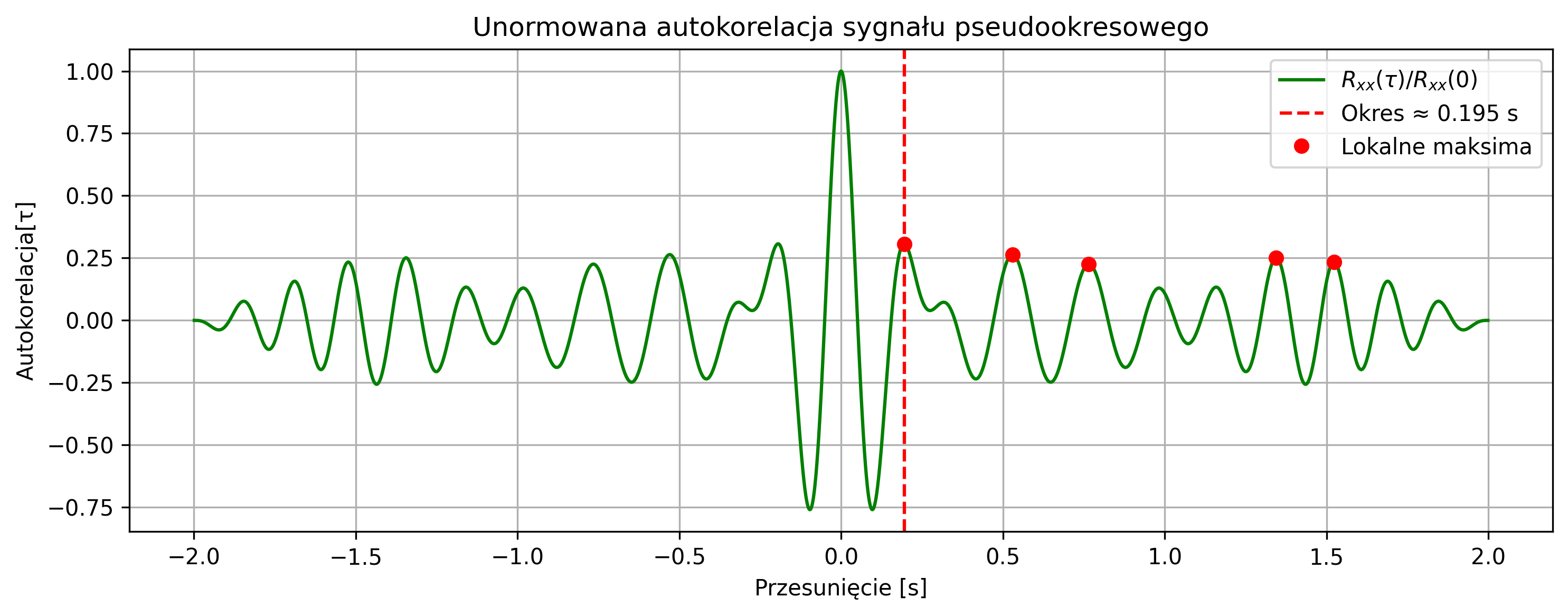

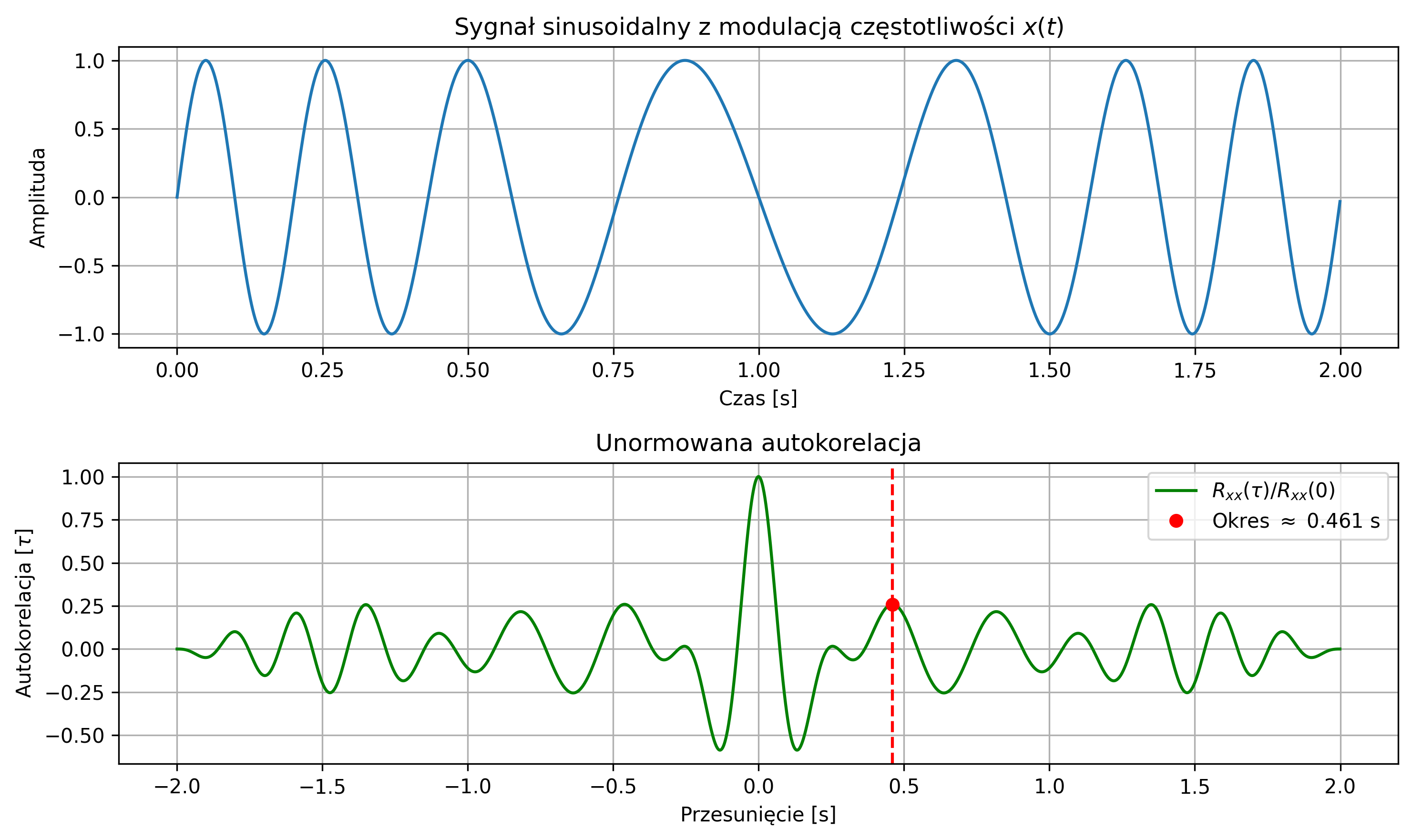

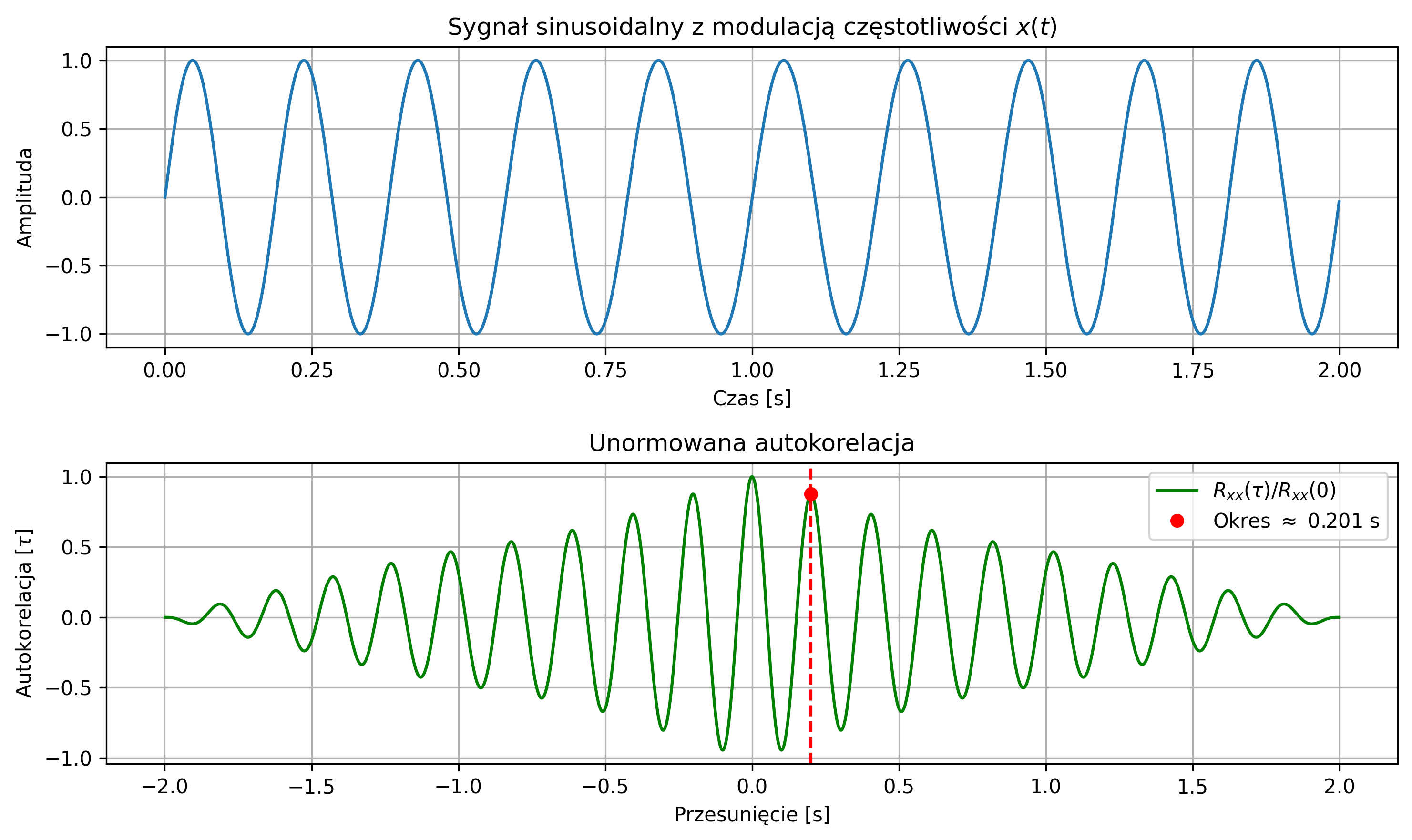

W rzeczywistości możemy mieć do czynienia z sygnałami pseudookresowymi, które nie są idealnie okresowe – kształt przebiegu powtarza się tylko orientacyjnie. Takie pseudookresy występują w sygnałach, np. dźwięku czy EEG i EKG. Przykładem takiego sygnału jest sygnał sinusoidalny z modulacją częstotliwości:

gdzie:

- \( A \) to amplituda sygnału,

- \( f \) to częstotliwość nośna sygnału,

- \( \beta \) to głębokość modulacji,

- \( f_m \) to częstotliwość modulacji.

Ponieważ modulacja takiego sygnału zmienia częstotliwość, ale nie zmienia amplitudy, to moc średnia takiego sygnału nadal wynosi \( A^2 / 2 \).

2.6. Korelacja wzajemna i autokorelacja

Kolejnym, alternatywnym sposobem charakteryzowania sygnałów w dziedzinie czasu jest opis korelacyjny. W przetwarzaniu sygnałów, korelacja wzajemna (ang. Cross-Correlation) jest miarą podobieństwa dwóch sygnałów.

Funkcja korelacji wzajemnej rzeczywistych sygnałów o ograniczonej energii to iloczyn skalarny dwóch sygnałów w funkcji przesunięcia jednego z nich i wyraża się wzorem:

gdzie:

- \( x(t) \) – pierwszy sygnał,

- \( y(t-\tau) \) – drugi sygnał przesunięty, ale nie odwrócony w czasie,

- \( \tau \) – przesunięcie.

Analogicznie definiuje się funkcję korelacji wzajemnej między sygnałem \( y(t) \) a sygnałem \( x(t) \):

W funkcji korelacji, drugi sygnał opóźnia się w stosunku do pierwszego o czas \( \tau \), następnie oba sygnały wymnaża się przez siebie i całkuje ich iloczyn. W ten sposób dla każdego przesunięcia \( \tau \) otrzymuje się wartość, która określa na ile opóźniony drugi sygnał jest podobny do sygnału pierwszego. Jest to operacja bardzo podobna do splotu, gdyż mierzy jak bardzo dwa sygnały są do siebie podobne, gdy jeden z nich jest przesuwany w czasie względem drugiego. Jednakże, w przeciwieństwie do operacji splotu, obliczając korelację nie odwracamy w czasie jednego z sygnałów.

Można pokazać, że

co oznacza, że taką samą wartość iloczynu skalarnego otrzymujemy przy przesunięciu sygnału \( y(t) \) w kierunku opóźnienia o czas \( \tau \), jak i przy przesunięciu sygnału \( x(t) \) o ten sam czas w kierunku przyspieszenia.

Funkcja korelacji wzajemnej dla dyskretnych sygnałów \( x \) i \( y \) przyjmuje postać:

Korelacja wzajemna pozwala wykrywać opóźnienia sygnałów względem siebie – położenie maksimum funkcji korelacji wskazuje na przesunięcie, które daje największe podobieństwo sygnałów.

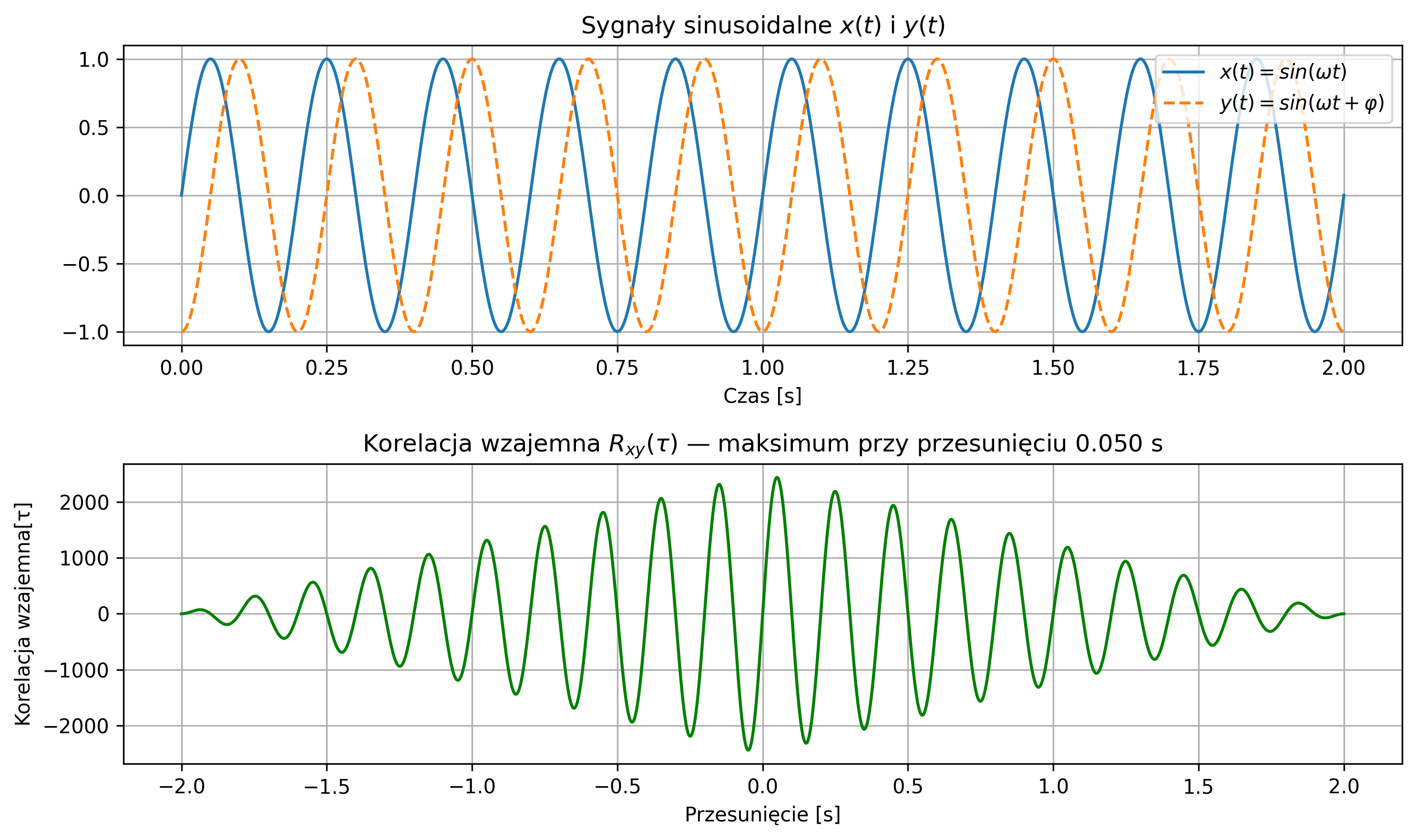

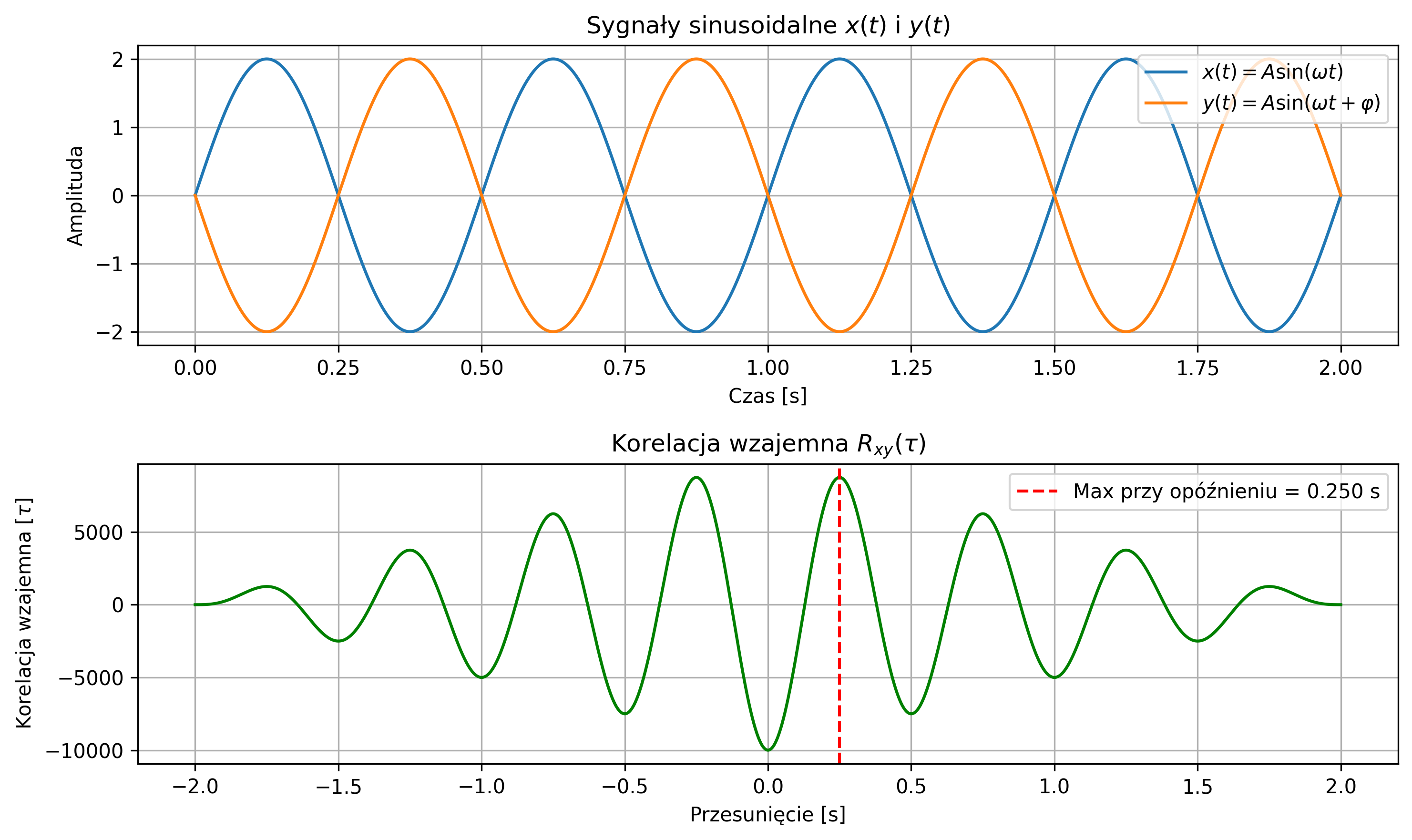

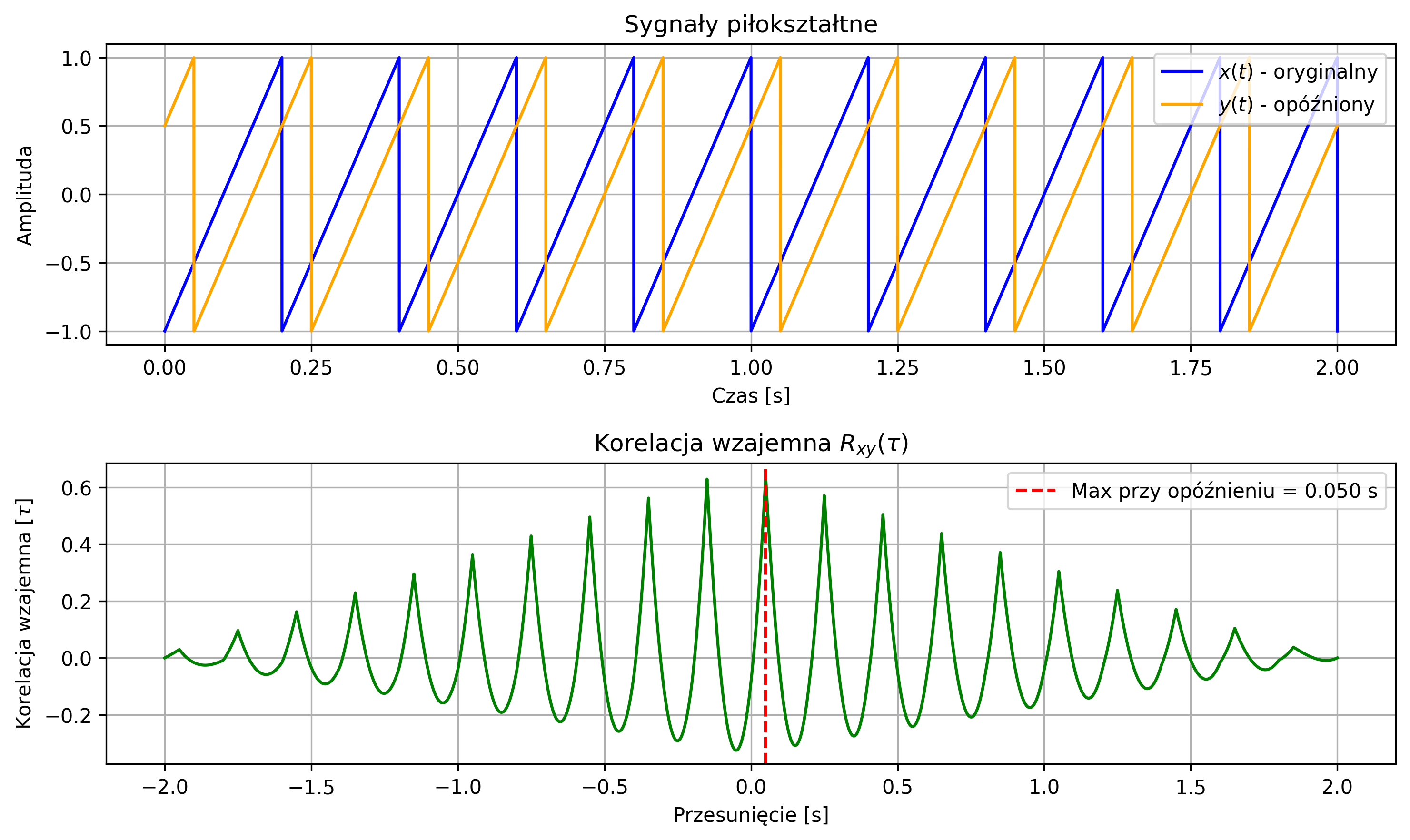

Na rys. 2.10 zostało pokazane wykorzystanie funkcji korelacji wzajemnej do wykrycia przesunięcia jednej sinusoidy:

względem drugiej \( y(t)=\sin(\omega t) \). Wykres korelacji wzajemnej pokazuje maksimum przy opóźnieniu \( \tau \), które wyniosło \( 0.25 \) s (\( \varphi=-7.85 \)).

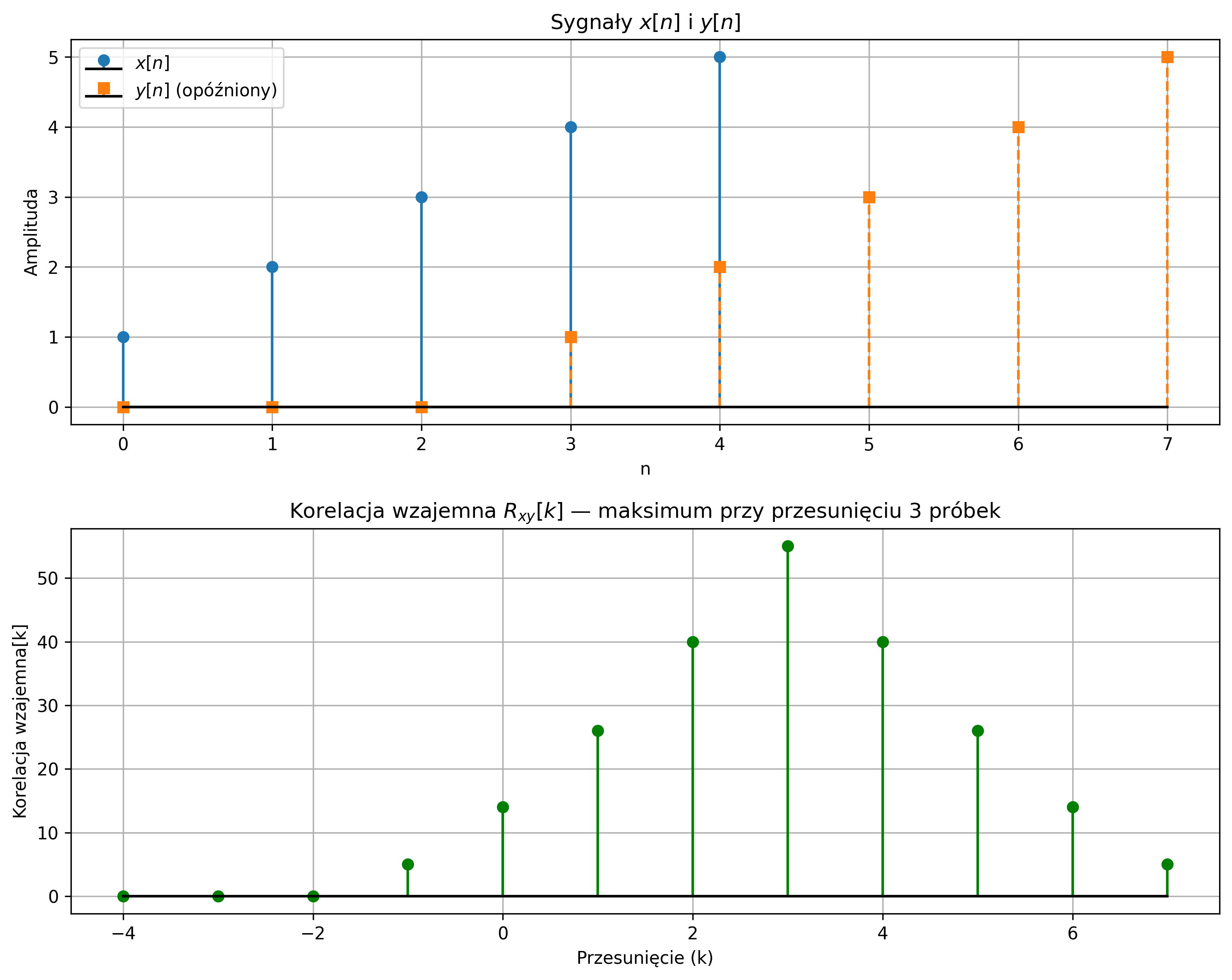

Analogiczny przykład, w wersji dyskretnych sygnałów został przedstawiony na rys. 2.11. Pokazany został przebieg ciągu próbek sygnału \( x = [1,2,3,4,5] \) oraz sygnału \( y \), który jest opóźnionym sygnałem \( x \) o 3 próbki. Korzystając z funkcji korelacji wzajemnej, wykryte zostało opóźnienie jednego sygnału względem drugiego – funkcja korelacji wzajemnej pokazała maksimum przy tym przesunięciu.

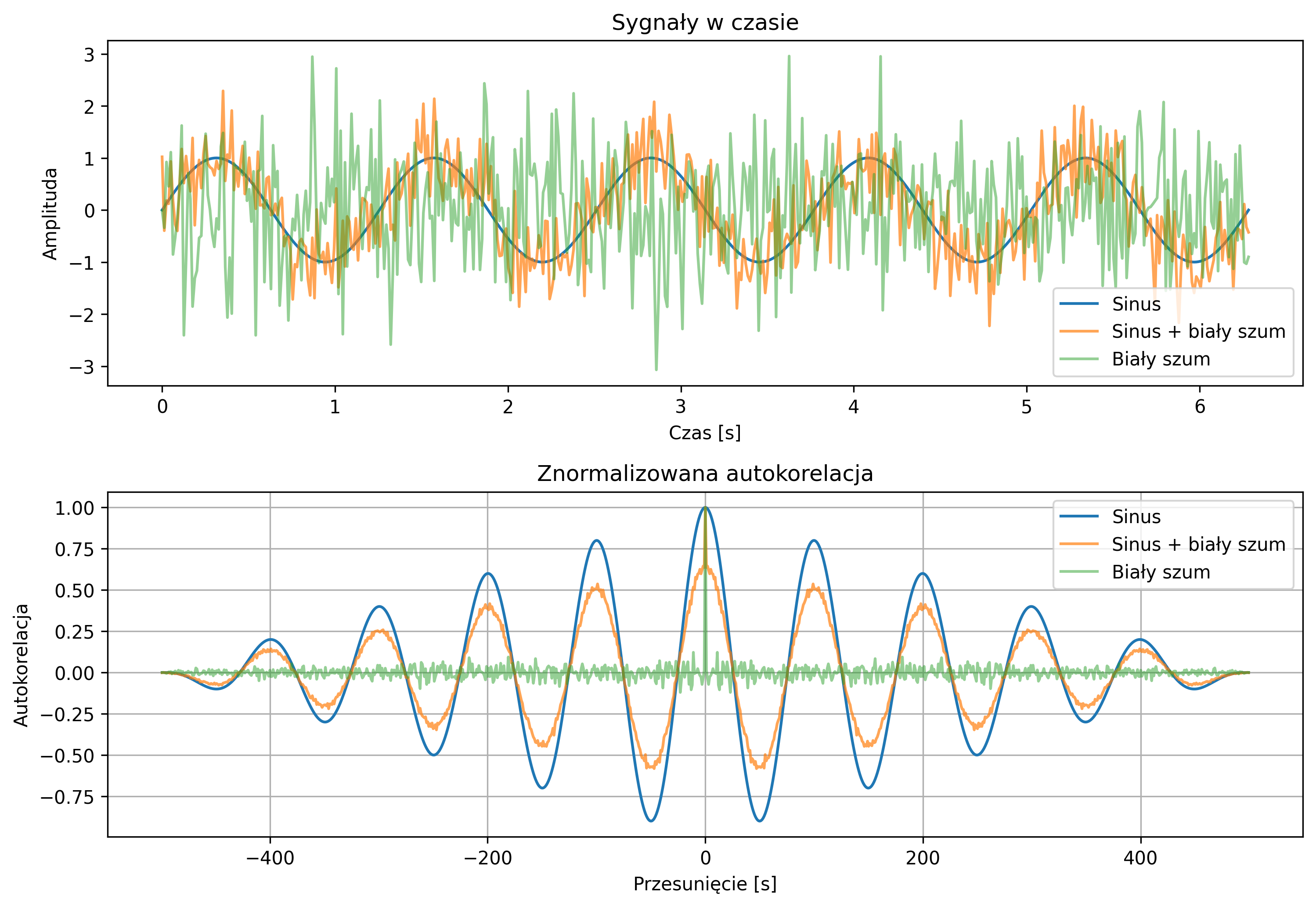

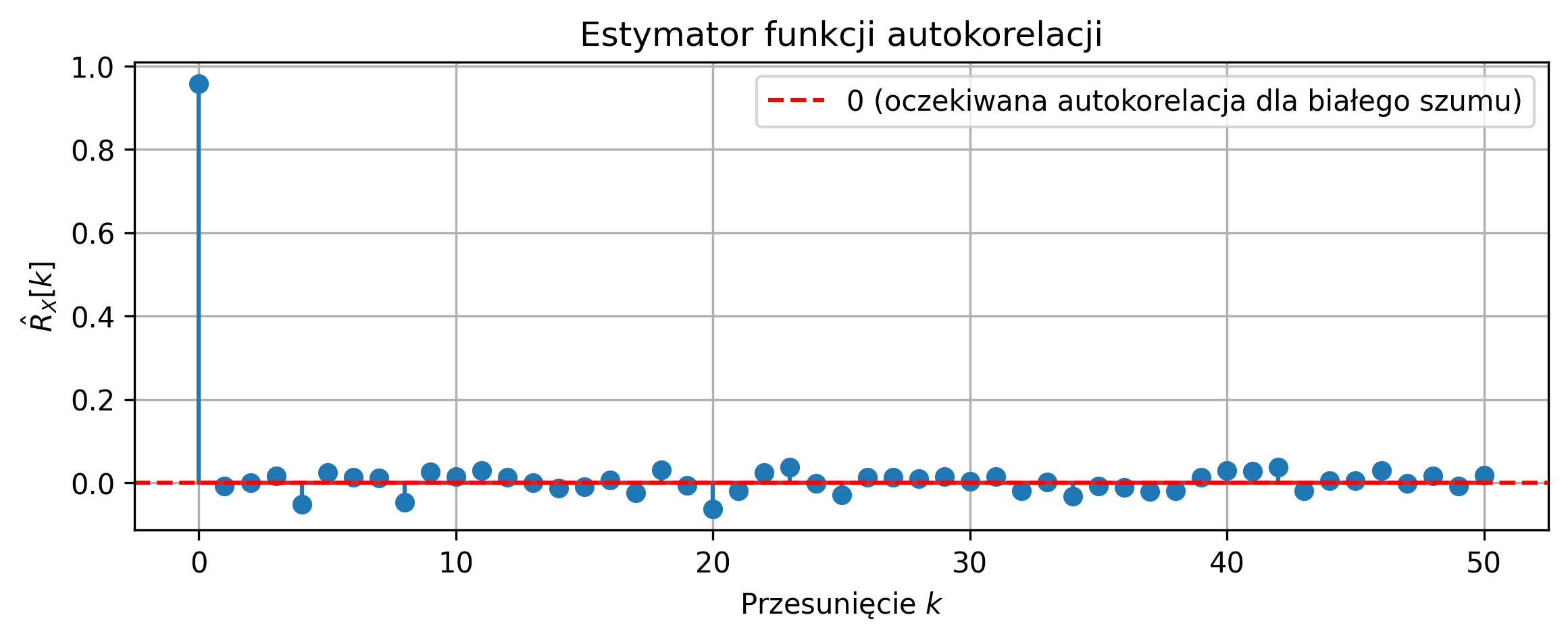

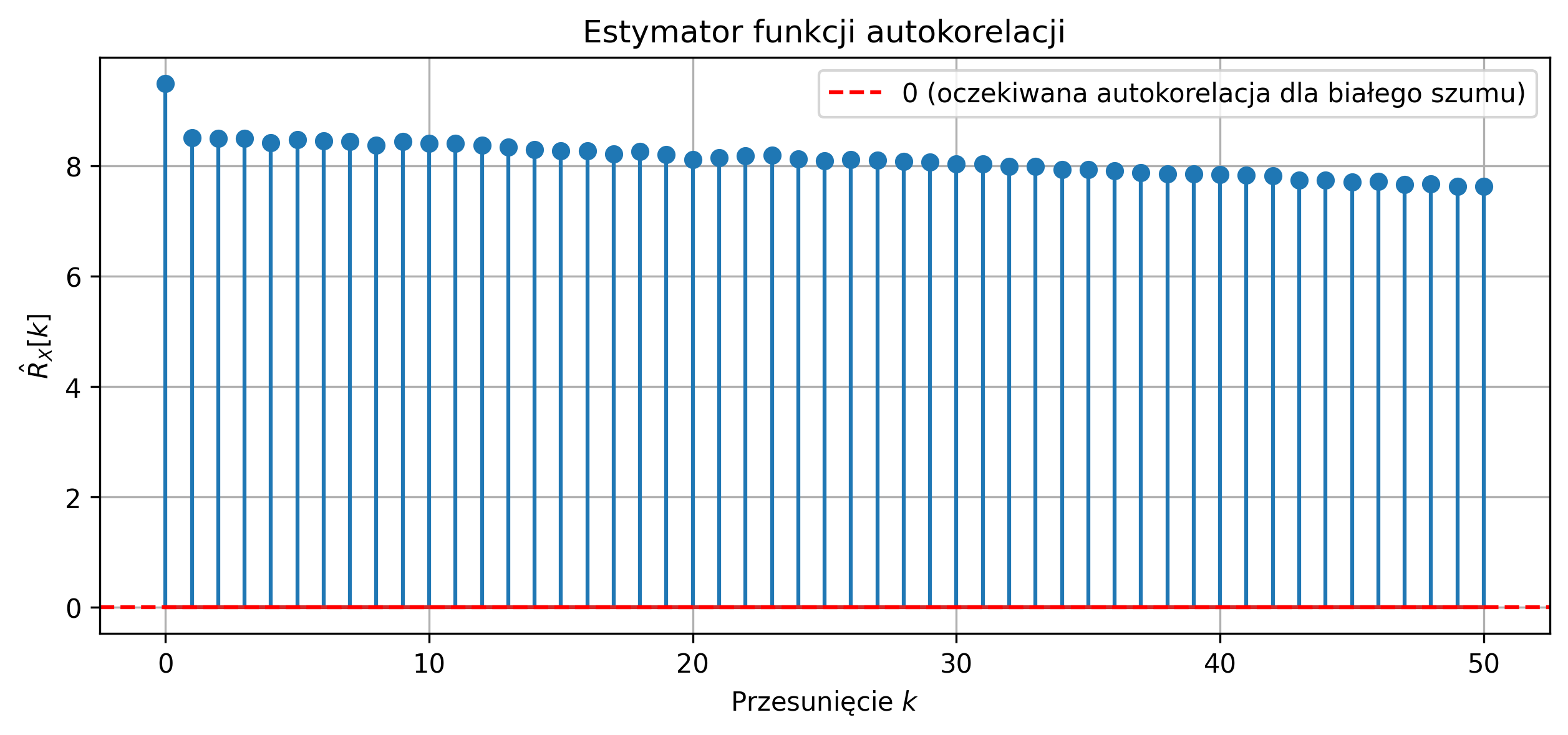

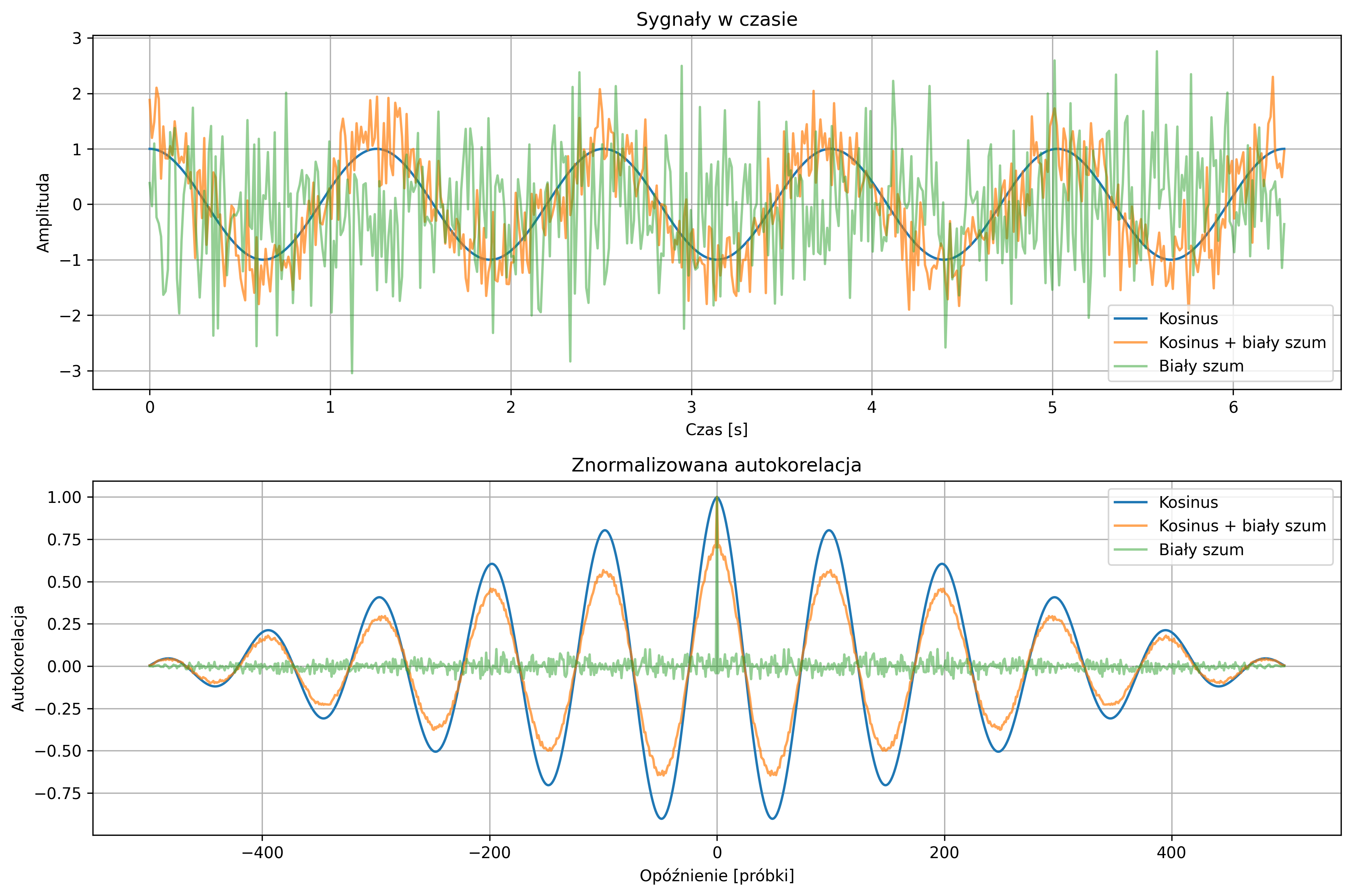

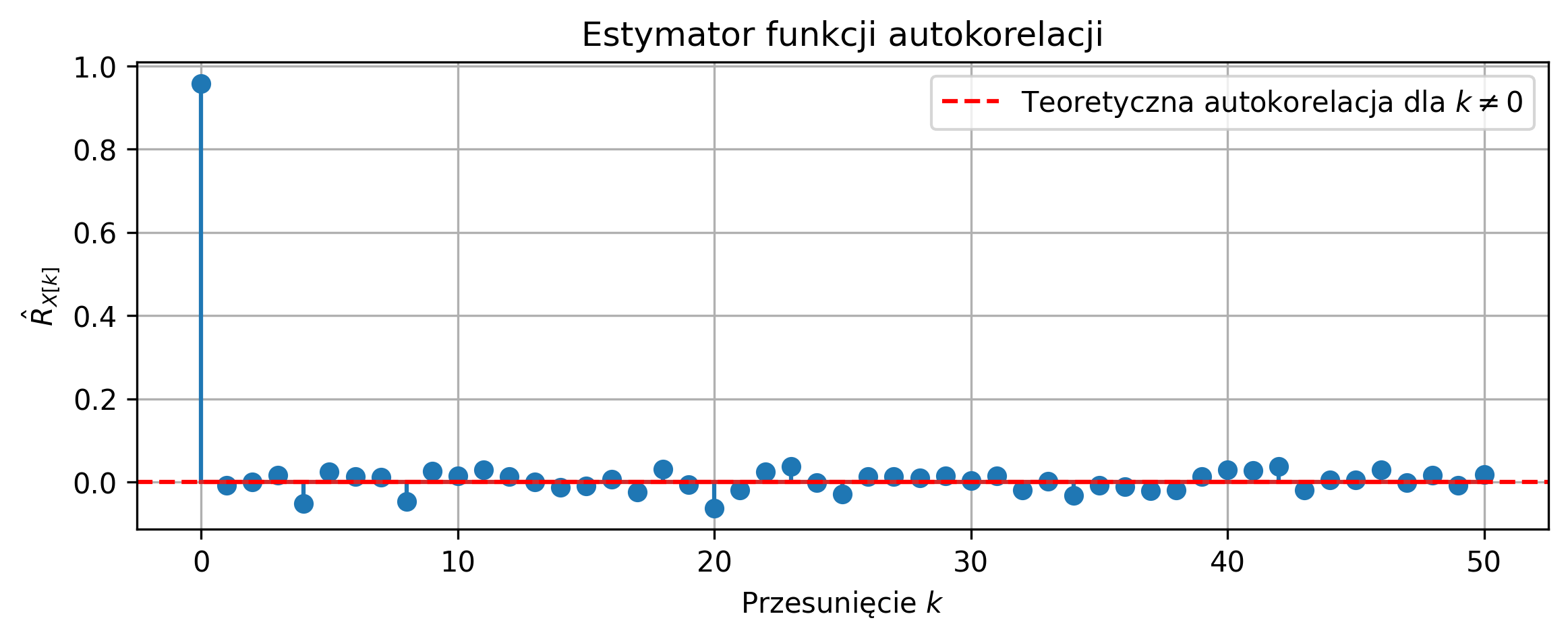

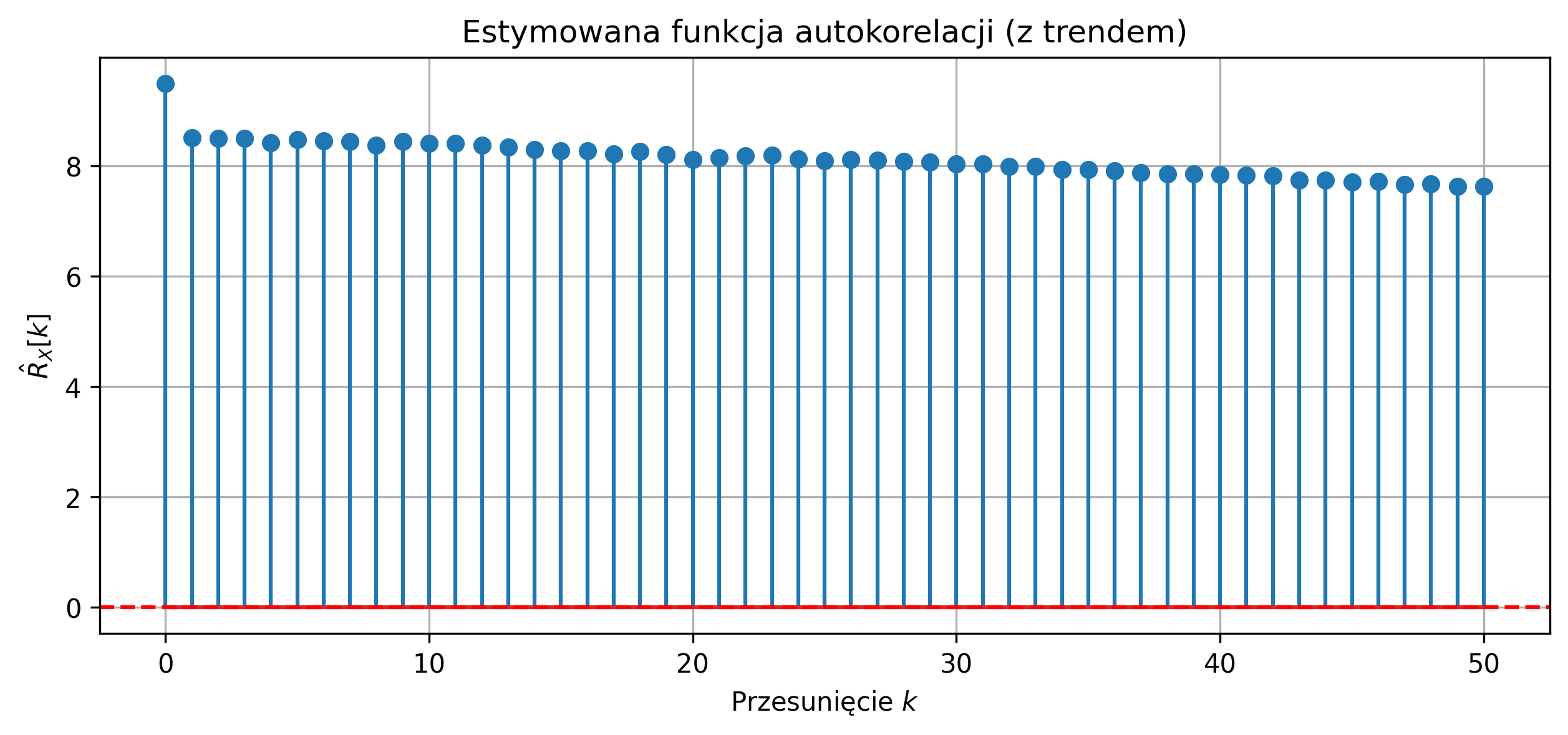

Szczególnym przypadkiem korelacji wzajemnej, gdy sygnał jest porównywany sam ze sobą, jest autokorelacja (ang. Autocorrelation). Autokorelacja dla danej wartości przesunięcia opisuje podobieństwo sygnału do jego przesuniętej w czasie kopii. Największe podobieństwo uzyskamy dla zerowego przesunięcia, gdy oba korelowane sygnały są identyczne.

Funkcja autokorelacji dla rzeczywistych sygnałów o ograniczonej energii:

gdzie:

- \( x(t) \) – pierwszy sygnał,

- \( x(t-\tau) \) – ten sam sygnał przesunięty, ale nie odwrócony w czasie,

- \( \tau \) – przesunięcie,

jest rzeczywista i parzysta – nie ma znaczenia, w którą stronę przesuwamy kopię sygnału: \( R_{xx}(\tau)=R_{xx}(-\tau) \).

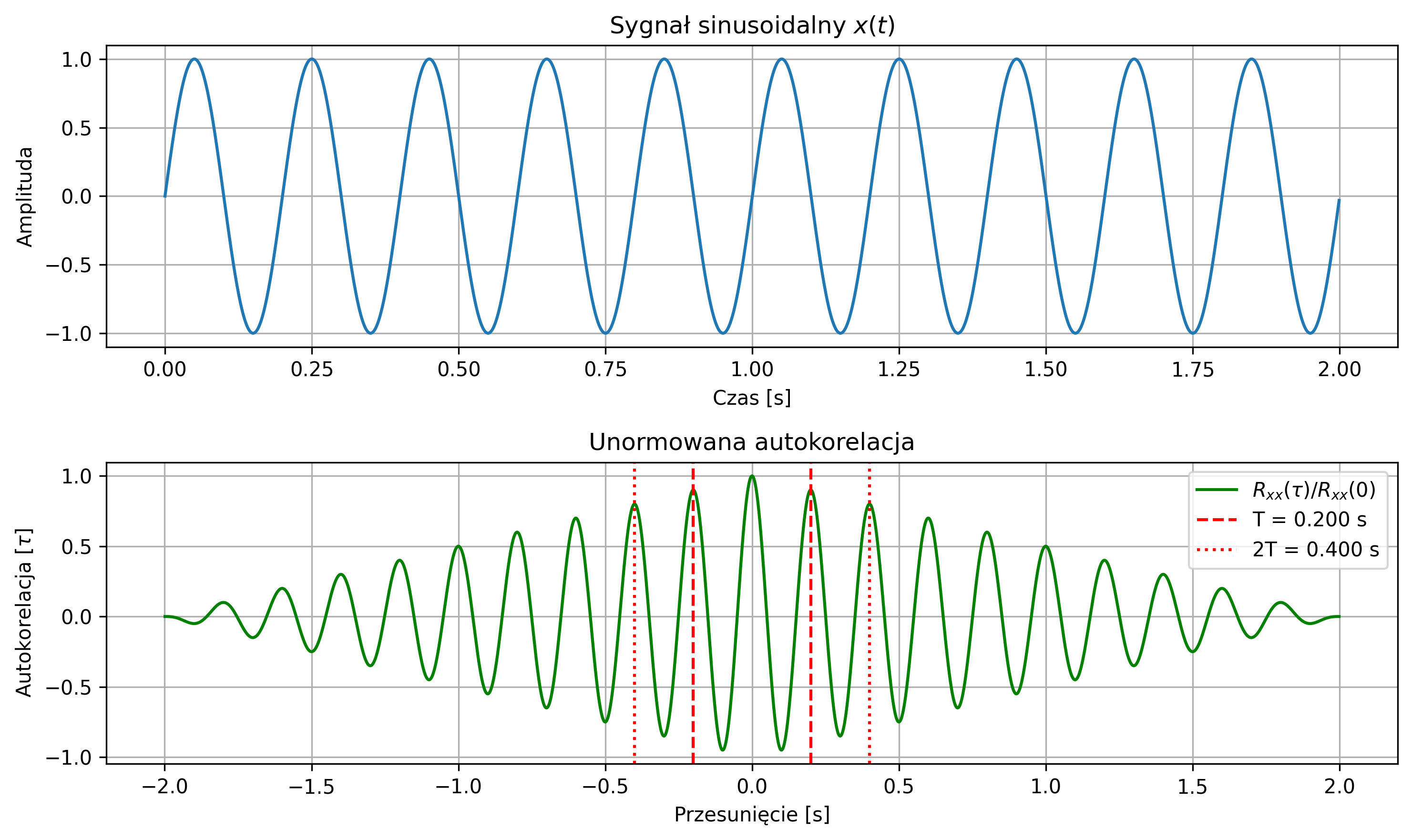

Autokorelacja jest przede wszystkim wykorzystywana do badania okresowości sygnału, ponieważ przyjmuje ona wartości maksymalne dla wartości przesunięcia \( \tau \) równego wielokrotności okresu sygnału. Może również posłużyć do wykrywania pewnych regularności w sygnałach – np. regularnych cykli tętna w przebiegu fal EEG.

Funkcja autokorelacji sygnału o ograniczonej energii jest także funkcją o ograniczonej energii. Zauważmy, że wartość funkcji autokorelacji w punkcie \( \tau = 0 \) jest równa energii sygnału:

Unormowana funkcja autokorelacji powstaje przez podzielenie wartości funkcji autokorelacji przez energię sygnału. Wtedy, dla zerowego przesunięcia, wartość autokorelacji przyjmuje wartość maksymalną, równą \(1\). Dzięki temu można porównywać kształt funkcji autokorelacji różnych sygnałów niezależnie od ich amplitudy i energii.

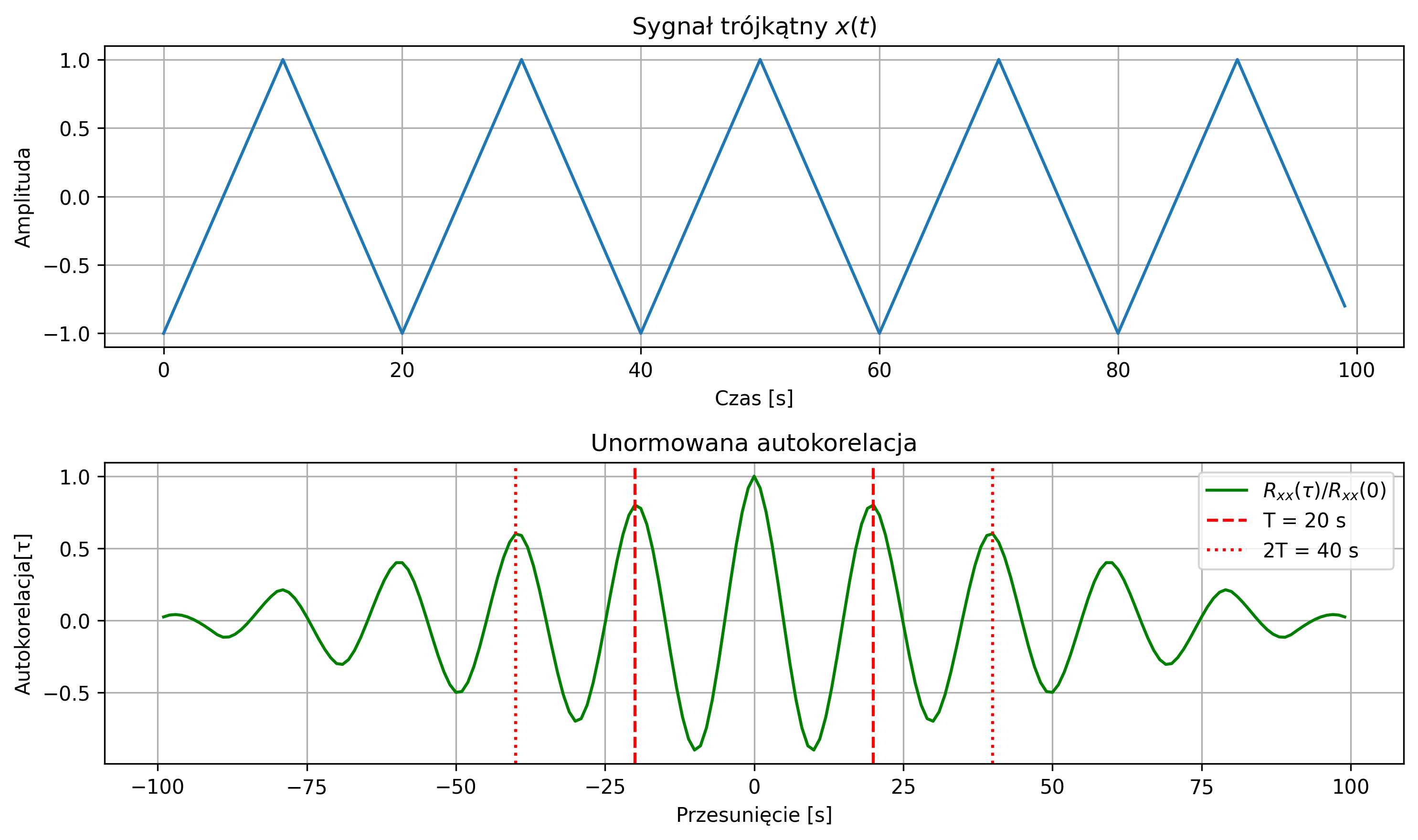

Na rys. 2.12 przedstawiono wykres sygnału trójkątnego i jego unormowanej funkcji autokorelacji. Ponieważ sygnał jest okresowy, maksima funkcji autokorelacji znajdują się w punktach równych wielokrotności okresu.

2.7. Sygnały zespolone

Oprócz sygnałów rzeczywistych, wykorzystywane są sygnały zespolone, które pomimo abstrakcyjnego charakteru ułatwiają analizę i przetwarzanie – zwłaszcza w dziedzinie częstotliwości. Sygnał zespolony przyjmuje wartości zespolone i ma postać algebraiczną:

gdzie

- \( x(t) = \operatorname{Re}\{z(t)\} \) i \( y(t) = \operatorname{Im}\{z(t)\} \) są sygnałami rzeczywistymi,

- \( j \) jest jednostką urojoną, dla której \( j^2 = -1 \)

Sygnał zespolony można również przedstawić w postaci wykładniczej:

gdzie

- \( |z(t)| = \sqrt{x^2(t)+y^2(t)} \) jest modułem sygnału,

- \( \varphi(t) = \arctan\frac{y(t)}{x(t)} \) jest argumentem sygnału.

Sygnałem sprzężonym z sygnałem \( z(t) \) nazywamy sygnał:

Sygnały zespolone również dzielimy na sygnały o ograniczonej energii i ograniczonej mocy. Wzory na energię i moc sygnałów zespolonych są zdefiniowane identycznie jak w przypadku sygnałów rzeczywistych, z tą różnicą, że w ich sformułowaniach pojawia się moduł \( |x(t)|^2 \) zamiast kwadratu sygnału \( x^2(t) \).

Analogiczne są również wzory na funkcję korelacji wzajemnej i funkcję autokorelacji sygnałów zespolonych o ograniczonej energii, z tą różnicą, że w iloczynie skalarnym pojawia się sprzężone zespolone przesunięcie jednego z sygnałów:

Najbardziej znanymi sygnałami zespolonymi są:

- zespolony sygnał sinusoidalny:

- sygnał analityczny, który powstaje z rzeczywistego sygnału \( x(t) \):

którego częścią rzeczywistą jest sygnał \( x(t) \), a częścią urojoną jest transformata Hilberta sygnału \( x(t) \).

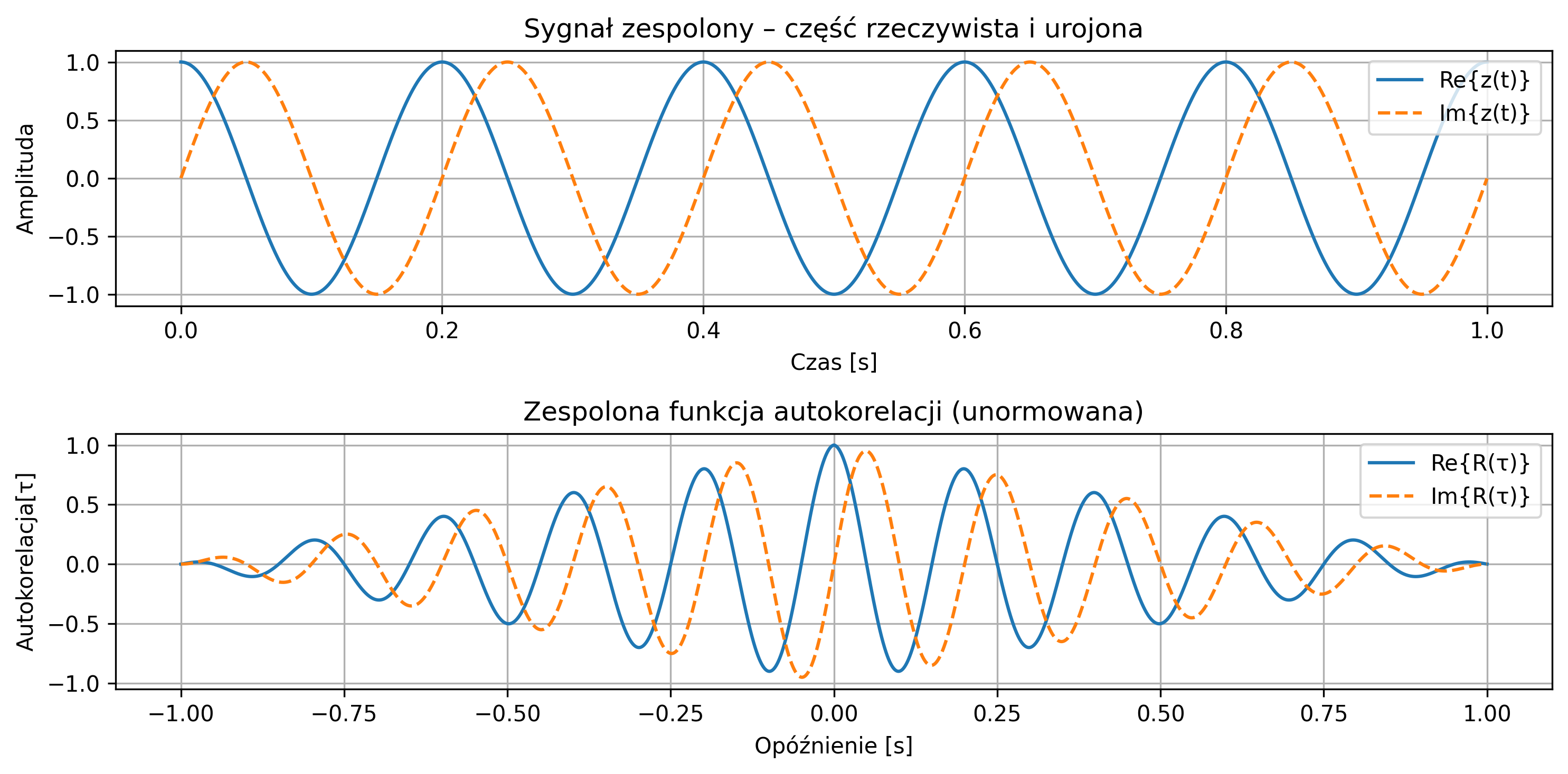

Na rys. 2.14 przedstawiono zespolony sygnał \( z(t) = e^{j2\pi f t} \) – przebieg jego części rzeczywistej i urojonej. Podobnie jak dla sygnałów rzeczywistych, można z wykresów odczytać, jak wyglądają oscylacje w dziedzinie czasu, powtarzalność i strukturę fazową, a także oszacować, jaki jest okres. Energia i moc przykładowego sygnału wynosi \(1\).

- amplituda chwilowa – moduł sygnału,

- faza chwilowa – zmiana kąta argumentu,

- obwiednia sygnału rzeczywistego – sposób, w jaki „kształt” energii sygnału zmienia się w czasie.

Ponadto sygnały zespolone są szeroko stosowane w przetwarzaniu sygnałów biomedycznych, takich jak EKG czy EEG, gdzie analiza fazy i obwiedni jest kluczowa dla diagnozy, na przykład przy wykrywaniu drżeń mięśni, zaburzeń rytmu serca lub analizie związków między regionami mózgu.

2.8. Reprezentacja sygnałów w języku Python

Celem poniższych ćwiczeń jest zapoznanie się z wybranymi typami sygnałów oraz nabycie praktycznych umiejętności w generowaniu i wizualizacji ich przebiegów, a także poznanie podstawowych funkcji i komend w języku Python przydatnych w analizie sygnałów.

Poniższe przykłady przedstawiają pełne kody źródłowe w języku Python, opracowane na potrzeby realizacji poszczególnych zadań. Do wykonania przedstawionych zadań wymagane jest wykorzystanie następujących bibliotek języka Python:

import numpy as np # obliczenia numeryczne i tablice

import matplotlib.pyplot as plt # tworzenie wykresów ciągłych i dyskretnych

import scipy.signal as signal # generowanie standardowych sygnałów,

# takich jak np. prostokątny, trójkątny, piłokształtny

oraz wymagana jest znajomość między innymi następujących poleceń i funkcji języka Python:

np.arange, np.linspace # tworzenie wektorów czasu

plt.figure, plt.plot, plt.stem # rysowanie wykresów ciągłych i dyskretnych

plt.grid, plt.xlabel, plt.ylabel, plt.title, plt.legend # oznaczanie osi, tytułów, legend i siatki

np.sin, np.exp, np.pi # generowanie sygnałów sinusoidalnych, wykładniczych, stała pi

signal.square, signal.sawtooth, signal.chirp # generowanie sygnałów specjalnych

W zadaniach będziemy łączyć te funkcje w celu generowania, wizualizacji i analizy różnych typów sygnałów. Poniżej znajdują się ćwiczenia z przykładową implementacją. Autor zachęca czytelnika do samodzielnego uruchamiania kodów oraz do eksperymentowania z różnymi parametrami sygnałów poprzez ich modyfikację.

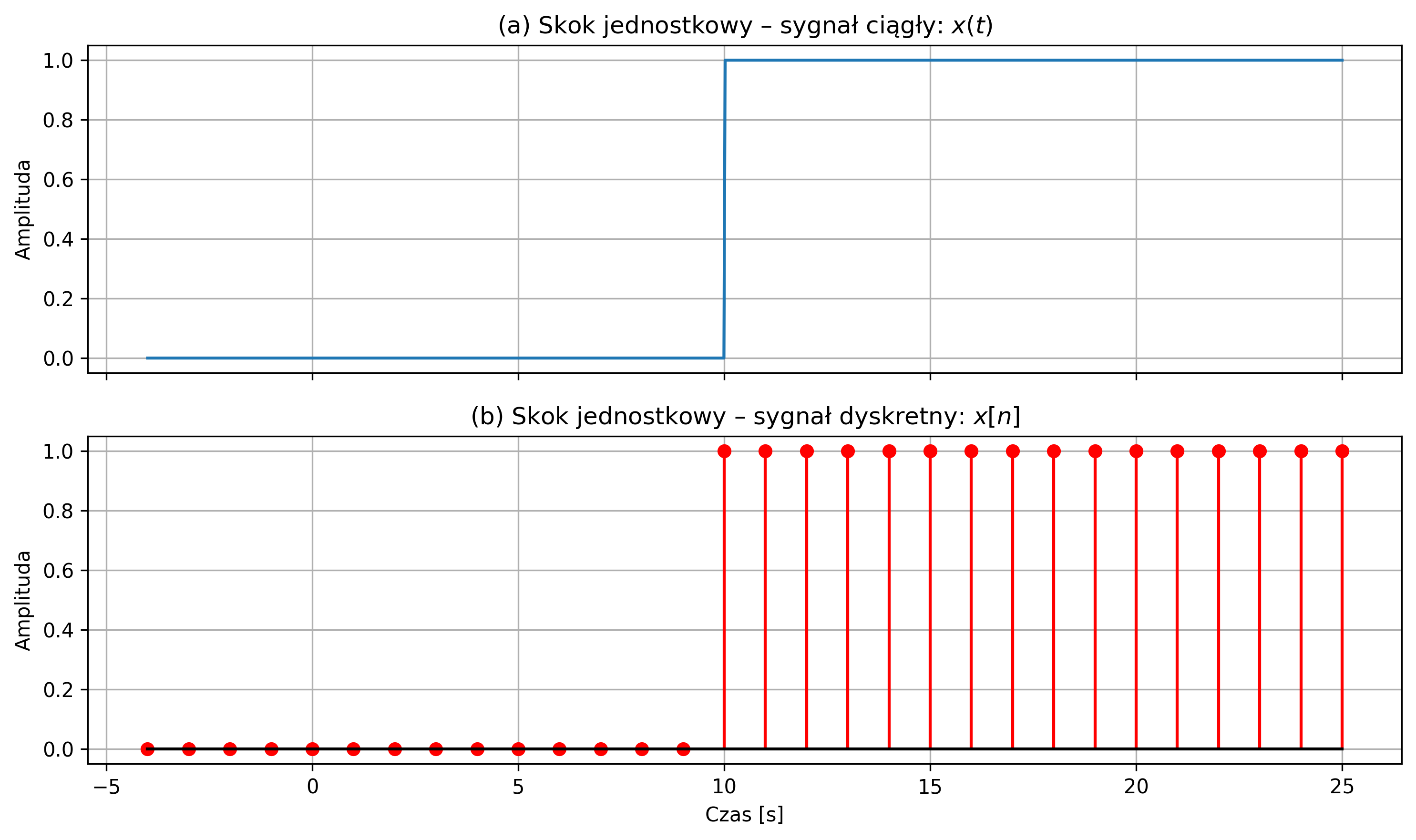

Wygenerować skok jednostkowy określony przez następujące równanie:

Narysować sygnał ciągły \(x(t)\) i jego wersję dyskretną \(x[n]\) dla \(N = 30\) próbek przy częstotliwości próbkowania \(f_s = 1\) Hz.

import numpy as np

import matplotlib.pyplot as plt

# Parametry sygnału

fs = 1 # częstotliwość próbkowania [Hz]

T = 1 / fs # okres próbkowania

n = np.arange(-4, 26) # 30 próbek: od -4 do 25

# Sygnał dyskretny: skok jednostkowy

x_disc = np.where(n >= 10, 1, 0)

# Sygnał ciągły (z większą rozdzielczością)

t_cont = np.linspace(-4, 25, 1000)

x_cont = np.where(t_cont >= 10, 1, 0)

# Tworzenie dwóch wykresów

fig, axs = plt.subplots(2, 1, figsize=(10, 6), sharex=True)

# Wykres 1: sygnał ciągły

axs[0].plot(t_cont, x_cont)

axs[0].set_title(r'(a) Skok jednostkowy – sygnał ciągły: $x(t)$')

axs[0].set_ylabel("Amplituda")

axs[0].grid(True)

# Wykres 2: sygnał dyskretny

axs[1].stem(n, x_disc, linefmt='r-', markerfmt='ro', basefmt='k-')

axs[1].set_title(r'(b) Skok jednostkowy – sygnał dyskretny: $x[n]$')

axs[1].set_xlabel('Czas [s]')

axs[1].set_ylabel('Amplituda')

axs[1].grid(True)

plt.tight_layout()

plt.show()

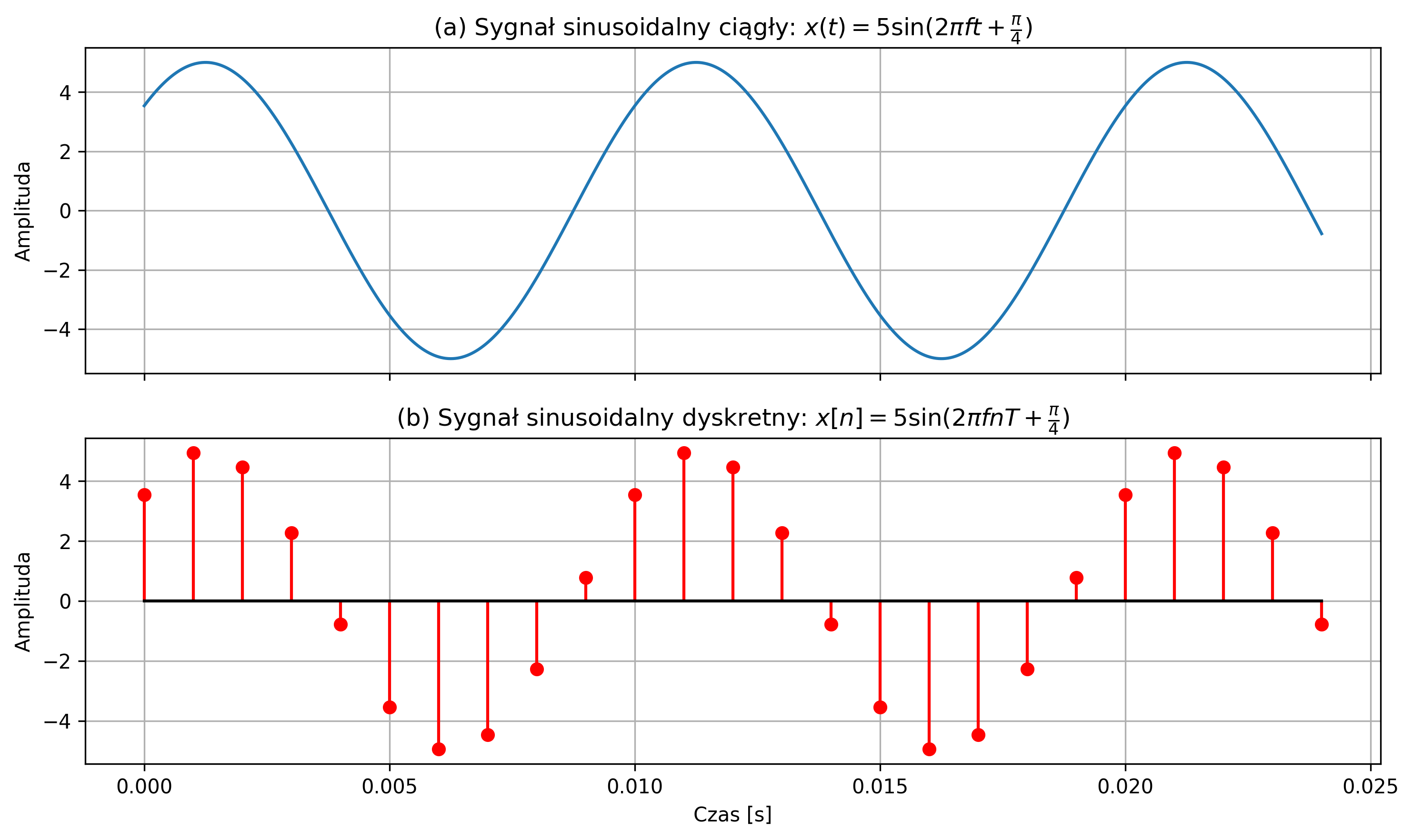

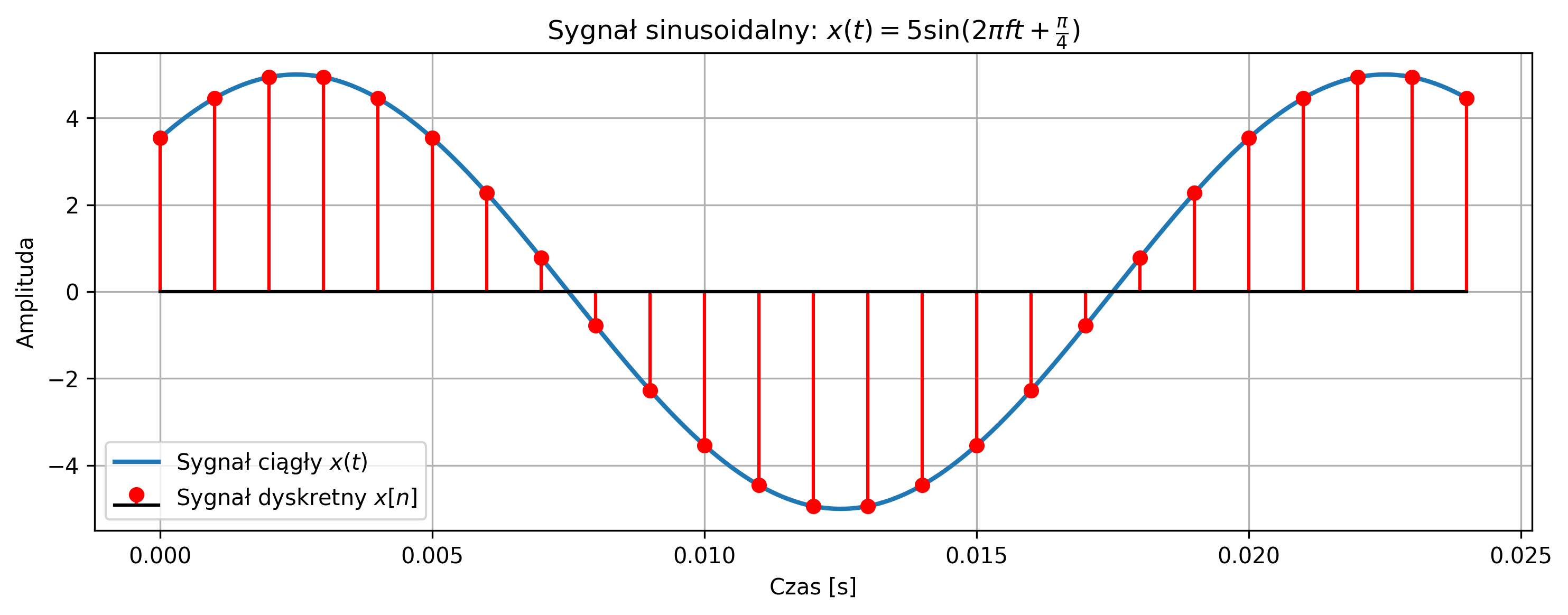

Wygenerować sygnał sinusoidalny określony przez następujące równanie:

o amplitudzie \( A = 5 \), częstotliwości sygnału \( f = 100 \) Hz i przesunięciu fazowym \( 45^{\circ} \). Narysować sygnał ciągły \(x(t)\) i jego wersję dyskretną \(x[n]\) dla \( N = 25 \) próbek, przyjmując częstotliwość próbkowania \( f_s =1000 \) Hz. Dodatkowo, sporządzić wspólny wykres sygnału ciągłego i dyskretnego na jednym rysunku.

import numpy as np

import matplotlib.pyplot as plt

# Parametry sygnału

fs = 1000 # częstotliwość próbkowania [Hz]

N = 25 # liczba próbek

A = 5 # amplituda

f = 100 # częstotliwość sygnału [Hz]

T = 1 / fs # okres próbkowania

phi = np.pi / 4 # przesunięcie fazowe [rad]

# Oś czasu: ciągła i dyskretna

t_cont = np.linspace(0, (N - 1) / fs, 1000)

n = np.arange(N)

t_disc = n * T

# Sygnały

x_cont = A * np.sin(2 * np.pi * f * t_cont + phi) # sygnał ciągły

x_disc = A * np.sin(2 * np.pi * f * t_disc + phi) # sygnał dyskretny

# Tworzenie dwóch wykresów

fig, axs = plt.subplots(2, 1, figsize=(10, 6), sharex=True)

# Wykres 1: sygnał ciągły

axs[0].plot(t_cont, x_cont)

axs[0].set_title(r'(a) Sygnał sinusoidalny ciągły: $x(t) =5\sin(2\pi f t + \frac{\pi}{4})$')

axs[0].set_ylabel('Amplituda')

axs[0].grid(True)

# Wykres 2: sygnał dyskretny

axs[1].stem(t_disc, x_disc, linefmt='r-', markerfmt='ro', basefmt='k-')

axs[1].set_title(r'(b) Sygnał sinusoidalny dyskretny: $x[n] = 5\sin(2\pi f nT + \frac{\pi}{4})$')

axs[1].set_xlabel('Czas [s]')

axs[1].set_ylabel('Amplituda')

axs[1].grid(True)

plt.tight_layout()

plt.show()

import numpy as np

import matplotlib.pyplot as plt

# Parametry sygnału

fs = 1000 # częstotliwość próbkowania [Hz]

N = 25 # liczba próbek

A = 5 # amplituda

f = 50 # częstotliwość sygnału [Hz]

T = 1 / fs # okres próbkowania

phi = np.pi / 4 # przesunięcie fazowe [rad]

# Oś czasu: ciągła i dyskretna

t_cont = np.linspace(0, (N - 1) / fs, 1000)

n = np.arange(N)

t_disc = n * T

# Sygnały

x_cont = A * np.sin(2 * np.pi * f * t_cont + phi) # sygnał ciągły

x_disc = A * np.sin(2 * np.pi * f * t_disc + phi) # sygnał dyskretny

# Wykres

plt.figure(figsize=(10, 4))

plt.plot(t_cont, x_cont, label=r'Sygnał ciągły $x(t)$', linewidth=2)

plt.stem(t_disc, x_disc, linefmt='r-', markerfmt='ro', basefmt='k-', label=r'Sygnał dyskretny $x[n]$')

plt.title(r'Sygnał sinusoidalny: $x(t) = 5\sin(2\pi f t + \frac{\pi}{4})$')

plt.xlabel('Czas [s]')

plt.ylabel('Amplituda')

plt.grid(True)

plt.legend()

plt.tight_layout()

plt.show()

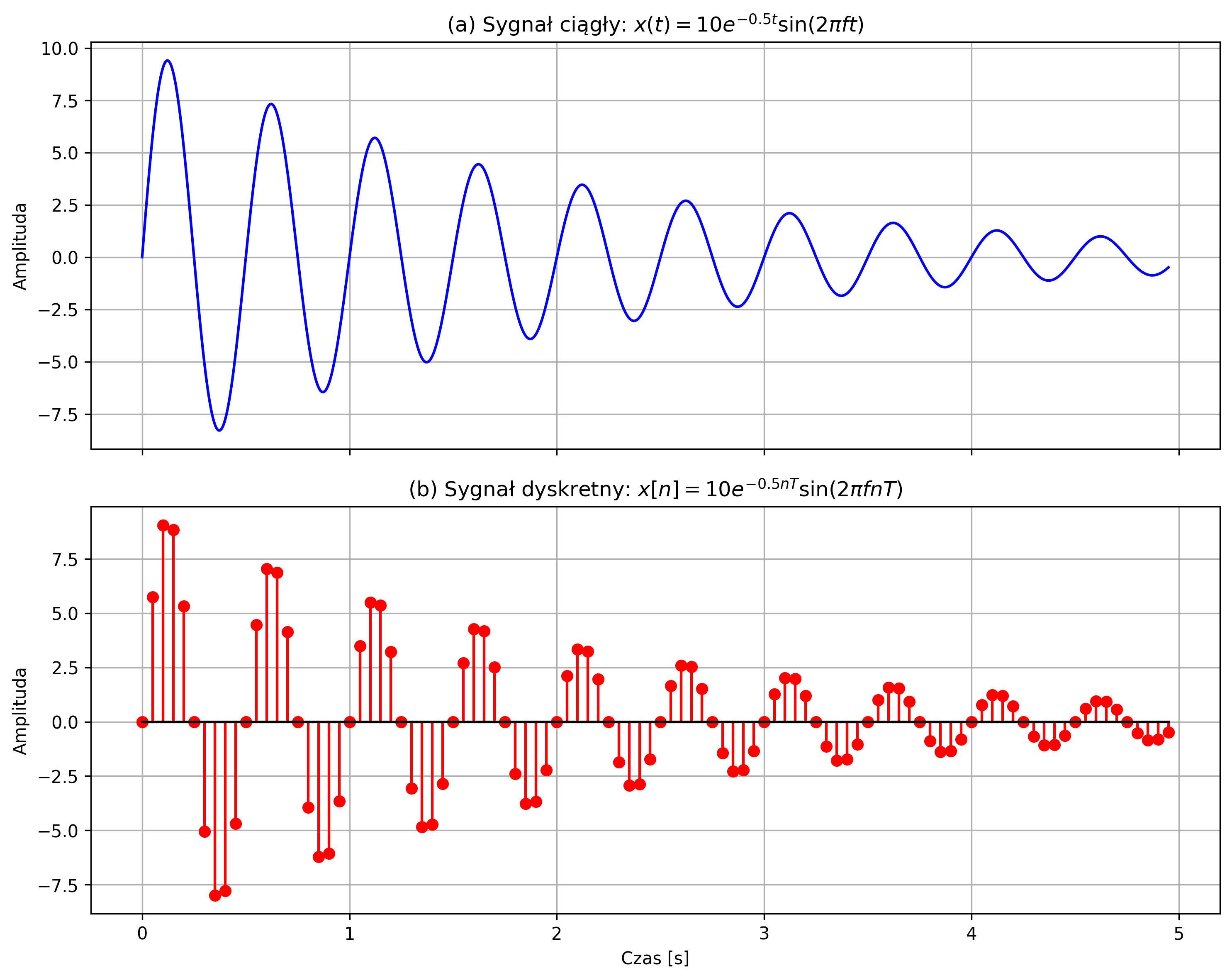

Wygenerować sygnał sinusoidalny tłumiony wykładniczo opisany równaniem:

dla amplitudy \( A = 10 \), częstotliwości sygnału sinusoidalnego \( f = 2 \) Hz i współczynnika tłumienia \(\alpha = 0.5 \). Narysować sygnał ciągły \( x(t) \) i jego wersję dyskretną \( x[n] \) dla \( N = 100 \) próbek, przyjmując częstotliwość próbkowania \( f_s = 20 \) Hz.

import numpy as np

import matplotlib.pyplot as plt

# Parametry sygnału

A = 10 # amplituda

f = 2 # częstotliwość sinusoidy [Hz]

alpha = 0.5 # tłumienie wykładnicze [1/s]

N = 100 # liczba próbek

fs = 20 # częstotliwość próbkowania [Hz]

T = 1 / fs # okres próbkowania

# Sygnał ciągły

t_cont = np.linspace(0, (N - 1) * T, 1000)

x_cont = A * np.exp(-alpha * t_cont) * np.sin(2 * np.pi * f * t_cont)

# Sygnał dyskretny

n = np.arange(N)

t_disc = n * T

x_disc = A * np.exp(-alpha * t_disc) * np.sin(2 * np.pi * f * t_disc)

# Tworzenie dwóch wykresów

fig, axs = plt.subplots(2, 1, figsize=(10, 8), sharex=True)

# Wykres 1: sygnał ciągły

axs[0].plot(t_cont, x_cont, color='blue')

axs[0].set_title(r'(a) Sygnał ciągły: $x(t) = 10e^{-0.5t}\sin(2\pi f t)$', fontsize=12)

axs[0].set_ylabel('Amplituda')

axs[0].grid(True)

# Wykres 2: sygnał dyskretny

axs[1].stem(t_disc, x_disc, linefmt='r-', markerfmt='ro', basefmt='k-')

axs[1].set_title(r'(b) Sygnał dyskretny: $x[n] = 10e^{-0.5nT}\sin(2\pi f nT)$', fontsize=12)

axs[1].set_xlabel('Czas [s]')

axs[1].set_ylabel('Amplituda')

axs[1].grid(True)

plt.tight_layout()

plt.show()

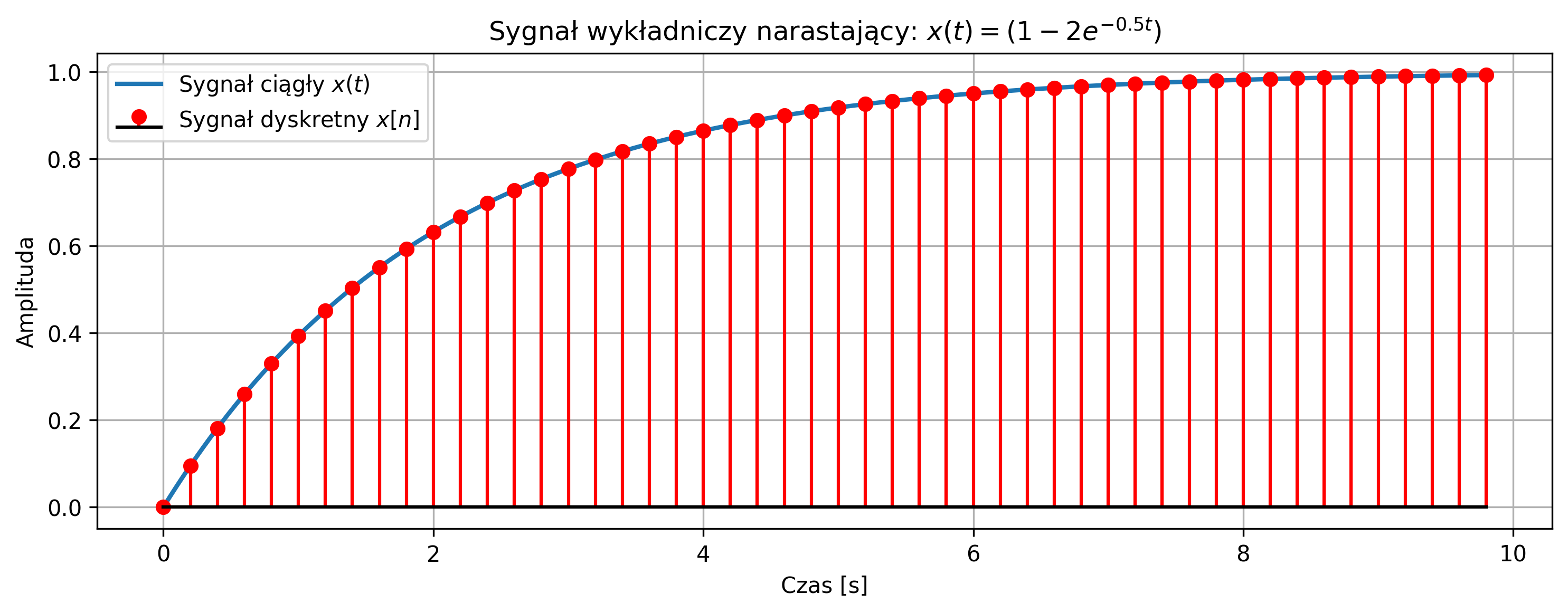

Wygenerować sygnał wykładniczy narastający określony przez następujące równanie:

Narysować na jednym wykresie sygnał ciągły \( x(t) \) oraz jego wersję dyskretną \( x[n] \) dla \( N = 50 \) próbek, przy częstotliwości próbkowania \( f_s = 5\text{ Hz} \).

import numpy as np

import matplotlib.pyplot as plt

# Parametry sygnału

fs = 5 # częstotliwość próbkowania [Hz]

N = 50 # liczba próbek

alpha = -0.5 # wykładnik

T = 1 / fs # okres próbkowania

t_max = (N - 1) / fs

# Czas ciągły i dyskretny

t_cont = np.linspace(0, t_max, 1000)

n = np.arange(N)

t_disc = n * T

x_cont = (1 - np.exp(alpha * t_cont))

x_disc = (1 - np.exp(alpha * t_disc))

# Wspólny wykres

plt.figure(figsize=(10, 4))

plt.plot(t_cont, x_cont, label=r'Sygnał ciągły $x(t)$', linewidth=2)

plt.stem(t_disc, x_disc, linefmt='r-', markerfmt='ro', basefmt='k-', label=r'Sygnał dyskretny $x[n]$')

plt.title(r'Sygnał wykładniczy narastający: $x(t) = \left(1 - 2e^{-0.5t}\right)$')

plt.xlabel('Czas [s]')

plt.ylabel('Amplituda')

plt.grid(True)

plt.legend()

plt.tight_layout()

plt.show()

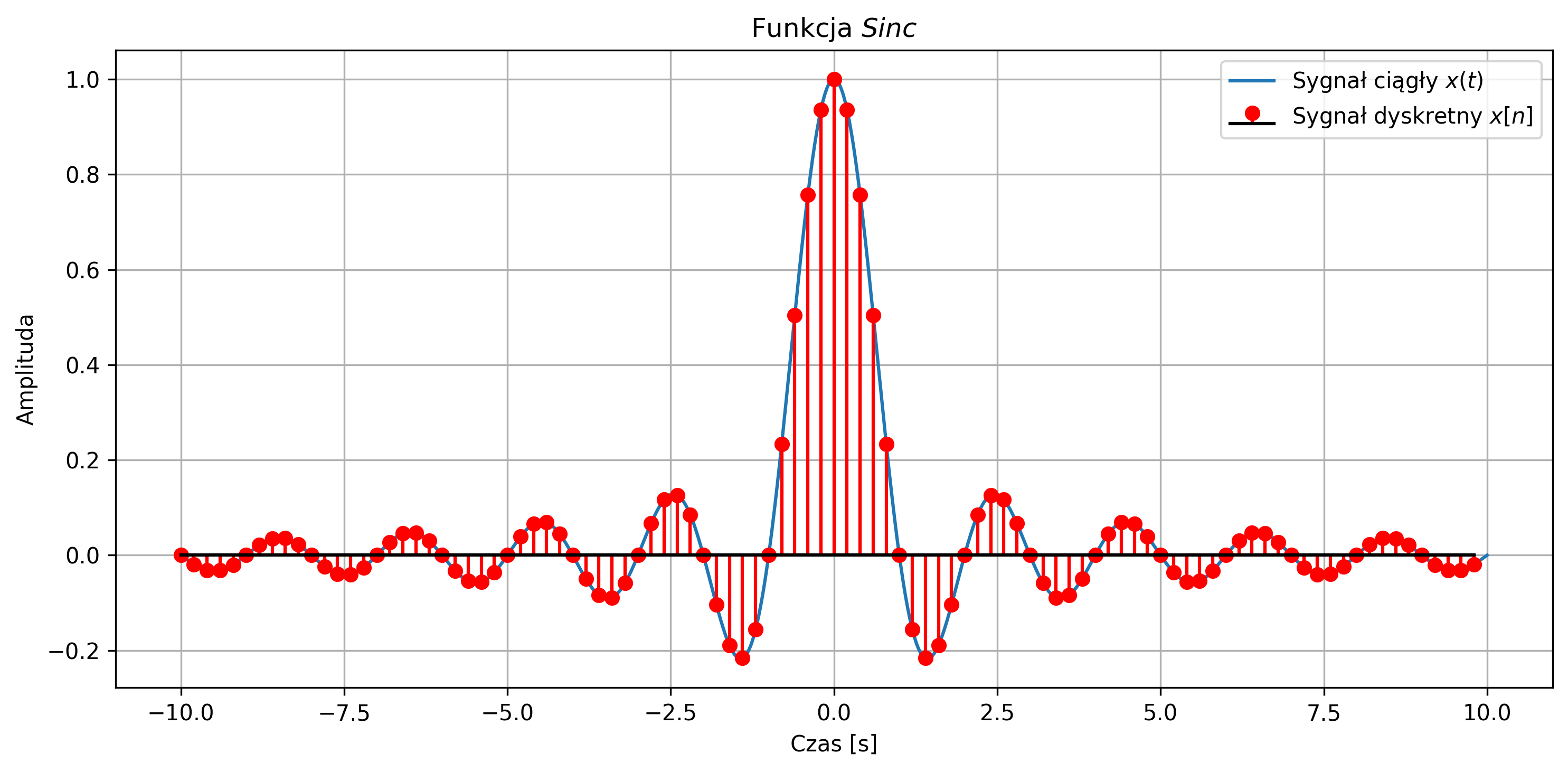

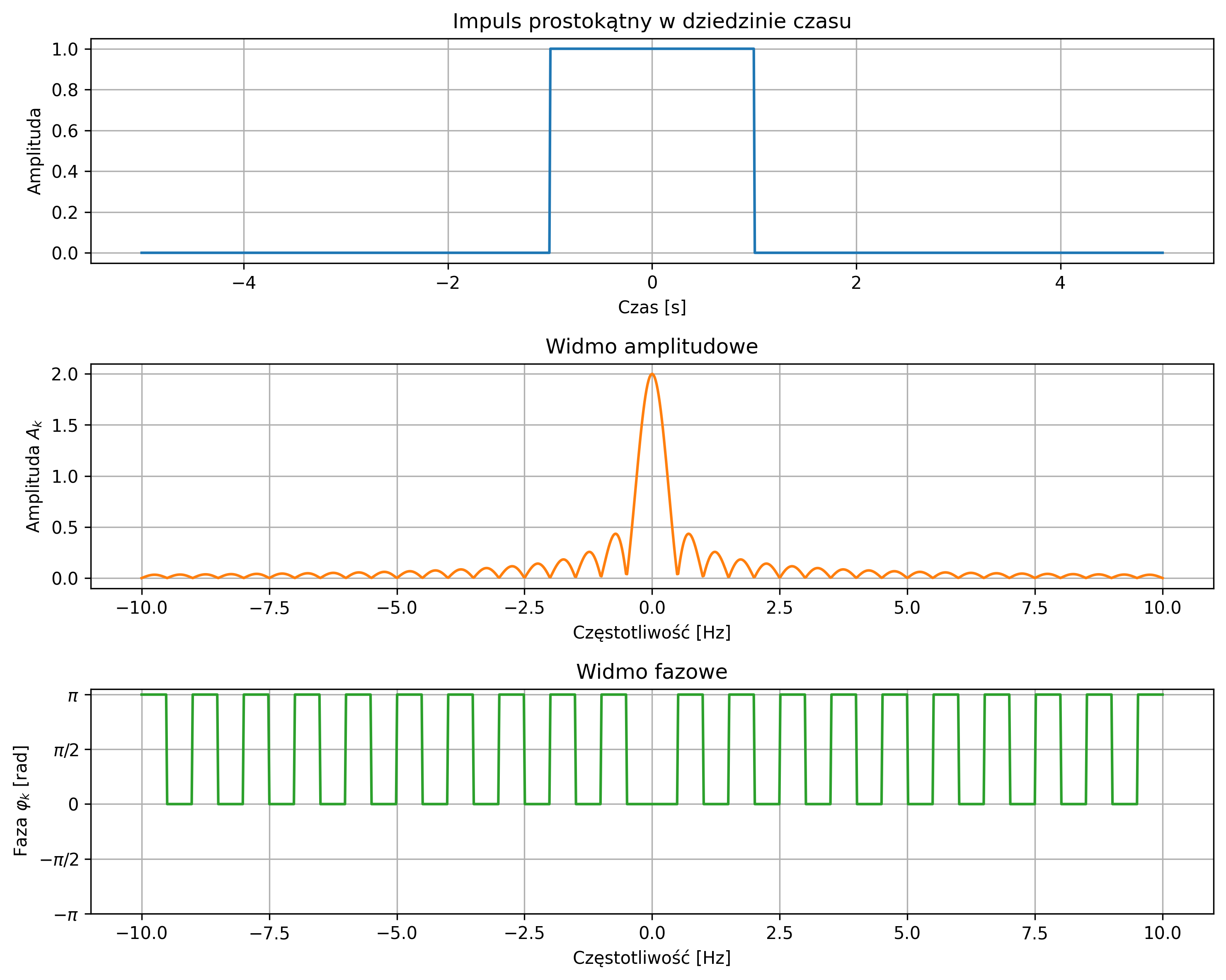

Wygenerować sygnał \(Sinc \) opisany równaniem:

dla częstotliwości sygnału sinusoidalnego \( f = 1 \) Hz. Narysować wspólny wykres sygnału ciągłego \(x(t)\) i dyskretnego \(x[n]\) dla \(N = 100\) próbek, przyjmując częstotliwość próbkowania \(f_s = 5\) Hz.

import numpy as np

import matplotlib.pyplot as plt

# Parametry sygnału

f = 1 # częstotliwość sygnału

fs = 5 # częstotliwość próbkowania

N = 100 # liczba próbek

T = 1 / fs

# Oś czasu - ciągła i dyskretna

t_cont = np.linspace(-10, 10, 1000)

n = np.arange(-N//2, N//2)

t_disc = n * T

# Funkcja Sinc - ciągła i dyskretna

y_cont = np.sinc(f * t_cont)

y_disc = np.sinc(f * t_disc)

# Wspólny wykres

plt.figure(figsize=(10, 5))

# Wersja ciągła i dyskretna

plt.plot(t_cont, y_cont, label=r'Sygnał ciągły $x(t)$')

plt.stem(t_disc, y_disc, linefmt='r-', markerfmt='ro', basefmt='k-', label=r'Sygnał dyskretny $x[n]$')

plt.title(r'Funkcja $Sinc$')

plt.xlabel('Czas [s]')

plt.ylabel('Amplituda')

plt.grid(True)

plt.legend()

plt.tight_layout()

plt.show()

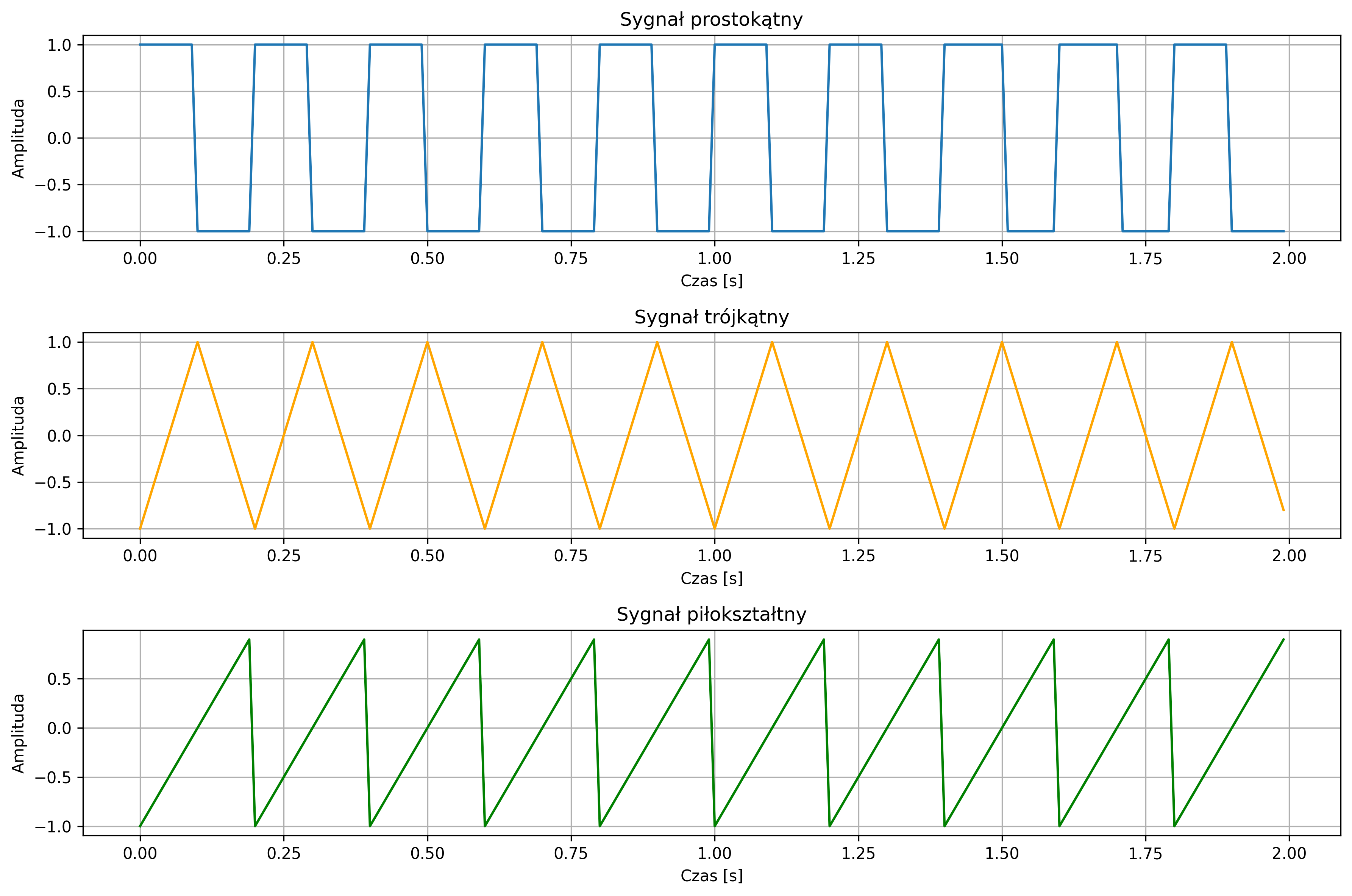

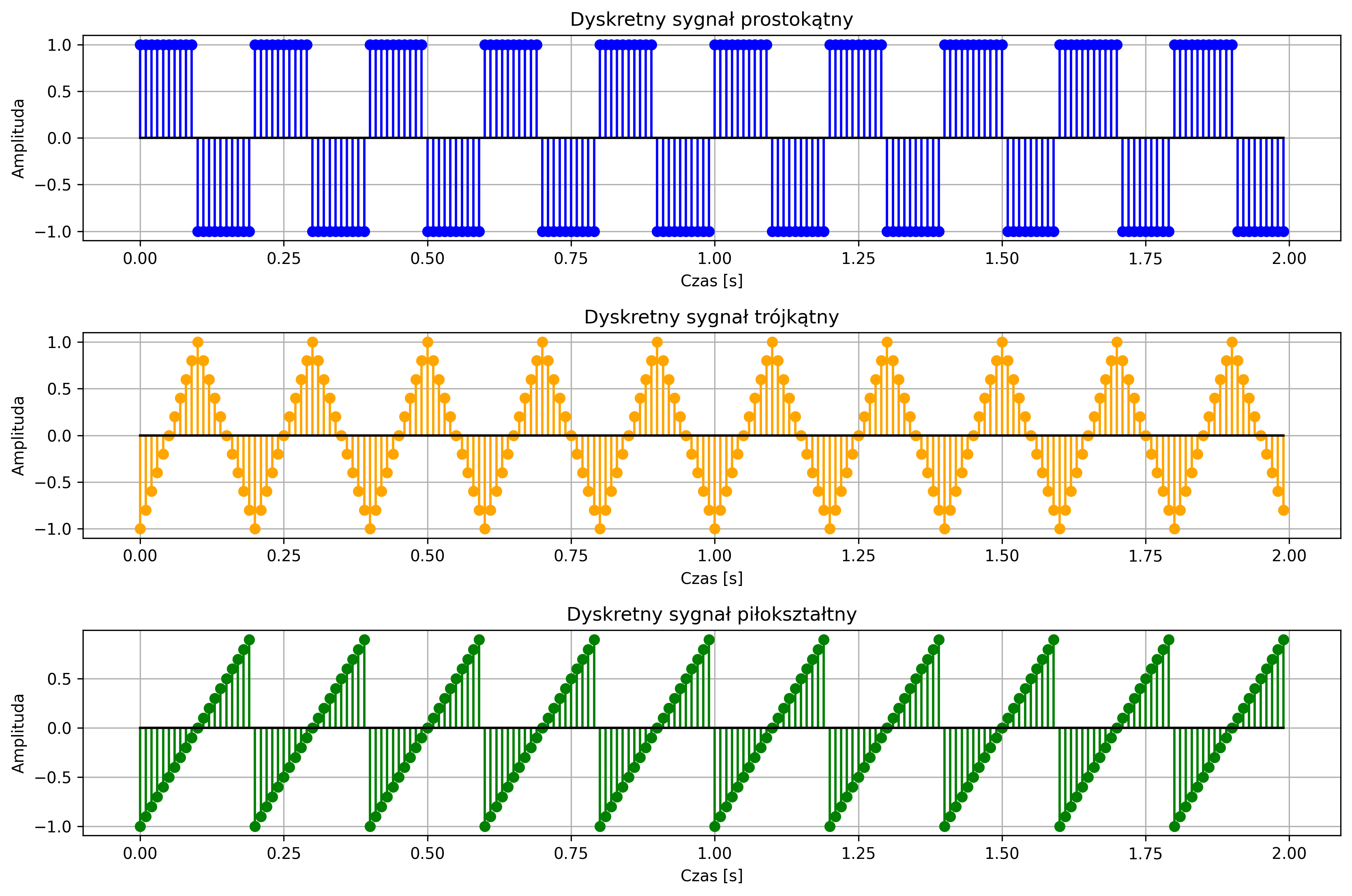

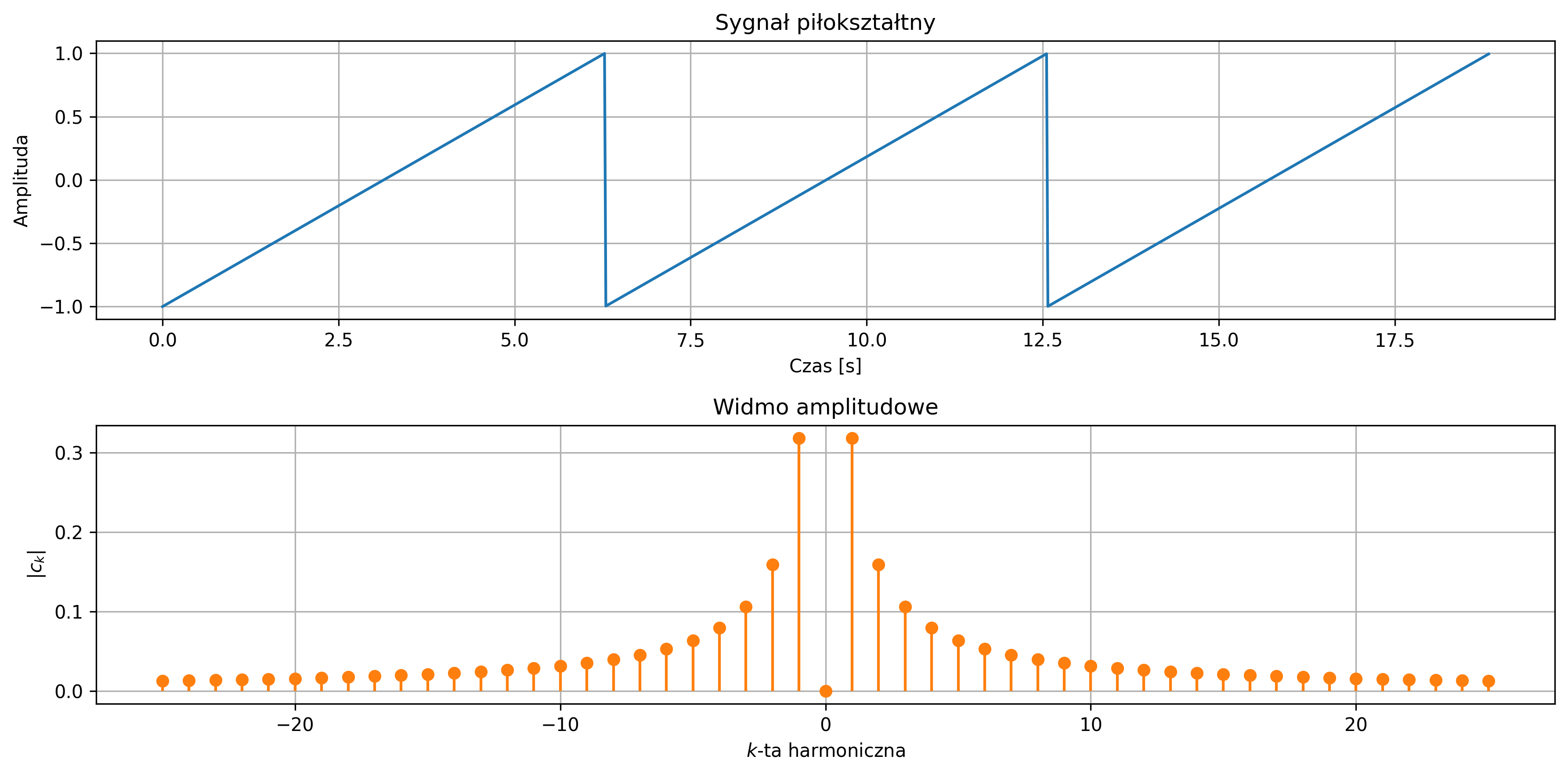

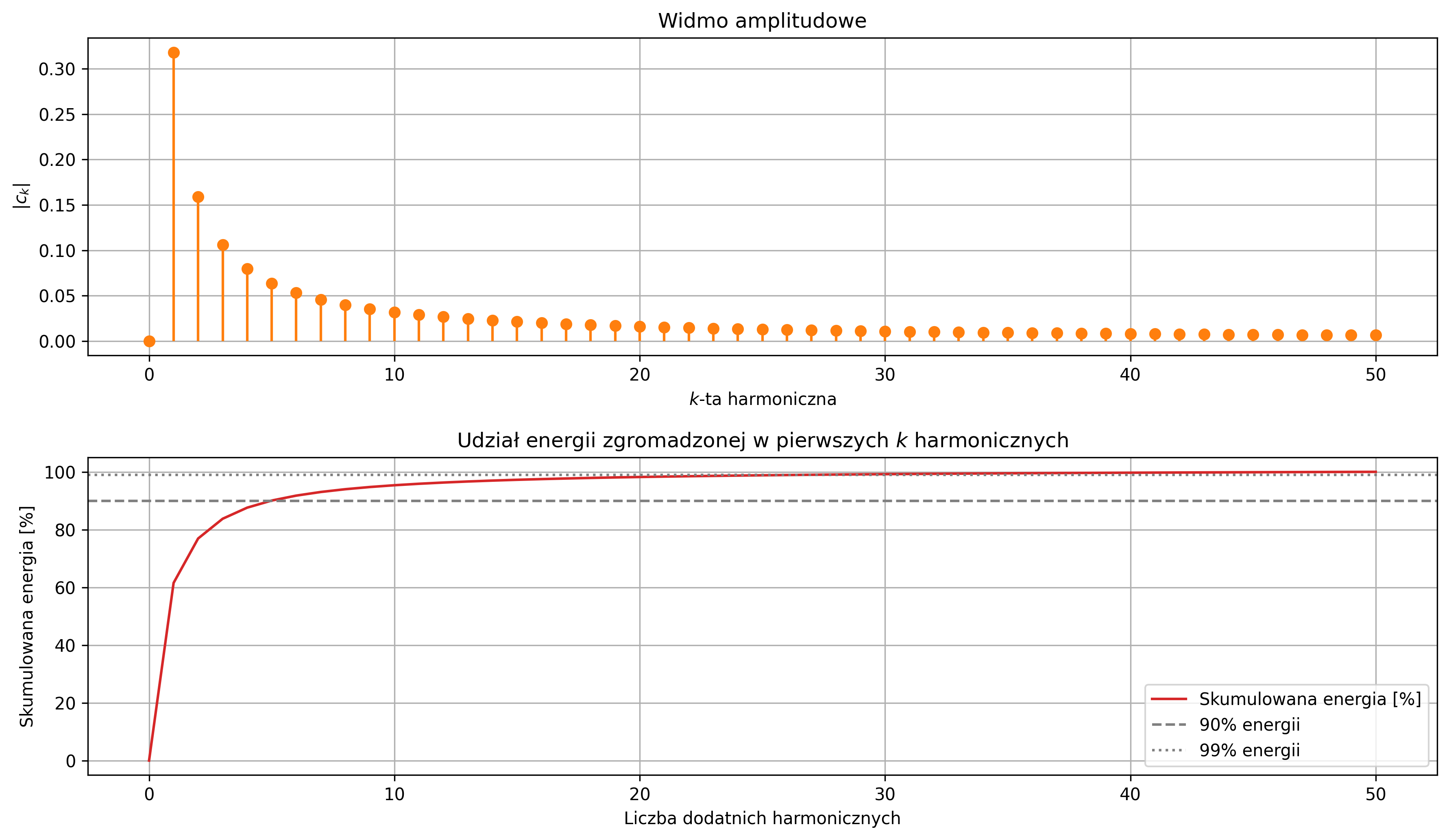

Wygenerować sygnały prostokątny, trójkątny oraz piłokształtny dla częstotliwości \(f = 5\ \text{Hz}\). Dla każdego sygnału narysować wersję ciągłą \(x(t)\) i dyskretną \(x[n]\) dla \(N = 200\) próbek, przyjmując częstotliwość próbkowania \(f_s = 100 \) Hz.

import numpy as np

import matplotlib.pyplot as plt

from scipy import signal

# Parametry sygnałów

fs = 100 # częstotliwość próbkowania [Hz]

f = 5 # częstotliwość sygnału [Hz]

N = 200 # liczba próbek

T = N / fs # czas trwania sygnału [s]

# Oś czasu

t = np.linspace(0, T, N, endpoint=False)

# Sygnał prostokątny

rect_signal = signal.square(2 * np.pi * f * t, duty=0.5) # duty musi mieścić się w [0,1].

# Sygnał trójkątny

tri_signal = signal.sawtooth(2 * np.pi * f * t, width=0.5) # width=0.5 daje trójkąt

# Sygnał piłokształtny (piłowy)

saw_signal = signal.sawtooth(2 * np.pi * f * t, width=1) # width=1 daje piłę

# Rysowanie wykresów

plt.figure(figsize=(12, 8))

plt.subplot(3,1,1)

plt.plot(t, rect_signal, label='Sygnał prostokątny')

plt.title('Sygnał prostokątny')

plt.xlabel('Czas [s]')

plt.ylabel('Amplituda')

plt.grid(True)

plt.subplot(3,1,2)

plt.plot(t, tri_signal, label='Sygnał trójkątny', color='orange')

plt.title('Sygnał trójkątny')

plt.xlabel('Czas [s]')

plt.ylabel('Amplituda')

plt.grid(True)

plt.subplot(3,1,3)

plt.plot(t, saw_signal, label='Sygnał piłokształtny', color='green')

plt.title('Sygnał piłokształtny')

plt.xlabel('Czas [s]')

plt.ylabel('Amplituda')

plt.grid(True)

plt.tight_layout()

plt.show()

import numpy as np

import matplotlib.pyplot as plt

from scipy import signal

# Parametry sygnałów

fs = 100 # częstotliwość próbkowania [Hz]

f = 5 # częstotliwość sygnału [Hz]

N = 200 # liczba próbek

T = N / fs # czas trwania sygnału [s]

# Oś czasu dyskretna

n = np.arange(N)

t = n / fs

# Sygnały dyskretne

rect_signal = signal.square(2 * np.pi * f * t, duty=0.5)

tri_signal = signal.sawtooth(2 * np.pi * f * t, width=0.5)

saw_signal = signal.sawtooth(2 * np.pi * f * t, width=1)

# Rysowanie wykresów

plt.figure(figsize=(12, 8))

plt.subplot(3,1,1)

plt.stem(t, rect_signal, linefmt='b-', markerfmt='bo', basefmt='k-')

plt.title('Dyskretny sygnał prostokątny')

plt.xlabel('Czas [s]')

plt.ylabel('Amplituda')

plt.grid(True)

plt.subplot(3,1,2)

plt.stem(t, tri_signal, linefmt='orange', markerfmt='o', basefmt='k-')

plt.title('Dyskretny sygnał trójkątny')

plt.xlabel('Czas [s]')

plt.ylabel('Amplituda')

plt.grid(True)

plt.subplot(3,1,3)

plt.stem(t, saw_signal, linefmt='green', markerfmt='o', basefmt='k-')

plt.title('Dyskretny sygnał piłokształtny')

plt.xlabel('Czas [s]')

plt.ylabel('Amplituda')

plt.grid(True)

plt.tight_layout()

plt.show()

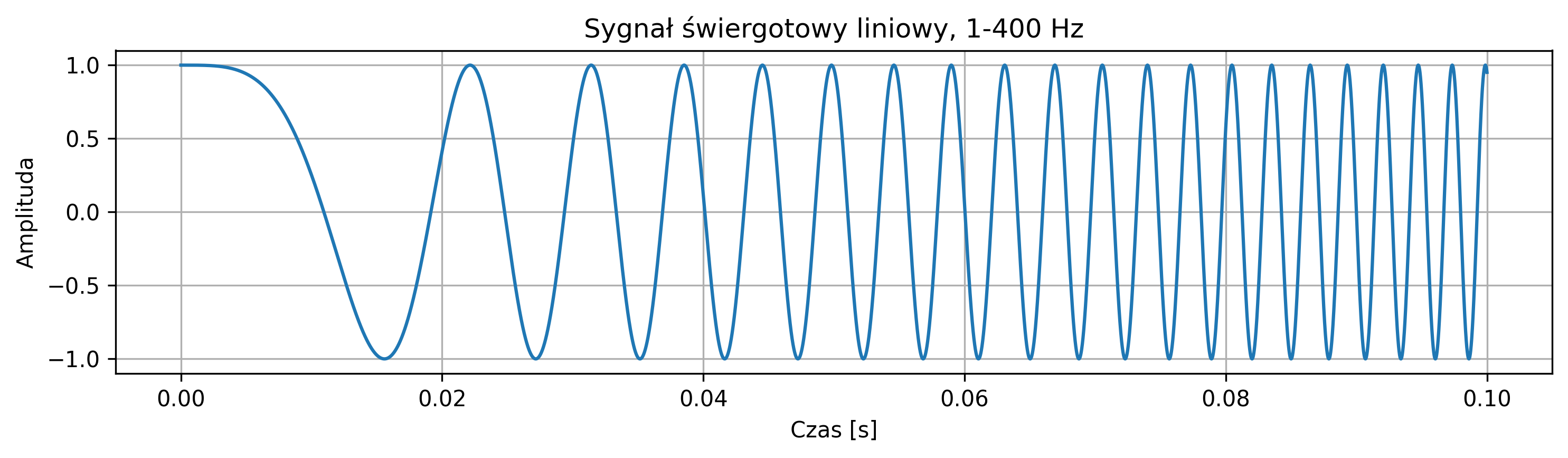

Wygenerować sygnał świergotowy (chirp) o częstotliwości liniowo rosnącej od \(1\) Hz do \(400\) Hz. Przyjąć czas trwania sygnału \(0.1\) sekundy oraz częstotliwość próbkowania \(f_s = 10\ 000\) Hz. Narysować wykres sygnału ciągłego \(x(t)\).

import numpy as np

import matplotlib.pyplot as plt

from scipy.signal import chirp

# Parametry

t = np.linspace(0, 0.1, 10000) # czas trwania 0.1 [s]

# Generowanie sygnału świergotowego liniowego od 1 do 400 Hz

x = chirp(t, f0=1, f1=400, t1=0.1, method='linear')

# f0 = 1 częstotliwość początkowa [Hz]

# f1 = 400 częstotliwość końcowa [Hz]

# t1 = 0.1 czas, w którym osiągana jest f1

plt.figure(figsize=(10, 3))

plt.plot(t, x)

plt.title('Sygnał świergotowy liniowy, 1-400 Hz')

plt.xlabel('Czas [s]')

plt.ylabel('Amplituda')

plt.grid(True)

plt.tight_layout()

plt.show()

Sygnał świergotowy to sygnał o zmiennej częstotliwości chwilowej. Najprostszym jego przypadkiem jest sygnał sinusoidalny, którego częstotliwość chwilowa jest przestrajana w trakcie generowania. Przestrajanie częstotliwości odbywa się zwykle w sposób liniowy lub logarytmiczny. Sygnały świergotowe stosuje się m.in. do analizy charakterystyk częstotliwościowych urządzeń (np. filtrów, wzmacniaczy, głośników), do wyznaczania odpowiedzi systemu na różne częstotliwości w krótkim czasie, a także do badania reakcji układów biologicznych na bodźce o zmiennej częstotliwości.

Po zapoznaniu się z możliwościami generowania podstawowych sygnałów, możemy prześledzić operację splotu oraz zagadnienia związane z wyznaczaniem odpowiedzi impulsowej systemów LTI.

Wymagana jest znajomość funkcji:

np.convolve # obliczanie splotu dwóch jednowymiarowych sygnałów dyskretnych

# funkcja z biblioteki NumPy, przeznaczona głównie do prostych operacji na wektorach

convolve # obliczanie splotu sygnałów (1D, 2D i wyższych wymiarów)

# funkcja z biblioteki scipy.signal, oferująca większe możliwości

dzięki którym można łatwo wykonać operację splotu, np. w celu wyznaczenia odpowiedzi impulsowej systemów LTI.

Obliczyć splot dwóch ciągów próbek sygnałów: \( X = [2,4,6] \) oraz \( Y = [1,2] \).

Zgodnie z zasadą obliczenia splotu, opisaną w rozdziale 2.4, najpierw odwracamy ciąg próbek \( Y \) w czasie i wyrównujemy go z ciągiem próbek \( X \) tak, aby ostatnia próbka \( Y \) po odwróceniu pokrywała się z pierwszą próbką \( X\). Następnie mnożymy przez siebie pokrywające się próbki i sumujemy wyniki, co daje pierwszą wartość splotu.

X 2 4 6 2 * 1 = 2

Y 2 1 splot = [2]

Odwrócony ciąg próbek \( Y \) przesuwamy w prawo o jedno miejsce i powtarzamy operację:

X 2 4 6 2 * 2 + 4 * 1 = 8

Y 2 1 splot = [2 8]

Następnie przesuwamy ciąg próbek \( Y \) ponownie:

X 2 4 6 4 * 2 + 6 * 1 = 14

Y 2 1 splot = [2 8 14]

Jeżeli żadne próbki sygnałów nie pokrywają się, to kończymy obliczenia:

X 2 4 6 6 * 2 = 12

Y 2 1 splot = [2 8 14 12]

Operacja splotu jest przemienna, co oznacza, że otrzymamy ten sam wynik, jeśli odwrócimy próbki \( X \) i przesuwamy próbki \( Y \). Taki wynik możemy uzyskać w Pythonie:

import numpy as np

X = [2, 4, 6]

Y = [1, 2]

splot = np.convolve(X, Y)

print('Wynik splotu:', splot)

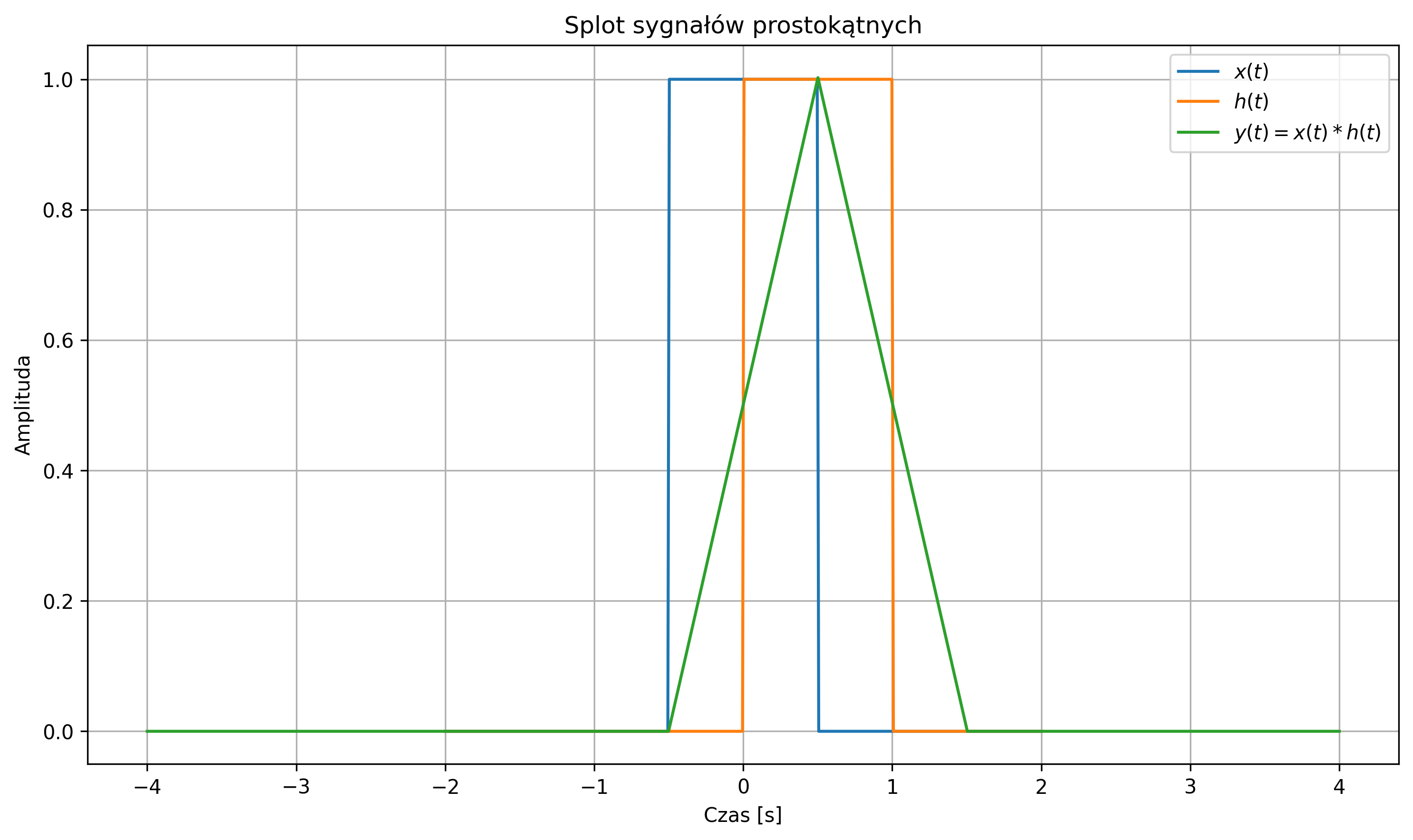

import numpy as np import matplotlib.pyplot as plt from scipy.signal import convolve # obliczanie splotu dwóch sygnałów # Definicja impulsu prostokątnego def rect(t): return np.where(np.abs(t) <= 0.5, 1, 0) # Osie czasu t = np.linspace(-2, 2, 400) dt = t[1] - t[0] # Sygnały x = rect(t) # impuls prostokątny h = rect(t - 0.5) # przesunięty impuls prostokątny # Splot ciągły (jako dyskretny z krokiem dt) y = convolve(x, h, mode='full') * dt t_y = np.linspace(t[0]+t[0], t[-1]+t[-1], len(y)) # Wykresy plt.figure(figsize=(10,6)) plt.plot(t, x, label='$x(t)$') plt.plot(t, h, label='$h(t)$') plt.plot(t_y, y, label='$y(t) = x(t)*h(t)$') plt.title('Splot sygnałów prostokątnych') plt.xlabel('Czas [s]') plt.ylabel('Amplituda') plt.legend() plt.grid(True) plt.tight_layout() plt.show()

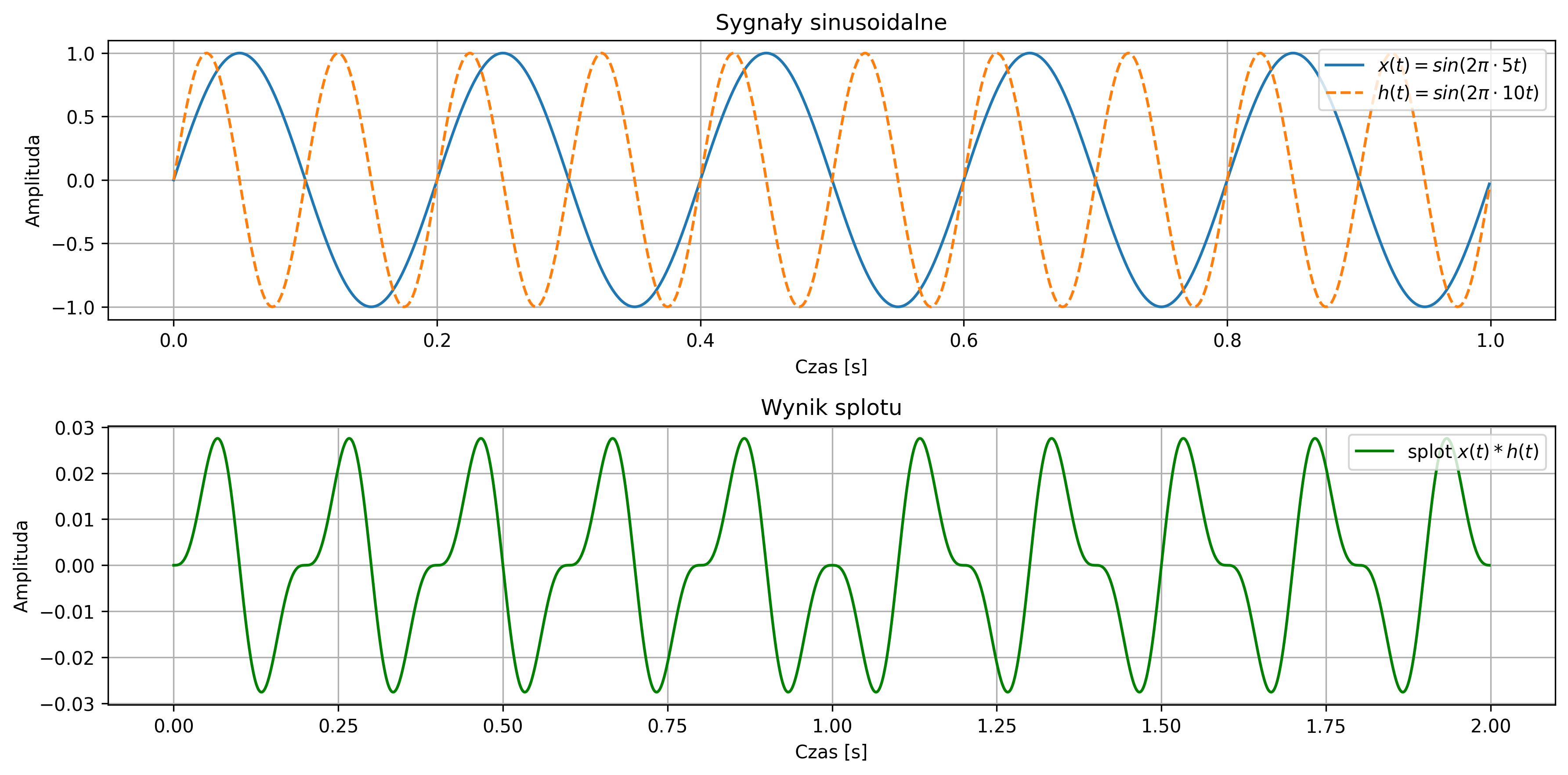

import numpy as np import matplotlib.pyplot as plt from scipy.signal import convolve # Parametry fs = 1000 # częstotliwość próbkowania [Hz] T = 1 / fs # okres próbkowania t = np.arange(0, 1, T) # oś czasu dla 1 sekundy # Częstotliwości sygnałów f1 = 5 # Hz f2 = 10 # Hz x = np.sin(2 * np.pi * f1 * t) h = np.sin(2 * np.pi * f2 * t) # Splot dyskretny y = convolve(x, h, mode='full') * T t_conv = np.arange(0, len(y)) * T # oś czasu dla splotu # Wykresy plt.figure(figsize=(12, 6)) # Wykres 1: oba sygnały wejściowe plt.subplot(2, 1, 1) plt.plot(t, x, label=r'$x(t) = sin(2\pi \cdot 5t)$') plt.plot(t, h, label=r'$h(t) = sin(2\pi \cdot 10t)$', linestyle='--') plt.title('Sygnały sinusoidalne') plt.xlabel('Czas [s]') plt.ylabel('Amplituda') plt.grid(True) plt.legend(loc='upper right') # Wykres 2: wynik splotu plt.subplot(2, 1, 2) plt.plot(t_conv, y, label=r'splot $x(t) * h(t)$', color='green') plt.title('Wynik splotu') plt.xlabel('Czas [s]') plt.ylabel('Amplituda') plt.grid(True) plt.legend(loc='upper right') plt.tight_layout() plt.show()

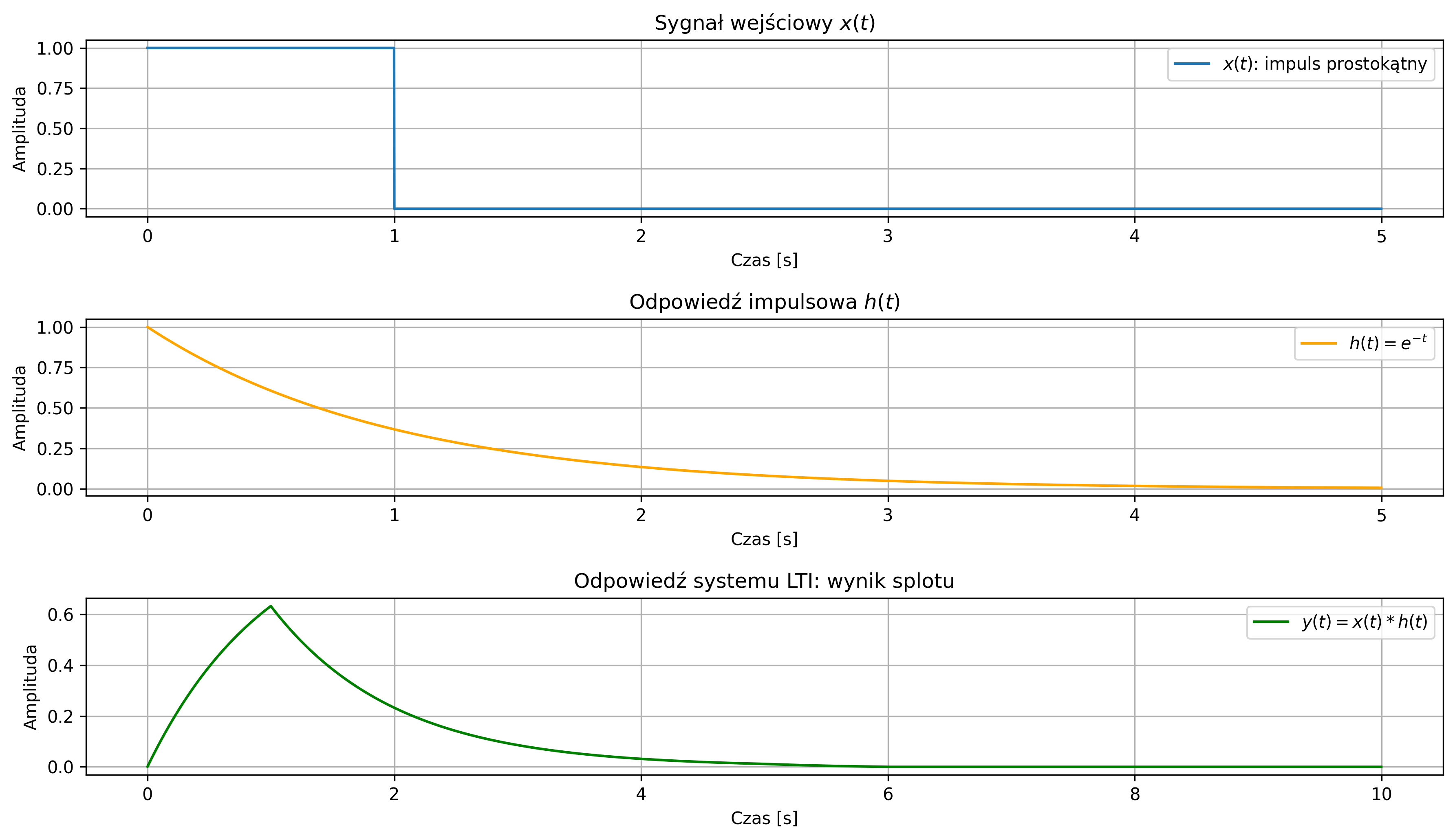

Wyznaczyć odpowiedź systemu LTI na sygnał wejściowy – impuls prostokątny, trwający \( 1 \) s, jeśli odpowiedź impulsowa systemu jest sygnałem wykładniczym malejącym:

Przypomnijmy, że odpowiedź systemu LTI na dowolny sygnał wejściowy jest splotem sygnału wejściowego z odpowiedzią impulsową.

import numpy as np

import matplotlib.pyplot as plt

from scipy.signal import convolve

# Parametry

fs = 1000 # częstotliwość próbkowania

T = 1 / fs # okres próbkowania

t = np.arange(0, 5, T) # od 0 do 5 s

# Sygnał wejściowy: impuls prostokątny trwający 1 [s]

x = np.where(t < 1, 1, 0)

# Odpowiedź impulsowa: sygnał wykładniczy malejąca

h = np.exp(-t)

# Splot

y = convolve(x, h, mode='full') * T

t_conv = np.arange(0, len(y)) * T

# Wykresy

plt.figure(figsize=(12, 7))

plt.subplot(3, 1, 1)

plt.plot(t, x, label=r'$x(t)$: impuls prostokątny')

plt.title(r'Sygnał wejściowy $x(t)$')

plt.xlabel('Czas [s]')

plt.ylabel('Amplituda')

plt.grid(True)

plt.legend()

plt.subplot(3, 1, 2)

plt.plot(t, h, label=r'$h(t) = e^{-t}$', color='orange')

plt.title(r'Odpowiedź impulsowa $h(t)$')

plt.xlabel('Czas [s]')

plt.ylabel('Amplituda')

plt.grid(True)

plt.legend()

plt.subplot(3, 1, 3)

plt.plot(t_conv, y, label=r'$y(t) = x(t) * h(t)$', color='green')

plt.title('Odpowiedź systemu LTI: wynik splotu')

plt.xlabel('Czas [s]')

plt.ylabel('Amplituda')

plt.grid(True)

plt.legend()

plt.tight_layout()

plt.show()

2.9. Charakterystyki sygnałów w języku Python

Celem poniższych ćwiczeń jest zapoznanie się z podstawowymi poleceniami w języku Python do wyznaczania wybranych charakterystyk sygnałów - parametrów energetycznych sygnałów oraz ich korelacji wzajemnej i autokorelacji.

Poniższe przykłady przedstawiają pełne kody źródłowe w języku Python, opracowane na potrzeby realizacji poszczególnych zadań. W trakcie realizacji ćwiczeń wykorzystywane będą następujące biblioteki:

import numpy as np # obliczenia numeryczne i tablice

import matplotlib.pyplot as plt # tworzenie wykresów ciągłych i dyskretnych

import scipy.signal as signal # generowanie standardowych sygnałów,

# takich jak np. prostokątny, trójkątny, piłokształtny

import scipy.integrate as integrate # numeryczne obliczanie całek

Rozwiązanie zadań wymaga znajomości podstawowych poleceń oraz funkcji dostępnych w języku Python, w tym m.in.:

np.sum # obliczanie sumy wartości próbek sygnału, np. przy wyznaczaniu energii sygnału

np.mean # wyznaczanie wartości średniej sygnału

np.abs # obliczanie wartości bezwzględnej próbek sygnału

np.max # wyznaczanie maksymalnej wartości sygnału

simpson # numeryczne całkowanie sygnału metodą Simpsona, np. do obliczania energii sygnału ciągłego

signal.correlate # obliczanie korelacji wzajemnej lub autokorelacji sygnałów

signal.correlate_lags # wyznaczanie wektora opóźnień (lagów) odpowiadających wartościom korelacji

Poniżej przedstawiono ćwiczenia zawierające przykładowe implementacje w języku Python. Autor zachęca czytelnika do uruchomienia zaprezentowanych kodów oraz do analizy charakterystyk sygnałów poprzez modyfikację wybranych parametrów sygnałów.

import numpy as np

import matplotlib.pyplot as plt

import scipy.integrate as integrate

# Parametry sygnału

A = 2 # amplituda

f = 1 # częstotliwość [Hz]

omega = 2 * np.pi * f # pulsacja [rad/s]

# Czas obserwacji (symulacja sygnału "nieskończonego")

T_obs = 10

t = np.linspace(-T_obs, T_obs, 10000)

# Sygnał ciągły

x = A * np.sin(omega * t)

# Moc sygnału: numerycznie przybliżona całka

power = (1 / (2 * T_obs)) * simpson(x**2, t)

# Wynik

print(f"Moc sygnału: {power:.2f}")

# Wykres sygnału

plt.figure(figsize=(10, 5))

plt.plot(t, x, label=fr'$x(t) = {A}\sin({omega:.2f} t)$', color='C0')

plt.title(fr'Sygnał sinusoidalny o ograniczonej mocy: $P_x \approx {power:.2f}$')

plt.xlabel('Czas [s]')

plt.ylabel('Amplituda')

plt.grid(True)

plt.legend(loc='upper right')

plt.tight_layout()

plt.show()

na podstawie próbek w przedziale czasu \([-5,5]\).

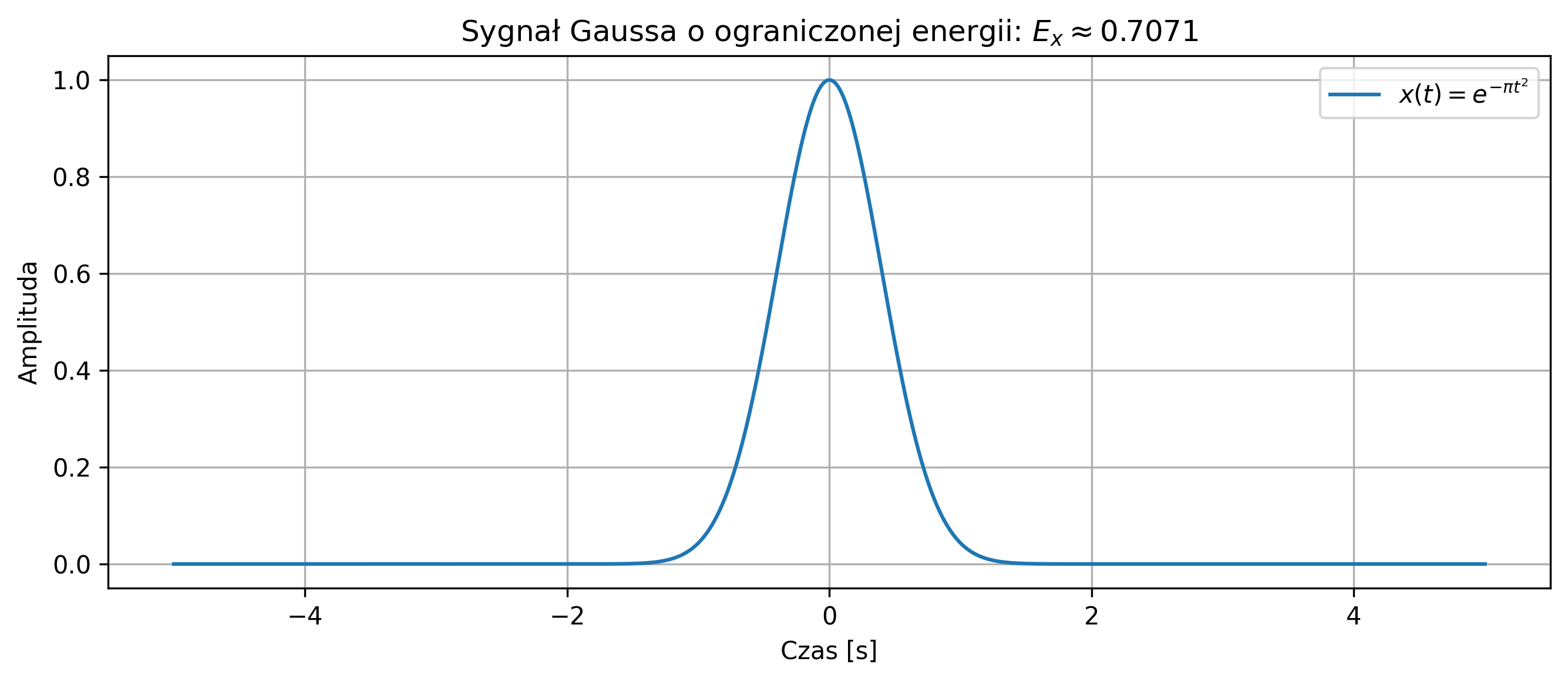

import numpy as np

import matplotlib.pyplot as plt

import scipy.integrate as integrate

# Zakres czasu

t = np.linspace(-5, 5, 10000)

dt = t[1] - t[0]

# Sygnał Gausso

x = np.exp(-np.pi*t**2)

# Energia

energy = np.sum(np.abs(x)**2) * dt

print(f'Energia sygnału: {energy:.4f}')

# Wartość średnia

mean = np.mean(x)

print(f'Wartość średnia: {mean:.6e}')

# Wykres sygnału

plt.figure(figsize=(9, 4))

plt.plot(t, x, label=r'$x(t) = e^{-\pi t^2}$')

plt.title(fr'Sygnał Gaussa o ograniczonej energii: $E_x \approx {energy:.4f}$')

plt.xlabel('Czas [s]')

plt.ylabel('Amplituda')

plt.grid(True)

plt.legend(loc='upper right')

plt.tight_layout()

plt.show()

na podstawie próbek w przedziale czasu \([-100,100]\).

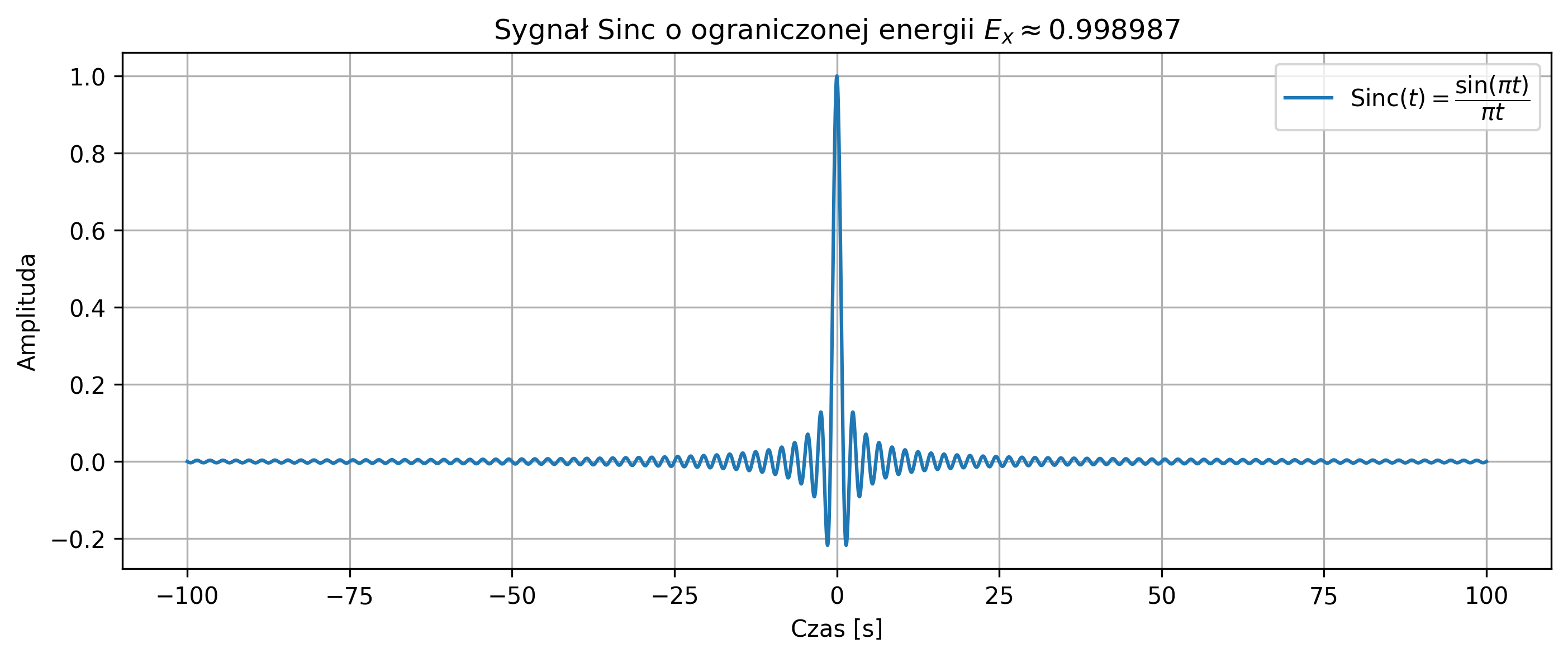

import numpy as np

import matplotlib.pyplot as plt

# Zakres czasu

t = np.linspace(-100, 100, 10000)

dt = t[1] - t[0]

# Sygnał Sinc

x = np.sinc(t)

# Obliczenie energii

energy = np.sum(np.abs(x)**2) * dt

print(f'Energia sygnału: {energy:.6f}')

# Wartość średnia

mean = np.mean(x)

print(rf'Wartość średnia sygnału: {mean:.6e}')

# Wykres

plt.figure(figsize=(11, 4))

plt.plot(t, x, label=r'$\mathrm{Sinc}(t) = \dfrac{\sin(\pi t)}{\pi t}$')

plt.title(fr'Sygnał Sinc o ograniczonej energii $E_x \approx {energy:.6f}$')

plt.xlabel('Czas [s]')

plt.ylabel('Amplituda')

plt.grid(True)

plt.legend(loc='upper right')

plt.show()

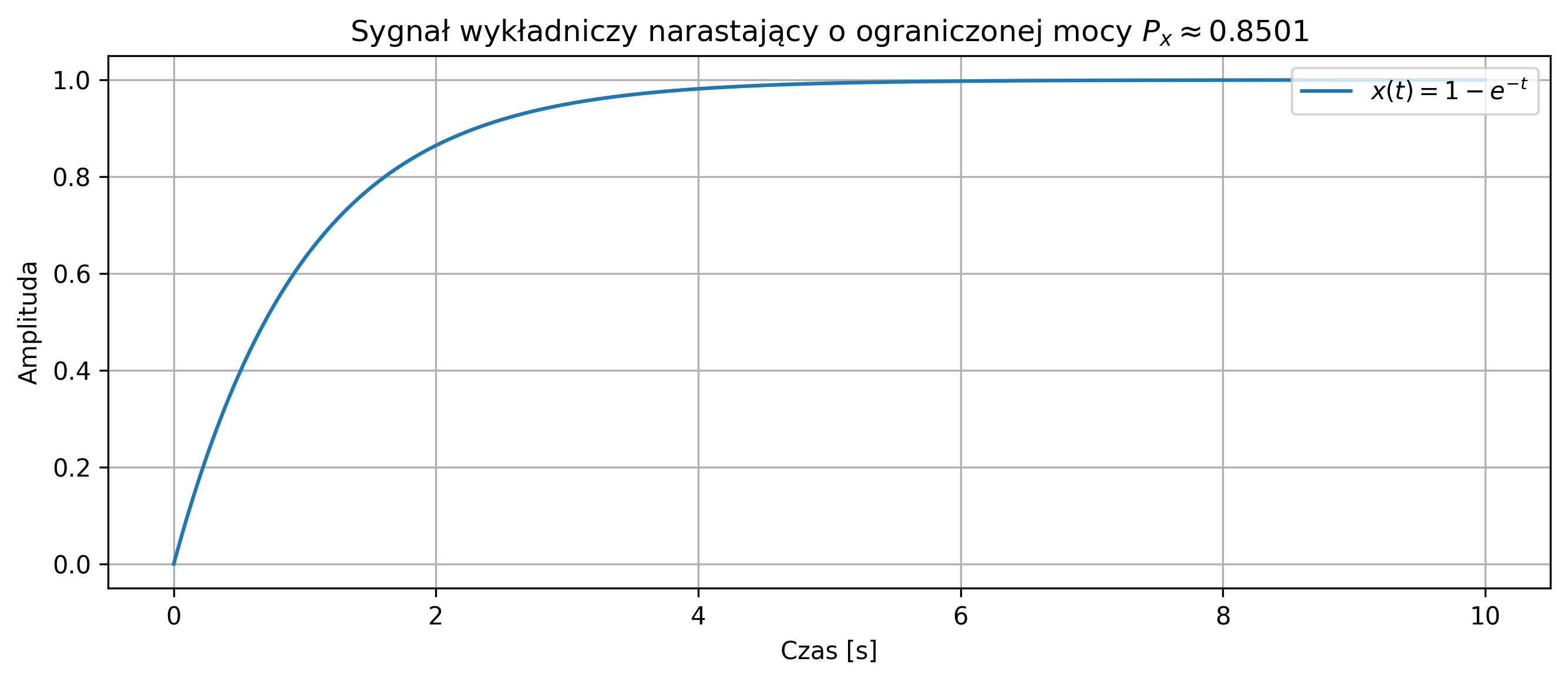

na podstawie jego próbek w przedziale czasu \([0,10]\).

import numpy as np

import matplotlib.pyplot as plt

# Zakres czasu

t = np.linspace(0, 10, 10000)

dt = t[1] - t[0]

# Sygnał wykładniczy narastający

x = 1 - np.exp(-t)

# Moc (energia średnia na przedziale)

power = np.sum(x**2) * dt / 10

print(f'Moc sygnału: {power:.4f}')

# Wartość średnia

mean = np.mean(x)

print(f'Wartość średnia: {mean:.4f}')

# Wykres

plt.figure(figsize=(9, 4))

plt.plot(t, x, label=r'$x(t) = 1 - e^{-t}$')

plt.title('Sygnał wykładniczy narastający')

plt.xlabel('Czas [s]')

plt.ylabel('Amplituda')

plt.grid(True)

plt.legend(loc='upper right')

plt.tight_layout()

plt.show()

import numpy as np

import matplotlib.pyplot as plt

import scipy.signal as signal

# Parametry sygnału

A = 2 # amplituda

f = 2 # częstotliwość [Hz]

omega = 2 * np.pi * f

tau = 0.25 # opóźnienie czasowe w sekundach

varphi = -omega * tau # odpowiadające przesunięcie fazowe

# Czas

t = np.linspace(0, 2, 5000)

# Sygnały

x = A * np.sin(omega * t)

y = A * np.sin(omega * t + varphi) # przesunięcie fazowe odpowiadające opóźnieniu

# Korelacja

r_xy = correlate(y, x, mode='full')

lags = correlation_lags(len(y), len(x), mode='full')

dt = t[1] - t[0]

lags_time = lags * dt

max_lag_time = lags_time[np.argmax(r_xy)]

# Wykresy

fig, axs = plt.subplots(2, 1, figsize=(10, 6))

axs[0].plot(t, x, label=r'$x(t) = A \sin(\omega t)$',linestyle='-')

axs[0].plot(t, y, label=r'$y(t) = A \sin(\omega t + \varphi)$',linestyle='-')

axs[0].set_title(fr'Sygnały sinusoidalne $x(t)$ i $y(t)$')

axs[0].set_xlabel('Czas [s]')

axs[0].set_ylabel('Amplituda')

axs[0].legend(loc='upper right')

axs[0].grid(True)

axs[1].plot(lags_time, r_xy, color='green')

axs[1].set_title(f'Korelacja wzajemna $R_{{xy}}(τ)$')

axs[1].axvline(max_lag_time, color='red', linestyle='--',

label = fr'Max przy opóźnieniu = {max_lag_time:.3f} s')

axs[1].set_xlabel('Przesunięcie [s]')

axs[1].set_ylabel(fr'Korelacja wzajemna $[\tau]$')

axs[1].legend(loc='upper right')

axs[1].grid(True)

plt.tight_layout()

plt.show()

import numpy as np

import matplotlib.pyplot as plt

from scipy.signal import sawtooth, correlate, correlation_lags

# Parametry ciągłego czasu

T_obs = 2 # czas obserwacji [s]

fs = 10000 # częstotliwość próbkowania [Hz]

t = np.linspace(0, T_obs, int(T_obs * fs))

dt = t[1] - t[0]

# Parametry sygnału piłokształtnego

f = 5 # Hz

x = sawtooth(2 * np.pi * f * t)

# Sygnał opóźniony

delay_sec = 0.05 # opóźnienie w sekundach

delay_samples = int(delay_sec * fs) # opóźnienie w próbkach

y = np.roll(x, delay_samples)

# Korelacja wzajemna

r_xy = correlate(y, x, mode='full') * dt

lags = correlation_lags(len(y), len(x), mode='full') * dt

# Znalezienie maksimum korelacji

max_idx = np.argmax(r_xy)

max_lag_time = lags[max_idx]

# Wykresy

fig, axs = plt.subplots(2, 1, figsize=(10, 6))

axs[0].plot(t, x, label=rf'$x(t)$ - oryginalny', color='blue')

axs[0].plot(t, y, label=rf'$y(t)$ - opóźniony', color='orange')

axs[0].set_title('Sygnały piłokształtne')

axs[0].set_xlabel('Czas [s]')

axs[0].set_ylabel('Amplituda')

axs[0].legend(loc='upper right')

axs[0].grid(True)

axs[1].plot(lags, r_xy, color='green')

axs[1].set_title(fr'Korelacja wzajemna $R_{{xy}}(τ)$')

axs[1].axvline(max_lag_time, color='red', linestyle='--',

label=fr'Max przy opóźnieniu = {max_lag_time:.3f} s')

axs[1].set_xlabel('Przesunięcie [s]')

axs[1].set_ylabel(rf'Korelacja wzajemna $[\tau]$')

axs[1].legend(loc='upper right')

axs[1].grid(True)

plt.tight_layout()

plt.show()

import numpy as np

import matplotlib.pyplot as plt

from scipy.signal import correlate, correlation_lags

# Parametry

fs = 1000 # częstotliwość próbkowania [Hz]

A = 1 # amplituda sygnału

f = 5 # częstotliwość sygnału [Hz]

T = 1 / f # okres [s]

t = np.arange(0, 2, 1/fs)

x = A * np.sin(2 * np.pi * f * t)

# Autokorelacja

R_xx = correlate(x, x, mode='full')

lags = correlation_lags(len(x), len(x), mode='full') / fs

# Normalizacja (opcjonalnie)

R_xx = R_xx / np.max(R_xx)

# Wykresy

fig, axs = plt.subplots(2, 1, figsize=(10, 6))

# Sygnał

axs[0].plot(t, x)

axs[0].set_title(f'Sygnał sinusoidalny $x(t)$')

axs[0].set_xlabel('Czas [s]')

axs[0].set_ylabel('Amplituda')

axs[0].grid(True)

# Autokorelacja

axs[1].plot(lags, R_xx, color='green', label=r"$R_{{xx}}(τ) / R_{{xx}}(0)$")

axs[1].axvline(T, color='r', linestyle='--', label=f'T = {T:.3f} s')

axs[1].axvline(2*T, color='r', linestyle=':', label=f'2T = {2*T:.3f} s')

axs[1].axvline(-T, color='r', linestyle='--')

axs[1].axvline(-2*T, color='r', linestyle=':')

axs[1].set_title('Unormowana autokorelacja')

axs[1].set_xlabel('Przesunięcie [s]')

axs[1].set_ylabel(rf'Autokorelacja $[\tau]$')

axs[1].grid(True)

axs[1].legend(loc='upper right')

plt.tight_layout()

plt.show()

import numpy as np

import matplotlib.pyplot as plt

from scipy.signal import correlate, correlation_lags

from scipy.signal import find_peaks

# Parametry

fs = 1000 # częstotliwość próbkowania [Hz]

A = 1 # amplituda sygnału

f = 3.5 # częstotliwość sygnału [Hz] (częstotliwość nośna sygnału modulowanego)

# czyli spodziewany okres wynosi w przybliżeniu 0.286 s

T = 1 / f # okres [s]

t = np.arange(0, 2, 1/fs) # czas trwania sygnału

# Sygnał pseudookresowy: sinus z modulacją częstotliwości

beta = 0.5 # większa głębokość modulacji

fm = 0.5 # czętotliwość modulacji [Hz]

x = np.sin(2 * np.pi * (f * t + beta * np.sin(2 * np.pi * fm * t)))

# Autokorelacja

R_xx = correlate(x, x, mode='full')

lags = correlation_lags(len(x), len(x), mode='full') / fs

# Normalizacja (opcjonalnie)

R_xx = R_xx / np.max(R_xx)

# Szukamy pików po stronie dodatnich opóźnień

center = len(R_xx) // 2

search_range = R_xx[center+1:] # pomijamy lag=0

lags_range = lags[center+1:]

peaks, properties = find_peaks(search_range, height=0.2, distance=int(0.05 * fs))

# wykryty pik ma mieć wartość co najmniej 0.2 - ignorujemy małe piki wynikające np. z szumu.

# minimalna odległość między pikami (w próbkach) - tu np. 0.05 * 1000 = 50 próbek,

# to chroni przed wykrywaniem zbyt blisko położonych pików.

# Szacowany okres

estimated_period = lags_range[peaks[0]] if len(peaks) > 0 else None

# Wykresy

fig, axs = plt.subplots(2, 1, figsize=(10, 6), sharex=False)

# Wykres 1: sygnał

axs[0].plot(t, x)

axs[0].set_title(f'Sygnał sinusoidalny z modulacją częstotliwości $x(t)$')

axs[0].set_xlabel('Czas [s]')

axs[0].set_ylabel("Amplituda")

axs[0].grid(True)

# Wykres 2: autokorelacja

axs[1].plot(lags, R_xx, label=r'$R_{{xx}}(τ) / R_{{xx}}(0)$', color='green')

if estimated_period is not None:

axs[1].plot(estimated_period, R_xx[center + peaks[0]], 'ro',

label=fr'Okres $\approx$ {estimated_period:.3f} s')

axs[1].axvline(estimated_period, color='red', linestyle='--')

axs[1].set_title('Unormowana autokorelacja')

axs[1].set_xlabel('Przesunięcie [s]')

axs[1].set_ylabel(rf'Autokorelacja $[\tau]$')

axs[1].legend()

axs[1].grid(True)

plt.tight_layout()

plt.show()

# Informacja tekstowa

if estimated_period is not None:

print(f'Szacowana długość powtarzającego się fragmentu: {estimated_period:.3f} sekundy')

else:

print("Nie wykryto okresu")

- znaczące zmniejszenie głębokości modulacji \( \beta \), by sygnał był mniej „zniekształcony”,

- zwiększenie częstotliwości nośnej,

- zamiast brania całości sygnału z modulacją, wziąć tylko krótki fragment, w którym częstotliwość się nie zmienia zbyt mocno.

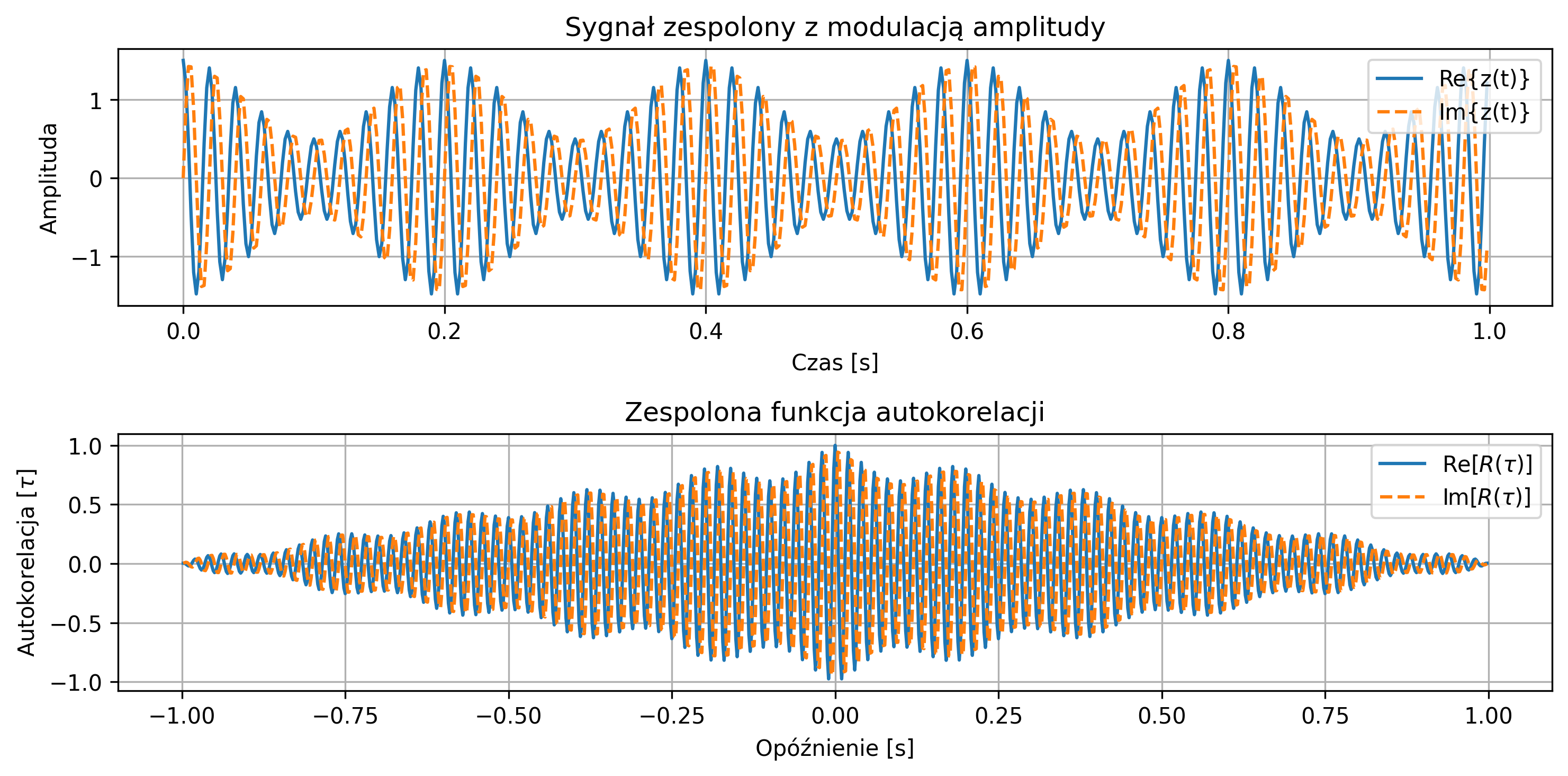

Przyjąć częstotliwość nośną \(50\) Hz i częstotliwość modulacji \(5\) Hz. Obliczyć moc i energię sygnału.

import numpy as np

import matplotlib.pyplot as plt

from scipy.signal import correlate, correlation_lags

# Parametry czasu

fs = 500

T = 1

t = np.linspace(0, T, int(fs*T), endpoint=False)

# Parametry sygnału

f = 50 # częstotliwość nośna [Hz]

fm = 5 # częstotliwość modulacji [Hz]

# Sygnał zespolony z modulacją amplitudy

envelope = 1 + 0.5 * np.cos(2 * np.pi * fm * t) # obwiednia

z = envelope * np.exp(1j * 2 * np.pi * f * t)

# Obliczanie mocy i energii

dt = 1 / fs

power = np.mean(np.abs(z)**2)

energy = np.sum(np.abs(z)**2) * dt

# Autokorelacja

corr = correlate(z, z, mode='full') * dt

lags = correlation_lags(len(z), len(z), mode='full') / fs

corr /= np.max(np.abs(corr)) # normalizacja

# Wyniki

print(f'Moc: {power:.4f}')

print(f'Energia: {energy:.4f}')

# Wykres

fig, axs = plt.subplots(2, 1, figsize=(10, 5), sharex=False)

# Sygnał zespolony: Re i Im

axs[0].plot(t, z.real, label='Re{z(t)}')

axs[0].plot(t, z.imag, '--', label='Im{z(t)}')

axs[0].set_title('Sygnał zespolony z modulacją amplitudy')

axs[0].set_xlabel('Czas [s]')

axs[0].set_ylabel('Amplituda')

axs[0].legend(loc='upper right')

axs[0].grid(True)

# Autokorelacja

axs[1].plot(lags, corr.real, label=rf'Re$[R(\tau)]$')

axs[1].plot(lags, corr.imag, '--', label=rf'Im$[R(\tau)]$')

axs[1].set_title('Zespolona funkcja autokorelacji')

axs[1].set_xlabel('Opóźnienie [s]')

axs[1].set_ylabel(rf'Autokorelacja $[\tau]$')

axs[1].legend()

axs[1].grid(True)

plt.tight_layout()

plt.show()

2.10. Test A - sprawdź swoją wiedzę

Test ma na celu sprawdzenie i utrwalenie wiadomości z zakresu analizy sygnałów, obejmując sygnały analogowe i cyfrowe, systemy LTI, operacje takie jak splot i autokorelacja oraz podstawowe własności sygnałów. Każde pytanie ma trzy odpowiedzi (A, B, C), z których tylko jedna jest poprawna.

Klucz odpowiedzi:

1. B

2. A

3. B

4. C

5. A

6. A

7. B

8. A

9. C

10. A

11. A

12.B

13. B

14. B

15. B

16. C

17. B

18. B

19. C

20. A

21. B

22. A

23. B

24. A

25. C

3. Cyfrowe przetwarzanie sygnałów

Przetwarzanie sygnałów cyfrowych (DSP, ang. Digital Signal Processing) jest dziedziną nauki i techniki zajmującą się analizą, przekształcaniem i interpretacją sygnałów zapisanych w postaci cyfrowej. Obejmuje zarówno teorię, jak i metody numeryczne oraz techniki przetwarzania dźwięku, obrazu i sygnałów biomedycznych. Cyfrowe przetwarzanie sygnałów znalazło szerokie zastosowanie w telekomunikacji, elektronice oraz w nowoczesnej diagnostyce medycznej, na przykład w tomografii komputerowej (CT), rezonansie magnetycznym (MRI), elektroencefalografii (EEG) czy badaniu echa serca (USG).

W systemach cyfrowych, sygnały analogowe (ciągłe w czasie i amplitudzie) muszą zostać zamienione na postać cyfrową – proces ten realizowany jest przez przetwornik analogowo-cyfrowy (A/C), który dokonuje próbkowania i kwantyzacji sygnału. Odpowiednie dobranie parametrów próbkowania ma kluczowe znaczenie dla jakości dalszego przetwarzania sygnału. Jednym z najważniejszych zagadnień w tym kontekście jest twierdzenie Nyquista-Shannona, które określa minimalną częstotliwość próbkowania konieczną do jednoznacznego odtworzenia sygnału. Brak spełnienia tego warunku prowadzi do zjawiska aliasingu – nakładania się widm i utraty informacji o sygnale. Dlatego w praktyce stosuje się filtry antyaliasingowe oraz odpowiednio wysokie częstotliwości próbkowania.

Przetwarzanie sygnałów cyfrowych jest zwykle realizowane przez specjalizowane układy cyfrowe. Dzięki dużej wydajności obliczeniowej możliwa jest obróbka sygnałów w czasie rzeczywistym, co ma kluczowe znaczenie w wielu nowoczesnych systemach technicznych.

W niniejszym rozdziale omówione zostaną zasady poprawnego próbkowania, rola twierdzenia Nyquista-Shannona oraz praktyczne aspekty związane z filtrowaniem antyaliasingowym. Zostaną również przedstawione przykłady w języku Python, ilustrujące skutki nieprawidłowego próbkowania, aliasingu oraz sposoby jego zapobiegania.

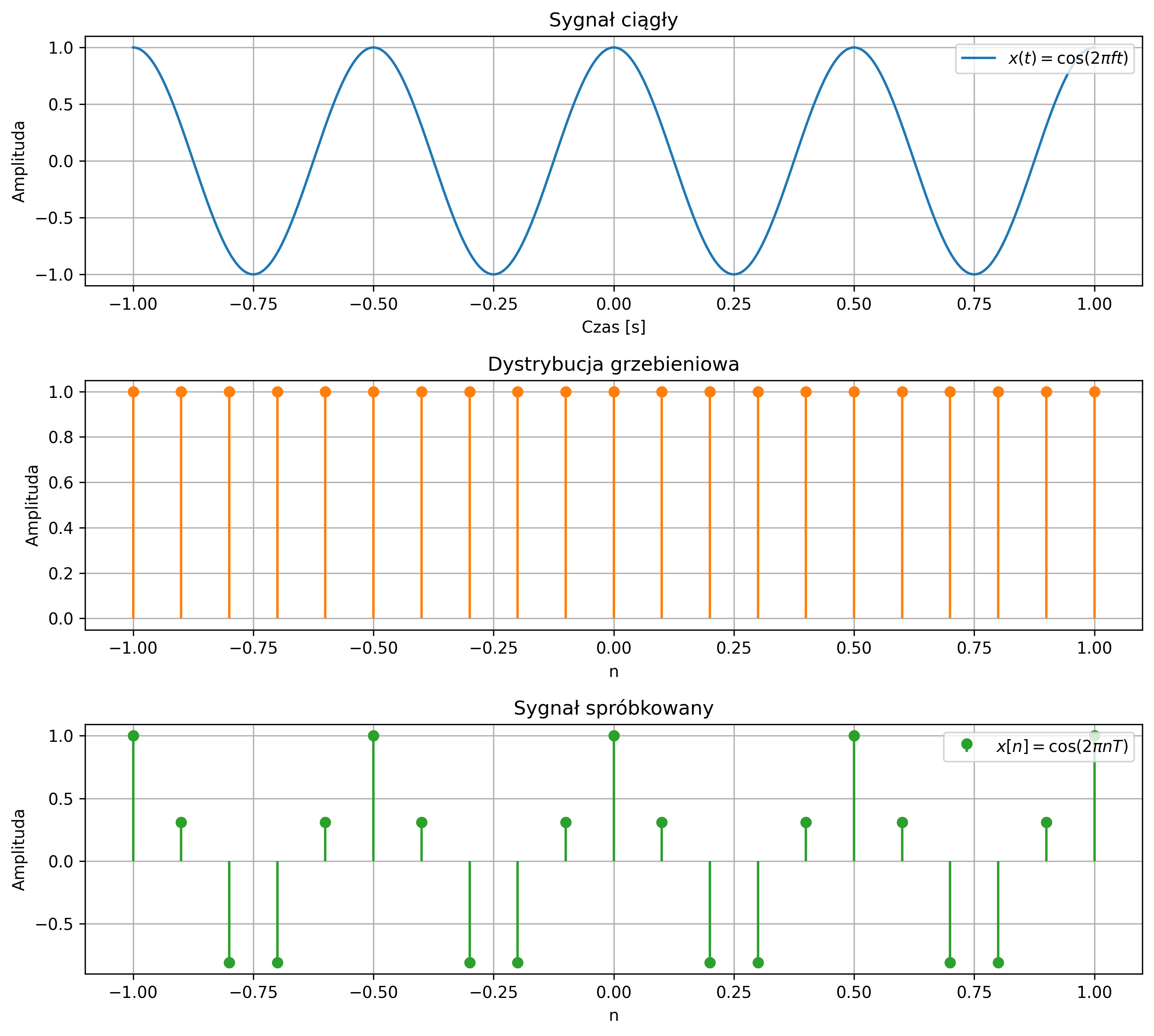

3.1. Reprezentacja próbkowania

Próbkowanie to proces przekształcania sygnału ciągłego w sygnał dyskretny poprzez pobieranie jego wartości w równych odstępach czasu. Stanowi ono pierwszy etap konwersji analogowo-cyfrowej (A/C) i jest niezbędne do analizy oraz przetwarzania sygnałów w systemach cyfrowych. W przypadku próbkowania w regularnych odstępach czasu podaje się częstotliwość próbkowania, wyrażaną w liczbie próbek na sekundę, czyli w hercach (Hz). Dla próbkowania wielowymiarowego określa się rozdzielczość w postaci liczby punktów lub pikseli na cal. Obecnie produkowane przetworniki analogowo-cyfrowe oferują maksymalną częstotliwość próbkowania od kilkudziesięciu kiloherców do kilku megaherców.

W wyniku próbkowania równomiernego z okresem \( T \) sygnał analogowy \( x(t) \) jest przetworzony w sygnał dyskretny \( x[n] \), którego argumentem jest czas unormowany względem okresu próbkowania. Proces próbkowania można stosunkowo łatwo modyfikować poprzez zmianę okresu próbkowania. Należy jednak pamiętać, że wpływa to na odwzorowanie sygnału analogowego w zapisie cyfrowym oraz ma istotne znaczenie dla identyfikacji i przetwarzania sygnału.

W rozdziale 2.4 została opisana operacja splotu i jej podstawowa własność – elementem identycznościowym operacji splotu jest impuls Diraca:

\( x(t)\ast \delta(t) = x(t) \) oraz \( x(t)\ast \delta(t-t_0) = x(t-t_0) \)

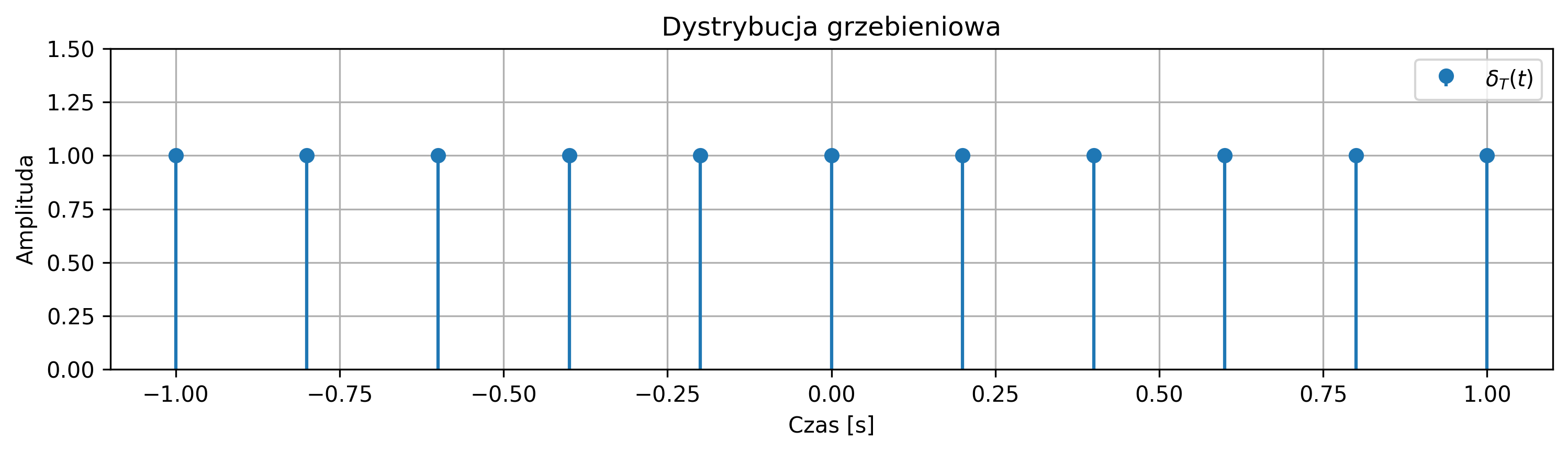

Matematycznie proces próbkowania można opisać jako mnożenie sygnału ciągłego przez funkcję impulsów jednostkowych Diraca rozmieszczonych okresowo – dystrybucję grzebieniową.

Dystrybucja grzebieniowa jest okresowym ciągiem impulsów Diraca, powtarzanych z okresem \( T \). Jej wykres przypomina nieskończony grzebień, którego „zęby” są równoodległe i mają jednakową wysokość:

3.2. Problemy związane z próbkowaniem

Przejście do sygnału cyfrowego pozwala na efektywne przetwarzanie, przechowywanie i transmisję, ale wiąże się z szeregiem potencjalnych problemów technicznych:

- aliasing (zakłócenia aliasowe),

- błąd kwantyzacji,

- opóźnienia,

- ograniczenia sprzętowe,

- artefakty cyfrowe.

Poprawne zaprojektowanie procesu próbkowania i konwersji ma kluczowe znaczenie dla jakości całego systemu cyfrowego.

W procesie próbkowania część informacji o sygnale jest pomijana. Jeżeli zmiany sygnału są bardzo szybkie w porównaniu z częstotliwością próbkowania, dynamika sygnału oryginału nie zostanie uchwycona. Podstawowym zagadnieniem podczas cyfrowego przetwarzania sygnałów jest właściwy dobór częstotliwości próbkowania. Powinna ona być dobrana tak, aby:

- była wystarczająco duża, by dokładnie odwzorowywać zmienność i dynamikę badanego sygnału,

- nie była nadmiernie wysoka, ponieważ zbyt gęste próbkowanie prowadzi do powstania dużej liczby silnie skorelowanych próbek, co zwiększa koszty pamięciowe i obliczeniowe, nie przynosząc istotnych korzyści informacyjnych,

- nie była też zbyt niska, ponieważ zbyt rzadkie próbkowanie może prowadzić do zjawiska, w którym informacje o składowych wysokoczęstotliwościowych zostają zniekształcone lub nieodróżnialne od składowych niskoczęstotliwościowych.

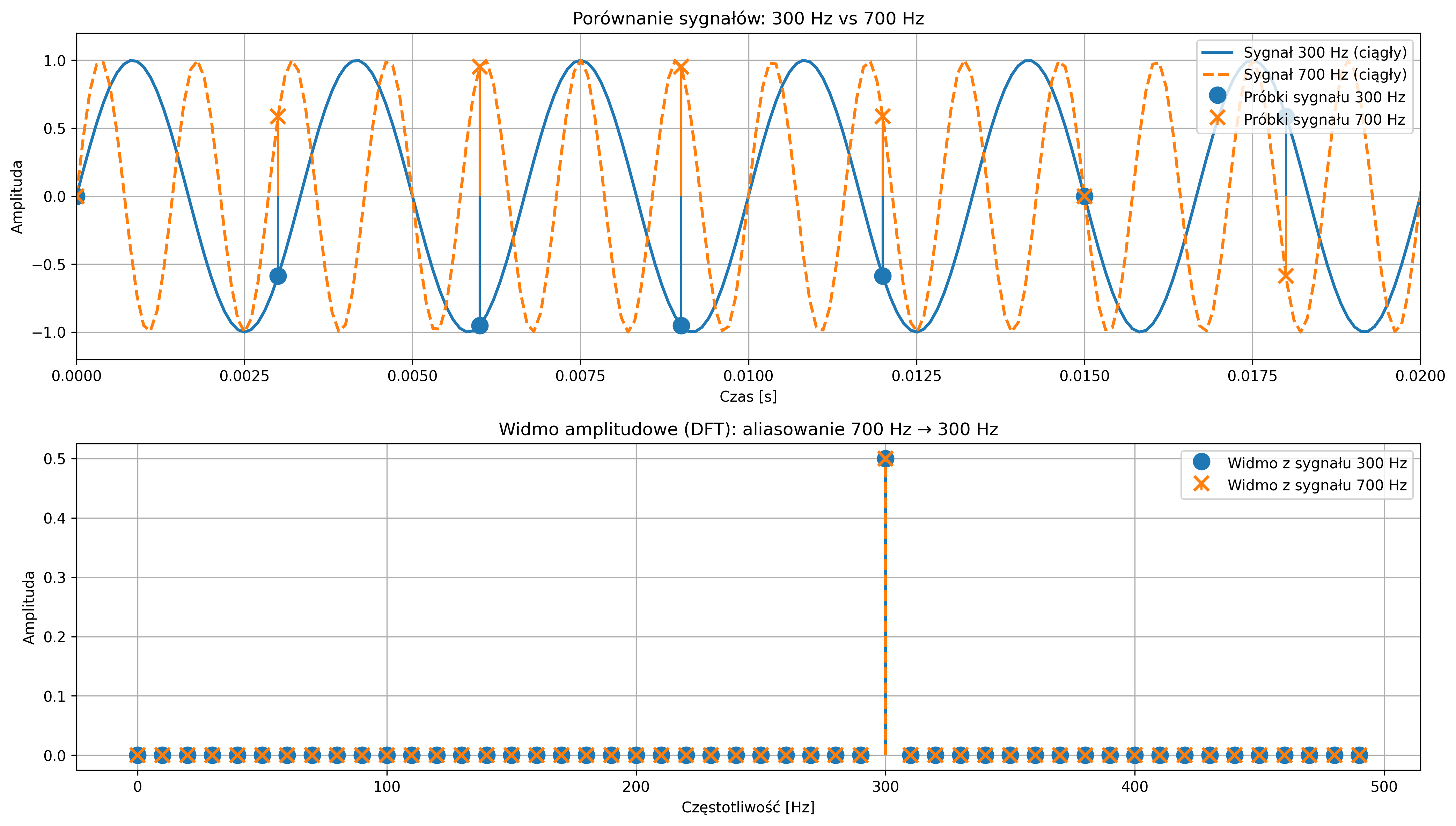

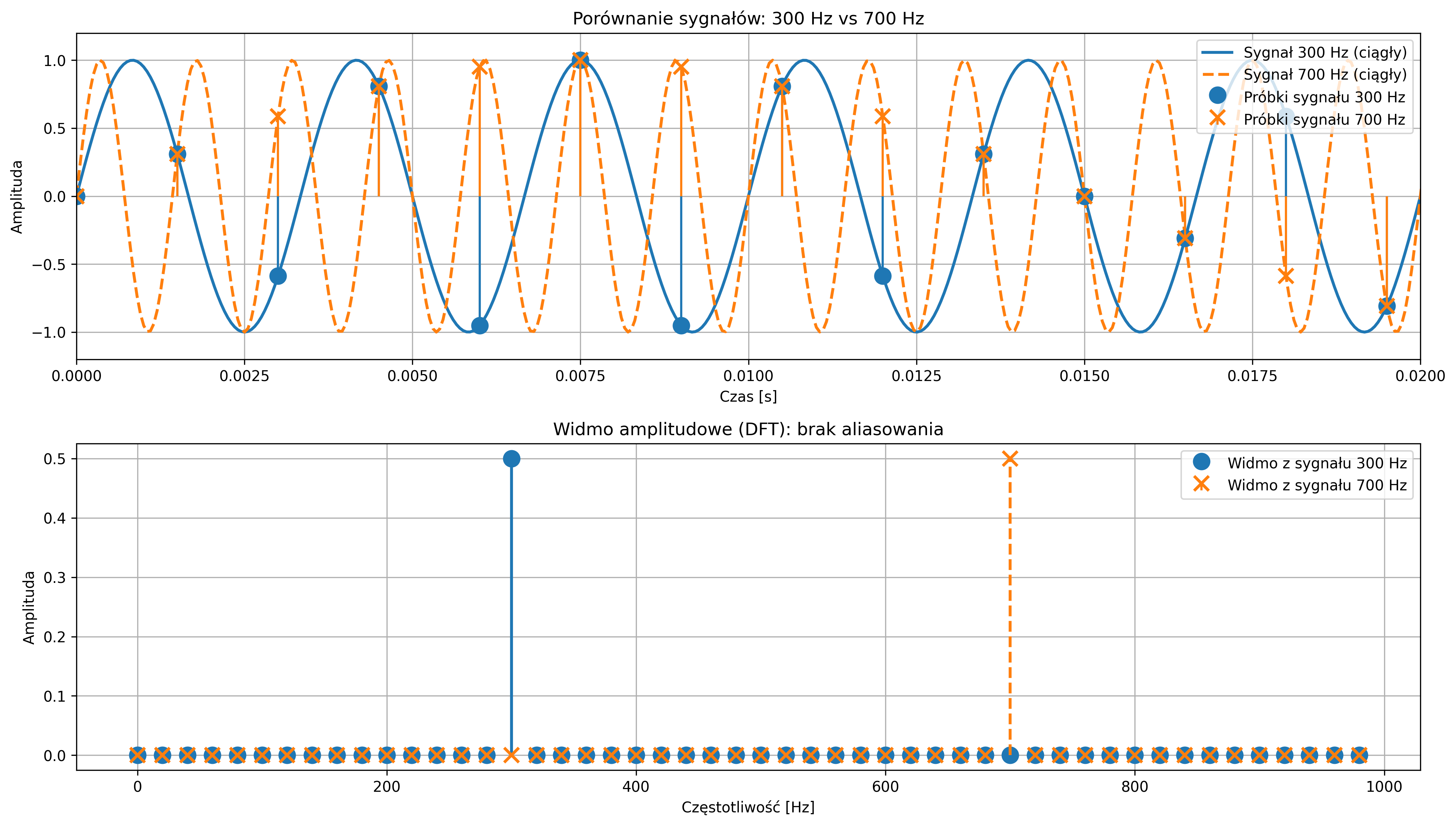

Podczas próbkowania sygnału z częstotliwością \( f_s \) próbek na sekundę, niemożliwe staje się jednoznaczne rozróżnienie między sygnałem sinusoidalnym o częstotliwości \( f \), a sygnałami o częstotliwościach \( f+kf_s \), gdzie \( k \) jest dowolną liczbą całkowitą. Oznacza to, że ten sam zbiór próbek może odpowiadać nieskończonej liczbie sinusoid różniących się całkowitymi wielokrotnościami częstotliwości próbkowania.

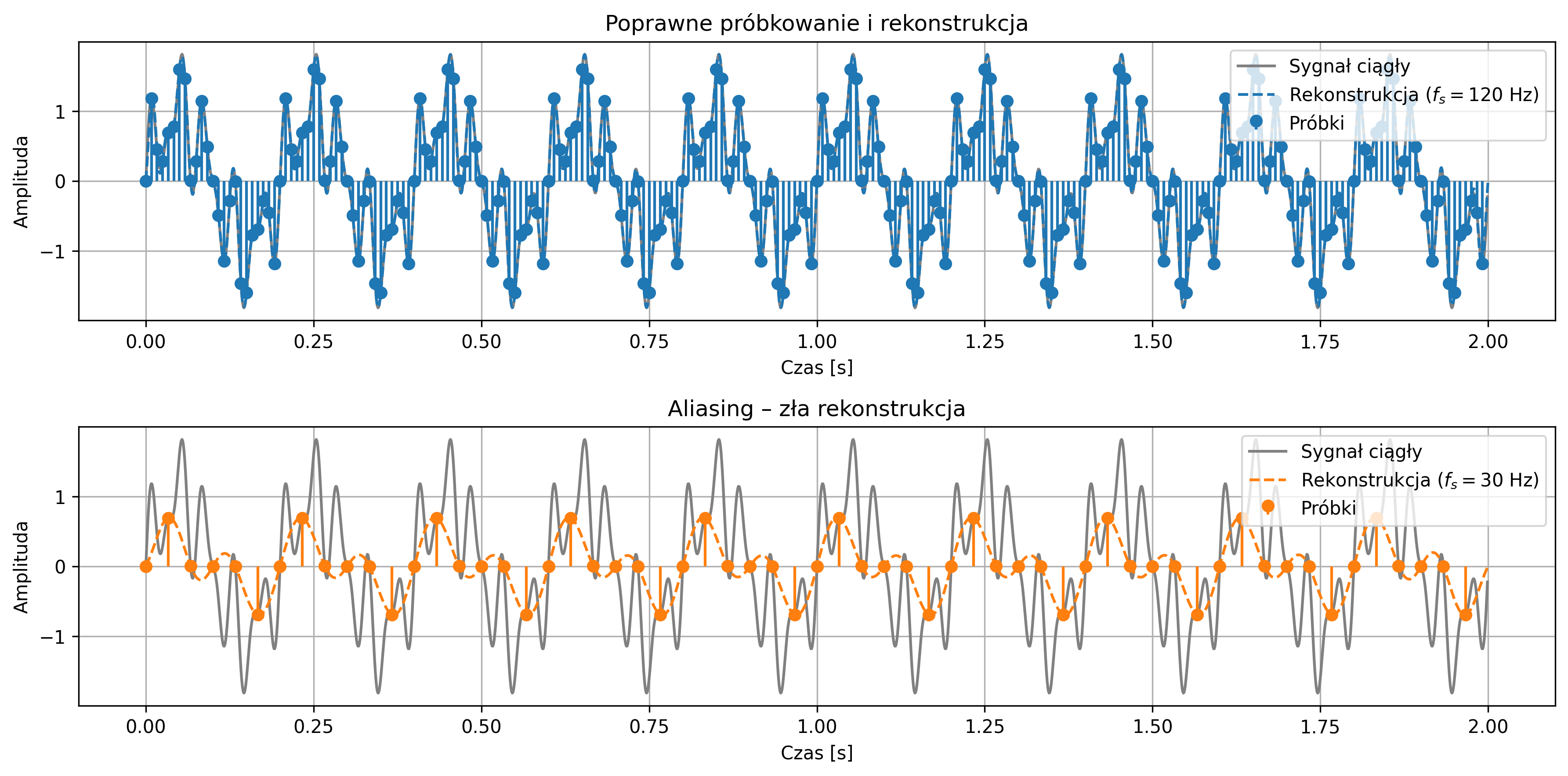

Jest to podstawowa właściwość próbkowania i jedna z kluczowych konsekwencji analizy sygnałów w dziedzinie częstotliwości. Niewłaściwie dobrana częstotliwość próbkowania prowadzi często do błędnej interpretacji sygnału analogowego, znanej jako aliasing. Zjawisko to polega na tym, że na podstawie zbyt rzadko pobranych próbek z oryginalnego przebiegu sygnału system cyfrowy interpretuje sygnał jako mający inną częstotliwość, niż w rzeczywistości.

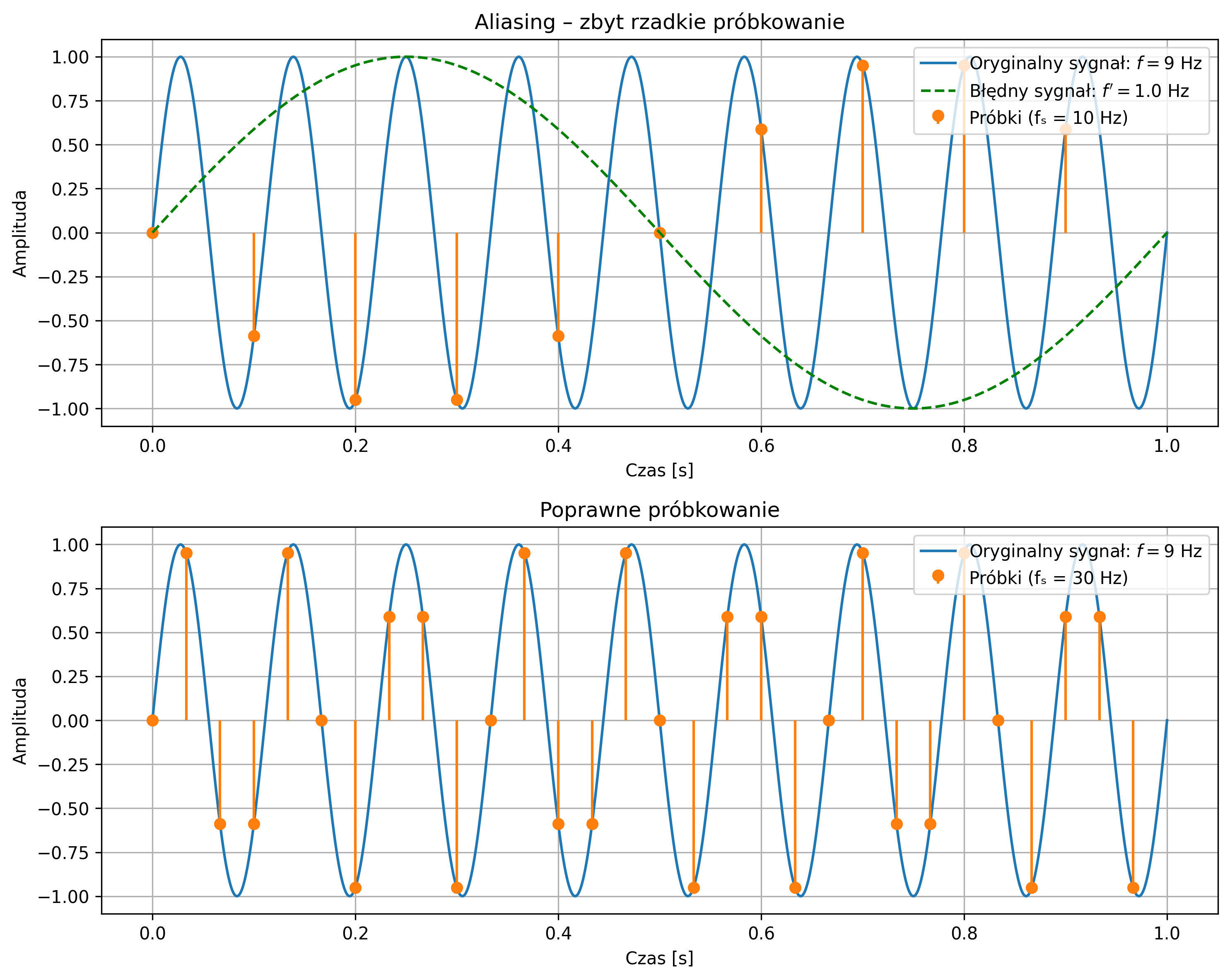

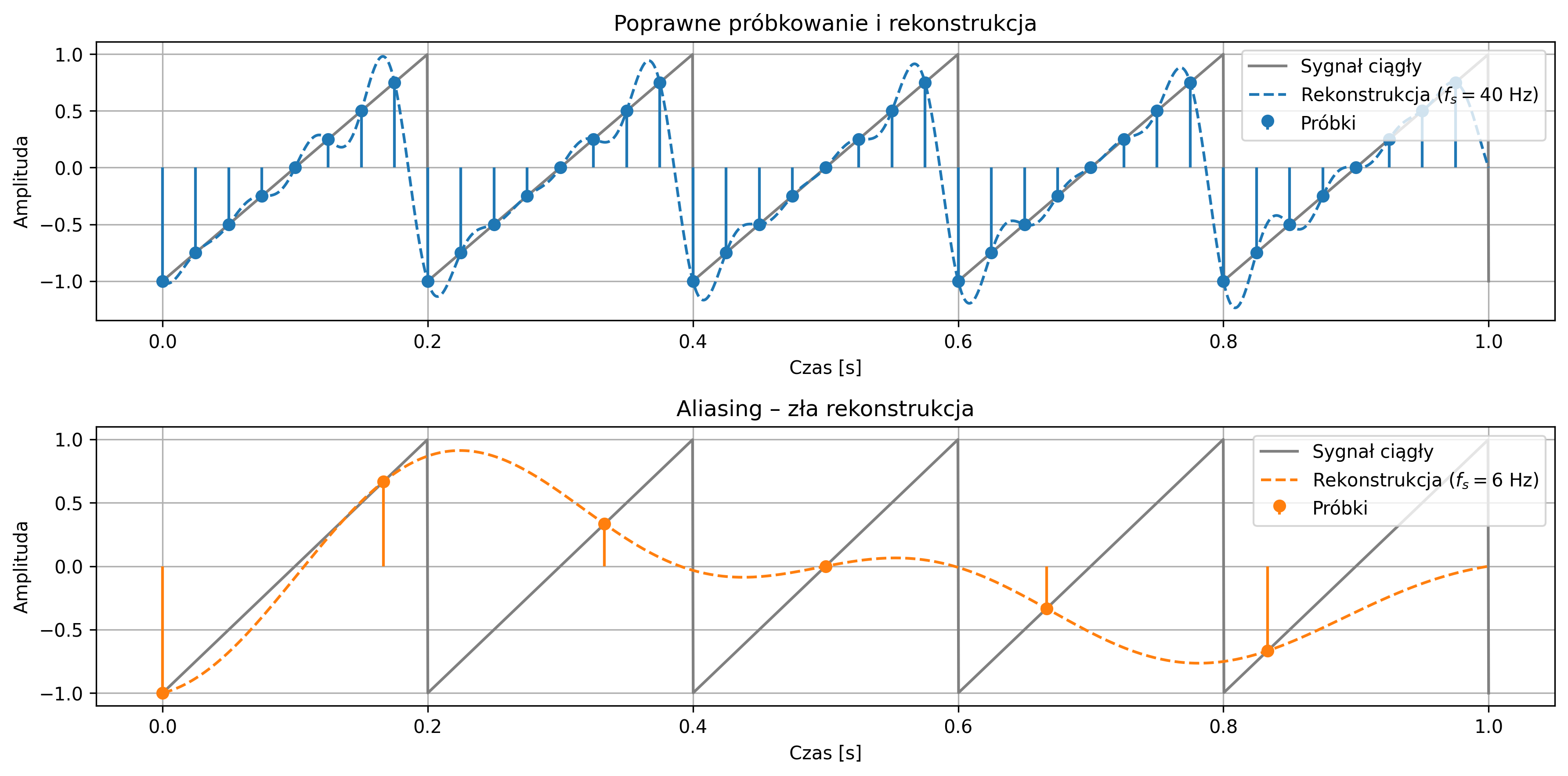

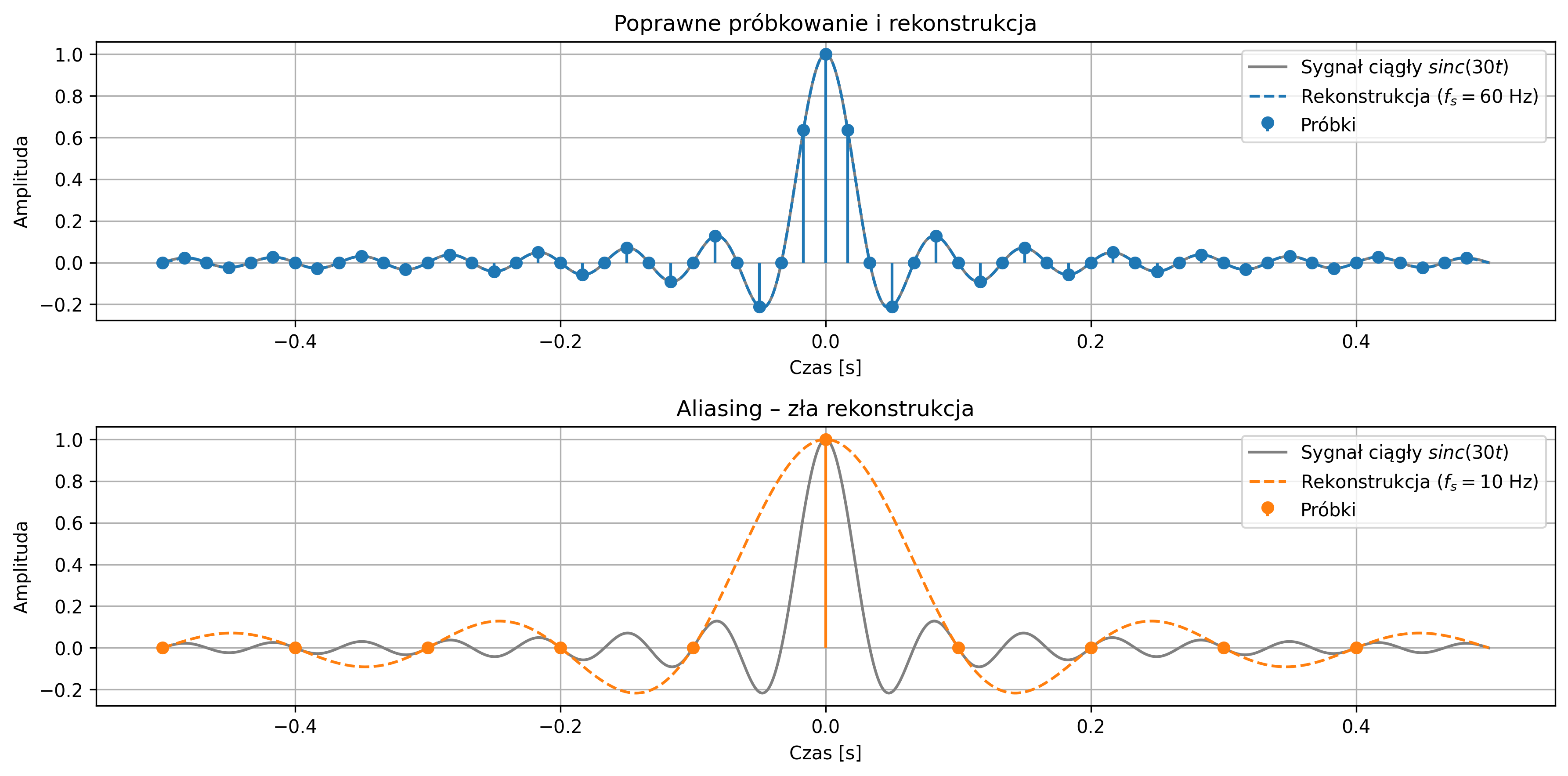

Na rys. 3.3 zostało graficznie przedstawione zjawisko aliasingu. Na pierwszym wykresie próbkowanie sygnału sinusoidalnego (o częstotliwości \(9\) Hz) jest zbyt rzadkie (częstotliwość próbkowania wynosi \(10\) Hz), co skutkuje jego błędnym odwzorowaniem sygnału. System identyfikuje sygnał jako mający niższą częstotliwość, niż w rzeczywistości. Drugi wykres pokazuje poprawne próbkowanie (na poziomie \(30\) Hz) – częstotliwość próbkowania jest wystarczająco wysoka, aby dokładnie odwzorować przebieg oryginalnego sygnału.

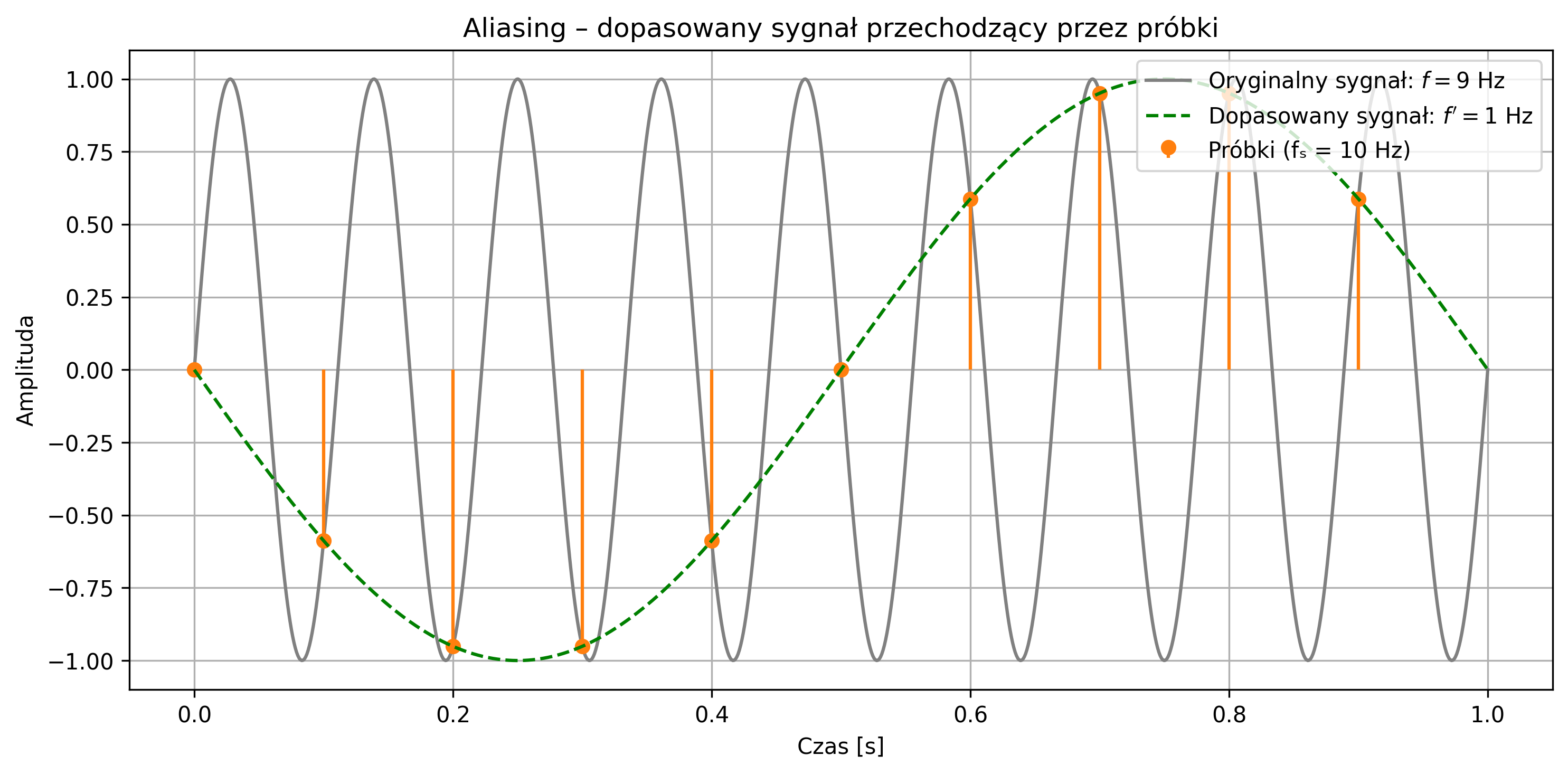

Błędnie odtworzony sygnał (zielona przerywana linia) nie musi przechodzić przez wszystkie próbki, ponieważ on nie jest rekonstrukcją sygnału rzeczywistego, tylko fałszywym sygnałem sinusoidalnym o innej częstotliwości, który mógłby dać te same próbki w tych samych chwilach czasu (rys. 3.4). Jednakże, pomimo tego, że próbkujemy zbyt rzadko, to więcej niż jeden sygnał ciągły może dawać te same próbki – takie same wartości w chwilach próbkowania (np. co \(0.1\) s), mimo że mają zupełnie inne kształty między tymi punktami.

Aby uniknąć aliasingu i móc jednoznacznie odtworzyć sygnał na podstawie jego próbek, konieczne jest spełnienie twierdzenia Nyquista-Shannona, które mówi, że:

gdzie:

- \( x(t) \) – sygnał pasmowo ograniczony do \( f_{max} \),

- \( x[n]=x(nT) \) – próbki sygnału, dla okresu próbkowania \( T=1/f_s \).

Częstotliwość próbkowania musi być co najmniej dwa razy większa od najwyższej częstotliwości zawartej w sygnale. Tę minimalną dopuszczalną częstotliwość próbkowania \( f_s=2f_{max} \) nazywamy częstotliwością Nyquista. Jeśli próbkowanie przebiega zgodnie z tym warunkiem, sygnał może zostać dokładnie zrekonstruowany z próbek.

Gdy częstotliwość sygnału przekracza częstotliwość Nyquista, wysokoczęstotliwościowe składowe sygnału „nakładają się” na niższe, tworząc mylący obraz przebiegu. Zjawisko to stanowi potencjalne źródło błędów, specyficznych dla cyfrowego przetwarzania sygnałów. Dlatego poprawny dobór częstotliwości próbkowania oraz zastosowanie odpowiednich filtrów antyaliasingowych są kluczowe dla wiarygodności cyfrowej analizy sygnałów.

Przypomnijmy, że sygnał spróbkowany to sygnał, który jest dyskretny w czasie, ale w ogólności ciągły w amplitudzie. Oznacza to, że jego wartości występują tylko w wybranych chwilach czasu, lecz same wartości próbek mogą przyjmować dowolne wartości rzeczywiste – należące do zbioru ciągłego. Aby możliwe było jego pełne przetwarzanie w systemach cyfrowych, konieczne jest ograniczenie również zakresu możliwych wartości amplitudy.

Proces ten nazywamy kwantyzacją – polega on na zaokrągleniu wartości próbek do najbliższych poziomów z ustalonego, skończonego zbioru dopuszczalnych wartości. W niniejszym opracowaniu, proces kwantyzacji nie jest uwzględniany, gdyż zwykle jest realizowany automatycznie przez przetworniki analogowo-cyfrowe i systemy komputerowe. Jednakże należy podkreślić, że kwantyzacja wiąże się z powstaniem błędu, tzw. szumu kwantyzacji. Jest to różnica między rzeczywistą wartością próbki, a jej reprezentacją cyfrową. Wartości tego błędu mogą obniżać jakość sygnału.

Kolejnym problemem są opóźnienia. Przetwarzanie cyfrowe zajmuje czas – w systemach czasu rzeczywistego może to prowadzić do opóźnień. Podobnie nieprawidłowe taktowanie może wprowadzić zmienność między odstępami próbkowania. Ponadto, przetworniki mają ograniczony zakres dynamiczny, pasmo przenoszenia i szybkość konwersji. Mogą nie nadążyć za sygnałem, zwłaszcza przy dużych częstotliwościach. Z kolei błędy numeryczne, aliasing, niewłaściwe próbkowanie lub filtrowanie mogą prowadzić do artefaktów w sygnałach – w obrazie, dźwięku lub analizie danych biomedycznych (np. EKG).

3.3. Próbkowanie sygnałów w języku Python

Celem poniższych ćwiczeń jest zapoznanie się z podstawowymi poleceniami języka Python, które umożliwiają poprawne próbkowanie sygnałów ciągłych oraz generowanie ich przebiegów czasowych.

Poniższe przykłady przedstawiają pełne kody źródłowe w języku Python, opracowane na potrzeby realizacji poszczególnych zadań. Do wykonania przedstawionych zadań wymagane jest wykorzystanie następujących bibliotek języka Python:

import numpy as np # obliczenia numeryczne i tablice

import matplotlib.pyplot as plt # tworzenie wykresów ciągłych i dyskretnych

import scipy.signal as signal # generowanie standardowych sygnałów,

# takich jak np. prostokątny, trójkątny, piłokształtny

oraz wymagana jest znajomość między innymi funkcji:

sawtooth # generowanie sygnału piłokształtnego (scipy.signal)

np.interp # interpolacja liniowa jednowymiarowych danych (NumPy)

Do rekonstrukcji sygnałów wykorzystano metodę interpolacji Sinc, będącą jedną z najdokładniejszych metod rekonstrukcji w teorii cyfrowego przetwarzania sygnałów. W poniższych implementacjach została ona zdefiniowana w postaci funkcji:

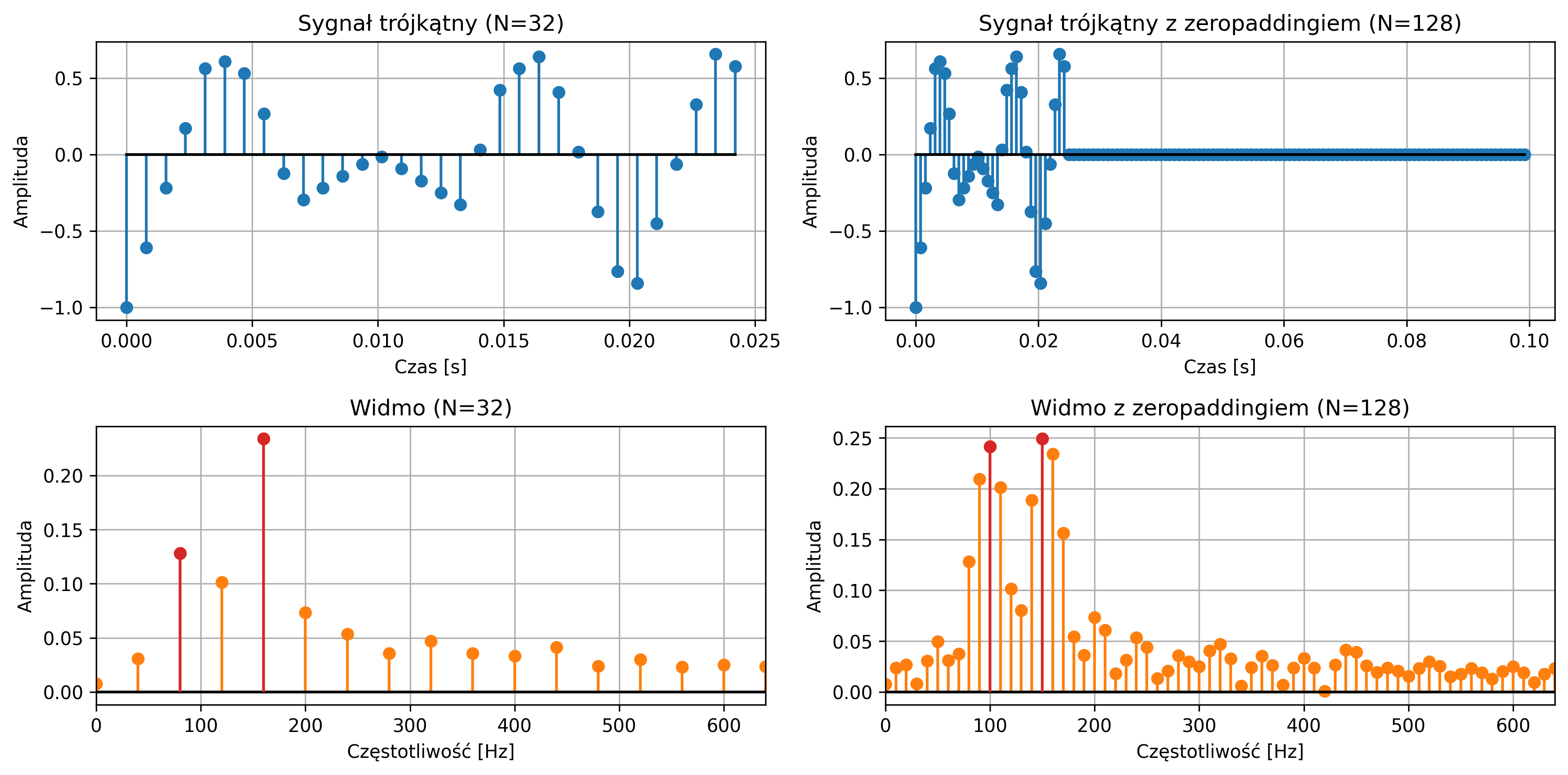

sinc_interp()