Podręcznik

| Strona: | SEZAM - System Edukacyjnych Zasobów Akademickich i Multimedialnych |

| Kurs: | 2. Zaawansowane struktury sieci neuronowych |

| Książka: | Podręcznik |

| Wydrukowane przez użytkownika: | Gość |

| Data: | czwartek, 22 stycznia 2026, 16:39 |

Spis treści

- 1. Sieci radialne RBF

- 1.1. Wprowadzenie

- 1.2. Sieć radialna RBF

- 1.3. Metody uczenia sieci neuronowych radialnych

- 1.4. Metody doboru liczby funkcji bazowych

- 1.5. Program komputerowy uczenia sieci radialnych

- 1.6. Przykład zastosowania sieci radialnej w aproksymacji

- 1.7. Porównanie sieci radialnych z sieciami sigmoidalnymi

- 1.8. Przykład zastosowania sieci RBF w modelu sztucznego nosa elektronicznego

- 1.9. Zadania i problemy

- 1.10. Słownik

- 2. Sieci wektorów nośnych SVM

- 2.1. Pojęcia wstępne

- 2.2. Sieć liniowa SVM w zadaniu klasyfikacji

- 2.3. Sieć nieliniowa SVM w zadaniu klasyfikacji

- 2.4. Sieć SVM do zadań regresji

- 2.5. Przegląd algorytmów rozwiązania zadania dualnego

- 2.6. Program komputerowy uczenia sieci SVM

- 2.7. Przykłady zastosowania sieci SVM

- 2.8. Porównanie sieci SVM z innymi rozwiązaniami neuronowymi

- 2.9. Zadania i problemy

- 2.10. Słownik

- 3. Sieci neuronowe głębokie

- 3.1. Wprowadzenie

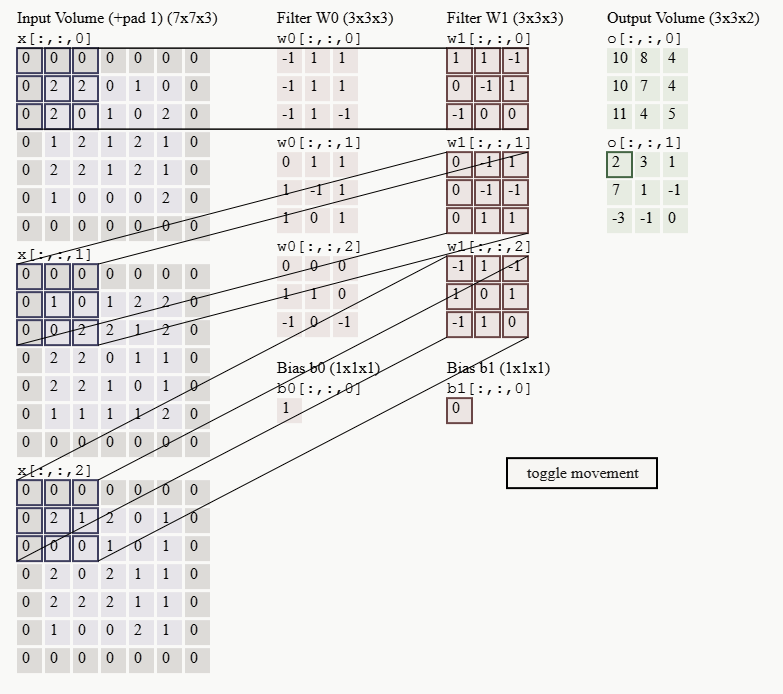

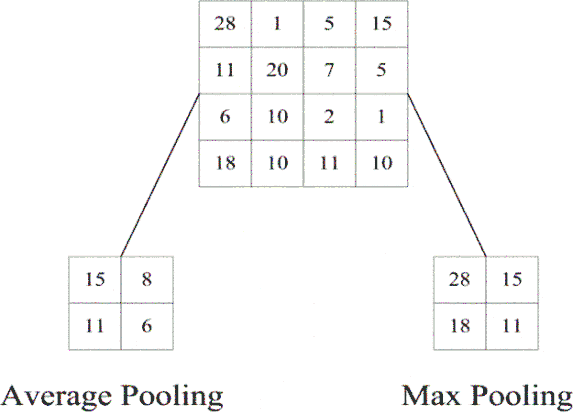

- 3.2. Sieć konwolucyjna CNN

- 3.3. Transfer Learning

- 3.4. Przykład użycia sieci ALEXNET w trybie transfer learning

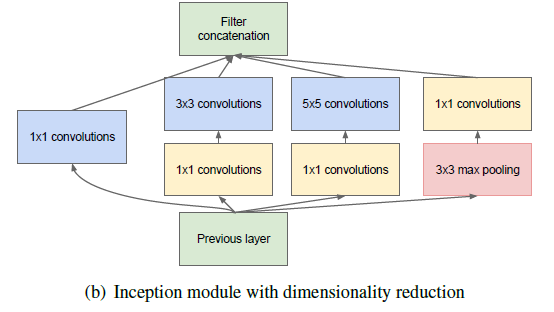

- 3.5. Inne rozwiązania pre-trenowanej architektury sieci CNN

- 3.6. Sieci CNN do detekcji obiektów w obrazie

- 3.7. Sieć U-NET w segmentacji obrazów biomedycznych

- 3.8. Autoenkoder

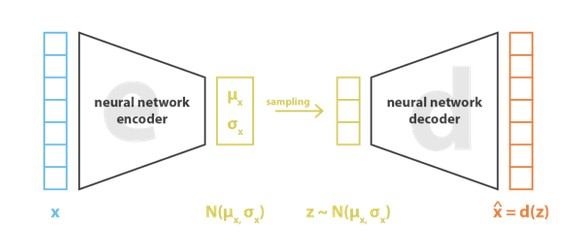

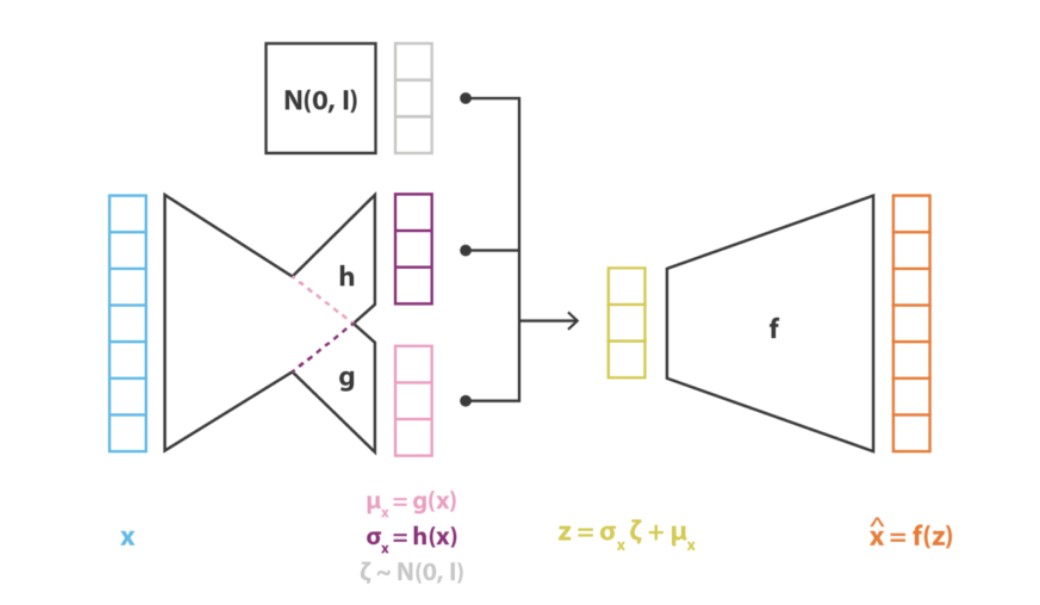

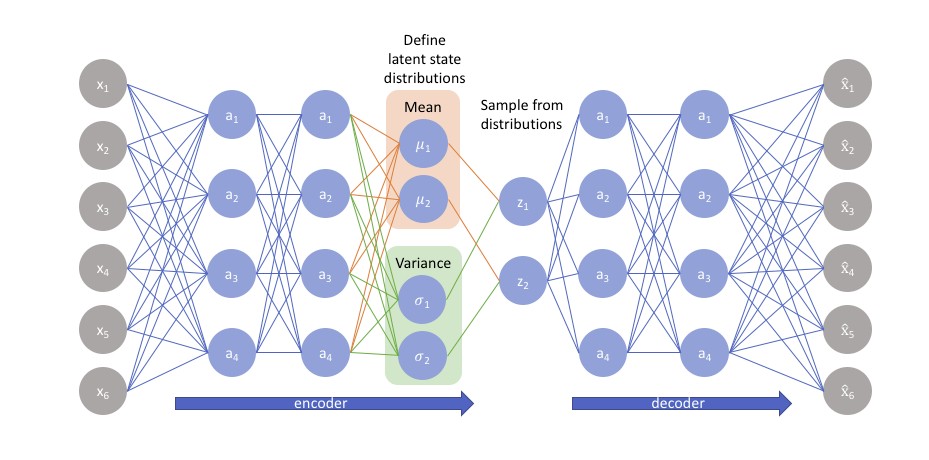

- 3.9. Autoenkoder wariacyjny

- 3.10. Sieci generatywne GAN

- 3.11. Zadania i problemy

- 3.12. Słownik

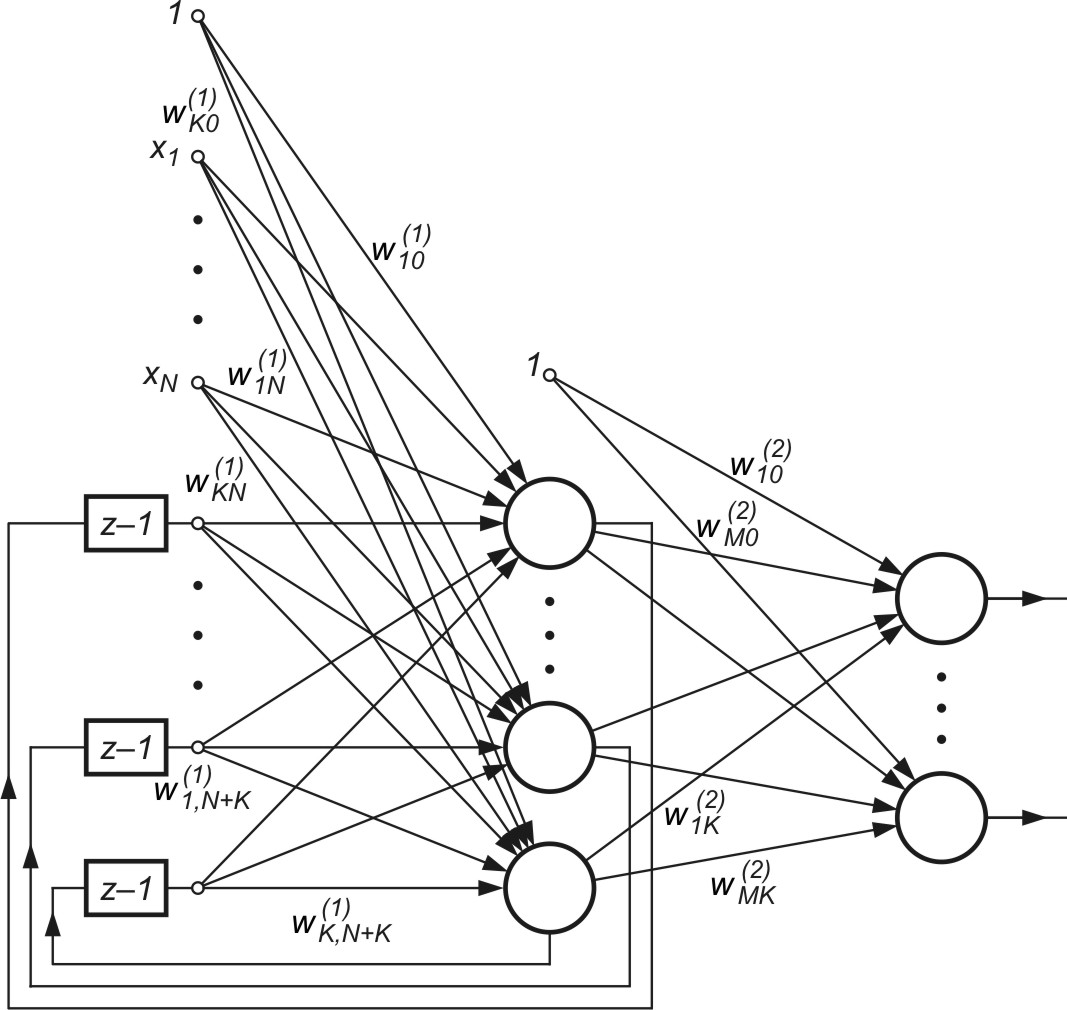

- 4. Sieci rekurencyjne

- 5. Literatura

1. Sieci radialne RBF

Wykład ten poświęcony będzie sieciom stosującym neurony o radialnej funkcji aktywacji (zwykle funkcja gaussowska), zwane sieciami RBF [24,46]. W odróżnieniu od sieci perceptonowej stosującej sigmoidalną funkcję aktywacji, niezerową w całym zakresie zmian zmiennej wejściowej, neurony gaussowskie w sieci RBF generują niezerowe wartości sygnałów jedynie w bliskim otoczeniu swojego centrum. Sieć taka stanowi uniwersalny aproksymator o charakterze lokalnym. Przedstawimy strukturę tej sieci oraz algorytmy uczące wykorzystujące lokalny charakter funkcji gaussowskiej. Algorytmy te są wielokrotnie szybsze niż algorytmy uczące sieci MLP. Na zakończenie przedstawimy program uczący sieci RBF oraz wyniki działania tego programu na wybranych problemach testowych.

1.1. Wprowadzenie

Sieci neuronowe wielowarstwowe, pełnią z punktu widzenia matematycznego rolę uniwersalnego aproksymatora funkcji wielu zmiennych, odwzorowując zbiór zmiennych wejściowych \( \mathbf{x} \) w zbiór zmiennych wyjściowych \( \mathbf{y} \). W przypadku sieci MLP jest to aproksymacja typu globalnego, w której ze względu na charakter sigmoidalnej funkcji aktywacji każdy neuron uczestniczy w odwzorowaniu funkcyjnym w całej przestrzeni wartości zmiennej wejściowej. Odwzorowanie wartości funkcji w dowolnym punkcie przestrzeni jest więc dokonywane zbiorowym wysiłkiem wielu neuronów na raz (stąd nazwa aproksymacji globalnej).

Innym komplementarnym sposobem odwzorowania zbioru wejściowego w wyjściowy jest odwzorowanie przy zastosowaniu wielu pojedynczych funkcji o skończonym nośniku, w którym działanie pojedynczego neuronu ogranicza się do wąskiego obszaru przestrzeni wielowymiarowej (w pobliżu centrum tej funkcji). W takim rozwiązaniu odwzorowanie pełnego zbioru danych jest sumą odwzorowań lokalnych, gdzie dla każdego punktu przestrzeni tylko nieliczne neurony charakteryzują się niezerowymi wartościami sygnałów - stąd nazwa aproksymacji lokalnej.

Przykładem są tu sieci o radialnej funkcji bazowej (RBF), w której neuron ukryty realizuje funkcję zmieniającą się radialnie wokół wybranego centrum \( c \) i przyjmującą wartości niezerowe tylko w otoczeniu tego centrum. Typowym przykładem, najczęściej stosowanym w sieciach RBF jest funkcja gaussowska, która w przypadku sieci RBF może być dla argumentu skalarnego zapisana w postaci [24]

| \( \varphi(x)=\exp \left(-\frac{(x-c)^2}{\sigma^2}\right) \) | (4.1) |

Funkcja ta przyjmuje niezerowe wartości jedynie w bliskim otoczeniu centrum \( c \), którego wielkość jest regulowana poprzez parametr szerokości \( \sigma \). W przypadku przestrzeni wielowymiarowej funkcja gaussowska jest opisana wzorem

| \( \varphi(\mathbf{x})=\varphi(\mathbf{x}-\mathbf{c})=\exp \left(-\frac{\|\mathbf{x}-\mathbf{c}\|^2}{\sigma^2}\right) \) | (4.2) |

w którym \( \|\mathbf{x}-\mathbf{c}\| \) oznacza normę euklidesową wektora \( (\mathbf{x}-\mathbf{c}) \). W sieciach RBF (ang. Radial Basis Function) rola neuronu ukrytego sprowadzać się będzie do odwzorowania radialnego przestrzeni wokół jednego punktu zadanego lub grupy takich punktów stanowiących klaster. Superpozycja sygnałów pochodzących od wszystkich neuronów ukrytych (klastrów), dokonywana przez neuron wyjściowy, pozwala uzyskać odwzorowanie całej przestrzeni wielowymiarowej.

Sieci typu radialnego stanowią naturalne uzupełnienie sieci sigmoidalnych. Co więcej, wobec różnej funkcji, jaką pełnią neurony, w sieciach radialnych nie zachodzi potrzeba stosowania wielu warstw ukrytych. Typowa sieć radialna jest strukturą zawierającą warstwę wejściową, do której przykładane są sygnały opisane wektorem wejściowym \( \mathbf{x} \), jedną warstwę ukrytą o neuronach typu radialnego transformującą \( N \) sygnałów wejściowych w przestrzeń \( K\)-wymiarową (\( K \)– liczba neuronów ukrytych) oraz warstwę wyjściową, złożoną z jednego lub większej liczby neuronów liniowych. Rola neuronu wyjściowego sprowadza się jedynie do sumowania wagowego sygnałów pochodzących od neuronów ukrytych tworząc sygnał \( y \). W przypadku zastosowania sieci RBF jako klasyfikatora wystarczy dołączyć na wyjściu blok realizujący funkcję signum o wartości wyjściowej 1 (rozpoznana klasa) lub 0 (brak przynależności do klasy).

1.2. Sieć radialna RBF

Najprostsza sieć neuronowa typu radialnego o jednym wyjściu działa na zasadzie wielowymiarowej aproksymacji, której zadaniem jest odwzorowanie \( p \) różnych wektorów wejściowych \( \mathbf{x}_i \) z przestrzeni wejściowej \( N \)-wymiarowej w zbiór \( p \) liczb rzeczywistych \( y_i \) odpowiadających wartościom zadanym \( d_i \). Interpolacja odpowiada tu przyjęciu \( p \) neuronów ukrytych typu radialnego o centrach w wektorach \( \mathbf{x}_i \) i określeniu takiej funkcji odwzorowania \( F(\mathbf{x}) \), dla której spełnione są warunki

| \( F\left(\mathbf{x}_i\right)=d_i+\varepsilon_i \) | (4.3) |

gdzie \( \varepsilon_i \) reprezentuje akceptowalny błąd dopasowania. Przy ograniczeniu się do \( K \) funkcji bazowych o różnych położeniach centrów \( \mathbf{c}_i \) rozwiązanie aproksymujące można przedstawić w postaci [24, 46]

| \( F(\mathbf{x})=\sum_{i=1}^K w_i \varphi\left(\mathbf{x}-\mathbf{c}_i\right) \) | (4.4) |

gdzie \( K < p \), wektory \( \mathbf{c}_i \) są jest zbiorem centrów, które będą podlegać wyznaczaniu w procesie uczenia.

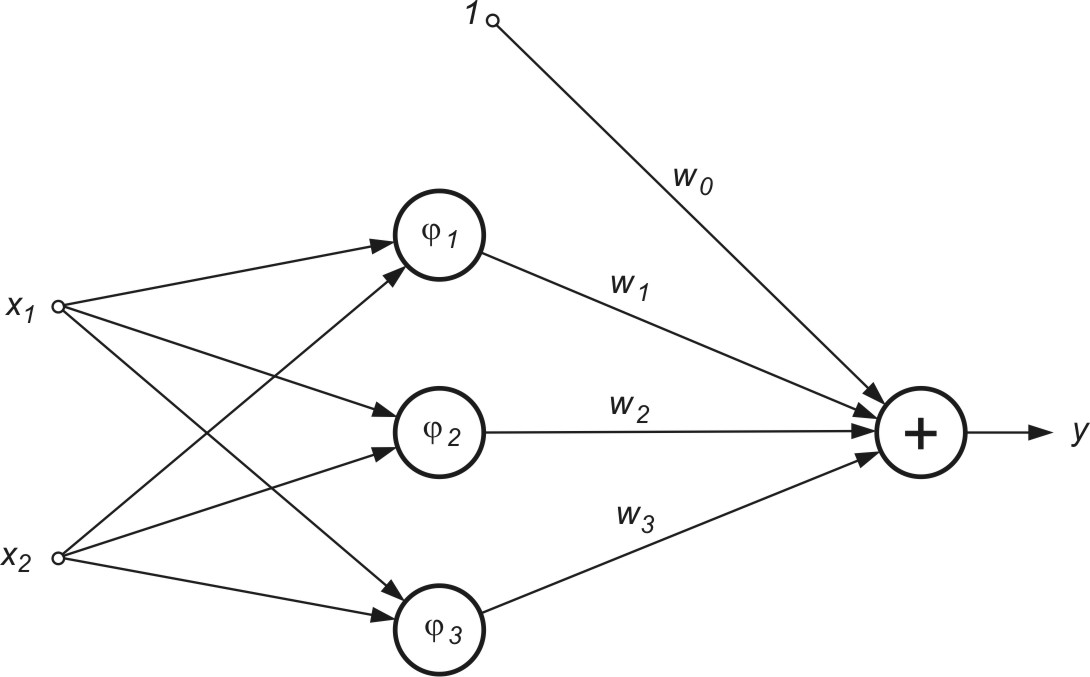

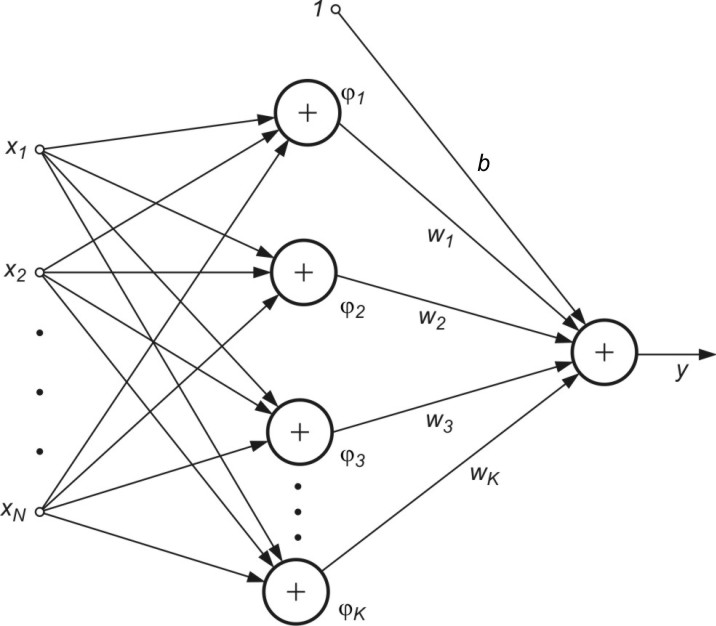

Rozwiązanie wyrażające funkcję aproksymującą w przestrzeni wielowymiarowej jako sumę wagową lokalnych funkcji bazowych \( \varphi\left(\mathbf{x}-\mathbf{c}_i\right) \) typu radialnego (wzór 4.4) może być zinterpretowany w postaci sieci neuronowej radialnej przedstawionej na rys. 4.1, gdzie przyjęto strukturę o \( M \) wyjściach realizujących odwzorowanie \( y(\mathbf{x}) = F(\mathbf{x}) \). Jest to struktura sieci dwuwarstwowej, w której jedynie warstwa ukryta reprezentuje odwzorowanie nieliniowe realizowane przez neurony o radialnej funkcji bazowej. Neuron wyjściowy jest zwykle liniowy, a jego rolą jest sumowanie wagowe sygnałów pochodzących od neuronów warstwy ukrytej. Waga \(w_0 \), podobnie jak w przypadku funkcji sigmoidalnych, reprezentuje polaryzację, wprowadzającą składnik stałego przesunięcia funkcji.

Uzyskana architektura sieci radialnych ma strukturę analogiczną do struktury wielowarstwowej sieci sigmoidalnej o jednej warstwie ukrytej. Rolę neuronów ukrytych pełnią tu radialne funkcje bazowe, różniące się kształtem od funkcji sigmoidalnych. Mimo podobieństwa istnieją również istotne różnice między obu typami sieci. Sieć radialna ma strukturę ustaloną o jednej warstwie ukrytej podczas gdy sieć sigmoidalna może mieć różną liczbę warstw, a neurony wyjściowe mogą być zarówno liniowe, jak i nieliniowe. Funkcja nieliniowa radialna jest zwykle typu gaussowskiego. Dla każdego neuronu ukrytego w sieci radialnej przyjmuje ona inne wartości parametrów \( \mathbf{c}_i \) oraz \( \mathbf{\sigma}_i \), natomiast w sieci sigmoidalnej stosuje się identyczne funkcje aktywacji. Ponadto zauważmy, że argumentem funkcji radialnej jest euklidesowa odległość danego wektora \( \mathbf{x} \) od wektora centrum \( \mathbf{c}_i \), podczas gdy w sieci sigmoidalnej jest to iloczyn skalarny wektorów \( \mathbf{w} \) oraz \( \mathbf{x} \).

Dalsze rozważania, dla uproszczenia, przedstawione będą dla sieci z jednym wyjściem.

Zadanie aproksymacji polega na dobraniu odpowiedniej liczby oraz parametrów funkcji radialnych \( \varphi\left(\mathbf{x}-\mathbf{c}_i\right) \) i takim doborze wag \( \mathbf{w}_i \) aby rozwiązanie (4.4) najlepiej przybliżało rozwiązanie dokładne. Problem doboru parametrów funkcji radialnych oraz wartości wag \( \mathbf{w}_i \) sieci w problemie regresji można zatem sprowadzić do minimalizacji funkcji celu, którą przy wykorzystaniu normy euklidesowej daje się zapisać w postaci

| \( \min E=\sum_{i=1}^p\left[\sum_{j=0}^K w_j \varphi\left(\mathbf{x}_i-\mathbf{c}_j\right)-d_i\right]^2 \) | (4.5) |

W równaniu tym \( K \) reprezentuje liczbę neuronów radialnych, natomiast \( p \) liczbę par uczących \( \left(\mathbf{x}_i, d_i\right) \), gdzie \( \mathbf{x}_i \) jest wektorem wejściowym, a \( d_i \) - odpowiadającą mu wielkością zadaną na wyjściu. Oznaczmy przez \(\mathbf{d} = [ d_0, d_1, \ldots, d_p]^T \) wektor wielkości zadanych, przez \(\mathbf{w} = [ w_0, w_1, \ldots, w_K]^T \) wektor wag sieci z uwzględnieniem polaryzacji (wartość \( w_0 \)), a przez \( \mathbf{G} \) - macierz radialną, zwaną macierzą Greena

| \( \mathbf{G}=\left[\begin{array}{cccc} \varphi\left(\mathbf{x}_1-\mathbf{c}_1\right) & \varphi\left(\mathbf{x}_1-\mathbf{c}_2\right) & \cdots & \varphi\left(\mathbf{x}_1-\mathbf{c}_K\right) \\ \varphi\left(\mathbf{x}_2-\mathbf{c}_1\right) & \varphi\left(\mathbf{x}_2-\mathbf{c}_2\right) & \cdots & \varphi\left(\mathbf{x}_2-\mathbf{c}_K\right) \\ \cdots & \cdots & \cdots & \cdots \\ \varphi\left(\mathbf{x}_p-\mathbf{c}_1\right) & \varphi\left(\mathbf{x}_p-\mathbf{c}_2\right) & \cdots & \varphi\left(\mathbf{x}_p-\mathbf{c}_K\right) \end{array}\right] \) |

(4.6) |

Przy ograniczeniu liczby funkcji bazowych do \( K \), macierz \( \mathbf{G} \) jest macierzą prostokątną o liczbie wierszy zwykle dużo większej niż liczba kolumn \((p \gg K) \). Przy założeniu znajomości parametrów funkcji radialnych macierz Greena jest ściśle określoną macierzą liczbową, a problem optymalizacyjny (4.6) sprowadza się do rozwiązania układu równań liniowych

| \( [ \mathbf{1} \; \mathbf{G}]{\mathbf{w}}=\mathbf{d} \) | (4.7) |

względem wektora wagowego \(\mathbf{w} \), a \(\mathbf{1} \) jest wektorem jednostkowym związanym z wagą polaryzacji \( w_0 \). Wobec prostokątności macierzy \(\mathbf{G} \) wektor wag \(\mathbf{w} \) wyznacza się, wykorzystując pojęcie pseudoinwersji macierzy \(\mathbf{G} \), to jest

| \( \mathbf{w}=[ \mathbf{1} \; \mathbf{G}]^{+}\mathbf{d} \) | (4.8) |

gdzie znak \( ^{+} \) oznacza pseudoinwersję macierzy prostokątnej. W praktyce numerycznej pseudoinwersja jest obliczana zwykle przy wykorzystaniu dekompozycji SVD [4,16].

1.3. Metody uczenia sieci neuronowych radialnych

Wprowadzone w poprzednim podrozdziale metody doboru wag \( w_i \) warstwy wyjściowej sieci radialnej RBF opierały się na założeniu, że parametry samych funkcji bazowych są znane, w związku z czym macierze Greena są określone w sposób numeryczny i zadanie sprowadza się do rozwiązania nadmiarowego układu równań liniowych o postaci (4.7). W rzeczywistych zastosowaniach liczba neuronów ukrytych \( K < p \) i problem uczenia sieci RBF z uwzględnieniem wybranego typu radialnej funkcji bazowej sprowadza się do:

-

ustalenia liczby neuronów gaussowskich \( K \) oraz doboru centrów \( \mathbf{c}_i \) i parametrów szerokości \( \mathbf{\sigma}_i \) funkcji bazowych Gaussa

-

doboru wag \( w_i \) neuronów warstwy wyjściowej.

4.3.1 Proces samoorganizacji w określeniu parametrów funkcji radialnych

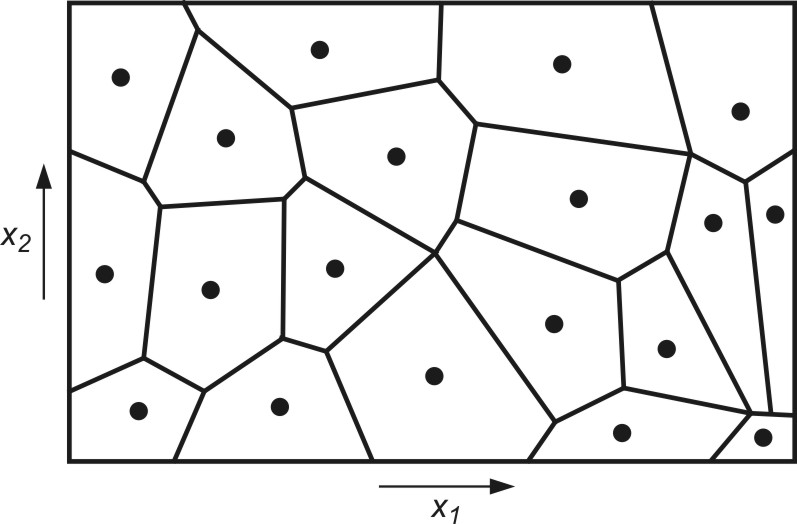

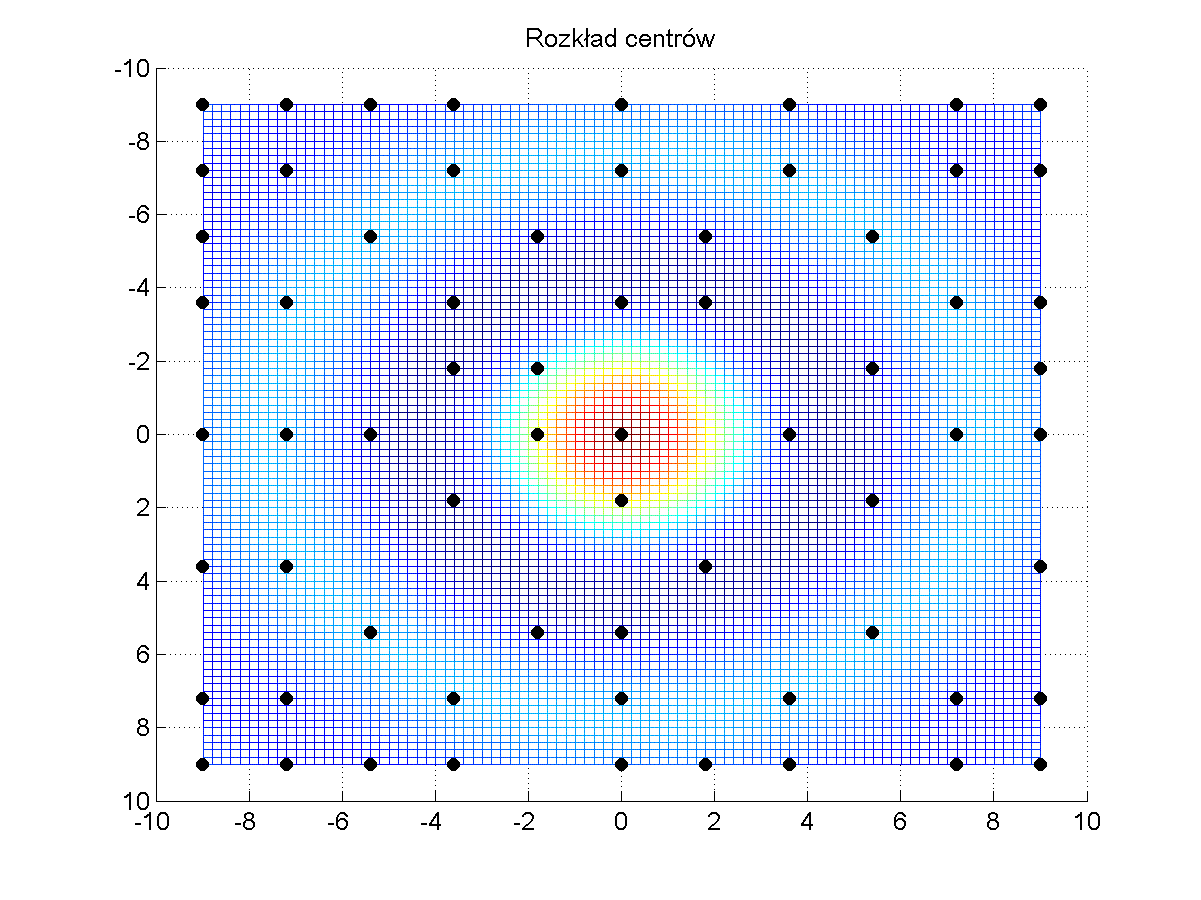

Określenie wartości parametrów funkcji radialnych (centra \( \mathbf{c}_i \) i szerokości \( \mathbf{<span>\sigma}_i \)) można uzyskać przy zastosowaniu algorytmu samoorganizacji poprzez współzawodnictwo. Proces samoorganizacji danych uczących poprzez współzawodnictwo dzieli automatycznie przestrzeń na tak zwane wieloboki Voronoia, przedstawiające obszary dominacji określonych centrów odpowiadających poszczególnym funkcjom radialnym. Przykład takiego podziału przestrzeni dwuwymiarowej pokazano na rys. 4.2.

Dane zgrupowane wewnątrz klastra są reprezentowane przez punkt centralny, stanowiący średnią ze wszystkich elementów danego klastra. Centrum klastra utożsamione będzie dalej z centrum c odpowiedniej funkcji radialnej. Liczba tych funkcji jest zatem równa liczbie centrów i może być korygowana przez algorytm samoorganizacji.

Proces podziału danych na klastry można przeprowadzić przy użyciu jednej z wersji algorytmu Linde-Buzo-Graya (LBG) zwanego również algorytmem K-uśrednień (ang. K-means). W wersji bezpośredniej (on-line) tego algorytmu aktualizacja centrów następuje po każdej prezentacji wektora \( \mathbf{x} \) ze zbioru danych uczących. W wersji skumulowanej (off-line) centra są aktualizowane jednocześnie po zaprezentowaniu wszystkich składników zbioru uczącego. W obu przypadkach wstępny wybór centrów odbywa się najczęściej losowo przy wykorzystaniu rozkładu równomiernego w zakresie zmienności poszczególnych składowych wektora \( \mathbf{x} \).

W wersji bezpośredniej (on-line) po zaprezentowaniu \( k \)-tego wektora \( \mathbf{x}_k \) ze zbioru uczącego selekcjonowane jest centrum \( \mathbf{c}_i \) najbliższe w sensie wybranej metryki danemu wektorowi. To centrum podlega aktualizacji zgodnie z algorytmem WTA

| \( \mathbf{c}_i(k+1)=\mathbf{c}_i(k)+\eta\left(\mathbf{x}_k-\mathbf{c}_i(k)\right) \) | (4.9) |

w którym \( \eta \) jest współczynnikiem uczenia o małej wartości (zwykle \( \eta \ll 1 \)), malejącym w czasie do zera. Pozostałe centra nie ulegają zmianie. Każdy wektor uczący \( \mathbf{x} \) jest prezentowany wielokrotnie, zwykle w kolejności losowej aż do ustalenia wartości centrów.

Stosowana jest również odmiana algorytmu, w której centrum zwycięskie adaptowane jest według wzoru (4.9), a jeden lub kilka najbliższych mu centrów odpychane w przeciwnym kierunku, przy czym realizacja procesu odpychania odbywa się zgodnie ze wzorem

| \( \mathbf{c}_i(k+1)=\mathbf{c}_i(k)-\eta_1\left(\mathbf{x}_k-\mathbf{c}_i(k)\right) \) | (4.10) |

Taka modyfikacja algorytmu pozwala na rozsunięcie centrów położonych blisko siebie i lepszą penetrację przestrzeni danych (zwykle \( \eta_1 \) < \(\eta \)).

W wersji skumulowanej uczenia prezentowane są wszystkie wektory uczące \( \mathbf{x} \) i każdy z nich przyporządkowany odpowiedniemu centrum. Zbiór wektorów przypisanych do jednego centrum tworzy klaster, którego nowe centrum jest średnią poszczególnych wektorów składowych

| \( \mathbf{c}_i(k+1)=\frac{1}{N_i} \sum_{j=1}^{N_i} \mathbf{x}_j \) | (4.11) |

gdzie \( N_i \) oznacza liczbę wektorów \( \mathbf{x}_j \) przypisanych w \( k \)-tym cyklu do \( i \)-tego centrum. Uaktualnianie wartości wszystkich centrów odbywa się równolegle. Proces prezentacji zbioru wektorów \( \mathbf{x} \) oraz uaktualniania wartości centrów powtarzany jest wielokrotnie aż do ustalenia się wartości centrów.

W praktyce używa się najczęściej algorytmu bezpośredniego ze względu na jego nieco lepszą zbieżność. Oba algorytmy nie gwarantują jednak bezwzględnej zbieżności do rozwiązania optymalnego w sensie globalnym, a jedynie zapewniają optymalność lokalną, uzależnioną od warunków początkowych i parametrów procesu. Przy niefortunnie dobranych warunkach początkowych pewne centra mogą utknąć w regionie, w którym liczba danych uczących jest znikoma lub żadna i proces modyfikacji ich położeń może zostać zahamowany. Pewnym rozwiązaniem tego problemu jest modyfikacja położeń wielu centrów na raz, ze stopniowaniem wartości stałej uczenia \( \eta \) dla każdego z nich. Centrum najbliższe aktualnemu wektorowi \( \mathbf{x} \) modyfikowane jest najbardziej, pozostałe w zależności od ich odległości względem wektora \( \mathbf{x} \) coraz mniej.

Po ustaleniu położeń centrów dobierane są wartości parametrów \( \sigma \), odpowiadających poszczególnym funkcjom bazowym. Parametr \( \sigma_j \) funkcji radialnej decyduje o kształcie funkcji i wielkości pola recepcyjnego, dla którego wartość tej funkcji jest niezerowa (większa od pewnej ustalonej wartości progowej). Dobór \( \sigma_j \) powinien być taki, aby pola recepcyjne wszystkich funkcji radialnych pokrywały cały obszar danych wejściowych, przy czym sąsiednie pola recepcyjne mogą pokrywać się w stopniu nieznacznym. Przy takim doborze wartości \( \sigma_j \) odwzorowanie funkcji realizowane przez sieci radialne będzie stosunkowo gładkie. W najprostszym rozwiązaniu za wartość \( \sigma_j \) odpowiadającą \( j \)-tej funkcji radialnej przyjmuje się odległość euklidesową \( j \)-tego centrum \( \mathbf{c}_j \) od jego najbliższego sąsiada [24,46]. W innym algorytmie z uwzględnieniem szerszego sąsiedztwa, na wartość \( \sigma_j \) wpływa odległość \( j \)-tego centrum od jego \( q \) najbliższych sąsiadów. Wartość \( \sigma_j \) określa się wtedy ze wzoru

| \( \sigma_j=\sqrt{\frac{1}{q} \sum_{k=1}^q\left\|\mathbf{c}_j-\mathbf{c}_k\right\|^2} \) | (4.12) |

W praktyce wartość \( q \) mieści się zwykle w zakresie od 3 do 6. W przypadku danych o podobnym charakterze zmian stosuje się często stałą wartość \( \sigma_j = \sigma\) dla wszystkich neuronów radialnych (dla danych znormalizowanych typowe wartości jest \( \sigma\) bliskie jedności).

Wstępny dobór liczby funkcji radialnych (neuronów ukrytych) dla każdego problemu jest sprawą kluczową, decydującą o dokładności odwzorowania. Stosuje się ogólną zasadę, że im większy jest wymiar wektora \( \mathbf{x} \) i liczba danych uczących, tym większa wymagana liczba funkcji radialnych. Często przyjmuje się na wstępie liczbę funkcji radialnych jako pewien ułamek (np. 1/3) liczby wszystkich par uczących \( p \).

4.3.2 Dobór wartości wag warstwy wyjściowej

Prosty jest również problem adaptacji wag neuronów warstwy wyjściowej. Zgodnie z zależnością (4.8) wektor wagowy \( \mathbf{x} \) może być wyznaczony w jednym kroku przez pseudoinwersję macierzy \( \mathbf{G} \), czyli \( \mathbf{W}=\left[\begin{array}{ll} \mathbf{1} & \mathbf{G} \end{array}\right]^{+} \cdot \mathbf{d} \). Dla uproszczenia wzorów przyjęto w dalszych rozważaniach oznaczenie rozszerzonej macierzy Greena \( \mathbf{G} \leftarrow [ \mathbf{1} \; \mathbf{G} ] \). W praktyce obliczenie pseudoinwersji macierzy \( \mathbf{G} \) następuje przy zastosowaniu dekompozycji według wartości osobliwych (SVD), według którego

| \( \mathbf{G} = \mathbf{USV}^T \) | (4.13) |

Macierze \( \mathbf{U} \) i \( \mathbf{V} \) są ortogonalne, o wymiarach odpowiednio \( p \times p \) oraz \( K \times K \), podczas gdy \( \mathbf{S} \) jest macierzą pseudodiagonalną o wymiarach \( p \times K \; (p < K) \), zawierającą elementy diagonalne zwane wartościami osobliwymi \( s_1 \geq s_2 \geq \ldots s_K \geq 0 \). Załóżmy, że jedynie \( r \) pierwszych elementów \( s_i \) ma znaczące wartości, a pozostałe są pomijalnie małe. Wtedy można zredukować liczbę kolumn macierzy ortogonalnych \( \mathbf{U} \) i \( \mathbf{V} \) do wartości \( r \), pomijając pozostałe. Utworzone w ten sposób zredukowane macierze \( \mathbf{U}_r \) i \( \mathbf{V}_r \) mają postać

\( \mathbf{U}_r=\left[\mathbf{u}_1, \mathbf{u}_2, \ldots, \mathbf{u}_r\right] \)

\( \mathbf{V}_r=\left[\mathbf{v}_1, \mathbf{v}_2, \ldots, \mathbf{v}_r\right] \)

a macierz \( \mathbf{S}_{r}=\operatorname{diag}\left[{s}_1, {s}_2, \ldots, {s}_{r}\right] \) staje się macierzą w pełni diagonalną (kwadratową). Macierze te aproksymują zależność (4.13) w postaci

| \( \mathbf{G} = \mathbf{U}_r \mathbf{S}_r \mathbf{V}_r^T \) | (4.14) |

Biorąc pod uwagę własności macierzy ortogonalnych (\( \mathbf{Q}^{-1} = \mathbf{Q}^{T} \)) macierz pseudoodwrotna do \( \mathbf{G} \) określona jest teraz prostą zależnością

| \( \mathbf{G}^{+} = \mathbf{V}_r \mathbf{S}_r^{-1} \mathbf{U}_r^T \) | (4.15) |

w której \( \mathbf{S}_r^{-1}=\left[ \frac{1}{s_1}, \frac{1}{s_2}, \ldots, \frac{1}{s_r} \right] \) a wektor wag sieci podlegającej adaptacji określony jest wzorem

| \( \mathbf{w} = \mathbf{V}_r \mathbf{S}_r^{-1} \mathbf{U}_r^T \mathbf{d}\) | (4.16) |

Zaletą takiego podejścia jest dobre uwarunkowanie problemu. Dobór wag wyjściowych sieci odbywa się w jednym kroku przy wykorzystaniu jedynie mnożenia odpowiednich macierzy, przy czym część macierzy (\( \mathbf{U}_r \) i \( \mathbf{V}_r \)) to macierze ortogonalne, z natury dobrze uwarunkowane (współczynnik uwarunkowania równy 1).

Zauważmy, że w uczeniu sieci RBF parametry podlegające adaptacji tworzą dwie niezależnie dobierane grupy: parametry funkcji radialnych adaptowane poprzez grupowanie danych oraz wagi \( \mathbf{w} \) warstwy wyjściowej określane poprzez pseudoinwersję macierzy Greena. Daje to efekt uproszczenia obliczeń i znacznego skrócenia czasu uczenia.

1.4. Metody doboru liczby funkcji bazowych

Dobór liczby funkcji bazowych, utożsamianych z liczbą neuronów ukrytych, jest podstawowym problemem przy właściwym rozwiązaniu problemu aproksymacji. Podobnie jak w sieciach sigmoidalnych, zbyt mała liczba neuronów nie pozwala dostatecznie zredukować błędu dopasowania na zbiorze danych uczących, natomiast zbyt duża ich liczba powoduje wzrost błędu generalizacji na zbiorze testującym. Dobór właściwej liczby neuronów jest uzależniony od wielu czynników, w tym wymiarowości problemu, liczby danych uczących, a przede wszystkim kształtu aproksymowanej funkcji w przestrzeni wielowymiarowej. Zwykle liczba funkcji bazowych \( K \) stanowi jedynie pewien ułamek liczby danych uczących \( p \), przy czym aktualna wartość tego ułamka jest uzależniona od wymiaru wektora \( \mathbf{x} \) oraz od stopnia zróżnicowania wartości zadanych \( d_i \), odpowiadających wektorom wejściowym \( \mathbf{x}_i \) dla \( i = 1,2,\ldots, p \).

4.4.1 Metody heurystyczne

Wobec niemożności określenia a priori dokładnej liczby neuronów ukrytych stosuje się metody adaptacyjne, które pozwalają na ich dodanie lub usunięcie w trakcie procesu uczenia. Powstało wiele metod heurystycznych umożliwiających takie operacje [24]. Zwykle uczenie sieci zaczyna się od pewnej wstępnie założonej liczby neuronów, a następnie kontroluje się zarówno stopień redukcji błędu średniokwadratowego, jak i zmiany wartości adaptowanych parametrów sieci. Najprostszym podejściem jest kolejne zwiększanie liczby neuronów ukrytych, jeśli aktualny błąd uczenia jest zbyt duży. Z kolei jeśli już wstępna wartość błędu jest zadowalająca należy podjąć próbę kolejnego zmniejszania liczby neuronów ukrytych aż do wartości skrajnej przy której dochodzi się do progu akceptowalności błędu.

W bardziej zaawansowanej technice procedura może być bardziej zaawansowana i uzależniona od średniej zmiany wartości wag po określonej liczbie cykli uczących. Jeśli jest zbyt mała \( \sum_i \Delta w_i < \varepsilon \) dodaje się dwie nowe funkcje bazowe (2 neurony) o centrach odpowiadających odpowiednio największej i najmniejszej wartości błędu dopasowania (dwie skrajne wartości błędu dopasowania), kontynuując uczenie tak rozbudowanej struktury. Jednocześnie kontroluje się absolutne wartości wag \( w_i \) poszczególnych neuronów. Jeśli są one mniejsze od założonego na wstępie progu, neurony im odpowiadające podlegają usunięciu. Zarówno dodawanie neuronów, jak i usuwanie odbywa się po określonej liczbie cykli uczących i trwa przez cały czas uczenia, aż do uzyskania odpowiedniej dokładności odwzorowania.

Inne podejście w sterowaniu liczbą neuronów ukrytych zaproponował J. Platt. Jest to metoda łącząca w sobie jednocześnie uczenie samoorganizujące i z nadzorem. Po każdej prezentacji kolejnego wzorca uczącego określana jest odległość euklidesowa między nim a najbliższym centrum istniejącej już funkcji radialnej. Jeśli ta odległość jest większa od założonego progu \( \Delta \), tworzone jest nowe centrum funkcji radialnej (dodawany neuron) w punkcie odpowiadającym prezentowanemu wektorowi \( \mathbf{x} \), po czym sieć podlega standardowemu douczeniu z wykorzystaniem metod gradientowych (uczenie z nadzorem). Proces dodawania neuronów zachodzi aż do uzyskania określonej wartości błędu odwzorowania. Ważnym problemem w tej metodzie jest dobór wartości progu \( \Delta \), decydującej o rozbudowie struktury sieci. Zwykle wartość ta zmienia się wykładniczo z czasem (liczbą iteracji) od wartości maksymalnej na początku procesu do wartości minimalnej na końcu.

4.4.2 Metoda ortogonalizacji Grama-Schmidta

Skuteczną metodą kontroli liczby neuronów ukrytych pozostaje zastosowanie specjalnej techniki uczenia sieci opartej na metodzie ortogonalizacji najmniejszych kwadratów (ang. Orthogonal Least Squares - OLS) i korzystającej z klasycznego algorytmu ortogonalizacji Grama-Schmidta [6,46]. Metoda ta ma wbudowany algorytm określania optymalnej liczby funkcji radialnych w trakcie procesu uczenia.

Punktem wyjścia jest przedstawienie problemu uczenia jako liniowego dopasowania wektora wag sieci \( \mathbf{w} \), minimalizującego wartość wektora błędu \( e \), czyli

| \( \min _{\mathbf{w}} \mathrm{E}=\|e\|^2=|\mathbf{G} \mathbf{w}-\mathbf{d}|^2 \) | (4.17) |

W równaniu tym \( \mathbf{G} \) jest macierzą Greena a \( \mathbf{d} \) wektorem wartości zadanych, \( \mathbf{d} = [d_1, d_2, \ldots, d_n]^T \) o zerowej wartości średniej. Na wstępie przyjmuje się liczbę funkcji radialnych \( K=p\) i centrach \( \mathbf{c}_i = \mathbf{x}_i \). Iloczyn \( \mathbf{Gw} \) podniesiony do kwadratu reprezentuje część pożądaną energii związaną z wartościami sygnałów zadanych wektorem \( \mathbf{d} \). Wartość tej energii podlega optymalizacji w procesie uczenia dążąc do wartości energii zdefiniowanej wektorem \( \mathbf{d} \) (suma kwadratów składników \(d_i\) wektora \( \mathbf{d} \)). Wprowadzając oznaczenia \( \mathbf{g}_i \) dla kolumn macierzy \( \mathbf{G} \) można ją przedstawić w postaci \( \mathbf{G} = [\mathbf{g}_1, \mathbf{g}_2, \ldots, \mathbf{g}_K ] \), w której wektory \(\mathbf{g}_i \) są powiązane z funkcjami bazowymi Gaussa. Metoda ortogonalizacji najmniejszych kwadratów polega na transformacji wektorów \(\mathbf{g}_i \) w zbiór bazowych wektorów ortogonalnych, umożliwiających ocenę indywidualnego wkładu każdego z nich w ogólną wartość energii reprezentowanej przez \(\mathbf{Gw} \) i eliminację pewnej ich liczby (których znaczenie dla procesu jest minimalne) z \( p \) do \( K \), przy czym \(K < p \).

W procesie uczenia macierz \(\mathbf{G} \) o wymiarze \( p \times K \) ulega rozkładowi na iloczyn macierzy \(\mathbf{Q} \) (o wymiarze \( p \times K \) złożonej z ortogonalnych wektorów kolumnowych \(\mathbf{q}_i\), \( \mathbf{Q} = [\mathbf{q}_1, \mathbf{q}_2, \ldots, \mathbf{q}_K ] \) oraz kwadratowej macierzy górnotrójkątnej \(\mathbf{A} \) stopnia \( K \) o jednostkowych wartościach na diagonali

| \( \mathbf{G} =\mathbf{QA} \) | (4.18) |

W równaniu tym

| \( \mathbf{A}=\left[\begin{array}{ccccc} 1 & a_{12} & a_{13} & \cdots & a_{1 K} \\ 0 & 1 & a_{23} & \cdots & a_{2 K} \\ \cdots & \cdots & \cdots & \cdots & \cdots \\ 0 & 0 & 0 & \cdots & 1 \end{array}\right] \) |

(4.19) |

przy czym macierz ortogonalna \(\mathbf{Q} \) spełnia zależność

| \( \mathbf{Q}^T\mathbf{Q}=\mathbf{H} \) |

(4.20) |

w której \( \mathbf{H} \) jest macierzą diagonalną o elementach diagonalnych \( h_{i i}=\mathbf{q}_i^T \mathbf{q}_i=\sum_{j=1}^K q_{i j}^2 \). Rozwiązanie zadania minimalizacji (4.17) sprowadza się do rozwiązania równania liniowego

| \( \mathbf{Gw} = \mathbf{QAw}=\mathbf{d} \) | (4.21) |

Po wprowadzeniu wektora pomocniczego b

| \( \mathbf{b}=\mathbf{Aw} \) | (4.22) |

równanie (4.21) upraszcza się do postaci

| \( \mathbf{d} = \mathbf{Qb} \) | (4.23) |

Jest to układ \( p \) równań z \( K \) niewiadomymi. Rozwiązanie tego równania (wektor \( \mathbf{\hat{b}} \)) przyjmuje postać

| \( \mathbf{\hat{b}} = [\mathbf{Q}^T\mathbf{Q}]^{-1}\mathbf{Q}^T\mathbf{d}=\mathbf{H}^{-1}\mathbf{Q}^T\mathbf{d} \) |

(4.24) |

Biorąc pod uwagę diagonalny charakter macierzy \( \mathbf{H} \) można podać jawny wzór opisujący poszczególne składniki wektora \( \mathbf{\hat{b}} \)

| \( \hat{b}_i=\frac{\mathbf{q}_i^T \mathbf{d}}{\mathbf{q}_i^T \mathbf{q}_i} \) | (4.25) |

Po określeniu wektora \( \mathbf{\hat{b}} \) można wyznaczyć również wektor poszukiwanych wag \( \mathbf{w} \)

| \( \mathbf{w} = \mathbf{A}^{-1}\mathbf{b} \) | (4.26) |

Przy trójkątnej postaci macierzy \( \mathbf{A} \) rozwiązanie równania (4.26) względem wektora \( \mathbf{w} \) nie sprawia trudności natury obliczeniowej. Ortogonalizacja macierzy \( \mathbf{G} \) opisana zależnością (4.18) może być dokonana różnymi metodami, z których najefektywniejszy jest algorytm ortogonalizacji Grama-Schmidta [6]. W metodzie tej generacja macierzy \( \mathbf{A} \) następuje kolumna po kolumnie z jednoczesnym tworzeniem kolejnych kolumn ortogonalnej macierzy \( \mathbf{Q} \). W kroku k-tym tworzy się kolumnę \( \mathbf{q}_k \) ortogonalną do wszystkich \( k-1 \) kolumn utworzonych wcześniej. Procedurę powtarza się dla kolejnych wartości \( k=2,3,\ldots, K \).

Ważną zaletą metody ortogonalizacji w tym zastosowaniu jest również możliwość selekcji wektorów \( \mathbf{q}_i \) pod względem ich ważności w odwzorowaniu danych uczących. Przy założonej na wstępie liczbie \( K=p \) funkcji radialnych zadanie polega na takim ustawieniu kolejnych wektorów \( \mathbf{q}_i \), aby wyselekcjonować pierwsze \( K_r \) najbardziej znaczące pod względem energetycznym, przy czym zwykle \( K_r \ll p \).

Uwzględnienie w dalszych obliczeniach tylko \( K_r \) funkcji radialnych odpowiada redukcji liczby neuronów ukrytych z wartości wstępnej \( p \) do wartości \( K_r \). Biorąc pod uwagę energię związaną z sygnałami opisanymi wektorem \( \mathbf{d} \) i uwzględniając zależność (4.25) otrzymuje

| \( \mathbf{d}^T \mathbf{d} \cong \sum_{i=1}^p \hat{b}_i^2 \mathbf{q}_i^T \mathbf{q}_i \) |

(4.27) |

Jeśli przyjmie się, że \( \mathbf{d} \) reprezentuje wektor zadany o zerowej wartości średniej, składnik \( \hat{b}_i^2 \mathbf{q}_i^T \mathbf{q}_i \) może być zinterpretowany jako średni wkład \( i \)-tej funkcji bazowej w odwzorowanie funkcji zadanej wektorem \( \mathbf{d} \). Względny udział tego składnika w ogólnym bilansie energii wyraża się zatem wzorem

| \( \varepsilon_i=\frac{\hat{b}_i^2 \mathbf{q}_i^T \mathbf{q}_i}{\mathbf{d}^T \mathbf{d}} \) |

(4.28) |

Wyznaczenie wartości \( \varepsilon_i \) odpowiadających poszczególnym funkcjom bazowym umożliwia określenie ich wkładu w odwzorowanie funkcyjne danych uczących, co ułatwia podjęcie decyzji o redukcji tych, których wpływ jest najmniejszy. Po wyselekcjonowaniu określonej liczby najbardziej znaczących funkcji radialnych proces ortogonalizacji przeprowadza się powtórnie, określając nowe rozwiązanie i selekcjonując następne, najbardziej znaczące funkcje radialne. Przy założeniu wartości startowej \( K=p \) po kilku cyklach ortogonalizacji Grama-Schmidta można wyselekcjonować pożądaną liczbę \(K_r \) najbardziej znaczących funkcji bazowych, eliminując pozostałe. Procedurę określania najbardziej znaczących w odwzorowaniu funkcji radialnych kończy się z chwilą spełnienia warunku

| \( 1-\sum_{j=1}^{K_r} \varepsilon_j < \rho \) |

(4.29) |

gdzie \( 0 < \rho < 1 \) jest przyjętą z góry wartością tolerancji.

W wyniku przeprowadzonej procedury zachowanych zostaje jedynie \(K_r \) najbardziej znaczących funkcji radialnych położonych w centrach określonych poprzez wybrane przez algorytm dane uczące \( \mathbf{x}_i \). Jednocześnie w wyniku działania algorytmu określone są poszczególne składowe \( b_i \) wektora \( \mathbf{b} \), na podstawie których z zależności (4.26) otrzymuje się wartości wag \( \mathbf{w} \) warstwy wyjściowej sieci.

Tolerancja \( \rho \) decydująca o zakończeniu procesu uczenia jest ważnym czynnikiem, od którego zależy z jednej strony dokładność odwzorowania danych uczących, a z drugiej - stopień złożoności sieci neuronowej. W wielu przypadkach jej wartość może być oszacowana na podstawie rozkładu statystycznego danych uczących oraz aktualnych postępów w uczeniu. W praktyce przeprowadza się zwykle wiele procesów uczenia sieci RBF przy różnych wartościach \( \rho \), zachowując jedynie tę, która zapewnia najlepsze działanie sieci na danych weryfikujących (część danych uczących nie biorąca udziału w uczeniu).

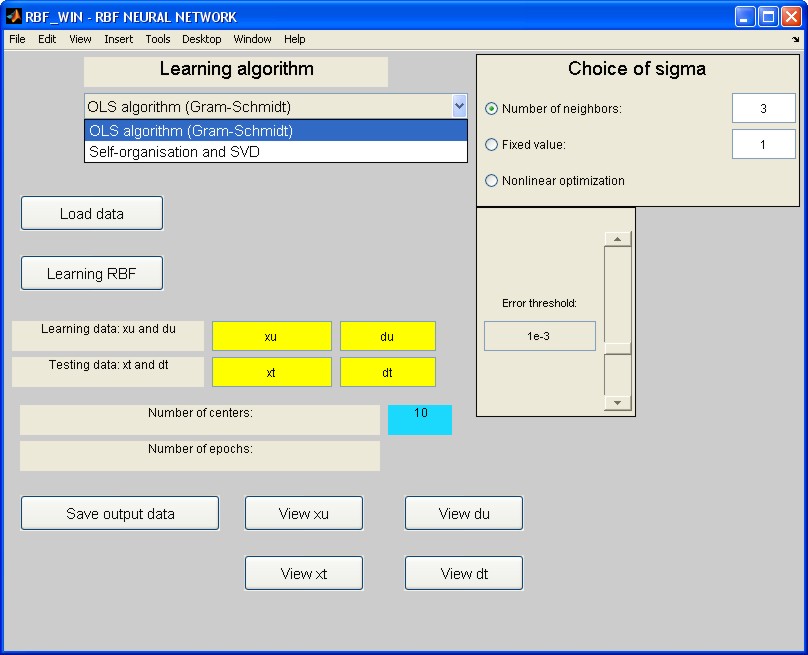

1.5. Program komputerowy uczenia sieci radialnych

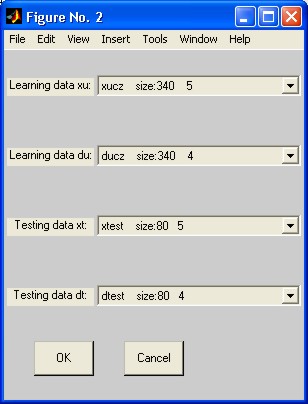

Algorytm uczenia sieci RBF wykorzystujący zarówno samoorganizację jak i ortogonalizację Grama-Schmidta został zaimplementowany w środowisku Matlab jako pakiet programów RBF. Wywołanie następuje poprzez napisanie nazwy programu głównego RBF_win w oknie komend Matlaba. Pojawia się wówczas menu programu w postaci przedstawionej na rys. 4.3, ułatwiające posługiwanie się programem.

W pierwszej kolejności należy wczytać dane uczące i testujące korzystając z przycisków Learning data oraz Testing data. Zmienne \( xu \) i \( xt \) oznaczają macierze zawierające wektory wierszowe \( \mathbf{x} \) danych wejściowych użytych odpowiednio w uczeniu i testowaniu sieci. Zmienne \( du \) i \( dt \)oznaczają stowarzyszone z nimi wartości sygnałów wartości zadanych na wyjściu sieci (zbiór wektorów \( \mathbf{d} \)). Można również zadać wielkości uczące i testujące zgromadzone w pliku, korzystając z przycisku Load data. Uaktywnienie tego przycisku otwiera okno wczytywania danych (rys. 4.4), które umożliwia wybór odpowiednich zmiennych, zapisanych wcześniej w pliku przez użytkownika ( \( xucz = xu, xtest=xt, ducz=du, dtest=dt \)).

W chwili obecnej w programie zaimplementowany jest algorytm uczący OLS Grama-Schmidta oraz algorytm podstawowy oparty na samoorganizacji i dekompozycji SVD, omówione w punktach poprzednich. Do wyboru konkretnego algorytmu służy pole Learning algorithm, przy czym możliwe jest dołączenie dowolnego innego programu uczącego. Przed uruchomieniem procesu uczenia należy wybrać wartość tolerancji \( \rho \) (przycisk Error threshold) oraz sposób określania szerokości funkcji radialnej \( \sigma \) (pole Choice of sigma). Możliwe jest automatyczne ustalanie wartości \( \sigma \) na podstawie odległości od podanej przez użytkownika liczby najbliższych sąsiadów (opcja Number of neighbors), przyjęcie wartości stałej podanej przez użytkownika (opcja Fixed value) lub wykorzystanie optymalizacji nieliniowej (opcja Nonlinear optimization) dobierającej szerokość funkcji radialnej poprzez jej optymalizację gwarantującą najlepsze dopasowanie do danych uczących (ta opcja działa skutecznie jedynie przy małej liczbie centrów). Wciśnięcie przycisku Learning RBF uruchamia główny proces uczenia sieci. W jego wyniku wyświetlana jest aktualna liczba wygenerowanych centrów (Number of centers). Jednocześnie następuje automatyczne testowanie wytrenowanej sieci na danych uczących, a wynik przekazywany do przestrzeni roboczej Matlaba jako zmienna \( y \). Pojawi się wówczas również dodatkowy przycisk Testing RBF umożliwiający testowanie wytrenowanej sieci na danych testujących nie uczestniczących w uczeniu. Wynik testowania przekazywany jest do przestrzeni roboczej Matlaba również jako zmienna y. Program umożliwia zapamiętanie zarówno sygnałów wyjściowych sieci w pliku (przycisk Save output data) jak i całej struktury oraz parametrów wytrenowanej sieci (przycisk Save network) do jej przyszłego wczytania (przycisk Load network). Rola użytkownika programu sprowadza się do przygotowania danych uczących oraz wyboru parametrów uczenia. Dodatkowo w przypadku danych jednowymiarowych możliwa jest wizualizacja graficzna danych uczących i testujących. Do tego celu służą przyciski View xlearn, View dlearn, View xtest oraz View dtest wyświetlające wykresy odpowiednich sygnałów przy wykorzystaniu funkcji graficznych Matlaba

1.6. Przykład zastosowania sieci radialnej w aproksymacji

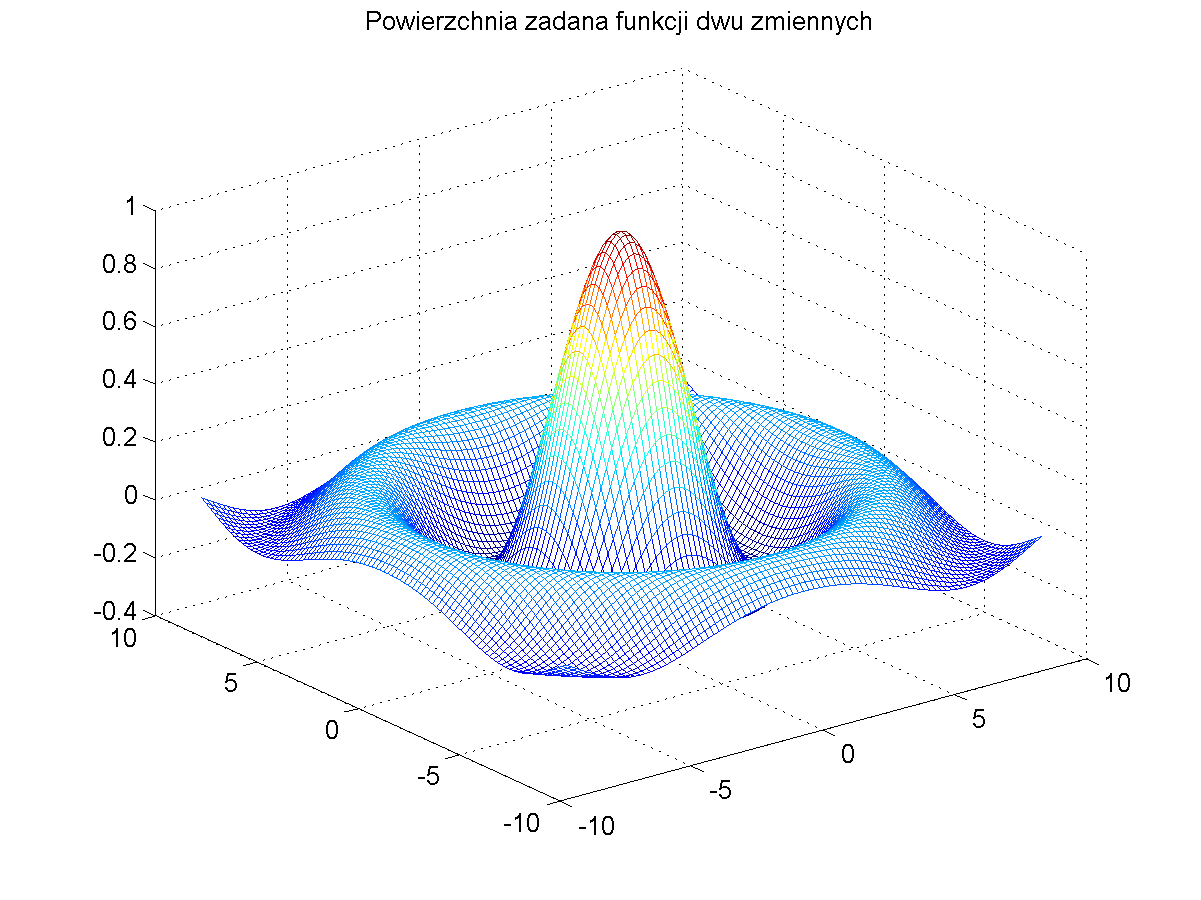

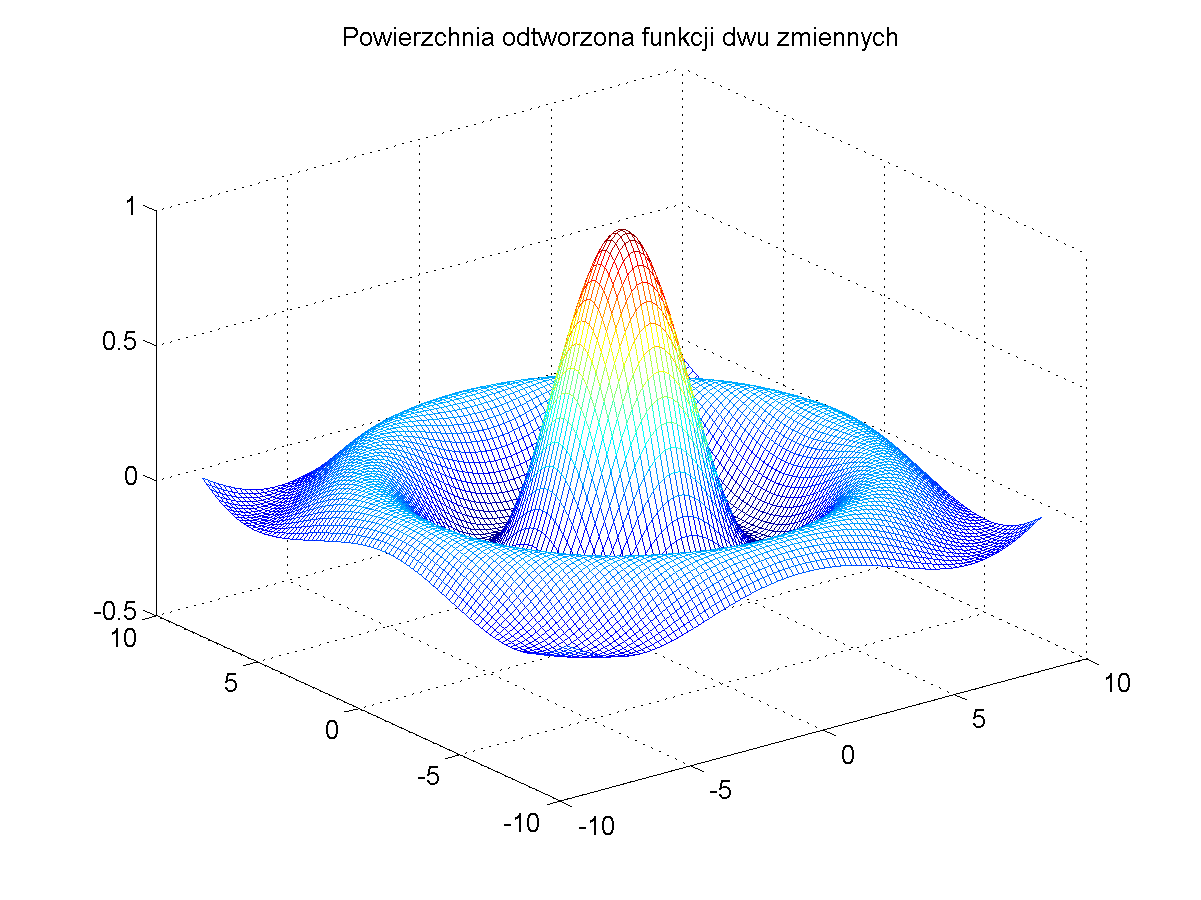

Sieci neuronowe o radialnych funkcjach bazowych znajdują zastosowanie zarówno w rozwiązywaniu problemów klasyfikacyjnych (na wyjściu sieci umieszcza się wówczas dodatkowo funkcję typu signum, wskazująca na określona klasę), zadaniach aproksymacji funkcji wielu zmiennych jak i zagadnieniach predykcji, a więc w tym obszarze zastosowań, gdzie sieci sigmoidalne mają od lat ugruntowaną pozycję. Sieci RBF wykonują te same zadania co sieci sigmoidalne choć w rozwiązaniu problemu stosują inny sposób przetwarzania danych, wykorzystujący lokalność odwzorowania. Dzięki tej własności możliwe jest znaczne uproszczenie, a przez to również skrócenie procesu uczenia. Jako przykład zastosowania sieci RBF rozpatrzymy problem aproksymacji funkcji nieliniowej dwu zmiennych opisanej wzorem

| \( f(\mathbf{x})=\frac{\sin \left(\sqrt{x_1^2+x_2^2}\right)}{\sqrt{x_1^2+x_2^2}} \) |

(4.30) |

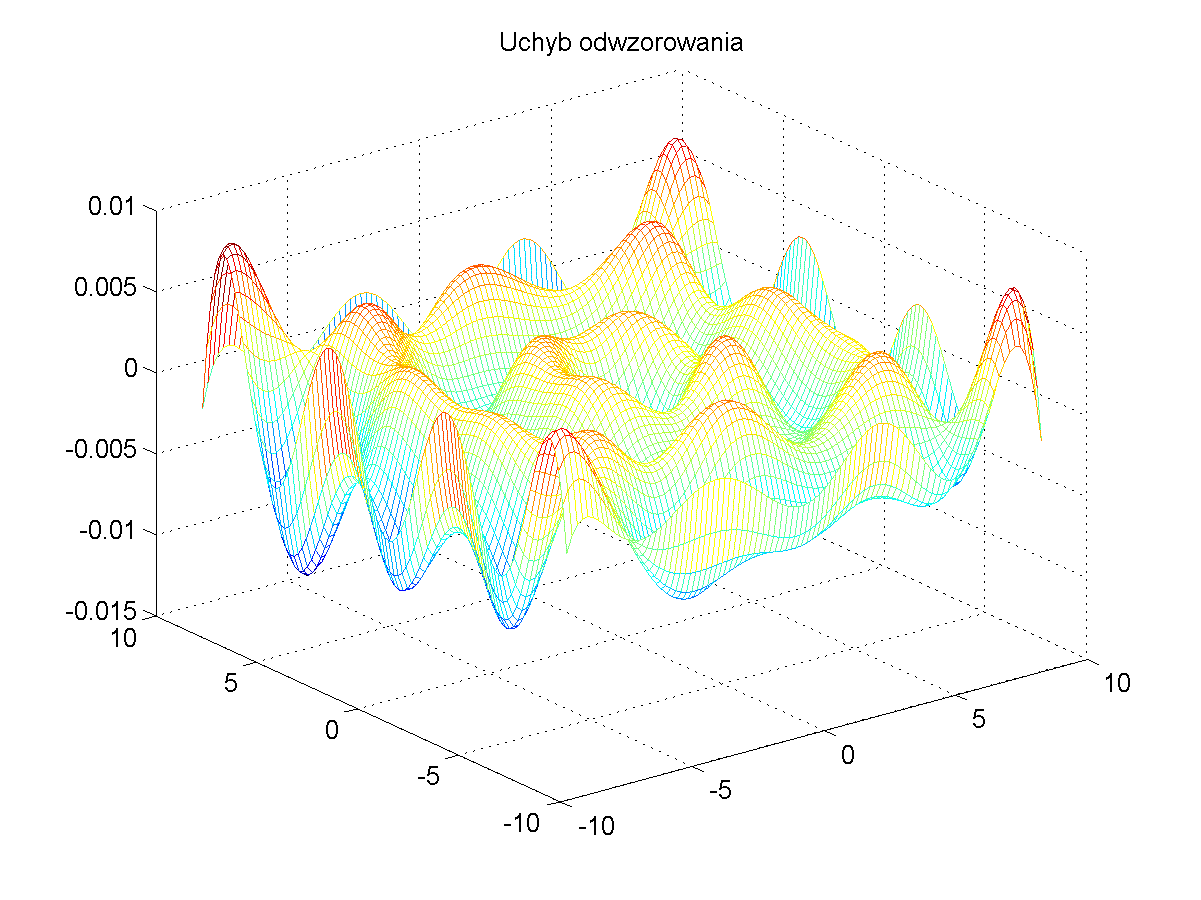

Dla wytrenowania sieci RBF należy w pierwszej kolejności utworzyć na podstawie tego wzoru zbiór par uczących \( ( \mathbf{x}, d(\mathbf{x})) \). Dane uczące utworzono dla 400 punktów danych, wygenerowanych dla zmiennych \( x_1 \) i \( x_2 \) rozłożonych równomiernie w zakresie (-9, 9). Dane te tworzą kształt funkcji trójwymiarowej przedstawionej na rys. 4.5a. Rys. 4.5b ilustruje położenia centrów funkcji bazowych wyselekcjonowanych przez sieć neuronową a rys. 4.5c i d odpowiednio postać funkcji odtworzonej oraz błąd odwzorowania. Szerokość funkcji radialnych była dobierana automatycznie w uzależnieniu od trzech najbliższych sąsiadów.

Jak widać odwzorowanie funkcji zadanej przez sieć RBF jest bliskie idealnemu. Błąd odwzorowania nie przekracza w całym zakresie wartości 0.01 i jest akceptowalny z praktycznego punktu widzenia.

1.7. Porównanie sieci radialnych z sieciami sigmoidalnymi

Sieci neuronowe radialne należą do tej samej grupy sieci trenowanych pod nadzorem co sieci sigmoidalne MLP. W stosunku do sieci wielowarstwowych o sigmoidalnych funkcjach aktywacji wyróżniają się pewnymi własnościami szczególnymi, pozwalającymi na łatwiejsze odwzorowanie cech charakterystycznych modelowanego procesu. Sieć sigmoidalna, w której niezerowa wartość funkcji sigmoidalnej rozciąga się od określonego punktu w przestrzeni aż do nieskończoności, reprezentuje aproksymację globalną funkcji zadanej, podczas gdy sieć radialna, opierająca się na funkcjach mających wartość niezerową jedynie w wąskiej przestrzeni wokół centrów, realizuje aproksymację typu lokalnego, której zasięg działania jest zwykle bardziej ograniczony. W efekcie należy się spodziewać, że zdolności generalizacyjne sieci radialnych są gorsze niż sieci sigmoidalnych, zwłaszcza na granicach obszaru danych uczących.

Sieci MLP ze względu na globalny charakter funkcji sigmoidalnej nie mają wbudowanego mechanizmu pozwalającego zidentyfikować region, na który najsilniej odpowiada dany neuron. Wobec niemożliwości fizycznego powiązania obszaru aktywności neuronu z odpowiednim obszarem danych uczących, w sieciach sigmoidalnych trudno jest określić optymalny punkt startowy w procesie uczenia. Biorąc pod uwagę wielomodalność funkcji celu, osiągnięcie minimum globalnego w tych warunkach jest trudne nawet przy wyrafinowanych metodach uczenia.

Sieci radialne radzą sobie z tym problemem znacznie lepiej. Funkcje radialne typu gaussowskiego, najczęściej używane w praktyce, są z natury funkcjami lokalnymi o wartościach niezerowych jedynie wokół określonego centrum. To pozwala łatwo powiązać parametry funkcji bazowych z fizycznym rozmieszczeniem danych uczących w przestrzeni wielowymiarowej. Stąd możliwe jest stosunkowo uzyskanie dobrych wartości startowych w procesie uczenia pod nadzorem. Zastosowanie podobnych algorytmów uczących przy wartościach startowych bliskich optymalnym zwielokrotnia prawdopodobieństwo uzyskania sukcesu dla sieci radialnych.

Uważa się, że sieci radialne lepiej niż sieci sigmoidalne nadają się do takich zadań klasyfikacyjnych, jak wykrywanie uszkodzeń w różnego rodzaju systemach, rozpoznawanie wzorców itp. Zastosowanie sieci radialnych w predykcji tak skomplikowanych szeregów czasowych, jak przewidywanie comiesięcznych zmian zatrudnienia w skali kraju, przewidywanie trendów ekonomicznych itp. pozwala uzyskać dobre rezultaty, porównywalne lub lepsze niż przy zastosowaniu sieci sigmoidalnych.

Ważną zaletą sieci radialnych jest znacznie uproszczony algorytm uczenia. Przy istnieniu tylko jednej warstwy ukrytej i ścisłym powiązaniu aktywności neuronu z odpowiednim obszarem przestrzeni danych uczących, punkt startowy uczenia jest znacznie bliżej rozwiązania optymalnego niż jest to możliwe do uzyskania w sieciach MLP. Dodatkowo możliwe jest oddzielenie etapu doboru parametrów funkcji bazowych od doboru wartości wag sieci (algorytm hybrydowy), co znacznie upraszcza i przyspiesza proces uczenia. Zysk czasowy jest znacznie większy, jeśli uwzględni się procedurę kształtowania optymalnej pod względem zdolności generalizacyjnych struktury sieci. W odniesieniu do sieci MLP jest to zagadnienie bardzo czasochłonne, wymagające zwykle wielokrotnego uczenia lub douczania. W sieciach radialnych przy zastosowaniu zwłaszcza ortogonalizacji, proces optymalnego kształtowania struktury sieci jest stałym fragmentem uczenia, nie wymagającym żadnego dodatkowego wysiłku.

1.8. Przykład zastosowania sieci RBF w modelu sztucznego nosa elektronicznego

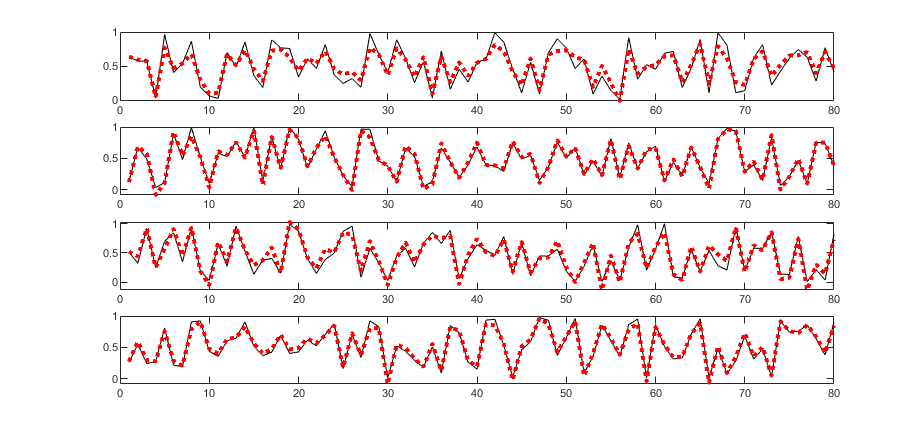

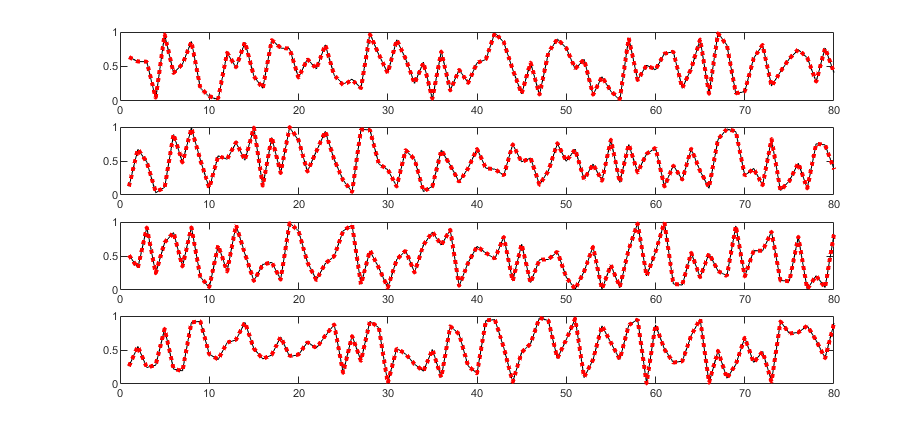

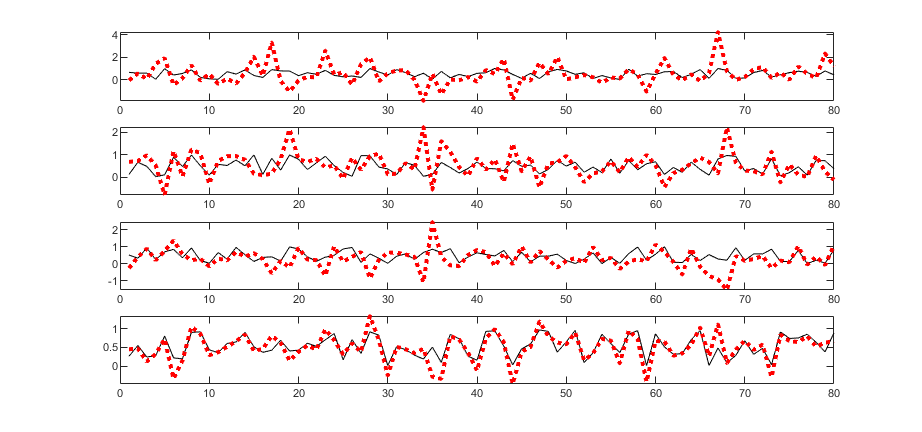

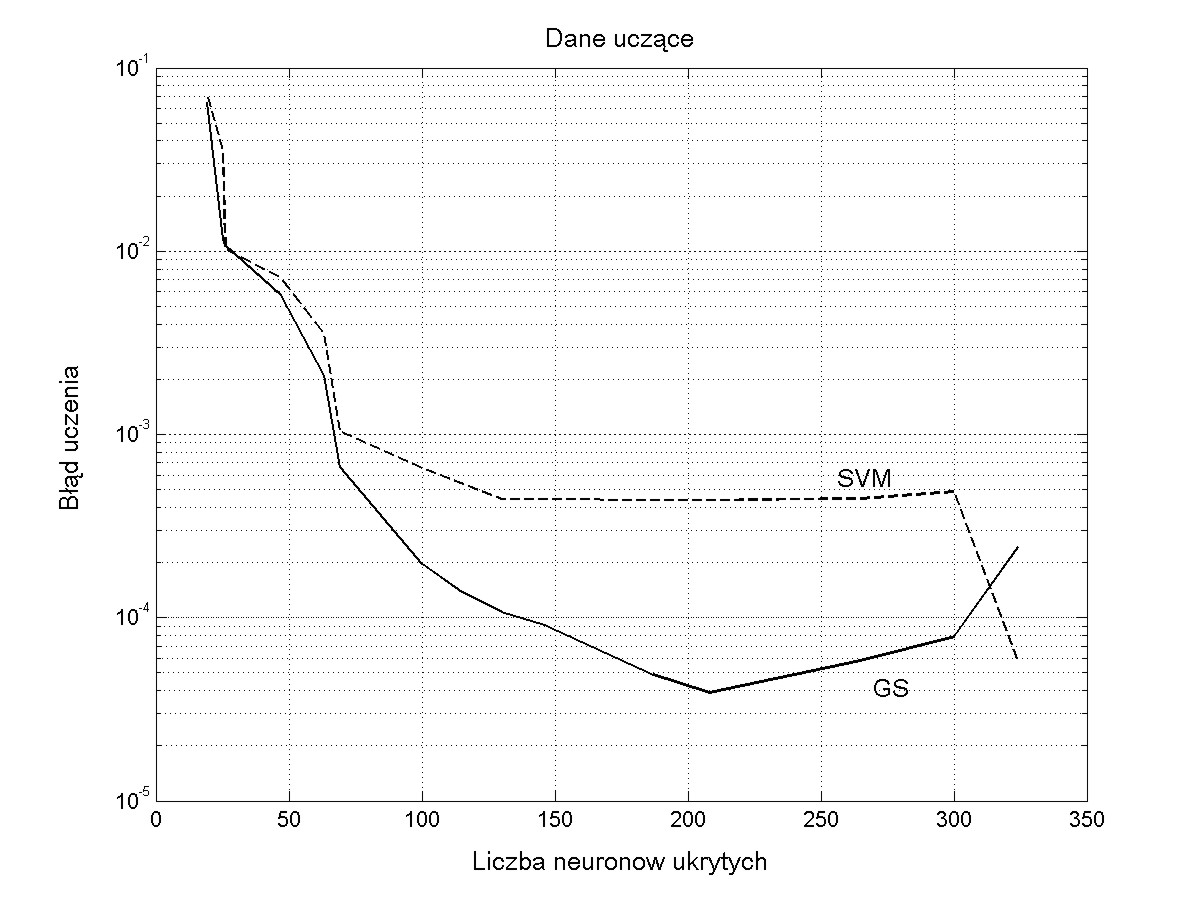

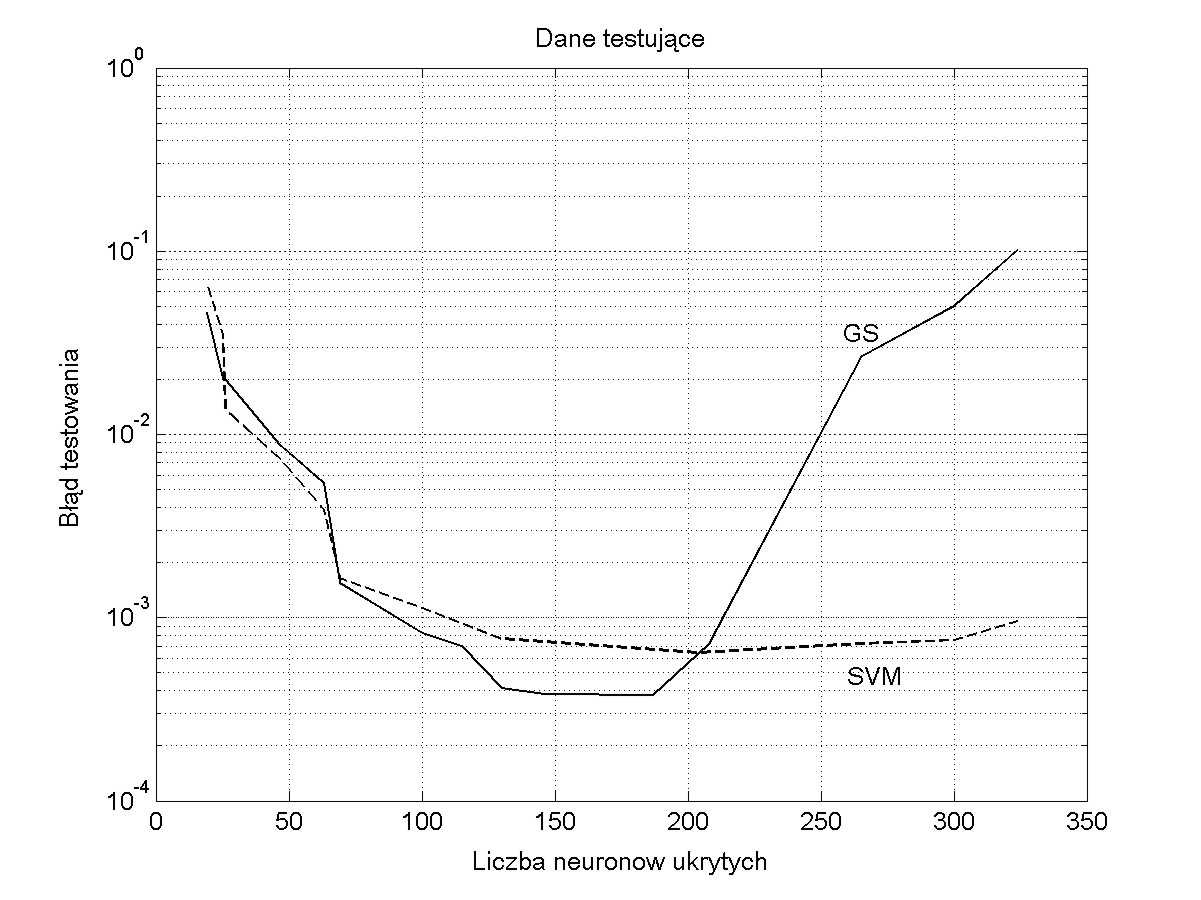

Zadaniem sieci RBF jest określenie stężenia 4 składników gazowych zmieszanych w różnym stosunku przy pomiarze za pomocą 5 czujników półprzewodnikowych firmy FIGARO. W uczeniu zastosowano 340 próbek o różnym stężeniu poszczególnych składników. W testowaniu sieci wytrenowanej użyto 80 próbek. Wynik testowania jest uzależniony od liczby neuronów ukrytych. Zbyt mała ich liczba prowadzi do sieci niedouczonej, zbyt duża liczba do sieci przeuczonej. Rys. 4.6 przedstawia wyniki testowania (wartości zadane względem estymowanych przez sieć) dla liczby neuronów \( K=20 \) (rysunek a), \( K=80 \) (rysunek b) oraz \( K=300\) (rysunek c).

|

a) |

|

|

b) |

|

|

c) |

|

1.9. Zadania i problemy

1. Porównać działanie sieci MLP i RBF pod kątem zalet i wad.

2. Korzystając z funkcji pinv Matlaba wyznaczyć pseudoinwersję macierzy losowej \( \mathbf{A} \) (wygenerowanej przy użyciu funkcji rand) przy założeniu, że macierz ta jest kwadratowa oraz prostokątna o liczbie wierszy większej i mniejszej niż liczba kolumn. Sprawdzić za każdym razem iloczyn macierzy \( \mathbf{A}\mathbf{A}^{-1} \). powiązać wyniki z uwarunkowaniem macierzy (funkcja cond Matlaba). Sprawdzić jak wartość funkcji cond zmienia się z wymiarami macierzy \( \mathbf{A} \).

3. Narysować szczegółową strukturę sieci RBF o dwu wejściach, dwu neuronach ukrytych i jednym wyjściu. Utworzyć sieć dołączoną do niej (sposób tworzenia identyczny jak dla sieci MLP przedstawionej w wykładzie 3). Napisać wyrażenia na gradient funkcji celu względem wag liniowych.

4. Rozważyć problem XOR opisany równaniem

|

x1=[1 1] |

d1=0 |

|

x1=[0 1] |

d1=1 |

|

x1=[1 0] |

d1=1 |

|

x1=[0 0] |

d1=0 |

Sieć RBF modelująca ten problem zawiera 2 neurony ukryte o centrach \( \mathbf{c}_1 = [1 \;1], \mathbf{c}_2 = [0 \; 0], \sigma_1 = \sigma_2 = 1 \). Określić macierz Greena oraz rozwiązanie względem wag \( \mathbf{w} \) przy wykorzystaniu pseudoinwersji. Wykorzystać odpowiednie funkcje macierzowe Matlaba.

5. Dana jest sieć RBF o strukturze przedstawionej na rys. 4.7

Centra funkcji radialnych dane są w postaci

\( \mathbf{c}_1=\left[\begin{array}{l}

1 \\

1

\end{array}\right], \quad \mathbf{c}_2=\left[\begin{array}{l}

2 \\

2

\end{array}\right], \quad \mathbf{c}_3=\left[\begin{array}{l}

3 \\

0

\end{array}\right] \)

a szerokość wszystkich funkcji równa \( \sigma_1 = 1 \). Wagi sieci są równe: \(w_1 =1, w_2 =0.5, w_3=1.5, w_4=-0.5 \). Sprawdzić przynależność do klasy 1 lub 2 następujących wektorów \( \mathbf{x} \)

\( \mathbf{x}_1=\left[\begin{array}{l} -1 \\ 0 \end{array}\right], \quad \mathbf{x}_2=\left[\begin{array}{l} 2 \\ 1 \end{array}\right], \quad \mathbf{x}_3=\left[\begin{array}{l} 3 \\ 1 \end{array}\right] \)

6. Zaprojektować sieć RBF modelującą funkcję nieliniową dwu zmiennych \( f_1(\mathbf{x})=\sqrt{x_1^2+x_2^2} \) korzystając z programu RBF_win.

7. Wygenerować zbiór danych o rozkładzie losowym typu gaussowskiego o trzech centrach położonych w \( \mathbf{c}_1 = [0.5 \; 1], \mathbf{c}_2 = [0.3 \; 0.8], \mathbf{c}_3 = [0.1 \; 0.5] \) (dla każdego centrum po 50 danych). Przyjąć wspólną wartość \( \sigma = 1 \). Napisać program w Matlabie określający centra 5 neuronów ukrytych przy wykorzystaniu metody off-line uczenia ze współzawodnictwem. Zilustrować graficznie otrzymany wynik na tle danych uczących.

1.10. Słownik

Słownik opanowanych pojęć

Wykład 4

Sieć neuronowa RBF – sieć neuronowa stosująca radialne funkcje aktywacji neuronów.

Aproksymator universalny lokalny – sieć neuronowa wykorzystująca funkcje aktywacji typu lokalnego (np. gaussowskiego)

Funkcja gaussowska – typ funkcji aktywacji bazujący na funkcji Gaussa, definiowany zwykle w postaci \( \varphi(\mathbf{x})=\exp \left(-\frac{\|\mathbf{x}-\mathbf{c}\|^2}{\sigma^2}\right) \), gdzie \( \mathbf{c} \) reprezentuje wektor centrum a \( \sigma \) szerokość funkcji gaussowskiej.

Macierz Greena – macierz zbudowana z funkcji radialnych na bazie danych uczących.

Pseudoinwersja – operacja macierzowa dotycząca procesu odwracania macierzy prostokątnej.

SVD – dekompozycja macierzy według wartości osobliwych.

Wielobok Voronoia – podział przestrzeni danych przedstawiający obszary dominacji określonych centrów odpowiadających poszczególnym funkcjom radialnym.

Grupowanie danych – podział zbioru danych na klastry grupujące dane podobne do siebie.

Algorytm K-uśrednień – metoda podziału zbioru danych na klastry (grupy) reprezentowane przez swoje centra.

Metoda OLS – metoda uczenia sieci RBF wykorzystująca dekompozycję Grama-Schmidta.

Program RBF_win – interfejs graficzny uczenia i testowania sieci RBF w środowisku Matlaba.

Nos elektroniczny – urządzenie do rozpoznawania zapachów przy zastosowaniu sensorów gazowych.

2. Sieci wektorów nośnych SVM

Przedstawione wcześniej sieci neuronowe typu MLP i RBF stosujące w uczeniu minimalizację nieliniowej funkcji celu (błędu), mają wiele wad. Po pierwsze minimalizowana funkcja jest zwykle wielomodalna względem optymalizowanych parametrów, o wielu minimach lokalnych, w których może utknąć proces uczenia w zależności od punktu startowego. Po drugie algorytm uczący nie jest zwykle w stanie kontrolować skutecznie złożoności sieci, stąd przyjęta na wstępie architektura sieci neuronowej i związana z nią wartość VCdim decyduje o przyszłych zdolnościach generalizacyjnych sieci [68]. Nawet sieć RBF stosująca w uczeniu metodę ortogonalizacji ma ograniczenia wynikające z pogarszającego się uwarunkowania macierzy Greena przy dużej liczbie danych uczących i pewnej arbitralności w doborze wartości \( \rho \).

Ten wykład wprowadza nowe podejście do tworzenia struktury i definiowania problemu uczenia sieci neuronowej poprzez modyfikację sposobu uczenia jako takiego doboru wag sieci, aby uzyskać w klasyfikacji najszerszy margines separacji oddzielający skrajne (położone najbliżej siebie) punkty danych uczących obu klas. To zapewni optymalną zdolność generalizacji tak wytrenowanej sieci. Sieć tego typu nosi nazwę SVM (ang. Support Vector Machine). Jej podstawy zostały zdefiniowane przez prof. Vapnika [68] zarówno dla zadania klasyfikacji jak i regresji. Wykład przedstawia podstawy budowy algorytmów uczących obu rodzajów sieci SVM oraz dyskusję uzyskanych wyników.

2.1. Pojęcia wstępne

W ogólności pod pojęciem sieci SVM rozumieć będziemy strukturę neuropodobną o jednej warstwie ukrytej stosującą różne rodzaje funkcji aktywacji i implementującą specjalny sposób uczenia sprowadzający się do programowania kwadratowego. W sieciach SVM rozróżnia się zadanie klasyfikacji i regresji. W przypadku zadania klasyfikacji maksymalizuje się margines separacji między dwoma klasami, przypisanymi danym (\( \mathbf{x}, d_i \)), przy zachowaniu jak najmniejszego błędu klasyfikacji na danych uczących. Zadanie aproksymacji zwane również regresją rozwiązuje się w tych sieciach przez sprowadzenie problemu uczenia do zadania analogicznego do klasyfikacji.

Sieci SVM należą do grupy sieci jednokierunkowych, o jednym neuronie wyjściowym, mają strukturę zwykle dwuwarstwową (warstwa ukryta i wyjściowa) i mogą implementować różne typy funkcji aktywacji, w tym funkcję liniową, wielomianową, radialną oraz sigmoidalną [32,46,68].

2.2. Sieć liniowa SVM w zadaniu klasyfikacji

Załóżmy, że dany jest zbiór par uczących \( (\mathbf{x}_i, d_i) \) dla \(i=1, 2, \ldots, p \) poddany klasyfikacji, w którym \( \mathbf{x}_i \) jest wektorem wejściowym a wartość zadana \( d_i \) jest równa \( 1 \) (klasa 1) bądź \( -1 \) (klasa przeciwstawna). Przy założeniu liniowej separowalności obu klas równanie hiperpłaszczyzny separującej może być zapisane wzorem

\( y(\mathbf{x})=\mathbf{w}^T\mathbf{x}+b=0 \)

w której \( \mathbf{w}=[w_1, w_2, \ldots, w_N]^T \) jest \(N\)-wymiarowym wektorem wag a \( \mathbf{x}=[x_1, x_2, \ldots, x_N]^T \), wektorem sygnałów wejściowych \( x_i \). Waga \(b\) stanowi polaryzację. Równania decyzyjne co do przynależności do klas przyjmują postać [68]

| \( \begin{aligned} \mathbf{w}^T \mathbf{x}_i+b > 0 & \rightarrow d_i=1 \\ \mathbf{w}^T \mathbf{x}_i+b < 0 & \rightarrow d_i=-1 \end{aligned} \) | (5.1) |

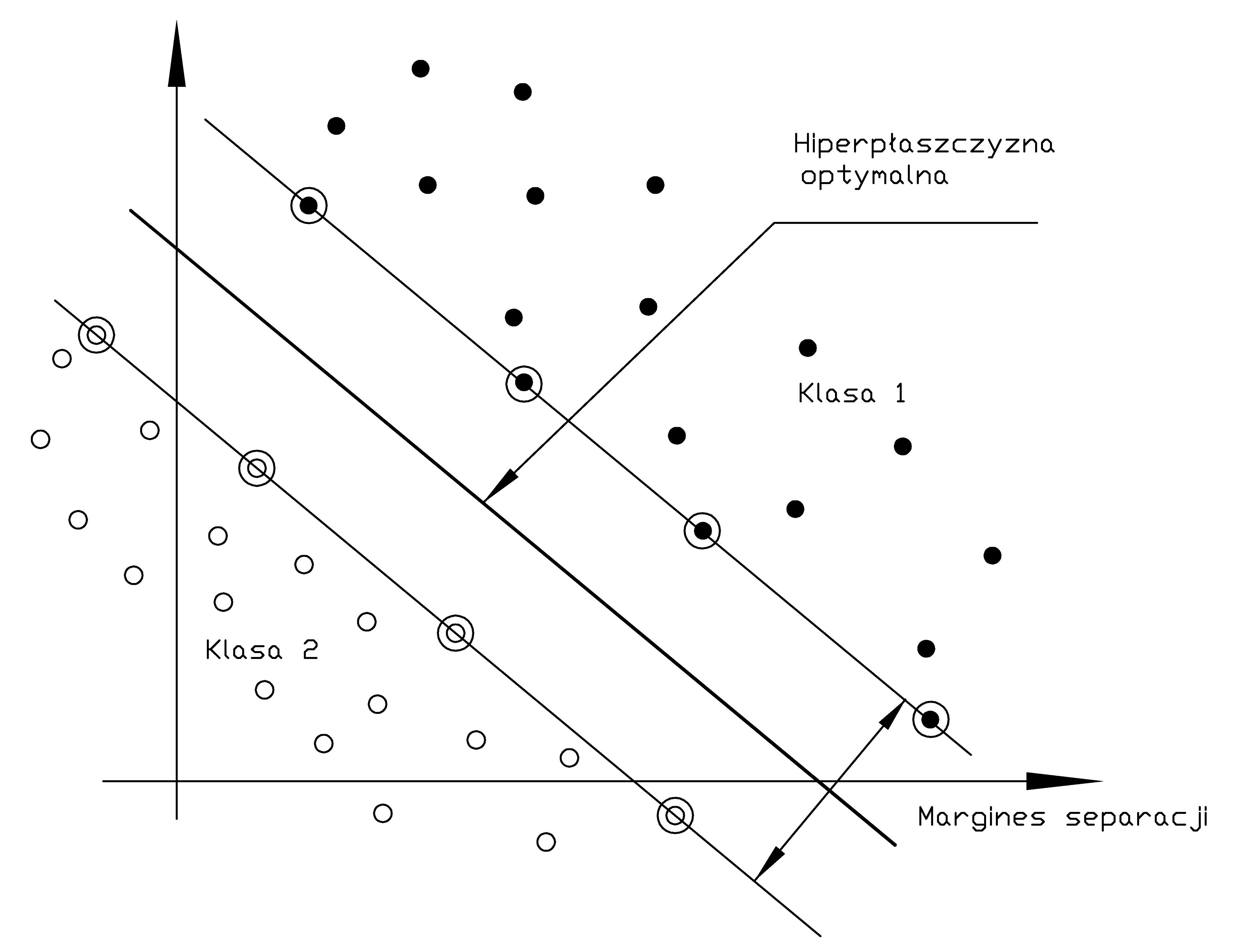

Za optymalną uważa się taką hiperpłaszczyznę \( y(\mathbf{x})=\mathbf{w}^T\mathbf{x}+b=0 \), która maksymalizuje margines separacji między dwoma klasami. Interpretacja marginesu separacji przedstawiona jest na rys. 5.1.

Odległość dowolnego punktu \( \mathbf{x}\) w przestrzeni wielowymiarowej od optymalnej hiperpłaszczyzny określona jest wzorem

| \( r(\mathbf{x})=\frac{y(\mathbf{x})}{\|\mathbf{w}\|} \) | (5.2) |

natomiast odległość początku układu współrzędnych od tej hiperpłaszczyzny jest szczególnym przypadkiem (\( \mathbf{x=0}\) ) i równa się \( r(\mathbf{0}) = b_0/\|\mathbf{w}\| \).

Na etapie uczenia wprowadza się pewien margines tolerancji rozdzielający obie klasy (nazywany marginesem separacji). Duża wartość tego marginesu zwiększa prawdopodobieństwo prawidłowej klasyfikacji dla danych testujących różniących się (z definicji) od danych uczących. Przy uwzględnieniu tolerancji i wprowadzeniu normalizacji warunek prawidłowego przypisania do klas można zapisać wówczas w postaci [68]

| \( \begin{aligned} \mathbf{w}^T \mathbf{x}_i+b \geq 1 & \rightarrow \quad d_i=1 \\ \mathbf{w}^T \mathbf{x}_i+b \leq -1 & \rightarrow \quad d_i=-1 \end{aligned} \) | (5.3) |

Oba równania można zapisać w pojedynczej postaci \( d_i\left(\mathbf{w}^T \mathbf{x}_i+b\right) \geq 1 \). Jeśli para punktów \( (\mathbf{x}_i, d_i) \) spełnia powyższe równanie ze znakiem równości to wektor \( \mathbf{x}_i \) tworzy tzw. wektor nośny \( \mathbf{x}_{sv} \)(ang. Support Vector - SV). Wektory nośne są tymi punktami danych, które leżą najbliżej optymalnej hiperpłaszczyzny i są najtrudniejsze w klasyfikacji. Co więcej przy założeniu pełnej separowalności liniowej danych należących do obu klas to one decydują o położeniu tej hiperpłaszczyzny i szerokości marginesu separacji, gdyż wszystkie punkty leżące z dala od hiperpłaszczyzny separującej spełniają warunek prawidłowej klasyfikacji z nadmiarem. Dla wektorów podtrzymujących \( \mathbf{x}_{sv} \) z definicji spełniony jest warunek \( \mathbf{w}^T\mathbf{x}_{sv} + b = \pm1 \) dla \( d(\mathbf{x}_{sv})=\pm1 \). Odległość wektorów podtrzymujących \( \mathbf{x}_{sv} \) od hiperpłaszczyzny określona jest zależnością

| \( r\left(\mathbf{x}_{s v}\right)=\frac{y\left(\mathbf{x}_{s v}\right)}{\|\mathbf{w}\|}=\left\{\begin{array}{ccc} \frac{1}{\|\mathbf{w}\|} & \text { dla } & g\left(\mathbf{x}_{sv}\right)=1 \\ -\frac{1}{\|\mathbf{w}\|} & \text { dla } & g\left(\mathbf{x}_{sv}\right)=-1 \end{array}\right. \) | (5.4) |

Margines separacji między obu klasami jest równy podwójnej wartości \( r(\mathbf{x}_{sv}) \), to znaczy

| \( \rho=2 r\left(\mathbf{x}_{sv}\right)=\frac{2}{\|\mathbf{w}\|} \) |

(5.5) |

Dla uzyskania efektu krzepkiej klasyfikacji, mało wrażliwej na szum występujący w danych pomiarowych, pożądana jest jak największa wartość tego marginesu. Z powyższego wzoru widać, że maksymalizacja marginesu separacji między dwoma klasami jest równoważna minimalizacji normy euklidesowej wektora wag \(\mathbf{w}\).

Problem uczenia liniowych sieci SVM, czyli doboru wag sieci dla danych uczących liniowo separowalnych sprowadza się do maksymalizacji marginesu separacji przy spełnieniu warunku (5.3). Nosi on nazwę problemu pierwotnego i zapisuje się go w postaci [68]

| \( \min \limits_w = \frac{1}{2}\mathbf{w}^T\mathbf{w} \) | (5.6) |

przy \( p \) liniowych ograniczeniach funkcyjnych \(i=1, 2, \ldots, p \)

| \( d_i\left(\mathbf{w}^T \mathbf{x}_i+b\right) \geq 1 \) |

(5.7) |

Jest to problem programowania kwadratowego z liniowymi ograniczeniami względem wag, który rozwiązuje się metodą mnożników Lagrange'a przez minimalizację tak zwanej funkcji Lagrange'a

| \( J(\mathbf{w}, b, \boldsymbol{\alpha})=\frac{1}{2} \mathbf{w}^T \mathbf{w}-\sum_{i=1}^p \alpha_i\left[d_i\left(\mathbf{w}^T \mathbf{x}_i+b\right)-1\right] \) | (5.8) |

w której wektor mnożników Lagrange'a \( \boldsymbol{\alpha} \) składa się z kolejnych mnożników \( \boldsymbol{\alpha}_i \) dla \(i=1, 2, \ldots, p \), o wartościach nieujemnych odpowiadających poszczególnym ograniczeniom, gdzie \( p \) oznacza liczbę par uczących. Mnożniki te rozszerzają liczbę parametrów optymalizowanych w procesie uczenia.

Rozwiązanie problemu minimalizacji funkcji Lagrange'a względem optymalizowanych parametrów \( \mathbf{w}, b, \boldsymbol{\alpha} \) jest określone przez punkt siodłowy funkcji Lagrange’a i odpowiada minimalizacji funkcji \( J(\mathbf{w}, b, \boldsymbol{\alpha}) \) względem wektora \(\mathbf{w},\) i parametru \( b \) oraz maksymalizacji względem wszystkich wartości mnożników tworzących wektor \(\boldsymbol{\alpha} \). Warunki optymalności rozwiązania względem \( \mathbf{w} \) i \( b \), są określone zależnościami

| \( \begin{aligned} & \frac{\partial J(\mathbf{w}, b, \boldsymbol{\alpha})}{\partial \mathbf{w}}=\mathbf{0} \quad \rightarrow \quad \mathbf{w}-\sum_{i=1}^p \alpha_i d_i \mathbf{x}_i=\mathbf{0} \\ & \frac{\partial J(\mathbf{w}, b, \boldsymbol{\alpha})}{\partial b}=0 \quad \rightarrow \quad \sum_{i=1}^p \alpha_i d_i=\mathbf{0} \end{aligned} \) | (5.9) |

Rozwiązanie powyższego układu równań przyjmuje postać

| \( \mathbf{w}=\sum_{i=1}^p \alpha_i d_i \mathbf{x}_i \) | (5.10) |

Dla wyznaczenia wartości b można wykorzystać fakt, że w punkcie siodłowym iloczyn mnożnika przez odpowiednie ograniczenie związane z wektorem \(\mathbf{x}_{sv} \) znika. Uwzględniając zależność \( \mathbf{w}^T\mathbf{x}_{sv} + b = \pm1 \) otrzymuje się

| \( b=\pm 1-\mathbf{w}^T\mathbf{x}_{sv} \) | (5.11) |

W przypadku doboru optymalnych wartości mnożników Lagrange’a uczenie sprowadza się do maksymalizacji funkcji Lagrange'a względem tych mnożników. Po wstawieniu zależności (5.10) i (5.11) do wzoru na funkcję Lagrange’a problem pierwotny przekształca się w problem dualny który można sformułować następująco [68]

| \( \max _{\boldsymbol{\alpha}} {Q}(\boldsymbol{\alpha})=\sum_{{i}=1}^{{p}} \alpha_{{i}}-\frac{1}{2} \sum_{{i}=1}^{{p}} \sum_{{j}=1}^{{p}} \alpha_{{i}} \alpha_{{j}} d_i d_j \mathbf{x}_i^T \mathbf{x}_j \) |

(5.12) |

przy ograniczeniach

| \( \begin{aligned}

\alpha_i & \geq 0 \\

\sum_{i=1}^p \alpha_i d_i & =0

\end{aligned} \) |

(5.13) |

dla \(i=1, 2, \ldots, p \). Rozwiązanie powyższego problemu optymalizacyjnego względem mnożników Lagrange'a pozwala wyznaczyć wartości optymalne wag w (równanie 5.10) i w następstwie również równanie określające sygnał wyjściowy \( y(\mathbf{x}) \) sieci (równy równaniu hiperpłaszczyzny separującej)

| \( y(\mathbf{x})=\sum_{i=1}^p \alpha_i d_i \mathbf{x}_i^T \mathbf{x}+b \) | (5.14) |

Przy rozwiązaniu problemu klasyfikacji wzorców nie w pełni separowalnych liniowo problem sprowadza się do określenia takiej optymalnej hiperpłaszczyzny, która minimalizuje prawdopodobieństwo błędu klasyfikacji na zbiorze uczącym z możliwie najszerszym marginesem separacji. W takim przypadku dane mogą naruszyć strefę marginesu separacji w dwojaki sposób.

-

Punkt danych \( (\mathbf{x}_i, d_i) \) położony jest wewnątrz strefy, ale po właściwej stronie optymalnej hiperpłaszczyzny. Nie występuje wówczas błąd klasyfikacji a jedynie realne zmniejszenie szerokości aktualnego marginesu.

-

Punkt danych \( (\mathbf{x}_i, d_i) \) położony jest wewnątrz lub na zewnątrz strefy, ale po niewłaściwej stronie optymalnej hiperpłaszczyzny. Odpowiada to wystąpieniu błędu klasyfikacji.

W rozwiązaniu problemu klasyfikacji danych nie separowalnych liniowo wprowadza się nieujemnie zdefiniowaną zmienną dopełniającą \( \xi \) zmniejszającą szerokość aktualnego marginesu separacji. Funkcje ograniczeń równościowych można wówczas zapisać w ogólniejszej postaci

| \( d_i\left(\mathbf{w}^T \mathbf{x}_i+b\right) \geq 1-\xi_i \) | (5.15) |

gdzie \( \xi_i \) jest nieujemną zmienną dopełniającą dobieraną indywidualnie dla każdej pary danych uczących. Jej wartość większa od zera efektywnie zmniejsza margines separacji, aż do jego przekroczenia, przy czym z definicji \( \xi_i \geq 0 \). Jeśli \( 0 \leq \xi_i \leq 1 \) to punkt danych \( (\mathbf{x}_i, d_i) \) leży wewnątrz strefy separacji po właściwej stronie. Jeśli natomiast \( \xi_i \geq 1 \) to punkt danych leży po niewłaściwej stronie optymalnej hiperpłaszczyzny i wystąpi błąd klasyfikacji. Wektory podtrzymujące spełniają dokładnie równanie \( d_i\left(\mathbf{w}^T \mathbf{x}_i+b\right) = 1-\xi_i \) a zatem uwzględnienie ich włącznie z tymi prowadzącymi do błędnej klasyfikacji ma wpływ na położenie optymalnej hiperpłaszczyzny. Uwzględnienie we wprowadzonych wcześniej ograniczeniach wyrażenia \( (1-\xi)_i \) zamiast wartości jednostkowej prowadzi do wzorów optymalizacyjnych o podobnej strukturze jak dla problemu klasyfikacji wzorców separowalnych liniowo. Przy klasyfikacji wzorców nie separowalnych liniowo problem pierwotny może więc być sprowadzony do minimalizacji zmodyfikowanej funkcji celu [59,68]

| \( \min _{\mathbf{w}} \frac{1}{2} \mathbf{w}^T \mathbf{w}+C \sum_{i=1}^p \xi_i \) | (5.16) |

przy ograniczeniach liniowych \(i=1, 2, \ldots, p \)

| \( \begin{aligned}

d_i\left(\mathbf{w}^T \mathbf{x}_i+b\right) & \geq 1-\xi_i \\

\xi_{\mathrm{i}} & \geq 0

\end{aligned} \) |

(5.17) |

Czynnik pierwszy we wzorze (5.16)) odpowiada maksymalizacji marginesu separacji, natomiast drugi odpowiada za przyszłe błędy testowania (suma \( \sum_{i=1}^p \xi_i \) jest maksymalnym, górnym oszacowaniem liczby tych błędów). Parametr \( C \) jest wagą z jaką traktowane są błędy testowania w stosunku do marginesu separacji, decydującą o złożoności przyszłej sieci neuronowej. Jest więc parametrem regularyzacyjnym, dobieranym przez użytkownika, na przykład w sposób eksperymentalny, poprzez trening połączony ze sprawdzaniem i oceną na bieżąco wyników. Postępując podobnie jak w przypadku wzorców separowalnych liniowo problem pierwotny jest sprowadzony do problemu dualnego, który można sformułować następująco [68] Dla danego zbioru danych uczących \( (\mathbf{x}_i, d_i) \) należy określić mnożniki Lagrange'a, które maksymalizują wartość funkcji błędu \( Q(\boldsymbol{\alpha}) \)

| \( \max \limits_{\boldsymbol{\alpha}} {Q}(\boldsymbol{\alpha})=\sum_{{i}=1}^{{P}} \alpha_{{i}}-\frac{1}{2} \sum_{{i}=1}^{{P}} \sum_{{j}=1}^{{P}} \alpha_{{i}} \alpha_{{j}} d_i d_j \mathbf{x}_i^T \mathbf{x}_j \) |

(5.18) |

przy ograniczeniach \(i=1, 2, \ldots, p \)

| \( \begin{aligned}

& 0 \leq \alpha_i \leq C \\

& \sum_{i=1}^p \alpha_i d_i=0

\end{aligned} \) |

(5.19) |

przy wartości \( C \) przyjętej z góry przez użytkownika. Ze sformułowania problemu wynika, że ani zmienna dopełniająca ani mnożniki Lagrange'a z nią związane nie pojawiają się w sformułowaniu problemu dualnego. Jedyna różnica w stosunku do problemu separowalności liniowej występuje w ograniczeniu górnym mnożników Lagrange'a. Mnożniki \( \alpha_i \) wynikające z rozwiązania zadania optymalizacyjnego (5.18) z ograniczeniami (5.19) muszą spełniać podstawowy warunek, mówiący że iloczyn mnożnika przez wartość funkcji ograniczenia dla każdej pary danych uczących jest równy zeru. Oznacza to, że wszystkie mnożniki dla których ograniczenie jest nieaktywne (ograniczenia spełnione z nadmiarem) muszą być równe zeru. Niezerowe wartości mnożników występują jedynie dla wektorów nośnych, dla których ograniczenie staje się typu aktywnego, ze znakiem równości (funkcja ograniczenia równa zeru).

Z rozwiązania problemu dualnego określa się wektor wag optymalnej hiperpłaszczyzny w postaci \( \mathbf{w}=\sum_{i=1}^p \alpha_i d_i \mathbf{x}_i \) identycznie jak dla problemu klasyfikacyjnego separowanego liniowo. Zauważmy, że sumowanie w powyższym wzorze dotyczy tylko składników uczących \(\mathbf{x}_i\), dla których mnożniki Lagrange'a są różne od zera. Są to tak zwane wektory nośne (podtrzymujące), których liczbę oznaczymy przez \( N_{sv} \). Jak z powyższego wzoru widać równanie optymalnej hiperpłaszczyzny zależy wyłącznie od wektorów nośnych. Pozostałe wektory ze zbioru danych uczących nie mają żadnego wpływu na wynik rozwiązania.

Równanie określające sygnał wyjściowy \( y(\mathbf{x}) \) sieci liniowej SVM o wagach optymalnych wynika ze wzoru (5.14), które tutaj przepiszemy w postaci

| \( y(\mathbf{x})=\sum_{i=1}^{N_{\text {sv }}} \alpha_i d_i \mathbf{x}_i^T \mathbf{x}+b \) | (5.20) |

Jest to równanie liniowe względem zmiennych wejściowych opisanych wektorem \( \mathbf{x} \) i wagach uzależnionych od niezerowych mnożników Lagrange'a i odpowiadających im wektorów podtrzymujących \( \mathbf{x}_i \) oraz wartości zadanych \( d_i\) stowarzyszonych z nimi.

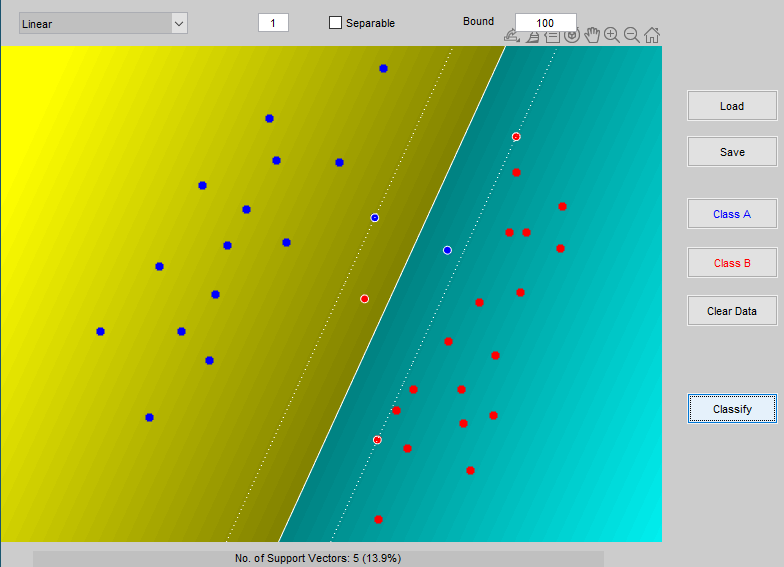

Na rys. 5.2 przedstawiono wynik klasyfikacji danych należących do dwu klas przy zastosowaniu liniowej sieci SVM uzyskany pry użyciu programu Gunna [21]. Wobec niepełnej separowalności danych uczących sieć liniowa dokonała klasyfikacji z 2 błędami (po jednym błędnym przypisaniu do każdej z klas). Margines separacji uwzględnia zmniejszenie odstępu od hiperpłaszczyzny separującej o wartości zmiennych dopełniających. Każdy punkt danych znajdujący się wewnątrz marginesu separacji oraz na obu hiperpłaszczyznach wektorów nośnych tworzy wektor podtrzymujący. W sumie jest ich 5, co stanowi 13.9% ogólnej liczby danych.

2.3. Sieć nieliniowa SVM w zadaniu klasyfikacji

Nieseparowalność liniowa wzorców nie oznacza braku ich separowalności w ogóle. Powszechnym rozwiązaniem, zastosowanym między innymi w poznanych już sieciach RBF jest nieliniowe zrzutowanie danych oryginalnych w inną przestrzeń funkcyjną, w której wzorce te są liniowo separowalne, bądź prawdopodobieństwo ich separowalności jest bliskie jedności. Podstawę matematyczną stanowi tu twierdzenia Covera [59,68], zgodnie z którym wzorce nieseparowalne liniowo w przestrzeni oryginalnej mogą być przetransformowane w inną przestrzeń parametrów, tak zwaną przestrzeń cech, zwykle o wymiarze \( K \ge N \), w której z dużym prawdopodobieństwem stają się separowalne liniowo. Warunkiem jest zastosowanie transformacji nieliniowej o odpowiednio wysokim wymiarze \(K\) przestrzeni cech.

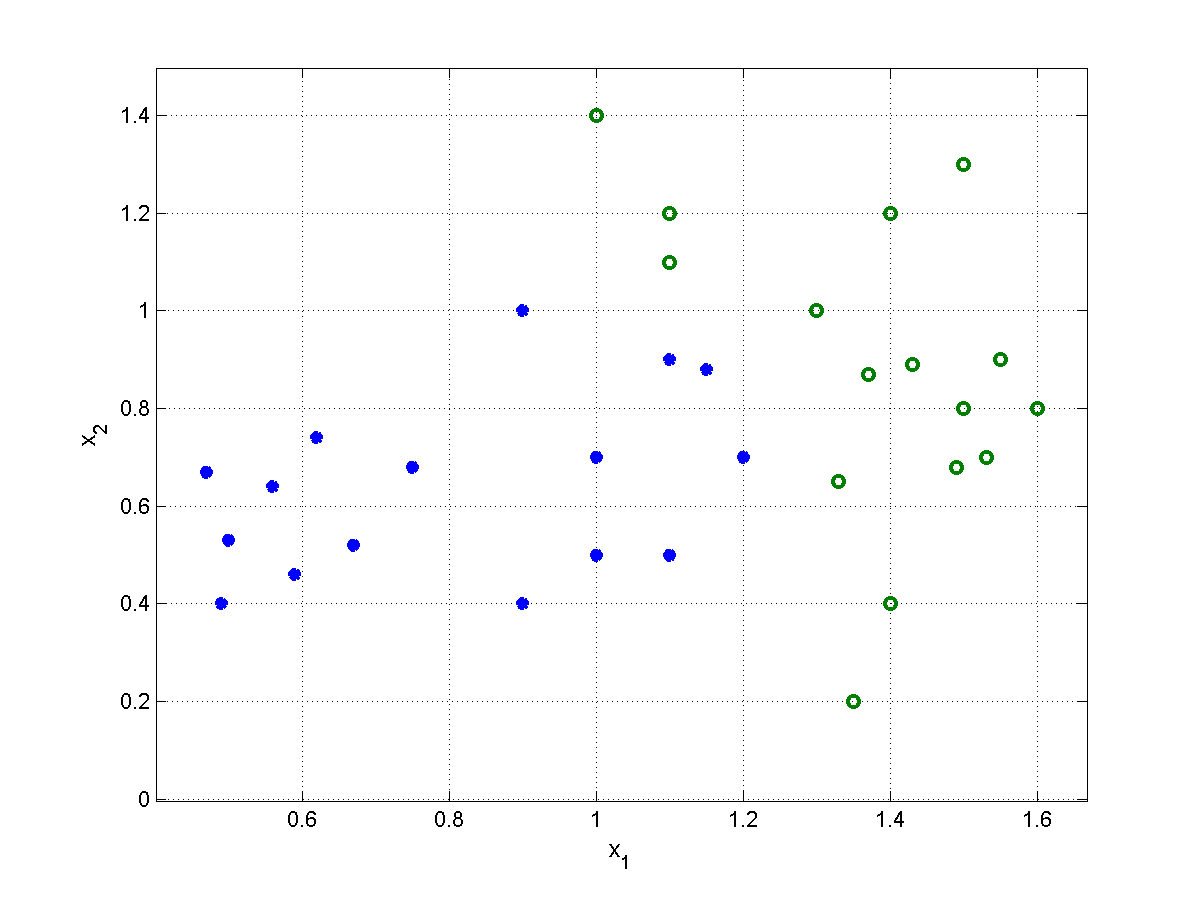

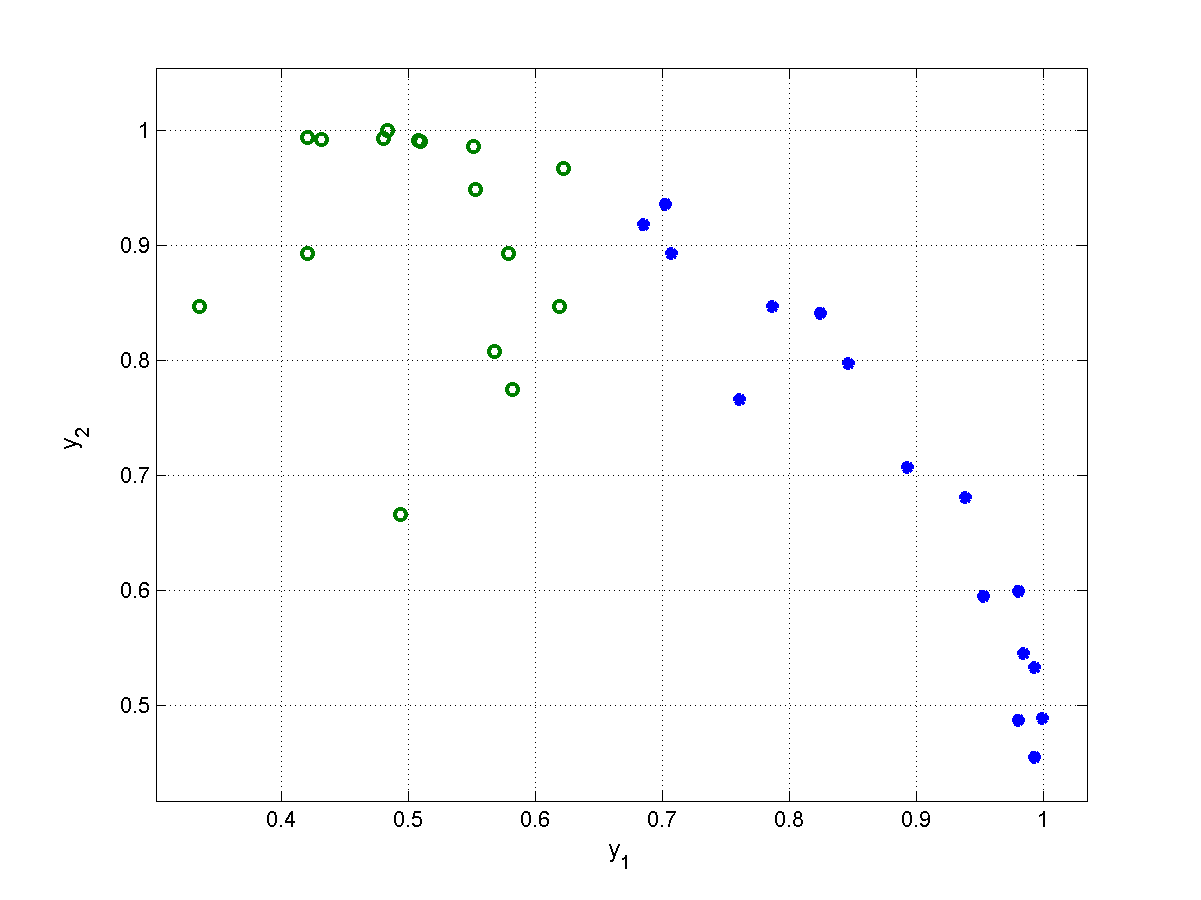

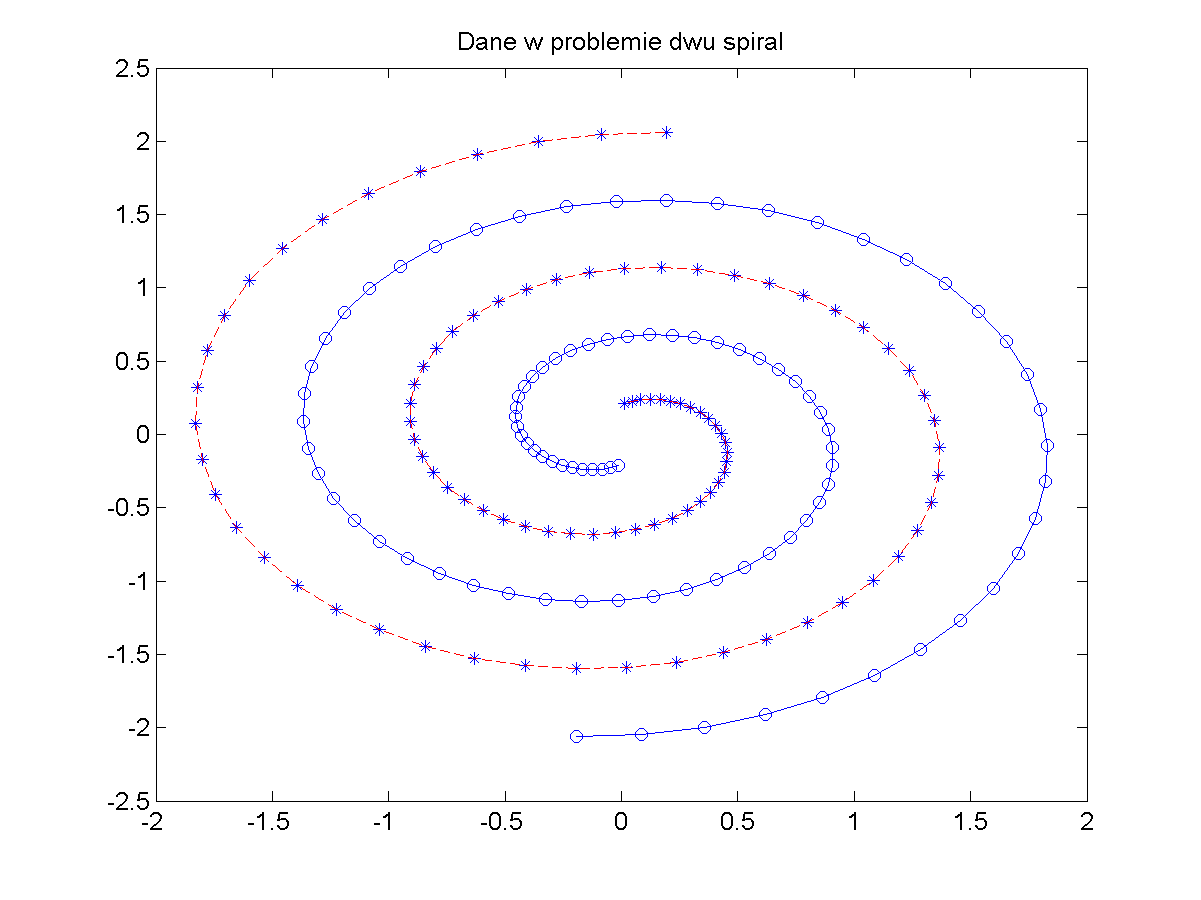

Rys. 5.3 przedstawia szczególny przykład nieliniowej transformacji wzorców należących do dwu klas nieseparowalnych liniowo (klasa \(1\) oznaczona gwiazdką i klasa \(2\) oznaczona symbolem o, obie określone w przestrzeni dwuwymiarowej, \(N=2\)), w przestrzeń funkcyjną zdefiniowaną za pośrednictwem 2 funkcji gaussowskich przy równej dla obu funkcji wartości \(\sigma^2=1,5\) oraz wartościach centrów \(\mathbf{c}_1=[0,5 ;\ 0,5]^T \), \(\mathbf{c}_2=[1,5 ;\ 0,8]^T \). Wzorce oryginalne nieseparowalne w przestrzeni dwuwymiarowej (rys. 5.3a) po transformacji nieliniowej stają się separowalne (rys. 5.3b) i mogą być rozdzielone jedną hiperpłaszczyzną separującą. Zauważmy, że w tym szczególnym przykładzie wystarczyło użycie tylko dwu funkcji nieliniowych, aby przekształcić problem nieseparowalny liniowo w problem całkowicie separowalny.

W ogólności, jeśli \( \mathbf{x} \) oznacza wektor wejściowy opisujący wzorzec, to po zrzutowaniu go w przestrzeń \(K\)-wymiarową jest on reprezentowany przez zbiór \( K\) cech \( \varphi_j(\mathbf{x}) \) dla \( j= 1, 2, \ldots, K \) tworzący wektor \( \boldsymbol{\varphi}(x)=[ \varphi_1(\mathbf{x}), \varphi_2(\mathbf{x}), \ldots, \varphi_K(\mathbf{x})]^T \). W efekcie takiej transformacji równanie hiperpłaszczyzny w przestrzeni liniowej określone wzorem \( y(\mathbf{x})=\mathbf{w}^T \boldsymbol{\varphi(\mathbf{x})}+b=0 \) może być zastąpione przez równanie hiperpłaszczyzny w przestrzeni cech, które można zapisać w postaci

| \( y(\mathbf{x})=\mathbf{w}^T \boldsymbol{\varphi}(\mathbf{x})+b=\sum_{j=1}^K w_j \varphi_j(\mathbf{x})+b=0 \) | (5.21) |

w której \( w_j \) oznaczają wagi prowadzące od \( \varphi_j(\mathbf{x}) \) do neuronu wyjściowego, \( \mathbf{w} = [w_1, w_2, \ldots, w_K]^T\). Wektor wag \( \mathbf{w} \) jest \(K\)-wymiarowy a \(b\) oznacza wagę polaryzacji. Cechy procesu opisane funkcjami \( \varphi_j(\mathbf{x}) \) przejęły rolę poszczególnych zmiennych \( x_j \). Wartość sygnału wyjściowego sieci opisuje teraz równanie

| \( y(\mathbf{x})=\mathbf{w}^T \boldsymbol{\varphi}(\mathbf{x})+b=0 \) |

(5.22) |

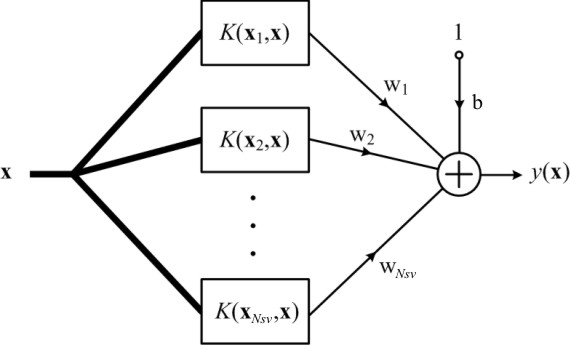

Równaniu (5.22) można przyporządkować strukturę sieci neuronowej analogiczną do sieci RBF, omówioną w rozdziale poprzednim jak to przedstawiono na rys. 5.4.

Zasadniczą różnicę w stosunku do sieci RBF stanowi fakt, że funkcje \( \varphi_j(\mathbf{x}) \) mogą przyjmować dowolną postać, w szczególności radialną, sigmoidalną czy wielomianową. Traktując warstwę ukrytą sieci jedynie jako układ rzutujący dane oryginalne w przestrzeń cech, w której są one liniowo separowalne, można traktować sygnały \( \varphi_j(\mathbf{x}) \) jako wymuszenia dla sieci liniowej SVM. Wszystkie zależności wyprowadzone dla sieci liniowej obowiązują zatem również tutaj, przy formalnym zastąpieniu wektora \( \mathbf{x} \) przez wektor \( \boldsymbol{\varphi}(\mathbf{x}) \). W szczególności problem pierwotny uczenia można przepisać w postaci

| \( \min \limits_{\mathbf{w}} \frac{1}{2} \mathbf{w}^T \mathbf{w}+C \sum_{i=1}^p \xi_i \) | (5.23) |

przy ograniczeniach liniowych (\(i=1, 2, …, p)\)

| \( \begin{aligned}

d_i\left(\mathbf{w}^T \boldsymbol{\varphi}\left(\mathbf{x}_i\right)+b\right) &\geq 1-\xi_i \\

\xi_i &\geq 0

\end{aligned} \) |

(5.24) |

Rozwiązanie problemu pierwotnego odbywa się poprzez jego transformację do problemu dualnego, identycznie jak dla sieci o liniowej separowalności wzorców poprzez minimalizację funkcji Lagrange'a [59,68]

| \( J(\mathbf{w}, b, \boldsymbol{\alpha}, \boldsymbol{\xi}, \boldsymbol{\mu})=\frac{1}{2} \mathbf{w}^T \mathbf{w}+C \sum_{i=1}^p \xi_i-\sum_{i=1}^p \alpha_i\left[d_i\left(\mathbf{w}^T \boldsymbol{\varphi}\left(\mathbf{x}_i\right)+b\right)-1+\xi_i\right]-\sum_{i=1}^p \mu_i \xi_i \) |

(5.25) |

w której mnożniki \( \alpha_i \) odpowiadają ograniczeniom funkcyjnym a \( \mu_i \) ograniczeniom nierównościowym nakładanym na zmienne \( \xi_i \) (wzór 5.24).

Rozwiązanie powyższego problemu optymalizacyjnego zakłada w pierwszym etapie przyrównanie do zera pochodnych funkcji Lagrange'a względem \( \mathbf{w} \), \( b \) oraz \( \xi_i \). Z zależności tych otrzymuje się wyrażenie wektora \( \mathbf{w} \) poprzez mnożniki Lagrange'a oraz dodatkowe zależności funkcyjne, które muszą być spełnione. Po uwzględnieniu tych zależności problem pierwotny przekształca się w problem dualny zdefiniowany wyłącznie względem mnożników Lagrange'a \( \alpha_i \) o następującej postaci (mnożniki \( \mu_i \) zostają wyeliminowane)

| \( \max _{\boldsymbol{\alpha}} {Q}(\boldsymbol{\alpha})=\sum_{{i}=1}^{{p}} \alpha_{{i}}-\frac{1}{2} \sum_{{i}=1}^{{p}} \sum_{{j}=1}^{{p}} \alpha_{{i}} \alpha_{{j}} d_i d_j K\left(\mathbf{x}_i, \mathbf{x}_j\right) \) |

(5.26) |

przy ograniczeniach \((i=1, 2,\ldots,p)\)

| \( \begin{aligned} 0 \leq \alpha_i &\leq C \\ \sum_{i=1}^p \alpha_i d_i&=0 \end{aligned} \) | (5.27) |

przy wartości stałej \( C \) przyjętej z góry przez użytkownika. Funkcja \( K\left(\mathbf{x}_i, \mathbf{x}_j\right) \) występująca w sformułowaniu zadania dualnego jest iloczynem skalarnym funkcji wektorowej \( \boldsymbol{\varphi}(\mathbf{x})=\left[\varphi_1(\mathbf{x}), \varphi_2(\mathbf{x}), \ldots, \varphi_K(\mathbf{x})\right]^T \) określonym dla wektorów \(\mathbf{x}_i \) oraz \(\mathbf{x}_j \)

| \( K\left(\mathbf{x}_i, \mathbf{x}_j\right)=\boldsymbol{\varphi}^T\left(\mathbf{x}_i\right) \boldsymbol{\varphi}\left(\mathbf{x}_j\right) \) | (5.28) |

Iloczyn ten nazywany jest funkcją jądra (ang. kernel function). Z definicji jest to skalarna funkcja symetryczna, to znaczy \( K\left(\mathbf{x}_i, \mathbf{x}_j\right) = K\left(\mathbf{x}_j, \mathbf{x}_i\right) \). Zauważmy, że sformułowanie problemu dualnego nie zawiera ani zmiennych dopełniających ani odpowiadających im mnożników Lagrange'a. Mnożniki \( \mu_i \) muszą spełniać równość \( \mu_i+\alpha_i=C \), ich iloczyn ze zmienną dopełniającą \( \xi_i \) musi być równy zeru, \( \mu_i \xi_i=0 \).

Rozwiązanie problemu dualnego pozwala wyznaczyć optymalne wartości mnożników Lagrange'a, na podstawie których określa się wartości optymalne wag sieci w postaci

| \( \mathbf{w}=\sum_{i=1}^p \alpha_i d_i \boldsymbol{\varphi}\left(\mathbf{x}_i\right) \) |

(5.29) |

Wartość wagi polaryzacyjnej \( b \) wyznacza się podobnie jak w przypadku liniowym wybierając dowolny wektor podtrzymujący \( \mathbf{x}_{sv} \) dla którego \( \xi_i = 0 \) i stosując wzór \( b= \pm 1-\mathbf{w}^T \varphi\left(\mathbf{x}_{s V}\right) \). Po podstawieniu zależności (5.29) do wzoru (5.22) otrzymuje się ostateczne wyrażenie określające sygnał wyjściowy sieci nieliniowej SVM w postaci

| \( y(\mathbf{x})=\mathbf{w}^T \boldsymbol{\varphi}(\mathbf{x})+b=\sum_{i=1}^{N_{S V}} \alpha_i d_i K\left(\mathbf{x}_i, \mathbf{x}_j\right)+b \) |

(5.30) |

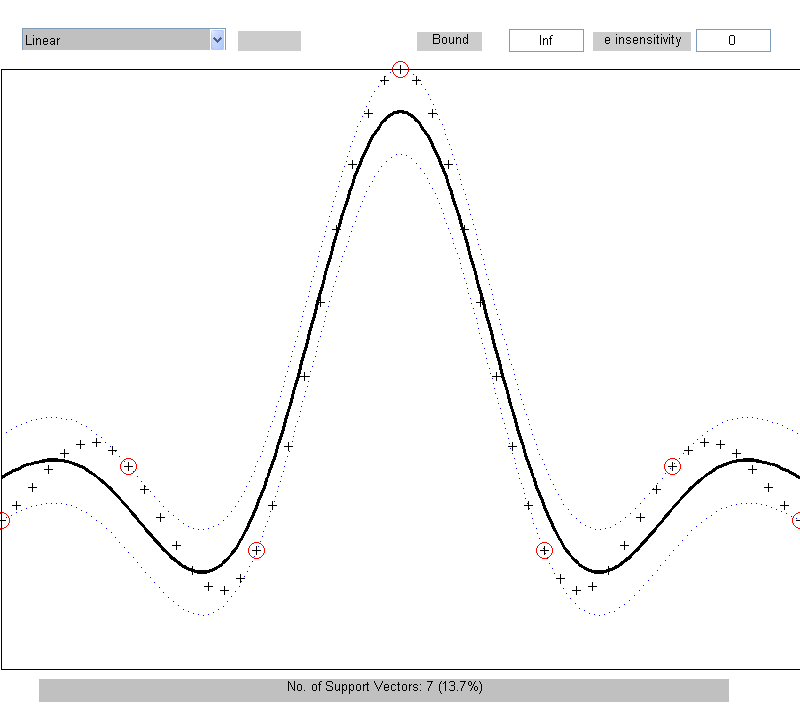

Sygnał wyjściowy sieci zależy od funkcji jądra \( K\left(\mathbf{x}_i, \mathbf{x}_j\right) \) a nie od funkcji aktywacji \( \varphi(\mathbf{x}) \). W związku z tym wynikową strukturę sieci nieliniowej SVM można przedstawić jak na rys. 5.5.

O tym czy funkcja \( K\left(\mathbf{x}_i, \mathbf{x}_j\right) \) jest kandydatem na jądro spełniającym warunek iloczynu skalarnego dwu bliżej nieokreślonych funkcji wektorowych \( \varphi(\mathbf{x}) \) i \( \varphi(\mathbf{x}_j) \) decyduje spełnienie warunków twierdzenia Mercera [68]. Istnieje wiele funkcji spełniających warunek Mercera, które mogą być użyte do budowy sieci SVM. Do takich funkcji należy między jądro typu gaussowskiego, wielomianowego, funkcje sklejane oraz (przy pewnych ograniczeniach) również jądro sigmoidalne [46,59].

W tabeli 5.1 zestawiono zależności odnoszące się do najczęściej używanych jąder: liniowego, wielomianowego, radialnego oraz sigmoidalnego. Zastosowanie jądra sigmoidalnego prowadzi do powstania sieci perceptronowej o jednej warstwie ukrytej, jądra radialnego - do sieci RBF, natomiast jądra wielomianowego do sieci wielomianowej. Wszystkie te sieci zawierają jedną warstwę ukrytą. W przypadku jądra liniowego sieć jest w pełni liniowa bez warstwy ukrytej.

Tabela 5.1. Przykłady funkcji jąder

|

Funkcja jądra |

Równanie |

Uwagi |

|

Liniowe |

\( K\left(\mathbf{x}_i, \mathbf{x}\right)=\mathbf{x}^T \mathbf{x}_i+\gamma \) |

\( \gamma \) - wartość stała |

|

Wielomianowe |

\( K\left(\mathbf{x}_i, \mathbf{x}\right)=\left(\mathbf{x}^T \mathbf{x}_i+\gamma\right)^q \) |

\(q\) –stopień wielomianu |

|

Gaussowskie |

\( K\left(\mathbf{x}_i, \mathbf{x}\right)=\exp \left(-\gamma\left\|\mathbf{x}-\mathbf{x}_i\right\|^2\right) \) |

\( \gamma \) - wartość stała (odwrotność \( \sigma^2 \)) |

|

Sigmoidalne |

\( K\left(\mathbf{x}_i, \mathbf{x}\right)=\operatorname{tgh}\left(\beta \mathbf{x}^T \mathbf{x}_i+\gamma\right) \) |

\( \beta, \gamma \) - współczynniki liczbowe |

Funkcje jądra dają swój wkład w definicję funkcji celu w zadaniu dualnym dla konkretnych wartości wektorów wejściowych \( \mathbf{x} \). Przy ustalonych przez użytkownika wartościach współczynników tych funkcji składniki związane z jądrem mają charakter liczbowy i rodzaj zastosowanego jądra nie ma żadnego związku z nieliniowością problemu optymalizacyjnego (problem dualny jest zawsze o postaci kwadratowej). Zauważmy, że funkcje jądra \( K\left(\mathbf{x}_i, \mathbf{x}_j\right) \) są wielkościami skalarnymi i dla wszystkich możliwych kombinacji indeksów \( i, j\) tworząc macierz kwadratową.

Należy podkreślić, że w sieci radialnej liczba funkcji bazowych i ich centra są automatycznie utożsamione z wektorami podtrzymującymi. Sieć SVM o radialnej funkcji jądra może więc być utożsamiona z siecią radialną RBF, choć jej ostateczna struktura jak również sposób uczenia są różne. W sieci sigmoidalnej liczba neuronów ukrytych jest określona również automatycznie przez liczbę wektorów podtrzymujących i położenia tych wektorów.

Istotnym elementem teorii sieci nieliniowej SVM jest fakt, że po zastąpieniu wektora \( \mathbf{x} \) poprzez wektor \( \boldsymbol{\varphi}(\mathbf{x}) \) a iloczynu skalarnego \( \mathbf{x}_i^T \mathbf{x}_j \) przez \( K\left(\mathbf{x}_i, \mathbf{x}_j\right) \) problem uczenia można sformułować w identyczny sposób jak dla sieci liniowej, jako problem pierwotny i dualny. Rozwiązaniu podlega praktycznie problem dualny, który niezależnie od rodzaju zastosowanej sieci jest sformułowany jako zadanie programowania kwadratowego. W procesie uczenia sieci SVM początkowa liczba wektorów podtrzymujących jest zwykle równa liczbie danych uczących. W zależności od przyjętych wartości ograniczeń (wartość parametru \( C \)) złożoność sieci jest redukowana i tylko część wektorów uczących pozostaje nadal wektorami podtrzymującymi.

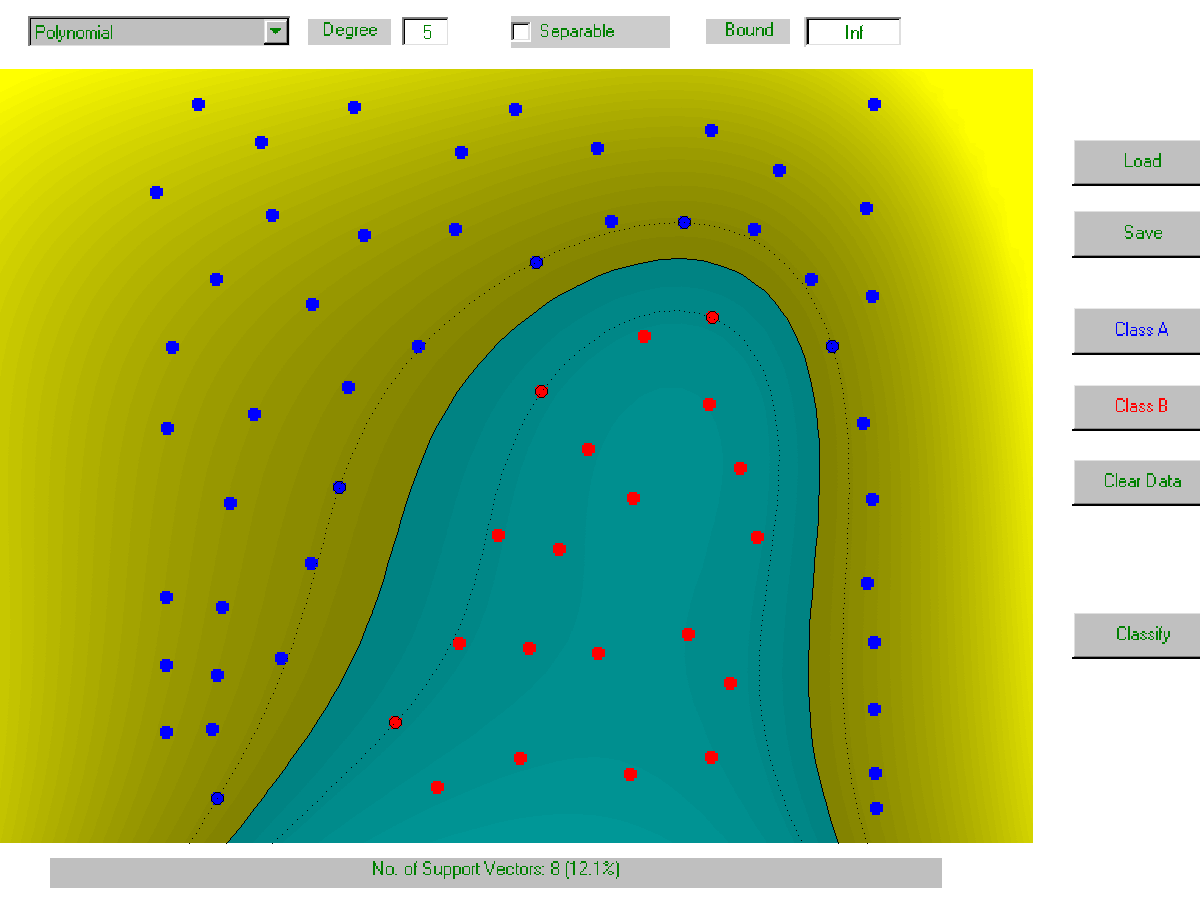

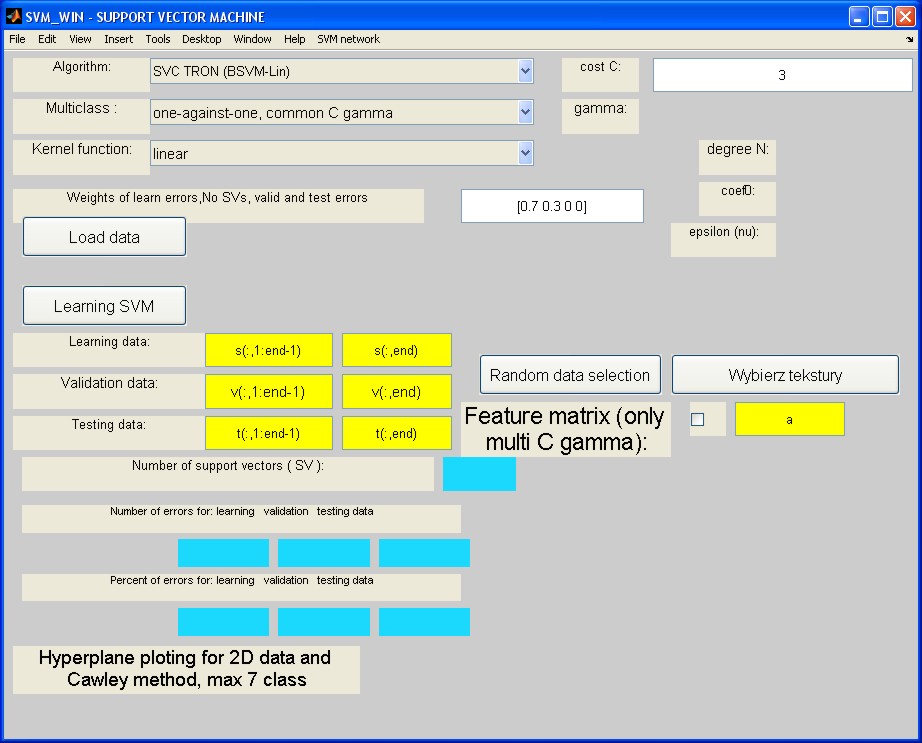

Na rys. 5.6 przedstawiono przykład działania klasyfikacyjnego sieci SVM o jądrze radialnym dla rozkładu danych dwuwymiarowych rozmieszczonych jak na rysunku, należących do dwu klas. Jak widać przy odpowiedniej wartości współczynnika \( C \) hiperpłaszczyzna w przestrzeni cech transformuje się w nieliniową krzywą w przestrzeni oryginalnej \( \mathbf{x} \), separującą bezbłędnie obie klasy. Liczba wektorów podtrzymujących zależy od wartości \( C \). Im wyższa jego wartość tym większa kara za przekroczenie ograniczeń i w efekcie węższy margines separacji, a co za tym idzie również mniejsza liczba wektorów podtrzymujących.

Przy małej wartości \( C \) kara za przekroczenie ograniczeń jest niewielka i optymalne wartości wag umożliwiają klasyfikację z wieloma błędami na danych uczących.

5.3.1 Interpretacja mnożników Lagrange'a w rozwiązaniu sieci

Mnożniki Lagrange'a spełniają bardzo ważną rolę w rozwiązaniu problemu uczenia sieci SVM. Każdy mnożnik \( \alpha_i \) jest stowarzyszony z odpowiadającą mu parą uczącą \( (\mathbf{x}_i, d_i) \) stanowiąc współczynnik kary za niespełnienie ograniczenia (w przypadku spełnienia tego ograniczenia wartość mnożnika powinna być zerowa). Z warunków optymalności Kuhna-Tuckera problemu optymalizacyjnego sformułowanego dla sieci SVM wynikają następujące zależności [32,59]

| \( \begin{aligned} & \alpha_i\left[ d_i\left(\mathbf{w}^T \varphi\left(\mathbf{x}_i\right)+b\right)+\xi_i-1\right]=0 \\ & 0 \leq \alpha_i \leq C \\ & \mu_i \xi_i=0 \\ & \alpha_i+\mu_i=C \\ & \xi_i \geq 0 \end{aligned} \) | (5.31) |

W przypadku spełnienia ograniczenia mnożnik Lagrange'a z definicji powinien przyjąć wartość zerową eliminując wpływ danego ograniczenia na wartość minimalizowanej funkcji celu. W zależności od obliczonych wartości mnożników \( \alpha_i \) możemy mieć do czynienia z 3 przypadkami.

-

\( \alpha_i = 0 \)

Biorąc pod uwagę warunek Kuhna-Tuckera \( \alpha_i+\mu_i=C \) wartość zmiennej dopełniającej \(\mu_i=C \). Uwzględniając zależność \(\mu_i\xi_i=0\) jest oczywiste, że \(\xi_i=0\), co oznacza, że para ucząca \( (\mathbf{x}_i, d_i) \) spełnia ograniczenie bez zmniejszania szerokości marginesu separacji (klasyfikacja całkowicie poprawna). Co więcej, wobec zerowej wartości \( \alpha_i \) para ta nie wnosi żadnego wkładu do ukształtowanej hiperpłaszczyzny separującej.

-

\( 0 < \alpha_i < C \)

Wartość mnożnika \(\mu_i\) jest równa \(\mu_i=C-\alpha_i\) co oznacza, że dla spełnienia warunki \(\mu_i\xi_i=0\) wartość \(\xi_i=0\) podobnie jak w przypadku poprzednim. Jednakże tym razem wobec niezerowej wartości \(\alpha_i\) zerować się musi czynnik \( d_i\left(\mathbf{w}^T \varphi\left(\mathbf{x}_i\right)+b\right)+\xi_i-1 \). Przy zerowej wartości \( \xi_i \) i binarnych wartościach zadanych \( d_i=\pm 1 \) otrzymuje się warunek \( \mathbf{w}^T \varphi\left(\mathbf{x}_i\right)+b= \pm 1 \) oznaczający, że wektor \( x_i \) jest wektorem podtrzymującym. Stąd wartość mnożnika z przedziału \( 0 < \alpha_i < C \) oznacza, że para danych uczących położona jest dokładnie na marginesie separacji (klasyfikacja poprawna).

-

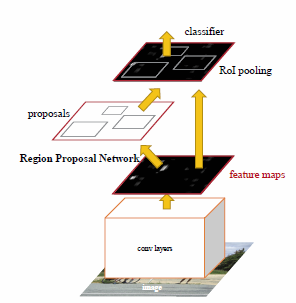

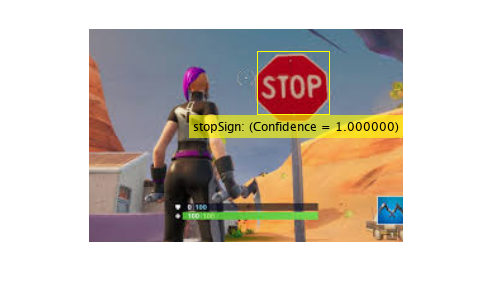

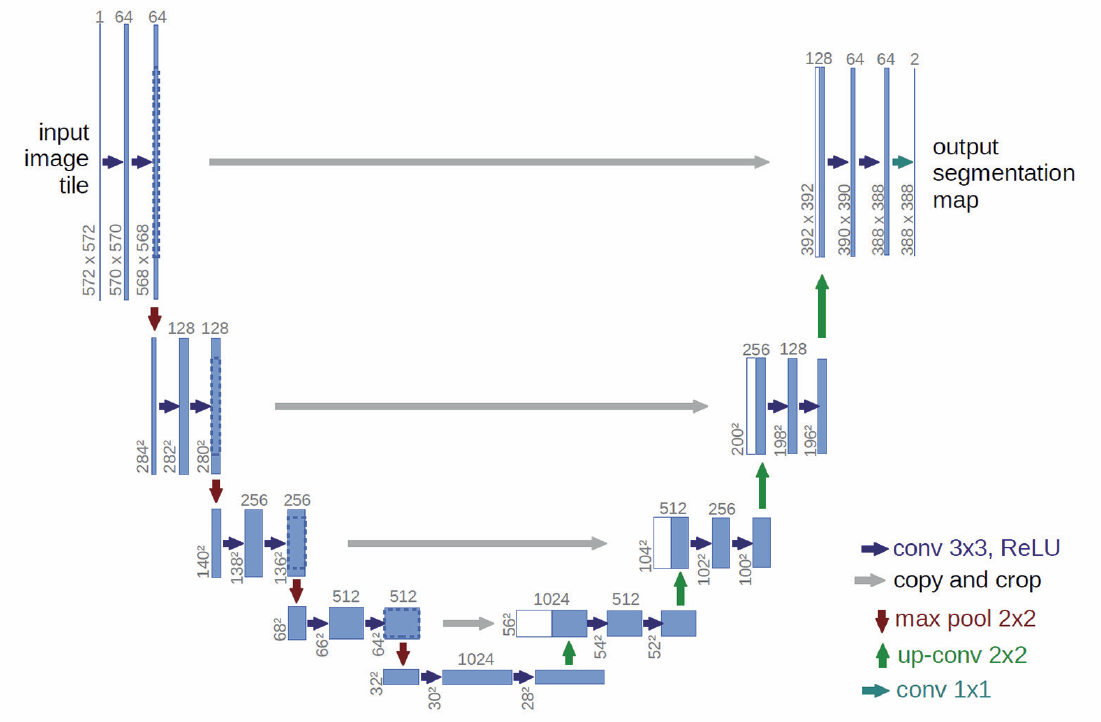

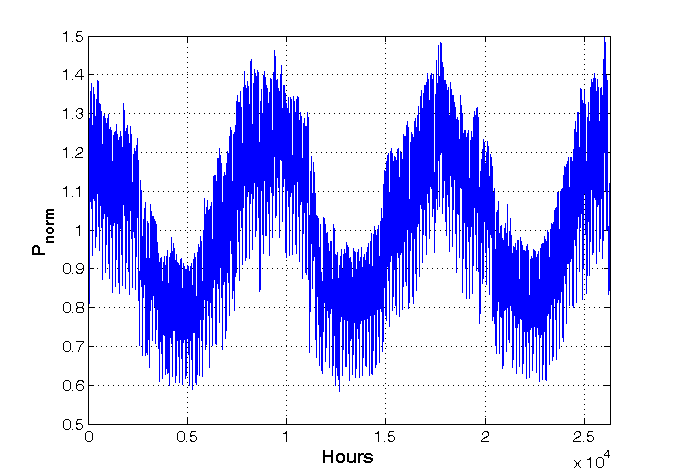

\( \alpha_i = C \)