Podręcznik

Warstwa transportowa w modelu TCP/IP pełni kluczową funkcję pośredniczącą między aplikacjami a mechanizmami przesyłu danych w sieci. Jej zadaniem jest zapewnienie sprawnej i niezawodnej komunikacji między procesami działającymi na różnych urządzeniach. Główne protokoły tej warstwy to TCP i UDP. TCP, jako protokół połączeniowy, gwarantuje dostarczenie danych w poprawnej kolejności i bez błędów, realizując mechanizmy kontroli przepływu oraz zarządzania zatorami. UDP natomiast oferuje transmisję bez nawiązywania połączenia, bez kontroli poprawności, co czyni go idealnym dla aplikacji wymagających niskiego opóźnienia, takich jak gry online czy transmisje audio-wideo. Warstwa ta odpowiada również za ustanawianie i zamykanie sesji komunikacyjnych oraz uwzględnia parametry jakości usług (QoS), które są istotne dla różnicowania priorytetów ruchu sieciowego, szczególnie w systemach wymagających niezawodnej i terminowej transmisji danych.

1. Warstwa Transportowa

1.4. Zagadnienia związane z jakością usług (QoS)

Zagadnienia związane z jakością usług (QoS) w sieciach komputerowych stanowią jeden z kluczowych obszarów badań i inżynierii systemów sieciowych. QoS, czyli Quality of Service, odnosi się do zestawu technik, mechanizmów oraz parametrów, które mają na celu kontrolowanie, gwarantowanie lub poprawianie jakości transmisji danych przez sieć. Pojęcie jakości usług nabiera szczególnego znaczenia w kontekście sieci zróżnicowanych aplikacyjnie – gdzie różne typy ruchu, takie jak transmisje wideo, rozmowy głosowe, synchronizacja danych czy zapytania do baz danych, konkurują o te same zasoby komunikacyjne. Ponieważ zasoby te (przepustowość, buforowanie, czasy przetwarzania, opóźnienia) są ograniczone, niezbędne jest wdrożenie mechanizmów umożliwiających ich odpowiedni podział i zarządzanie.

QoS obejmuje zarówno aspekty ilościowe, takie jak dostępna przepustowość (bandwidth), średnie opóźnienie (latency), zmienność opóźnienia (jitter), jak i jakość percepcyjną, która ma szczególne znaczenie w aplikacjach czasu rzeczywistego, takich jak VoIP (Voice over IP), wideokonferencje, transmisje live czy gry sieciowe. Parametry te nie są tylko czysto techniczne – ich wartości bezpośrednio wpływają na komfort użytkownika końcowego. Na przykład, wysoki jitter w połączeniu głosowym może powodować zniekształcenia dźwięku, mimo że przepustowość sieci jest wysoka. Odpowiednie zarządzanie QoS wymaga więc nie tylko alokacji zasobów, ale również klasyfikacji pakietów, ich kolejkowania, oznaczania priorytetów i mechanizmów reagowania w przypadku przeciążeń lub awarii.

W klasycznych sieciach best-effort, takich jak standardowy model działania Internetu, wszystkie pakiety traktowane są jednakowo. Niezależnie od tego, czy są to pakiety wideo, zapytania DNS czy fragmenty plików FTP – nie mają przypisanego priorytetu ani nie są obsługiwane przez mechanizmy, które gwarantowałyby im określony poziom usługi. Ten model jest prosty i skalowalny, ale nieprzystosowany do potrzeb współczesnych aplikacji wrażliwych na opóźnienia. Dlatego wprowadzono szereg modeli i mechanizmów QoS, które pozwalają różnicować sposób obsługi ruchu, zapewniać priorytety, a w skrajnych przypadkach – gwarancje parametrów transmisji.

Jednym z podstawowych elementów QoS jest klasyfikacja ruchu, czyli zdolność sieci do rozróżnienia, do jakiej klasy należy dany pakiet. Klasyfikacja może być realizowana na podstawie informacji zawartych w nagłówkach protokołów warstw 3 i 4 (np. adres IP, port TCP/UDP) albo przez bardziej zaawansowane mechanizmy inspekcji pakietów. Dzięki klasyfikacji można przypisać pakietom etykiety oznaczające ich istotność. Przykładowo, pakiet RTP z głosem w czasie rzeczywistym może być oznaczony jako „priorytet wysoki”, podczas gdy pakiet z aktualizacją systemu operacyjnego jako „priorytet niski”.

W kolejnych etapach przetwarzania pakiety trafiają do kolejek obsługiwanych z różnym priorytetem. Najpopularniejsze metody obsługi kolejek to FIFO (pierwsze przyszło, pierwsze wyszło), WFQ (Weighted Fair Queuing), PQ (Priority Queuing) oraz CBWFQ (Class-Based Weighted Fair Queuing). Techniki te różnią się podejściem do kolejności obsługi pakietów oraz udziałem pasma przypisanym poszczególnym klasom ruchu. Na przykład, PQ może zawsze obsługiwać pakiety głosowe przed innymi, co gwarantuje niskie opóźnienia, ale może prowadzić do wygłodzenia mniej istotnych klas.

QoS może być realizowany według dwóch głównych modeli: IntServ (Integrated Services) i DiffServ (Differentiated Services). IntServ opiera się na rezerwacji zasobów w całej ścieżce transmisji i jest zbliżony do koncepcji kanałów w sieciach telefonicznych – każda aplikacja żąda określonych zasobów, a sieć albo przydziela je, albo odrzuca żądanie. Głównym protokołem wspierającym IntServ jest RSVP (Resource Reservation Protocol), który umożliwia przesyłanie żądań rezerwacji i ich potwierdzeń. Ten model oferuje silne gwarancje jakości, ale jest mało skalowalny i trudny w implementacji w globalnym Internecie.

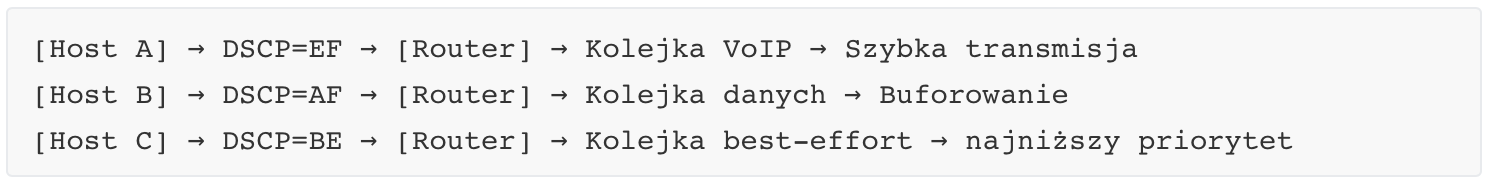

DiffServ jest bardziej praktycznym rozwiązaniem i opiera się na przypisywaniu pakietom etykiet w polu DSCP (Differentiated Services Code Point) nagłówka IP. Pakiety są oznaczane zgodnie z wcześniej zdefiniowanymi klasami usług (np. EF – Expedited Forwarding dla VoIP, AF – Assured Forwarding dla ważnych danych) i obsługiwane przez routery zgodnie z tymi oznaczeniami. DiffServ nie gwarantuje twardej rezerwacji zasobów, ale umożliwia różnicowanie poziomu usług i bardzo dobrą skalowalność.

Z punktu widzenia warstwy transportowej, QoS dotyka głównie TCP i UDP jako podstawowych protokołów. TCP jest wrażliwy na opóźnienia, stratę pakietów i jitter, ponieważ jego mechanizmy retransmisji oraz dostosowywania tempa transmisji (np. poprzez CWND) zakładają pewne modele zachowania sieci. Jeśli jitter jest wysoki, może dochodzić do niepotrzebnych retransmisji lub nadmiernego zmniejszenia okna przeciążeniowego, co wpływa negatywnie na wydajność. UDP nie implementuje własnych mechanizmów QoS – jest bezstanowy i nie gwarantuje dostarczenia danych – dlatego jego użycie w aplikacjach czasu rzeczywistego wymaga wsparcia ze strony infrastruktury sieciowej. To routery, przełączniki i punkty dostępowe muszą zapewnić, że pakiety UDP będą miały odpowiedni priorytet i minimalne opóźnienia.

W systemach opartych o MPLS (Multiprotocol Label Switching) możliwe jest jeszcze bardziej zaawansowane zarządzanie QoS. MPLS umożliwia przypisywanie ścieżek przesyłu danych z uwzględnieniem klasy usług i może współpracować z modelami DiffServ. Przykładowo, pakiety VoIP mogą być kierowane przez szybsze i mniej przeciążone łącza, a dane mniej wrażliwe – przez kanały o niższym priorytecie. MPLS rozszerza możliwości QoS również w kontekście tzw. Traffic Engineering, gdzie inżynierowie mogą projektować sieci zgodnie z oczekiwanym ruchem i wymaganiami jakościowymi.

QoS nie jest też domeną wyłącznie dużych operatorów czy sieci korporacyjnych. W nowoczesnych domowych sieciach Wi-Fi QoS bywa realizowane przez funkcje takie jak WMM (Wi-Fi Multimedia), które przypisują różne priorytety do danych głosowych, wideo, danych ogólnych i sygnałów kontrolnych. Przykładowo, transmisja z kamery IP lub połączenia przez komunikator może otrzymać wyższy priorytet niż pobieranie pliku.

Równie istotne jak aspekty techniczne są aspekty biznesowe QoS. W sieciach operatorów telekomunikacyjnych QoS jest podstawą umów SLA (Service Level Agreement), w których usługodawca zobowiązuje się do utrzymania określonych parametrów transmisji, np. maksymalnego opóźnienia, dostępności usługi czy minimalnej przepustowości. Takie zobowiązania wymagają nie tylko monitorowania i raportowania parametrów sieciowych, ale również implementacji systemów automatycznego wykrywania i reagowania na pogorszenie jakości.

Mechanizmy QoS wiążą się także z bezpieczeństwem i zarządzaniem przeciążeniami. Ataki typu DDoS (Distributed Denial of Service) mogą zapełnić kolejki ruchu o niskim priorytecie, wpływając przy okazji na inne klasy ruchu. Dlatego niektóre systemy QoS uwzględniają również mechanizmy ochronne, takie jak policing (odrzucanie nadmiarowego ruchu), shaping (regulowanie tempa transmisji) i remarking (zmiana klasy pakietu). Zastosowanie tych technik może skutecznie ograniczyć skutki niepożądanych zjawisk sieciowych.

QoS to nie tylko mechanizmy w infrastrukturze, ale także proces zarządzania – obejmuje analizę ruchu, pomiar jakości, adaptacyjne planowanie pasma, oraz integrację z systemami zarządzania usługami. W nowoczesnych architekturach sieci, takich jak SDN (Software-Defined Networking), QoS może być realizowane dynamicznie na podstawie polityk i reguł aplikacyjnych, co pozwala np. aplikacji wideokonferencyjnej zgłosić zapotrzebowanie na niskie opóźnienie i automatycznie otrzymać odpowiedni poziom usług.

W środowiskach chmurowych QoS ma znaczenie nie tylko dla transmisji między użytkownikami a chmurą, ale również w ramach samych centrów danych – np. podczas synchronizacji replik baz danych, migracji maszyn wirtualnych czy działania kontenerów, gdzie opóźnienia sieciowe mogą powodować realne konsekwencje dla aplikacji rozproszonych. W takich środowiskach stosuje się również techniki lokalne, takie jak ograniczanie IOPS dla urządzeń blokowych, przydział zasobów CPU, czy regulacja pasma interfejsów wirtualnych.

QoS, choć trudny w implementacji na skalę globalną, pozostaje kluczowym elementem architektury sieci nowej generacji. Jego skuteczność zależy zarówno od implementacji technicznej w urządzeniach sieciowych, jak i od właściwego projektowania polityk, monitoringu i ciągłego dostrajania ustawień zgodnie z realnymi wymaganiami aplikacji i użytkowników.