Podręcznik

Aplikacje i usługi sieciowe stanowią podstawowy komponent współczesnych systemów informatycznych, umożliwiając komunikację i wymianę danych w rozproszonym środowisku. W centrum ich działania znajdują się protokoły aplikacyjne, takie jak HTTP, SMTP, FTP czy DNS, które definiują zasady interakcji między klientami a serwerami. Większość współczesnych aplikacji opiera się na modelu klient-serwer, zapewniając skalowalność, modularność i łatwość zarządzania. Coraz większe znaczenie zyskuje bezpieczeństwo — zarówno na poziomie transmisji danych, jak i autoryzacji dostępu — co jest kluczowe w kontekście cyberzagrożeń. Równolegle rozwijają się zdecentralizowane modele, jak sieci P2P, oferujące alternatywne podejście do współdzielenia zasobów. Istotnym trendem jest także rosnąca rola chmur obliczeniowych, które umożliwiają elastyczne, skalowalne i zdalne świadczenie usług sieciowych na żądanie, przy zachowaniu wysokiej dostępności i niezawodności.

1. Aplikacje i Usługi Sieciowe

1.4. Sieci P2P

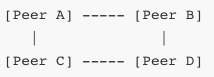

Sieci peer-to-peer (P2P) stanowią alternatywę wobec tradycyjnego modelu klient-serwer, który dominuje w większości zastosowań sieciowych. W modelu P2P każdy węzeł sieci działa jednocześnie jako klient i serwer, co oznacza, że uczestnik sieci może zarówno pobierać dane, jak i je udostępniać. Brak centralizacji i hierarchicznej struktury sprawia, że sieci P2P cechują się wyjątkową odpornością na awarie, dobrą skalowalnością i wysoką efektywnością w rozproszonej wymianie zasobów. Ich działanie opiera się na kooperacji pomiędzy równorzędnymi uczestnikami, z których każdy ma potencjalnie równy dostęp do wspólnych zasobów i odpowiedzialność za ich przechowywanie i rozpowszechnianie.

W odróżnieniu od architektury klient-serwer, w której serwer centralny odpowiada za przechowywanie i dostarczanie danych wszystkim klientom, w modelu P2P dane są rozproszone pomiędzy uczestników sieci. Każdy peer może zawierać fragmenty danych, które są wymieniane z innymi węzłami bez potrzeby angażowania centralnego serwera. W związku z tym sieci P2P lepiej znoszą przeciążenia i ataki DDoS, ponieważ nie istnieje pojedynczy punkt awarii, którego wyeliminowanie mogłoby sparaliżować system.

Pierwsze powszechnie znane implementacje sieci P2P pojawiły się pod koniec lat 90. Jedną z najsłynniejszych była sieć Napster, służąca do dzielenia się plikami muzycznymi. Napster był modelem hybrydowym – centralny serwer indeksował lokalizacje plików, ale same dane przesyłane były bezpośrednio pomiędzy użytkownikami. W późniejszych latach powstały bardziej zdecentralizowane systemy, takie jak Gnutella, eDonkey czy BitTorrent, które z czasem ewoluowały w kierunku pełnej decentralizacji. W sieciach takich każdy peer sam przechowuje i rozpowszechnia dane, a mechanizmy odkrywania zasobów i trasowania zapytań są wbudowane w samą sieć.

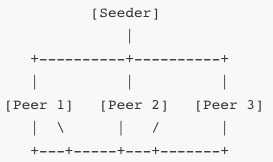

W BitTorrent, który jest jednym z najbardziej zaawansowanych protokołów P2P, dane są dzielone na małe fragmenty, które są pobierane i jednocześnie udostępniane innym użytkownikom. Oznacza to, że im więcej osób pobiera dany plik, tym szybciej działa cała sieć, ponieważ rośnie liczba dostępnych źródeł. Mechanizm ten działa dzięki konstrukcji zwanej swarm (rój), w której wszyscy uczestnicy danego transferu wymieniają się fragmentami danych.

W powyższym schemacie każdy peer wymienia się fragmentami z innymi peerami. Seeder to peer, który posiada cały plik i udostępnia go innym. Klient rozpoczynający pobieranie staje się najpierw leecherem, a następnie – gdy pobierze część pliku – także udostępnia go innym. Gdy pobierze całość, staje się seederem.

Dzięki mechanizmowi równego udziału użytkowników w wymianie danych, sieci P2P są naturalnie odporne na skalowanie – im więcej użytkowników uczestniczy, tym większa przepustowość całego systemu. Ograniczeniem może być jednak dostępność rzadkich fragmentów plików. W tym celu stosuje się algorytmy optymalizujące rozprowadzanie danych, takie jak „rarest first”, który preferuje pobieranie najrzadszych fragmentów, aby zapewnić ich rozprzestrzenianie się w roju.

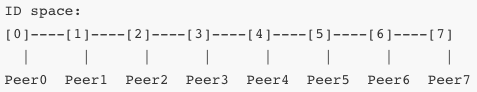

W kontekście komunikacji pomiędzy peerami, istotne są dwie koncepcje: routowanie i odkrywanie zasobów. W sieciach niezcentralizowanych nie istnieje centralny katalog plików ani węzeł indeksujący. Dlatego każdy peer musi samodzielnie znaleźć inne węzły posiadające interesujące go dane. W sieciach typu Gnutella wykorzystywano rozgłoszeniowe zapytania (flooding), które rozsyłały żądania po całej sieci. To jednak generowało duży ruch i było nieefektywne. W nowszych rozwiązaniach stosuje się struktury logiczne takie jak DHT (Distributed Hash Table), które umożliwiają zlokalizowanie zasobu na podstawie jego identyfikatora.

Każdy peer odpowiada za pewien zakres identyfikatorów i przechowuje informacje o zasobach znajdujących się w tym zakresie. Zapytanie o zasób kierowane jest do odpowiedniego peera poprzez system trasowania, który przypomina drzewo binarne lub sieć kółek, w zależności od implementacji. Takie rozwiązania są stosowane np. w protokole Kademlia i uTorrent.

W sieciach P2P istotnym problemem jest zarządzanie reputacją i wiarygodnością peerów. Ponieważ każdy peer może pełnić funkcję zarówno źródła danych, jak i ich odbiorcy, sieci te są podatne na ataki typu poisoning (rozpowszechnianie fałszywych danych), freeloading (brak współdzielenia plików) czy sybiling (podszywanie się pod wielu użytkowników). Aby przeciwdziałać tym zjawiskom, wprowadza się systemy reputacji, limity współdzielenia, protokoły weryfikacji danych (hashowanie SHA-1 lub SHA-256), oraz mechanizmy szyfrowania komunikacji pomiędzy peerami.

Sieci P2P znajdują zastosowanie nie tylko w udostępnianiu plików, ale również w wielu innych obszarach. Przykładem może być technologia blockchain, która działa w pełni w modelu P2P. W tej technologii każdy węzeł sieci posiada kopię rozproszonej księgi, do której są dopisywane nowe transakcje. Brak centralnego serwera i konsensus pomiędzy węzłami (np. przez Proof-of-Work lub Proof-of-Stake) sprawia, że sieć jest odporna na modyfikację danych i cenzurę.

Innym przykładem są komunikatory zdecentralizowane, takie jak Tox czy RetroShare, w których rozmowy są szyfrowane end-to-end, a dane przechowywane lokalnie. Aplikacje te nie opierają się na serwerze pośredniczącym i pozwalają na bezpośrednią komunikację pomiędzy użytkownikami. Podobne mechanizmy stosowane są w niektórych systemach rozproszonych gier sieciowych, aktualizacji oprogramowania czy streamingu P2P.

Jedną z form nowoczesnych sieci P2P są tzw. sieci mesh, w których urządzenia łączą się bezpośrednio ze sobą i przekazują dalej dane innym uczestnikom. Takie rozwiązania wykorzystywane są w sieciach ad-hoc, komunikacji kryzysowej, smart-city czy IoT. Przykładowo, urządzenia mogą tworzyć lokalną sieć wymiany informacji, nawet bez dostępu do Internetu.

W architekturze P2P występuje również problem NAT traversal – wielu użytkowników korzysta z sieci za NAT-em (Network Address Translation), co uniemożliwia bezpośrednie połączenia. W odpowiedzi powstały techniki takie jak STUN (Simple Traversal of UDP through NATs), TURN (Traversal Using Relays around NAT) i ICE (Interactive Connectivity Establishment), które umożliwiają zestawianie połączeń P2P nawet w środowiskach zamkniętych. Technologie te wykorzystywane są m.in. w protokole WebRTC, który umożliwia tworzenie bezpośrednich połączeń audio/wideo pomiędzy przeglądarkami.

Z perspektywy użytkownika końcowego, sieci P2P mogą działać transparentnie – użytkownik instaluje aplikację, która automatycznie odnajduje inne węzły, zarządza zasobami i optymalizuje przepływ danych. Ale z perspektywy administratora systemów lub projektanta sieci, implementacja protokołu P2P wymaga przemyślanego zarządzania pamięcią, pasmem, bezpieczeństwem i wydajnością. Wymagana jest synchronizacja danych, obsługa utraty pakietów, dynamiczne zarządzanie topologią sieci, balansowanie obciążenia i ochrona przed przeciążeniem.

Bezpieczeństwo w sieciach P2P to temat złożony. Brak centralnej kontroli sprawia, że trudniejsze jest monitorowanie aktywności, egzekwowanie zasad, przeciwdziałanie nadużyciom. Ataki typu man-in-the-middle, fałszywe źródła danych, analiza ruchu czy celowe przeciążanie wybranych peerów mogą być trudne do wykrycia i zneutralizowania. W odpowiedzi stosuje się szyfrowanie end-to-end, podpisy cyfrowe, redundancję danych, dywersyfikację źródeł, a także dynamiczne protokoły reputacyjne. W blockchainie bezpieczeństwo zapewniają funkcje skrótu i łańcuch bloków, w BitTorrent – hasze plików i algorytmy dystrybucji danych.

Projektowanie sieci P2P wymaga wiedzy z zakresu teorii grafów, teorii informacji, kryptografii i protokołów sieciowych. Algorytmy rozgłaszania, trasowania, synchronizacji i rozwiązywania konfliktów muszą być odporne na błędy, opóźnienia i działanie w niepewnym środowisku sieciowym. Sieci P2P oferują ogromny potencjał w budowie usług zdecentralizowanych, odpornych na cenzurę, awarie i przeciążenia – od systemów plików (IPFS), przez repozytoria kodu (GIT'a), aż po całe platformy aplikacyjne (Dat, Secure Scuttlebutt).